神经网络概念

一、神经网络的种类:

基础神经网络:单层感知机,线程神经网络,bp神经网络,hopfield神经网络等

进阶神经网络:玻尔兹曼机,受限玻尔兹曼机,递归神经网络等

深度神经网络:深度置信网络,卷积神经网络,循环神经网络,lstm圣经网络等

一、 感知机 svm

有n个输入数据,通过权重与各数据之间的计算和 ,w1x1+w2x2+w3*x3+…=y

比较激活函数结果,得出输出

应用:很容易解决与、或问题

感知机是解决分类问题

异或问题:相同为0,不同为1

如何解决:线性回归模型构造直线 通过直线分解

单个感知机无法解决异或问题 可以使用两个感知机解决。而神经网络就是基于感知机模型。

神经网络的特点

输入向量的纬度和输入神经元的 个数相同

每个连接都有神经元之间的连接

由输入层、隐层、输出层组成

第N与第N-1层的所有神经元连接,也叫全连接

DNN (深度神经网络)

CNN(卷积神经网络)

卷积层:

一、卷积层概念

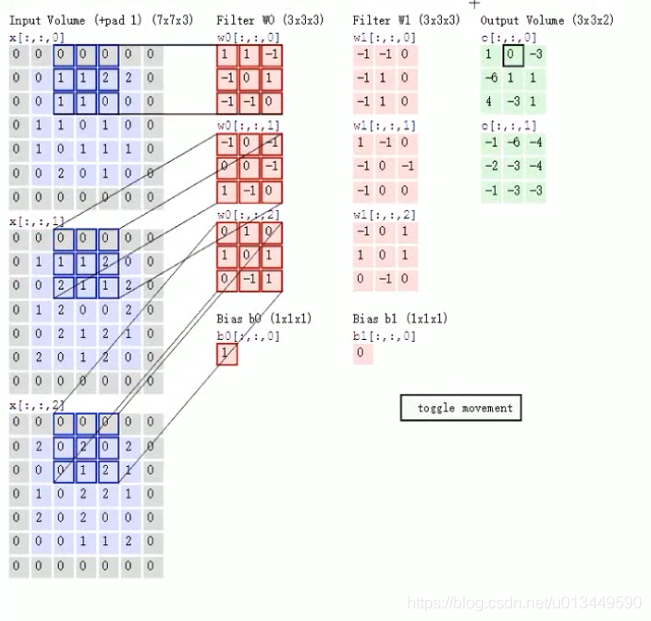

定义过滤器(观察窗口)的大小,和移动的步长。

对于一张图片不去对整体像素值进行分析,而是通过部分像素点(叫做窗口)进行线程回归,然后通过向左和向下平移在去对其余的像素进行分析。

这里用三个权重矩阵来分别处理三个通道像素。

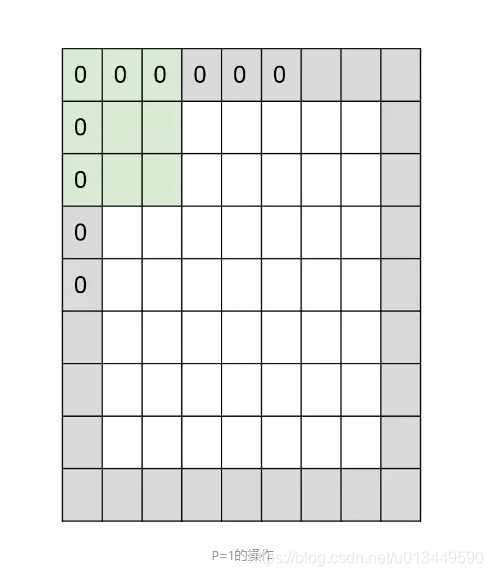

二、零填充

为了使卷积层输出结果的大小和原图大小相同。将原图使用0填充。当填充层数padding = 1 时填充结果图:

这样如果要想使卷积层输出和原图大小 相同 可以通过简单计算 计算出padding 的层数。达到目的。

激活层

一、激活函数 relu max(0,x)

相比与sigmod 函数来说relu计算比较方便

sigmod反向传播容易造成梯度爆炸

池化层

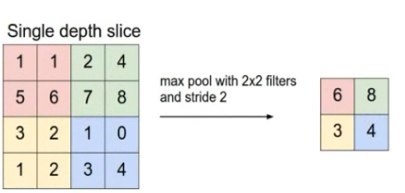

一、作用

特征提取,过滤掉不重要的样本 从而减少参数的数量 最常见的方法是Max Pooling

全连接层

一、作用

池化 卷积等相当于 特征工程 全连接相当于特征加权。起到分类器的作用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?