目录

自动化工作流管理:通过 Argo Workflows 简化 Kubernetes 工作流执行

引言

在云原生技术的世界中,工作流管理工具是自动化的核心组成部分,尤其是在容器化和 Kubernetes 环境中。Argo Workflows 是一个强大的工具,用于在 Kubernetes 集群中编排和管理工作流。它为用户提供了简单、高效的方式来创建、调度和管理复杂的任务序列。本文将基于 Argo Workflows 的官方文档,全面介绍 Argo Workflows 的核心概念、使用方法及其应用场景,帮助您快速上手。

一、Argo Workflows 概念介绍

Argo Workflows 是一个 Kubernetes 原生的工作流引擎,能够帮助用户定义和管理任务流。工作流的核心目标是编排复杂的任务,并通过 Kubernetes 自动化执行每一个步骤。

1. 工作流(Workflow)

工作流是由一组任务组成的,并且每个任务都是 Kubernetes 中的 Pod。一个工作流包含多个步骤,步骤之间可以是顺序执行或并行执行。通过 Workflow,您可以调度和管理整个任务流程。

工作流的定义通常是通过一个 YAML 文件来描述的,文件中指定了任务的执行顺序、输入和输出参数、资源需求等。

2. 模板(Template)

模板是工作流的构成单位,每个步骤可以看作是一个模板。模板定义了任务的执行逻辑,包括任务类型(容器、脚本等)以及运行时的参数。Argo Workflows 提供了多种模板类型,如:

- Container Template:用于运行容器化任务。

- Script Template:用于运行脚本。

- DAG Template:用于定义有向无环图(DAG)形式的任务依赖关系。

3. 步骤(Steps)与 DAG(有向无环图)

工作流中的步骤(Steps)是组成任务流的基本单元。在 Argo Workflows 中,任务可以顺序执行或并行执行,顺序执行的任务是通过 steps 来描述的,步骤之间通过依赖关系进行连接。

DAG(有向无环图)是另一种常用的任务依赖描述方式。在 DAG 模式下,任务之间的依赖关系是通过图形的方式定义的,每个节点代表一个任务,边代表任务间的依赖关系。DAG 模式更适合复杂的任务流。

4. 参数化(Parameterization)

工作流支持参数化,使得每个任务可以根据输入参数动态调整。例如,您可以通过工作流的参数传递不同的数据集、容器镜像或配置文件,以适应不同的执行场景。

DAG(有向无环图)是一种图形结构,用来表示任务之间的依赖关系。它由一系列节点(表示任务)和有方向的边(表示依赖关系)组成,但没有环路,也就是说,图中不存在从某个节点出发又回到该节点的路径。

通俗解释:

想象你有多个任务需要按顺序完成,但有些任务可以并行进行,只有完成前面的任务才能做后面的任务。DAG

就像一张“路线图”,帮助你安排任务的执行顺序。

- 节点:任务或操作。

- 边:表示任务间的依赖关系。例如,任务 A 完成后,任务 B 才能开始。

DAG 的原理:

- 有向:边有方向,表示任务之间的执行顺序。

- 无环:图中没有回到原点的路径,确保任务的执行没有死循环,避免任务间的依赖造成无限等待。

在 Argo Workflows 中,DAG 被用来定义任务之间的复杂依赖关系,确保任务按正确的顺序执行。

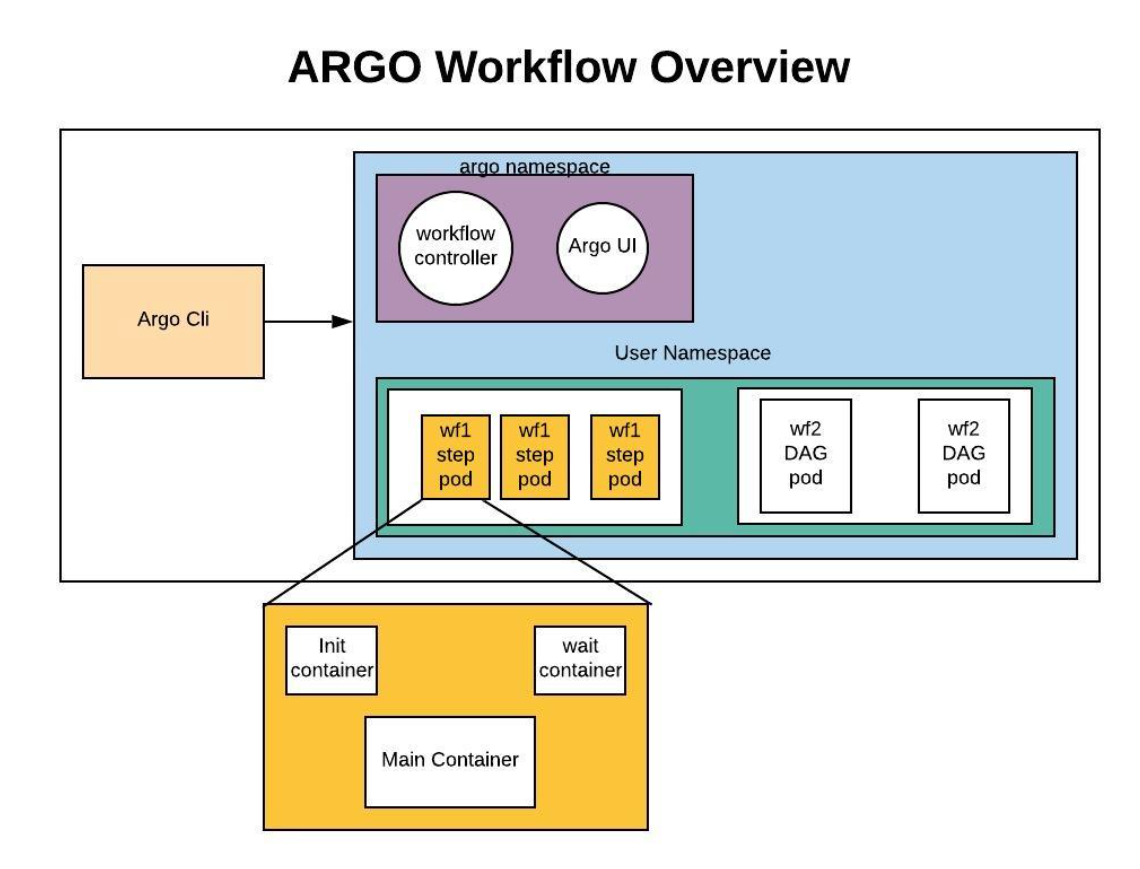

二、Argo Workflows 原理与架构

Argo Workflows 构建在 Kubernetes 之上,充分利用 Kubernetes 的容器编排和管理能力。它通过 Kubernetes 的资源管理系统来创建和调度任务。以下是 Argo Workflows 的核心组件和执行原理:

1. 核心组件

-

Workflow Controller:Workflow Controller 是 Argo Workflows 的核心,它负责创建和管理工作流的生命周期。控制器会根据工作流定义文件中的描述,自动调度每个任务的执行。

-

Argo Server:Argo Server 提供了 Web 界面和 API,用户可以通过它查看工作流的状态、获取日志信息等。Web UI 使得工作流的监控和管理变得更加直观。

-

CLI 工具:Argo 提供了

argo命令行工具,用户可以通过命令行提交工作流、查看日志和状态、管理工作流等。

2. 工作流执行过程

在 Argo Workflows 中,工作流的执行过程涉及多个步骤和组件协同工作。以下是 Argo 执行全流程的概述,并附有 Mermaid 格式的时序图和步骤说明。

步骤说明:

-

用户提交工作流定义: 用户使用 Argo CLI 提交包含任务和依赖关系的工作流 YAML 文件。

-

Argo Server 接收请求: Argo Server 接收工作流提交请求,并将其转发给 Workflow Controller。

-

Workflow Controller 创建工作流对象: Workflow Controller 在 Kubernetes 中创建相应的工作流对象,开始管理任务的执行。

-

调度任务执行: Workflow Controller 根据工作流定义,创建并调度 Kubernetes Pod 来执行各个任务。

-

任务执行与反馈: Kubernetes Pod 执行任务,并将执行结果反馈给 Workflow Controller。

-

更新工作流状态: Workflow Controller 更新工作流的执行状态,并将信息返回给 Argo Server。

-

用户获取结果: 用户通过 Argo CLI 或 Web UI 查看工作流的执行状态和结果。

通过上述流程,Argo Workflows 实现了对复杂任务的自动化编排和管理,确保任务按照预定的顺序和依赖关系高效执行。

三、如何使用 Argo Workflows:从入门到实践

接下来,我们将通过简单的示例,演示如何使用 Argo Workflows 创建并执行工作流。

1. 安装 Argo Workflows

首先,您需要在 Kubernetes 集群中安装 Argo Workflows。您可以使用以下命令进行安装:

kubectl create namespace argo

kubectl apply -n argo -f https://github.com/argoproj/argo-workflows/releases/latest/download/install.yaml

安装完成后,您可以通过以下命令验证 Argo 是否成功安装:

kubectl -n argo wait --for=condition=Ready pod -l app=workflow-controller

kubectl -n argo wait --for=condition=Ready deployment argo-server

2. 创建工作流 YAML 文件

接下来,我们将创建一个简单的工作流,执行一个容器任务,输出一条消息。创建一个名为 simple-workflow.yaml 的文件,内容如下:

apiVersion: argoproj.io/v1alpha1

kind: Workflow

metadata:

generateName: hello-world-

spec:

entrypoint: whalesay

templates:

- name: whalesay

container:

image: docker/whalesay:latest

command: [cowsay]

args: ["hello world"]

此工作流包含一个步骤,使用 docker/whalesay 容器并执行 cowsay 命令输出 hello world。

3. 提交工作流

使用 Argo CLI 提交工作流:

argo submit simple-workflow.yaml --watch

这将启动工作流并在命令行中显示执行过程。

4. 查看工作流状态与日志

提交工作流后,您可以通过以下命令查看工作流的状态:

argo list

查看日志信息:

argo logs <workflow-name>

5. 删除工作流

工作流完成后,您可以使用以下命令删除工作流:

argo delete <workflow-name>

四、Argo Workflows 的应用场景

Argo Workflows 的设计使其在多个场景下都能提供强大的支持。以下是几个常见的应用场景:

1. CI/CD 流水线

Argo Workflows 可以自动化整个持续集成(CI)和持续交付(CD)流程。例如,在代码提交后自动构建应用、运行单元测试,并将构建结果部署到生产环境。

2. 数据处理与 ETL

在数据工程中,Argo Workflows 能帮助团队自动化 ETL(数据抽取、转换和加载)流程。用户可以在多个数据源之间调度任务,实现复杂的数据处理任务。

3. 机器学习模型训练

Argo Workflows 是数据科学家和机器学习工程师的好帮手,它能够自动化机器学习模型的训练、评估和部署过程。例如,您可以通过工作流自动化模型超参数调优,训练多个模型并选择最佳结果。

五、Argo Workflows 的可观测性

1. Argo Workflows 的可观测性概述

可观测性是指通过收集和分析指标、日志和追踪数据,来理解系统内部状态的能力。对于 Argo Workflows,确保其可观测性涉及以下方面:

- 工作流和节点状态监控:实时了解工作流及其各个步骤的执行状态。

- 日志管理:收集和持久化工作流执行过程中的日志,以便于故障排查和性能分析。

- 指标收集:获取工作流执行的关键性能指标,帮助优化和调整工作流。

2. 监控工作流和节点状态

Argo Workflows 提供了多种方式来监控工作流和节点的状态:

- Argo CLI:使用

argo list命令列出当前命名空间下的所有工作流及其状态。 - Kubernetes 命令:通过

kubectl get pods查看与工作流相关的 Pods,并使用kubectl logs查看特定 Pod 的日志。 - Web UI:Argo Server 提供的 Web 界面允许用户直观地查看工作流的状态、日志和执行历史。

3. 日志管理与持久化

默认情况下,Argo Workflows 的日志存储在 Kubernetes Pods 中,但这些日志可能在 Pod 被删除后丢失。为了确保日志的持久性和便于集中管理,建议将日志输出到外部存储系统,如 MinIO、S3 等。

步骤:

- 部署 MinIO:在 Kubernetes 集群中部署 MinIO,用于存储工作流日志。

- 创建存储桶:在 MinIO 中创建用于存储日志的存储桶,例如

argo-workflow-logs。 - 配置访问密钥:设置访问 MinIO 所需的访问密钥,并在 Argo Workflow Controller 的 ConfigMap 中引用这些密钥。

- 修改 ConfigMap:编辑 Argo Workflow Controller 的 ConfigMap,设置日志存储的相关参数,例如启用日志归档并配置存储桶信息。

4. 集成 Prometheus 和 Grafana

为了实现对 Argo Workflows 的全面监控,可以结合使用 Prometheus 和 Grafana,收集和可视化工作流的指标数据。

步骤:

- 部署 Prometheus:在 Kubernetes 集群中部署 Prometheus,用于收集工作流的指标数据。

- 配置指标暴露:确保 Argo Workflows 的组件(如 Workflow Controller)暴露 Prometheus 可抓取的指标端点。

- 设置 Grafana 仪表板:使用 Grafana 创建仪表板,实时显示工作流的执行状态、成功率、执行时间等关键指标。

5. 使用 Argo Server 的 Web UI

Argo Server 提供了一个基于 Web 的用户界面,方便用户查看工作流的状态、日志和执行历史。

功能:

- 工作流列表:查看所有工作流的执行状态,包括成功、失败、进行中等状态。

- 日志查看:点击特定工作流,可以查看各个步骤的日志输出,方便调试和分析。

- 执行历史:查看工作流的历史执行记录,分析执行趋势和性能。

五、总结

Argo Workflows 是一个强大的 Kubernetes 原生工作流编排工具,能够帮助用户管理和自动化复杂的任务流。它通过简单直观的 YAML 配置文件定义工作流,支持任务的顺序执行和并行执行,同时提供强大的参数化、DAG 支持和模板复用功能,广泛应用于 CI/CD、数据处理、机器学习等领域。

在确保工作流高效、可靠运行的过程中,Argo Workflows 的可观测性至关重要。通过集成日志管理、指标收集和监控工具,用户可以深入了解工作流的执行情况,及时发现并解决问题。这种可观测性不仅提高了工作流的透明度,还增强了系统的可靠性和性能。

通过本文的学习,您已经掌握了 Argo Workflows 的基本概念、工作原理、如何创建和管理工作流,以及如何实施日志管理和监控。接下来的步骤是继续实践,进一步探索 Argo Workflows 的高级特性,掌握更复杂的工作流编排技巧。

495

495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?