一、全参数微调核心概念

全参数微调(Full Parameter Fine-tuning)是指对预训练模型的所有权重参数进行梯度更新的优化方法。相较于LoRA等参数高效微调技术,这种方法通过全局反向传播使模型全面适应目标领域,尤其适用于专业领域知识迁移场景。其核心优势体现在:

-

知识迁移充分:充分利用预训练模型的通用语义理解能力

-

任务适配性强:特别适合医疗、法律等专业领域微调

-

生成质量优异:通常能获得更连贯、准确的输出结果

技术代价方面需要关注:

-

32GB+显存需求(以Qwen3-1.7B为例)

-

约2小时训练耗时(A100显卡)

-

过拟合风险需通过早停法缓解

二、环境配置指南

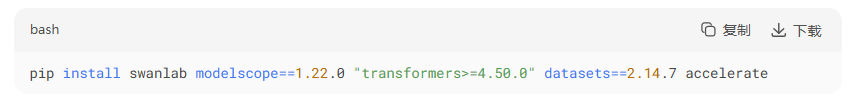

推荐使用Python 3.10+和CUDA 11.8环境,主要依赖库包括:

关键组件说明:

-

ModelScope:阿里开源的模型托管平台

-

SwanLab:训练可视化工具(国产W&B替代方案)

-

Accelerate:分布式训练加速库<

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

22万+

22万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?