目录

3.1 容量需求:从 “GB 级” 到 “PB 级”,海量数据吞噬存储

3.2 性能需求:高吞吐 + 低延迟,不能让 AI “等数据”

场景 1:AI 大模型训练(如 GPT 类)—— 垄断高端存储产能

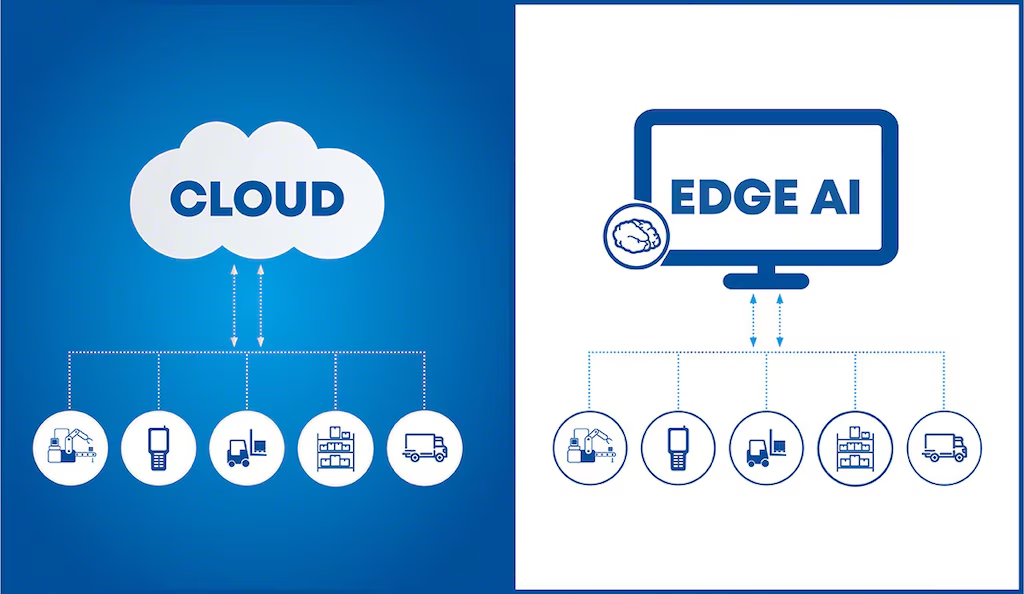

场景 6:智能音箱 / 摄像头(边缘 AI)—— 抢占低端存储产能

class 卑微码农:

def __init__(self):

self.技能 = ['能读懂十年前祖传代码', '擅长用Ctrl+C/V搭建世界', '信奉"能跑就别动"的玄学']

self.发量 = 100 # 初始发量

self.咖啡因耐受度 = '极限'

def 修Bug(self, bug):

try:

# 试图用玄学解决问题

if bug.严重程度 == '离谱':

print("这一定是环境问题!")

else:

print("让我看看是谁又没写注释...哦,是我自己。")

except Exception as e:

# 如果try块都救不了,那就...

print("重启一下试试?")

self.发量 -= 1 # 每解决一个bug,头发-1

# 实例化一个我

我 = 卑微码农()引言

2025 年的双十一,电脑装机佬们集体哀嚎:去年 618 花 343 元就能买到的 16GB DDR4 内存条,如今价格飙到 759 元,一年时间直接翻倍。更离谱的是,DDR4 价格居然反超新一代 DDR5,三星、美光等巨头还集体暂停报价,二手市场的企业级硬盘都被抢疯了。

这波堪比黄金涨幅的存储涨价潮,真的是商家炒作吗?其实背后藏着一个被忽略的关键推手 ——AI。当大家还在纠结手机该选 256GB 还是 512GB 时,AI 应用已经在悄悄 “吞噬” 全球超 40% 的内存产能,从数据中心到智能手机,从自动驾驶到智能音箱,AI 对存储的需求正在重构整个行业格局。

这篇文章用 “菜市场囤货” 的通俗逻辑,结合真实数据和场景,拆解 AI 如何改写存储规则。全文没有复杂算法,只有接地气的行业洞察、6 个典型场景案例和 4 套实用应对方案,哪怕你不懂深度学习,也能看懂存储涨价背后的底层逻辑。

一、先看震撼现状:存储市场疯涨有多夸张?

这轮存储涨价不是局部波动,而是覆盖 DRAM、NAND、HDD 全品类的 “普涨风暴”,数据足以说明问题:

- 内存(DRAM):DDR4 16GB 现货价较年初暴涨 200%,部分经销商溢价 50% 出售,甚至出现 “越涨越抢、越抢越涨” 的恐慌性囤货;

- 固态硬盘(NAND):QLC SSD 单月涨幅达 31.3%,企业级大容量 SSD 价格领涨,32TB、64TB 产品供不应求;

- 机械硬盘(HDD):交期超一年,价格上涨 20%-30%,创下矿潮后最大涨幅,数据中心淘汰的二手氦气硬盘成了 “香饽饽”;

- 高端存储:HBM(高带宽内存)价格是 DDR5 的 5 倍以上,却依然 “一货难求”,SK 海力士仅凭 HBM 产品就超越三星,登顶全球 DRAM 市场第一。

更关键的是,这轮涨价不是短期炒作。摩根士丹利预测,由于 AI 需求的持续性,全球存储市场规模或在 2027 年突破 3000 亿美元;德邦证券更是直言,DDR4 紧缺至少持续至 2026 年中,涨价周期可能长达 3 年以上。

普通消费者感受到的是 “装机成本翻倍”,但企业和开发者面临的是 “无货可买” 的困境 —— 某 AI 创业公司负责人透露,今年采购服务器内存的预算增加了 150%,却还得排队等货,原本 3 个月能落地的项目被迫延期。

二、核心疑问:为什么是 AI 引爆存储涨价?

存储涨价的本质是 “供需失衡”,但这轮失衡的核心推手不是消费电子回暖,而是 AI 应用的 “爆发式需求”。用一个通俗比喻理解:存储市场就像一个菜市场,原本供给(三大原厂产能)和需求(消费电子 + 传统服务器)刚好平衡,而 AI 突然成了 “超级大客户”,不仅要包圆儿高端菜品(HBM),还抢光了普通菜品(DDR4/DDR5),直接打破了市场平衡。

2.1 供给端:原厂 “断舍离”,产能向 AI 倾斜

全球存储芯片市场被三星、SK 海力士、美光三大巨头垄断,合计占据 95% 以上的 DRAM 市场份额。从去年开始,这些原厂做了一个关键决策:放弃低毛利的传统存储,全力冲刺 AI 需要的高端产品。

- 三大原厂全面停止 DDR4 新订单,将 80% 资本开支倾斜至 HBM 与 DDR5 等高毛利产品,DDR4 产线设备甚至被直接拆除;

- HBM 生产需要占用大量 3D 堆叠与先进封装产能,直接挤压了传统 DRAM 产量,而 HBM 的制造成本是 DDR5 的 5 倍以上,进一步加剧供给矛盾;

- 全球 DRAM 产能利用率已达 95% 的物理上限,新建晶圆厂周期长达 2-3 年,最快要到 2026 年下半年才能释放产能,短期内供给缺口无法填补。

简单说,原厂们发现 “卖给 AI 公司的高端存储更赚钱”,于是果断减产普通存储,导致消费级市场的 “菜量” 大幅减少。

2.2 需求端:AI 是 “吞存巨兽”,胃口远超想象

如果说传统服务器对存储的需求是 “一碗饭”,AI 服务器的需求就是 “一大锅饭”。AI 对存储的消耗,从训练到推理全链路都在 “超纲”:

- 单台 AI 服务器对 DRAM 的需求是普通服务器的 8 倍,NAND 需求达 3 倍,相当于一台 AI 服务器要吃掉 8 台普通服务器的存储资源;

- OpenAI “星际之门” 计划每月采购的 90 万片 DRAM 晶圆,就占全球总产量近 40%,相当于直接垄断了五分之二的产能;

- 2025 年全球 AI 服务器内存采购量同比增超 30%,而服务器内存占全球存储需求的 35%,直接拉动整个存储市场价格上涨;

- 除了 AI 服务器,AI 手机、AI PC、自动驾驶等终端产品也在抢存储:2025 年 AI 手机将占 30% 市场份额,LPDDR5X 成标配;智能汽车单台车年数据量达 3.6PB,100 辆车就需要 360PB 存储,相当于 18 亿部高清电影。

更关键的是,AI 对存储的需求是 “刚性” 的 —— 模型训练不能中断,数据不能丢失,哪怕存储价格翻倍,AI 公司也得咬牙采购,这就形成了 “需求不减、价格上涨” 的恶性循环。

2.3 叠加效应:消费电子 + 国产化替代,进一步加剧缺口

除了 AI 这个核心推手,两个叠加因素让涨价更猛烈:

- 消费电子市场回暖:2025 年下半年智能手机、游戏本新品密集发布,LPDDR5X/DDR5-6400 成为标配,暑期备货潮让本就紧张的产能雪上加霜;

- 国产化替代加速:江波龙、佰维等国内厂商切入阿里、腾讯供应链,批量交付存储产品,进一步消耗颗粒库存,群联电子数据显示,9 月 PCIe SSD 控制芯片出货量同比增 300%。

三者叠加之下,存储市场从 “供大于求” 瞬间变成 “供不应求”,价格上涨也就成了必然。

三、透过涨价看本质:AI 对存储的 3 大核心需求

内存涨价只是表象,背后是 AI 应用对存储的 “特殊要求”—— 和传统应用相比,AI 对存储的需求堪称 “苛刻”,这也是原厂愿意放弃传统市场、全力冲刺 AI 存储的根本原因。用 “仓库管理” 的比喻,传统应用的存储是 “社区超市”,而 AI 的存储是 “巨型物流中心”,核心需求体现在 3 个方面:

3.1 容量需求:从 “GB 级” 到 “PB 级”,海量数据吞噬存储

AI 的核心是 “数据喂养”,模型性能越强,需要的数据越多,对存储容量的需求呈指数级增长:

- 训练一个基础图像识别模型,需要至少 100 万张图片,按每张 1MB 算,仅原始数据就需要 1TB 存储,再加上标注数据、模型参数,总存储需求达 2-3TB;

- 训练大语言模型(如 LLaMA),需要 1.4 万亿个单词的文本数据,存储量超过 10TB,而训练过程中产生的中间参数快照,每小时就要占用 1TB 存储;

- 自动驾驶公司更夸张,Waymo 的测试车累计产生的数据超过 20PB,相当于 2 亿部高清电影;单辆车每天产生 10TB 数据,一年就是 3.6PB,100 辆车的年存储需求达 360PB;

- 数据中心的存储需求更是恐怖,2025 年全球数据中心存储的数据量约为 100ZB,换算成 TB 就是 1073741824TB,相当于每个中国人拥有 7.6TB 的数据需要存储。

更关键的是,这些数据不能 “用完就扔”。AI 训练需要多轮迭代,旧数据要和新数据对比效果,模型参数要长期保存以便调优,这意味着存储容量必须 “随用随扩”,且需要长期占用大量空间。

3.2 性能需求:高吞吐 + 低延迟,不能让 AI “等数据”

如果说容量是 “仓库大小”,性能就是 “取货速度”。AI 的训练和推理都是 “分秒必争”,存储速度慢一点,就会拖慢整个流程:

- 训练阶段:10 块 GPU 同时工作,每块 GPU 每秒需要读取 10GB 数据,存储系统每秒至少要传输 100GB 数据才能不 “拖后腿”;而大模型训练用 1000 台 GPU 集群,存储每秒需传输 1TB 数据,相当于 1 秒传 200 部电影;

- 推理阶段:AI 客服、自动驾驶等实时应用,需要毫秒级响应。比如自动驾驶识别突然出现的行人,从存储调用模型参数和历史路况数据,必须在 0.1 秒内完成,否则可能引发事故;AI 手机的实时翻译、美颜功能,延迟超过 0.05 秒就会感觉 “卡顿”;

- 特殊需求:AI 推理依赖的 KV Cache 技术,随上下文长度和并发数急剧膨胀,需要存储具备快速读写和缓存能力,否则会导致首屏响应时间过长。

存储性能不足,再强的 GPU 也会 “饿肚子”。某 AI 公司测试显示,存储吞吐不够时,原本 10 天能训练完的模型会拖到 15 天,算力成本直接增加 50%—— 这也是 AI 公司愿意花高价采购 HBM 的原因,HBM 的带宽是传统 DDR5 的 5 倍以上,能让 GPU “吃饱喝足”。

3.3 结构需求:分层存储 + 高可靠,既要省钱又要安全

AI 对存储的需求不是 “一刀切”,而是 “分层刚需”,同时对可靠性要求极高:

- 分层存储:AI 数据有明显的 “冷热差异”,训练中的高频访问数据(热数据)需要 HBM、DDR5 等高速存储,近 3 个月的训练数据(温数据)可用混合存储,历史备份数据(冷数据)可存 QLC SSD 或 HDD,这样能平衡性能和成本;

- 高可靠性:AI 数据丢不起 —— 训练大模型时,中间参数快照丢了,可能意味着之前 3 天的训练白费,损失几十万元算力成本;自动驾驶的测试数据损坏,可能导致模型学到错误路况,影响行车安全;

- 兼容性:需要兼容多数据格式(文本、图像、视频、张量)和 AI 框架(TensorFlow、PyTorch),还要支持多节点并行访问,满足集群训练需求。

这种 “分层 + 可靠 + 兼容” 的复合需求,让传统存储方案难以满足,也推动了 HBM、QLC SSD、分布式存储等新技术的爆发。

四、6 个真实场景:AI 如何抢光你的存储资源?

不同 AI 应用对存储的需求不同,但都在无形中挤占消费级市场的产能。我们用 6 个场景,看看 AI 是如何 “分食” 存储资源的:

场景 1:AI 大模型训练(如 GPT 类)—— 垄断高端存储产能

应用特点:千亿参数大模型训练,需要 1000 台 GPU 超算集群,持续训练数月。存储需求:需要 HBM(高带宽内存)和并行文件系统,追求极致吞吐和低延迟。抢产能方式:单台训练集群需要上百 TB HBM,而 HBM 产能被三星、SK 海力士优先供给英伟达、OpenAI 等大客户,直接挤压传统 DRAM 产能。数据支撑:HBM 市场 2025 年需求增长超 80%,12 层堆叠的 HBM3e 成主流,占 DRAM 市场份额已接近 30%。用什么存储:HBM3e(带宽达 1TB/s)+ 并行文件系统(Lustre/IBM Spectrum Scale),单套存储成本超千万元。

场景 2:AI 服务器(数据中心)—— 海量采购普通内存

应用特点:支撑 AI 推理(如智能客服、图像识别 API),单数据中心部署数千台服务器。存储需求:需要大容量 DDR5 内存和企业级 SSD,追求高并发和弹性扩容。抢产能方式:单台 AI 服务器需 32-128GB DDR5 内存,数据中心批量采购导致 DDR5 供不应求,倒逼原厂减产 DDR4。数据支撑:2025 年全球 AI 服务器预计达 1330 万台,主流平台全面支持 DDR5 和 PCIe5.0,内存采购量同比增 30%。用什么存储:DDR5-6400 内存(单条 32GB)+ 32TB QLC SSD,单台服务器存储成本超 2 万元。

场景 3:AI 手机 —— 挤占移动存储产能

应用特点:内置大语言模型,支持离线语音识别、智能相册、实时翻译。存储需求:需要 LPDDR5X 内存和 UFS4.1 闪存,追求低功耗和高速度。抢产能方式:AI 手机内存标配 8-12GB LPDDR5X,存储标配 512GB UFS4.1,2025 年占手机市场 30% 份额,吞噬大量移动存储产能。数据支撑:UFS4.1 IO 速度达 3.6GB/s,512GB 至 1TB 的 QLC UFS 将成为 AI 手机主流。用什么存储:LPDDR5X(12GB)+ UFS4.1(1TB),手机存储成本占整机成本的 15%-20%。

场景 4:自动驾驶 —— 海量数据倒逼存储扩容

应用特点:实时识别路况,同时回传数据到云端训练,每车每天产生 10TB 数据。存储需求:车端需要抗震动的工业级 SSD,云端需要 PB 级对象存储。抢产能方式:单车企 100 辆车年需 360PB 存储,大量采购企业级 SSD 和 HDD,导致 HDD 交期超一年。数据支撑:智能汽车存储需求年增速超 50%,工业级 SSD 占汽车电子存储市场的 60% 以上。用什么存储:车端用 2TB 工业级 SSD,云端用对象存储(AWS S3 / 阿里云 OSS)+ 分布式文件系统。

场景 5:AI PC—— 推动 PC 内存规格升级

应用特点:内置 NPU,支持本地 AI 计算(如文档摘要、图像编辑)。存储需求:需要 DDR5 内存和 PCIe4.0 SSD,追求大容量和低延迟。抢产能方式:AI PC 内存标配 16-32GB DDR5,存储标配 1TB SSD,2025 年迎来爆发,拉动 DDR5 和消费级 SSD 需求。数据支撑:DDR5 内存在 PC 市场渗透率 2025 年将达 60%,PCIe4.0 SSD 成为标配。用什么存储:DDR5-5600(32GB)+ 1TB PCIe4.0 SSD,存储成本占 PC 总成本的 25%。

场景 6:智能音箱 / 摄像头(边缘 AI)—— 抢占低端存储产能

应用特点:支持离线 AI 功能(如语音唤醒、人形检测),部署量巨大。存储需求:需要低成本 eMMC 闪存和小容量 DDR4 内存。抢产能方式:单台设备需 2-8GB eMMC 闪存,全球数十亿台边缘设备,吞噬大量低端存储产能。数据支撑:边缘 AI 设备存储需求年增速超 40%,eMMC 闪存出货量 2025 年达 5 亿片。用什么存储:DDR4-2666(2GB)+ eMMC 5.1(8GB),单台存储成本仅 50-100 元。

这 6 个场景覆盖了从高端到低端的全存储品类,AI 应用的全面爆发,相当于从 “金字塔尖” 到 “金字塔底” 全方位抢占存储产能,消费级市场自然会出现 “缺货涨价”。

五、应对之策:不同角色如何穿越涨价周期?

面对持续 3 年以上的涨价周期,普通消费者、AI 开发者、企业决策者都需要针对性策略,既不盲目跟风,也不被动挨宰。

5.1 普通消费者:刚需入手,避开溢价陷阱

- 刚需不等待:如果是装机、升级电脑,没必要等降价,DDR4/DDR5 价格短期内难回调,早买早用,避免越涨越贵;

- 避开花费陷阱:优先选 DDR5 而非 DDR4,虽然价格相近,但 DDR5 性能更强、未来兼容性更好;SSD 选 1TB 容量,性价比最高,避免小容量后续不够用;

- 考虑二手优质货:数据中心淘汰的企业级氦气硬盘,实际寿命和性能没太大影响,价格是消费级的 60%-70%,找老店购买并索要售后保障;

- 拒绝盲目囤货:普通用户没必要囤内存 / 硬盘,存储产品更新快,囤货可能面临 “过时贬值”,且占用资金。

5.2 AI 开发者:优化方案,降低存储依赖

- 数据瘦身:删除重复、模糊、无标注的数据,用数据增强技术替代部分真实数据,可减少 50% 存储需求;

- 模型优化:采用量化、剪枝技术压缩模型参数,比如将 16 位精度模型量化为 8 位,存储需求减半,推理速度还能提升;

- 存储分层策略:训练时将热数据存 SSD,温数据存混合存储,冷数据存对象存储,避免全用高性能存储;

- 采用 “以存代算” 方案:用高性能 SSD 替代部分高价内存,比如极客天成的 KV Cache 加速方案,可降低 70% 推理成本,性能不打折。

5.3 IT 运维:架构升级,平衡性能与成本

- 冷热数据分层:用 Ceph、GlusterFS 等分布式存储,自动将高频数据移到 SSD,低频数据移到 HDD / 对象存储,节省 30%-50% 成本;

- 内存池化:通过 CXL 技术实现内存共享,多个 GPU/CPU 共用内存资源,提高内存利用率,减少采购量;

- 国产化替代:选用长江存储、长鑫存储的产品,比如长江存储的 Xtacking4.0 SSD,性能接近国际品牌,价格低 10%-20%;

- 二手设备复用:数据中心淘汰的服务器内存、SSD,经测试后可用于非核心业务,成本降低 40% 以上。

5.4 企业决策者:战略布局,锁定长期成本

- 长期协议锁价:与存储厂商签订 1-2 年长期采购协议,锁定价格,避免后续涨价风险;

- 技术预研:投入 “以存代算”“AISSD” 等新技术,比如华为 UCM、浪潮 AS3000G7 等方案,从根源降低对高价内存的依赖;

- 产能合作:与国产存储厂商(如长江存储、长鑫存储)深度合作,优先获取产能,同时降低供应链风险;

- 云存储弹性扩容:核心业务用私有存储,非核心业务用公有云存储,按实际使用量付费,避免自建存储的高额初始投入。

六、未来趋势:AI 驱动存储行业 3 大变革

这轮存储涨价不仅是市场周期,更是行业变革的信号。未来 3-5 年,存储行业将迎来 3 大趋势,直接影响我们的技术选择和采购决策:

趋势 1:技术迭代加速,HBM+QLC 成主流

- HBM 持续爆发:从 HBM3e 到 HBM4,带宽和容量持续提升,2030 年营收占比将超 DRAM 总营收的 50%,成为 AI 训练的核心存储方案;

- QLC SSD 普及:QLC SSD 容量达 128TB,成本比 TLC 低 30%,将成为数据中心冷存储的主流,同时切入消费级市场;

- 4D NAND 落地:SK 海力士已量产 321 层 4D NAND,铠侠计划 2027 年推出 1000 层 3D NAND,存储密度提升 10 倍,单位成本持续下降。

趋势 2:架构重构,存算分离 + 以存代算

- 存算分离:存储与计算(GPU/CPU)独立部署,通过高速网络连接,存储和计算可各自扩容,提高资源利用率;

- 以存代算:将 AI 推理的 KV Cache 等数据迁移至 SSD,减少对高价内存的依赖,端到端推理成本降低 70%,首 Token 时延缩短 87%;

- 内存池化:基于 CXL3.0 技术,实现多设备内存共享,打破单设备内存限制,提高资源利用率。

趋势 3:国产化崛起,打破海外垄断

- 3D NAND 突破:长江存储的 Xtacking 技术已达国际先进水平,第五代 TLC 3D NAND 产品广泛应用于消费级和企业级场景;

- DRAM 量产:长鑫存储实现 DDR4、LPDDR4x 量产,逐步打破三星、SK 海力士的垄断,未来 3 年将持续扩产;

- 生态完善:国内厂商在分布式存储、存储控制器、固件算法等领域持续突破,形成完整产业链,降低对海外技术的依赖。

结语:AI 重构存储,涨价只是开始

内存价格翻倍的背后,是 AI 对存储行业的 “重构革命”。这不是一次简单的市场周期波动,而是技术变革带来的需求升级 ——AI 需要的不是 “更多存储”,而是 “更聪明的存储”,这种需求正在推动存储技术从 “容量竞赛” 转向 “性能与效率竞赛”。

对于普通消费者,这轮涨价是 “甜蜜的烦恼”—— 我们要为 AI 时代的到来支付更高的硬件成本,但也能享受到 AI 带来的智能体验;对于技术从业者,这是机遇也是挑战 —— 存储技术的变革将催生新的产品、方案和商业模式,抓住趋势就能抢占先机。

未来,存储不再是 “默默无闻的配角”,而是决定 AI 性能上限的 “核心基础设施”。当 HBM、以存代算、国产化存储成为主流,我们或许会发现,这轮涨价不仅是成本的上涨,更是技术进步的 “入场券”。

1487

1487

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?