现象:

线上spark任务出现卡住一直运行不完的问题

一:排查步骤

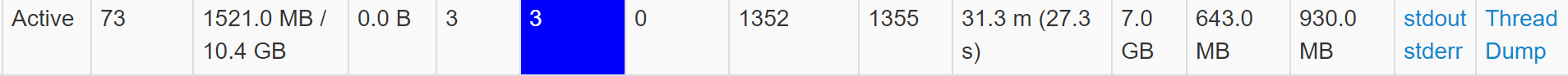

1.查看spark任务执行过程发现有三个task在运行

2.spark任务参数配置的一个executor三个core,查看task对应的excutor的日志发现当前excutor完成driver分配的上一个(206.0)task后,在执行下一个driver分配的下一个(236.0)task时,日志不再输出,看下图日志可以看到三个worker线程都是一样的在执行driver分配的task时没有任何日志输出,怀疑线程阻塞了。

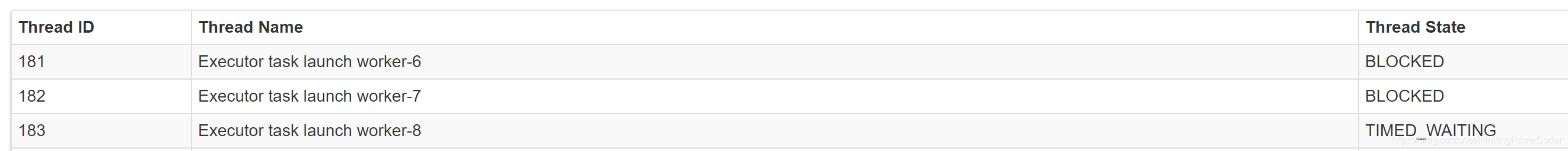

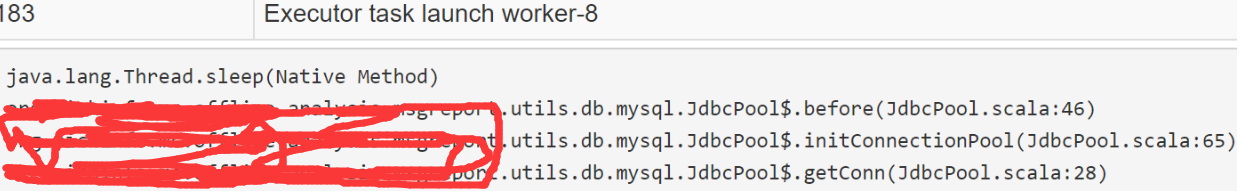

3.点击thread dump后可看到线程Executor task launch worker-6和Executor task launch worker-7处于BLOCKED状态,Executor task launch worker-8处于time_waiting状态。

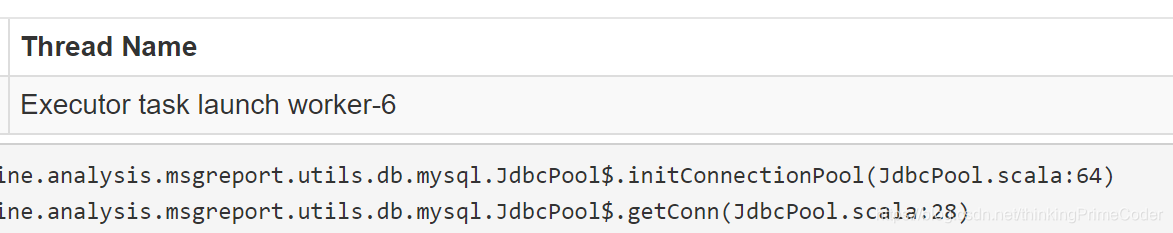

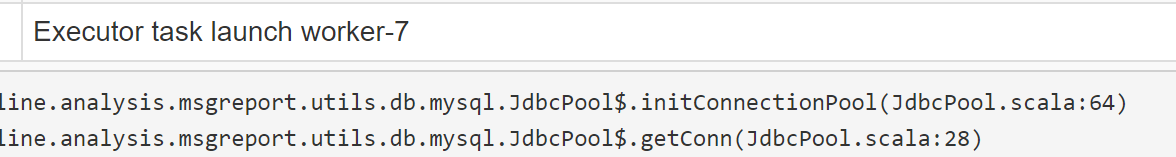

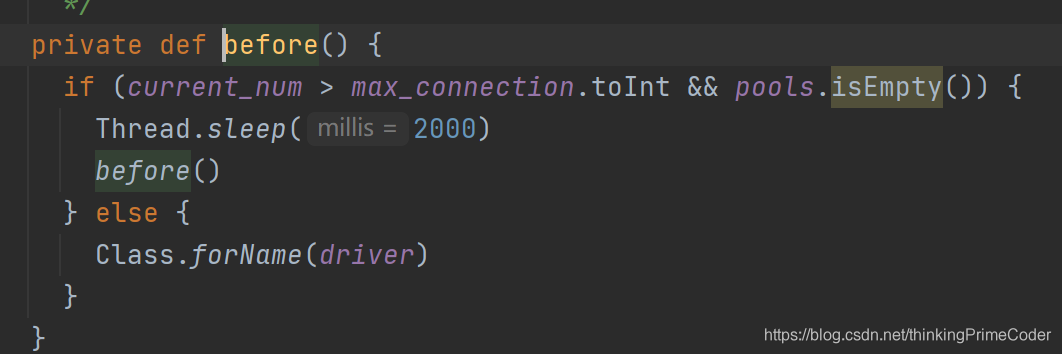

4.分别查看每个线程

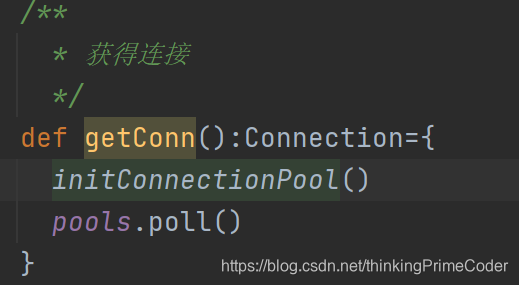

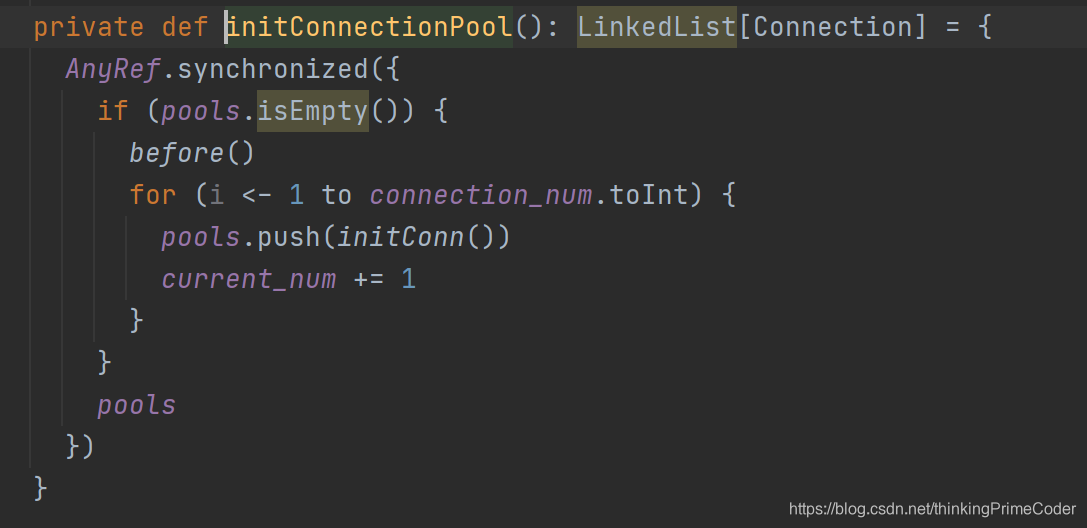

5.发现线程时在初始化连接池时block(excutor端在会把计算结果写入数据库,在插入数据库获取连接)

6.查看初始化连接池的代码发现在线程池连接已经用完并且连接数已经达到最大配置时,获取连接的线程在获取锁以后会循环执行before方法,导致其他线程在获取连接时等待锁(和thread dump显示的一致,三个worker线程两个block,一个time_waiting)因此当前executor的task一直运行不完。

二:分析原因

spark任务分析结果插入数据库时,为了避免每条结果数据都初始化一个连接使用foreachpartiton的在每个patition获取连接,减少连接数。但是在每个partition获取连接后没有释放连接,导致连接池中连接已经使用完,获取锁的线程一直不释放锁,其他线程进入block状态,导致任务一直运行不结束。

线上Spark任务出现长时间运行未结束的情况。排查发现,executor的task在执行数据库插入时,由于连接池耗尽,线程在初始化连接时被阻塞。分析原因,可能是foreachpartition操作中,每个partition获取连接后未及时释放,导致线程锁竞争,任务无法正常完成。

线上Spark任务出现长时间运行未结束的情况。排查发现,executor的task在执行数据库插入时,由于连接池耗尽,线程在初始化连接时被阻塞。分析原因,可能是foreachpartition操作中,每个partition获取连接后未及时释放,导致线程锁竞争,任务无法正常完成。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?