一.(本地使用comfyui)基本模块的了解

1.1这是初始界面

1.2搭建一个基本的工作流(如果使用的是秋叶大佬的包,每次进入会自动出现该工作流)

1.2.1加载器和取样器:

加载器,鼠标右键,点击新建节点,按下图操作,出现加载器

取样器,鼠标右键,然后按下图操作

可以看到如图结果:我们将“模型“连接起来;

1.2.2clip文本编辑器

如图一:我们从正面条件那里拉出一条“线“到空白处,然后松开,会显示出图二的提示,我们选择CLIP文本编辑器就可以了,然后对负面条件进行同样的操作:

图一

图二

结果如图:注意到,我们要把对应的CLIP连接起来

1.2.3Latent和VAE解码

如图,我们从k采样器左下角的latent拉出一条“线“,然后松开鼠标,会出现图二的提示,我们点击空Latent

图一

图二

结果如下图:

Vae解码:对K采样器左侧的Latent进行拉“线“,选择Vae解码:

然后,我们要将Vae解码的VAE和我们最开始创建的加载器的VAE连起来:

1.2.4图像的预览

同样的,我们从刚刚创建的VAE上引出一条“线“,松开鼠标,然后在提示里选择预览图象即可

1.2.5最后的结果和运行

最后的结果如下图:

注:事实上,我们没有必要每次用comfyui时都来创建比这个基本骨架更加完善的工作流,你可以使用b站秋叶aaaki的comfyui整合包(点击跳转),这位大佬的整合包会在你每次启动时默认搭建好了工作流,相当方便。

点击添加提示词队列:

生成结果如下图:

(结果,在这里没有添加任何其他的插件)

1.2.6图生图的搭建

图生图事实上是在文生图的框架上进行略微的修改,修改步骤如下:

首先:右击鼠标,按照下图的操作,加载一张图片:

然后选择我们要处理的图片,同时把原来的空Latent删去(如下图):

和其他模块连接,如下图:

然后就可以开始图生图了

1.3辅助插件的了解

1.3.1翻译类的插件,可以帮助我们更好的写提示词

按照下图操作使用该插件,三种翻译插件实际上都可以用于翻译提示词,这取决于你的习惯,可以自己用用看看适不适合哦~

使用这种插件的好处之一是:在输入提示词时,可以直接输入中文,该组件会帮助翻译为英文,一种连接方式如下图:

该图中的“预览文本“和”CLIP文本编辑器“可分别由下图得到:

注:该插件的翻译有时候不尽人意,仅面向于英文可能不是很熟练的朋友

二.(本地使用comfyui) 总结

Comfyui与web-ui的不同在于comfyui允许我们更精确的控制我们所生成的图片,但是同时,comfyui更加难以上手,往往需要我们拥有相关的前提知识(基础知识)才能比较自由地去使用,上述的操作,仅仅是一个最基础的工作流,无法实现和lora等等内容一起去调节图片的生成,但是如果这个简单的comfyui的工作流的搭建让你对AIGC有了更浓厚的兴趣,更愿意去探索这片位置的领域,这篇博客也就达成了它本身的意义。

三.(从魔搭社区开始使用comfyui)在线体验

Comfyui作为AIGC的一个工具,它太大了,如果你等不及让它慢慢地下载完,也许你可以试试魔搭社区,在这里,你可以在线使用comfyui,并且它更快(也许?),免去了你等待的时间。

1.1进入魔搭社区的个人界面,找到下图显示的位置:

点击启动,会跳转到另一个界面

1.2打开comfyui

在跳转出来的界面中,按照下图的步骤创建一个Terminal

在Terminal中复制如下的代码:

git lfs install

git clone https://www.modelscope.cn/datasets/maochase/kolors_test_comfyui.git

mv kolors_test_comfyui/* ./

rm -rf kolors_test_comfyui/

mkdir -p /mnt/workspace/models/lightning_logs/version_0/checkpoints/

mv epoch=0-step=500.ckpt /mnt/workspace/models/lightning_logs/version_0/checkpoints/

双击左栏的Comfyui,然后点击下图中红框中的标记,等待它运行完毕,

运行完毕后,复制然后进入下图中用红框框起来的地址:

这样就打开了comyui。

1.2尝试运行comfyui

我们要先加载模型,这些模型你可以在:Datawhile|魔搭社区怎么使用comfyui中找到,同时也有相应的教程,你可以在教程的对应的部分找到带lora和不带lora的模型

1.3结语

你可以在魔搭社区体验comfyui的使用,提前熟悉它的界面和使用方法

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

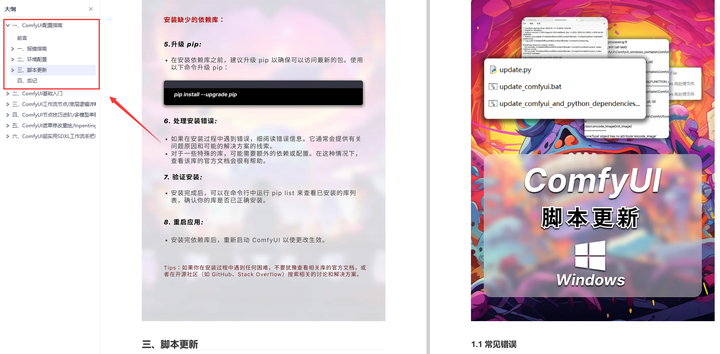

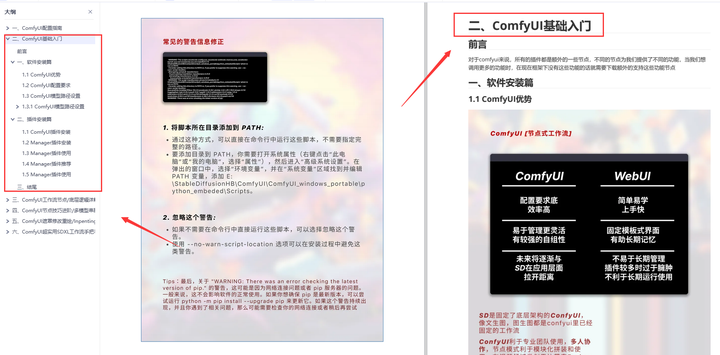

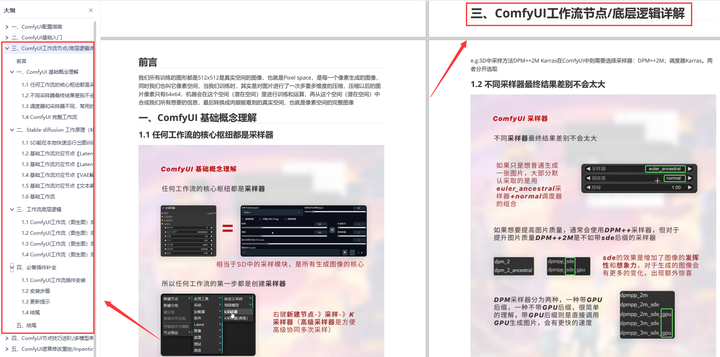

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

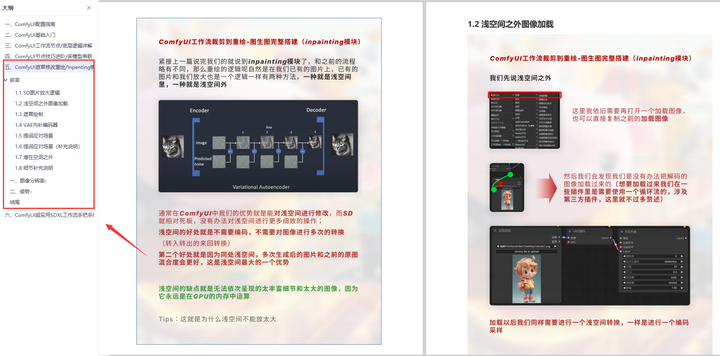

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

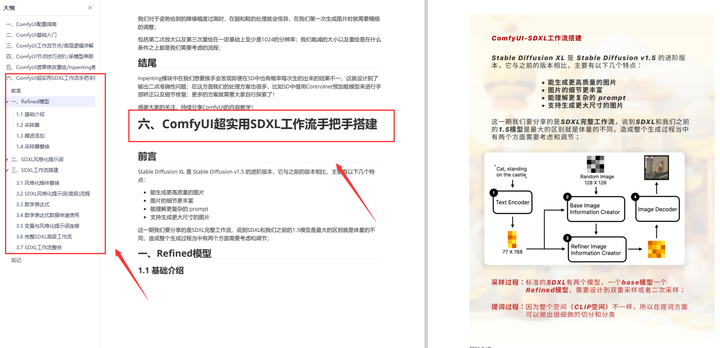

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

9737

9737

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?