视频版:https://v.douyin.com/A96FgcGl6uA/

Everything一直是我的装机必备软件,可以用来快速检索文件。但是它有两大缺点,缺点一是,只能用精确的文件名查找文件,一旦记错了文件名,就查找不到任何内容。缺点二是,Everything只有对文件名字的索引,而没有对文件内容的索引,如果需要按照文件内容查找,就会变得非常的慢。最近我找到了一个完全免费,且百分百离线运行的AI文件助手:Hyperlink。Hyperlink可以索引本地电脑上的文件,把文本、PDF、图片等各种类型的文件,整合成一个知识库。同时,Hyperlink会在本地运行一个离线AI模型,我们只需要输入自然语言,就可以快速查找文件。Hyperlink会使用本地AI,基于文件内容给出精准回答。每个答案都带有内嵌引用,可以直接链接到文档中的相关部分。Hyperlink还能通过多个文档进行综合推理,跨文件连接信息,很擅长发现知识的隐藏关联。比起其他的AI知识库软件,Hyperlink的最大好处是完全本地离线运行,使用本地运行的开源大模型,完全避免了调用API产生的费用。离线运行还确保了文件内容的隐私。另外一个好处是,Hyperlink提供了一键安装包和精美的用户界面,开箱即用,无需复杂的设置,就能把本地计算机变成自己的第二大脑,将所有重要的信息连接在一起,帮助我们处理重要的事情。

下载与安装

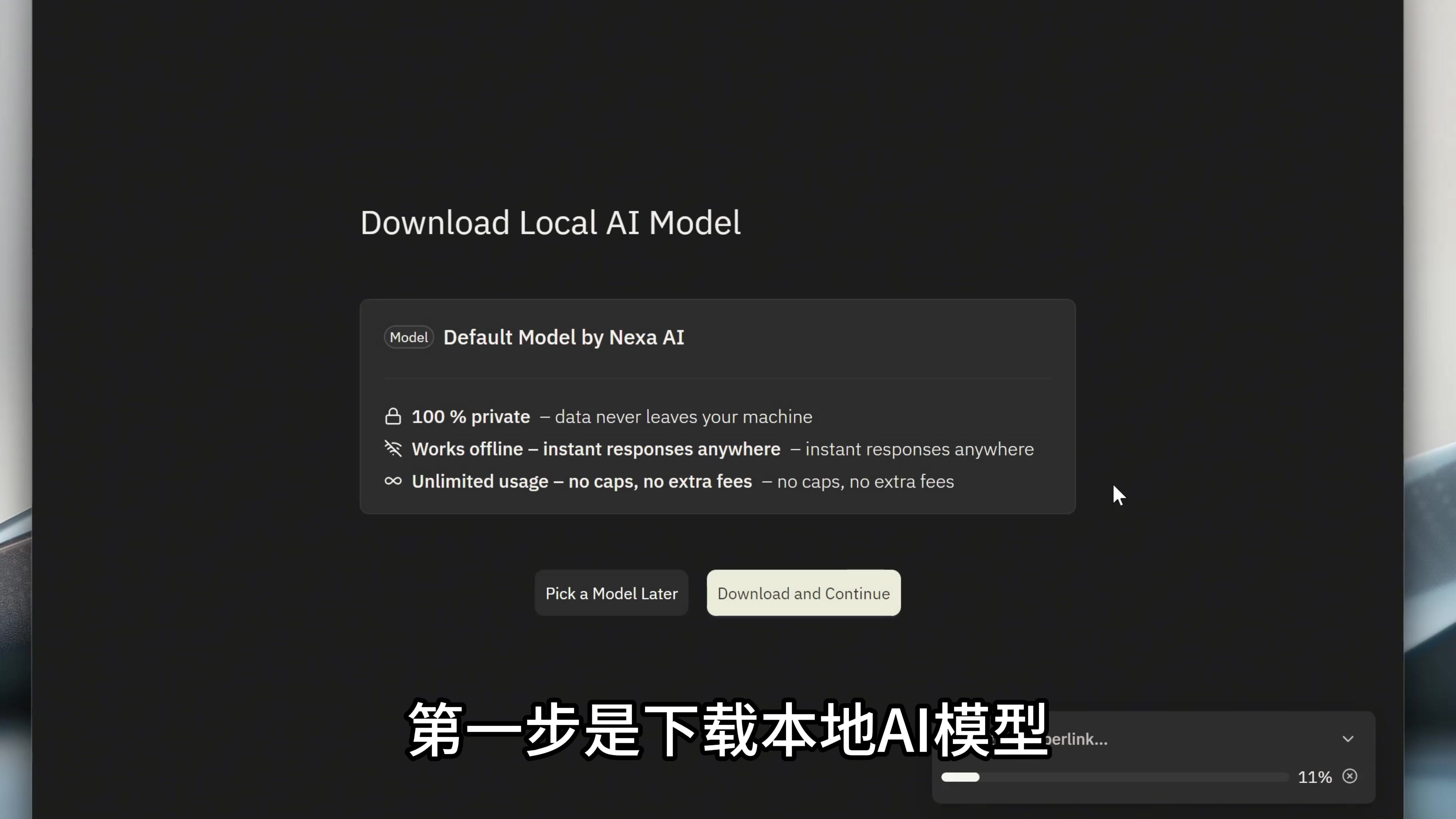

我们来到Hyperlink的官网,就是屏幕上这个地址,把软件下载一下。 因为要在本地运行大模型,独立显卡需要8GB的显存,集成显卡需要32GB的内存。这次我使用的设备,是搭载了AMD 锐龙 AI9 HX 370的电脑,这款芯片搭载的NPU,拥有50 TOPS的强大AI算力。下载完成以后,双击安装。进入软件以后,第一步是下载本地AI模型。

因为要在本地运行大模型,独立显卡需要8GB的显存,集成显卡需要32GB的内存。这次我使用的设备,是搭载了AMD 锐龙 AI9 HX 370的电脑,这款芯片搭载的NPU,拥有50 TOPS的强大AI算力。下载完成以后,双击安装。进入软件以后,第一步是下载本地AI模型。 这个产品安装后可以下载模型库里面支持的各种开源模型,最大甚至可以支持 gpt-oss-20b参数的模型。还有一些模型通过Nexa自研的NexaML,可以支持在部分AIPC上利用NPU进行模型推理,功耗更低的同时获得更好的推理性能,让你的AIPC真正释放算力潜力。

这个产品安装后可以下载模型库里面支持的各种开源模型,最大甚至可以支持 gpt-oss-20b参数的模型。还有一些模型通过Nexa自研的NexaML,可以支持在部分AIPC上利用NPU进行模型推理,功耗更低的同时获得更好的推理性能,让你的AIPC真正释放算力潜力。

建立知识库

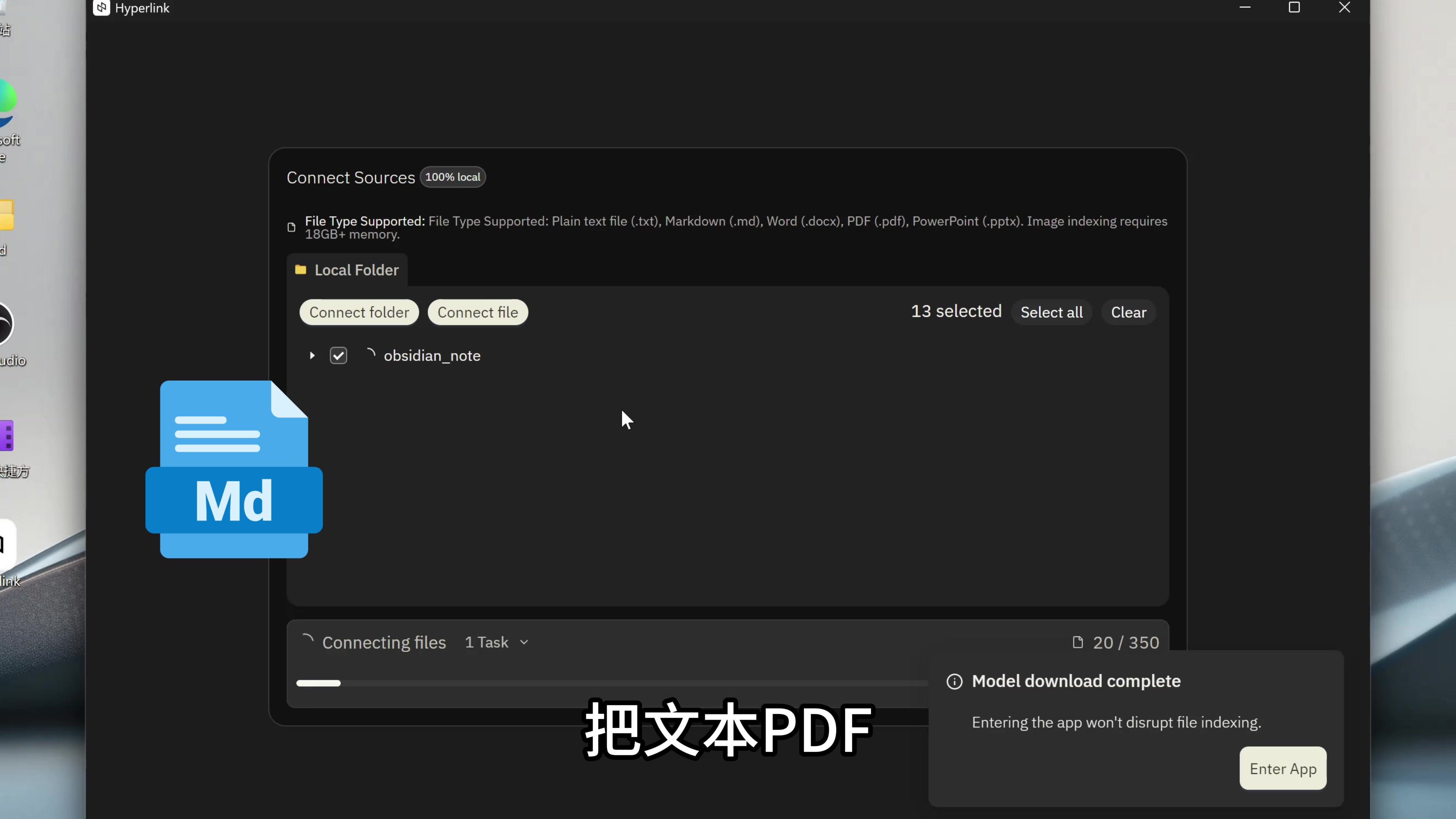

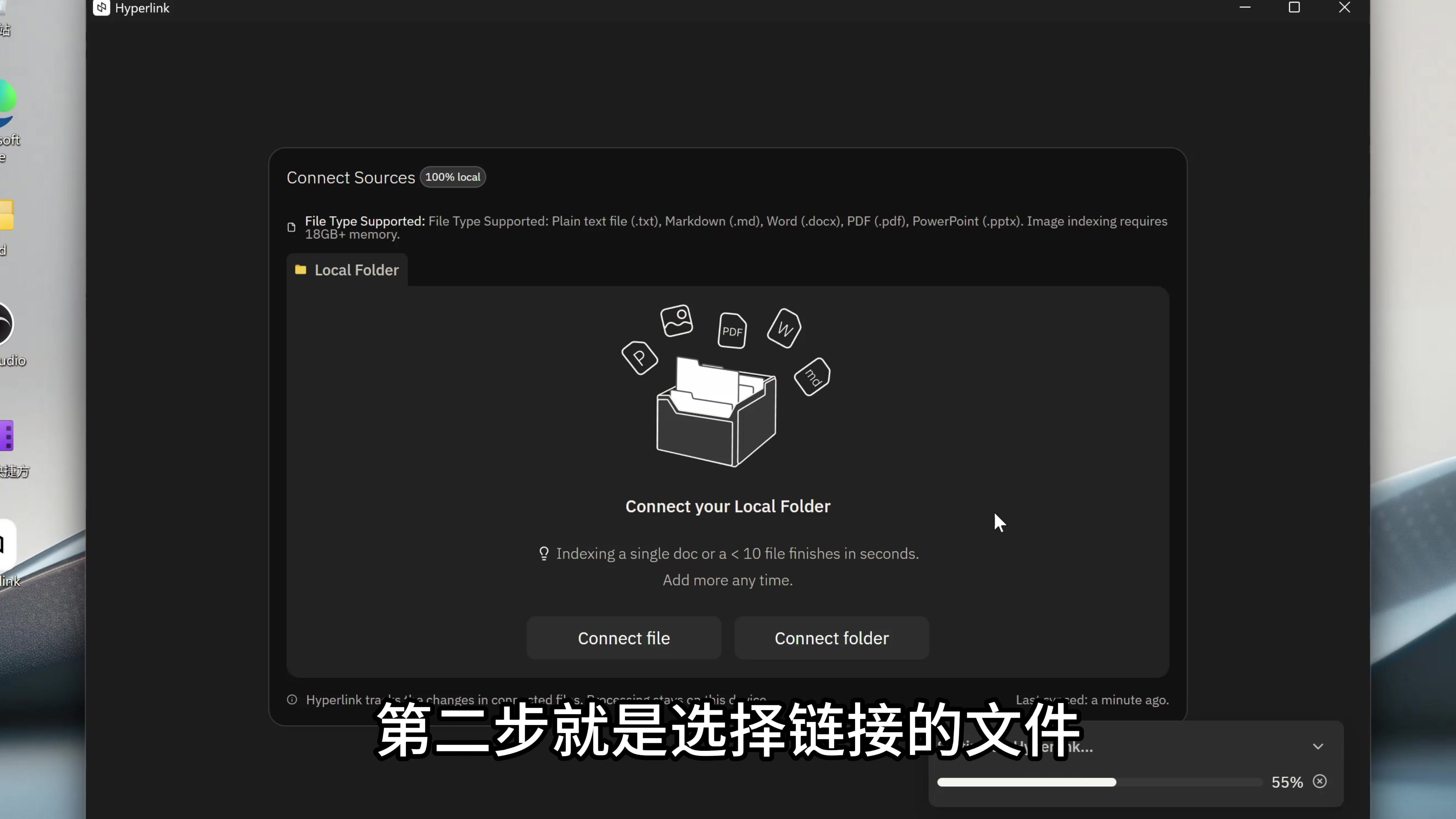

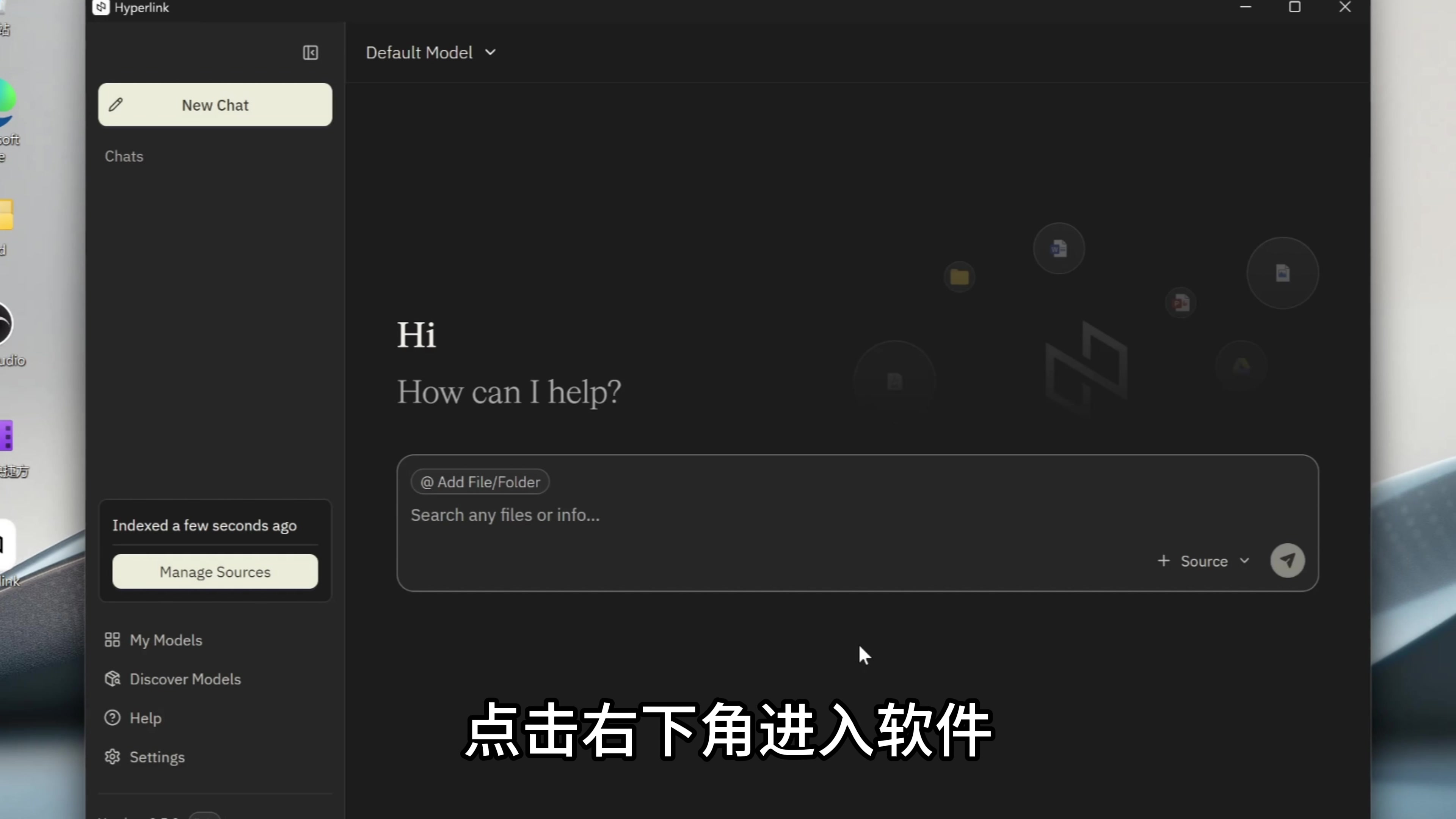

第二步就是选择链接的文件。 这里我选择obsidian_note文件夹,里面存储了我最近几年记录的所有知识类的笔记,我准备把这些笔记链接进Hyperlink,当做AI知识库使用。Hyperlink会为这些文件创建本地索引,文件夹里面所有新增/修改的文件,都会自动同步索引。文件索引、查找、整理答案,这些都是本地计算的,不会上传到任何云存储,保证了这些文件的私密性。Hyperlink管理的文件数量没有最大限制,一次可以索引几千个文件。索引完成,点击右下角进入软件。

这里我选择obsidian_note文件夹,里面存储了我最近几年记录的所有知识类的笔记,我准备把这些笔记链接进Hyperlink,当做AI知识库使用。Hyperlink会为这些文件创建本地索引,文件夹里面所有新增/修改的文件,都会自动同步索引。文件索引、查找、整理答案,这些都是本地计算的,不会上传到任何云存储,保证了这些文件的私密性。Hyperlink管理的文件数量没有最大限制,一次可以索引几千个文件。索引完成,点击右下角进入软件。

功能演示

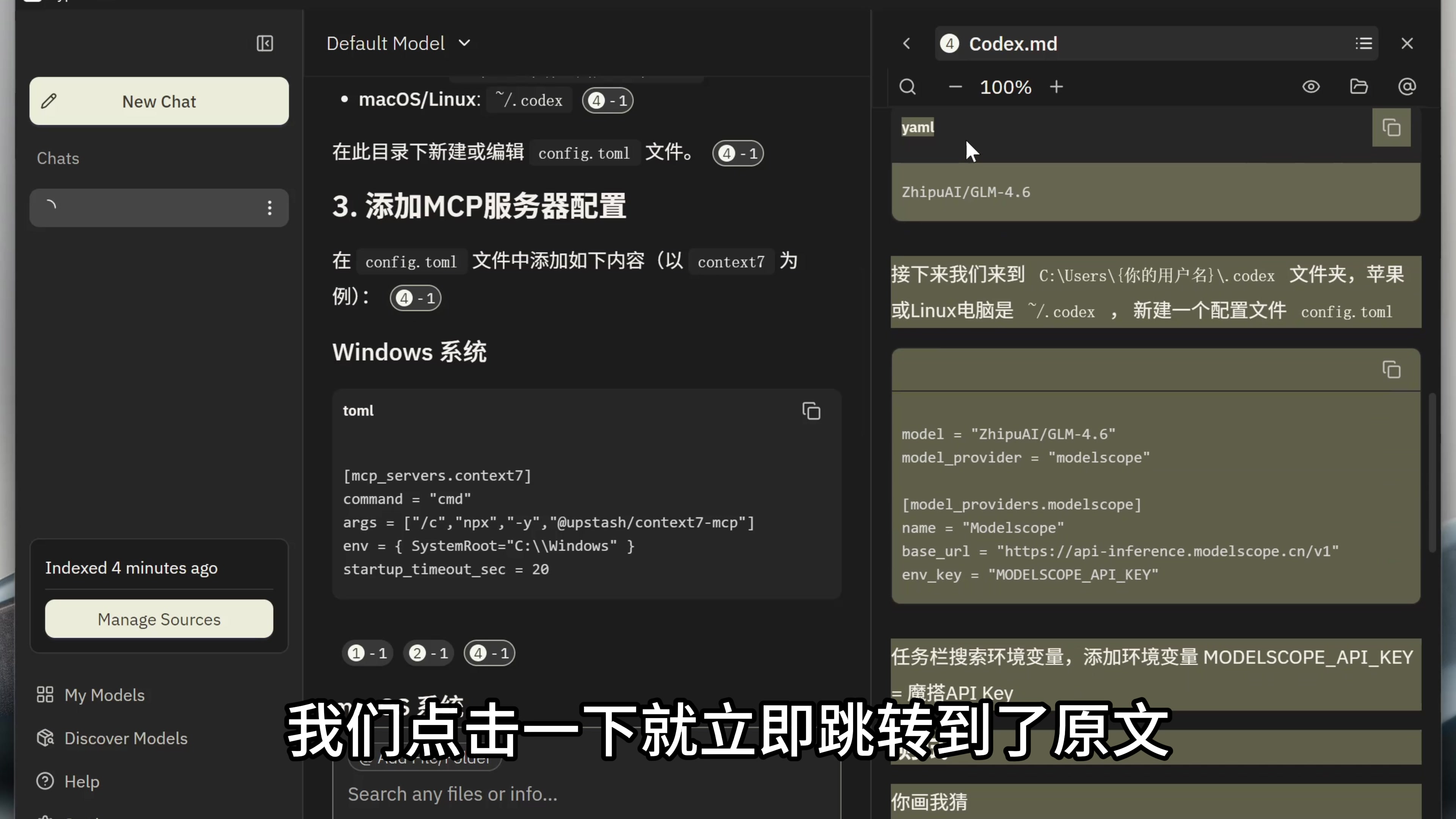

先在右下角,选中我们刚才链接的文件夹。 我的第一个问题是:“Codex怎么配置MCP?” 这里看到,Hyperlink成功检索到了我之前记录的笔记文案,并且输出了答案。在答案下面还有一个引用链接,我们点击一下就立即跳转到了原文。

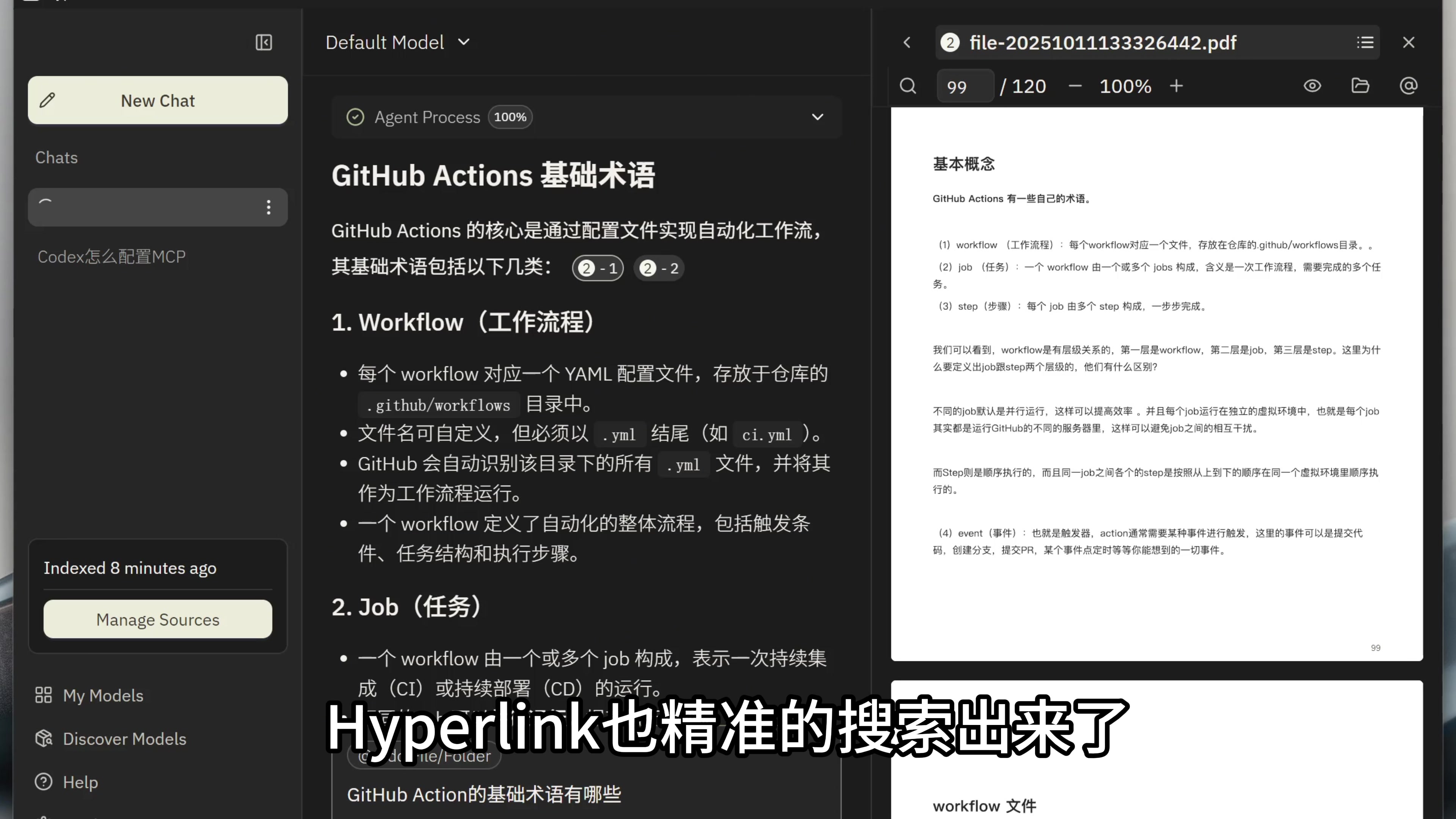

我的第一个问题是:“Codex怎么配置MCP?” 这里看到,Hyperlink成功检索到了我之前记录的笔记文案,并且输出了答案。在答案下面还有一个引用链接,我们点击一下就立即跳转到了原文。 除了能搜索Markdown格式的笔记,还可以检索Powerpoint与PDF格式的内容。我的下一个问题是:“Github Action的基本术语有哪些?” 这是我之前做过的一个视频课的教案,这个信息是存在一个PDF文档里面的,Hyperlink也精准的搜索出来了。

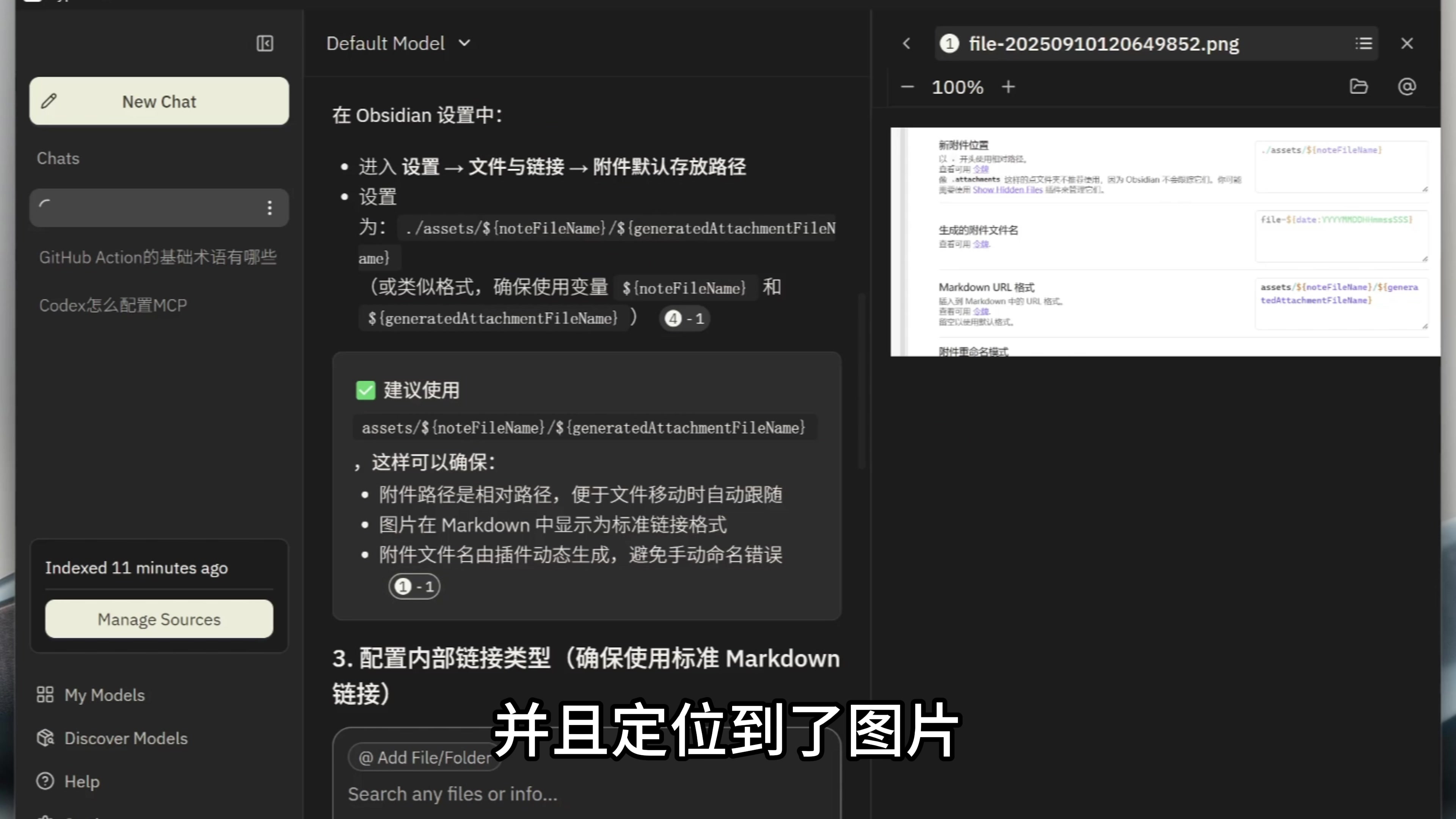

除了能搜索Markdown格式的笔记,还可以检索Powerpoint与PDF格式的内容。我的下一个问题是:“Github Action的基本术语有哪些?” 这是我之前做过的一个视频课的教案,这个信息是存在一个PDF文档里面的,Hyperlink也精准的搜索出来了。 Hyperlink也支持图片搜索,我的下一个问题是:“Obsidian的Custom Attach Location插件如何配置Markdown URL?” 这个信息是存在一个图片里面的,Hyperlink也成功进行了检索,并且定位到了图片。

Hyperlink也支持图片搜索,我的下一个问题是:“Obsidian的Custom Attach Location插件如何配置Markdown URL?” 这个信息是存在一个图片里面的,Hyperlink也成功进行了检索,并且定位到了图片。

自定义模型与NexaML框架

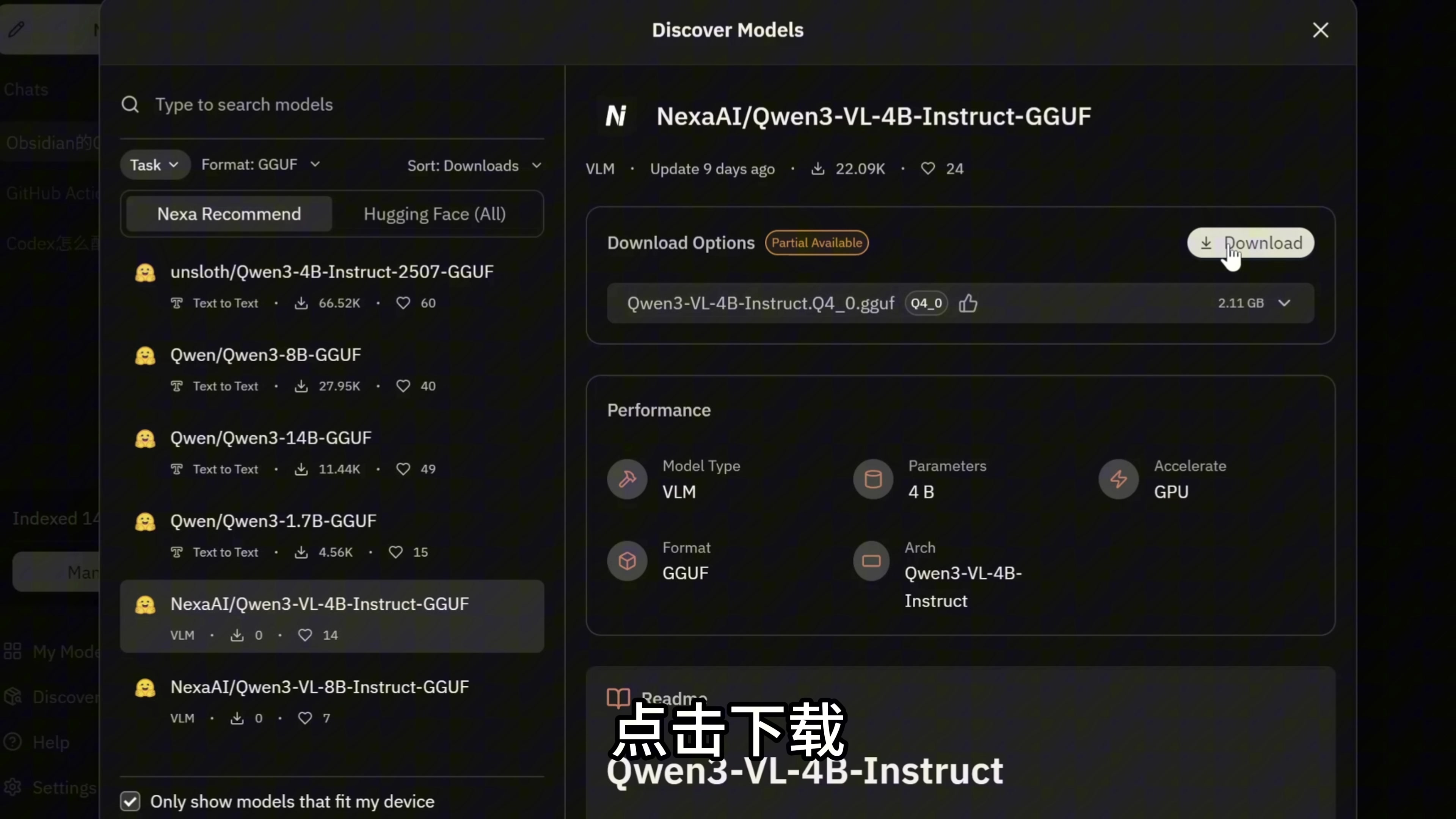

Hyperlink支持自己部署开源大模型,在左上角点击模型切换,我们就可以在HuggingFace上面下载自己喜欢的AI模型。 Hyperlink里内置了NexaML推理框架,这是一个比Ollama更强大的本地推理引擎,可以将端侧小模型高效部署在CPU、GPU、NPU等各类算力芯片上。NexaML针对NPU硬件进行了独特设计,能够尽可能地利用到市面上的NPU算力。在PC端、手机端、汽车座舱端、IoT端都可以使用该推理引擎。NexaML拥有在任何后端上支持任意模型的能力。比如说最近,Qwen团队推出了最强端侧多模态模型 Qwen3-VL-4B和8B,模型发布当天,Nexa团队就进行了首发的技术支持。目前还没有其他的本地AI推理框架支持Qwen3 VL 4B/8B,这个最强端侧多模态模型,NexaML是唯一的一个。通过NexaML,Qwen3模型目前可以通过一行代码就在PC上运行起来。如果您是开发者,可以使用Github上的开源项目 NexaSDK 来轻松使用NexaML框架,制作自己的本地AI APP。Hyperlink就是使用NexaSDK做的,并且NexaSDK是市面上最简单易用的端侧AI开发SDK。我们说回到Hyperlink,这里我选择Qwen3-VL-4B模型,点击下载。

Hyperlink里内置了NexaML推理框架,这是一个比Ollama更强大的本地推理引擎,可以将端侧小模型高效部署在CPU、GPU、NPU等各类算力芯片上。NexaML针对NPU硬件进行了独特设计,能够尽可能地利用到市面上的NPU算力。在PC端、手机端、汽车座舱端、IoT端都可以使用该推理引擎。NexaML拥有在任何后端上支持任意模型的能力。比如说最近,Qwen团队推出了最强端侧多模态模型 Qwen3-VL-4B和8B,模型发布当天,Nexa团队就进行了首发的技术支持。目前还没有其他的本地AI推理框架支持Qwen3 VL 4B/8B,这个最强端侧多模态模型,NexaML是唯一的一个。通过NexaML,Qwen3模型目前可以通过一行代码就在PC上运行起来。如果您是开发者,可以使用Github上的开源项目 NexaSDK 来轻松使用NexaML框架,制作自己的本地AI APP。Hyperlink就是使用NexaSDK做的,并且NexaSDK是市面上最简单易用的端侧AI开发SDK。我们说回到Hyperlink,这里我选择Qwen3-VL-4B模型,点击下载。 下载完成以后,就可以在Hyperlink里面切换到这个模型进行使用。

下载完成以后,就可以在Hyperlink里面切换到这个模型进行使用。

离线运行验证

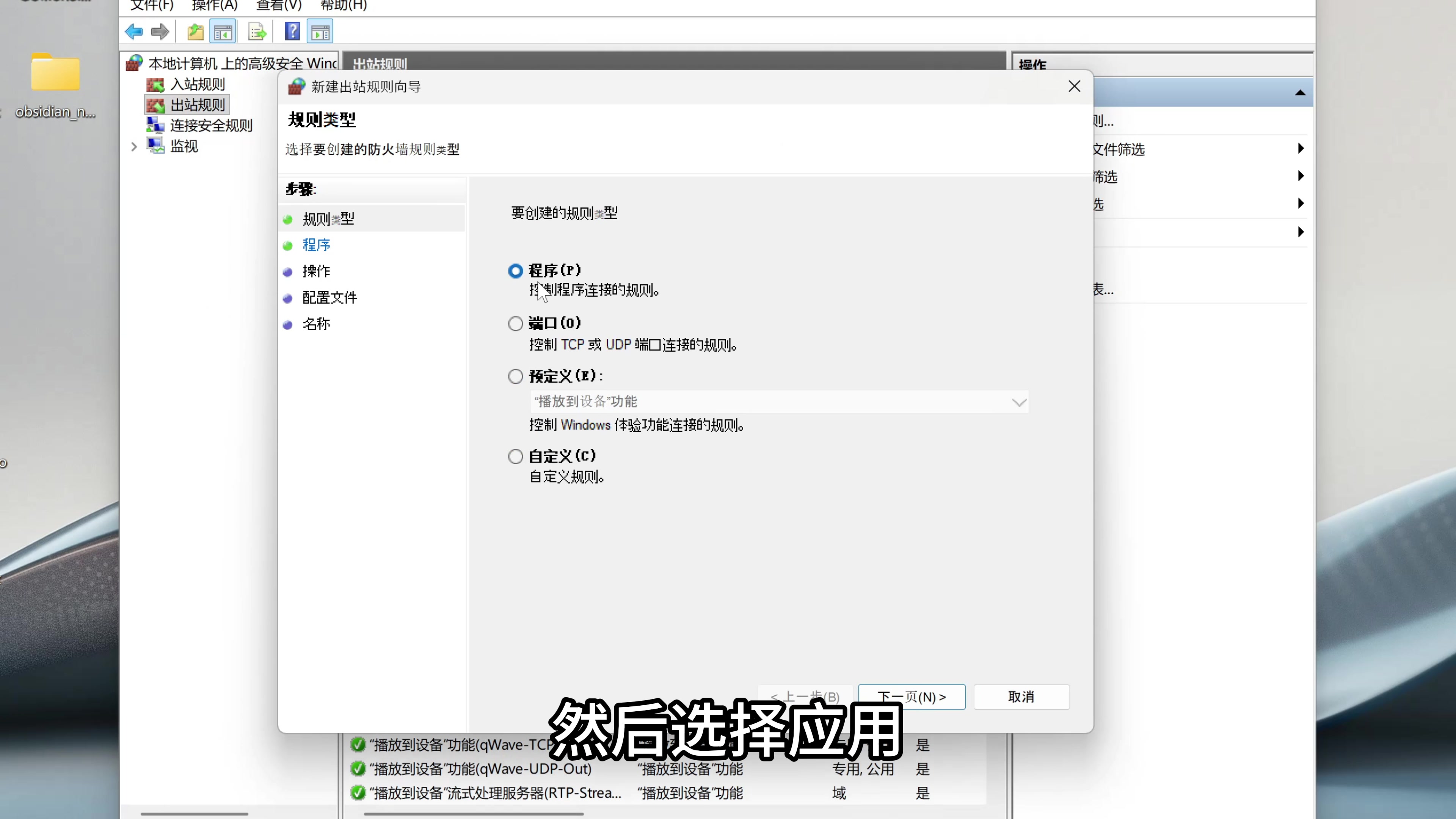

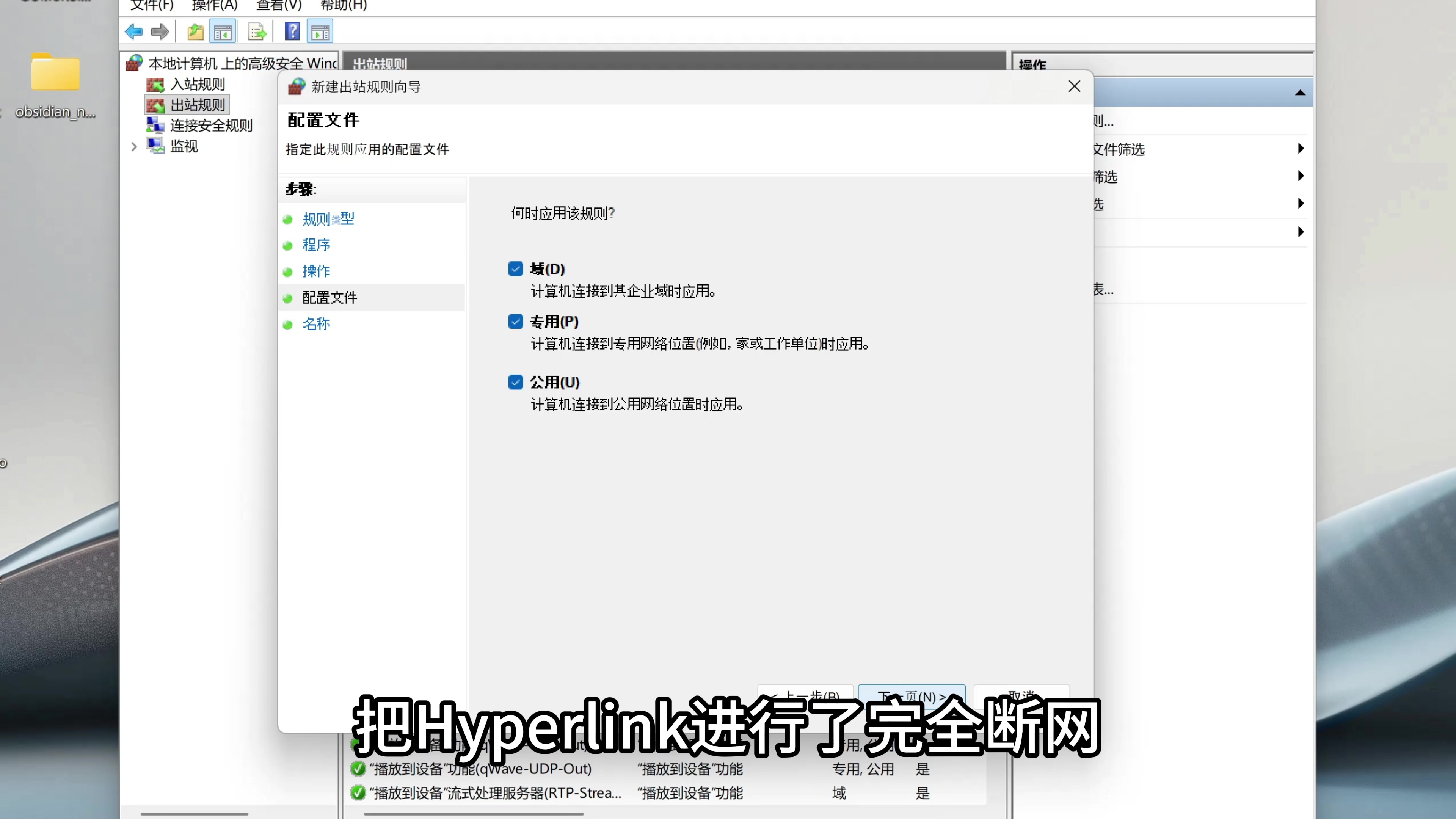

我们来做一个实验,看看Hyperlink是否真的百分百离线运行。我们在搜索栏搜索Windows防火墙,在出站规则这里选择新建出站规则,然后选择应用。 在程序上面,这里我把Hyperlink的启动程序填进去,这样我们就在操作系统层面把Hyperlink进行了完全断网。

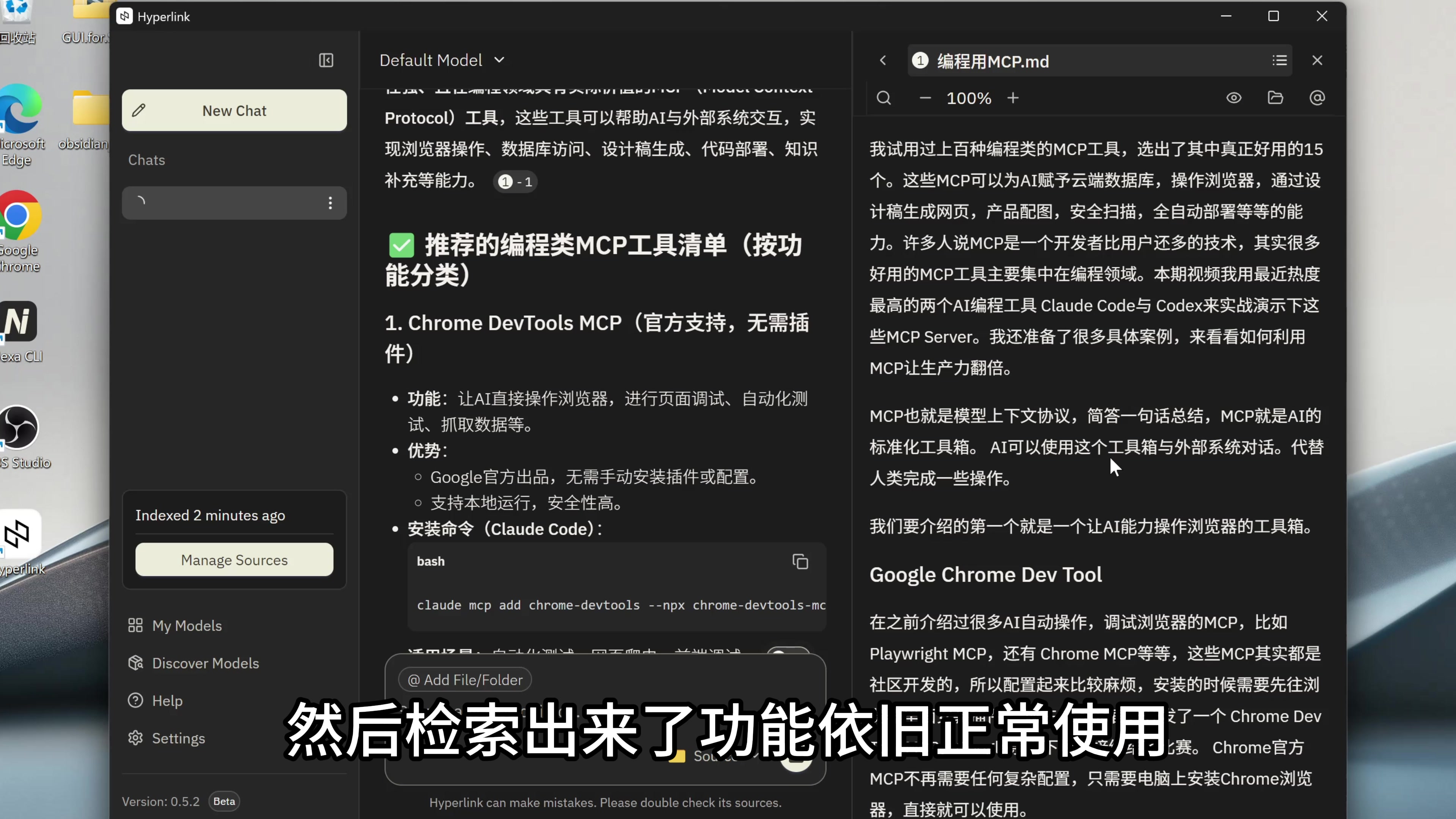

在程序上面,这里我把Hyperlink的启动程序填进去,这样我们就在操作系统层面把Hyperlink进行了完全断网。 回到软件我们来测试一下,这里我进行一下文件索引,然后我问AI:“编程类的好用的MCP有哪些?” 这里AI在文件里面查找到了上期视频的文案,然后检索出来了,功能依旧正常使用。

回到软件我们来测试一下,这里我进行一下文件索引,然后我问AI:“编程类的好用的MCP有哪些?” 这里AI在文件里面查找到了上期视频的文案,然后检索出来了,功能依旧正常使用。 这就验证了,Hyperlink是可以完全离线正常工作的。

这就验证了,Hyperlink是可以完全离线正常工作的。

好,这就是本期视频的全部内容,感谢大家点赞支持,我们下期再见。

918

918

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?