在数字经济蓬勃发展的当下,计算资源的高效利用成为企业和开发者关注的核心命题。微擎面板凭借其在云原生管理领域的卓越性能,与 GPU 虚拟化技术深度融合,尤其是借助 HAMi 项目的强大支持,为复杂计算场景提供了高效、灵活的解决方案。本文将深入剖析这一技术组合的底层逻辑、实现方式及应用价值。

一、微擎面板:云原生管理的基石

微擎面板 [1](W7Panel)是基于 Kubernetes 的云原生控制面板,只需一键脚本,5 分钟内即可在 2 核 4G 以上 Linux 服务器完成部署,支持Docker、Helm 等多元部署方式,适配全开发语言与运行环境,能快速部署各类 Web 系统,依托微擎应用市场,应用生态丰富。

二、GPU 虚拟化:计算资源优化的核心

GPU 虚拟化技术借助软件层面的精心架构,突破了传统模式下 GPU 资源只能被单个应用独占的束缚。以 HAMI 为代表的前沿技术,进一步拓展了 GPU 虚拟化的优势。它不仅支持在同一物理 GPU 上并行运行多个虚拟机实例,各实例均可独立调用 GPU 资源,实现图形渲染、AI 计算、科学模拟等复杂任务的高效处理与安全隔离访问;而且能够根据不同应用负载的实时需求,动态分配 GPU 资源,极大提升资源利用率,降低成本。即使面对高并发、多样化的任务场景,GPU 虚拟化也能确保每个任务流畅运行,满足企业对高性能计算的严苛要求 。

三、HAMi 项目:GPU 虚拟化的技术桥梁

HAMi [2] (Heterogeneous AI Computing Virtualization Middleware)原名为 k8s-vGPU-scheduler,是一款 “all-in-one” Chart,用于管理 k8s 集群中的异构 AI 计算设备。它实现了设备共享与资源隔离,提升了集群中异构计算设备的使用率,并提供统一的复用接口。

在设备虚拟化方面,HAMi 支持 GPU、MLU、NPU 等设备虚拟化,可灵活实现设备共享与资源隔离。其设备共享模式多样,能按核心或内存分配,也能设置硬限制,无需修改现有程序,还具备动态迁移功能。资源隔离上,HAMi 在容器内实现硬隔离,避免任务间资源干扰。同时,HAMi 兼容英伟达 GPU、华为昇腾 NPU、海光 DCU 等设备,通过统一监控和调度策略进行管理,降低多设备管理成本。

HAMi 具有开放性和中立性,由多方联合发起,遵循 CNCF 开放治理,避免供应商锁定,可与主流云提供商集成。目前,HAMi 已在 50 余家企业和机构落地,覆盖多个行业,助力实现计算资源的高效管理与利用。

四、微擎面板与 GPU 虚拟化的深度融合实践

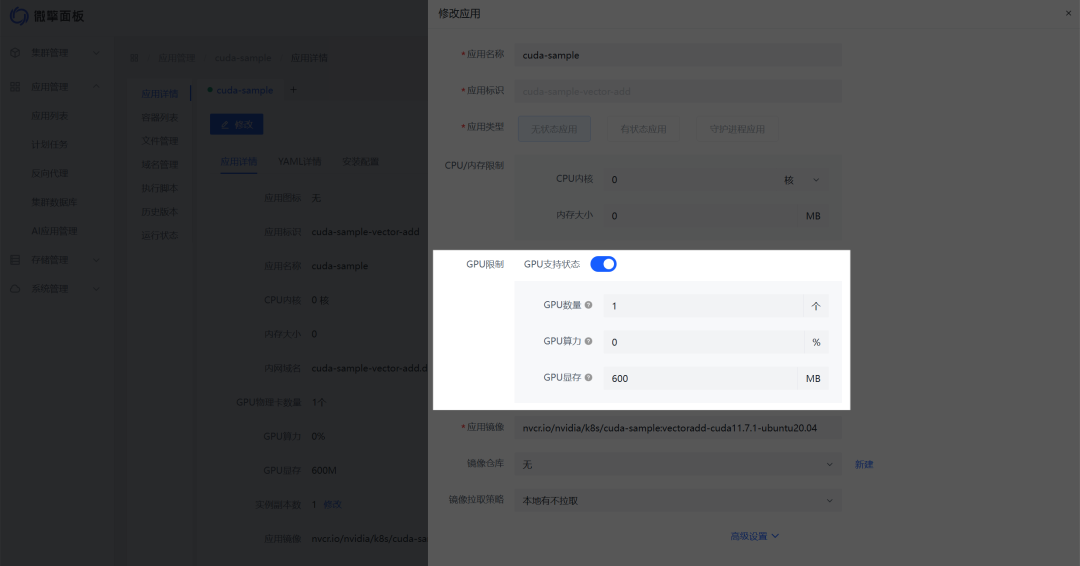

在微擎面板中集成 HAMi 实现 GPU 虚拟化,为对图形处理和计算能力要求极高的场景提供强大支持。用户可在微擎面板的节点管理页面查看服务器 GPU 资源状态,并依据应用需求灵活调配。在应用管理中,部署对 GPU 性能有要求的应用时,可在详情页指定 GPU 资源数量和类型,微擎面板结合 HAMi 自动完成资源分配,确保应用充分发挥 GPU 性能。如何在微擎面板中安装使用,下面是演示步骤:

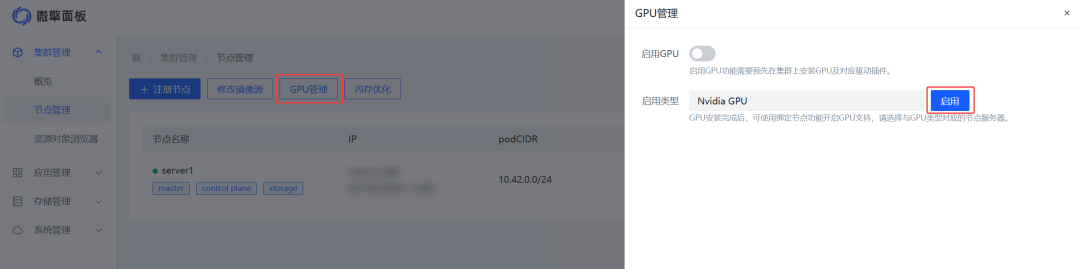

1,进入节点管理,找到GPU管理入口

2,选择显卡类型后,点击启用,此时会弹出驱动安装界面

3,安装完成后,在应用管理的应用列表页会出现两个应用,全为绿色状态即为安装成功

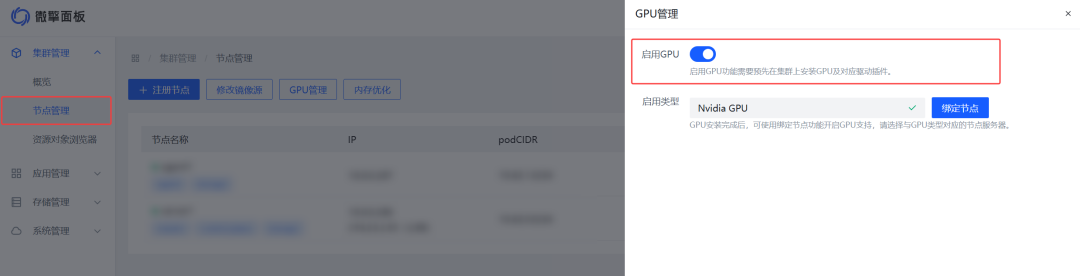

4,此时在GPU管理页面,打开启用GPU

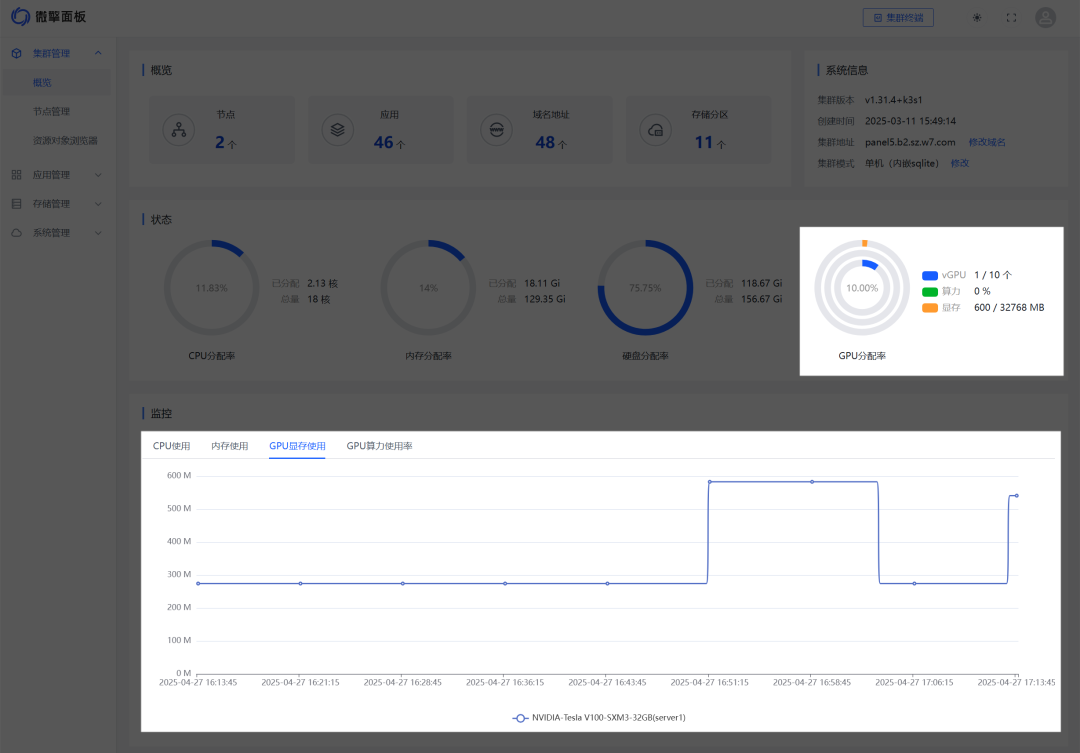

启用后,可在概览页面看到关于GPU的监控统计数据,在应用管理页面会看到GPU相关的配置设置,默认情况下一块物理GPU会被虚拟化为10块vGPU,可以支持十个应用实例同时占用一块GPU处理任务,每个任务可分配不同显存大小,总显存不超过物理GPU的显存即可。

五、总结

微擎面板与基于 HAMi 的 GPU 虚拟化技术相结合,在计算资源管理领域展现出一定优势。微擎面板部署便捷,具备云原生管理能力,HAMi 能够对 GPU 资源进行精细调度与高效隔离,两者搭配为企业和开发者提供了一套较为灵活且高效的解决方案。这种结合在一定程度上提升了计算效率,降低了资源管理成本,有助于各类复杂计算任务的顺畅运行。

6021

6021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?