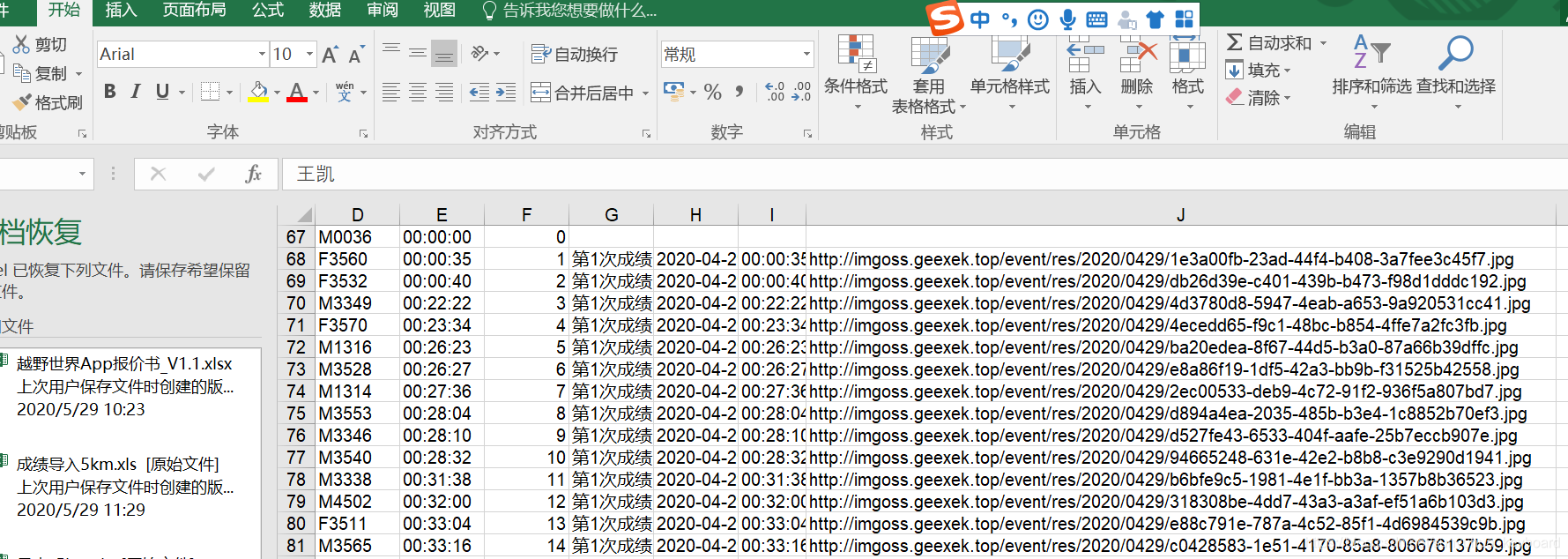

下载到excel中的图片,没办法直接查看,是一个链接地址,现在需要一个工具,将图片下载到本地,便于查看。

直接上python代码

import xlrd

import requests

import logging

a = xlrd.open_workbook('名单.xls', 'r') # 打开.xlsx文件

sht = a.sheets()[0] # 打开表格中第一个sheet

row1 = sht.row_values(1)

# 设置要下载的图片的范围,对应于 Excel 中的行数

start = 1

#获取excel

nrows = sht.nrows;

for i in range(start, nrows):

url = sht.cell(i, 9).value # 依次读取每行第十列的数据,也就是 URL

if url:

logging.info(url)

f = requests.get(url)

roadName=sht.cell(i,2).value

markNo=sht.cell(i, 3).value

ii = str(roadName)+"_"+markNo # 按照下载顺序(行号)构造文件名

url2 = url[-3:] # 根据链接地址获取文件后缀,后缀有.jpg 和 .gif 两种

dir = ii + "." + url2 # 构造完整文件名称

with open(dir, "wb") as code:

code.write(f.content) # 保存文件

print(url) # 打印当前的 URL

jindu = (i - start) / (nrows - start) * 100 # 计算下载进度

print("下载进度:", jindu, "%") # 显示下载进度

本文介绍了一款使用Python编写的工具,能够从Excel文件中批量下载图片链接,并将其保存到本地。通过解析Excel表格,该工具可以读取指定列的图片URL,按顺序下载并保存图片,同时显示下载进度。

本文介绍了一款使用Python编写的工具,能够从Excel文件中批量下载图片链接,并将其保存到本地。通过解析Excel表格,该工具可以读取指定列的图片URL,按顺序下载并保存图片,同时显示下载进度。

1638

1638