命名实体识别(Named Entity Recognition,简称NER),又称作“专名识别”,任务是识别出待处理文本中三大类(实体类、时间类和数字类)、七小类(人名、机构名、地名、时间、日期、货币和百分比)命名实体。

通常包括两部分:(1)实体边界识别;(2) 确定实体类别(人名、地名、机构名或其他)。

英语中的命名实体具有比较明显的形式标志(即实体中的每个词的第一个字母要大写),所以实体边界识别相对容易,任务的重点是确定实体的类别。和英语相比,汉语命名实体识别任务更加复杂,而且相对于实体类别标注子任务,实体边界的识别更加困难。

Abstract

本文提出了一系列基于长短期记忆(LSTM) 的序列标注模型,包括LSTM,bidirectional LSTM(BI-LSTM),LSTM-CRF,BI-LSTM-CRF。我们的工作是首次将双向的LSTM CRF(简称BI-LSTM-CRF)模型应用于NLP基准序列标记数据集。与以前的观测相比,该方法具有较强的鲁棒性,对嵌入词的依赖性较小。

1. Introduction

序列标注 包括词性标注、分块和命名实体识别(NER),是一项经典的自然语言处理任务。

现有的序列标记模型大多为线性统计模型,包括隐马尔可夫模型(HMM)、最大熵马尔可夫模型(MEMMs) 和条件随机场(CRF)。

基于卷积网络的模型用来解决序列标记问题,将这种模型称为Conv-CRF,因为它由卷积网络和输出的CRF层(原论文使用了句子级loglikelihood (SSL)这个术语)组成。

在语音语言理解领域,提出了基于递归神经网络和卷积网络的语音理解模型。

其他相关工作包括提出了一种用于语音识别的双向递归神经网络。

本文提出了各种基于神经网络的序列标记任务模型,包括LSTM网络、双向LSTM网络(BI-LSTM)、带CRF层的LSTM网络(LSTM-CRF)和带CRF层的双向LSTM网络(BI-LSTM-CRF)。工作总结:

1)系统比较了上述模型在NLP标记数据集上的性能;

2)首次将双向LSTM CRF(简称BI-LSTM-CRF)模型应用于NLP基准序列标记数据集。由于具有双向LSTM组件,该模型可以使用过去和未来的输入特性。此外,由于有CRF层,该模型可以使用句子级标签信息。模型可以在POS、分块和NER数据集上产生最先进(或接近)的精确性;

3)证明了BI-LSTMCRF模型是健壮的,与之前的观察相比,它对单词嵌入的依赖性更小。它不需要依靠嵌入词就可以产生精确的标注性能。

2. Models

2.1 LSTM Networks

循环神经网络(RNN) 在语言模型和语音识别等方面取得了良好的效果。一个RNN维持了一个基于历史信息的记忆单元,使模型能够根据长距离特征预测当前输出。

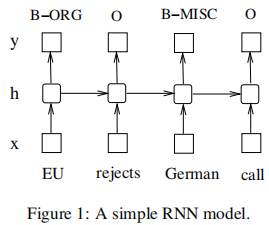

如图1,其中输入层为x,隐含层为h,输出层为y。在命名实体标签上下文中,x代表输入特征,y代表标签。一个命名实体识别系统,其中每个单词都被标记为其他(O)或四种实体类型之一:Person (PER)、Location (LOC)、Organization (ORG)和杂类(MISC)。句子:EU rejects German call to boycott British lamb. 标记为B-org O B-misc O O O B-misc O O O,其中B-、I-标记表示实体的起始位置和中间位置。

输入层表示t时刻的特征,可以是对单词特征、密集向量特征或稀疏特征进行一次独热编码one-hot-encoding。输入层的维数与特征维度相同。输出层表示t时刻在标签上的概率分布,它与标签具有相同的维度。

与前馈网络相比,RNN引入了前隐状态与当前隐状态之间的联系(从而引入了递归层权值参数)。这个循环层用于存储历史信息。隐藏层和输出层的值计算如下:

h(t) = f(Ux(t) + Wh(t-1)); (1)

y(t) = g(Vh(t)); (2)

其中U、W、V为训练时需要计算的连接权值,f(z)、g(z)为sigmoid、softmax激活函数,如下所示 :

f ( z ) = 1 1 + e − z g ( z m ) = e z m ∑ k e z k \begin{aligned} f(z) &=\frac{1}{1+e^{-z}} \\ g\left(z_{m}\right) &=\frac{e^{z_{m}}}{\sum_{k} e^{z_{k}}} \end{aligned} f(z)g(zm)=1+e−z1=∑kezkezm

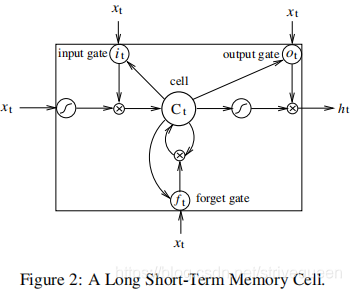

本文应用了 长短期记忆LSTM 到序列标记。除了隐藏层更新被专门构建的记忆单元所替代之外,长期和短期内存网络与RNN是相同的。因此,他们可能更善于发现和利用数据中的长期依赖关系。如图2所示为单个LSTM记忆单元:

LSTM记忆单元 实现如下:

i t = σ ( W x i x t + W h i h t − 1 + W c i c t − 1 + b i ) f t = σ ( W x f x t + W h f h t − 1 + W c f c t − 1 + b f ) c t = f t c t − 1 + i t tanh ( W x c x t + W h c h t − 1 + b c ) o t = σ ( W x o x t + W h o h t − 1 + W c o c t + b o ) h t = o t tanh ( c t ) \begin{aligned} i_{t} &=\sigma\left(W_{x i} x_{t}+W_{h i} h_{t-1}+W_{c i} c_{t-1}+b_{i}\right) \\ f_{t} &=\sigma\left(W_{x f} x_{t}+W_{h f} h_{t-1}+W_{c f} c_{t-1}+b_{f}\right) \\ c_{t} &=f_{t} c_{t-1}+i_{t} \tanh \left(W_{x c} x_{t}+W_{h c} h_{t-1}+b_{c}\right) \\ o_{t} &=\sigma\left(W_{x o} x_{t}+W_{h o} h_{t-1}+W_{c o} c_{t}+b_{o}\right) \\ h_{t} &=o_{t} \tanh \left(c_{t}\right) \end{aligned} itftc

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2117

2117

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?