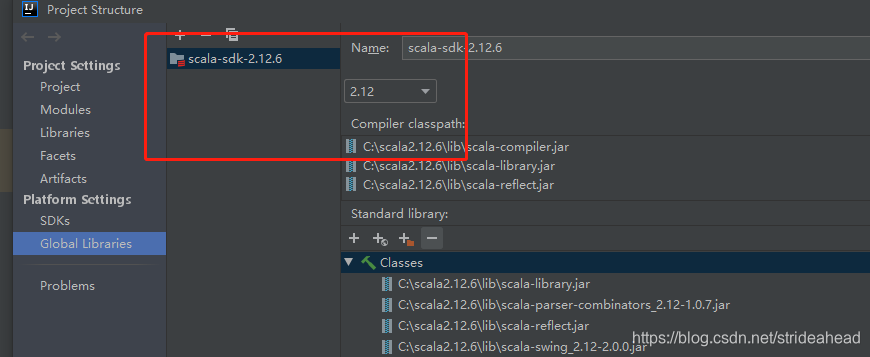

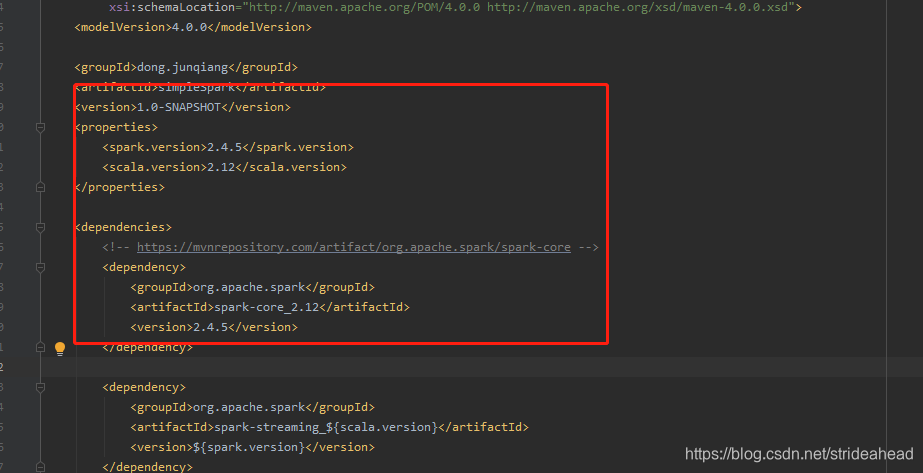

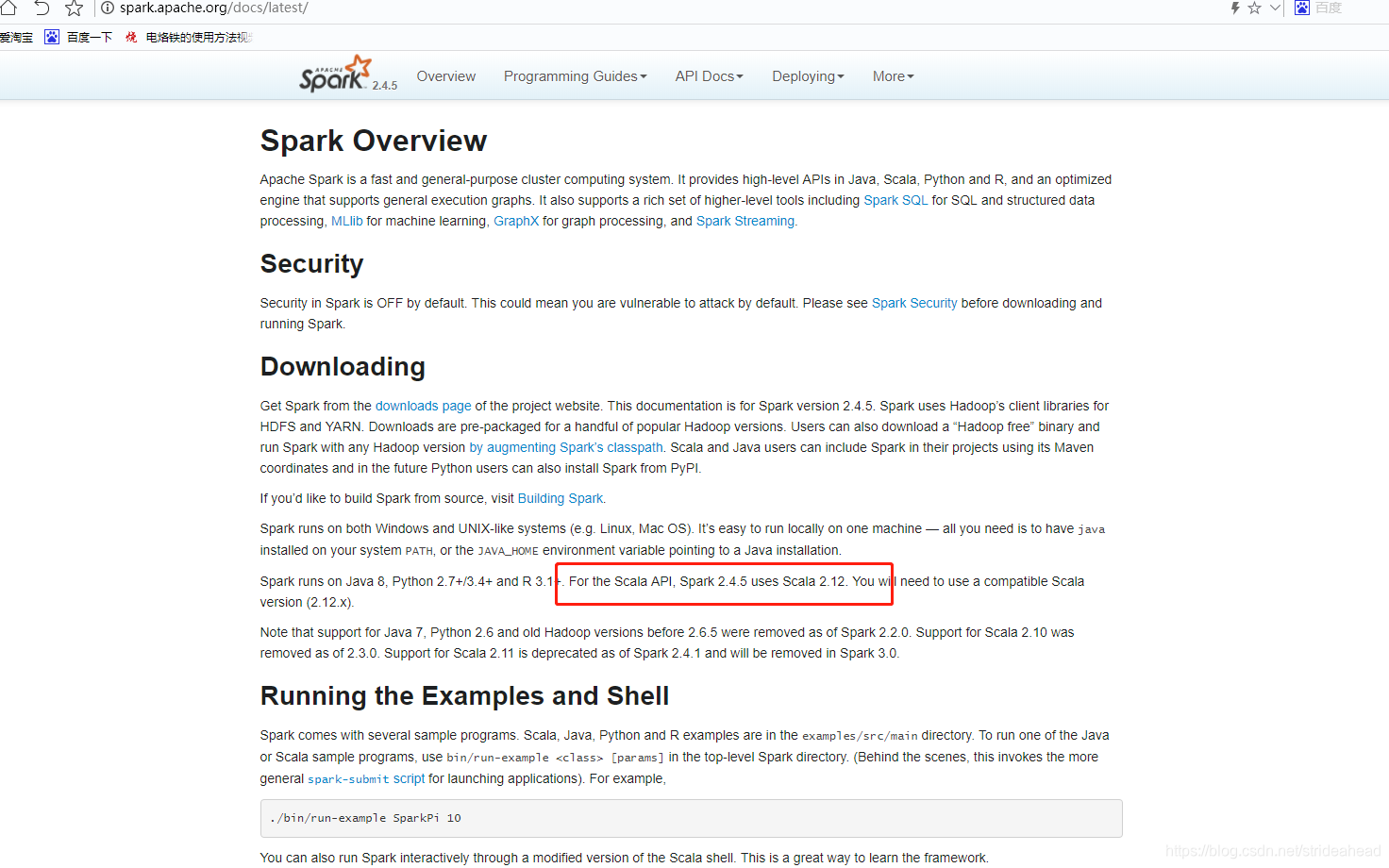

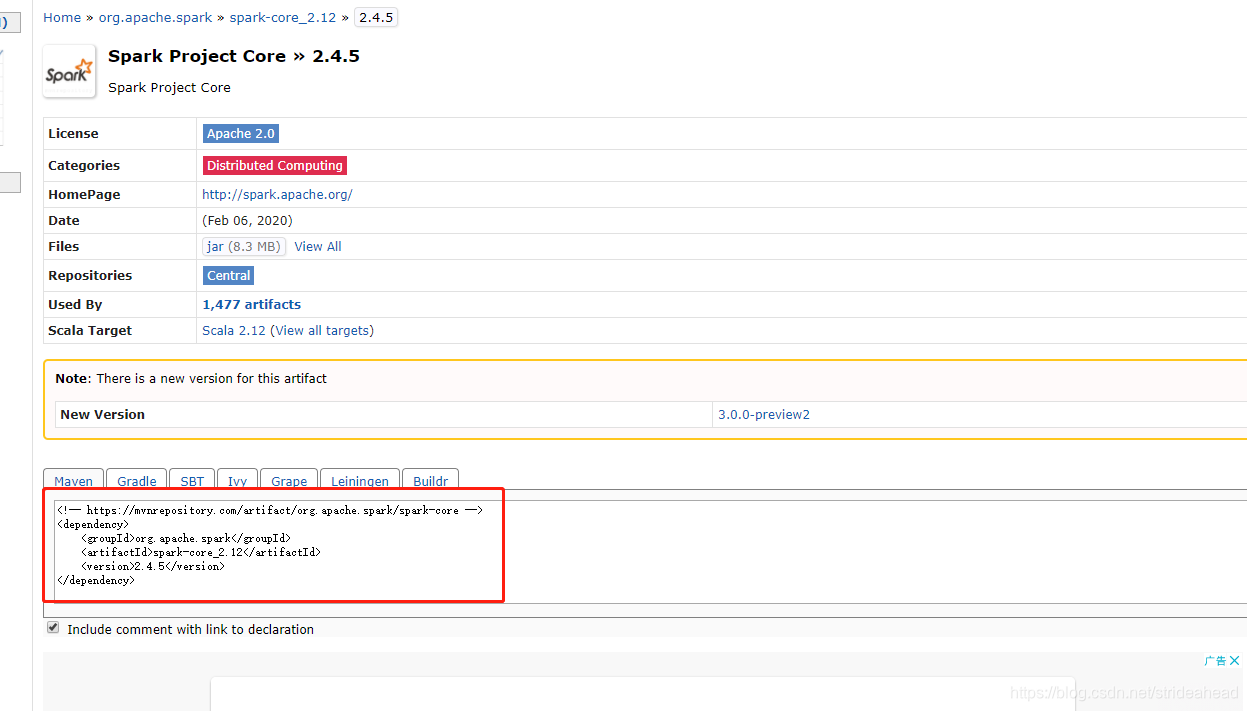

spark和scala版本一定要适配,

https://mvnrepository.com/

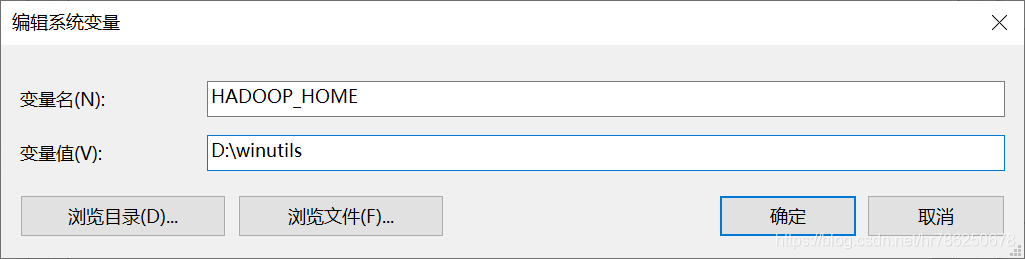

cala运行异常Could not locate executable null\bin\winutils.exe in the Hadoop binaries

出现这个问题的原因是我们在windows上模拟开发环境,但并没有真正的搭建hadoop和spark

解决办法:当然也并不需要我们真的去搭建hadoop

下载这个winutils:链接:https://pan.baidu.com/s/12o-QubOX2B5RdFYYXUG4Ag 提取码:951p 复制这段内容后打开百度网盘手机App,操作更方便哦

放到任意的目录下,我这里是放到了D:\winutils\bin

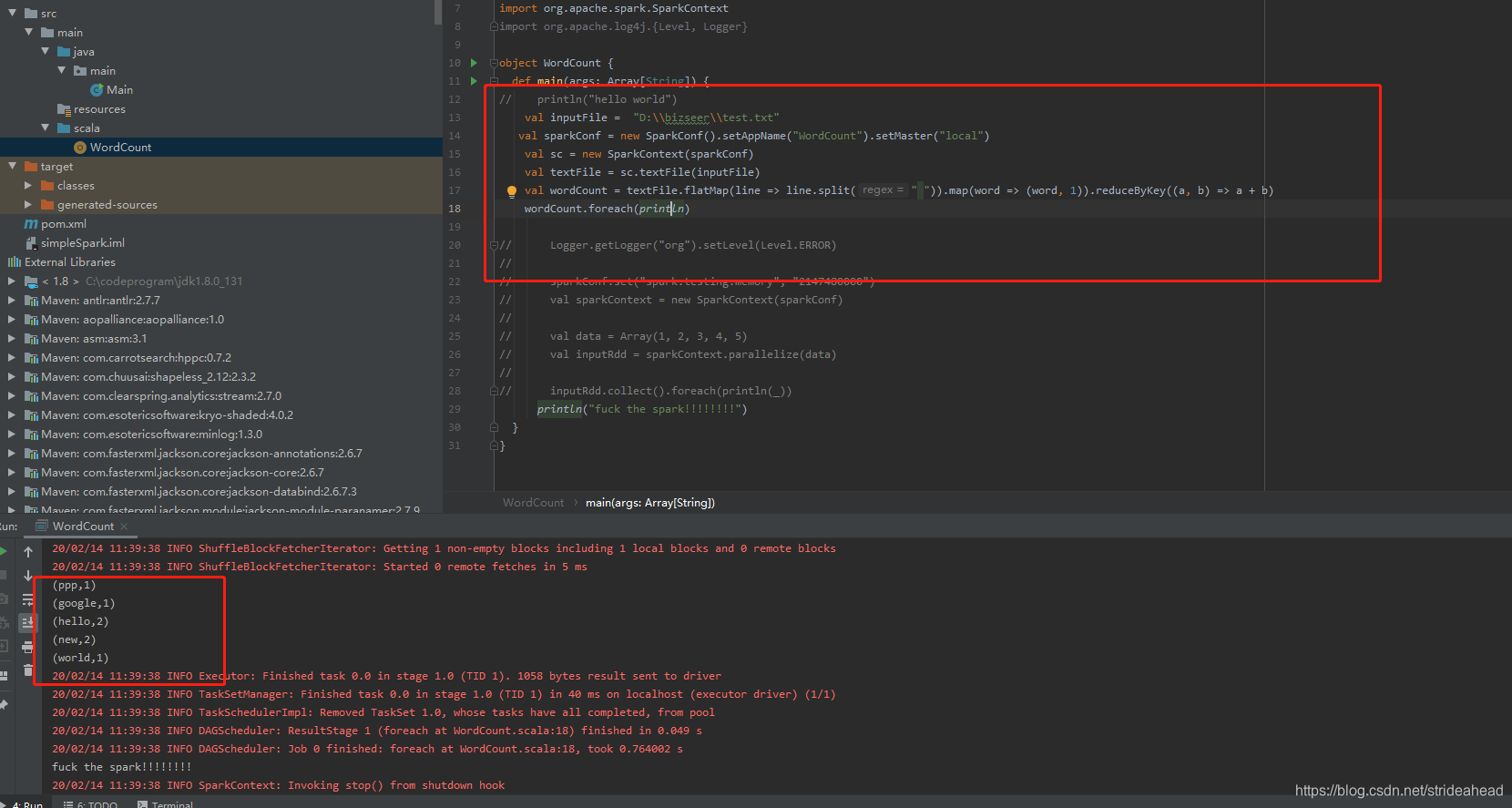

本文详细介绍了在Windows环境下配置Spark开发环境时遇到的常见问题——找不到winutils.exe的解决方案。通过下载并正确放置winutils工具,可以避免因缺少Hadoop二进制文件导致的错误,确保Spark和Scala版本适配,从而顺利进行大数据处理任务。

本文详细介绍了在Windows环境下配置Spark开发环境时遇到的常见问题——找不到winutils.exe的解决方案。通过下载并正确放置winutils工具,可以避免因缺少Hadoop二进制文件导致的错误,确保Spark和Scala版本适配,从而顺利进行大数据处理任务。

6249

6249

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?