Hadoop伪分布式集群搭建

基于大电脑配置问题,在这里给他家分享一下伪分布式集群搭建的配置方式本文内容仅仅只是为了配置比较低的电脑来完成分布式集群搭建的学习

前提:

1. 虚拟机网络配置

2. 修改主机名为:hadoop100

3. 还有配置主机名和IP的映射关系(便于使用主机名访问虚拟机)

4.关闭防火墙 service iptables stop;chkconfig iptables off

5. 虚拟机上必须配置JDK

第一步:

下载Hadoop地址 https://archive.apache.org/dist/hadoop/common/hadoop-2.6.4/

用文件传输工具或者其他方式将hadoop-2.6.4.tar.gz导入/usr/local/ 这个路径下

进入/usr/local文件加下 解压hadoop文件

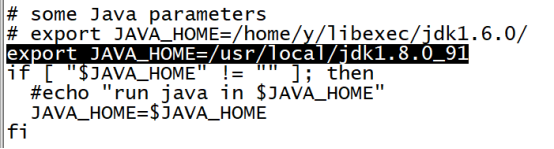

第二步:配置环境变量

vi /etc/profile文件 添加变量

添加完成后 执行命令(一定要执行)

source /etc/profile

第三步:(配置文件较多,请按照顺序严格配置)

修改/usr/local/hadoop-2.6.4/etc/hadoop文件夹下的配置文件

1.修改Hadoop-env.sh

2.修改core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop100:9000</value> //这里的hadoop100就是你的主机名后面的端口号不要乱改

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.6.4/data/tmp</value>

</property>

3.修改hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>默认副本数是3个 量力而行

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop100:50090</value>

</property>

4.修改Yarn-env.sh

5.配置Yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop100</value>

</property>

6.配置mapred-env.sh

7.Mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

8.Slaves

第四步:设置免密码登录

1.执行命令

ssh-keygen -t rsa 不断回车

2.复制

ssh-copy-id hadoop100

3.验证

ssh hadoop100

第五步:格式化文件系统(切记只执行一次,执行两次会出问题)

执行hadoop namenode -format

第六步:启动

start-dfs.sh

第七步:验证

3657

3657

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?