问题一:spark 提交任务时,在resourcemanager上提交任务能执行,在其他机器上提交不了

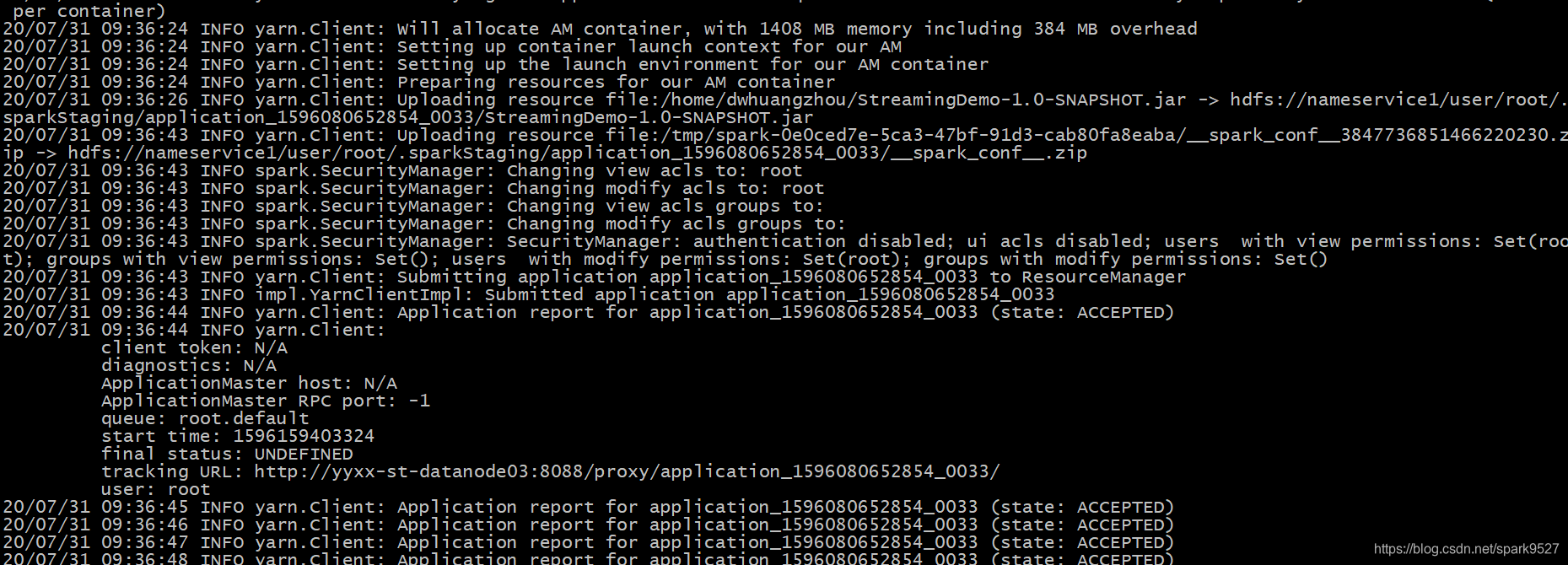

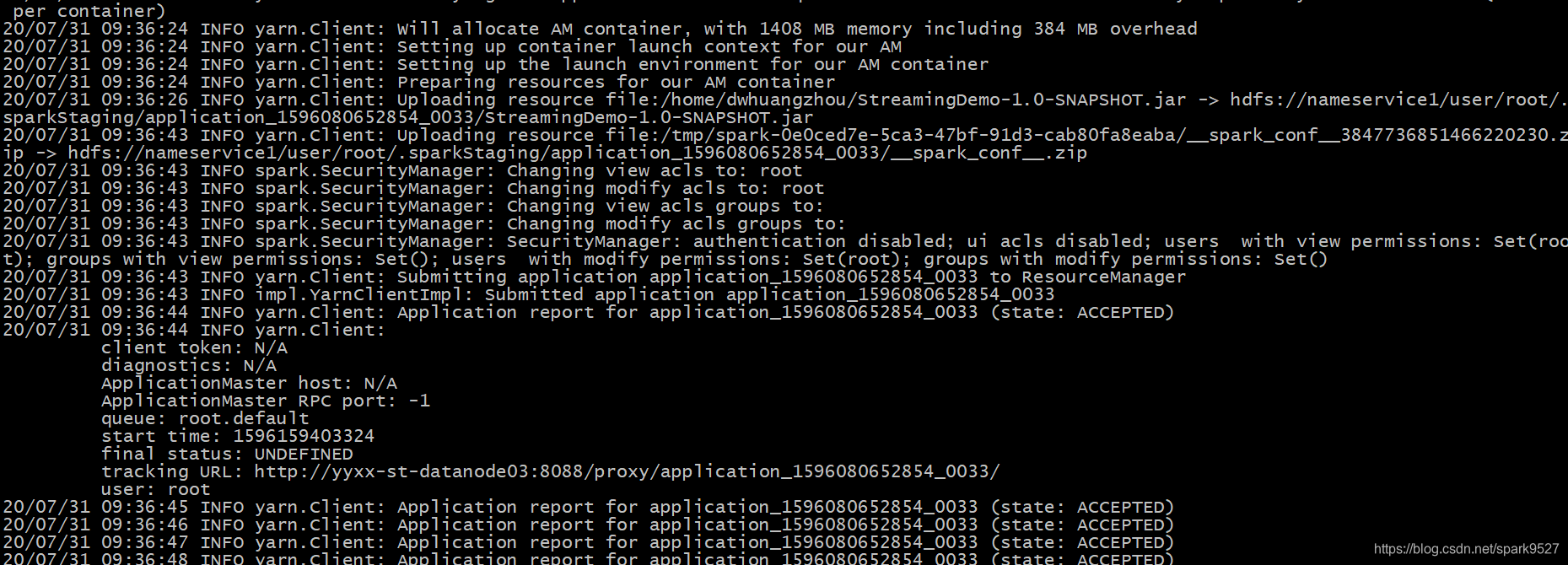

问题二:spark任务提交yarn时,用cilent模式不报错,换成cluster一直accepted

问题一排查:检查配置文件 spark-env.sh spark-defaults.conf

发现在spark-env.sh 中指定的 HADOOP_CONF_DIR 有误,并不是现在正在用的版本的hadoop的配置文件,在进行更改后,第一个问题解决

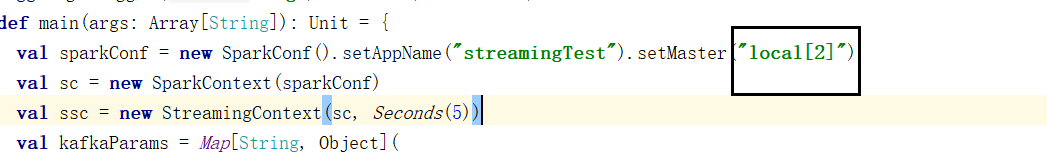

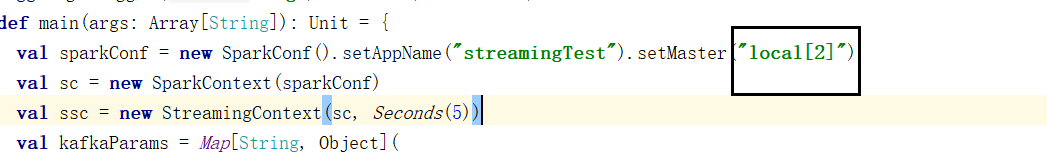

问题二排查:代码有误

本文解决了两个关键问题:在ResourceManager上成功提交Spark任务但在其他机器上失败;使用YARN时,client模式正常,cluster模式一直accepted。通过检查并更正spark-env.sh中的HADOOP_CONF_DIR配置错误,解决了第一个问题。第二个问题则由于代码错误导致。

本文解决了两个关键问题:在ResourceManager上成功提交Spark任务但在其他机器上失败;使用YARN时,client模式正常,cluster模式一直accepted。通过检查并更正spark-env.sh中的HADOOP_CONF_DIR配置错误,解决了第一个问题。第二个问题则由于代码错误导致。

问题一:spark 提交任务时,在resourcemanager上提交任务能执行,在其他机器上提交不了

问题二:spark任务提交yarn时,用cilent模式不报错,换成cluster一直accepted

问题一排查:检查配置文件 spark-env.sh spark-defaults.conf

发现在spark-env.sh 中指定的 HADOOP_CONF_DIR 有误,并不是现在正在用的版本的hadoop的配置文件,在进行更改后,第一个问题解决

问题二排查:代码有误

3671

3671

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?