温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Hadoop+Spark+Hive共享单车可视化与数据分析》的任务书模板,结合大数据处理技术与可视化需求设计,可根据实际项目需求调整内容:

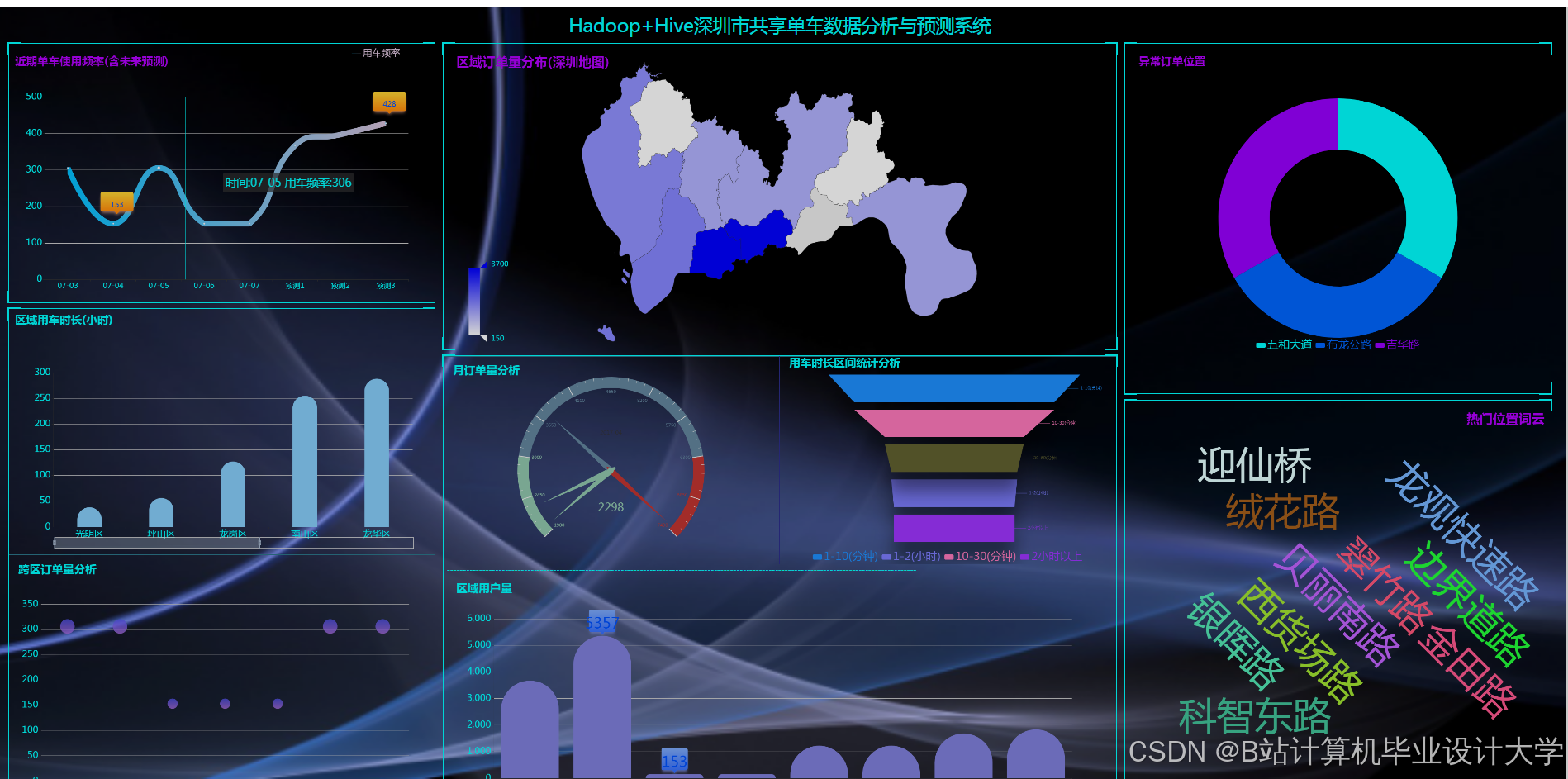

任务书:基于Hadoop+Spark+Hive的共享单车数据可视化分析

一、项目背景与目标

- 背景

共享单车作为城市短途出行的重要工具,其运营数据(如骑行记录、车辆分布、用户行为等)蕴含丰富的城市交通规律与用户需求信息。通过大数据技术分析共享单车数据,可优化车辆调度、提升用户体验,并为城市交通规划提供决策支持。 - 目标

- 构建基于Hadoop+Spark+Hive的共享单车数据存储与处理平台。

- 实现骑行数据的清洗、聚合分析及用户行为挖掘。

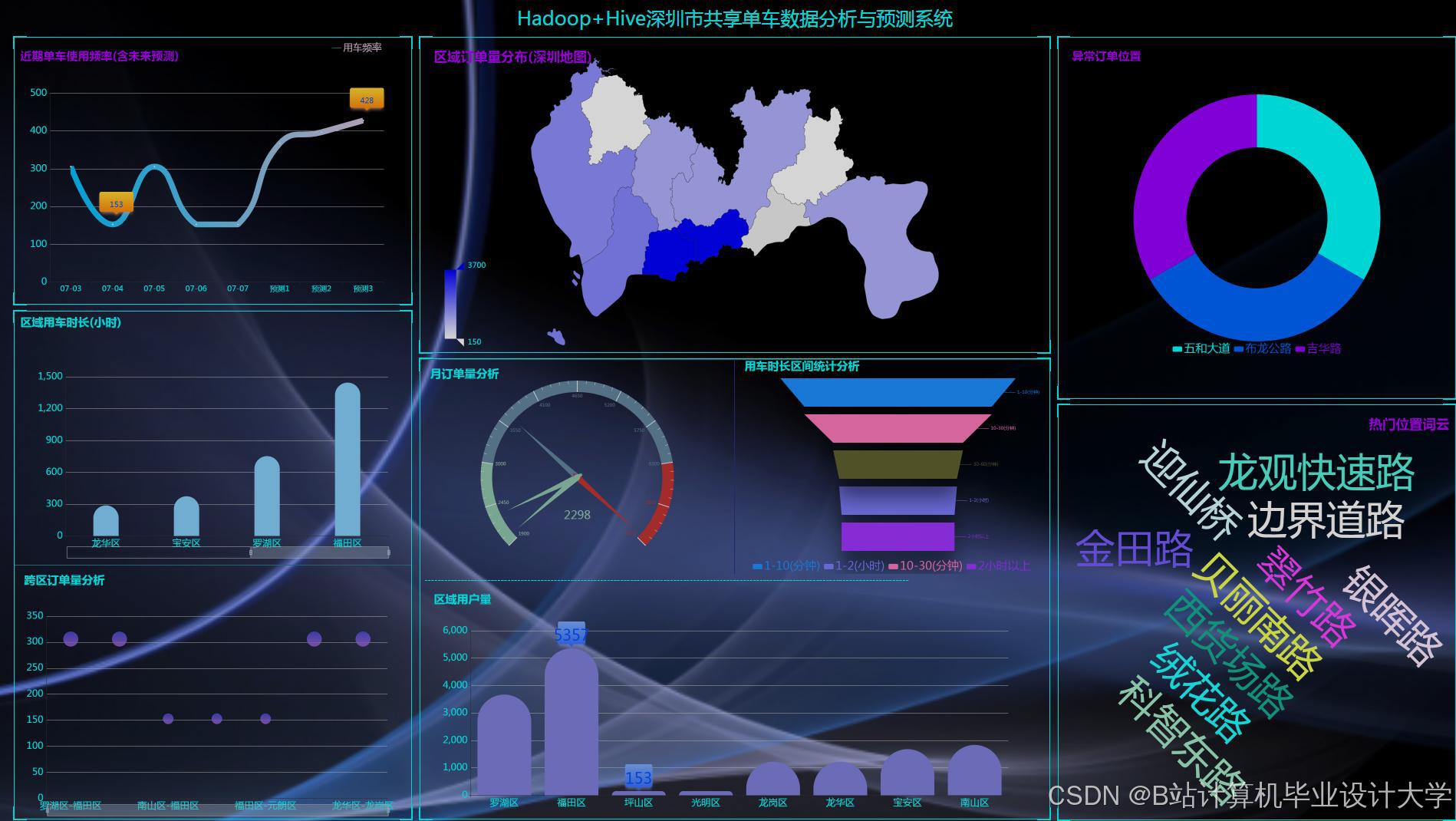

- 通过可视化技术展示关键指标(如热点区域、高峰时段、车辆周转率等)。

二、任务内容与分工

1. 数据采集与预处理

- 任务内容:

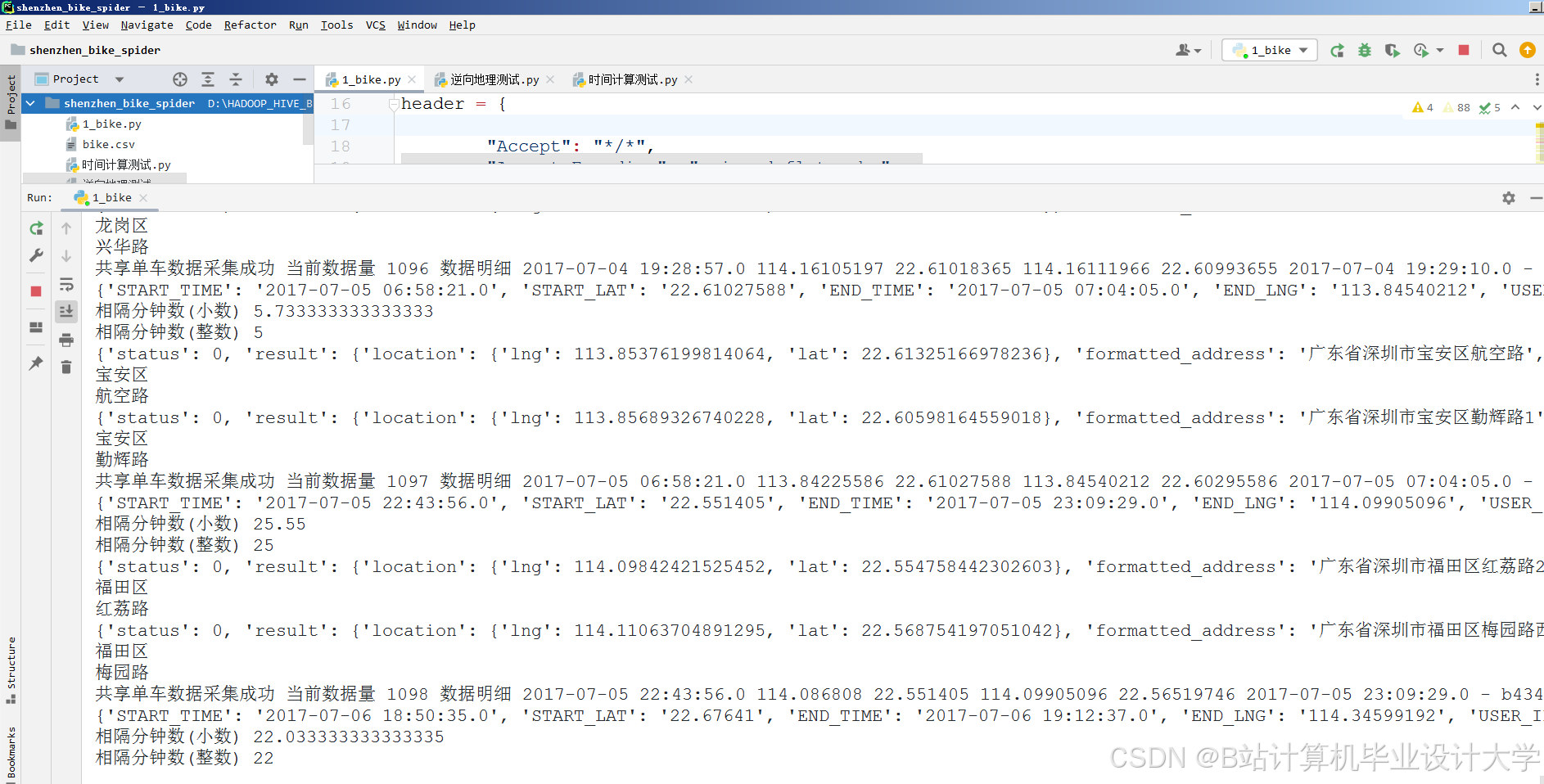

- 获取共享单车公开数据集(如摩拜、哈啰等历史数据,或模拟生成数据)。

- 数据清洗:处理缺失值(如GPS坐标缺失)、异常值(如骑行时间过长)、重复记录等。

- 数据转换:统一时间格式、坐标系(如WGS84转GCJ02),提取关键字段(用户ID、骑行时长、起止站点等)。

- 技术工具:

- Python(Pandas、NumPy)、正则表达式。

- 数据源:公开数据集(如Kaggle共享单车数据)、API接口(需授权)。

2. 分布式存储与计算环境搭建

- 任务内容:

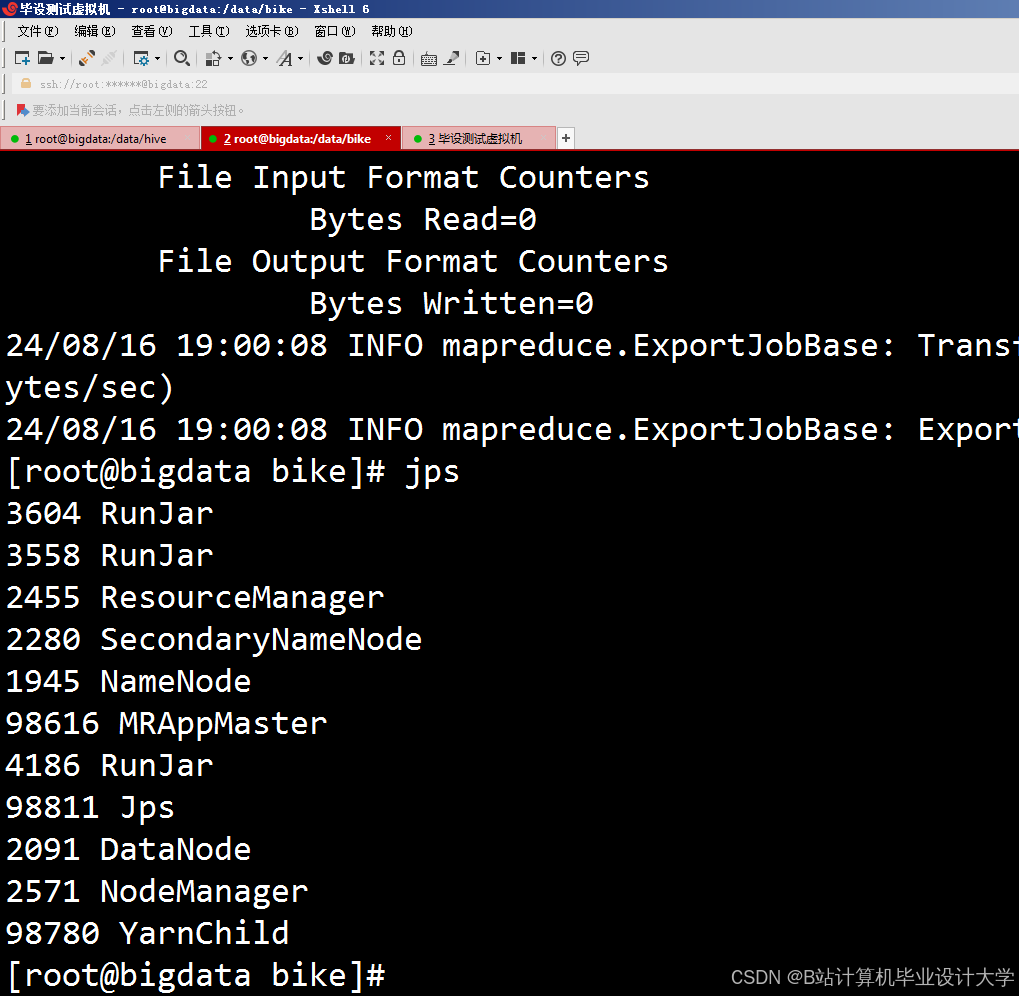

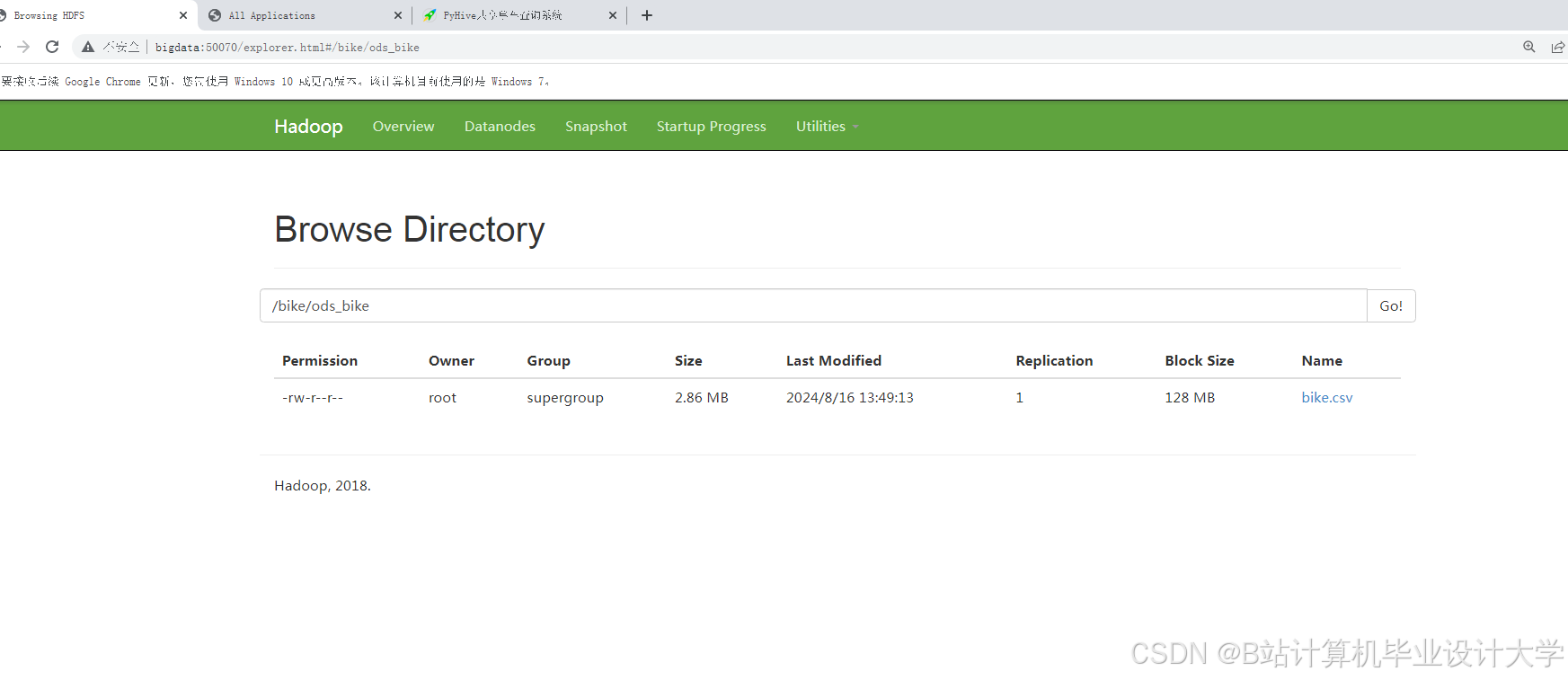

- 部署Hadoop集群(HDFS存储原始数据)。

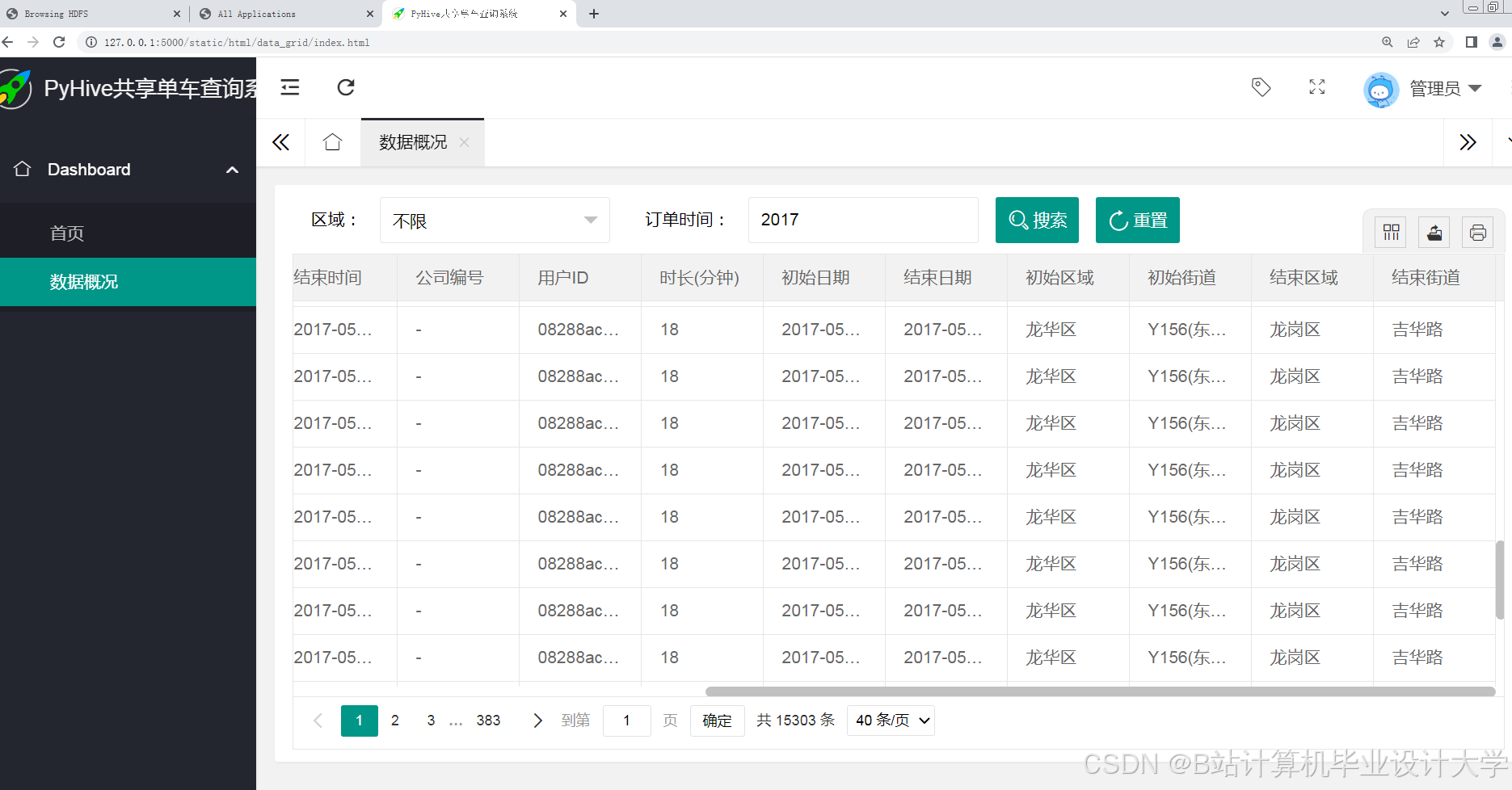

- 使用Hive构建数据仓库,定义表结构(如骑行记录表、用户表、站点表)。

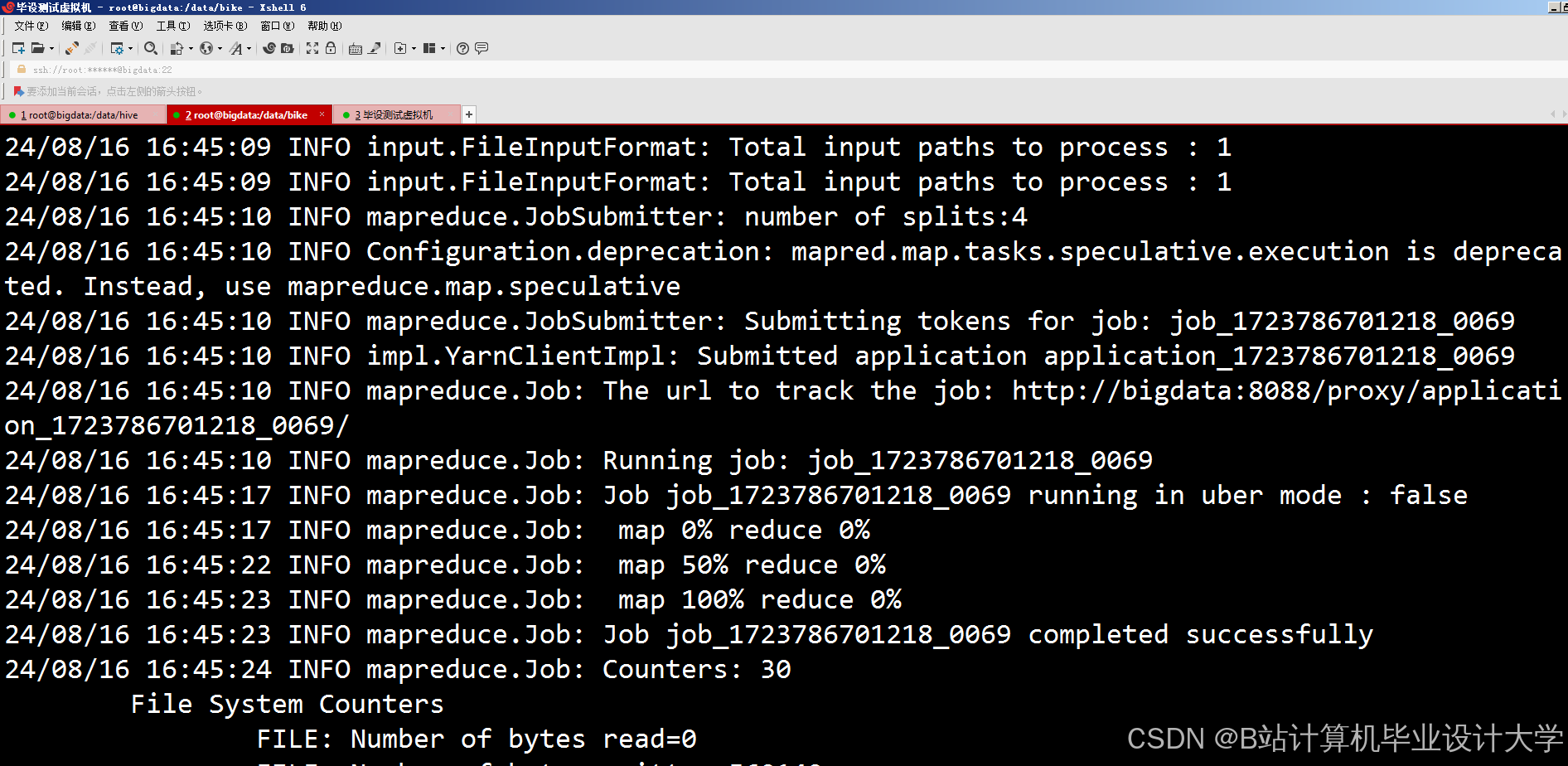

- 配置Spark环境,用于后续分布式计算(如聚合分析、机器学习)。

- 技术工具:

- Hadoop 3.x、Hive 3.x、Spark 3.x。

- 集群部署方式:本地虚拟机(如VirtualBox)、云服务(如阿里云EMR、AWS EMR)。

3. 数据分析与挖掘

- 任务内容:

- 基础分析:

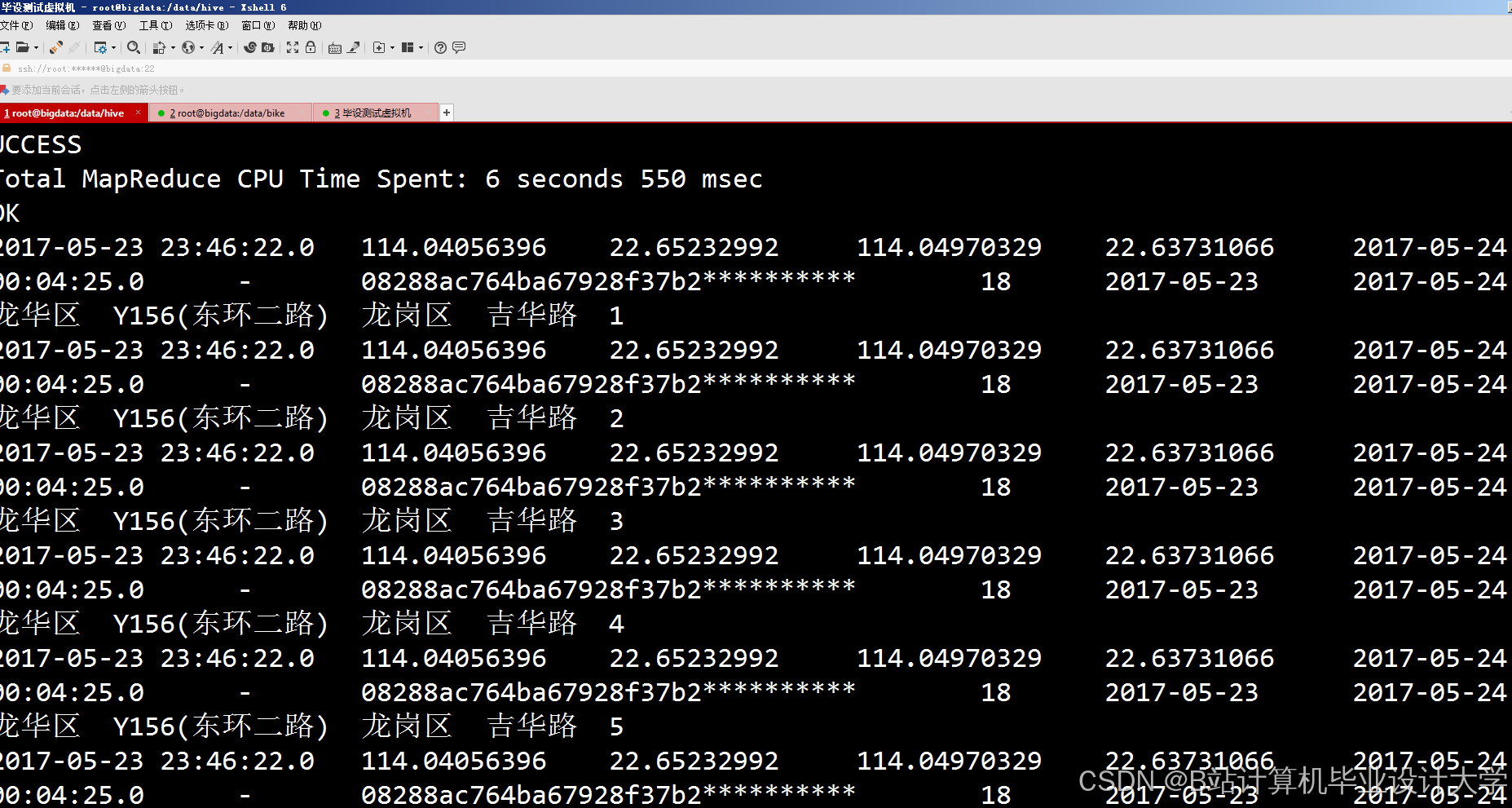

- 使用Hive SQL统计每日骑行次数、平均骑行时长、热门起止站点。

- 按时间(小时/周/月)分析骑行高峰时段与周期性规律。

- 高级分析:

- 基于Spark MLlib聚类分析:识别高频骑行区域(如商圈、地铁站周边)。

- 用户行为分析:划分用户类型(如通勤用户、休闲用户)及其骑行偏好。

- 车辆周转率分析:计算单车日均使用次数,评估区域供需平衡。

- 基础分析:

- 技术工具:

- Hive SQL、Spark RDD/DataFrame、Spark MLlib(K-Means聚类)。

4. 数据可视化与报告输出

- 任务内容:

- 可视化关键指标:

- 热点区域地图(使用ECharts/Leaflet展示骑行起止点密度)。

- 时间趋势图(骑行量随时间变化曲线)。

- 用户分类占比(饼图/柱状图)。

- 生成分析报告:

- 包含数据概况、分析结论、优化建议(如车辆调度策略)。

- 可视化关键指标:

- 技术工具:

- 可视化库:Python(Matplotlib、Seaborn)、JavaScript(ECharts、D3.js)。

- 报告工具:Jupyter Notebook、Markdown、PPT。

三、技术路线

- 数据流设计

1数据采集 → 数据清洗 → HDFS存储 → Hive数据仓库 → Spark分析 → 可视化展示 - 关键技术点

- 分布式存储:HDFS实现海量骑行数据可靠存储。

- 并行计算:Spark加速聚类分析与复杂统计任务。

- 交互式查询:Hive SQL简化多维度聚合操作。

四、时间计划

| 阶段 | 时间 | 任务内容 |

|---|---|---|

| 环境搭建 | 第1周 | 部署Hadoop/Hive/Spark集群,验证基础功能 |

| 数据采集与清洗 | 第2周 | 完成数据获取、清洗及初步探索分析 |

| 核心分析与建模 | 第3-4周 | 实现聚类分析、用户行为分类及周转率计算 |

| 可视化与报告 | 第5周 | 生成图表、撰写分析报告 |

| 验收与优化 | 第6周 | 系统测试、文档整理及答辩准备 |

五、预期成果

- 技术成果:

- 完整的大数据分析平台,支持TB级共享单车数据处理。

- 可复用的Hive数据仓库模型与Spark分析脚本。

- 分析成果:

- 共享单车骑行热点地图与高峰时段分布图。

- 用户分类报告与车辆调度优化建议。

- 交付物:

- 代码仓库(GitHub/GitLab)。

- 分析报告(PDF/PPT)。

- 部署文档与操作指南。

六、资源需求

- 硬件资源:

- 服务器或云主机(建议8核16G以上,3节点集群)。

- 软件资源:

- Hadoop/Hive/Spark生态组件、Python开发环境、可视化库。

- 数据资源:

- 共享单车公开数据集(如City Bike Data)或模拟数据。

七、风险评估与应对

- 数据质量风险:

- 风险:原始数据缺失率过高或字段不统一。

- 应对:提前检查数据质量,制定清洗规则(如插值、删除异常值)。

- 集群性能风险:

- 风险:Spark任务运行缓慢或内存溢出。

- 应对:优化分区策略、调整Executor内存配置、使用缓存(

cache())。

- 可视化效果风险:

- 风险:地图热点展示不清晰或交互性差。

- 应对:选择合适地图底图(如高德/Google Maps API),简化数据聚合粒度。

负责人(签字):

日期:

备注:

- 可扩展方向:引入Flink实现实时骑行数据监控,或结合机器学习预测未来骑行需求。

- 数据安全:若涉及用户隐私数据,需脱敏处理并遵守相关法规(如GDPR)。

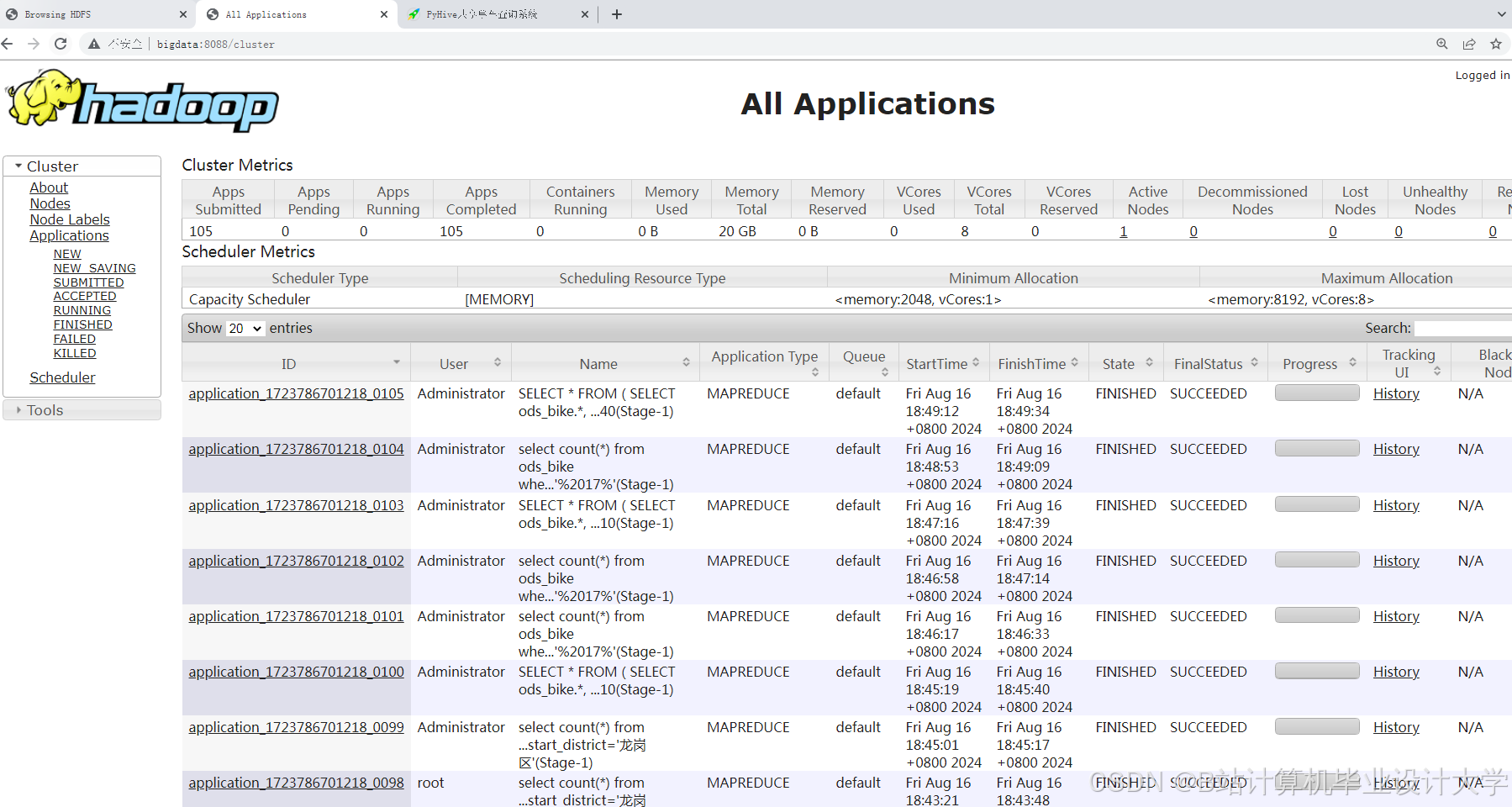

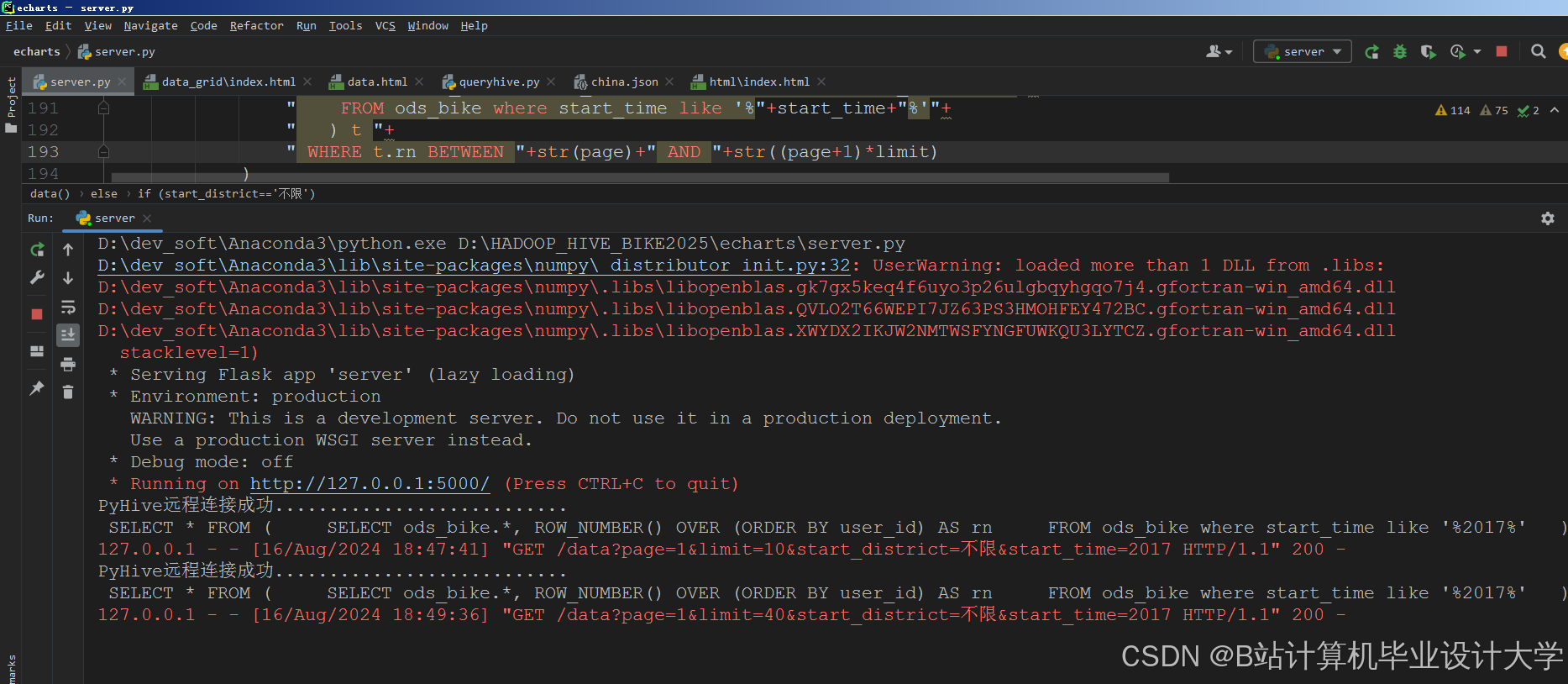

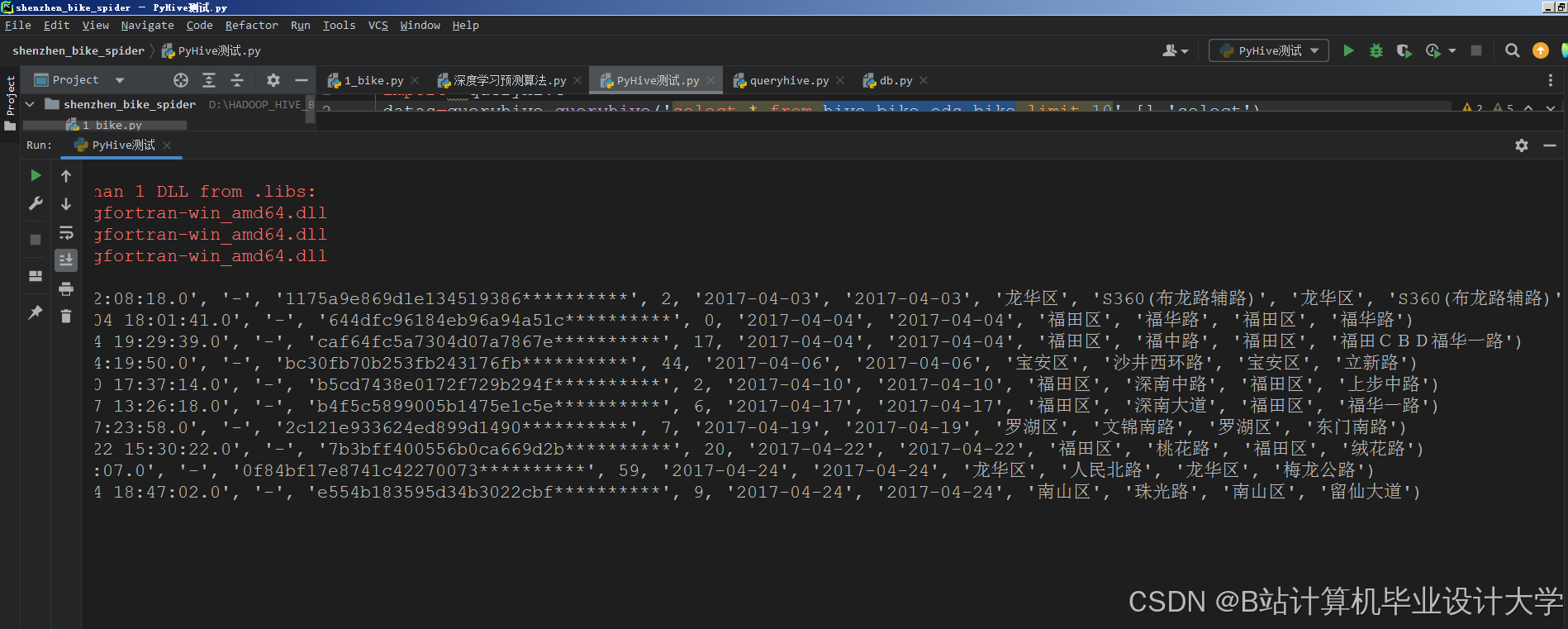

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

881

881

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?