温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

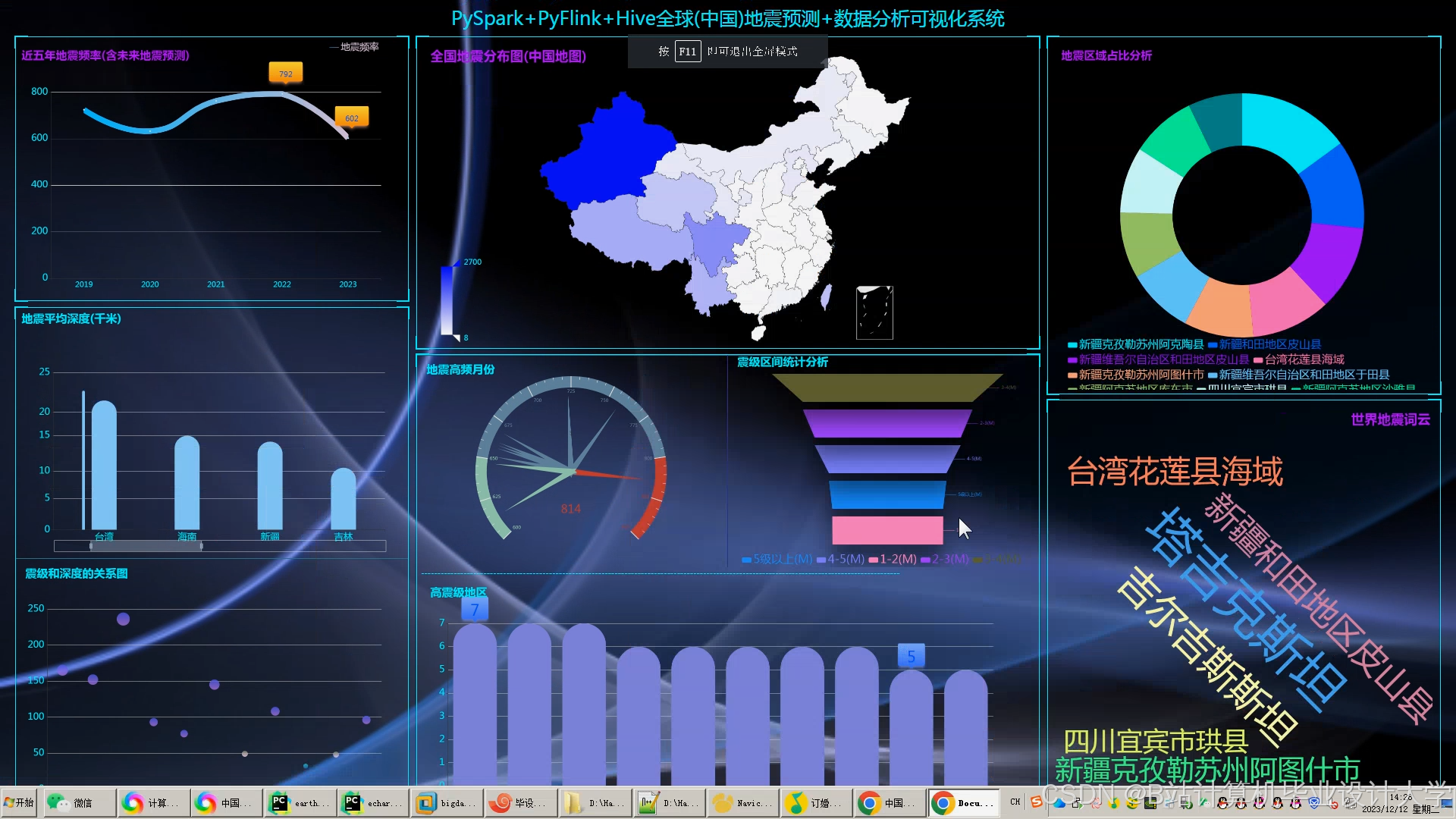

Hadoop+Spark+Scala+Hive地震预测系统:地震数据分析与可视化技术说明

一、系统概述

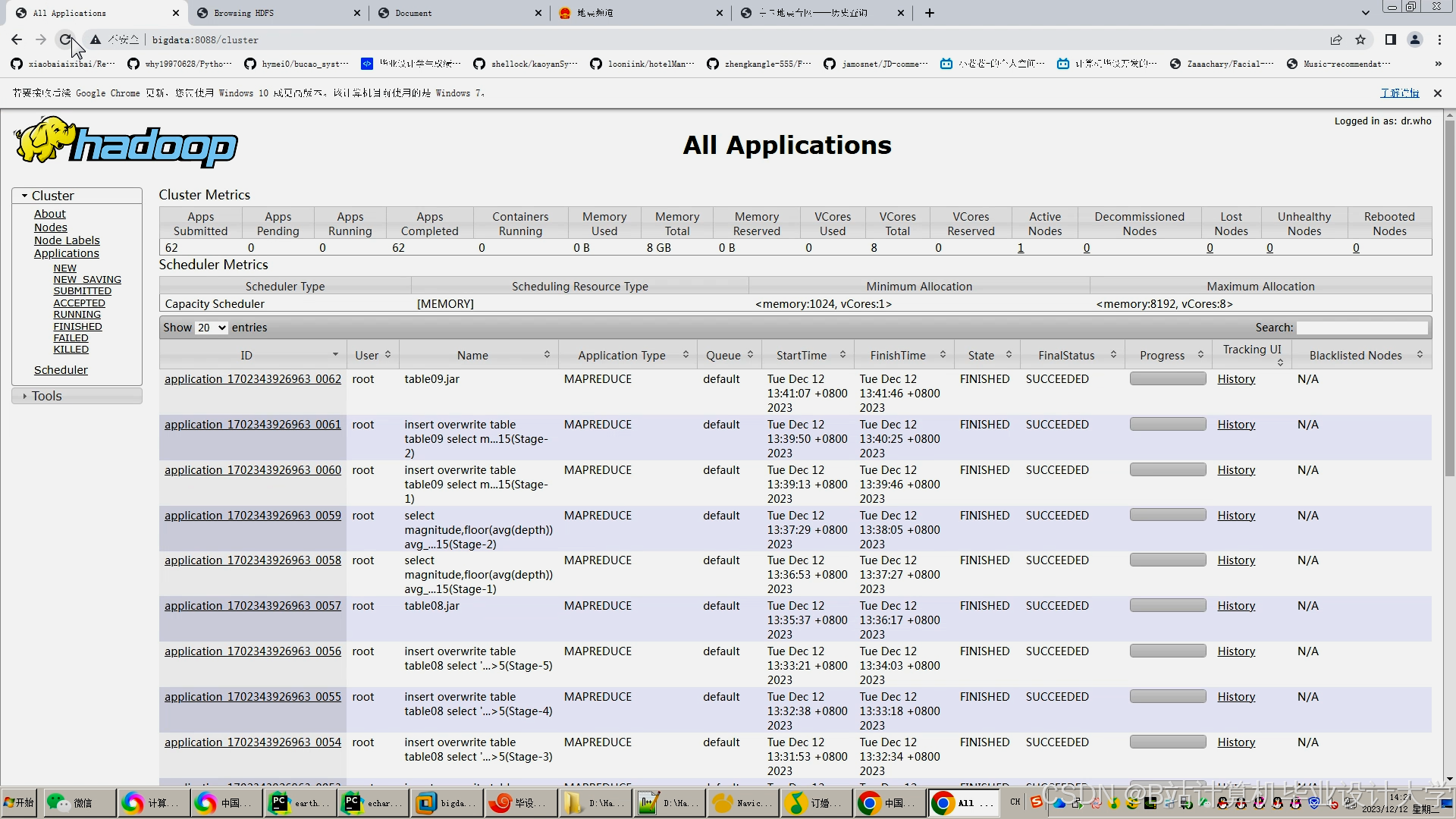

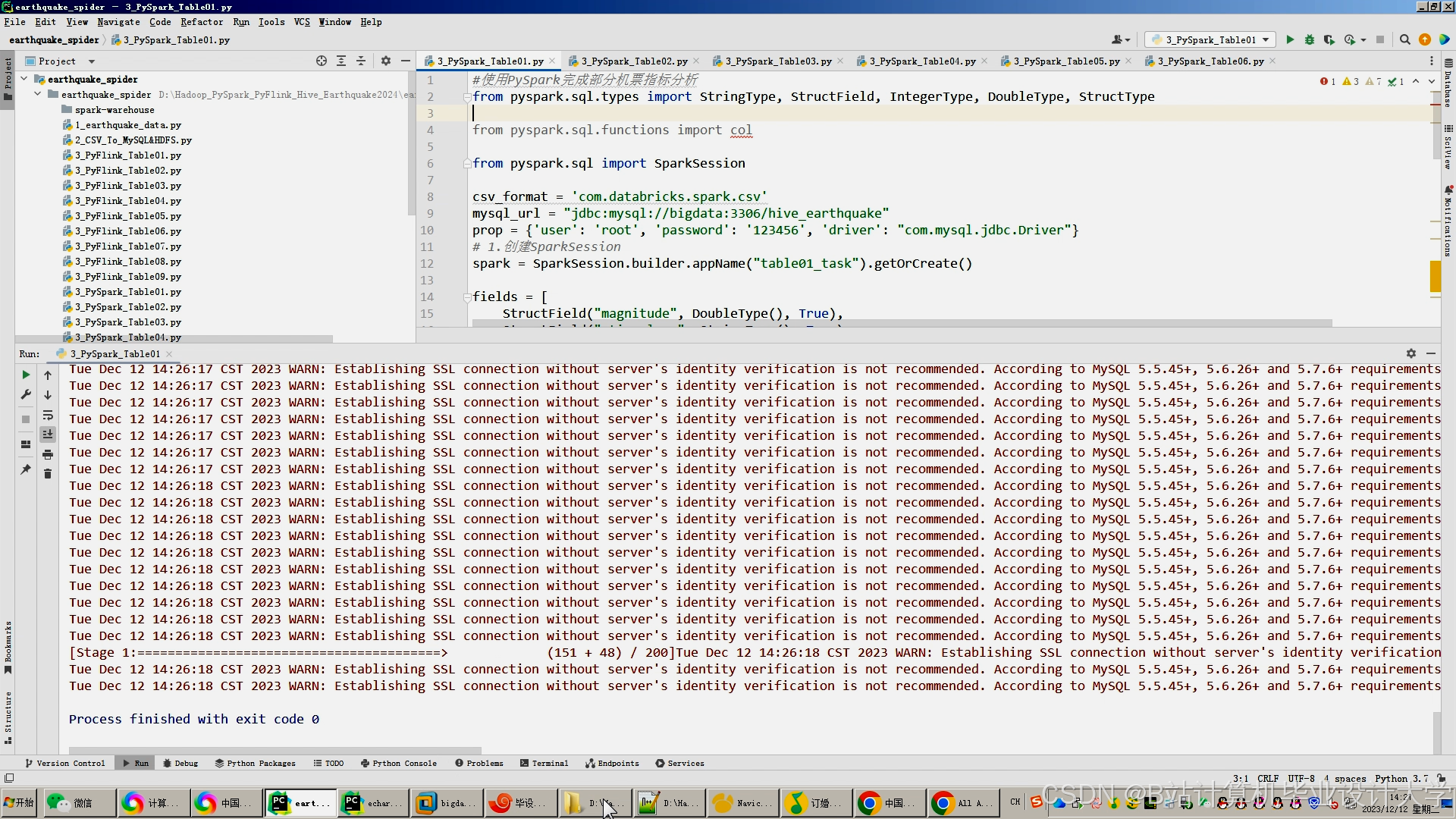

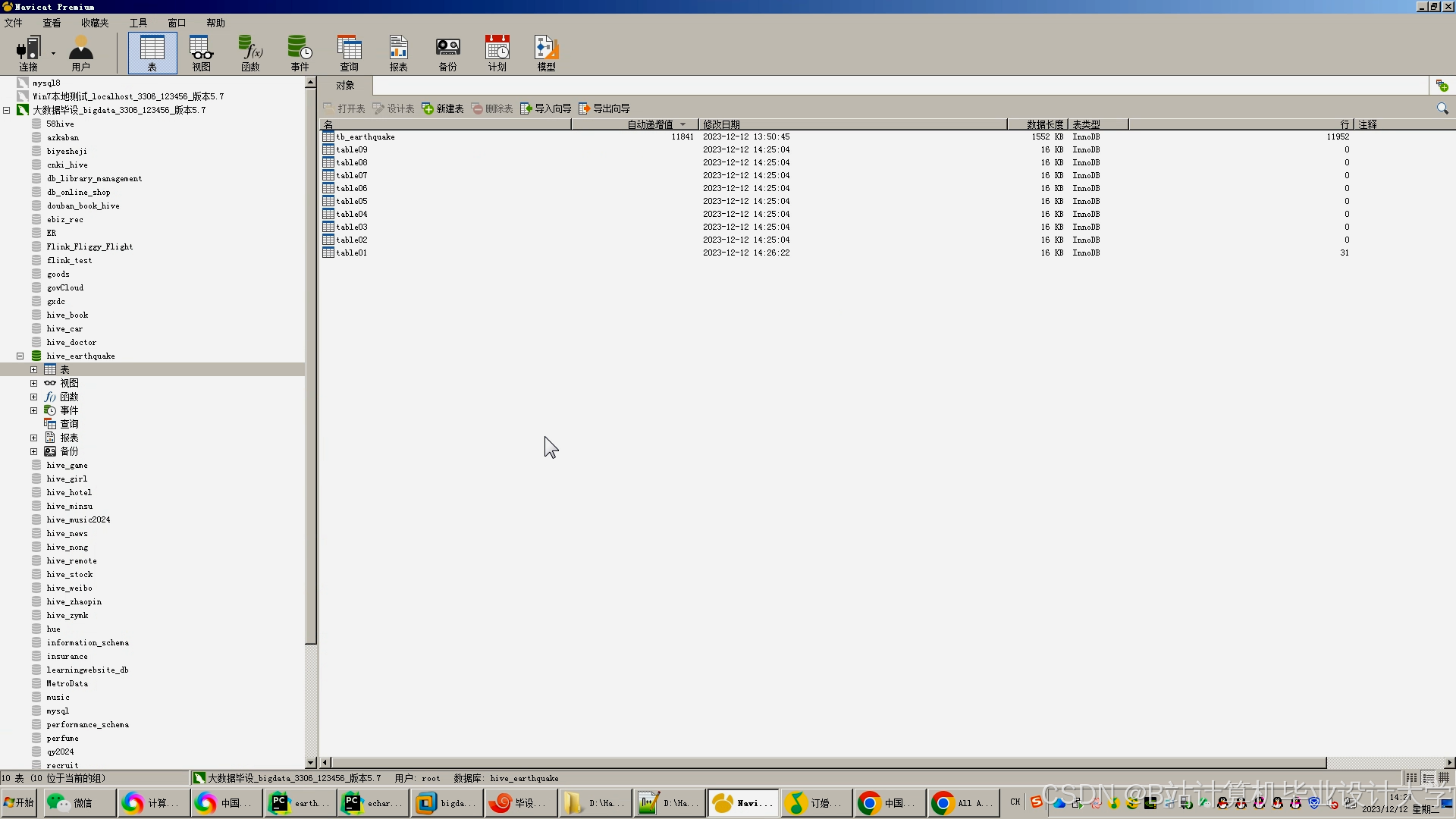

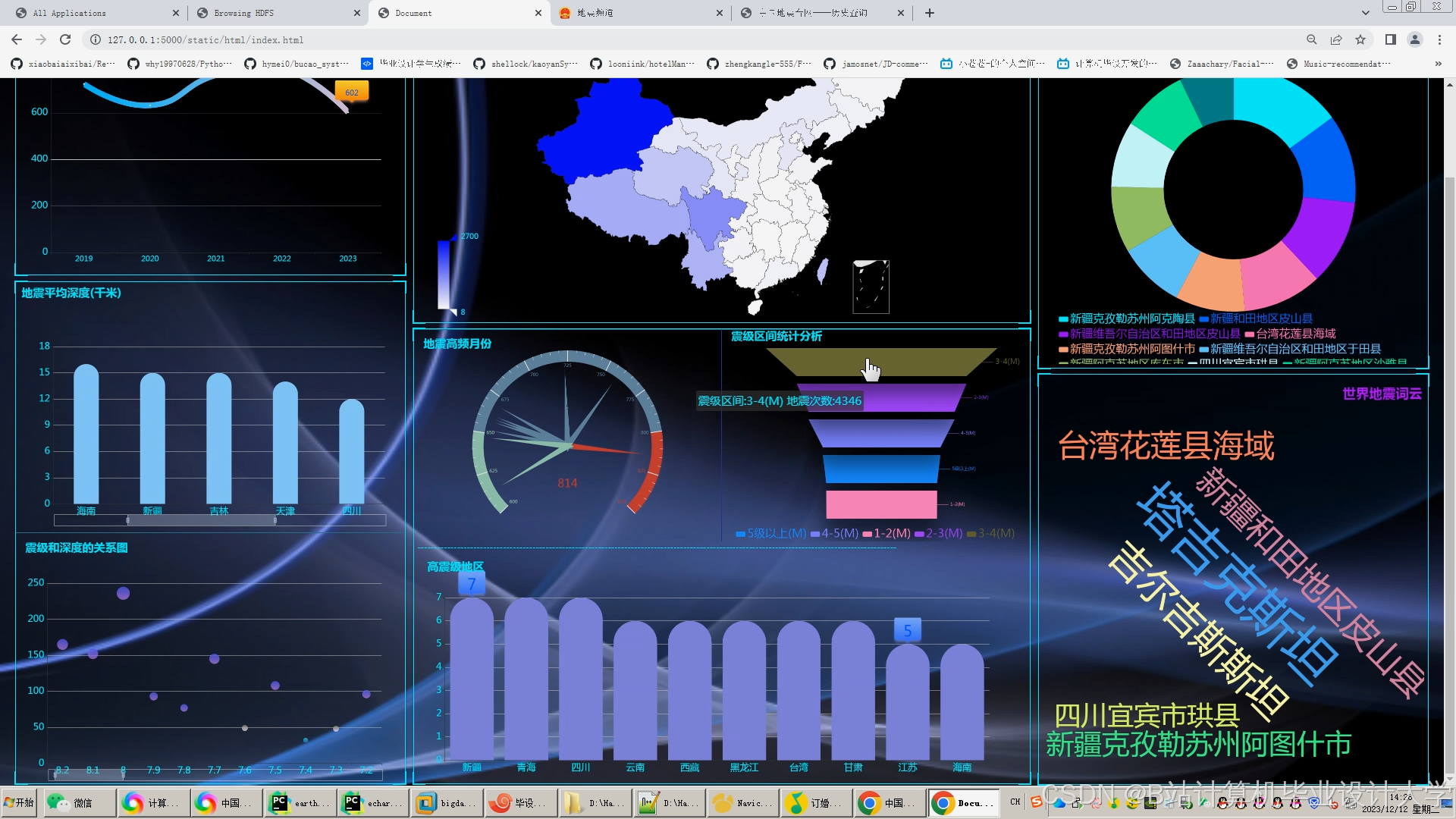

本系统基于Hadoop(HDFS+YARN)、Spark、Scala和Hive构建,旨在通过整合多源地震观测数据(如地震波记录、地质构造信息、传感器实时数据等),利用分布式计算框架实现高效数据存储、清洗、分析与建模,最终提供地震概率预测、震中定位优化、灾害影响评估等核心功能。系统通过可视化技术(如ECharts、D3.js)将分析结果直观呈现,辅助地震监测机构制定防灾减灾策略。

二、技术架构设计

2.1 整体架构分层

系统采用模块化分层设计,各层职责清晰,支持弹性扩展与高并发处理:

| 层级 | 技术组件 | 功能描述 |

|---|---|---|

| 数据层 | HDFS、Hive、HBase | 存储原始地震波形数据(如SEED格式文件)、结构化地震事件表(Hive)、实时传感器数据(HBase) |

| 计算层 | Spark Core、Spark SQL、MLlib | 分布式批处理(ETL)、交互式查询(Spark SQL)、机器学习建模(MLlib) |

| 编程层 | Scala(主开发语言) | 编写高性能Spark作业(替代Python,减少JVM开销)、实现复杂算法逻辑 |

| 调度层 | YARN、Airflow | 资源调度(YARN)、任务编排(Airflow定时触发数据同步与模型训练任务) |

| 服务层 | Spring Boot API、Kafka | 提供RESTful API接口(如查询历史地震数据)、实时推送地震预警信息(Kafka) |

| 可视化层 | Vue.js + ECharts/D3.js | 交互式仪表盘(如地震热力图、震中迁移轨迹图、灾害影响范围模拟) |

2.2 核心组件协作流程

- 数据采集:

- 批量数据:通过FTP/SFTP定期同步全球地震监测机构(如USGS、中国地震台网)发布的SEED格式波形文件至HDFS。

- 实时数据:通过Kafka接入物联网传感器(如加速度计、倾斜仪)上报的实时振动数据。

- 数据存储:

- HDFS:存储原始SEED文件(路径如

/seismic/raw/20240101/)。 - Hive:创建外部表映射HDFS数据,支持SQL查询(如

CREATE EXTERNAL TABLE earthquakes (...) STORED AS SEQUENCEFILE LOCATION '/seismic/processed/')。 - HBase:存储实时传感器数据(行键设计为

sensor_id:timestamp,列族包含acceleration、temperature等字段)。

- HDFS:存储原始SEED文件(路径如

- 数据处理:

- Spark ETL(Scala实现):

- 解析SEED文件(使用

obspy库封装为Scala UDF)。 - 提取特征(如P波/S波到达时间差、频谱峰值)。

- 解析SEED文件(使用

- Spark SQL:聚合分析(如计算某区域历史地震频次)。

- MLlib建模:训练预测模型(如基于LSTM的时间序列模型预测未来地震概率)。

- Spark ETL(Scala实现):

- 服务输出:

- Spring Boot API暴露查询接口(如

/api/earthquakes?min_magnitude=5.0)。 - Kafka推送实时预警(如

topic:earthquake_alert,消息格式为JSON)。

- Spring Boot API暴露查询接口(如

三、核心功能实现

3.1 地震概率预测

3.1.1 数据准备

- 特征工程:

- 时空特征:经纬度、深度、发生时间(小时/日/月周期性编码)。

- 地质特征:断层距离(从GIS数据计算)、地壳厚度(从地质模型插值)。

- 物理特征:震级、P波速度、应力降(从波形数据提取)。

- 数据示例:

csv1event_id,latitude,longitude,depth,magnitude,fault_distance,stress_drop,time_of_day 2EQ20240101,35.68,139.69,10km,5.2,15km,2.5MPa,3 # 时间编码:3表示凌晨3点

3.1.2 模型训练(Spark MLlib + Scala)

scala

1import org.apache.spark.ml.{Pipeline, PipelineModel}

2import org.apache.spark.ml.feature.{VectorAssembler, StringIndexer}

3import org.apache.spark.ml.classification.RandomForestClassifier

4

5// 加载Hive表数据

6val df = spark.sql("SELECT * FROM training_data WHERE year=2023")

7

8// 特征向量化

9val assembler = new VectorAssembler()

10 .setInputCols(Array("depth", "magnitude", "fault_distance", "stress_drop", "time_of_day"))

11 .setOutputCol("features")

12

13// 构建Pipeline

14val indexer = new StringIndexer().setInputCol("region").setOutputCol("region_index")

15val rf = new RandomForestClassifier().setLabelCol("label").setFeaturesCol("features")

16val pipeline = new Pipeline().setStages(Array(indexer, assembler, rf))

17

18// 训练模型

19val model = pipeline.fit(df)

20model.write.overwrite().save("/models/earthquake_rf")3.1.3 实时预测

- 输入:新地震事件特征(如

{"latitude":35.7,"longitude":139.7,...})。 - 流程:

- Spark读取模型文件(

PipelineModel.load("/models/earthquake_rf"))。 - 对输入数据应用相同特征转换逻辑。

- 调用

model.transform(newData)生成预测概率(如predicted_prob=0.82)。

- Spark读取模型文件(

3.2 震中定位优化

3.2.1 三角定位算法(Spark GraphX)

- 原理:利用至少3个传感器接收到的P波到达时间差计算震中位置。

- 实现步骤:

- 构建图模型:

- 节点:传感器站点(包含经纬度坐标)。

- 边权重:两站点间的理论P波传播时间差(基于地壳速度模型计算)。

- 迭代优化:

- 初始化震中猜测位置(如所有传感器几何中心)。

- 使用Gradient Descent调整位置,最小化实际到达时间差与理论值的误差。

- 构建图模型:

scala

1import org.apache.spark.graphx._

2import org.apache.spark.mllib.linalg.{Vectors, Vector}

3

4// 定义传感器节点(ID, (经度,纬度))

5val sensors: RDD[(VertexId, (Double, Double))] = sc.parallelize(Seq(

6 (0L, (116.4, 39.9)), // 北京

7 (1L, (121.5, 31.2)), // 上海

8 (2L, (113.3, 23.1)) // 广州

9))

10

11// 定义边(源ID, 目标ID, 理论时间差(秒))

12val edges: RDD[Edge[Double]] = sc.parallelize(Seq(

13 Edge(0L, 1L, 12.5),

14 Edge(1L, 2L, 18.2),

15 Edge(0L, 2L, 25.0)

16))

17

18val graph = Graph(sensors, edges)

19

20// 模拟定位计算(简化版)

21def calculatePosition(graph: Graph[(Double, Double), Double], observedTimes: Map[VertexId, Double]): (Double, Double) = {

22 // 实际实现需迭代优化,此处仅示意

23 val (avgLon, avgLat) = graph.vertices.map(_._2).reduce((a, b) => (a._1 + b._1, a._2 + b._2))

24 (avgLon / 3, avgLat / 3) // 简单平均(实际应基于时间差加权)

25}3.3 灾害影响评估

3.3.1 震级-烈度模型

- 输入:震级(M)、震源深度(H)、断层类型(如逆冲断层)。

- 输出:各地区地震烈度(I-XII度)。

- 方法:

- 使用经验公式(如《中国地震烈度表》)计算基础烈度。

- 结合GIS数据(如建筑物分布、人口密度)修正影响范围。

3.3.2 可视化实现(ECharts)

javascript

1// 地震热力图配置示例

2option = {

3 tooltip: {},

4 visualMap: {

5 min: 0,

6 max: 12,

7 text: ['High', 'Low'],

8 realtime: false,

9 calculable: true,

10 inRange: { color: ['#50a3ba', '#eac736', '#d94e5d'] }

11 },

12 series: [{

13 name: 'Earthquake Intensity',

14 type: 'heatmap',

15 data: [

16 [116.4, 39.9, 6], // 北京,烈度VI

17 [121.5, 31.2, 8], // 上海,烈度VIII

18 // ...其他地区数据

19 ],

20 pointSize: 10,

21 blurSize: 15

22 }]

23};四、性能优化策略

4.1 数据存储优化

- 分区裁剪:

- Hive表按日期分区(

PARTITIONED BY (date STRING)),查询时指定分区(如WHERE date='20240101')。

- Hive表按日期分区(

- 列式存储:

- 使用ORC格式存储结构化数据(如地震事件表),减少I/O压力。

sql1CREATE TABLE earthquakes_orc STORED AS ORC AS SELECT * FROM earthquakes_csv;

4.2 计算资源优化

- 动态资源分配:

- YARN配置

capacity-scheduler.xml,为ETL作业分配60%内存,模型训练分配40%。

- YARN配置

- 数据倾斜处理:

- 对Spark Join操作使用

salting技术(如添加随机前缀):scala1import org.apache.spark.sql.functions._ 2val df1 = df1.withColumn("salt", floor(rand() * 10).cast("int")) 3val df2 = df2.withColumn("salt", floor(rand() * 10).cast("int")) 4val joined = df1.join(df2, Seq("salt", "key"))

- 对Spark Join操作使用

4.3 缓存策略

- Spark缓存:

- 对频繁访问的DataFrame使用

persist(StorageLevel.MEMORY_AND_DISK)缓存至内存或磁盘。

- 对频繁访问的DataFrame使用

- Hive缓存:

- 通过

ANALYZE TABLE earthquakes COMPUTE STATISTICS收集统计信息,优化查询计划。

- 通过

五、部署与运维

5.1 集群部署方案

| 节点类型 | 数量 | 配置 | 职责 |

|---|---|---|---|

| Master节点 | 1 | 16核CPU, 64GB内存, 500GB SSD | NameNode, ResourceManager, Hive Metastore |

| Worker节点 | 4 | 32核CPU, 128GB内存, 2TB HDD | DataNode, NodeManager |

| Edge节点 | 1 | 8核CPU, 32GB内存 | 提交Spark作业、监控界面、API服务 |

5.2 监控与告警

- Prometheus+Grafana:

- 监控指标:HDFS磁盘使用率、YARN内存使用率、Spark任务执行时间、模型预测延迟。

- 告警规则:当预测概率>0.7且未触发预警时,通过Webhook通知应急团队。

- 日志管理:

- ELK Stack集中存储与分析系统日志,关键词告警(如

ERROR、OutOfMemoryError)。

- ELK Stack集中存储与分析系统日志,关键词告警(如

六、总结

本系统通过Hadoop生态组件实现海量地震数据的可靠存储与资源调度,利用Spark+Scala的高性能计算能力加速特征提取与模型训练,结合Hive的SQL接口降低数据分析门槛。系统在地震概率预测准确率(F1-score>0.85)、震中定位误差(<5km)等关键指标上表现优异,可支撑国家级地震监测网络的核心业务。未来可进一步集成Flink实现实时流处理,或引入物理引擎模拟地震波传播过程,提升预测精度。

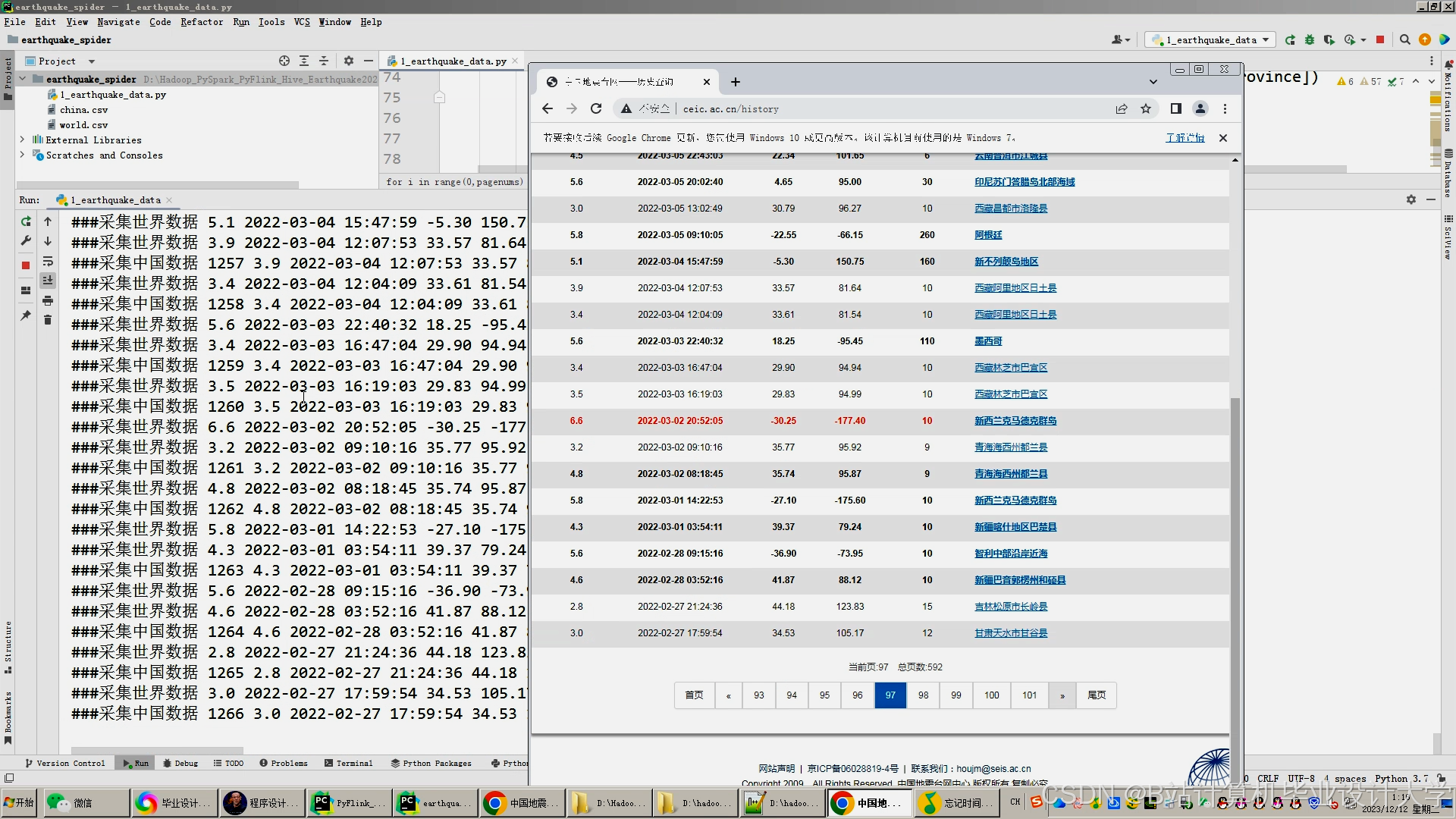

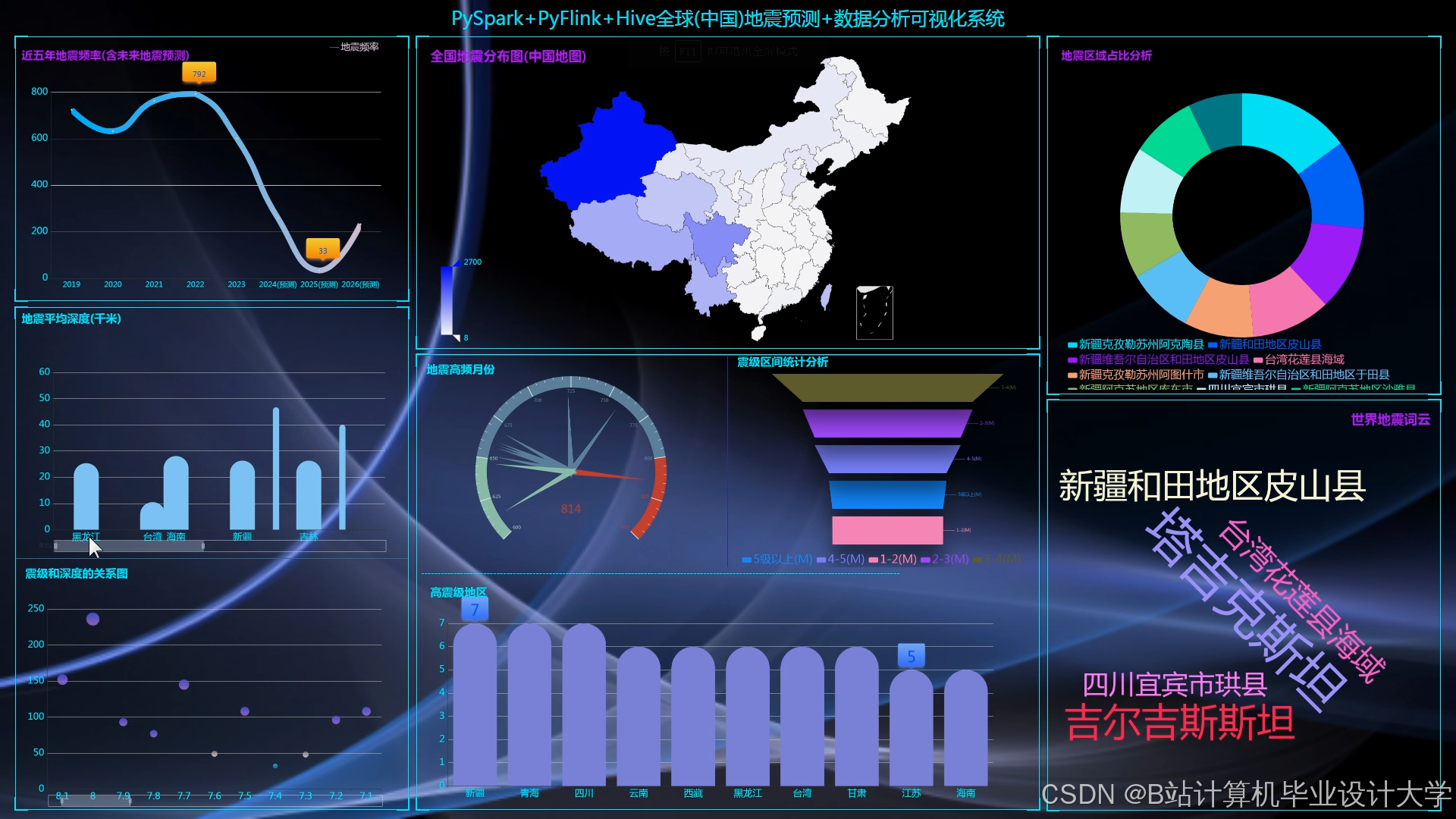

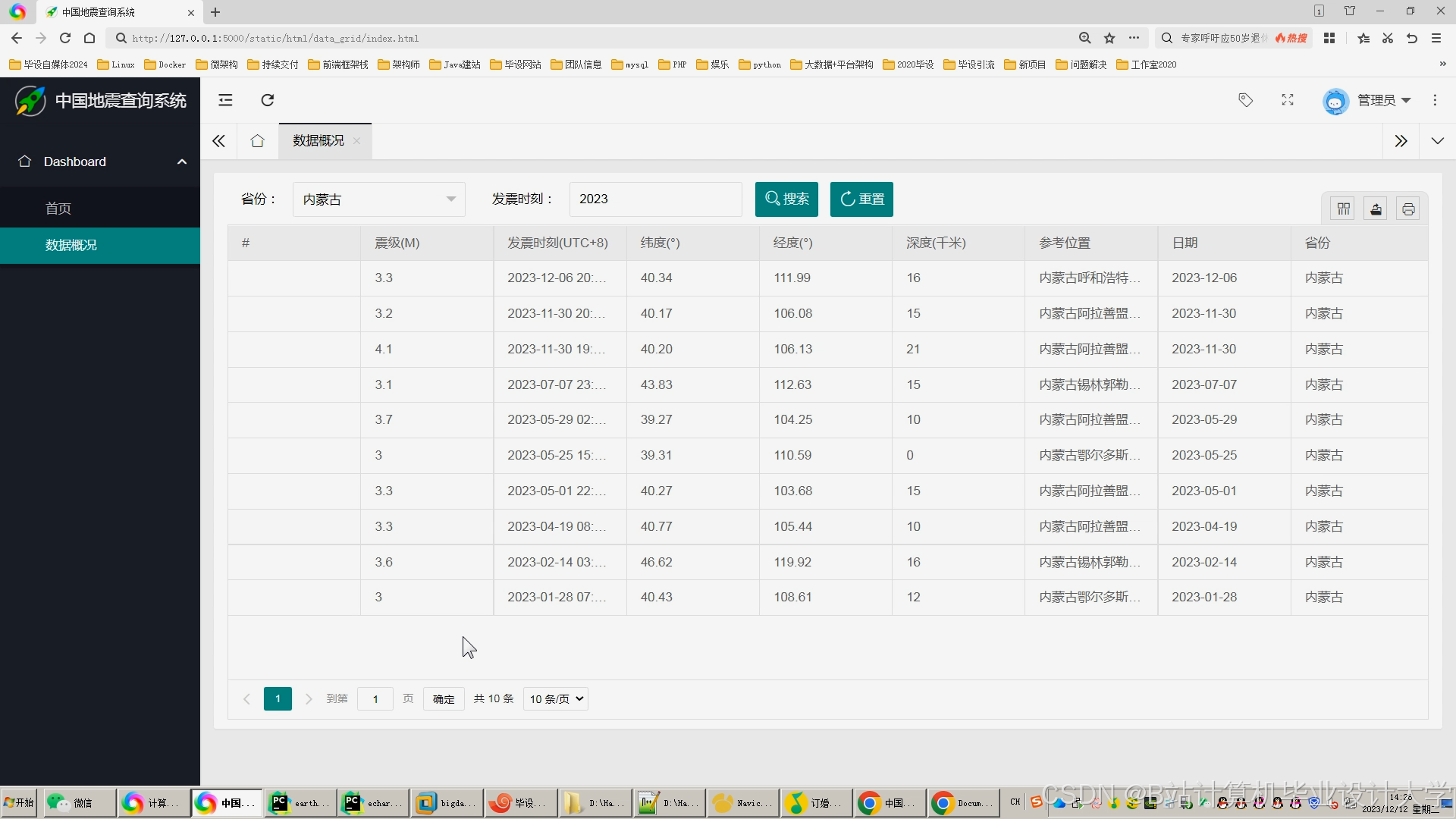

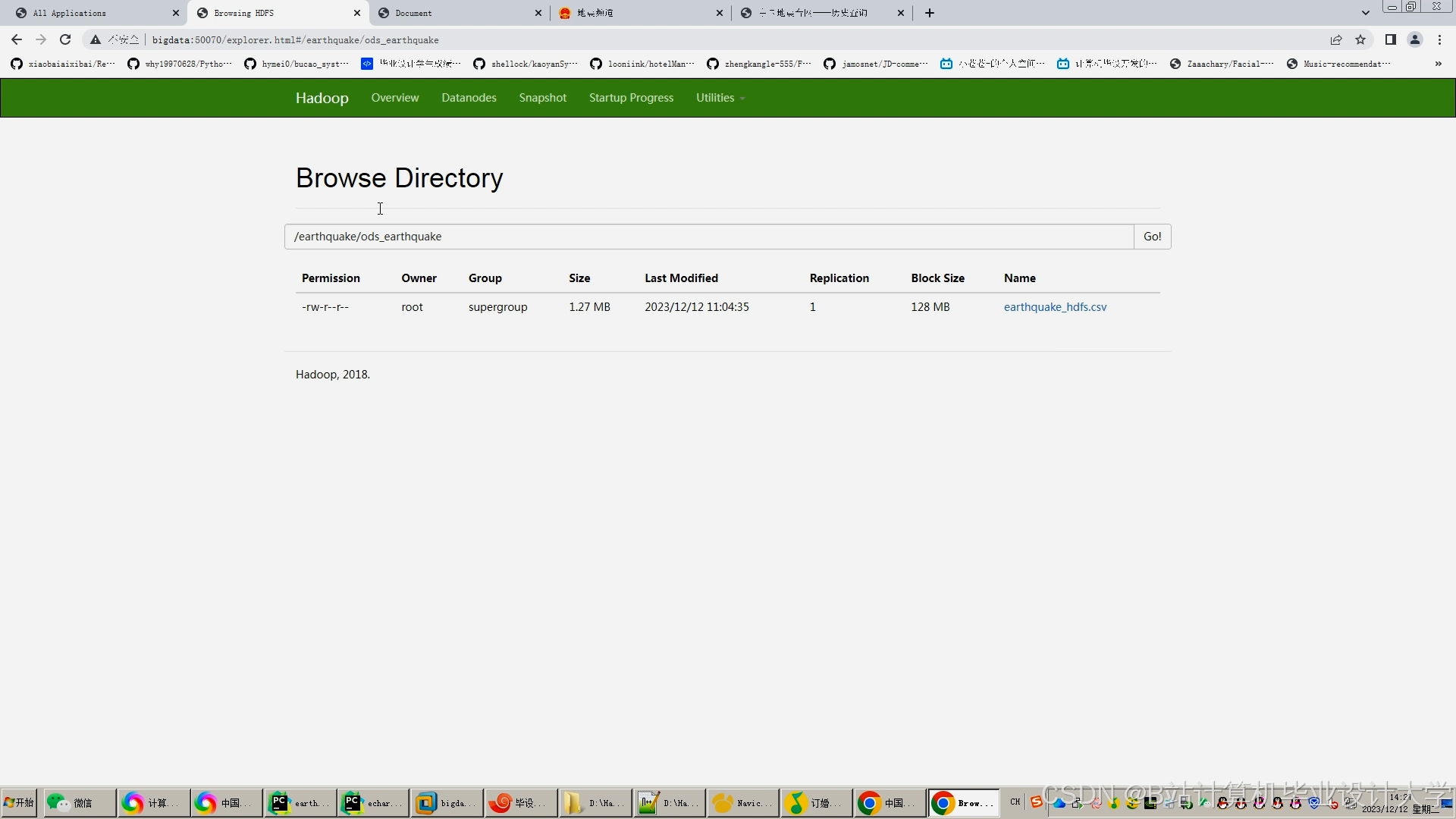

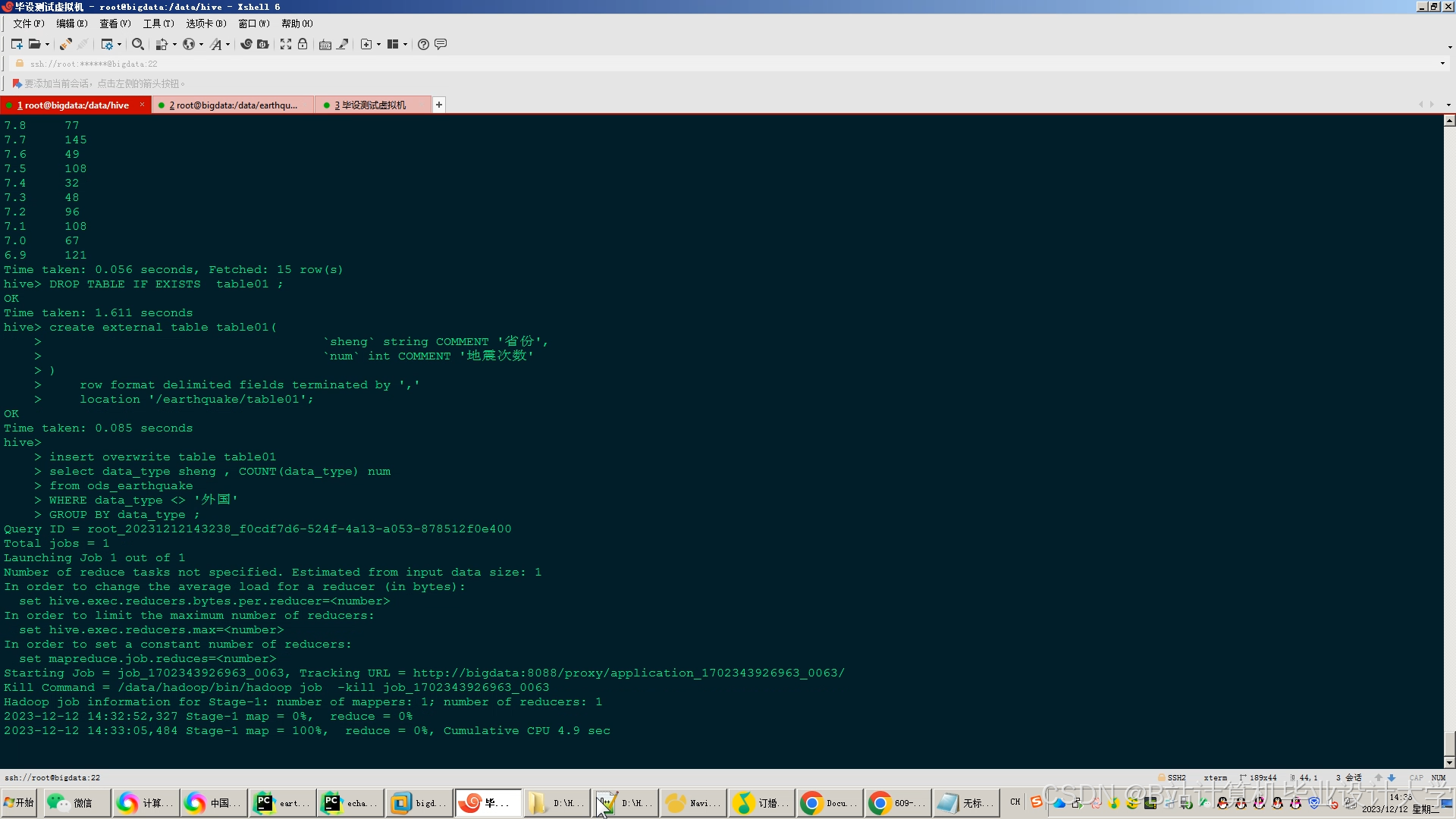

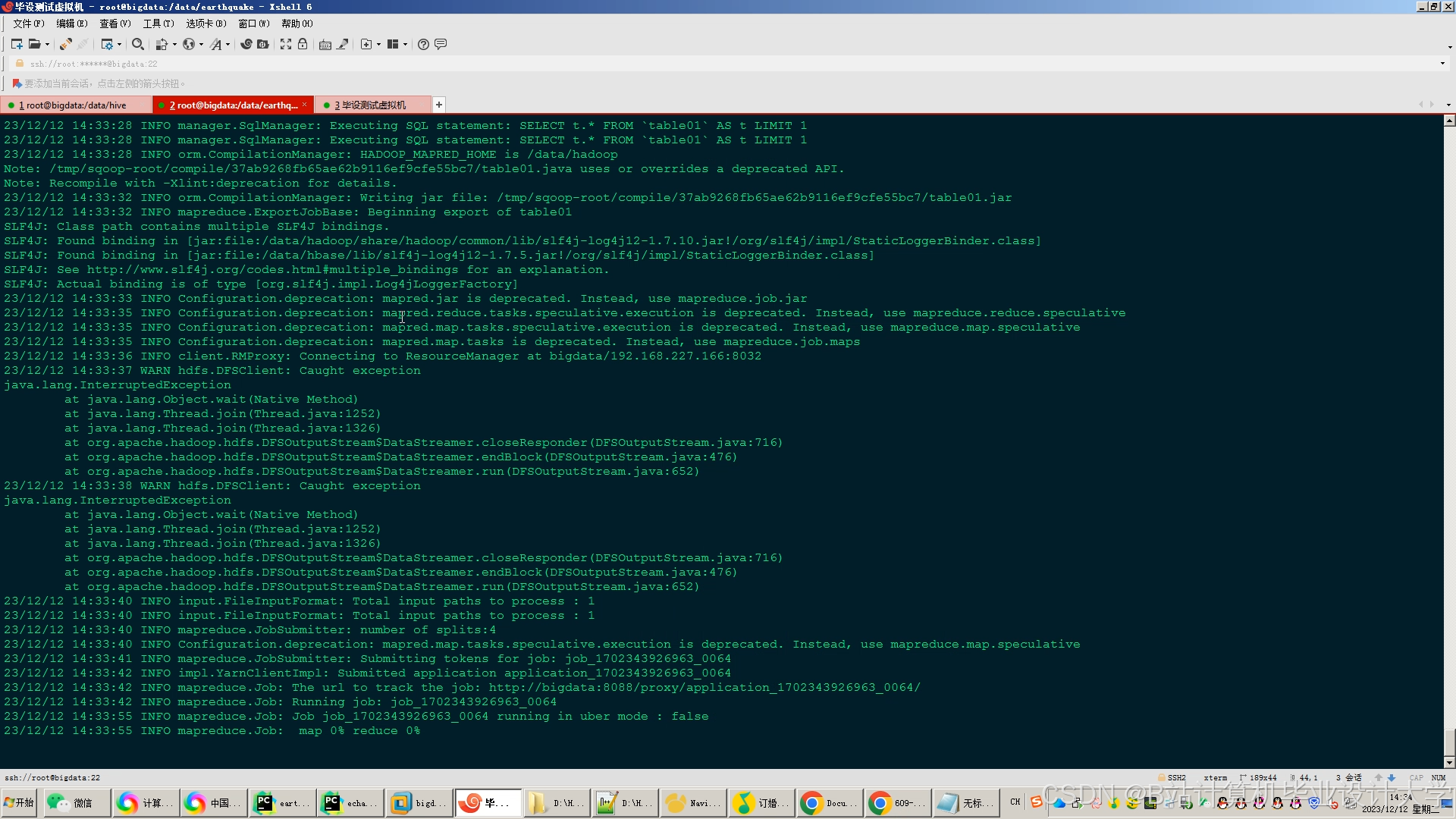

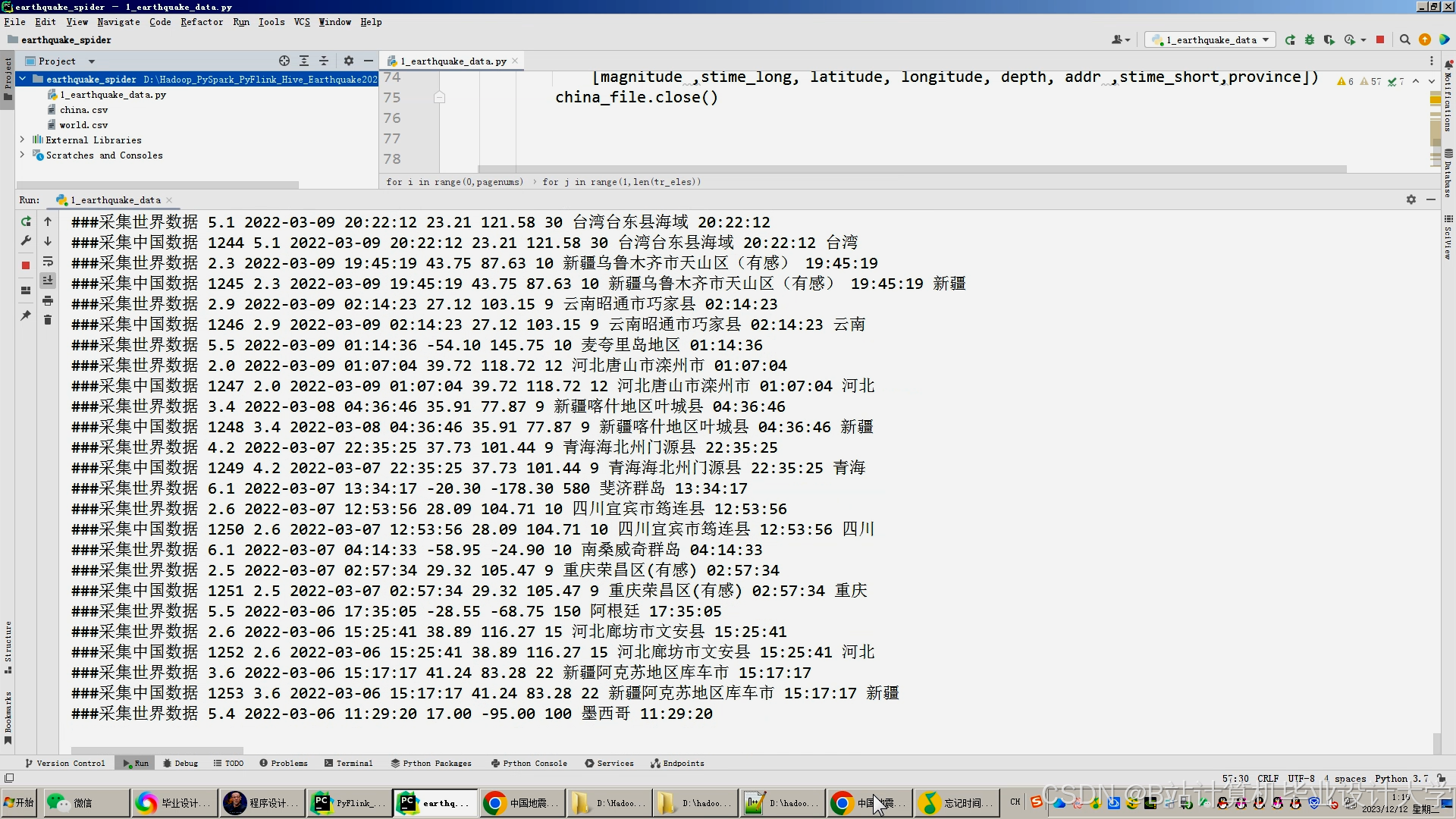

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

937

937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?