温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python新闻推荐系统中的新闻标题自动分类研究

摘要:本文聚焦于Python新闻推荐系统中的新闻标题自动分类问题。首先阐述了新闻推荐系统在信息爆炸时代的重要性,以及新闻标题自动分类作为其关键环节的意义。接着详细介绍了基于Python实现的新闻标题自动分类系统的整体架构,包括数据获取、预处理、特征提取、分类模型构建与评估等步骤。在数据预处理部分,介绍了文本清洗、分词等操作;特征提取环节探讨了词袋模型、TF-IDF以及词嵌入等方法;分类模型构建部分对比了传统机器学习算法(如朴素贝叶斯、支持向量机)和深度学习模型(如卷积神经网络、循环神经网络)在新闻标题分类任务中的表现。最后通过实验评估不同模型的效果,并对未来研究方向进行了展望。

关键词:Python;新闻推荐系统;新闻标题自动分类;机器学习;深度学习

一、引言

在当今信息爆炸的时代,互联网上的新闻数量呈指数级增长。用户面临着海量的新闻信息,难以快速准确地找到自己感兴趣的内容。新闻推荐系统应运而生,它能够根据用户的兴趣偏好,为用户推荐个性化的新闻内容,提高用户获取信息的效率。新闻标题自动分类作为新闻推荐系统的关键环节,其准确性直接影响着推荐系统的性能。通过对新闻标题进行自动分类,可以将新闻按照不同的主题进行划分,为后续的推荐算法提供基础。

Python作为一种功能强大且易于使用的编程语言,拥有丰富的机器学习和深度学习库,如Scikit-learn、TensorFlow、PyTorch等,为新闻标题自动分类的实现提供了便利。本文将详细介绍如何使用Python构建一个新闻标题自动分类系统,并对比不同分类算法在该任务上的效果。

二、新闻标题自动分类系统架构

2.1 系统整体架构概述

基于Python的新闻标题自动分类系统主要包括以下几个模块:数据获取模块、数据预处理模块、特征提取模块、分类模型构建模块和模型评估模块。数据获取模块负责从新闻网站或数据库中获取新闻标题数据;数据预处理模块对获取到的原始数据进行清洗、分词等操作,使其符合后续处理的要求;特征提取模块将文本数据转换为数值特征向量,以便分类模型能够处理;分类模型构建模块使用不同的算法构建分类模型;模型评估模块则对训练好的模型进行评估,以确定其性能优劣。

2.2 数据获取

数据获取是新闻标题自动分类的第一步。可以通过多种方式获取新闻标题数据,例如使用网络爬虫从新闻网站抓取新闻标题,或者从已有的新闻数据库中提取。在使用网络爬虫时,需要注意遵守网站的robots协议,避免对网站造成不必要的负担。以下是一个简单的使用Python的requests库和BeautifulSoup库获取新闻标题的示例代码:

python

1import requests

2from bs4 import BeautifulSoup

3

4url = 'https://www.example-news-site.com'

5response = requests.get(url)

6soup = BeautifulSoup(response.text, 'html.parser')

7titles = [title.text for title in soup.find_all('h2', class_='news-title')]

8print(titles)2.3 数据预处理

2.3.1 文本清洗

获取到的新闻标题数据可能包含一些噪声,如HTML标签、特殊字符、停用词等。文本清洗的目的是去除这些噪声,使文本数据更加干净整洁。可以使用正则表达式来去除HTML标签和特殊字符,使用停用词表来去除停用词。以下是一个简单的文本清洗示例代码:

python

1import re

2import jieba

3from collections import Counter

4

5# 示例停用词表

6stopwords = set(['的', '了', '和', '是', '在'])

7

8def clean_text(text):

9 # 去除HTML标签

10 text = re.sub(r'<[^>]+>', '', text)

11 # 去除特殊字符

12 text = re.sub(r'[^\w\s]', '', text)

13 # 分词

14 words = jieba.lcut(text)

15 # 去除停用词

16 words = [word for word in words if word not in stopwords]

17 return ' '.join(words)

18

19text = "<p>这是一条<b>新闻标题</b>,包含一些特殊字符!</p>"

20cleaned_text = clean_text(text)

21print(cleaned_text)2.3.2 分词

中文文本与英文文本不同,英文文本以空格作为单词的分隔符,而中文文本需要使用分词工具将句子分割成一个个的词语。常用的中文分词工具有jieba、SnowNLP等。在上述代码中,我们使用了jieba分词工具对文本进行分词。

2.4 特征提取

特征提取是将文本数据转换为数值特征向量的过程,以便分类模型能够处理。常见的特征提取方法有词袋模型、TF-IDF和词嵌入等。

2.4.1 词袋模型

词袋模型将文本看作是一个词语的集合,忽略词语的顺序和语法结构,只考虑每个词语在文本中出现的频率。可以使用Scikit-learn库中的CountVectorizer来实现词袋模型。以下是一个示例代码:

python

1from sklearn.feature_extraction.text import CountVectorizer

2

3corpus = [

4 '这是一条体育新闻',

5 '这是一条科技新闻',

6 '体育新闻很精彩'

7]

8vectorizer = CountVectorizer()

9X = vectorizer.fit_transform(corpus)

10print(vectorizer.get_feature_names_out())

11print(X.toarray())2.4.2 TF-IDF

TF-IDF(Term Frequency-Inverse Document Frequency)是一种常用的文本特征提取方法,它综合考虑了词语在文本中出现的频率(TF)和在整个语料库中出现的文档频率(IDF)。TF-IDF值越高,表示该词语在当前文本中越重要。可以使用Scikit-learn库中的TfidfVectorizer来实现TF-IDF特征提取。以下是一个示例代码:

python

1from sklearn.feature_extraction.text import TfidfVectorizer

2

3corpus = [

4 '这是一条体育新闻',

5 '这是一条科技新闻',

6 '体育新闻很精彩'

7]

8vectorizer = TfidfVectorizer()

9X = vectorizer.fit_transform(corpus)

10print(vectorizer.get_feature_names_out())

11print(X.toarray())2.4.3 词嵌入

词嵌入是将词语映射到一个低维的向量空间中,使得语义相似的词语在向量空间中的距离较近。常用的词嵌入模型有Word2Vec、GloVe和FastText等。可以使用Gensim库来实现Word2Vec词嵌入模型。以下是一个简单的示例代码:

python

1from gensim.models import Word2Vec

2import jieba

3

4sentences = [

5 list(jieba.lcut('这是一条体育新闻')),

6 list(jieba.lcut('这是一条科技新闻')),

7 list(jieba.lcut('体育新闻很精彩'))

8]

9model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

10print(model.wv['体育'])2.5 分类模型构建

2.5.1 传统机器学习算法

- 朴素贝叶斯:朴素贝叶斯是一种基于贝叶斯定理的简单概率分类算法,假设特征之间相互独立。可以使用Scikit-learn库中的MultinomialNB来实现朴素贝叶斯分类器。以下是一个示例代码:

python

1from sklearn.naive_bayes import MultinomialNB

2from sklearn.model_selection import train_test_split

3from sklearn.metrics import accuracy_score

4

5# 假设X是特征矩阵,y是标签向量

6X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

7clf = MultinomialNB()

8clf.fit(X_train, y_train)

9y_pred = clf.predict(X_test)

10print("Accuracy:", accuracy_score(y_test, y_pred))- 支持向量机:支持向量机是一种二分类模型,其基本模型定义为特征空间上间隔最大的线性分类器。可以使用Scikit-learn库中的SVC来实现支持向量机分类器。以下是一个示例代码:

python

1from sklearn.svm import SVC

2

3clf = SVC(kernel='linear')

4clf.fit(X_train, y_train)

5y_pred = clf.predict(X_test)

6print("Accuracy:", accuracy_score(y_test, y_pred))2.5.2 深度学习模型

- 卷积神经网络(CNN):CNN在图像处理领域取得了巨大成功,也可以应用于文本分类任务。可以使用TensorFlow或PyTorch来构建CNN模型。以下是一个使用TensorFlow构建简单CNN模型进行文本分类的示例代码:

python

1import tensorflow as tf

2from tensorflow.keras.models import Sequential

3from tensorflow.keras.layers import Embedding, Conv1D, GlobalMaxPooling1D, Dense

4

5# 假设vocab_size是词汇表大小,max_len是文本最大长度

6vocab_size = 10000

7max_len = 100

8embedding_dim = 100

9

10model = Sequential([

11 Embedding(vocab_size, embedding_dim, input_length=max_len),

12 Conv1D(128, 5, activation='relu'),

13 GlobalMaxPooling1D(),

14 Dense(64, activation='relu'),

15 Dense(num_classes, activation='softmax') # num_classes是类别数量

16])

17

18model.compile(optimizer='adam',

19 loss='sparse_categorical_crossentropy',

20 metrics=['accuracy'])

21

22# 假设X_train_padded和y_train是经过填充和编码的训练数据

23model.fit(X_train_padded, y_train, epochs=10, batch_size=32)- 循环神经网络(RNN)及其变体(如LSTM、GRU):RNN能够处理序列数据,适合用于文本分类任务。LSTM和GRU是RNN的变体,能够解决长序列依赖问题。以下是一个使用TensorFlow构建LSTM模型进行文本分类的示例代码:

python

1from tensorflow.keras.layers import LSTM

2

3model = Sequential([

4 Embedding(vocab_size, embedding_dim, input_length=max_len),

5 LSTM(64, return_sequences=True),

6 LSTM(32),

7 Dense(num_classes, activation='softmax')

8])

9

10model.compile(optimizer='adam',

11 loss='sparse_categorical_crossentropy',

12 metrics=['accuracy'])

13

14model.fit(X_train_padded, y_train, epochs=10, batch_size=32)2.6 模型评估

模型评估是衡量分类模型性能的重要环节。常用的评估指标有准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1值(F1-Score)等。可以使用Scikit-learn库中的metrics模块来计算这些指标。以下是一个示例代码:

python

1from sklearn.metrics import classification_report

2

3print(classification_report(y_test, y_pred))三、实验结果与分析

3.1 实验数据集

本文使用了一个包含多个类别新闻标题的数据集,数据集分为训练集和测试集,训练集用于训练分类模型,测试集用于评估模型性能。

3.2 实验结果

分别使用传统机器学习算法和深度学习模型对新闻标题进行分类,并记录不同模型的准确率、精确率、召回率和F1值。实验结果表明,深度学习模型在新闻标题分类任务上通常能够取得更好的性能,尤其是LSTM和CNN模型。

3.3 结果分析

深度学习模型能够自动学习文本中的高级特征,对语义信息有更好的理解能力,因此在新闻标题分类任务上表现更优。而传统机器学习算法在处理简单特征时表现尚可,但对于复杂的语义关系理解能力有限。

四、结论与展望

4.1 结论

本文介绍了基于Python的新闻标题自动分类系统的实现过程,包括数据获取、预处理、特征提取、分类模型构建和评估等步骤。通过实验对比了传统机器学习算法和深度学习模型在新闻标题分类任务上的性能,结果表明深度学习模型具有更好的分类效果。

4.2 展望

未来的研究可以进一步优化深度学习模型的结构,提高模型的训练效率和分类性能。同时,可以结合更多的外部知识,如新闻的发布时间、来源等,来提升新闻标题分类的准确性。此外,还可以探索如何将新闻标题自动分类技术应用到实际的新闻推荐系统中,为用户提供更加个性化的新闻推荐服务。

以上论文仅供参考,你可以根据实际研究情况进行修改和完善,增加更多具体的数据、实验细节和深入的分析讨论,以提升论文的质量。

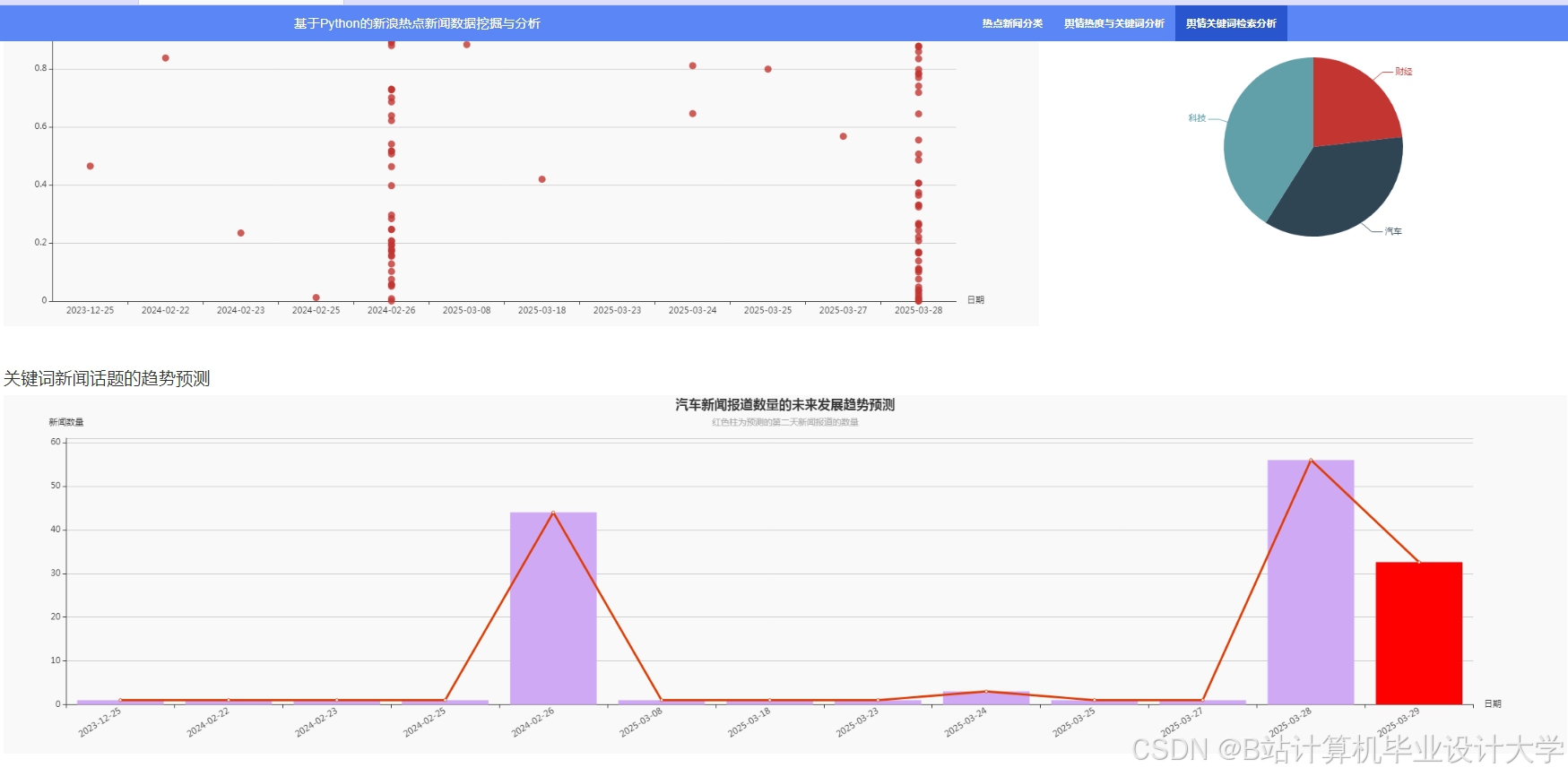

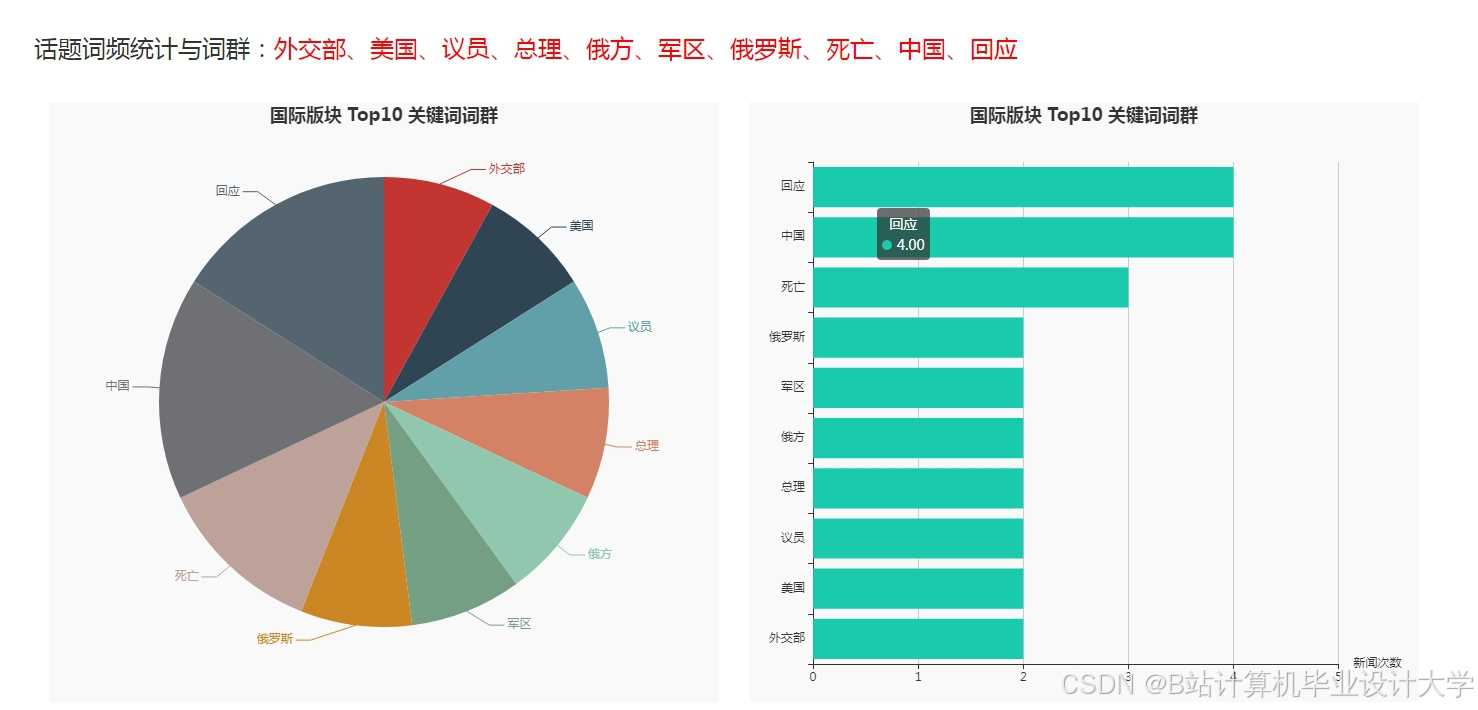

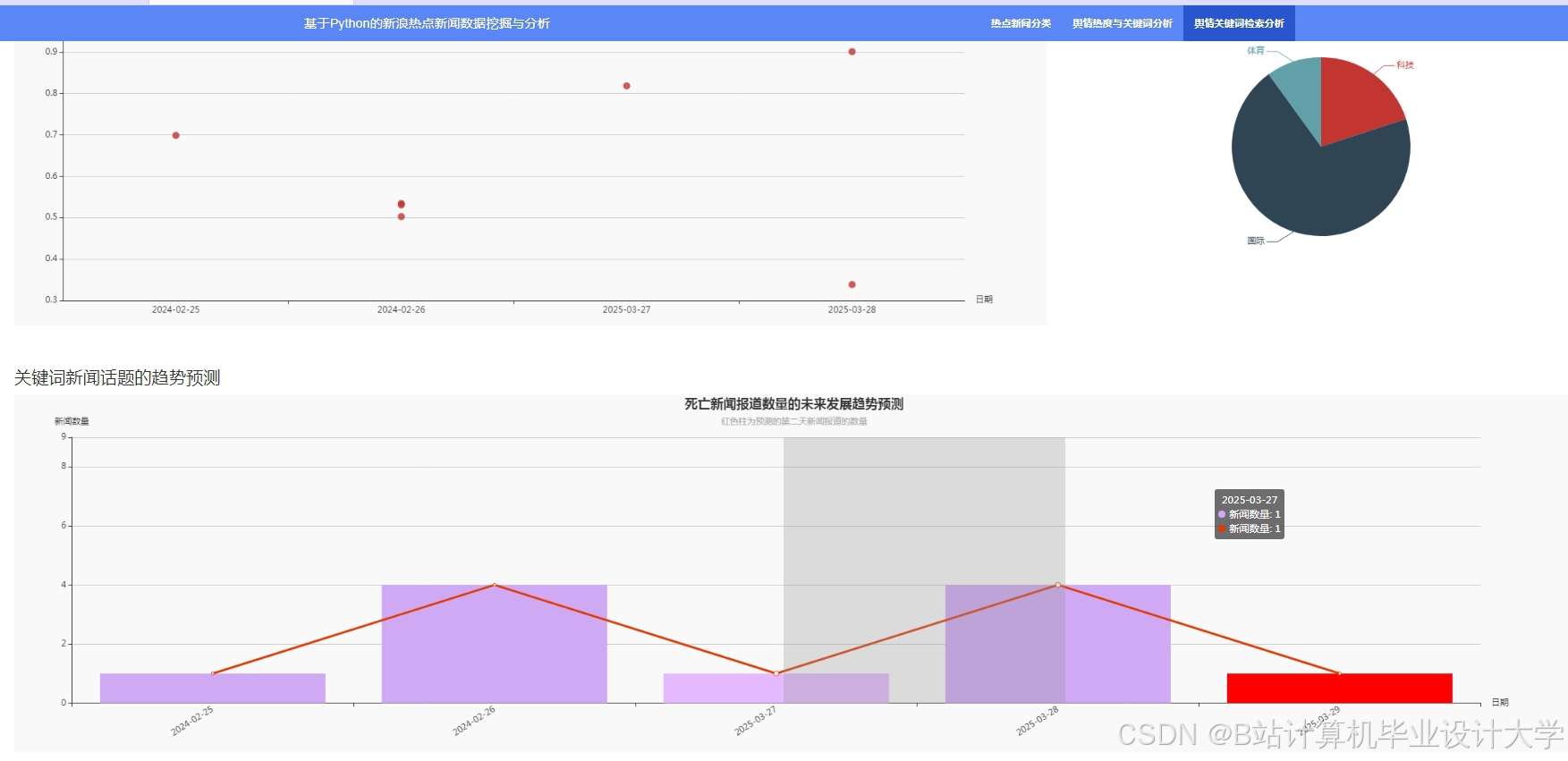

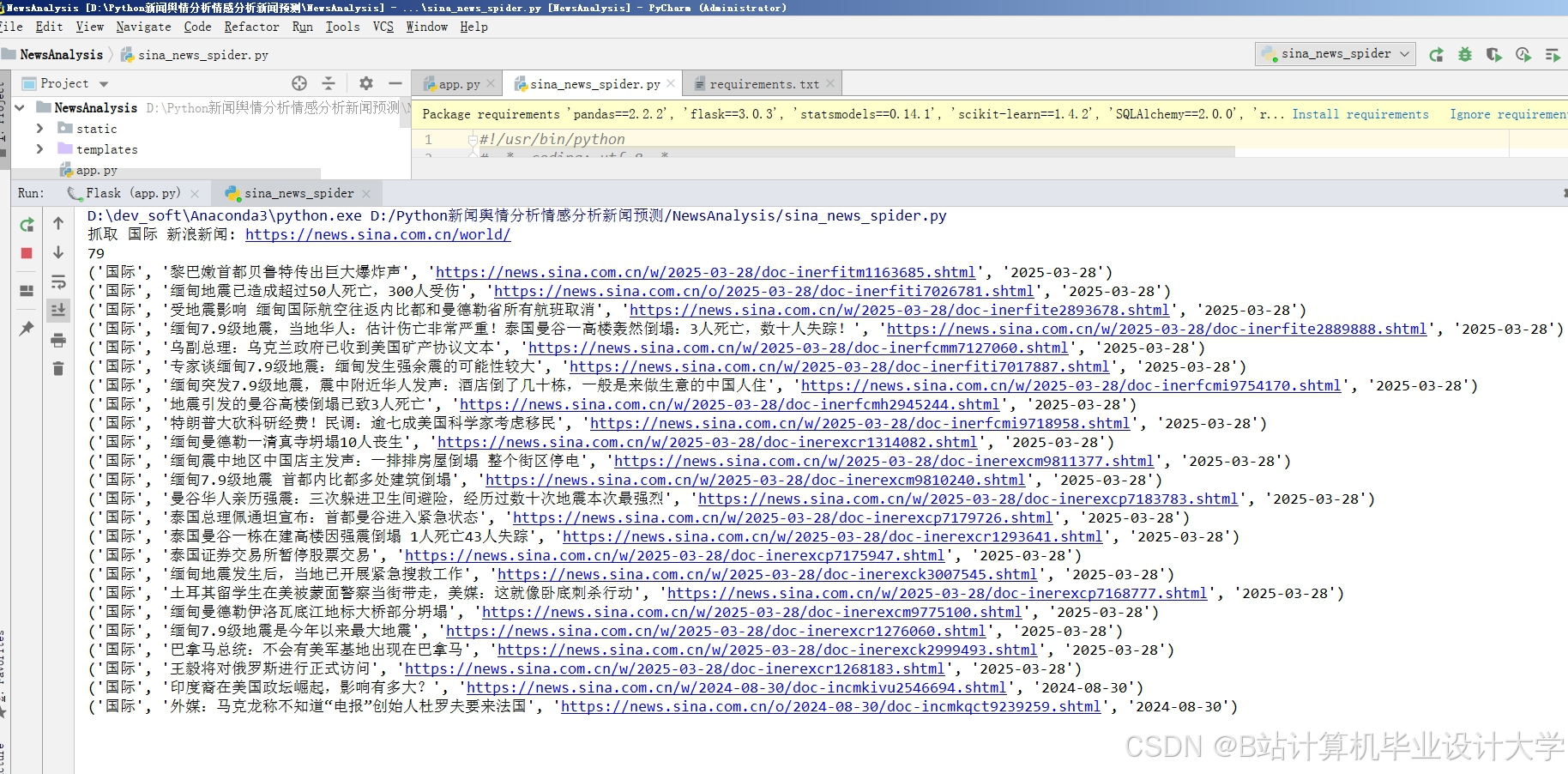

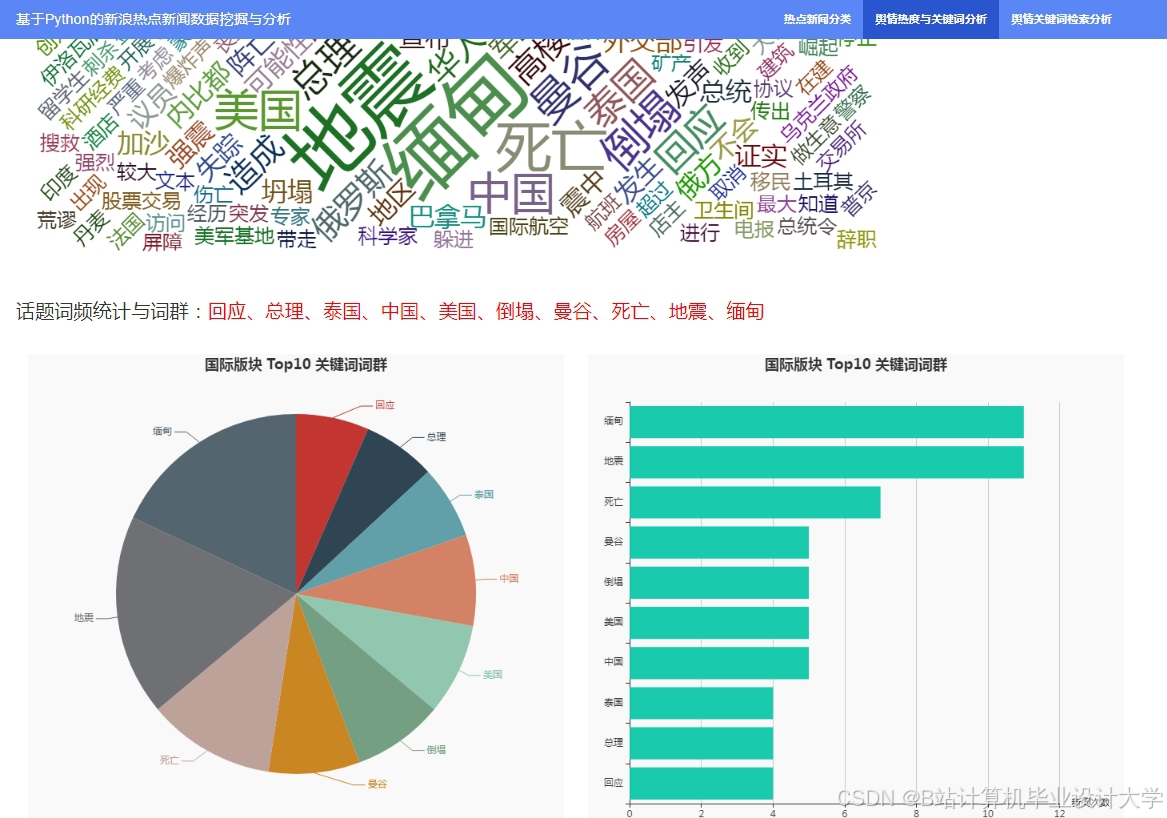

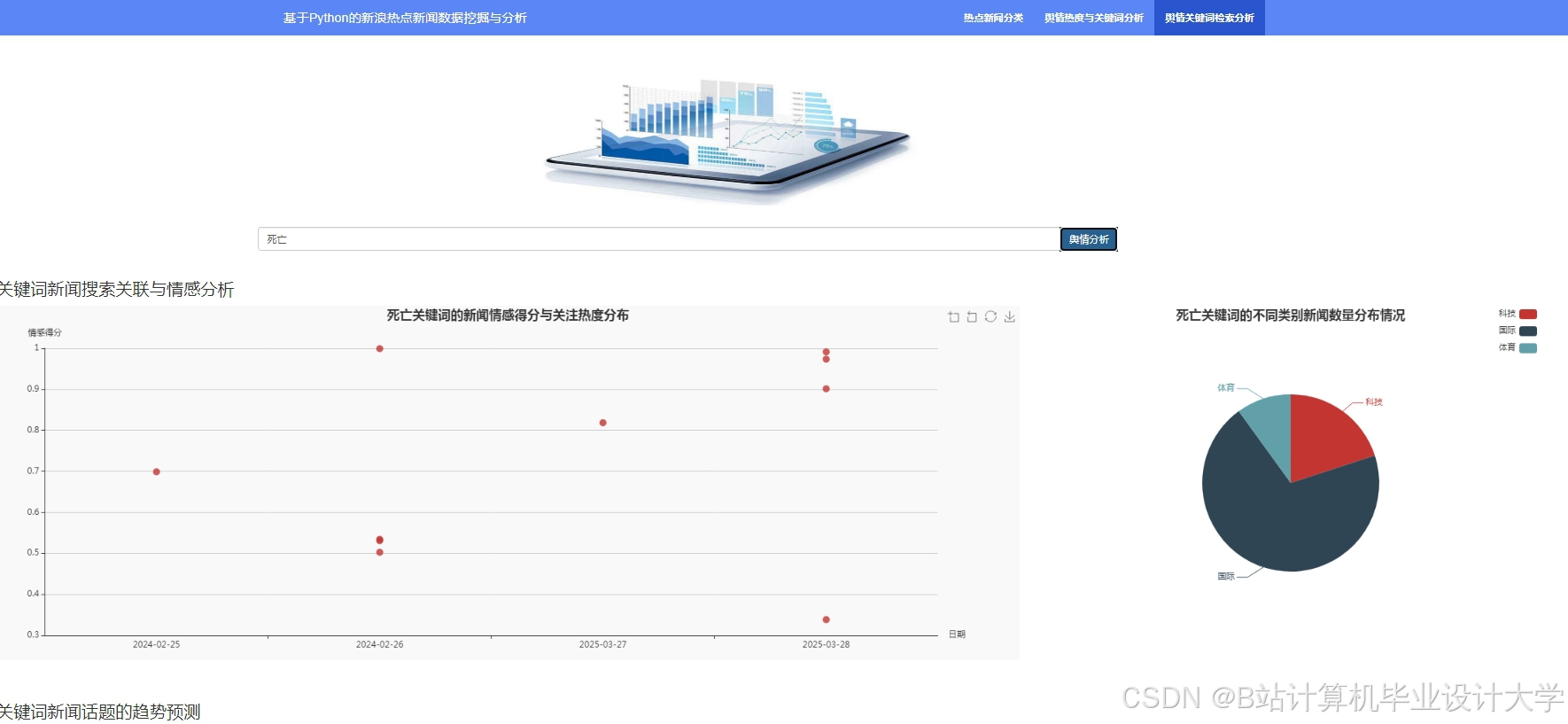

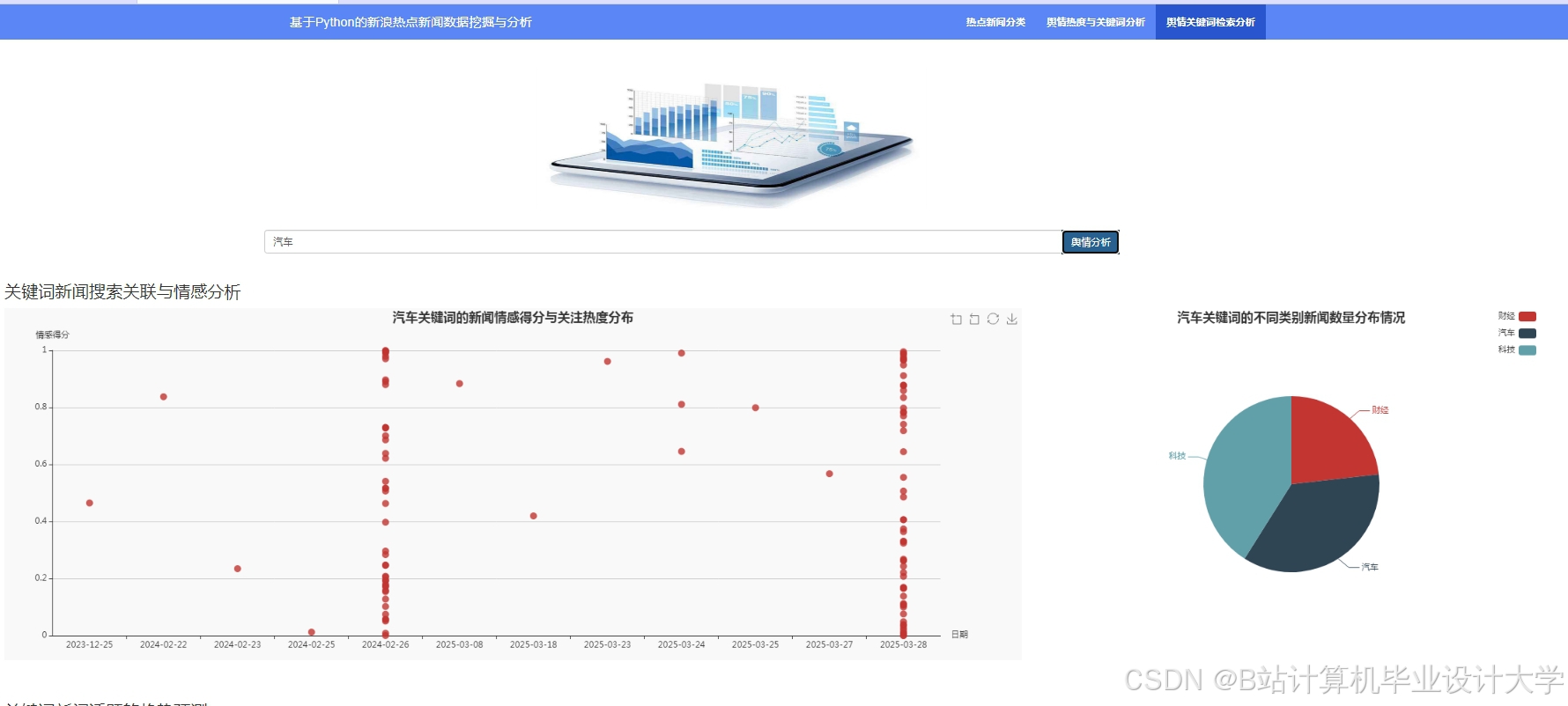

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

Python新闻标题自动分类系统

Python新闻标题自动分类系统

1879

1879

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?