温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive知网论文推荐系统》任务书

一、项目背景与意义

随着互联网技术的迅猛发展和大数据时代的全面到来,学术文献数量呈现爆炸式增长。中国知网(CNKI)作为国内领先的学术资源平台,收录了海量期刊论文、学位论文、会议论文等学术资源,覆盖各学科领域。然而,科研人员日均需浏览文献超200篇,面临严重信息过载问题。传统关键词匹配检索方式难以满足个性化需求,导致科研人员在筛选文献时耗费大量时间精力,影响科研效率。

本项目旨在利用Hadoop分布式存储、Spark高效计算及Hive数据查询分析能力,构建基于大数据技术的知网论文推荐系统。通过挖掘用户兴趣与论文特征的关联,实现个性化、精准化的文献推荐,提升科研人员获取相关资源的效率,促进学术知识传播与创新。

二、项目目标

- 技术目标:整合Hadoop、Spark、Hive技术,构建分布式论文推荐系统原型,实现高效数据处理与实时推荐能力。

- 功能目标:开发用户管理、文献检索、个性化推荐、可视化分析等核心功能模块,支持用户注册登录、历史行为记录、推荐结果展示等交互需求。

- 性能目标:系统需具备高扩展性,支持千万级论文数据存储与秒级响应,推荐准确率不低于85%,召回率不低于80%。

- 应用目标:为学术机构提供高效文献推荐工具,降低科研人员信息检索成本,提升学术资源利用率。

三、项目任务分解

(一)需求分析与系统设计

- 需求调研:与科研人员、知网平台管理人员沟通,明确功能需求(如推荐精度、响应速度)、性能要求(如并发处理能力)及使用习惯。

- 系统架构设计:采用分层架构,包含数据采集层(Scrapy爬虫)、数据存储层(HDFS+Hive)、数据处理层(Spark清洗与特征提取)、推荐算法层(混合推荐模型)、应用展示层(Flask+Vue.js)。

- 模块划分:定义用户管理、数据采集与预处理、推荐算法、结果展示等模块,明确接口规范与数据传输方式。

(二)数据采集与预处理

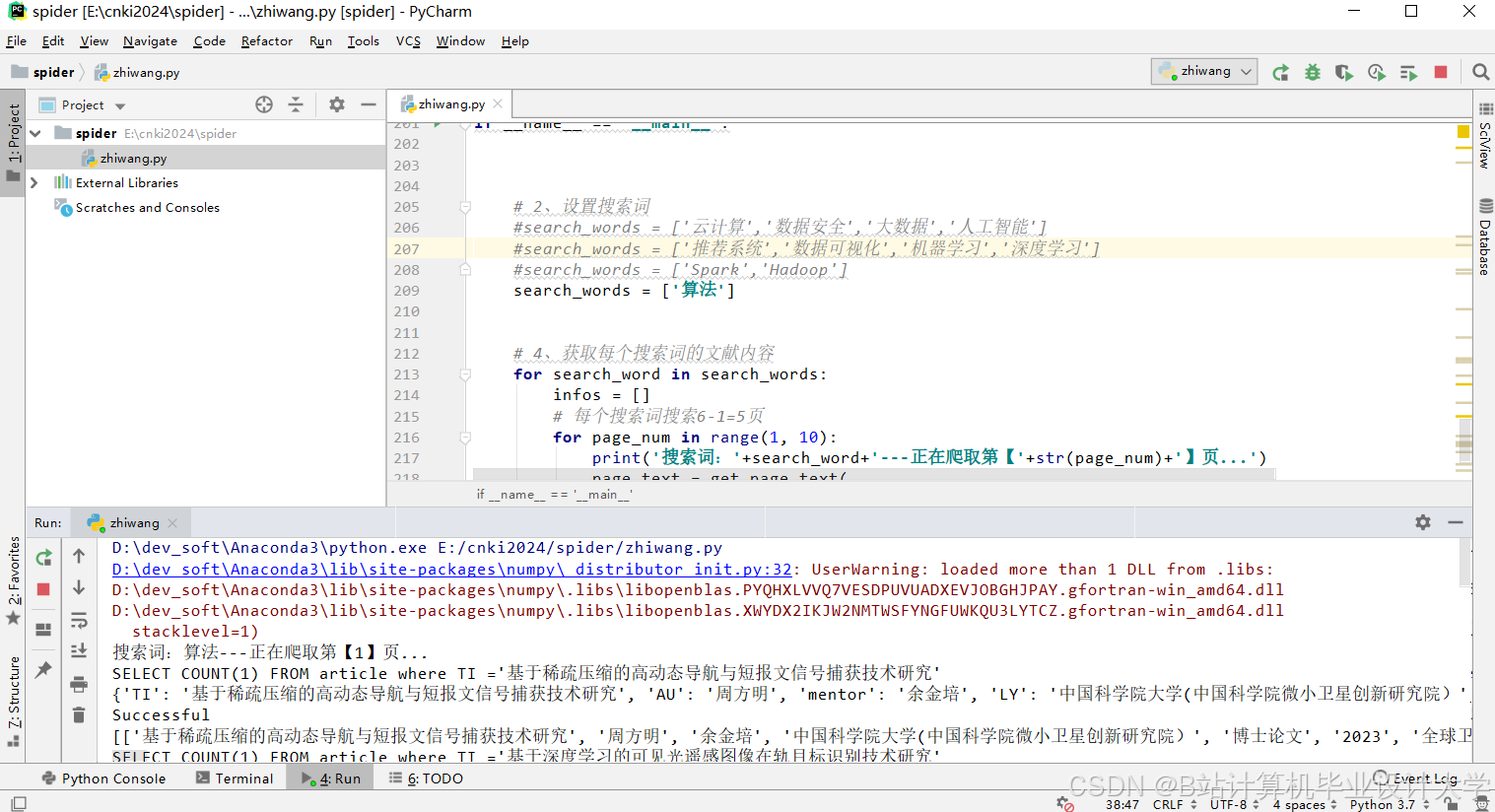

- 数据采集:使用Scrapy框架抓取知网论文元数据(标题、作者、摘要、关键词、引用关系)及用户行为数据(浏览、收藏、下载记录)。

- 数据清洗:通过Spark去除重复数据、修正格式错误、处理缺失值(均值填充/删除记录)。

- 特征提取:利用TF-IDF、Doc2Vec生成文本向量,Spark GraphX构建引用网络,统计作者论文数量、引用量等特征。

(三)推荐算法研究与实现

- 算法选型:结合基于内容的推荐(余弦相似度)、协同过滤(ALS矩阵分解)、深度学习推荐(DNN模型),引入知识图谱嵌入(TransE算法)丰富特征。

- 混合推荐模型:采用动态权重融合机制,平衡文本特征、引用特征、用户行为特征的贡献,优化推荐多样性。

- 模型训练:在Spark MLlib中实现算法,通过交叉验证调整超参数,提升F1分数。

(四)系统开发与集成

- 后端开发:基于Spring Boot框架构建RESTful API,处理用户请求与数据库交互(MySQL存储用户信息)。

- 前端开发:使用Vue.js实现响应式界面,集成Echarts可视化用户行为数据(阅读兴趣分布、热门论文推荐)。

- 系统集成:连接Hadoop集群(3节点)、Spark计算引擎(内存优化配置)、Hive数据仓库,确保模块间数据流通。

(五)系统测试与优化

- 功能测试:验证用户注册、文献检索、推荐结果展示等功能的正确性。

- 性能测试:模拟并发访问,测试响应时间、吞吐量,优化HDFS块大小与Spark并行度。

- 用户体验测试:邀请科研人员试用,收集反馈调整界面布局与推荐策略。

四、项目资源与计划

(一)人力资源

- 项目负责人:1名,统筹规划与协调。

- 需求分析师:1名,负责需求调研与文档编写。

- 系统架构师:1名,设计技术方案与选型。

- 数据工程师:2名,处理数据采集与存储。

- 算法工程师:2名,实现推荐模型与优化。

- 前端开发工程师:1名,开发用户界面。

- 后端开发工程师:2名,构建服务端逻辑。

- 测试工程师:1名,执行系统测试。

(二)硬件资源

- 服务器:5台Linux服务器,部署Hadoop/Spark/Hive集群及后端服务。

- 存储设备:配置足够磁盘空间存储论文数据与中间结果。

(三)软件资源

- 开发工具:IntelliJ IDEA、PyCharm、Eclipse。

- 大数据框架:Hadoop 3.3.4、Spark 3.5.0、Hive 3.1.3。

- 数据库:MySQL 8.0存储结构化数据。

(四)项目计划

- 第1-2月:完成文献综述、需求分析,确定技术路线。

- 第3-4月:搭建开发环境,实现数据采集与预处理模块。

- 第5-6月:开发推荐算法模型,完成初步集成。

- 第7-8月:执行系统测试,优化性能瓶颈。

- 第9-10月:撰写论文,准备答辩材料。

五、风险管理与应对措施

- 技术风险:大数据处理与推荐算法实现可能遇阻。应对:前期技术调研,组织团队培训,必要时引入外部专家。

- 数据风险:知网数据不完整或更新延迟。应对:建立数据质量检查机制,与知网签订数据更新协议。

- 人员风险:团队成员离职影响进度。应对:制定人员备份计划,加强团队凝聚力建设。

- 进度风险:项目延期。应对:制定详细甘特图,定期监控进度,调整资源分配。

六、预期成果

- 系统原型:完成基于Hadoop+Spark+Hive的论文推荐系统,支持千万级数据实时推荐。

- 学术论文:发表1-2篇核心期刊论文,分享算法优化与系统设计经验。

- 知识产权:申请软件著作权,保护系统技术成果。

- 应用价值:为高校图书馆、科研机构提供可复用的推荐系统解决方案,推动学术资源高效利用。

项目负责人签字:_________________

日期:2025年11月2日

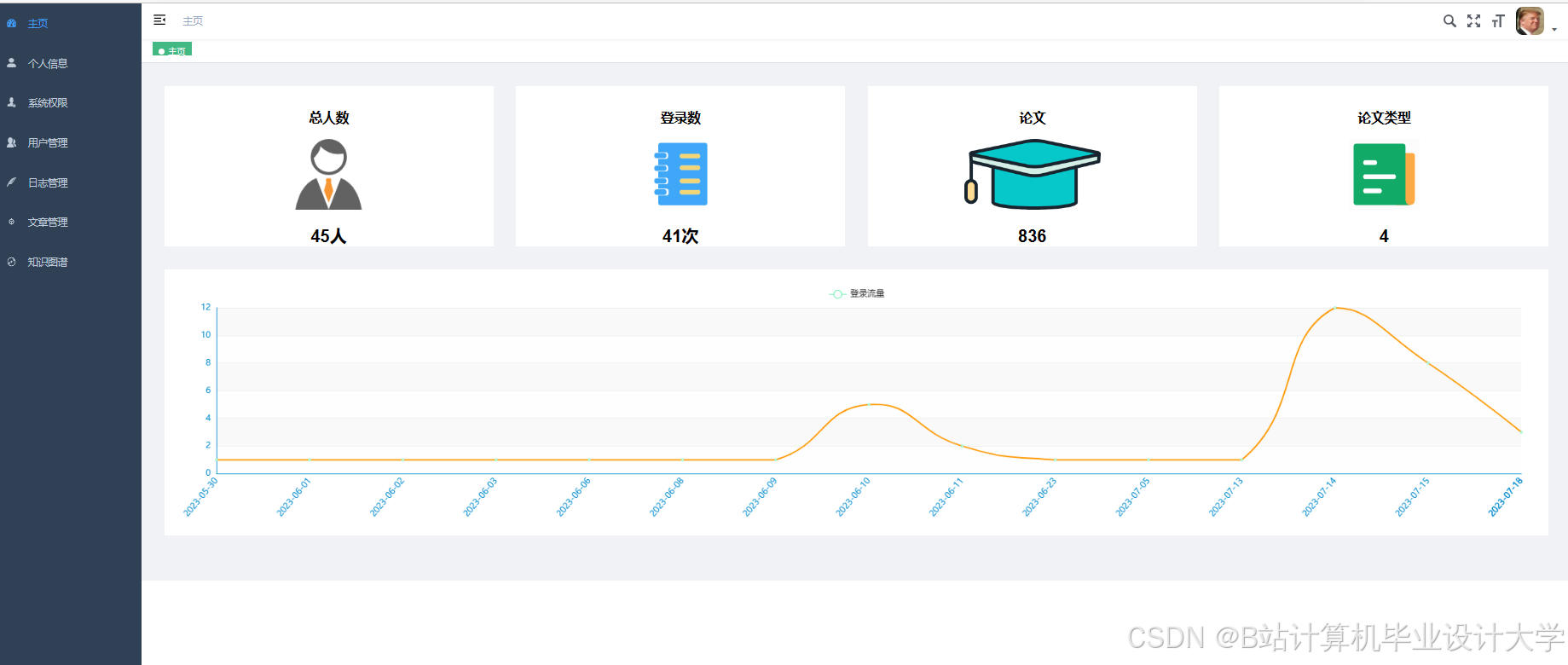

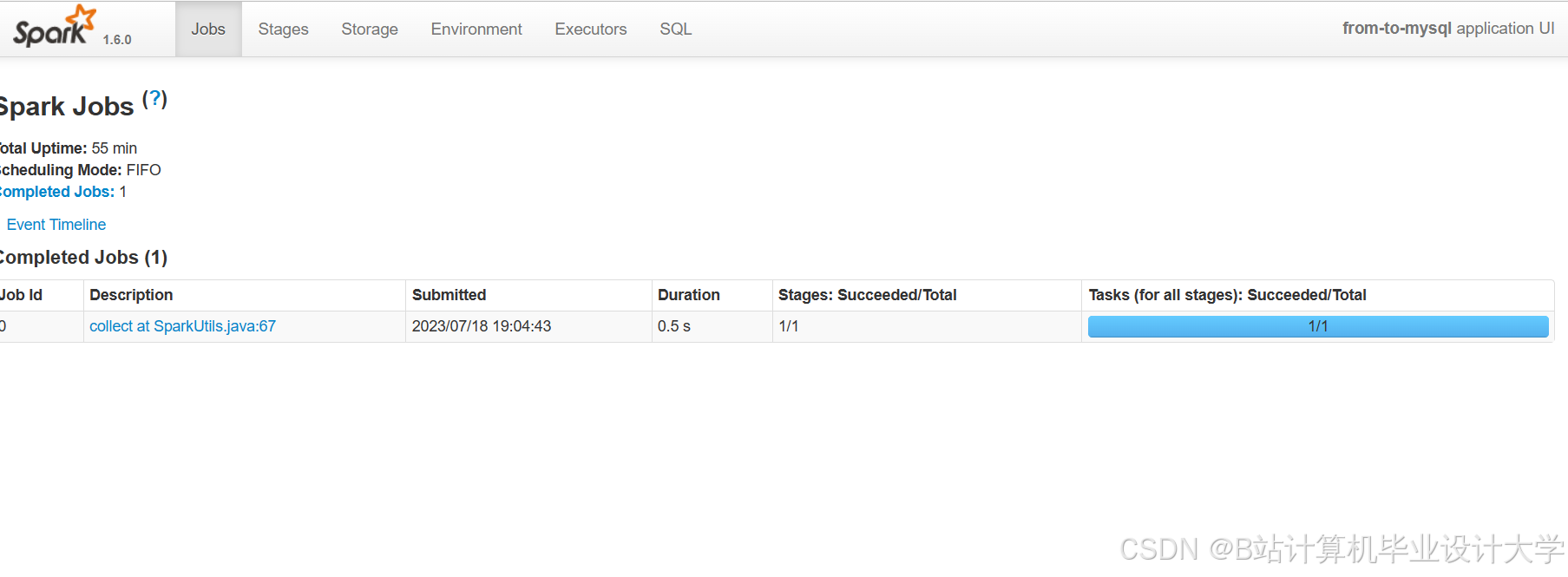

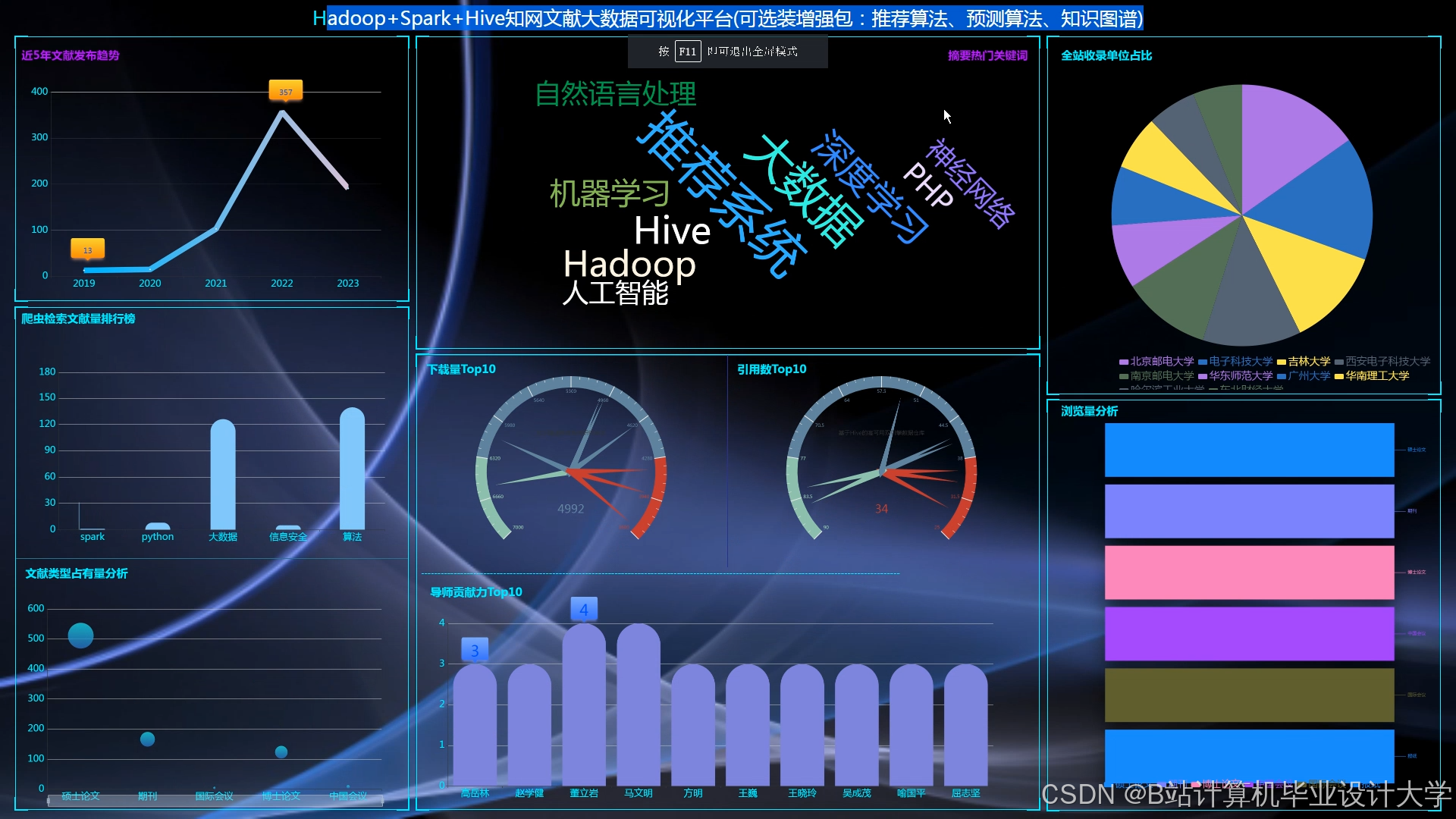

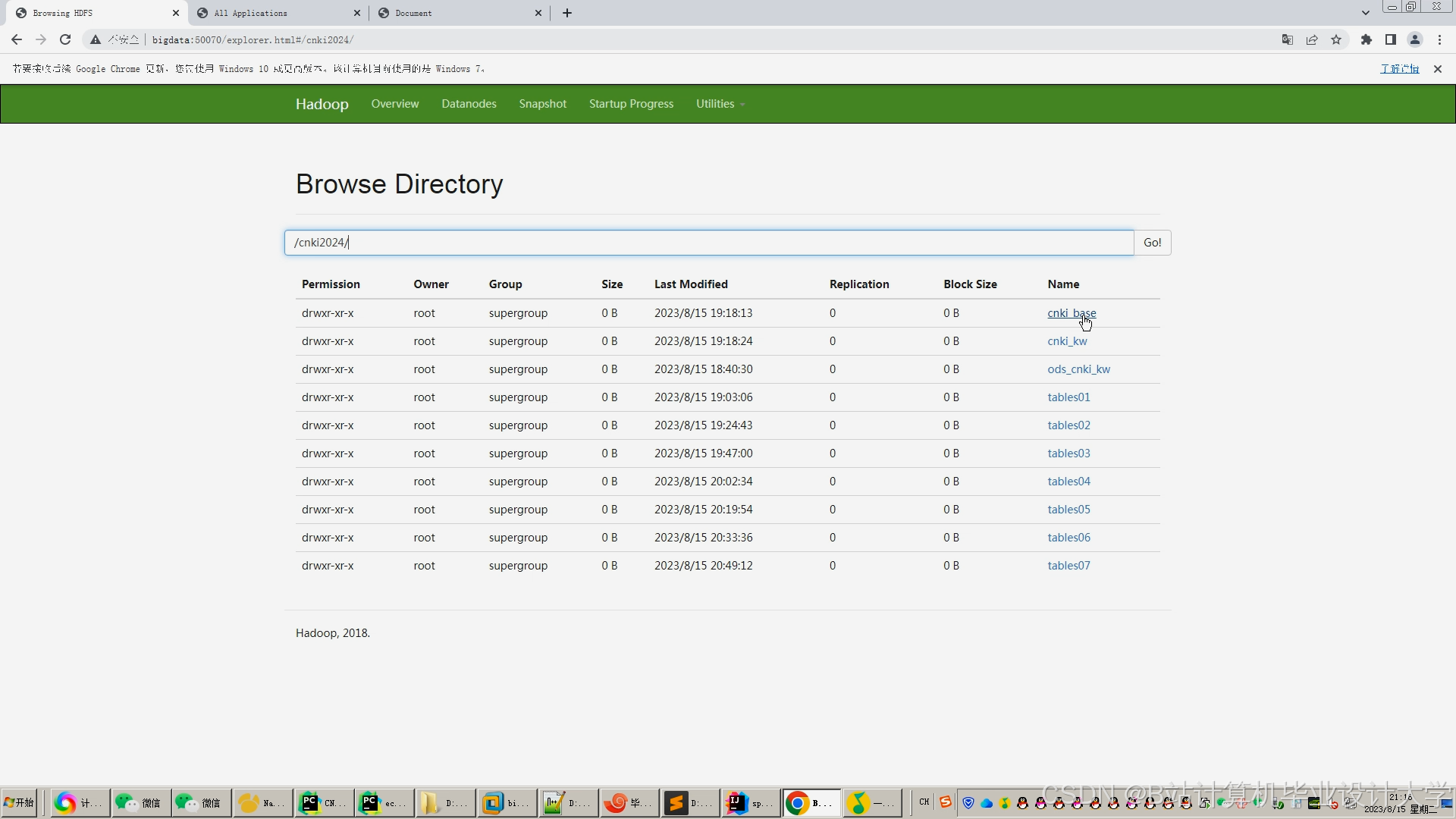

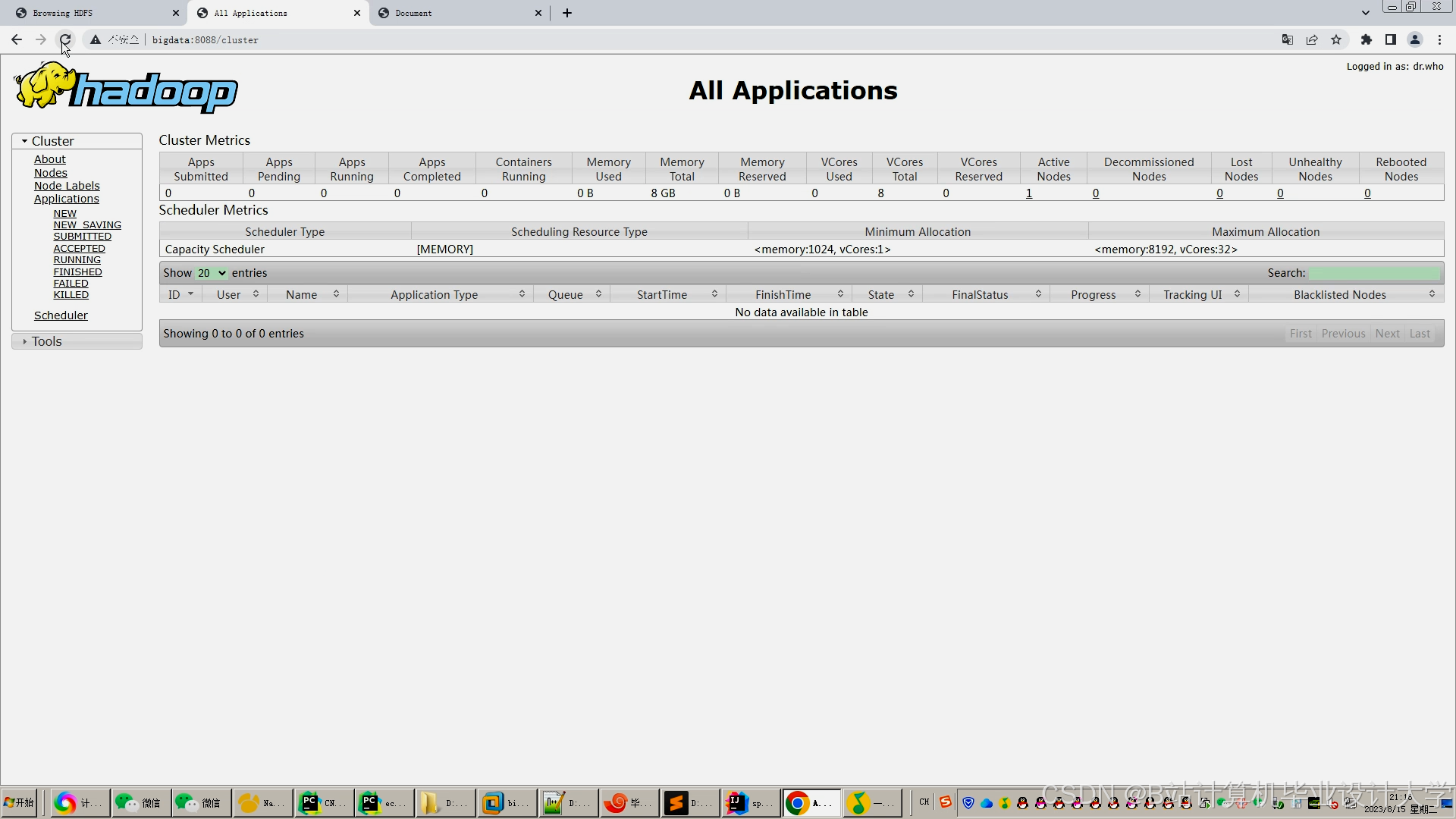

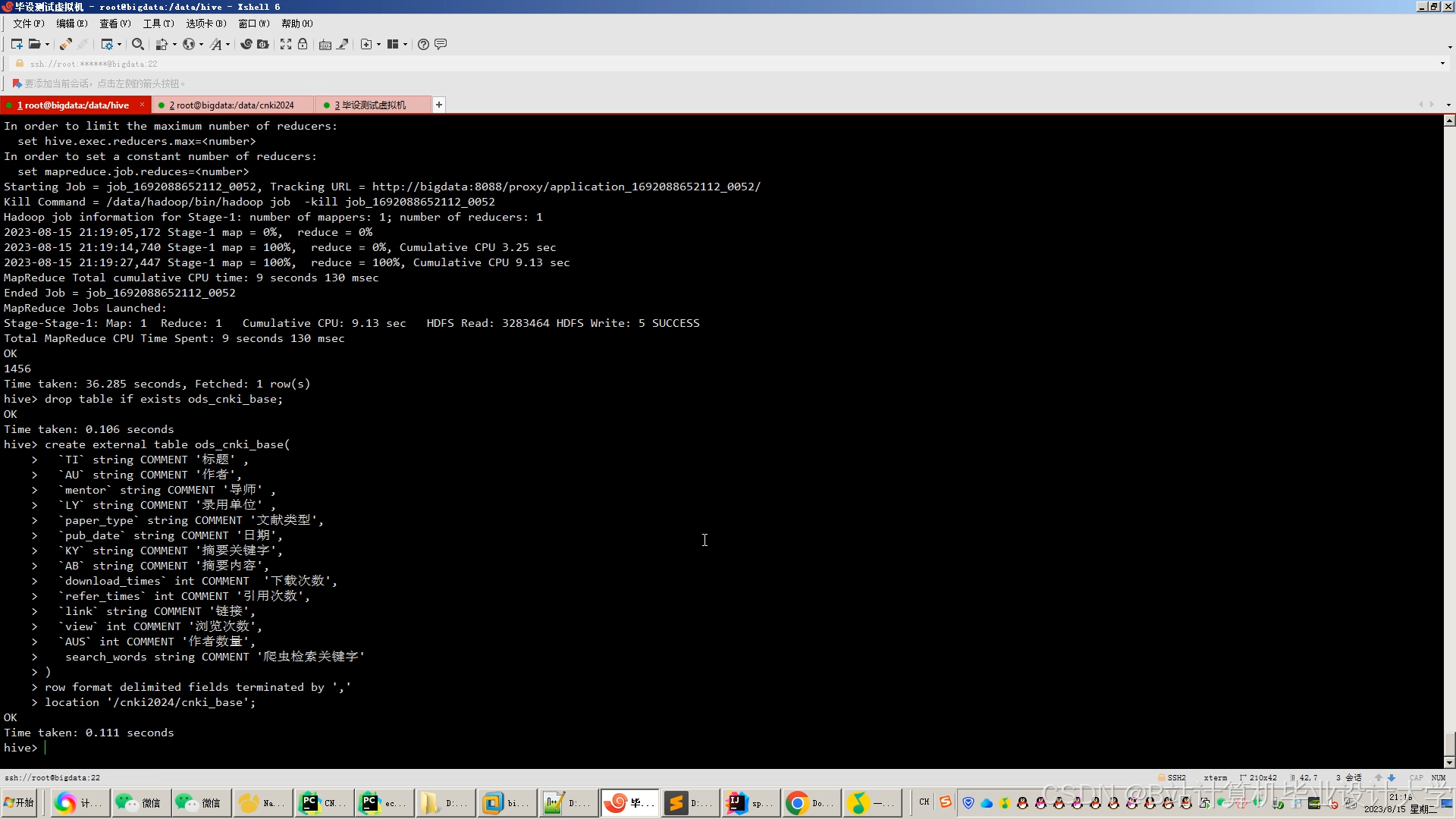

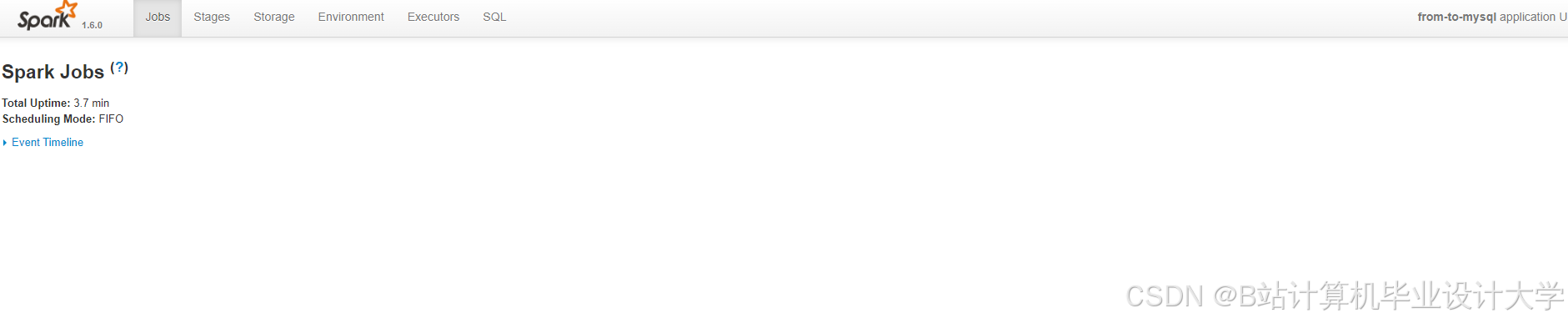

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

441

441

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?