温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《PyFlink+PySpark+Hadoop+Hive物流预测系统》的任务书模板,涵盖项目背景、技术架构、功能模块、任务分解及实施计划等内容:

任务书:基于PyFlink+PySpark+Hadoop+Hive的物流预测系统

项目名称:大数据驱动的物流时效与成本预测系统

项目周期:20周

负责人:[填写姓名]

团队成员:[数据工程师、算法工程师、后端开发、测试工程师、领域专家(物流运营)]

一、项目背景与目标

- 背景

- 物流行业面临时效性要求高、成本波动大、异常事件频发(如天气、交通管制)等挑战。

- 传统预测方法依赖历史均值或简单回归,难以捕捉动态因素(如实时路况、订单突发)。

- 大数据技术(Hadoop/Hive)可整合多源异构数据(订单、车辆GPS、天气、历史运价),PyFlink/PySpark支持实时与批量分析。

- 目标

- 构建一个覆盖“运输时效预测”和“成本动态估算”的物流预测系统,实现:

- 实时预测货物到达时间(ETA),误差≤2小时;

- 动态估算运输成本(燃油、路桥费、异常附加费),误差≤5%;

- 支持全局优化(如路线重规划、运力调度)。

- 构建一个覆盖“运输时效预测”和“成本动态估算”的物流预测系统,实现:

二、技术架构设计

- 数据层

- 数据源:

- 订单数据:发货地、目的地、货物重量/体积、时效要求(MySQL/API);

- 车辆数据:GPS轨迹、车载传感器数据(速度、油耗)(Kafka实时流);

- 外部数据:天气预报、交通事件(高德/百度地图API)、燃油价格(第三方数据平台)。

- 数据存储:

- HDFS存储原始数据(日志、GPS点位);

- Hive构建数据仓库(订单事实表、车辆状态表、外部因子表)。

- 数据源:

- 计算层

- 批处理计算:

- PySpark处理历史数据(如训练时效预测模型、成本回归模型);

- HiveQL聚合统计(如计算各线路平均耗时、成本构成)。

- 实时计算:

- PyFlink处理车辆GPS流数据(计算实时位置、预计剩余时间);

- 结合Redis缓存热门路线预测结果。

- 批处理计算:

- 算法层

- 时效预测算法:

- 时间序列模型(Prophet处理周期性因素);

- 图神经网络(GNN建模路线网络中的拥堵传播);

- 集成学习(XGBoost融合天气、交通、历史时效特征)。

- 成本估算算法:

- 线性回归(基础运费+动态因子加权);

- 强化学习(动态调整运价以平衡利润与市场竞争力)。

- 时效预测算法:

- 服务层

- 预测API服务(gRPC封装);

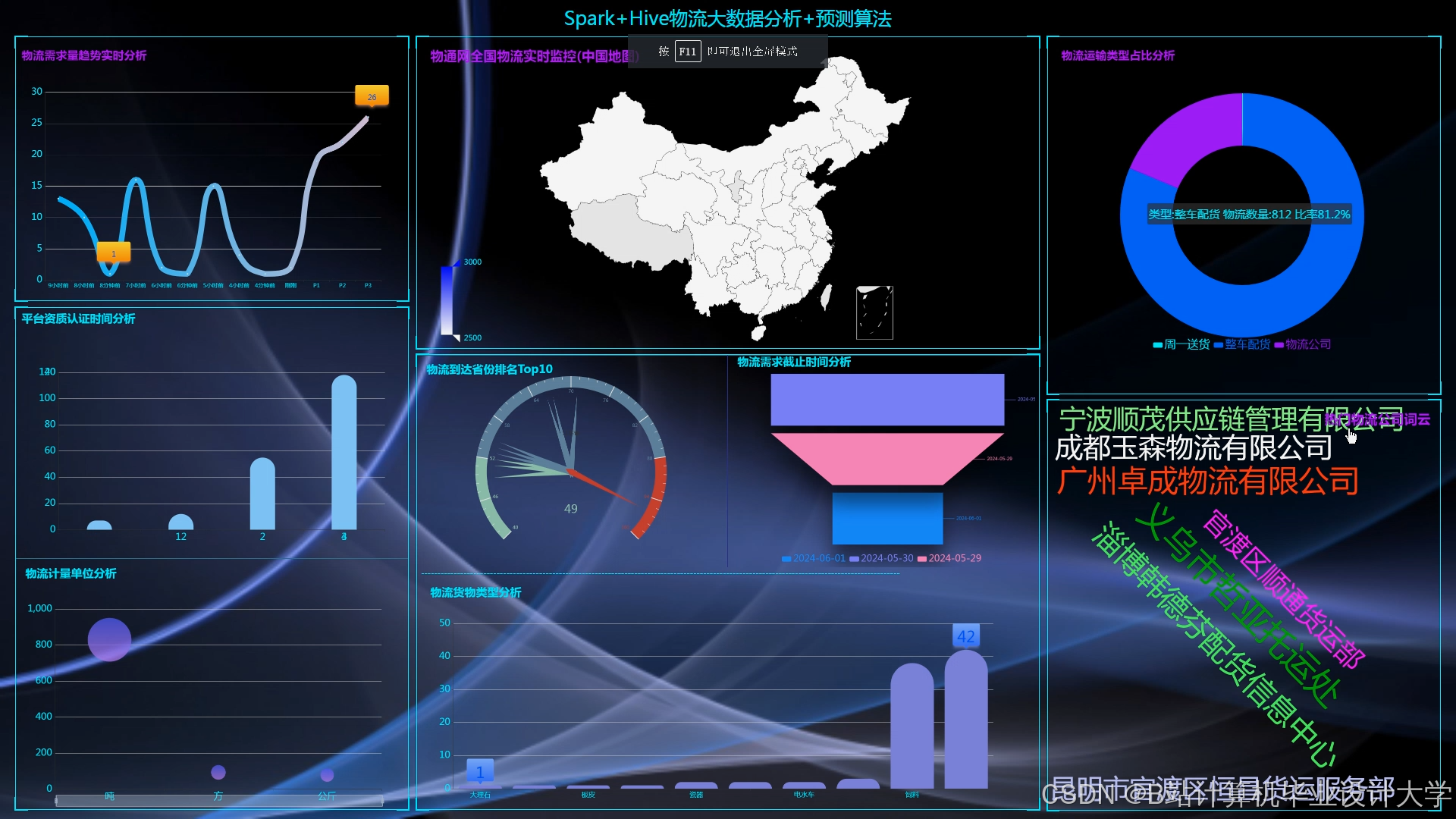

- 可视化看板(ECharts展示预测结果与历史对比);

- 异常告警(邮件/短信通知延迟或成本超支)。

三、功能模块设计

| 模块 | 功能描述 |

|---|---|

| 数据采集模块 | 实时采集车辆GPS(Kafka)、同步订单数据(Flume)、调用外部API(天气/交通事件) |

| 数据处理模块 | 批处理(PySpark清洗异常订单、补全缺失GPS点位)、流处理(PyFlink过滤无效轨迹) |

| 预测引擎模块 | 时效预测(多模型融合)、成本估算(动态因子调整)、异常检测(基于孤立森林算法) |

| 优化调度模块 | 路线重规划(遗传算法优化多订单拼车)、运力分配(贪心算法匹配车辆与货物) |

| 用户交互模块 | 运营端(预测结果审批、手动调整)、司机端(APP推送ETA与路线建议) |

| 运维管理模块 | 集群监控(Node Exporter+Prometheus)、模型版本管理(MLflow)、日志追溯(ELK) |

四、任务分解与时间安排

| 阶段 | 任务内容 | 时间 | 交付物 |

|---|---|---|---|

| 第1-3周 | 需求分析与数据调研 - 梳理物流业务流(订单→调度→运输→签收) - 确定关键预测指标(ETA误差率、成本波动率) | 3周 | 需求文档、数据字典 |

| 第4-5周 | 环境搭建与数据接入 - 部署Hadoop集群(8节点) - 配置Hive元数据存储 - 开发Kafka生产者(车辆GPS模拟器) | 2周 | 可运行的集群环境、模拟数据源 |

| 第6-7周 | 数据预处理与特征工程 - PySpark清洗订单数据(去重、异常值处理) - 构建时空特征(如“发货地-目的地”对的历史耗时) | 2周 | 清洗后的数据集、特征表结构 |

| 第8-10周 | 时效预测模型开发 - PySpark MLlib实现Prophet基线模型 - 训练GNN模型(PyG库) - 模型融合(加权投票) | 3周 | 训练好的模型文件、评估报告 |

| 第11-12周 | 成本估算模型开发 - 线性回归模型(基础运费+动态因子) - 强化学习模拟环境(OpenAI Gym) | 2周 | 成本模型代码、仿真结果 |

| 第13-14周 | 实时预测流程开发 - PyFlink处理车辆GPS流(窗口聚合计算剩余里程) - 动态更新ETA(每10分钟刷新) | 2周 | 实时预测逻辑代码、测试用例 |

| 第15-16周 | 异常检测与优化调度 - 孤立森林算法检测异常延迟 - 遗传算法优化拼车路线(减少空驶率) | 2周 | 异常处理规则、调度算法代码 |

| 第17-18周 | 系统集成与API封装 - gRPC封装预测接口 - 开发可视化看板(ECharts+Vue.js) | 2周 | 可交互的预测原型、API文档 |

| 第19-20周 | 测试与上线 - 压力测试(模拟10万订单/日) - A/B测试(对比新旧预测系统准确率) - 编写运维手册 | 2周 | 测试报告、部署文档、监控看板 |

五、预期成果

- 核心指标:

- ETA预测准确率≥90%(MAE≤2小时);

- 成本估算误差率≤5%(对比实际结算单)。

- 业务价值:

- 减少15%的运输延迟投诉;

- 降低8%的空驶率与燃油浪费。

六、风险评估与应对

- 数据质量问题:

- 风险:GPS信号丢失导致轨迹中断。

- 应对:插值算法补全缺失点位,结合历史路线模式修正。

- 模型泛化性不足:

- 风险:新路线或极端天气下预测偏差大。

- 应对:引入迁移学习(预训练模型+少量新数据微调)。

- 实时计算延迟:

- 风险:PyFlink任务积压导致ETA更新不及时。

- 应对:优化窗口策略(如事件时间触发),增加并行度。

七、资源需求

- 硬件:

- 服务器:8台(配置:32核CPU、256GB内存、8TB硬盘);

- 网络:专线接入高德地图API(低延迟要求)。

- 软件:

- 大数据组件:Hadoop 3.3、PySpark 3.4、PyFlink 1.17、Hive 3.1;

- 机器学习库:Scikit-learn、PyTorch Geometric(GNN)、Optuna(超参优化);

- 开发工具:IntelliJ IDEA、Postman、DBeaver。

- 数据:

- 模拟数据集:100万条历史订单、5000辆车辆GPS轨迹(可通过合作物流企业获取脱敏数据)。

项目负责人签字:_________________

日期:_________________

备注:可扩展功能包括碳排放估算(结合车辆型号与里程)、与TMS(运输管理系统)对接实现自动调度。

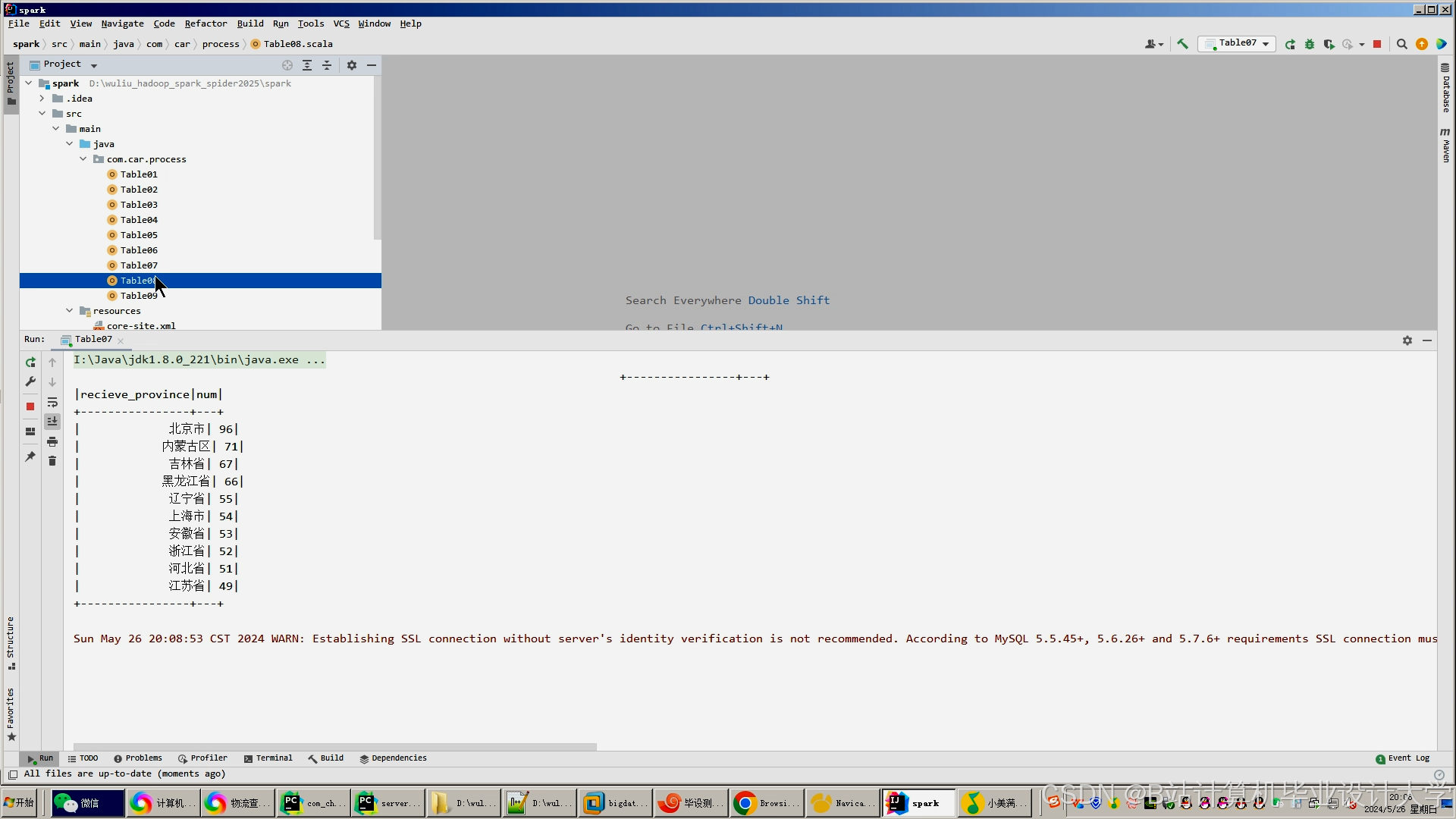

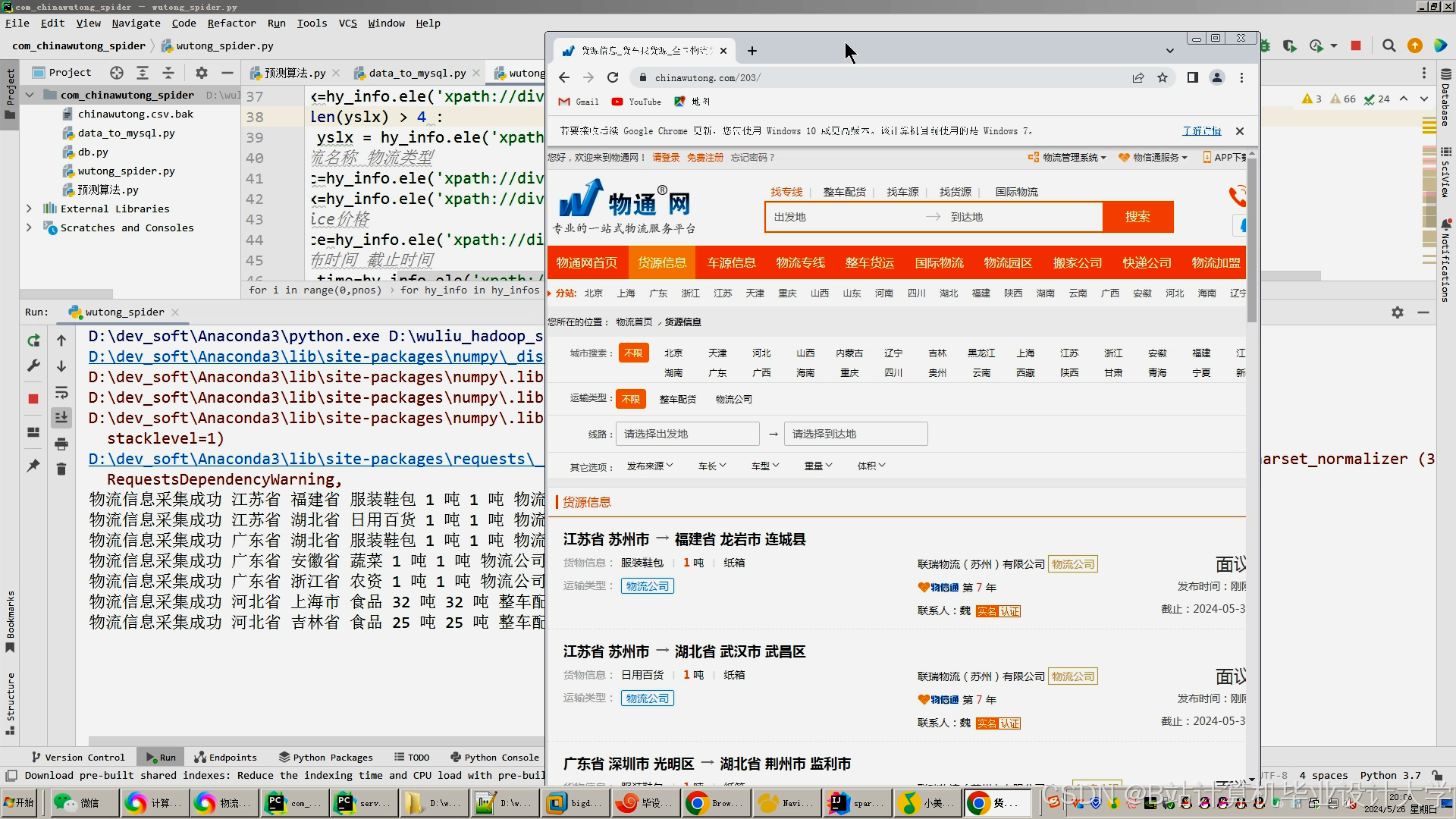

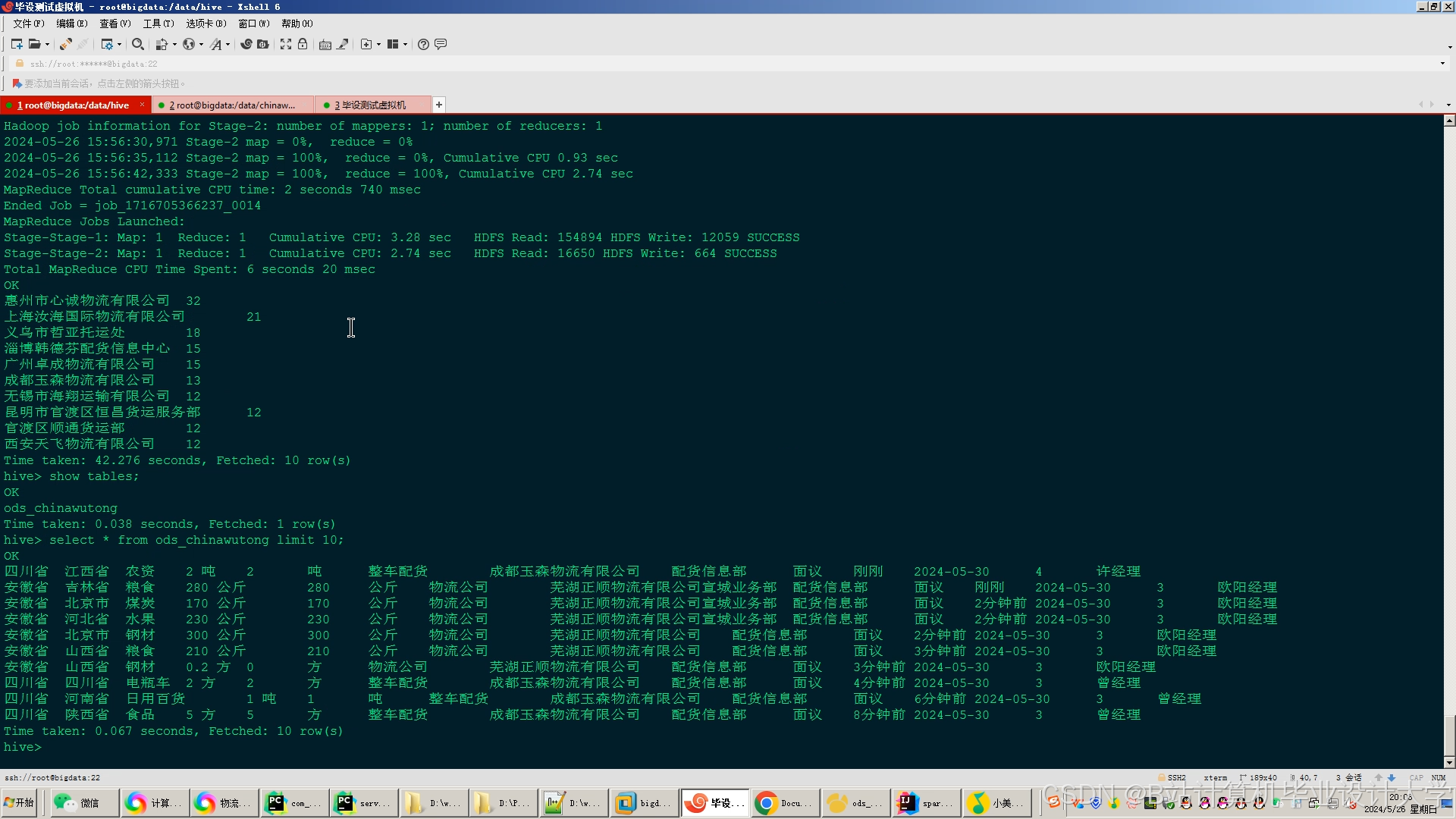

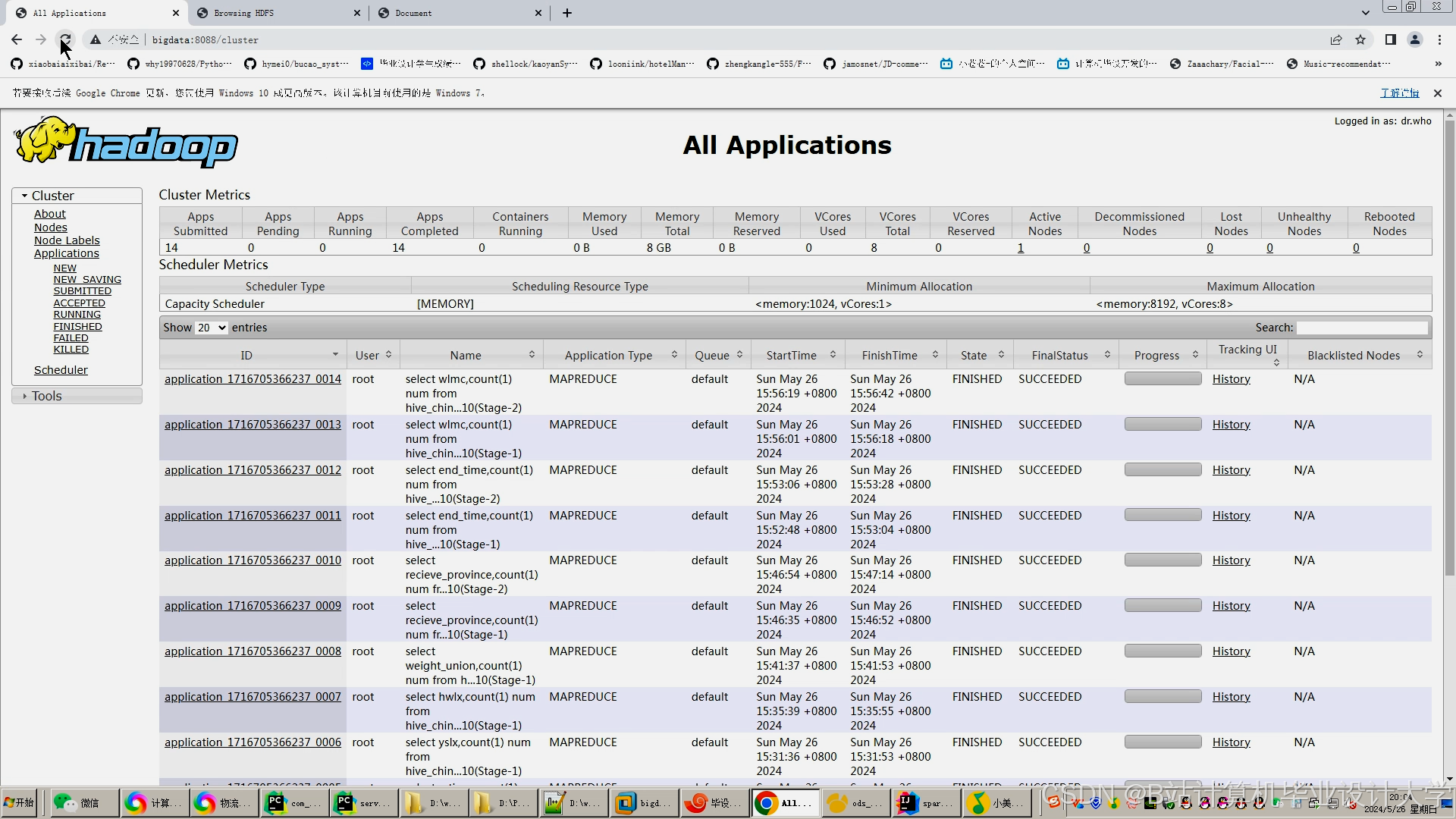

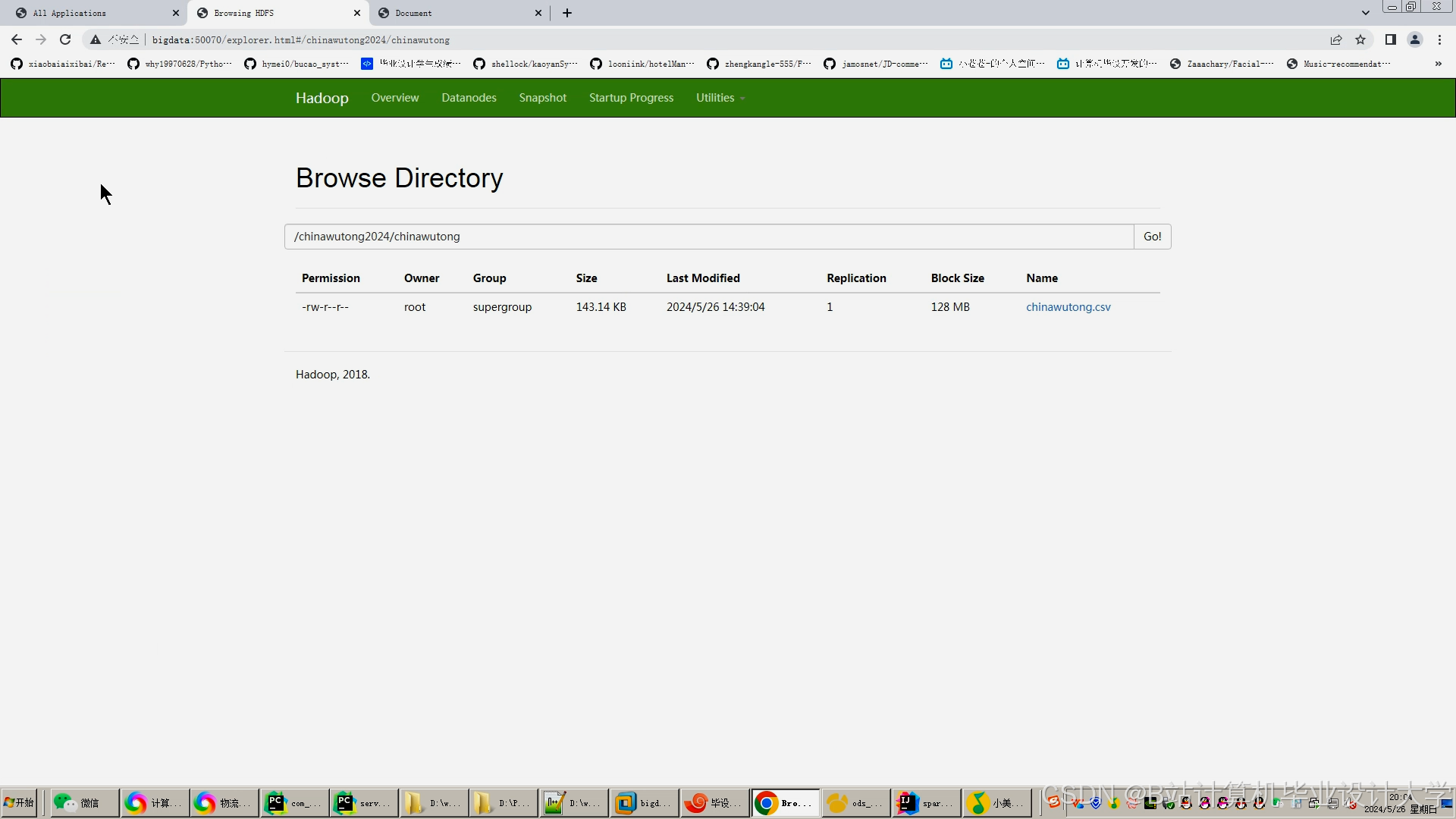

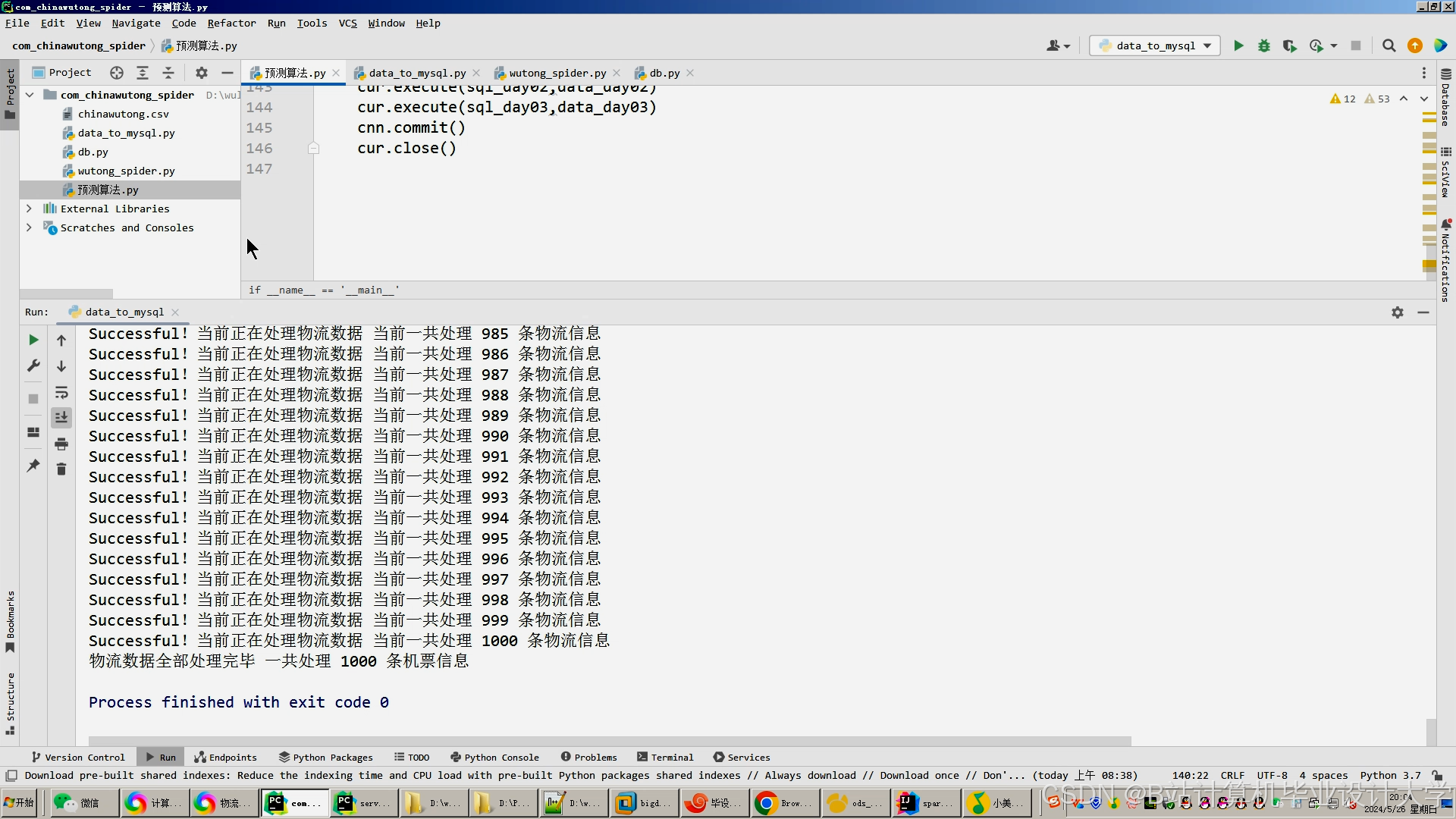

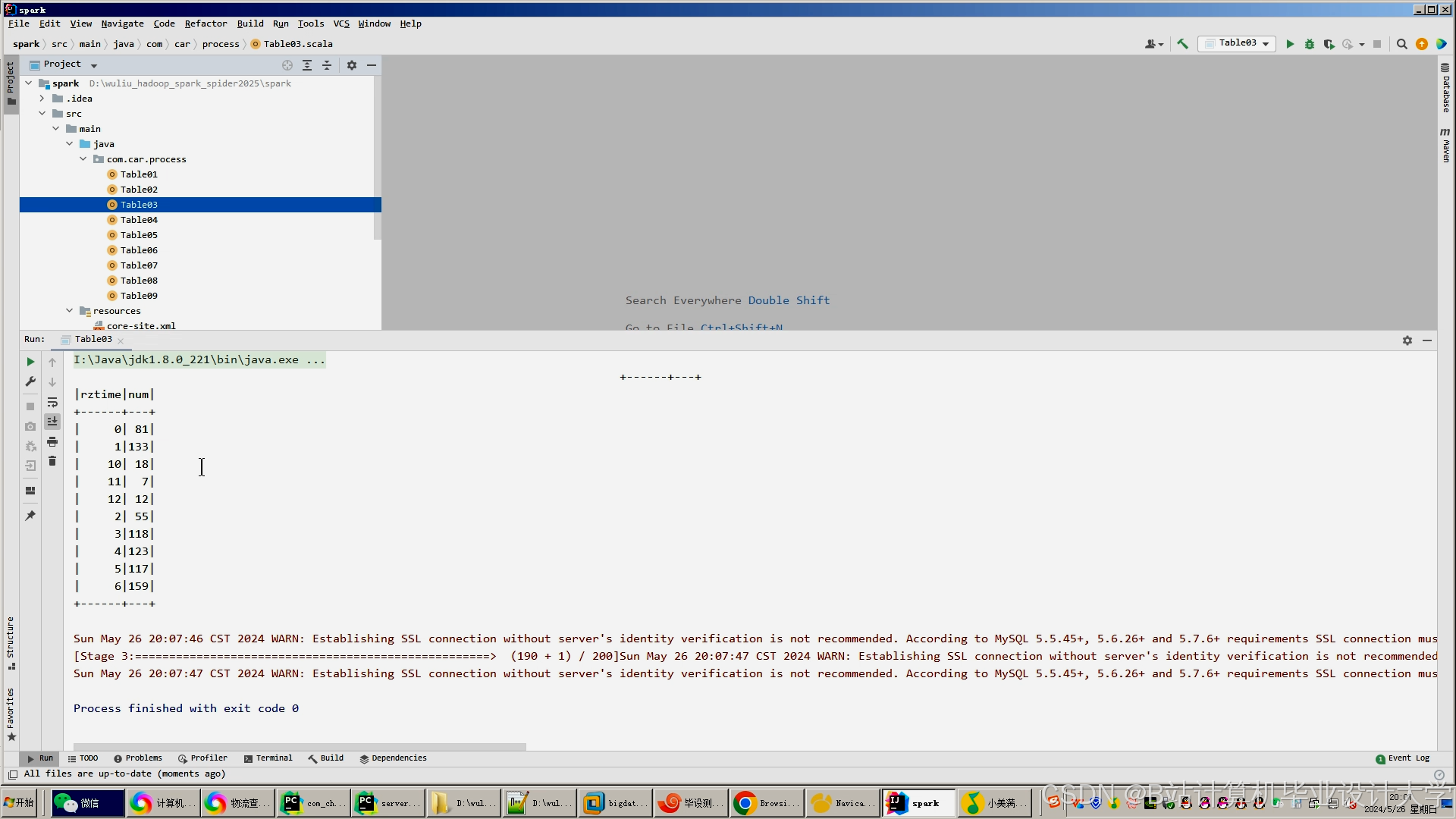

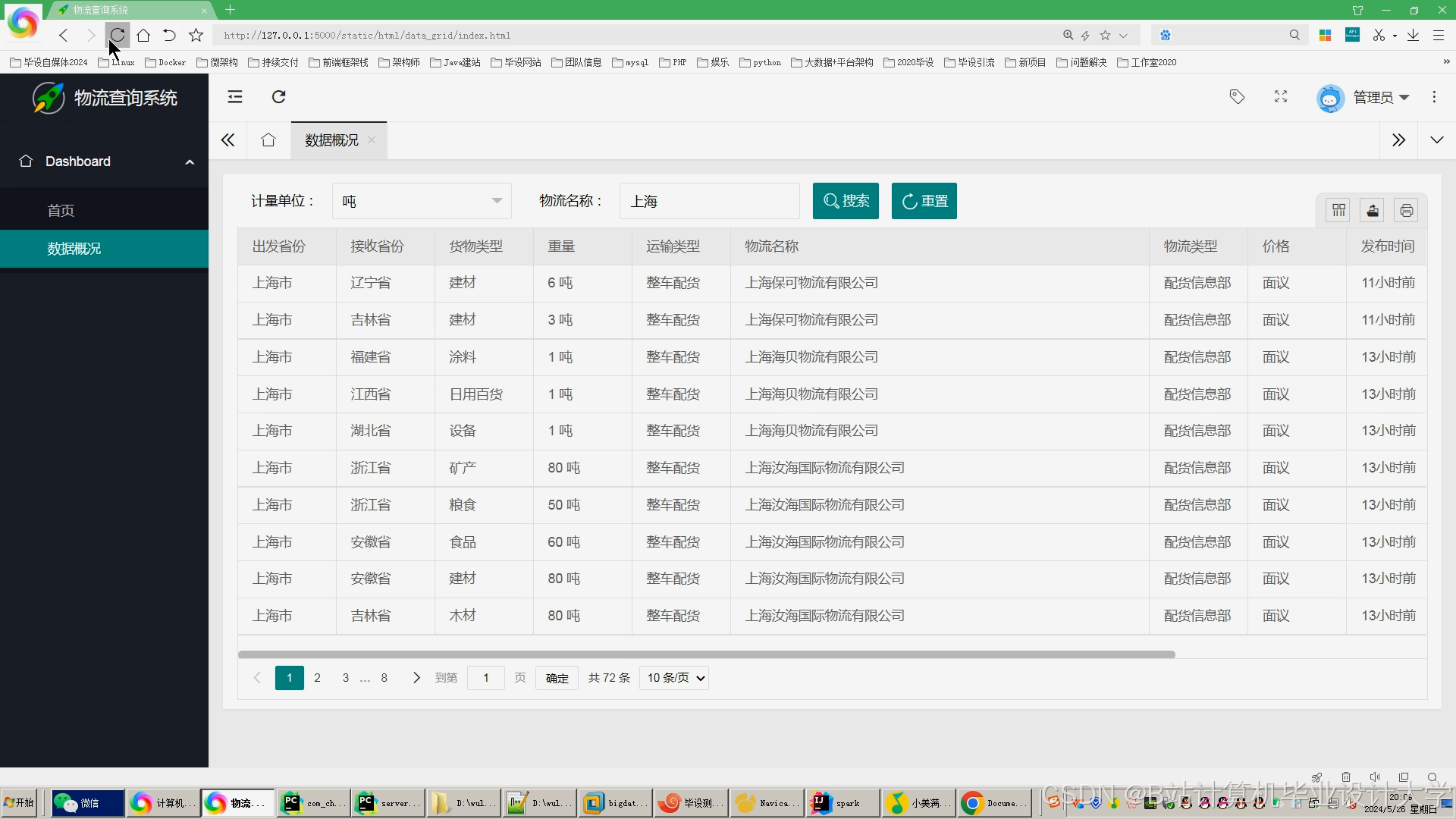

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

基于PyFlink与Spark的物流预测系统

基于PyFlink与Spark的物流预测系统

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?