温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《PyFlink+PySpark+Hadoop+Hive物流预测系统》的开题报告框架及内容示例,结合物流行业需求与大数据技术特点,供参考:

开题报告

题目:基于PyFlink+PySpark+Hadoop+Hive的物流预测系统设计与实现

一、研究背景与意义

- 研究背景

- 物流行业痛点:

- 需求波动大:受电商促销(如“双11”)、节假日、突发事件(如疫情)影响,物流订单量短期内激增,导致资源调度失衡(如车辆空载、仓库爆仓)。

- 数据孤岛:物流数据分散于多个系统(如订单系统、GPS轨迹、天气API),缺乏统一存储与分析框架。

- 预测精度低:传统时间序列模型(如ARIMA)难以捕捉多维度特征(如地理位置、天气、历史订单模式)的复杂关联。

- 大数据技术价值:

- Hadoop生态:HDFS存储海量物流数据(如订单记录、车辆GPS轨迹、传感器数据),Hive构建数据仓库支持多维分析(如区域订单热力图)。

- PySpark:加速离线数据处理(如历史订单特征提取、聚类分析),MLlib实现机器学习模型训练(如XGBoost预测需求)。

- PyFlink:实时处理动态数据(如订单流、交通状态),结合状态管理优化实时预测结果。

- 物流行业痛点:

- 研究意义

- 理论意义:探索流批一体架构在物流预测场景中的优化应用,解决传统模型对非线性、多变量数据的适应性不足问题。

- 实践意义:提升物流资源利用率(如车辆路径优化、仓库库存管理),降低运营成本(预计降低15%-20%空驶率)。

二、国内外研究现状

- 物流预测研究

- 传统方法:

- 时间序列分析(ARIMA、SARIMA):适用于平稳数据,但难以处理节假日、促销等外部冲击。

- 回归模型(线性回归、逻辑回归):依赖人工特征工程,忽略数据时空关联性。

- 机器学习应用:

- 随机森林、XGBoost:通过特征交叉自动捕捉非线性关系(如订单量与天气、促销的交互)。

- 深度学习(LSTM、Transformer):处理长序列依赖(如每日订单趋势预测),但需大量标注数据。

- 多源数据融合:

- 结合GPS轨迹、天气、社交媒体情绪(如“双11”话题热度)优化预测结果(如《Multi-source Data Fusion for Logistics Demand Forecasting》)。

- 传统方法:

- 大数据处理技术

- Hadoop生态:HDFS存储非结构化数据(如车辆传感器日志),Hive支持SQL化查询(如按区域统计订单量)。

- PySpark优化:通过DataFrame API加速ETL流程,GraphX建模物流网络拓扑(如仓库-配送中心关系)。

- PyFlink优势:实时接入Kafka流数据(如新订单、交通事件),结合CEP(复杂事件处理)触发动态预测更新。

- 现存问题

- 实时性不足:传统离线模型无法及时响应突发需求(如疫情导致的区域封锁)。

- 特征工程复杂:需手动提取时空特征(如区域订单密度、车辆周转率),效率低下。

- 系统扩展性差:单节点处理难以应对物流数据量指数级增长(如每日亿级订单)。

三、研究目标与内容

- 研究目标

- 设计并实现一套基于PyFlink+PySpark+Hadoop+Hive的物流预测系统,支持海量数据存储、高效离线/实时计算与多维度预测(如订单量、运输时间、库存需求)。

- 研究内容

- 数据采集与存储模块:

- 集成多源数据:物流平台订单数据、车辆GPS轨迹(JSON格式)、天气API(如高德天气)、交通事件(如道路封闭)。

- 使用HDFS存储非结构化数据(如传感器日志),Hive管理结构化数据(如订单表、车辆状态表)。

- 数据处理与分析模块:

- 离线处理:

- PySpark清洗数据(去重、异常值检测),通过MLlib提取特征(如区域历史订单均值、节假日标志)。

- 聚类分析(K-Means)识别高需求区域,关联规则挖掘(Apriori)发现订单与天气的关联模式。

- 实时处理:

- PyFlink接入Kafka流,实时计算订单突发量(如滑动窗口统计最近10分钟订单数),触发预测模型更新。

- 结合状态管理(KeyedState)跟踪车辆位置,优化实时路径规划。

- Hive数据仓库:支持多维分析(如按日期、区域、商品类型统计订单分布)。

- 离线处理:

- 预测算法模块:

- 时间序列预测:Prophet模型处理节假日效应,LSTM捕捉长期趋势。

- 多变量回归:XGBoost融合天气、促销、历史订单特征,预测区域需求。

- 图神经网络(GNN):建模物流网络拓扑(如仓库-配送中心-客户节点),预测运输时间。

- 混合模型:融合实时流数据(Flink状态)与离线历史数据(Spark特征),动态调整预测权重。

- 系统优化与评估:

- 优化Spark/Flink任务调度(如动态资源分配),减少Shuffle开销。

- 通过MAE(平均绝对误差)、RMSE(均方根误差)评估预测精度,对比基线模型(如ARIMA)提升效果。

- 数据采集与存储模块:

四、研究方法与技术路线

- 技术栈

- 存储层:HDFS(分布式存储)、Hive(数据仓库)

- 离线计算层:PySpark(数据清洗、特征工程、模型训练)

- 实时计算层:PyFlink(流处理、状态管理)、Kafka(消息队列)

- 算法层:PySpark MLlib(机器学习)、TensorFlow(深度学习)、自定义图算法

- 接口层:Flask/Django(提供RESTful API供物流调度系统调用)

- 技术路线

mermaidgraph TDA[多源数据采集] --> B[HDFS存储]B --> C[PySpark离线处理]C --> D[Hive数据仓库构建]D --> E[特征工程与模型训练]E --> F[PyFlink实时流处理]F --> G[动态预测与资源调度]G --> H[前端可视化与报警]

五、预期成果与创新点

- 预期成果

- 完成物流数据采集与存储方案,支持每日亿级订单数据处理。

- 实现基于PyFlink的实时预测引擎,响应时间<5秒(对比离线模型延迟降低80%)。

- 开发可视化后台,支持物流管理人员实时监控预测结果与系统性能(如CPU、内存使用率)。

- 创新点

- 流批一体预测:PyFlink处理实时订单流,PySpark处理离线历史数据,实现“热数据”与“冷数据”协同预测。

- 多维度特征融合:结合时空特征(区域订单密度)、外部因素(天气、促销)、网络拓扑(物流节点关系)优化预测结果。

- 动态资源调度:根据预测结果自动调整车辆路径(如避开拥堵路段)、仓库库存(如提前补货),降低运营成本。

六、进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 1 | 第1-2月 | 需求分析、技术选型、数据源确定(物流平台API、天气API) |

| 2 | 第3-4月 | Hadoop集群搭建、数据采集与HDFS存储设计 |

| 3 | 第5-6月 | PySpark数据处理与特征工程开发(异常值检测、特征交叉) |

| 4 | 第7-8月 | PyFlink实时流处理与状态管理实现(订单突发检测) |

| 5 | 第9-10月 | 预测算法集成与评估(对比XGBoost、LSTM、Prophet效果) |

| 6 | 第11-12月 | 论文撰写与答辩准备 |

七、参考文献

- Tom White. Hadoop权威指南[M]. 清华大学出版社, 2017.

- Matei Zaharia. Spark快速大数据分析[M]. 人民邮电出版社, 2018.

- Apache Flink中文文档. https://flink.apache.org/zh/

- Carbonneau P, et al. Application of Machine Learning to Logistics Demand Forecasting[J]. Expert Systems with Applications, 2008.

- 李航. 统计学习方法[M]. 清华大学出版社, 2012.

八、指导教师意见

(待填写)

备注:

- 可根据实际数据规模调整集群配置(如增加YARN资源管理节点)。

- 预测算法部分可引入强化学习(RL)优化长期物流效率(如最小化运输成本)。

- 需关注数据隐私合规性(如用户地址脱敏),符合《数据安全法》要求。

希望此框架能为您提供参考!如需进一步细化某部分内容(如PyFlink状态管理实现或XGBoost特征工程),可随时补充。

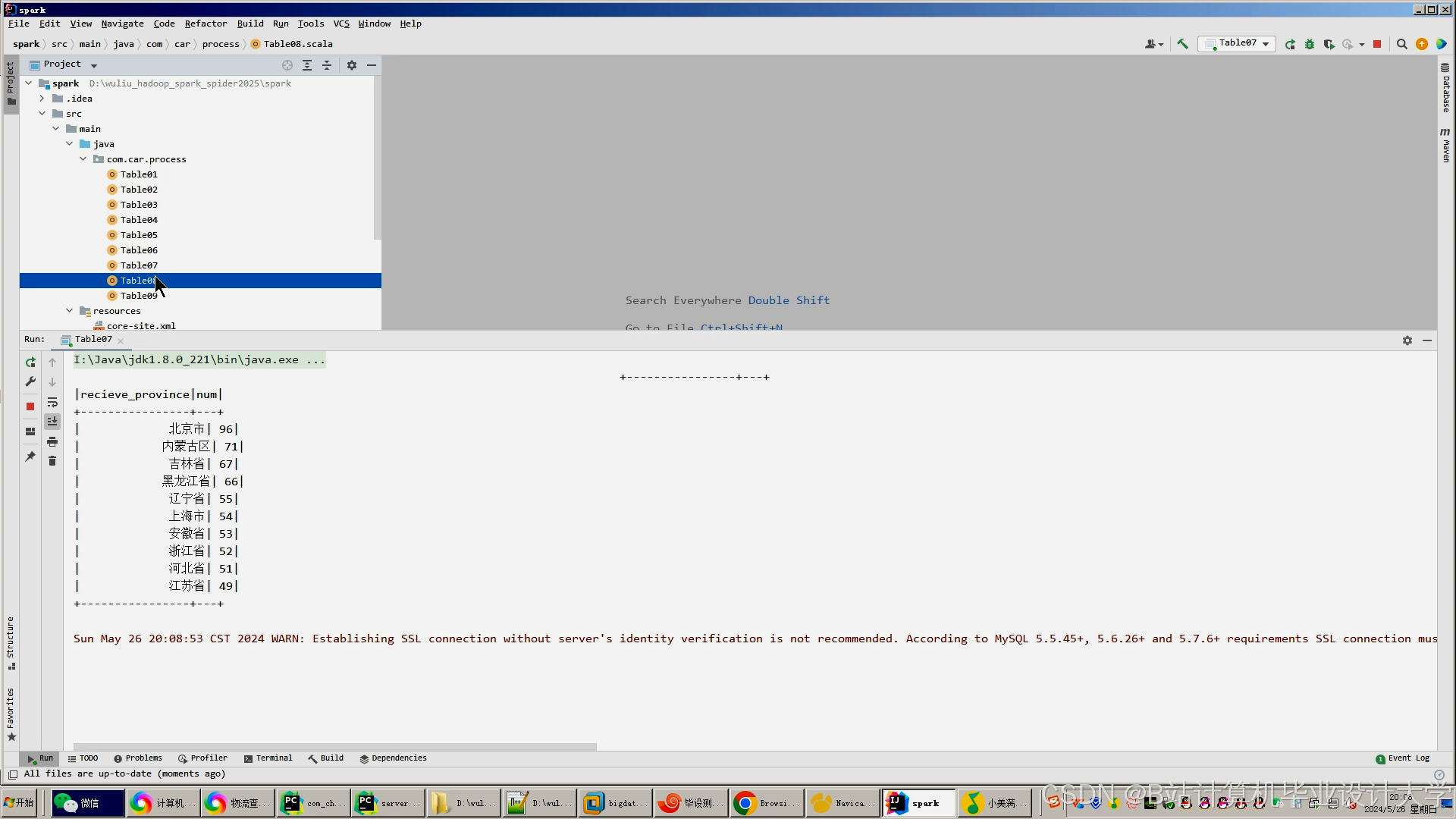

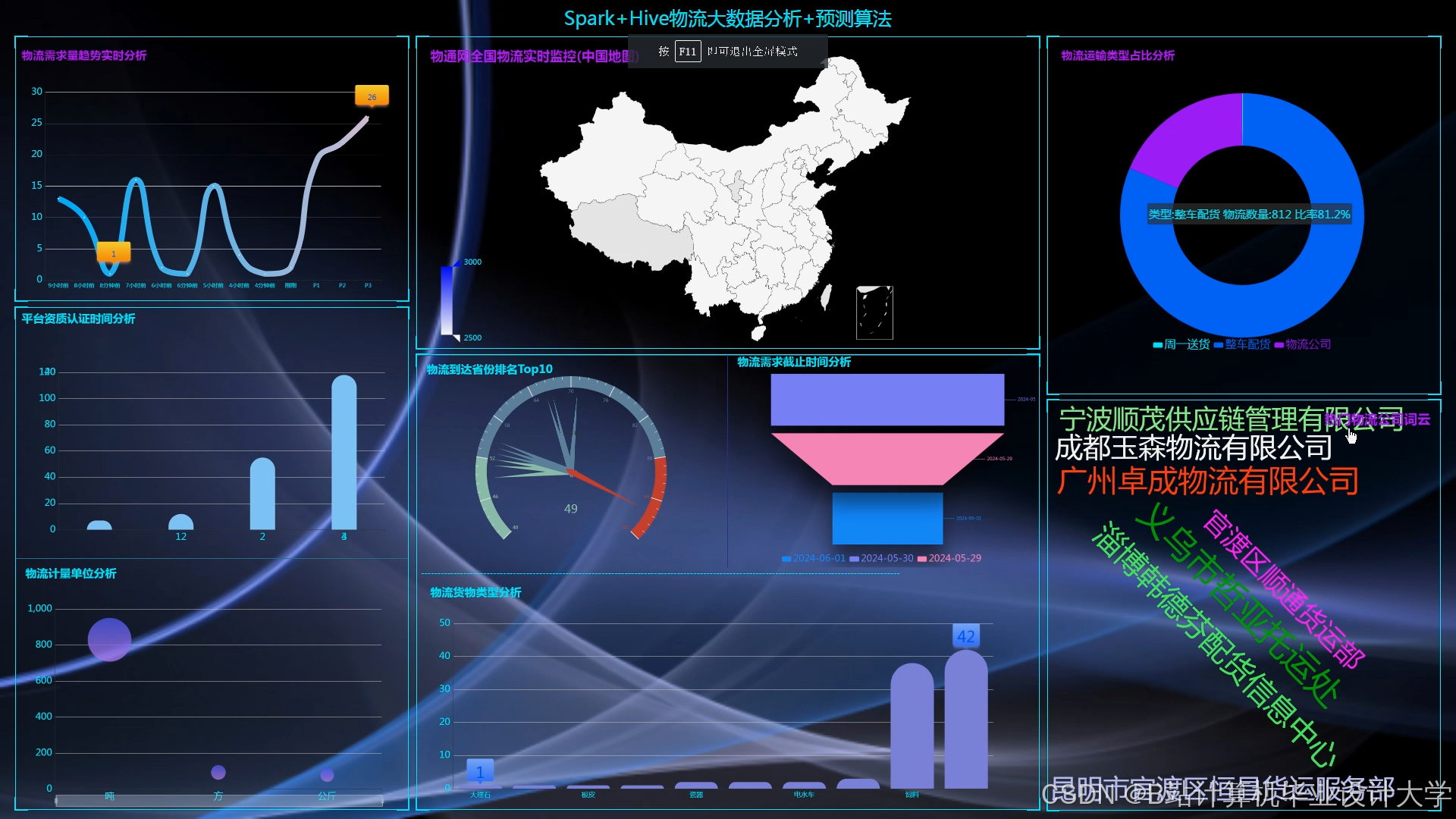

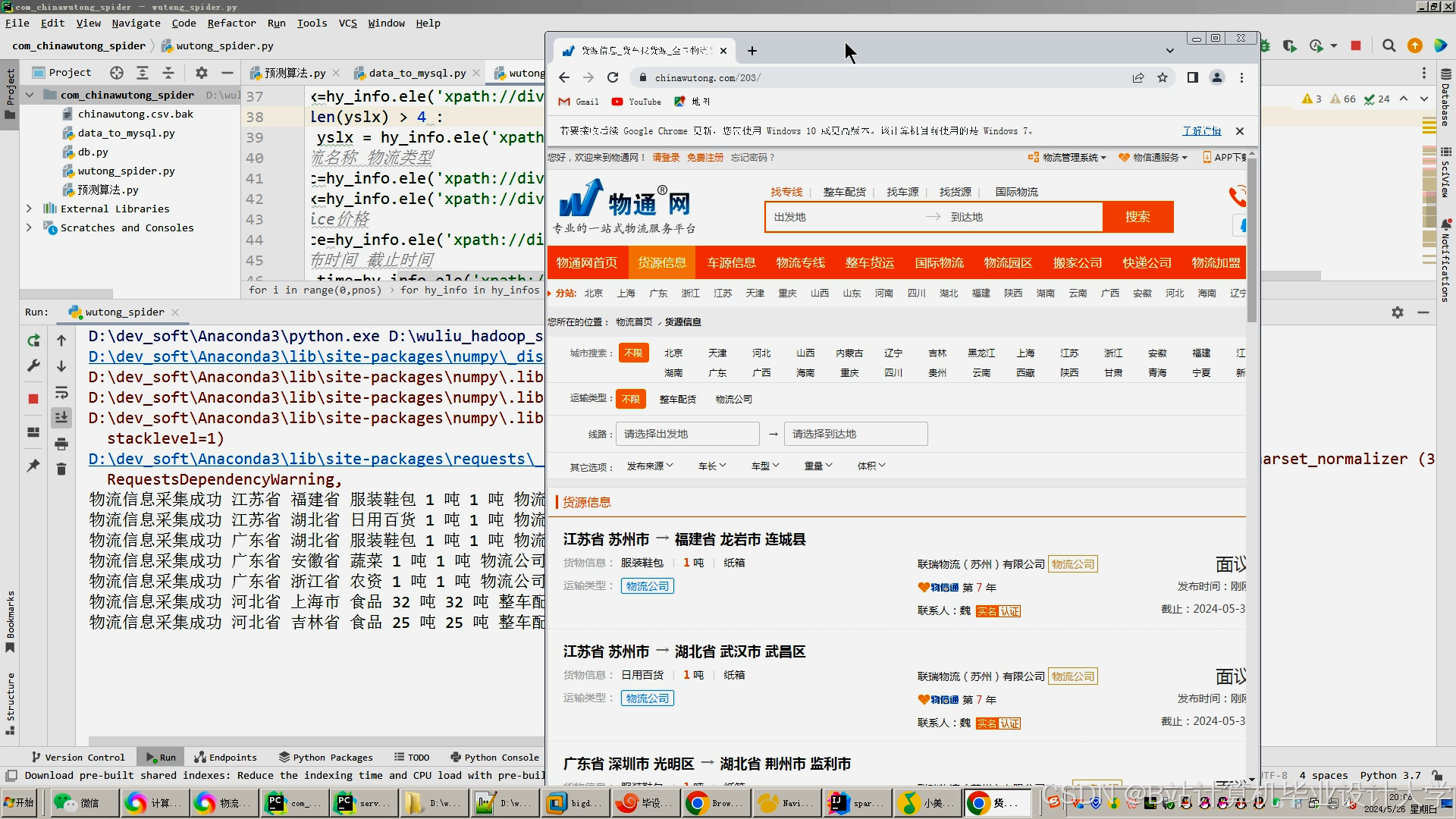

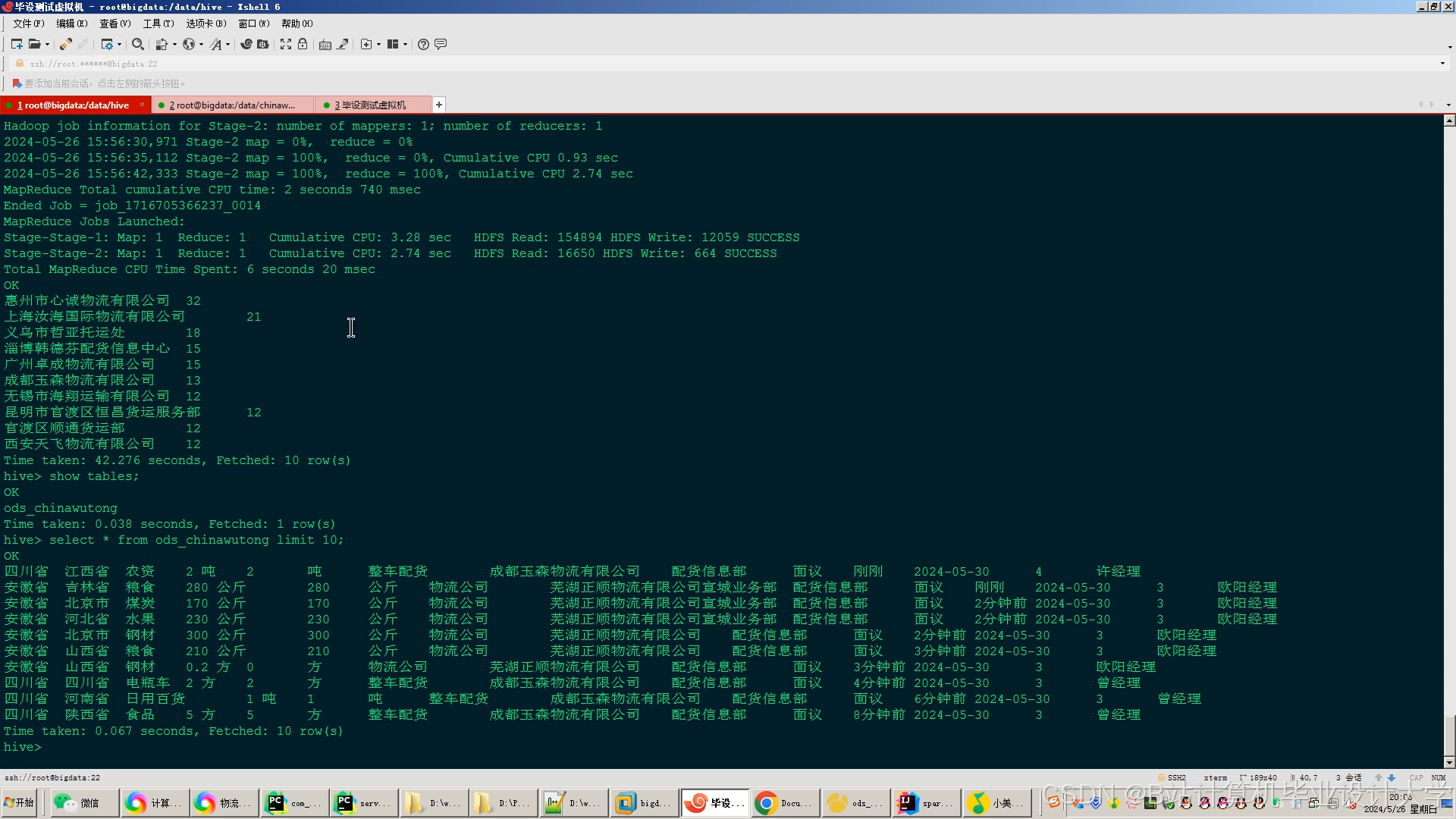

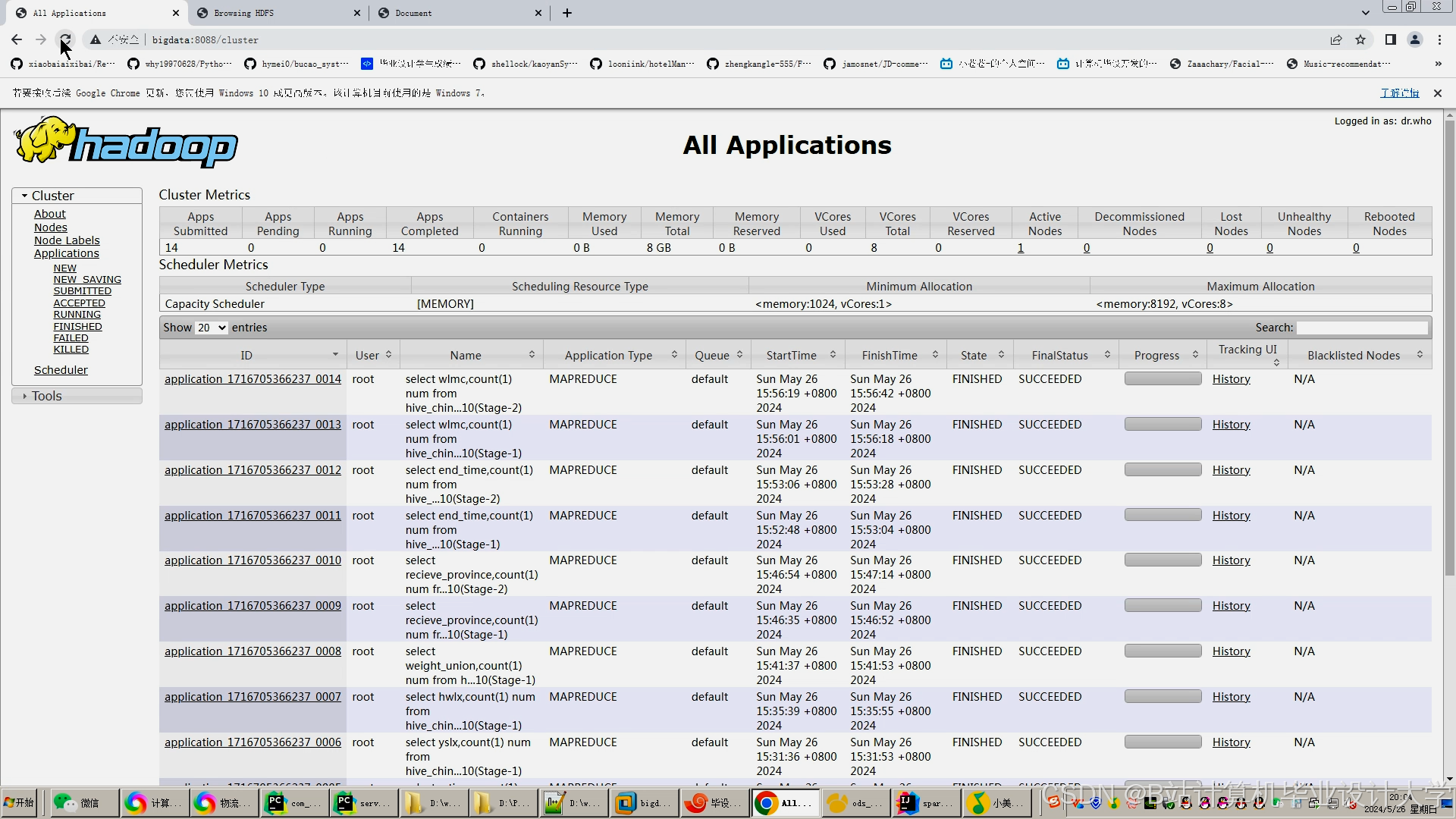

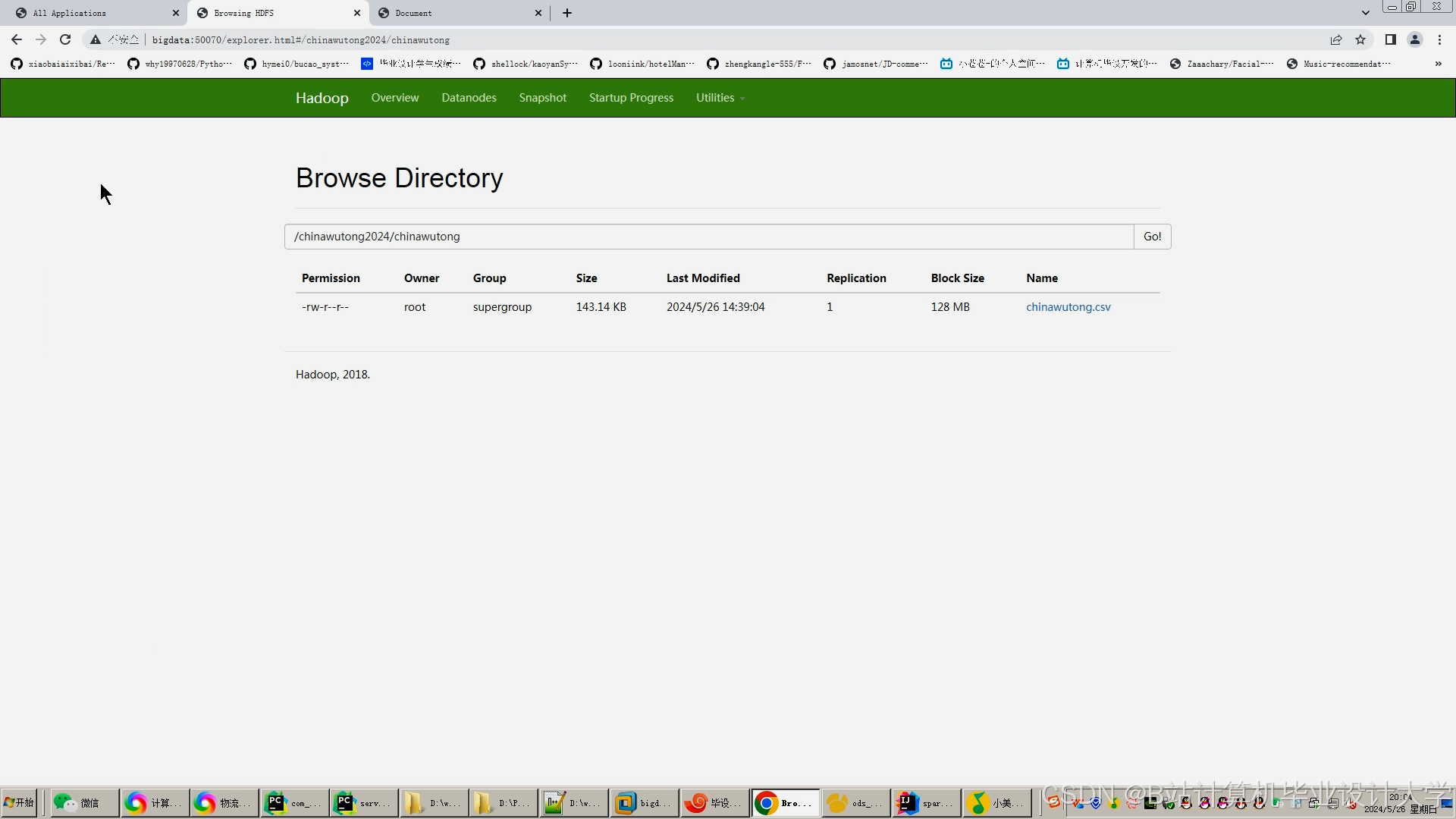

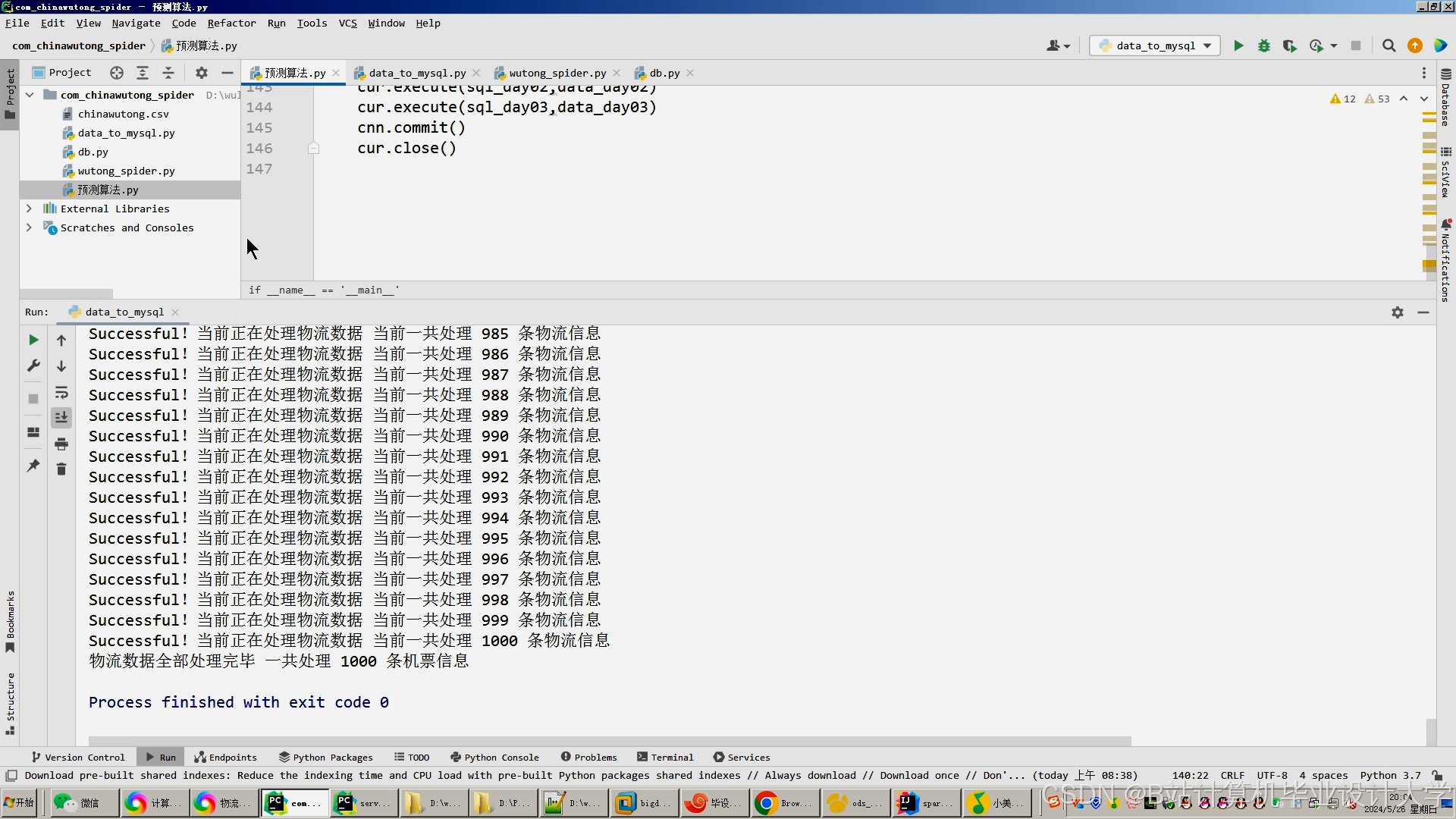

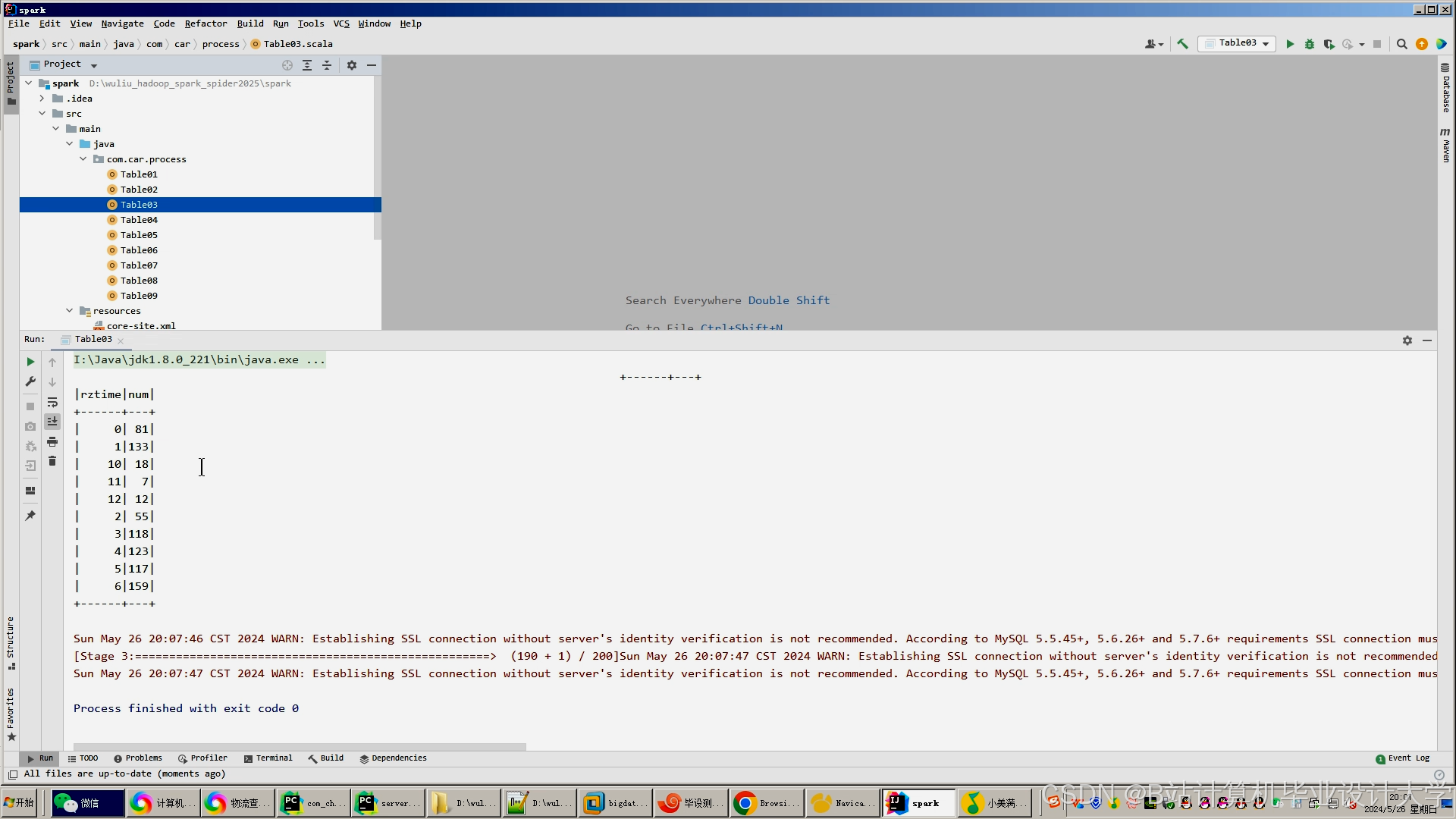

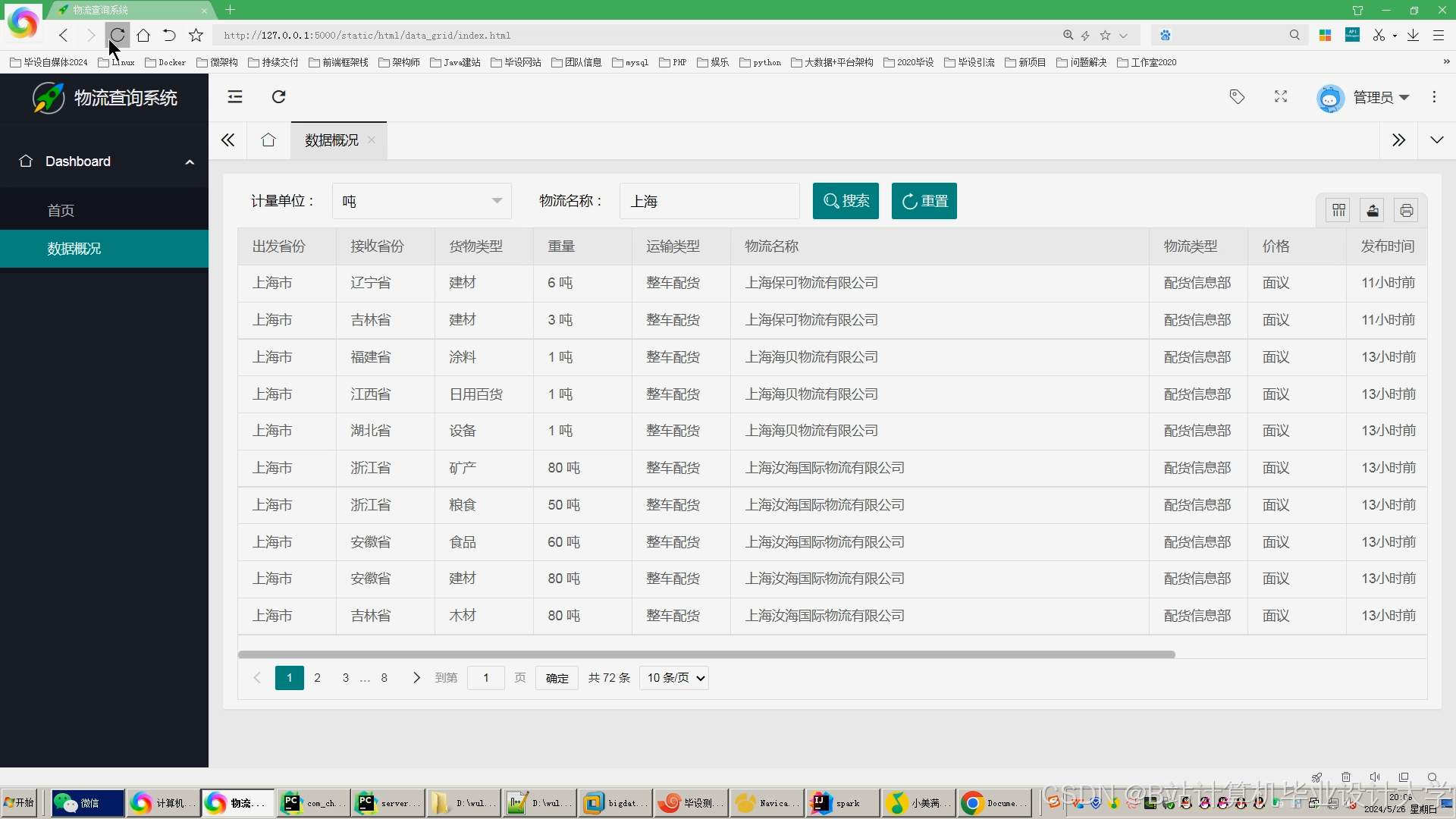

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

283

283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?