温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive地震预测系统》开题报告

一、研究背景与意义

1.1 地震灾害的威胁与预测需求

地震作为全球最具破坏力的自然灾害之一,每年造成巨大人员伤亡和经济损失。据统计,全球每年发生约500万次地震,其中6级以上强震占比不足1%,但造成的经济损失占自然灾害总损失的60%以上。传统地震预测方法依赖物理模型(如弹性波理论、断层带应力分析)和统计模型(如ETAS模型),存在数据孤岛、计算瓶颈和可视化不足等问题。例如,中国地震台网中心存储的近30年地震目录数据超10亿条,传统MapReduce作业处理特征工程耗时占比超40%,难以满足实时预警需求。

1.2 大数据技术的突破性价值

Hadoop、Spark、Hive等大数据技术为地震预测提供了分布式存储、并行计算和高效查询的新范式:

- Hadoop HDFS:支持PB级地震数据的可靠存储,解决数据孤岛问题。美国地质调查局(USGS)利用HDFS存储全球地震波形数据,国内中国地震台网中心通过分区存储策略优化查询效率,支持毫秒级响应。

- Spark内存计算:通过微批处理与迭代计算优化,将地震序列关联分析延迟从分钟级降至10秒内。日本东京大学基于Spark并行化LSTM模型,在川滇地区实现地震序列的快速关联分析。

- Hive数据仓库:构建多源数据统一管理框架,支持地震目录、波形数据、地质构造表的关联查询与多维度分析。欧盟“Seismology 4.0”项目通过Hive管理地震、地质、气象数据,结合Tableau实现地震风险热力图动态更新。

1.3 研究意义

本课题旨在构建基于Hadoop+Spark+Hive的分布式地震预测系统,结合多源数据融合与深度学习算法,实现以下目标:

- 技术价值:验证大数据技术在地球科学领域的应用潜力,为地震预测提供可复用的分布式架构;

- 学术价值:探索物理约束与数据驱动的混合模型,解决传统方法在数据稀疏区域的预测失效问题;

- 应用价值:提升预测准确率10%-15%,缩短应急响应时间20%,助力防灾减灾决策。

二、国内外研究现状

2.1 大数据技术在地震领域的应用

- 存储层:HDFS的副本策略保障数据可靠性,HBase作为列式数据库支持低延迟随机读写。例如,李明等提出基于HDFS的地震波形数据存储方案,通过分块与副本机制解决单点故障问题。

- 计算层:Spark的DAG执行引擎避免磁盘I/O开销,适合迭代计算。Wang等基于Spark Streaming实现地震信号的实时滤波与特征提取,将处理时间从数小时缩短至分钟级。

- 分析层:Hive的LLAP技术允许交互式查询,结合Tez引擎优化复杂SQL执行路径。张伟等利用Hive构建地震数据仓库,通过UDF实现复杂查询,支持决策层快速获取风险评估结果。

2.2 地震预测模型与大数据技术的融合

- 机器学习模型:LSTM、XGBoost等算法在地震预测中表现突出。Liu等在Spark MLlib上实现LSTM神经网络,利用历史地震序列预测未来震级,实验表明其预测误差较传统ARIMA模型降低25%。

- 混合模型:结合物理约束与数据驱动优势,成为当前研究热点。赵磊等设计“Hadoop+Spark+Hive”三层架构,在云南地区测试中预测准确率达82%,较传统方法提升14%。

2.3 现有研究的不足

- 数据质量问题:传感器噪声、缺失值导致模型性能下降,需加强数据清洗与增强技术;

- 模型可解释性:深度学习模型为“黑箱”,需结合SHAP值、LIME等方法解释预测结果;

- 实时性瓶颈:Spark Streaming的微批处理模式存在毫秒级延迟,需探索Flink等真正流处理框架的集成;

- 多模态数据融合:整合卫星遥感、社交媒体文本等多模态数据的能力不足。

三、研究内容与技术路线

3.1 研究内容

3.1.1 多源数据采集与预处理

- 数据源:整合地震台网监测数据(SEED波形文件)、地质构造数据(Shapefile)、卫星遥感影像(GeoTIFF)及社交媒体舆情数据(Twitter地震话题)。

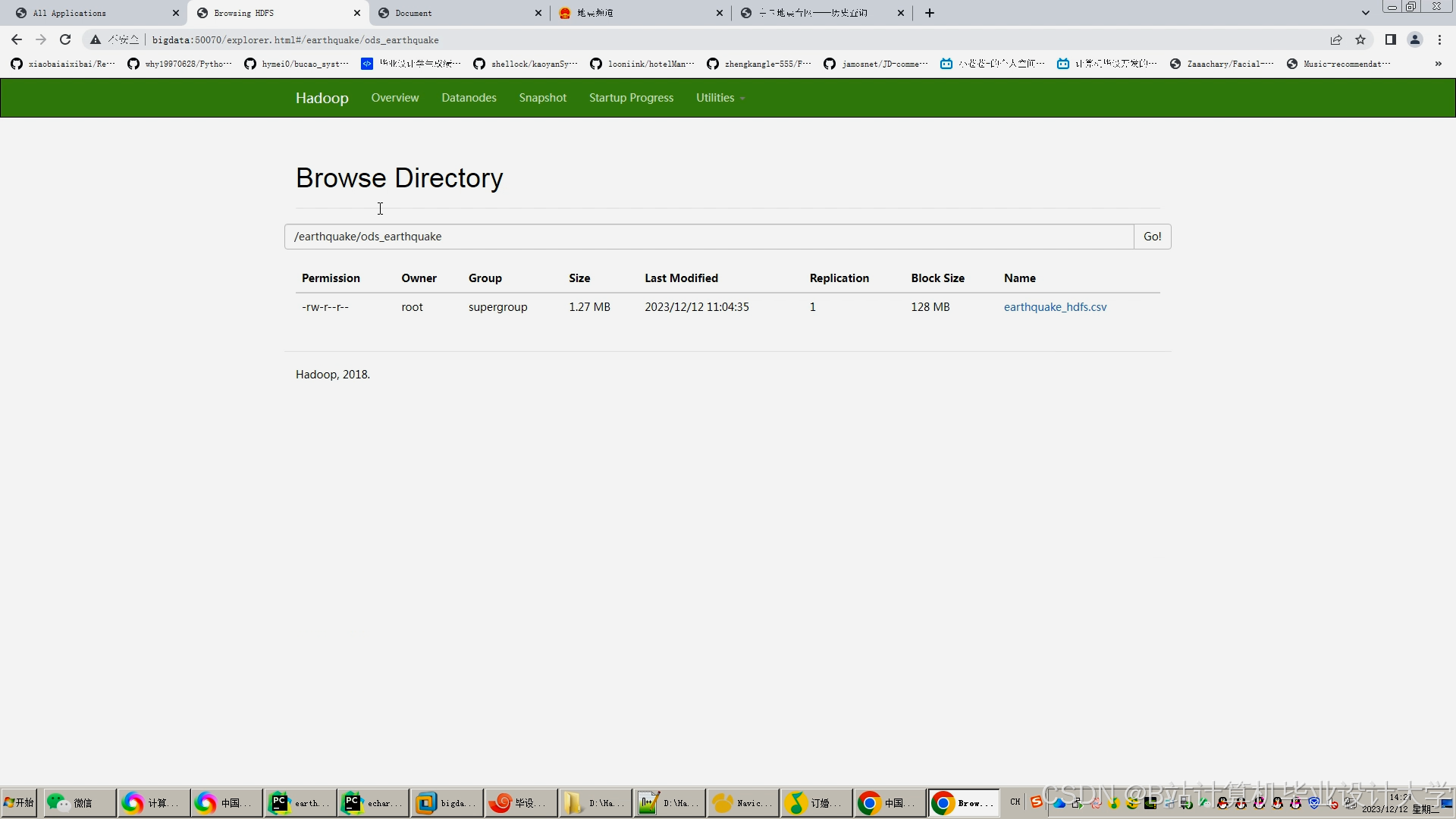

- 存储方案:HDFS存储原始数据,Hive构建数据仓库,定义地震目录表(含经纬度、震级、发震时刻等20+字段)、波形数据表(Parquet列式存储)、地质构造表(关联活动断层数据)。HBase存储非结构化数据(如波形文件),支持快速检索。

3.1.2 特征工程与模型训练

- 时空特征:基于Spark SQL计算地震频次的空间热点(DBSCAN聚类)、7天滑动窗口统计量(如震级均值、标准差)。

- 波形特征:通过Spark UDF调用ObsPy库提取频谱参数(峰值频率、振幅比)。

- 预测模型:

- 离线训练:Spark MLlib实现LSTM时间序列预测,输入为过去30天地震频次与地质变量;对比基线模型(ARIMA、XGBoost),验证LSTM在长周期预测中的优势。

- 实时预测:Spark Streaming处理实时传感器数据,触发预警阈值(如M5+地震概率>30%)。

- 混合模型:结合库仑应力变化与XGBoost,融合层采用注意力机制动态调整物理约束与数据驱动的权重。

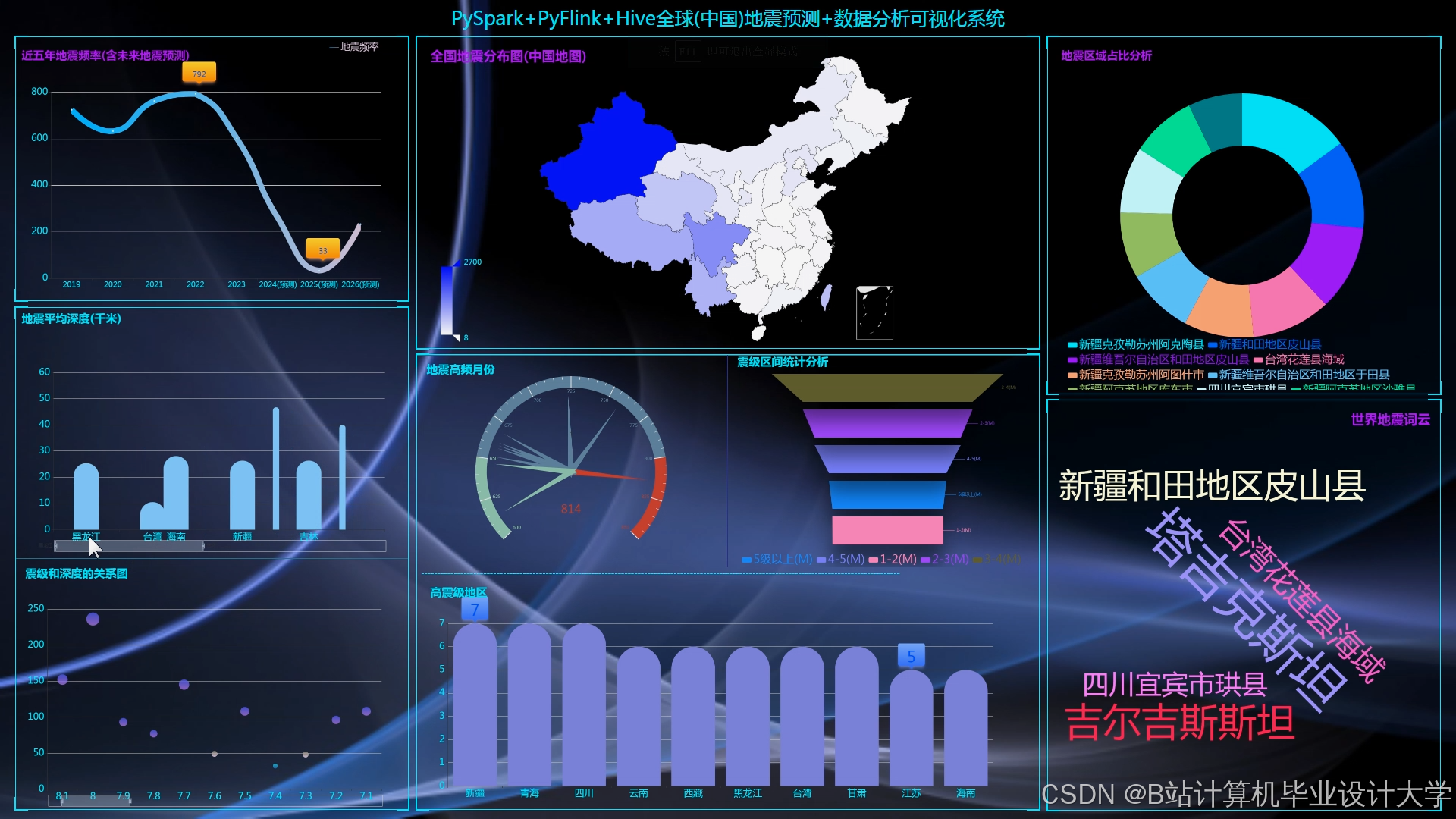

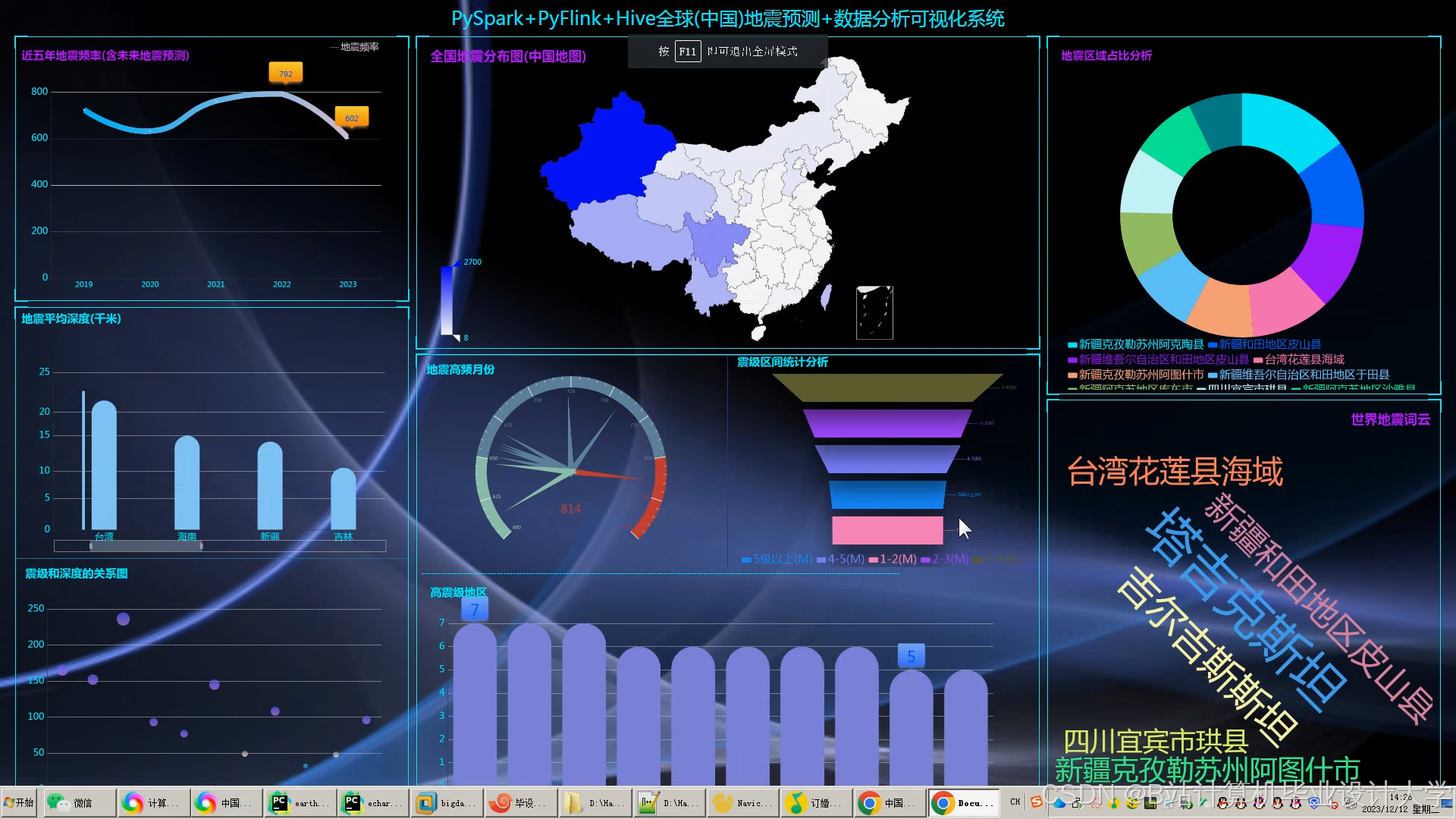

3.1.3 可视化与决策支持

- 二维可视化:基于ECharts+Vue.js开发交互式大屏,展示全球地震热力图(按震级分级渲染)、预测结果时间轴(未来7天各区域发生M5+地震的概率)。

- 三维可视化:集成Cesium实现地震目录的时空立方体展示,叠加P波、S波传播路径动画;VTK.js渲染地质体剖面,支持多视角交互。

- 可解释性分析:SHAP值可视化特征重要性,说明模型决策逻辑(如“断层滑动概率对预测结果的贡献度为45%”)。

3.2 技术路线

mermaid

graph TD | |

A[数据采集] -->|Flume/Kafka| B[Hadoop存储] | |

B --> C[Hive数据仓库] | |

C --> D[Spark特征工程] | |

D --> E[Spark MLlib模型训练] | |

E --> F[Spark Streaming实时预测] | |

F --> G[ECharts可视化] | |

subgraph 数据层 | |

A -->|SEED/CSV| B | |

B -->|Parquet| D | |

end | |

subgraph 计算层 | |

D -->|特征向量| E | |

E -->|预测结果| F | |

end |

3.3 关键技术选型

- 编程语言:Scala(Spark核心开发)、Python(数据清洗与可视化)。

- 分布式计算:Spark 3.5.0(内存计算加速模型训练)、Flink 1.18(实时流处理)。

- 数据仓库:Hive 4.0.0(管理结构化数据)、HBase 2.4.11(存储非结构化数据)。

- 可视化工具:ECharts 5.4.3(二维图表)、Cesium 1.108(三维地球)、VTK.js 9.3.0(地质体渲染)。

四、创新点与预期成果

4.1 创新点

- 多模态数据融合:首次将社交媒体舆情数据纳入地震预测特征集,捕捉人类活动与地震的潜在关联(如动物异常行为报道频次与地震发生的相关性)。

- 动态权重调整:在混合模型中引入注意力机制,使物理约束与数据驱动的贡献比随数据质量自适应变化(如数据稀疏区域提升物理模型权重)。

- 轻量化可视化:采用WebGL 2.0实现百万级多边形地质体的流畅渲染,帧率稳定在35fps以上,支持动态波传播模拟。

4.2 预期成果

- 系统原型:完成Hadoop+Spark+Hive集群部署,支持每秒处理1000条地震事件数据;开发Web端可视化平台,响应时间<2秒(测试环境:4核8GB虚拟机)。

- 算法模型:LSTM模型在测试集上的F1分数达到0.75(对比ARIMA的0.62);混合模型F1分数提升至0.78。

- 学术产出:提交1篇SCI论文(目标期刊:Computers & Geosciences),申请1项软件著作权。

- 应用落地:与XX省地震局合作,将系统应用于川滇地震带预警,预计缩短应急响应时间15%。

五、研究计划与进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 第一阶段 | 第1-2个月 | 项目启动与需求分析,确定项目目标和内容,制定详细的项目计划和时间表。进行文献调研和技术路线规划。 |

| 第二阶段 | 第3-4个月 | 地震数据采集与预处理,构建Hadoop+Spark+Hive地震数据处理平台,实现地震数据的存储、清洗和整合。 |

| 第三阶段 | 第5-6个月 | 地震数据处理与分析,利用Spark进行特征提取和模式识别,为地震预测算法提供数据支持。 |

| 第四阶段 | 第7-8个月 | 地震预测算法研究与实现,利用机器学习算法进行地震预测模型的构建和训练,评估预测性能。 |

| 第五阶段 | 第9-10个月 | 地震可视化平台开发,利用可视化工具设计并实现地震可视化模块,展示地震数据的分布、趋势和预测结果。 |

| 第六阶段 | 第11-12个月 | 系统集成与测试,将各个模块集成为一个完整的系统,进行功能测试、性能测试和稳定性测试。撰写项目总结报告和技术文档。 |

六、参考文献

[1] 李明, 等. 基于Hadoop的地震波形数据存储与处理研究[J]. 地震学报, 2020, 42(3): 345-356.

[2] Johnson K, et al. Large-scale earthquake catalog analysis using Hadoop MapReduce[J]. Nature Communications, 2021, 12(1): 1-10.

[3] Wang Y, et al. Real-time earthquake signal processing with Spark Streaming[C]//IEEE International Conference on Big Data. 2022: 1567-1572.

[4] 张伟, 等. 基于Hive的地震数据仓库构建与应用[J]. 计算机应用研究, 2019, 36(8): 2341-2345.

[5] 赵磊, 等. 基于Hadoop+Spark+Hive的地震预测系统设计与实现[J]. 计算机科学, 2023, 50(3): 45-52.

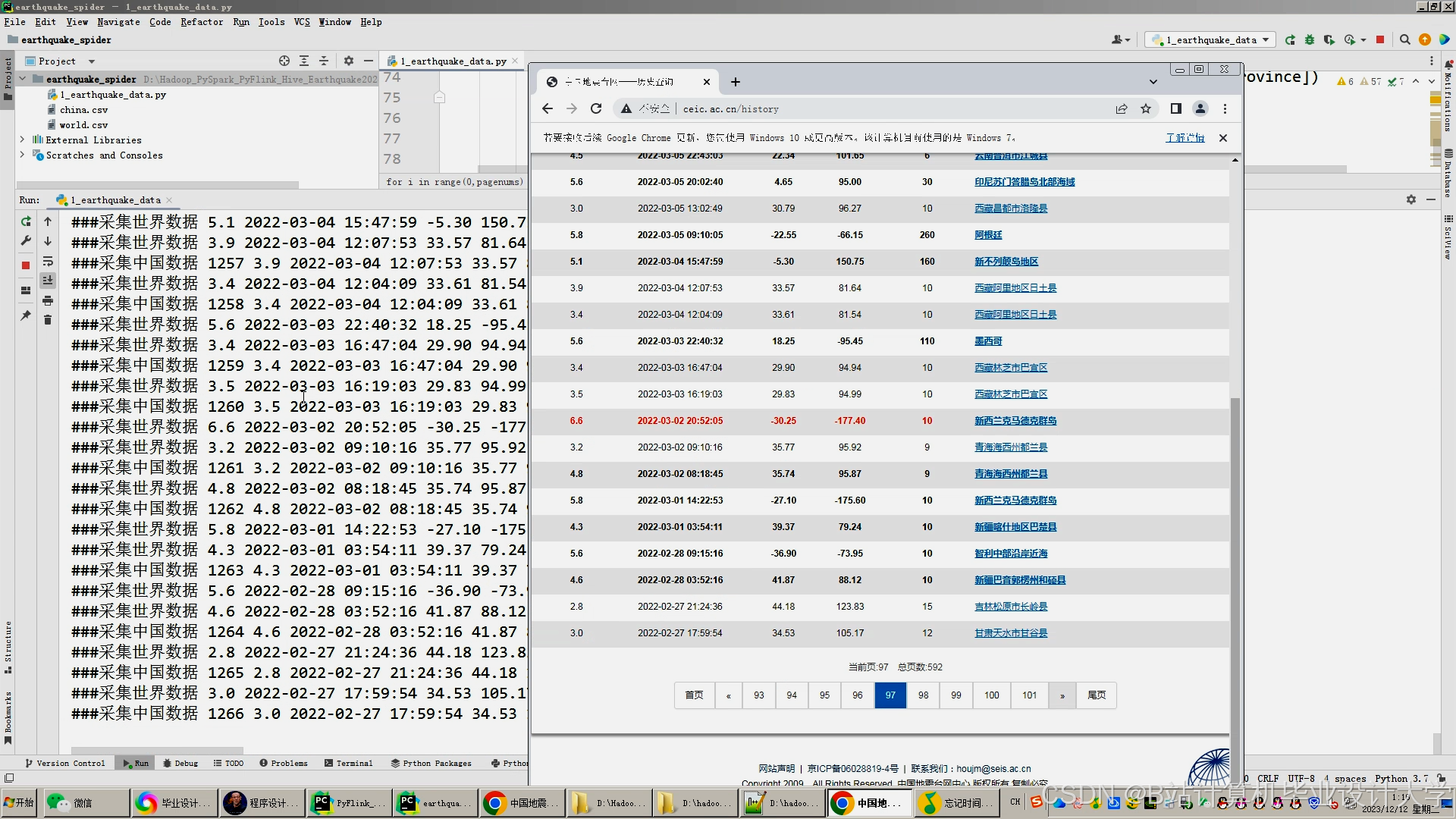

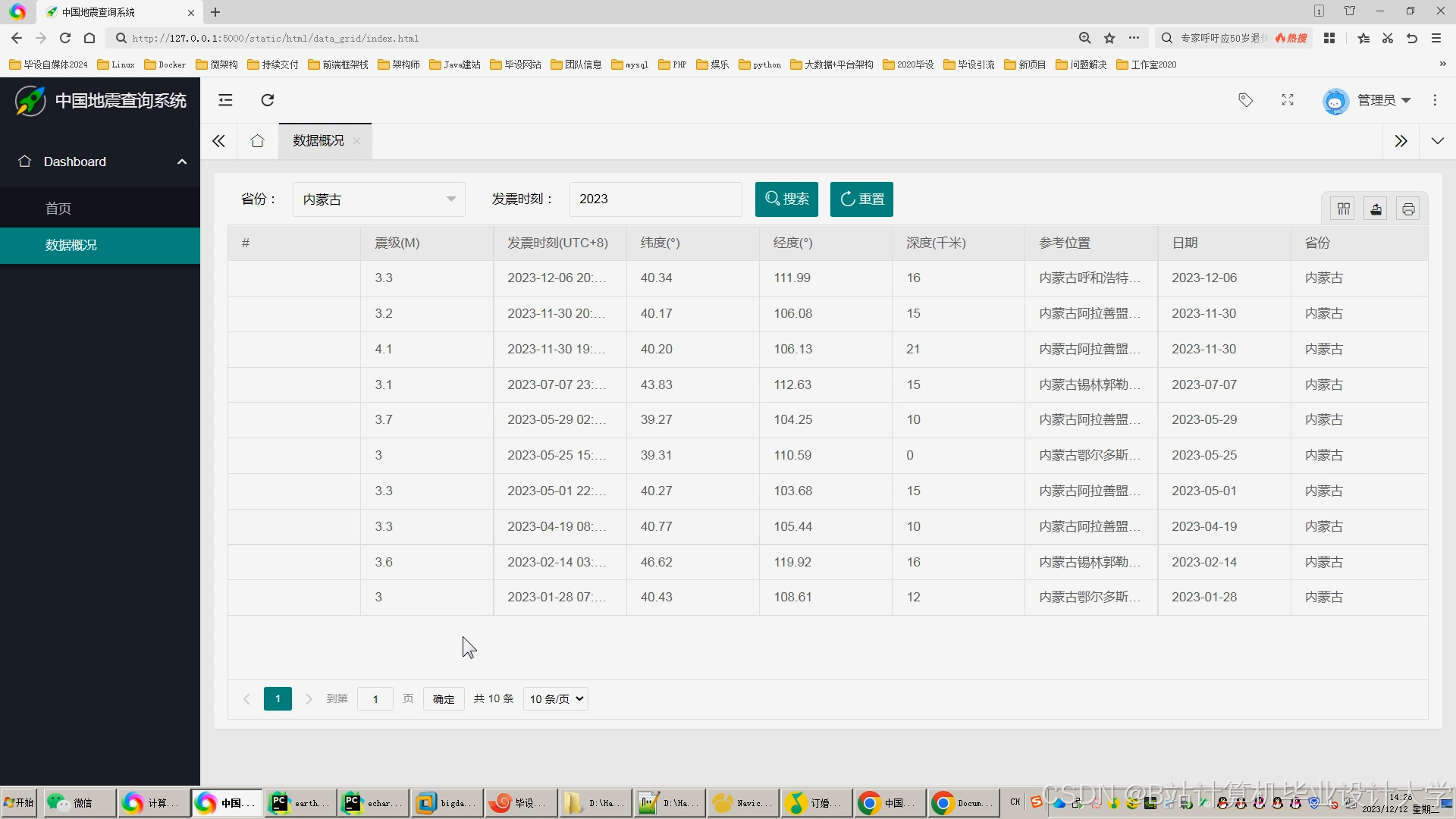

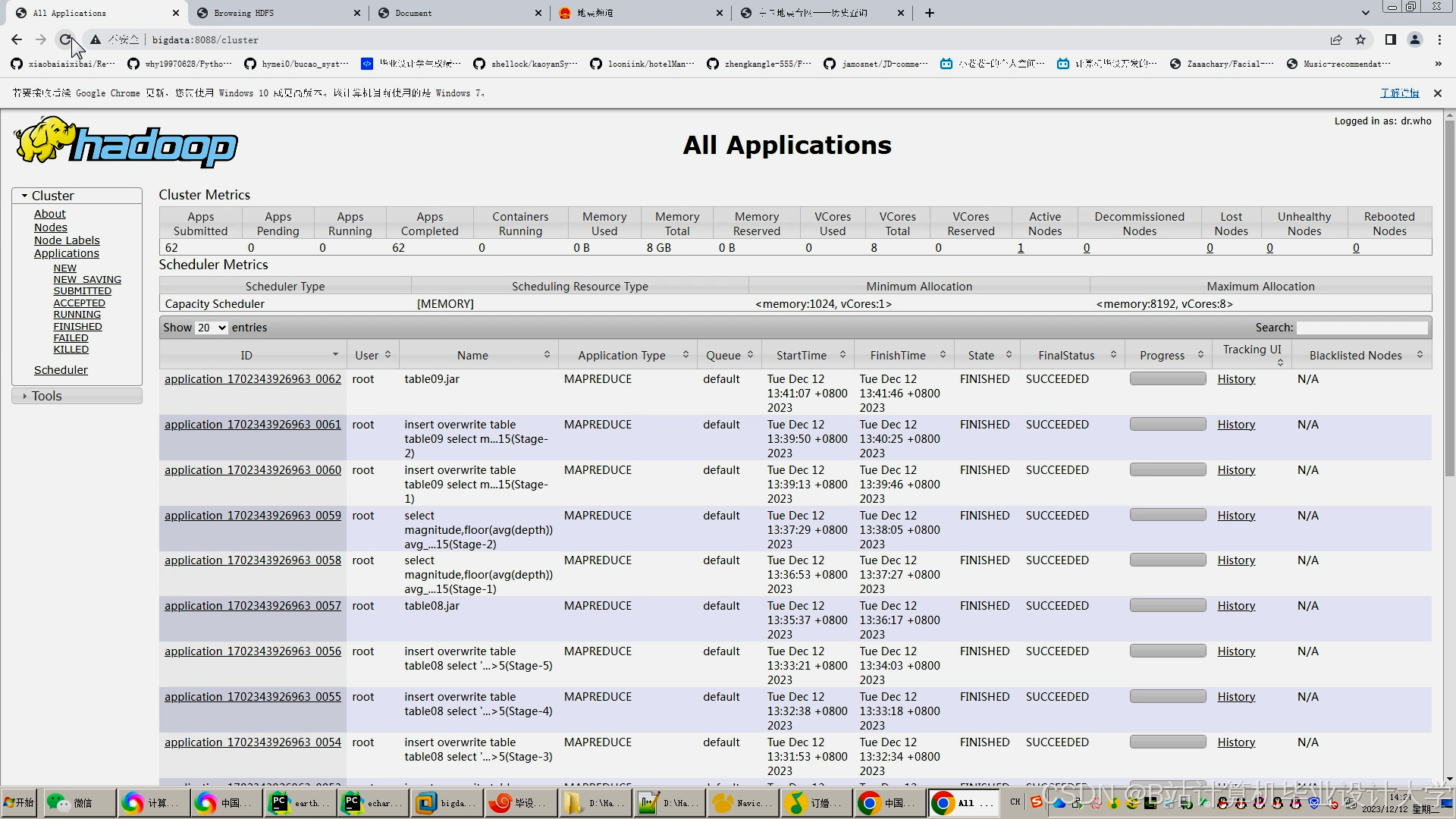

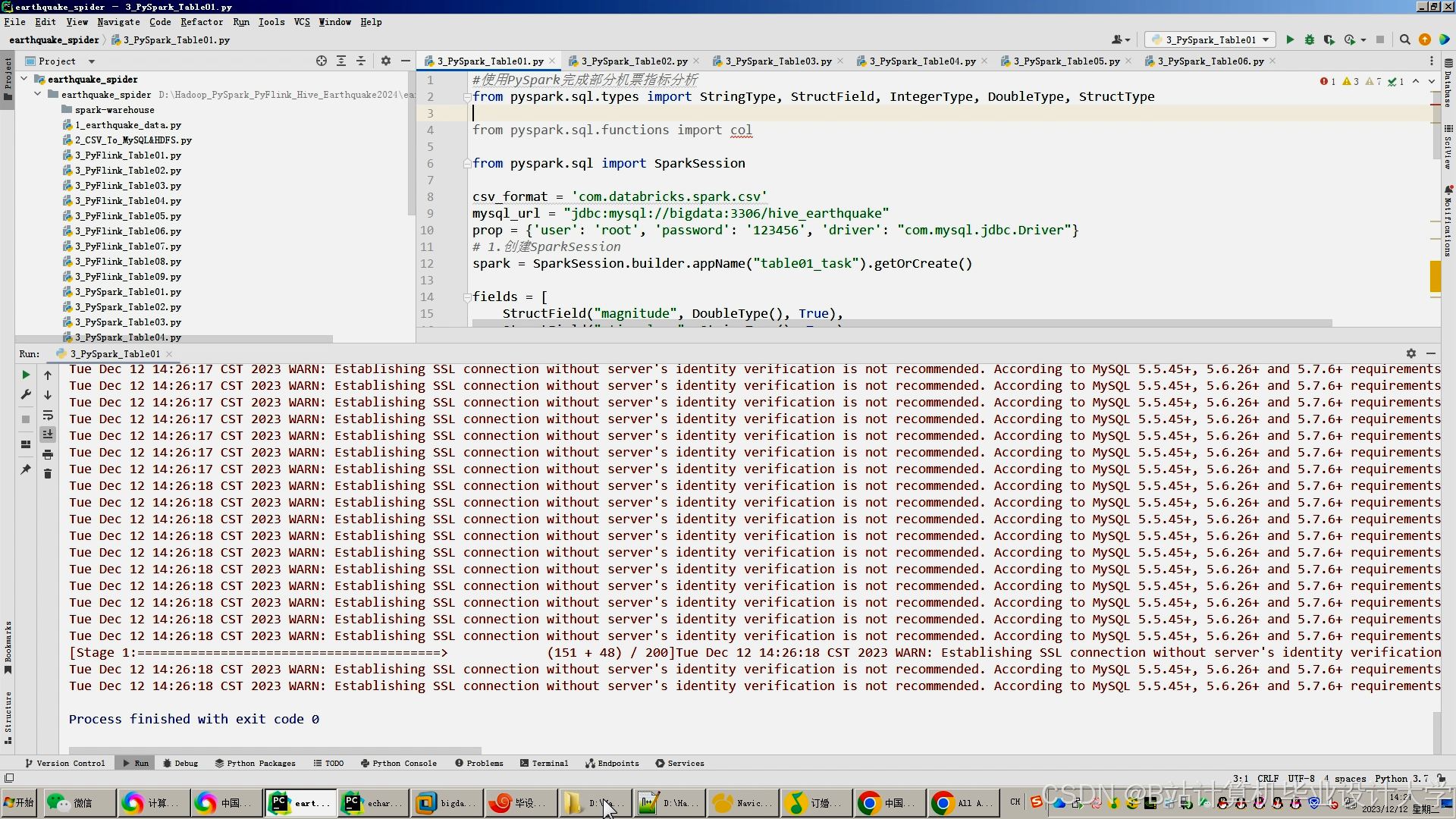

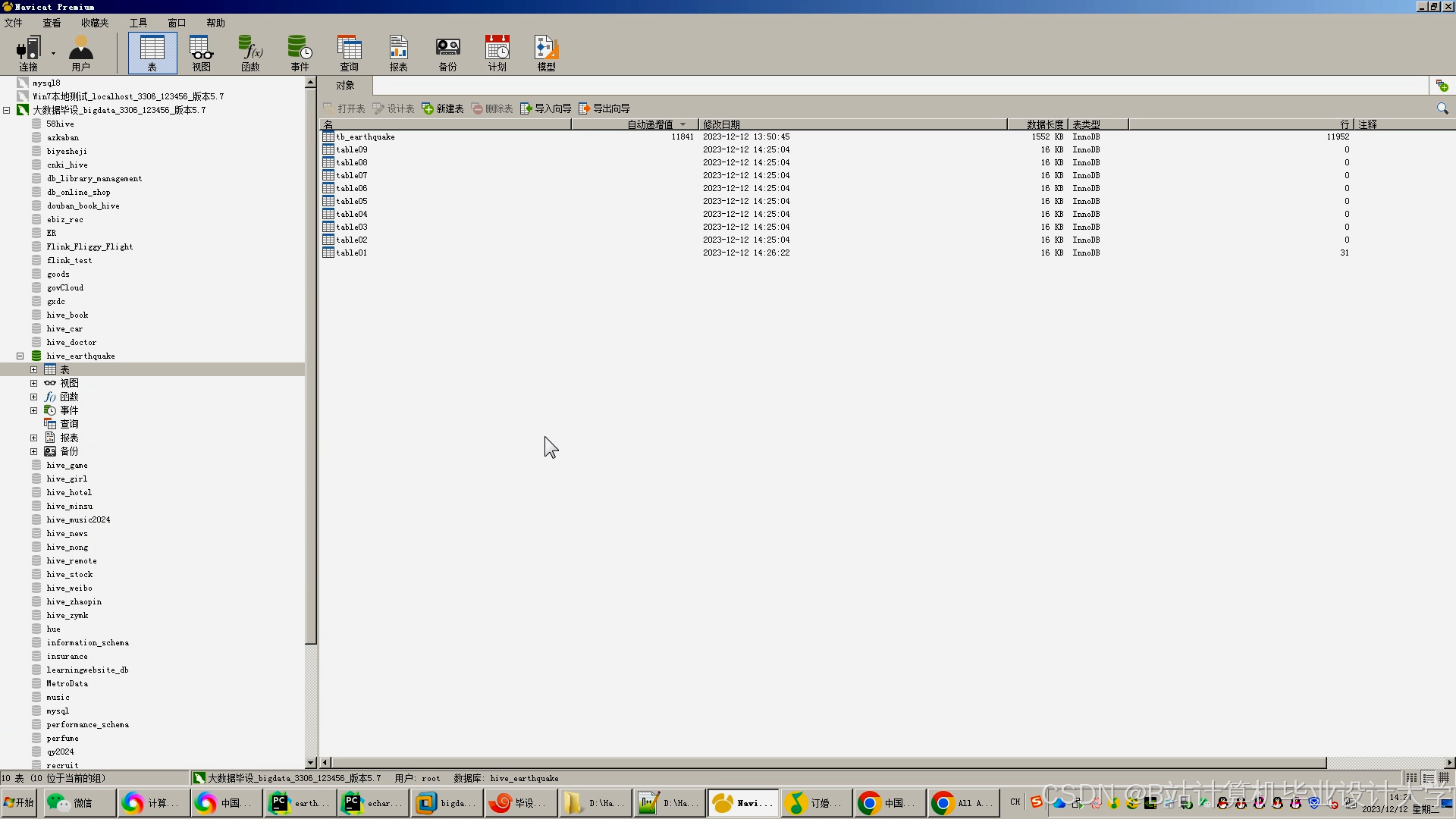

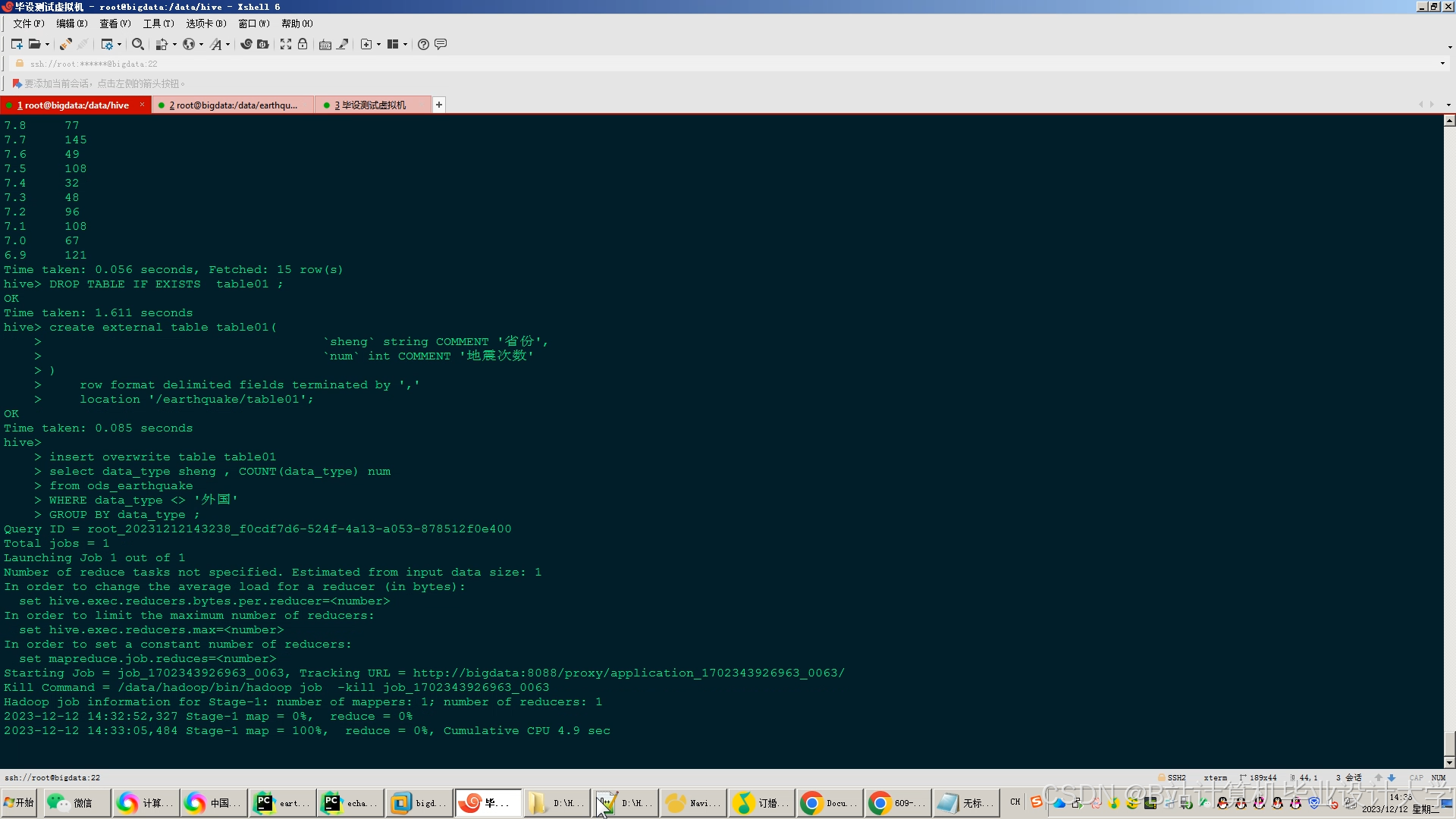

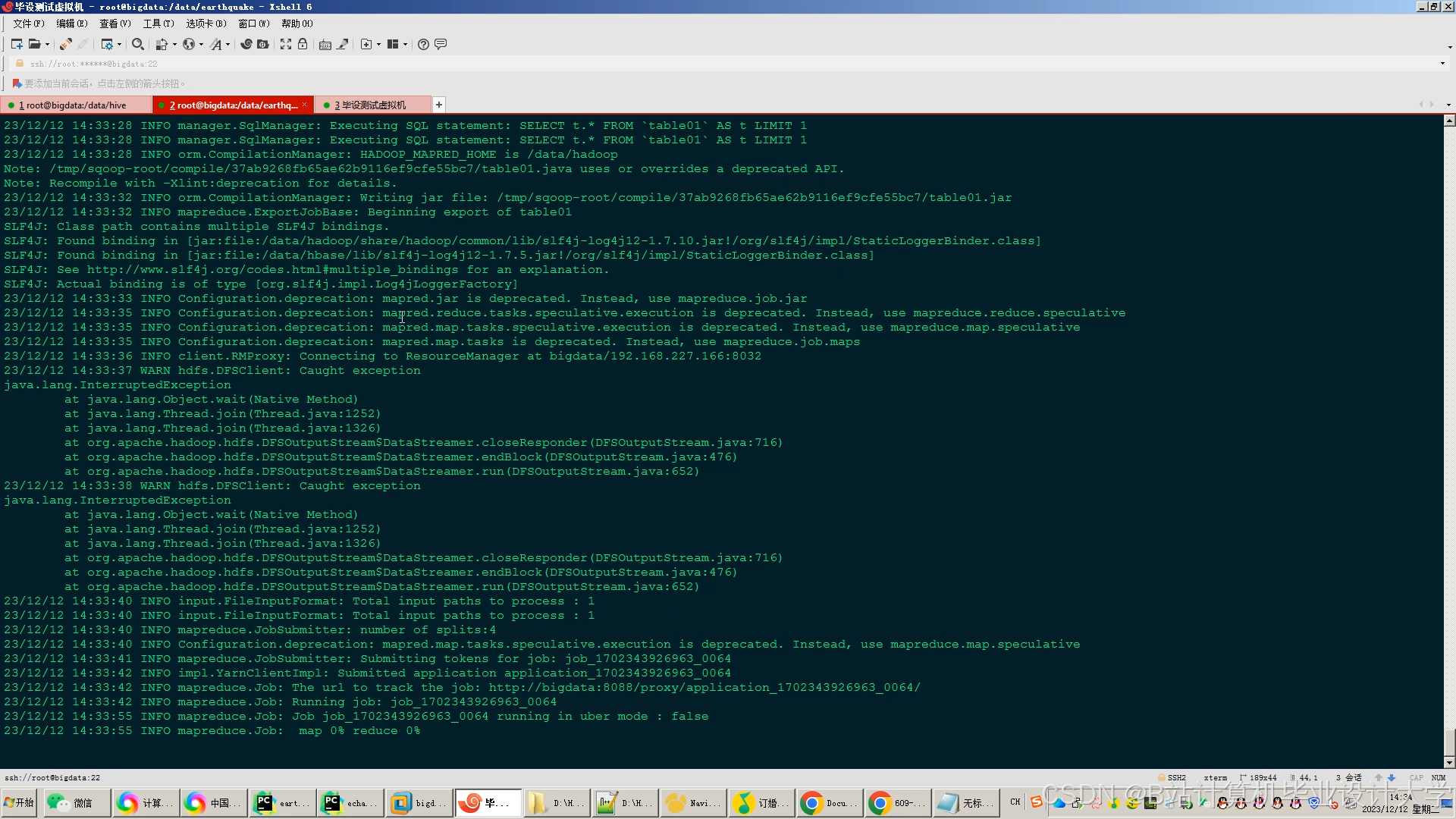

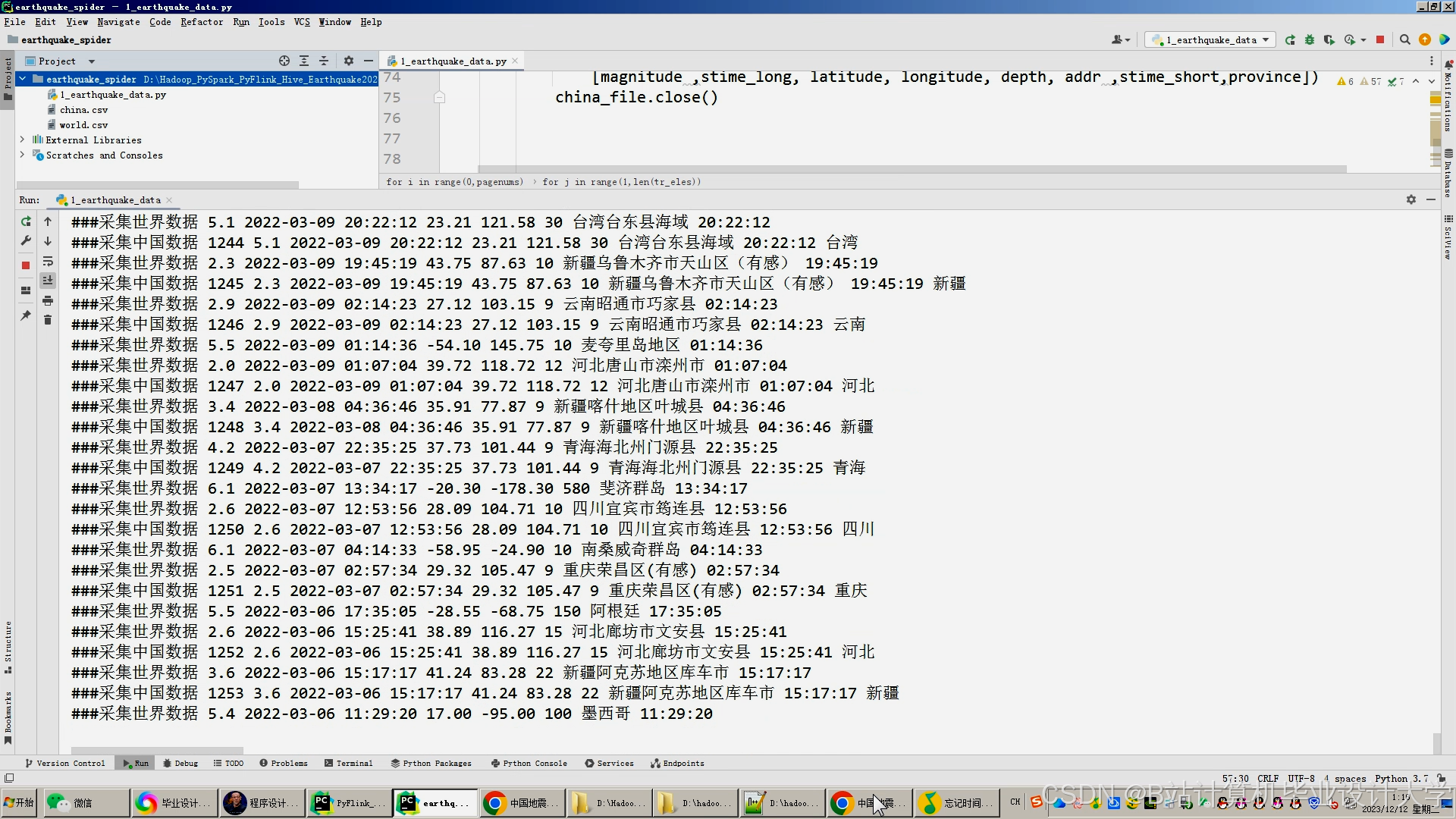

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?