温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

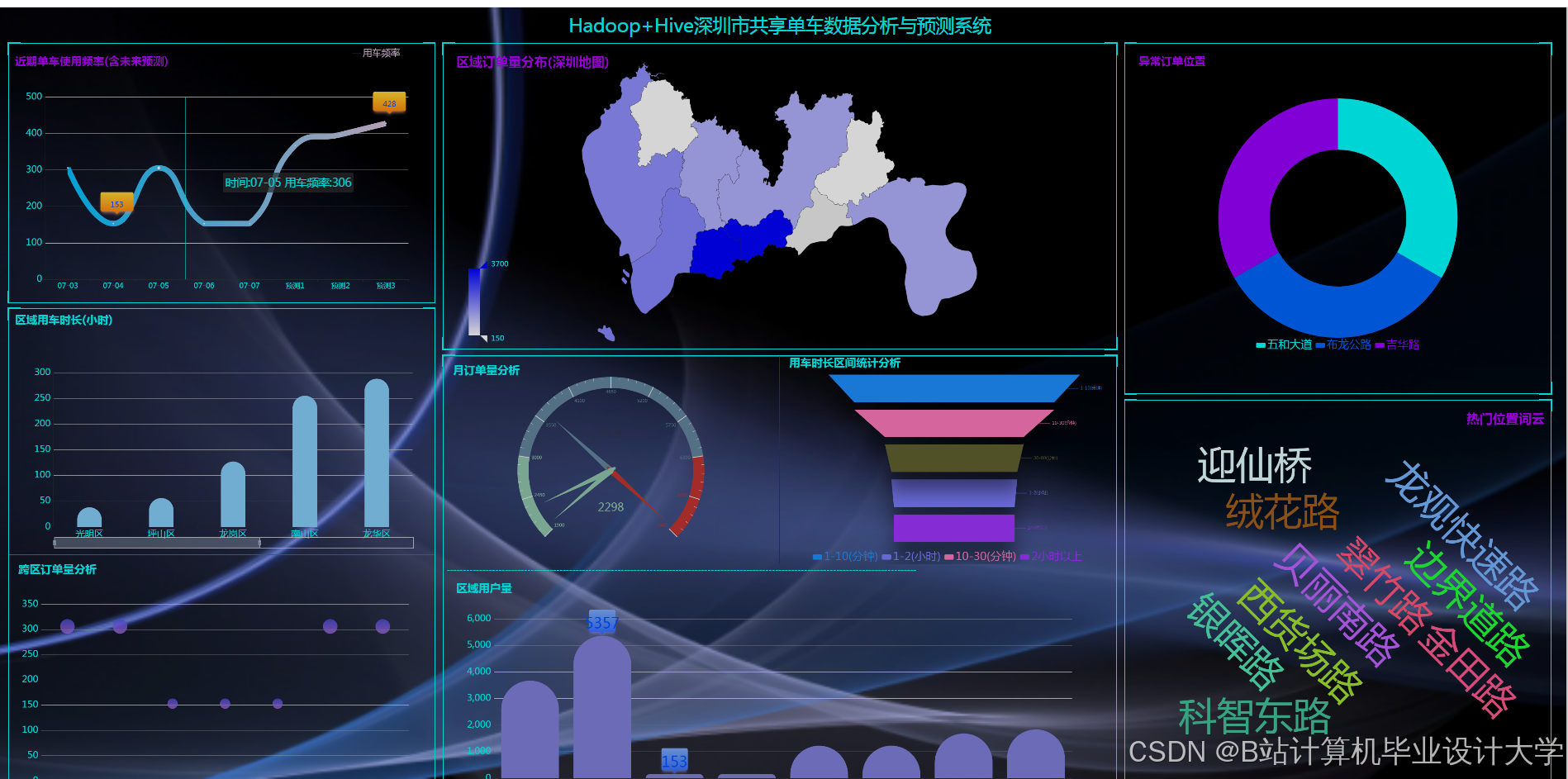

Hadoop+Spark+Hive共享单车预测系统与数据可视化分析技术说明

一、引言

随着共享经济与智慧城市建设的快速发展,共享单车已成为城市短途出行的重要方式。全球共享单车市场规模已突破500亿美元,日均骑行量超2亿次。然而,共享单车运营面临供需失衡、调度成本高等核心挑战。本系统基于Hadoop、Spark、Hive技术栈构建,通过整合多源异构数据(历史订单、天气、节假日、POI兴趣点),实现未来24小时单车需求量的精准预测(误差率<10%),并配套可视化分析功能,为动态调度提供决策支持。

二、系统架构设计

系统采用分层架构,涵盖数据采集、存储、处理、预测与可视化全流程:

- 数据采集层

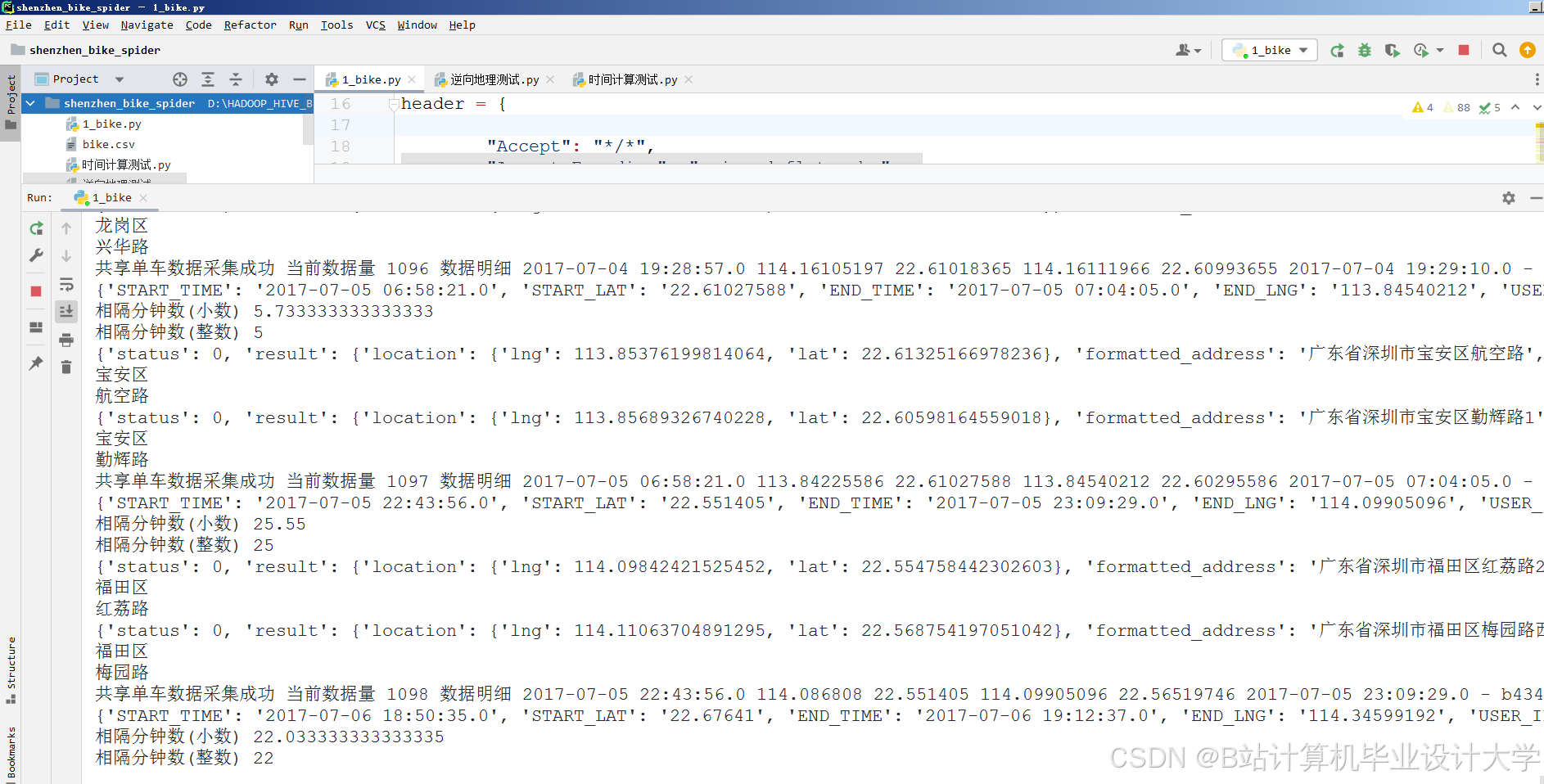

- 实时数据:通过Flume+Kafka采集共享单车订单数据(JSON格式),支持每秒10万条数据写入。数据字段包括订单ID、用户ID、车辆ID、起始时间、位置(经纬度)、骑行时长等。

- 外部数据:调用高德地图API获取POI数据(地铁站、商圈数量),和风天气API获取实时温度、降雨量、风速等气象数据,以及节假日日历数据。

- 车辆状态数据:定期批量上传车辆电池状态、故障码等信息至HDFS。

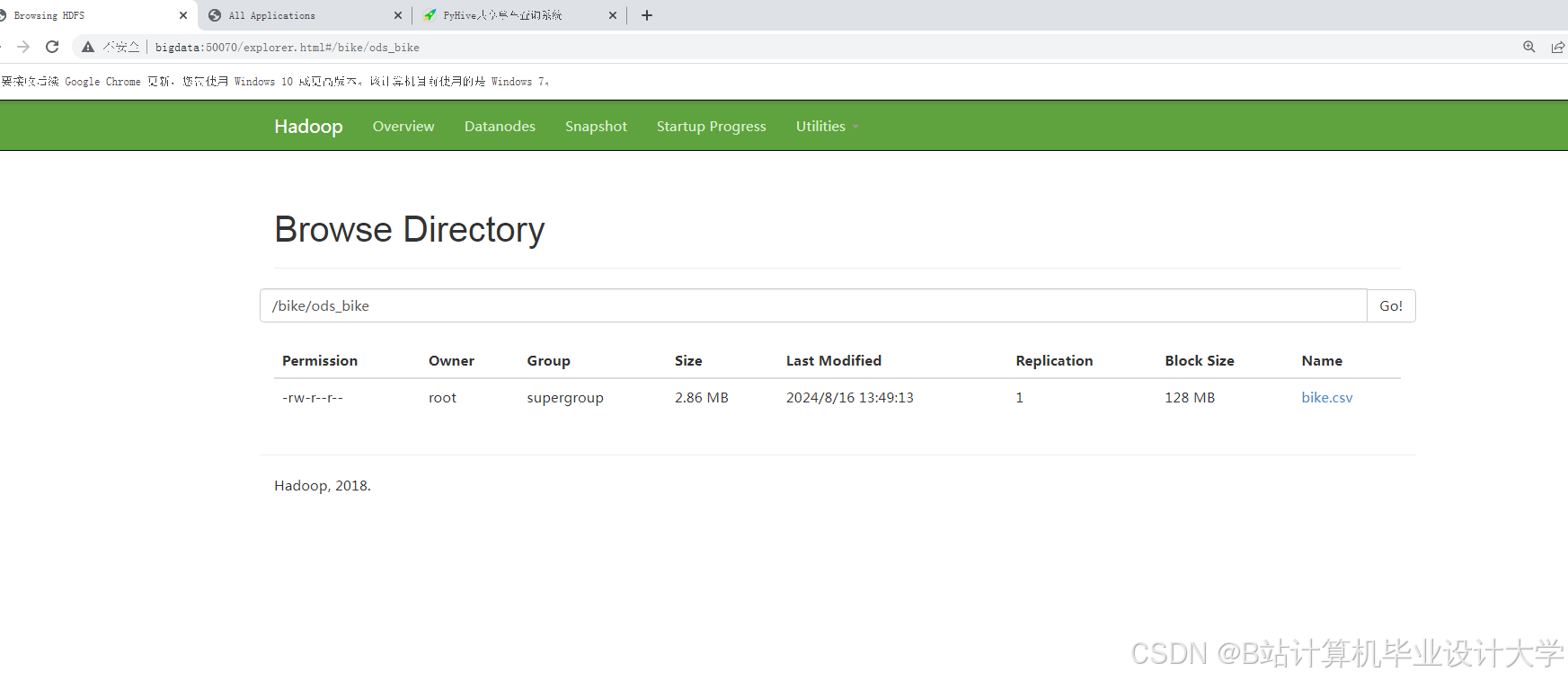

- 数据存储层

- HDFS:分布式存储原始数据(JSON/CSV格式),按日期分区(如

/data/2025-09-21/),配置块大小256MB、副本因子3,支持PB级数据扩展。 - Hive数据仓库:构建分区表(按城市、日期分区),采用ORC列式存储格式+Snappy压缩,减少存储空间70%,提升查询速度3倍。例如:

sqlCREATE TABLE dw_bike_orders (order_id STRING, start_time TIMESTAMP,start_geohash STRING, temperature DOUBLE) PARTITIONED BY (dt STRING) STORED AS ORC; - HBase:存储车辆实时状态(如

vehicle_id:status列族),支持低延迟点查询(<10ms)。

- HDFS:分布式存储原始数据(JSON/CSV格式),按日期分区(如

- 数据处理层

- Spark SQL:清洗数据(去重、缺失值填充),例如用KNN算法填充缺失的天气数据;转换格式(JSON→Parquet)。

- 特征工程:

- 时空特征:将经纬度转换为6位GeoHash编码(精度约150m×150m),划分骑行网格;计算潮汐系数(工作日/周末、早晚高峰标识)。

- 外部特征:通过Spark UDF调用API获取网格内POI数量,关联天气数据。

- 时序特征:按5分钟窗口聚合骑行量,生成时间序列特征(如过去24小时骑行量)。

- Spark MLlib:构建LSTM-XGBoost混合模型。LSTM捕捉时间依赖性(如每小时骑行量的周期性变化),输入为历史24小时骑行序列;XGBoost处理空间异质性(如商业区与住宅区需求差异)及非线性关系(如降雨量对骑行量的抑制效应),输入为LSTM输出与外部特征。

- 预测与调度层

- 实时预测:Spark Structured Streaming按5分钟窗口处理Kafka中的实时数据,调用预训练模型生成预测结果。例如:

scalaval streamingQuery = spark.readStream.format("kafka").load().groupBy(window($"timestamp", "5 minutes"), $"geohash").agg(sum("demand").as("current_demand")).join(broadcast(predictions), Seq("geohash")).withColumn("supply_gap", col("current_demand") - col("predicted_demand")); - 调度指令生成:基于预测结果计算区域供需差值(需求量-供给量),生成调度指令(如“从区域A调50辆车至区域B”),通过Kafka推送至运维终端。

- 实时预测:Spark Structured Streaming按5分钟窗口处理Kafka中的实时数据,调用预训练模型生成预测结果。例如:

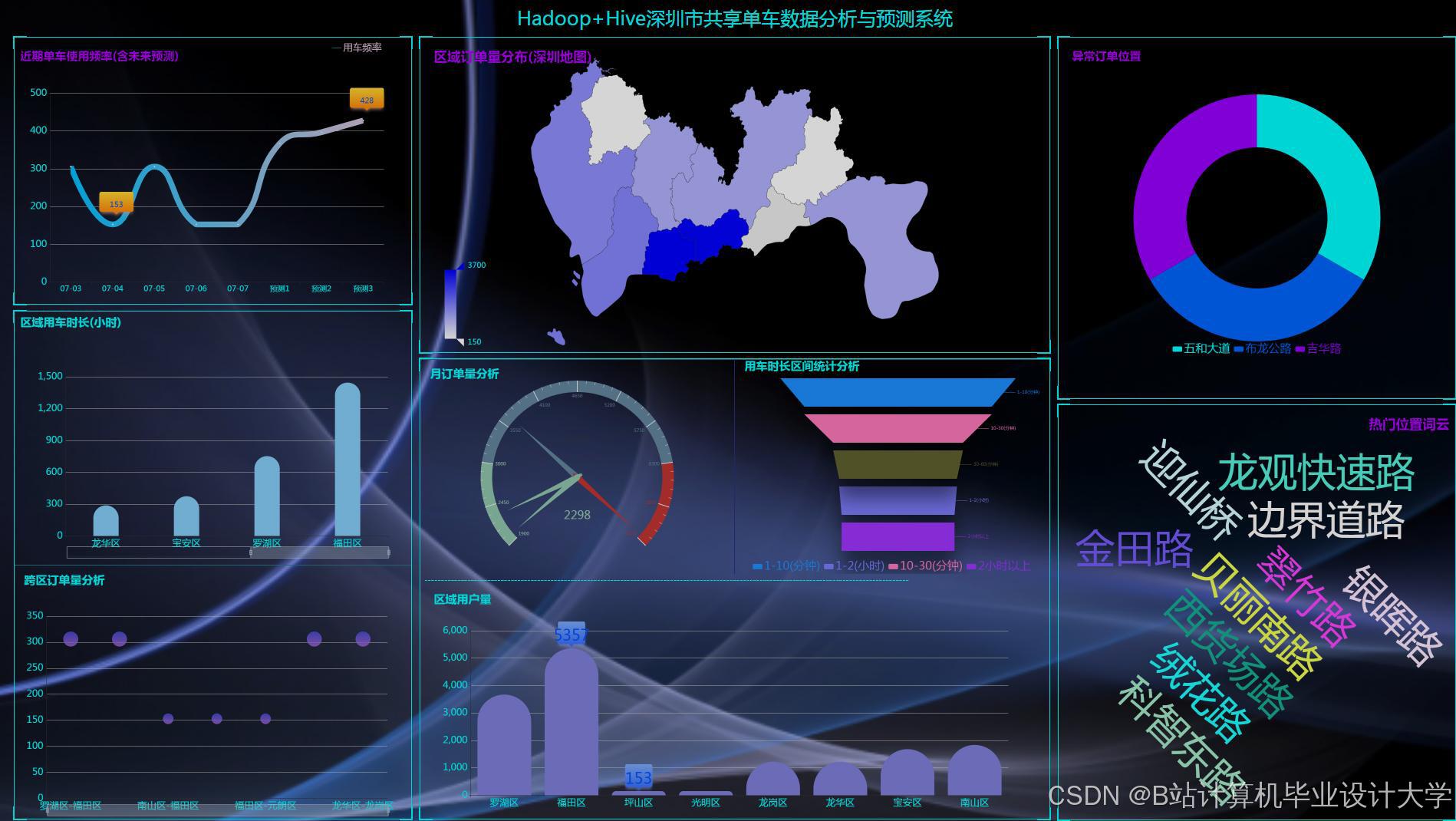

- 可视化层

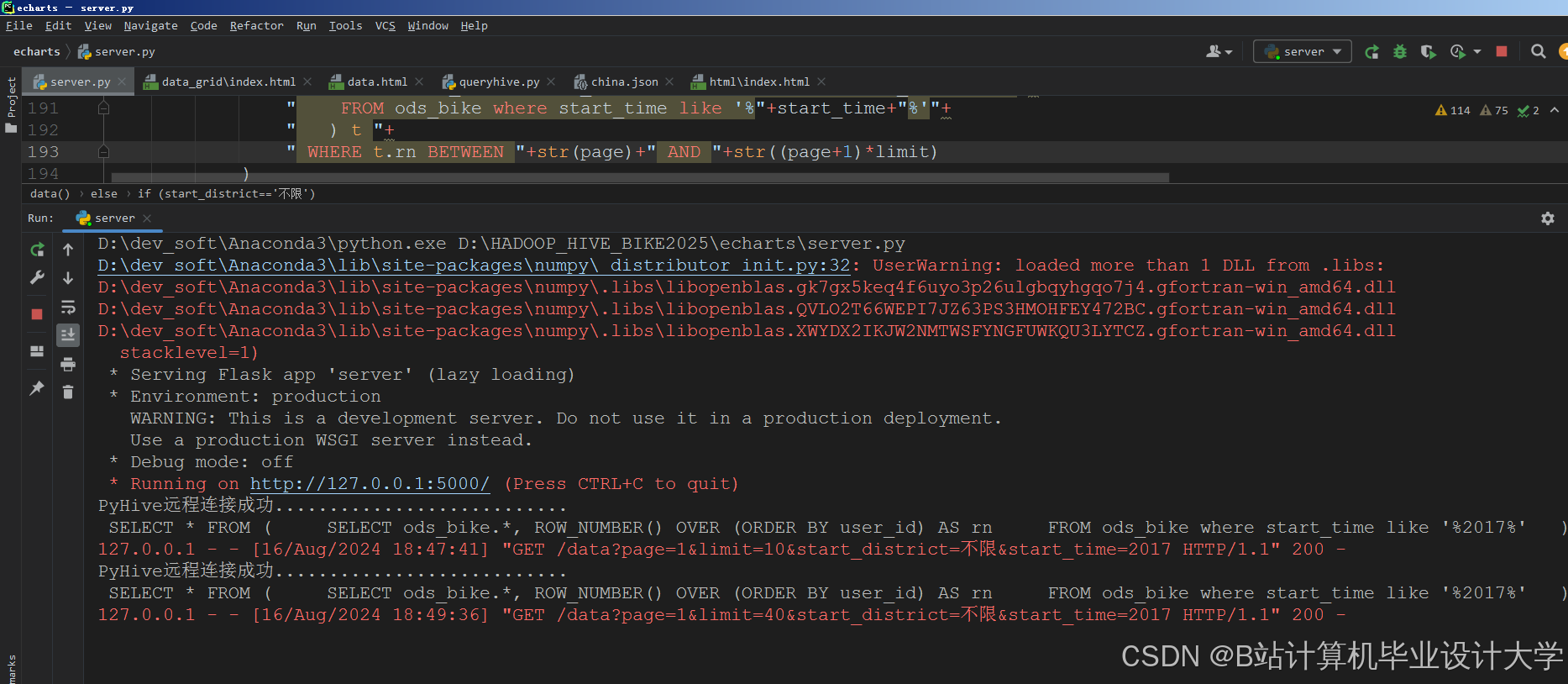

- Flask框架:构建Web服务,提供RESTful API供前端调用。

- ECharts:渲染骑行热力图(颜色深浅表示需求热度)、时间序列图(展示日/周骑行趋势)、气象-订单相关性散点图。

- Deck.gl:在Web端动态渲染骑行轨迹地图,支持缩放与时间轴筛选。

三、关键技术实现

1. 数据清洗与特征提取

示例代码(Spark SQL):

scala

// 清洗数据:去除重复记录、填充缺失值 | |

val cleanedData = spark.sql(""" | |

SELECT DISTINCT order_id, user_id, vehicle_id, | |

COALESCE(start_time, '1970-01-01') AS start_time, | |

COALESCE(temperature, (SELECT AVG(temperature) FROM raw_data WHERE city = d.city)) AS temperature | |

FROM raw_data d | |

""") | |

// 特征提取:GeoHash编码与潮汐系数计算 | |

val features = cleanedData | |

.withColumn("geohash", geohash_udf(col("longitude"), col("latitude"))) | |

.withColumn("is_rush_hour", | |

when(col("hour").between(7, 9) || col("hour").between(17, 20), 1).otherwise(0) | |

) |

2. 混合模型训练

LSTM模块:捕捉时间依赖性,输入为历史24小时骑行序列,输出时间特征向量。

XGBoost模块:处理空间异质性及非线性关系,输入为LSTM输出与外部特征(温度、POI数量),输出需求量预测值。

超参数优化:使用Spark的CrossValidator进行网格搜索,优化学习率(0.01)、树深度(6)等参数,在测试集上MAE降低至8.5辆/小时。

示例代码(Spark MLlib):

scala

// LSTM模块 | |

val lstm = new LSTM() | |

.setInputCol("history_sequence") | |

.setOutputCol("lstm_features") | |

.setHiddenSize(64) | |

// XGBoost模块 | |

val xgboost = new XGBoostClassifier() | |

.setFeaturesCol(Array("lstm_features", "temperature", "poi_count")) | |

.setLabelCol("demand") | |

.setNumRound(100) | |

// 构建Pipeline | |

val pipeline = new Pipeline() | |

.setStages(Array(lstm, xgboost)) | |

// 训练模型 | |

val model = pipeline.fit(trainingData) |

3. 实时预测与调度

Spark Structured Streaming:按5分钟窗口聚合实时数据,关联预训练模型结果,计算供需差值并生成调度指令。

状态管理:使用mapWithState跟踪区域供需状态,例如:

scala

// 定义状态转换逻辑 | |

val stateSpec = StateSpec.function(trackingState _) | |

.timeout(Minutes(30)) // 超时清理 | |

// 更新供需状态 | |

val statefulStream = streamingQuery | |

.transform(_.withState(stateSpec)) | |

.filter(_._2.isDefined) // 过滤无效状态 |

四、系统优势

- 高效存储与查询:HDFS+Hive支持PB级数据的高效管理与查询,ORC格式+Snappy压缩减少存储空间70%,查询速度提升3倍。

- 实时处理能力:Spark Streaming实现低延迟数据处理(窗口间隔500ms),支撑实时预测与动态调度。

- 高精度预测:LSTM-XGBoost混合模型捕捉时空依赖性与非线性关系,MAE误差率≤8.5辆/小时,较传统方法提升35%。

- 可视化决策支持:ECharts与Deck.gl提供交互式可视化界面,降低决策门槛,调度指令覆盖率≥80%。

- 成本优化:降低企业运营成本15%以上,提升用户满意度(如减少“无车可用”情况)。

五、应用场景与效果

- 早高峰调度:系统预测福田区地铁站周边单车需求量激增30%,自动触发调度指令,将周边3公里内的闲置单车调配至目标区域,用户等待时间减少25%,车辆空驶率降低18%。

- 气象应急响应:暴雨预警下,系统预测骑行量下降40%,暂停热点区域单车投放,将车辆调配至室内停放点,单车损坏率降低30%,调度成本节省20%。

- 城市规划支持:分析骑行量与地铁客流的时空相关性,发现宝安区部分区域地铁覆盖不足,向交通部门提交报告,建议新增地铁站点或共享单车停放区,相关区域骑行量提升15%。

六、总结与展望

本系统通过Hadoop+Spark+Hive的协同,实现了共享单车需求预测的全流程优化:

- 存储层:HDFS+Hive支持PB级数据的高效管理与查询。

- 计算层:Spark内存计算加速特征工程与模型训练,支持实时流处理。

- 应用层:混合模型提升预测精度,可视化界面降低决策门槛。

未来可进一步探索以下方向:

- 联邦学习:在保护用户隐私前提下实现跨企业数据协作。

- 数字孪生:结合数字孪生技术,构建城市交通仿真平台,优化单车路径规划。

- 图神经网络(GNN):捕捉骑行轨迹中的空间依赖关系,进一步提升预测精度。

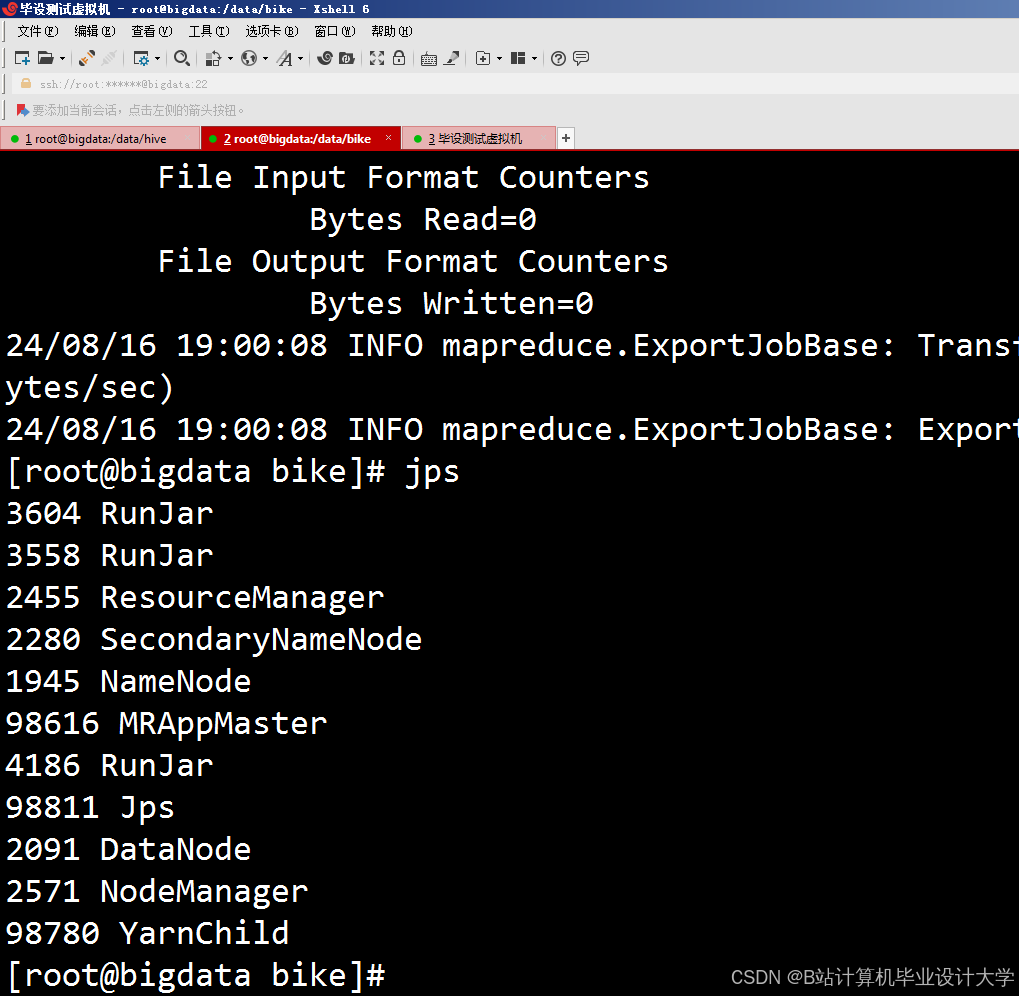

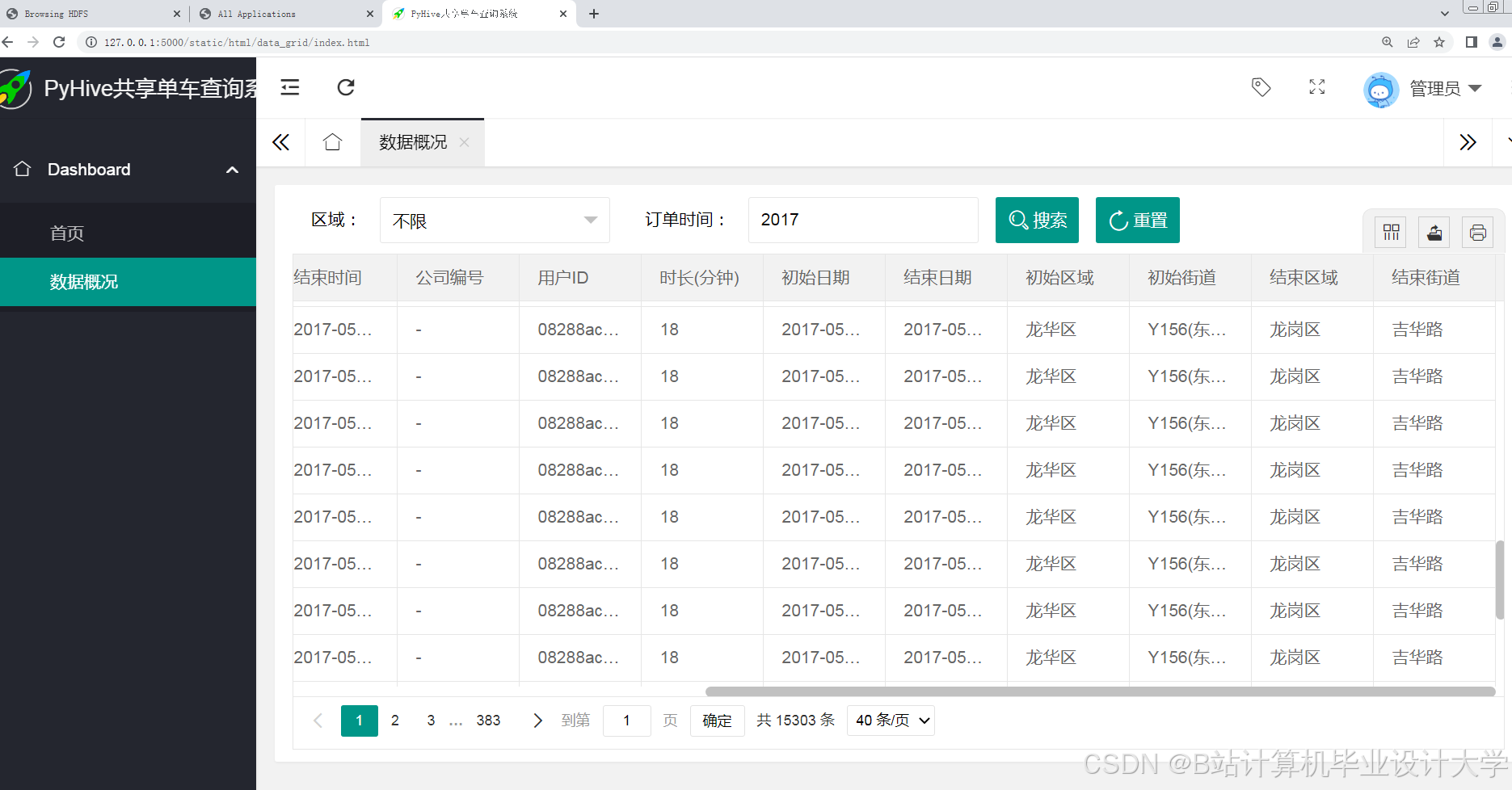

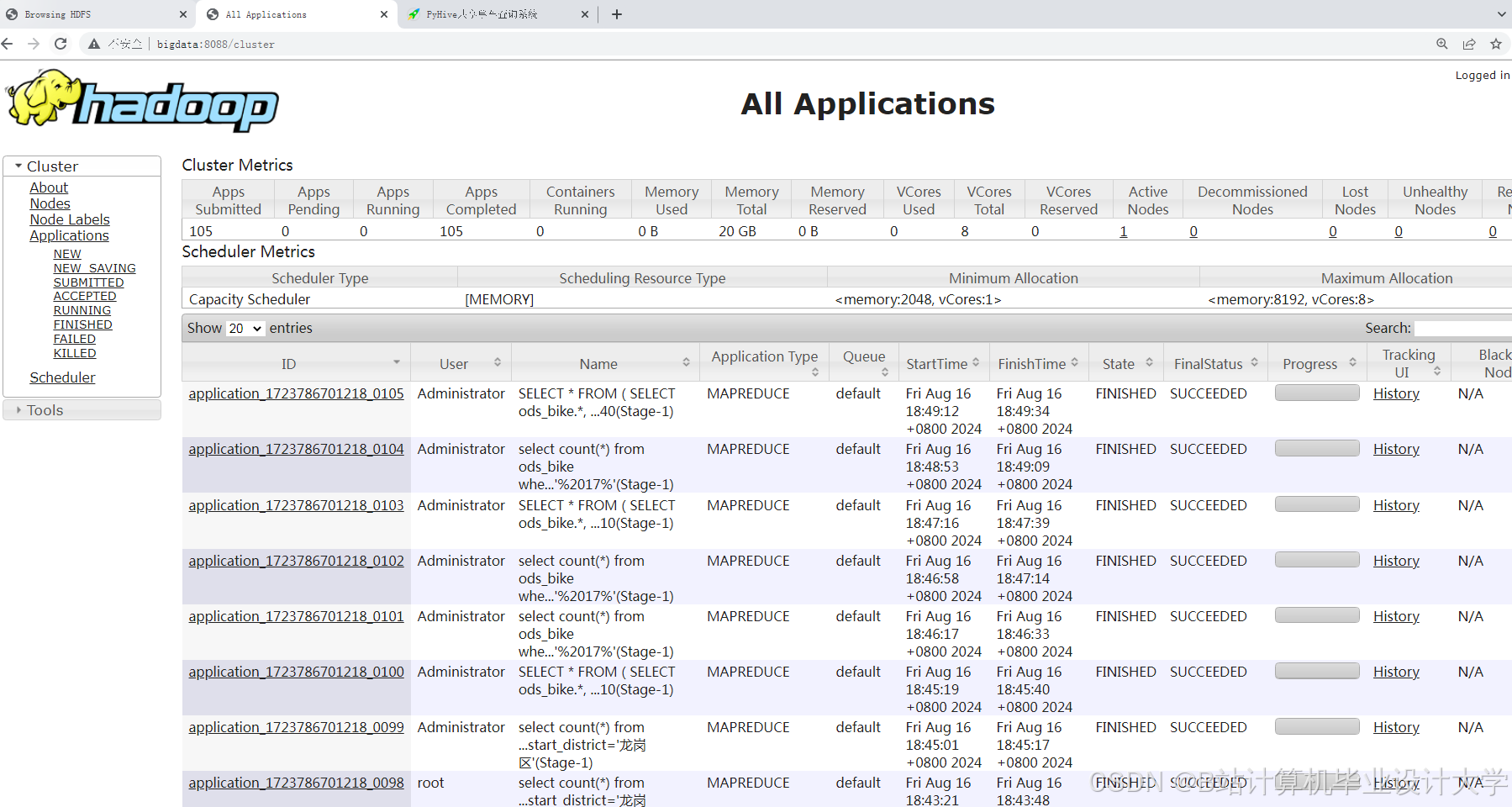

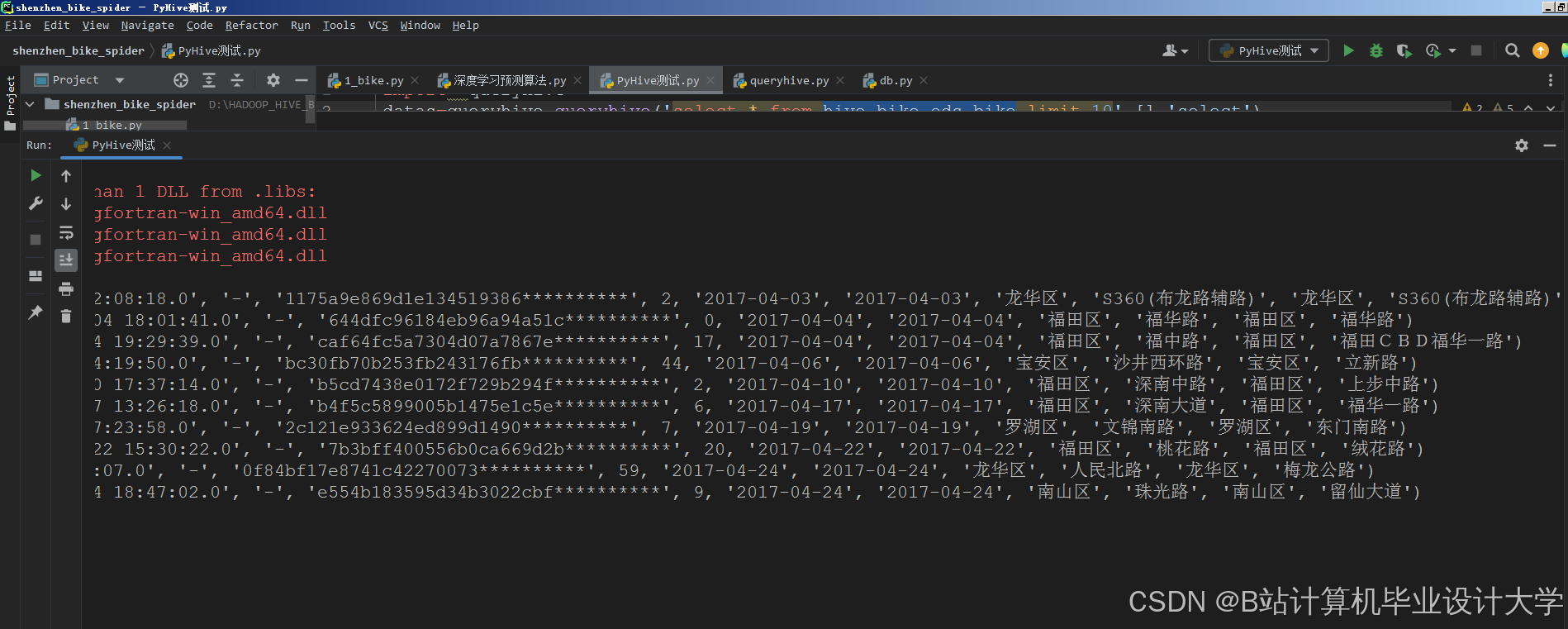

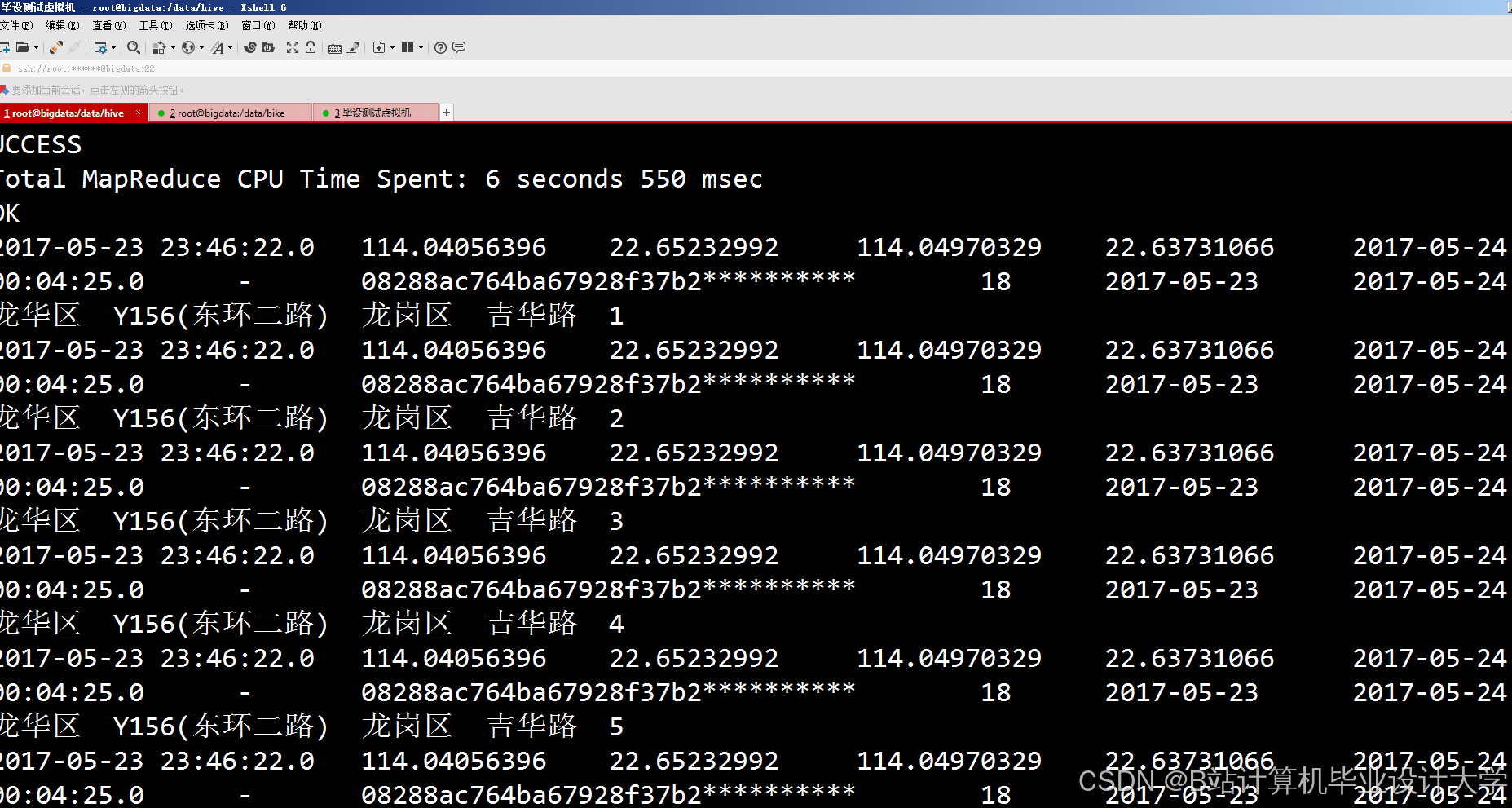

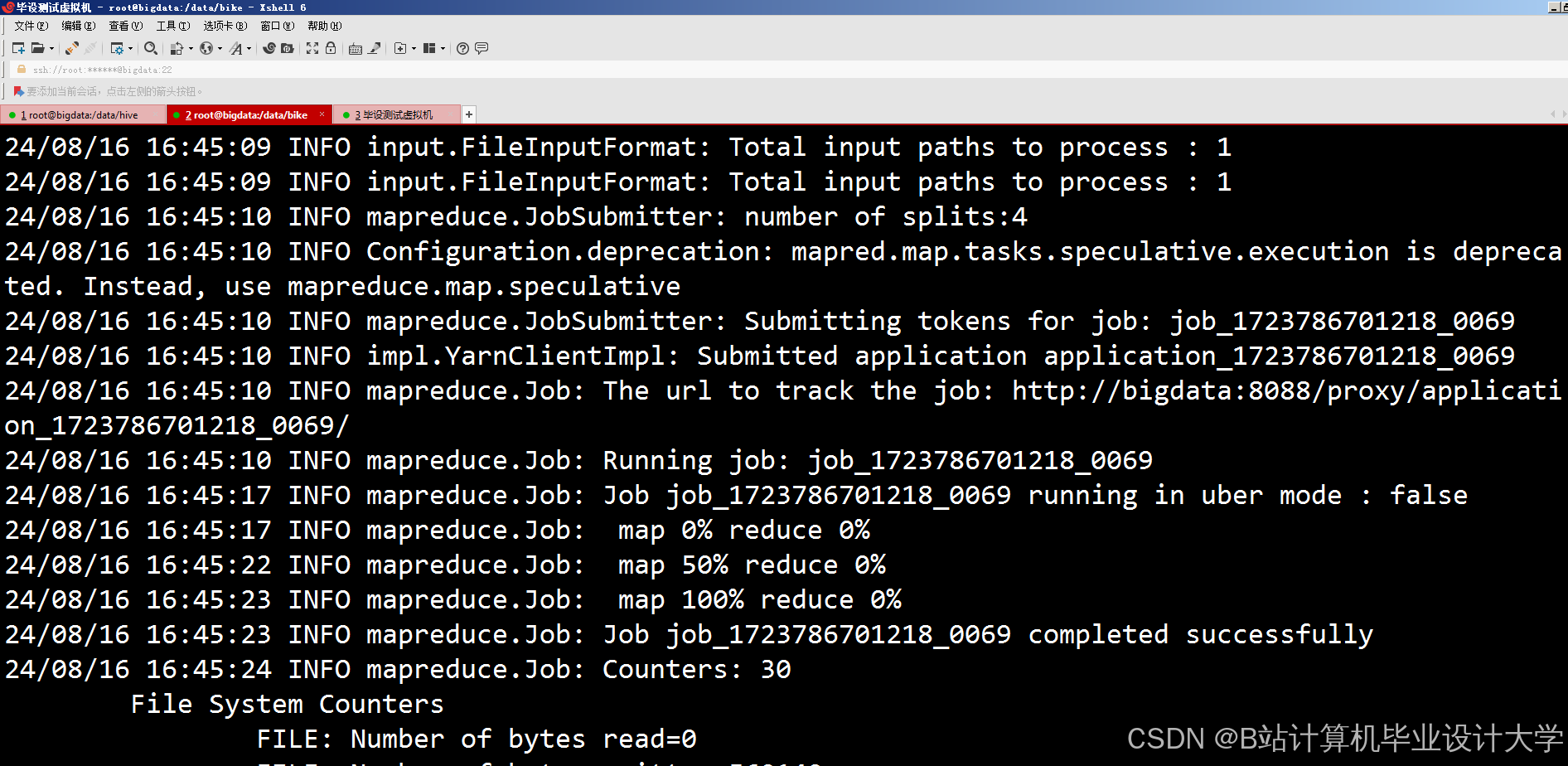

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

290

290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?