温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop + Spark + Hive物流预测系统技术说明

一、引言

在当今全球化和电子商务蓬勃发展的时代,物流行业面临着前所未有的挑战与机遇。准确预测物流需求、运输时间、货物库存等关键指标,对于优化物流资源配置、降低成本、提高客户满意度至关重要。Hadoop、Spark和Hive作为大数据处理领域的核心技术栈,为构建高效、准确的物流预测系统提供了强大的支持。本技术说明将详细介绍基于Hadoop + Spark + Hive的物流预测系统的架构、功能模块、技术实现及优势。

二、系统架构概述

本物流预测系统采用分层架构设计,主要包括数据采集层、数据存储层、数据处理层、模型训练与预测层以及应用展示层。

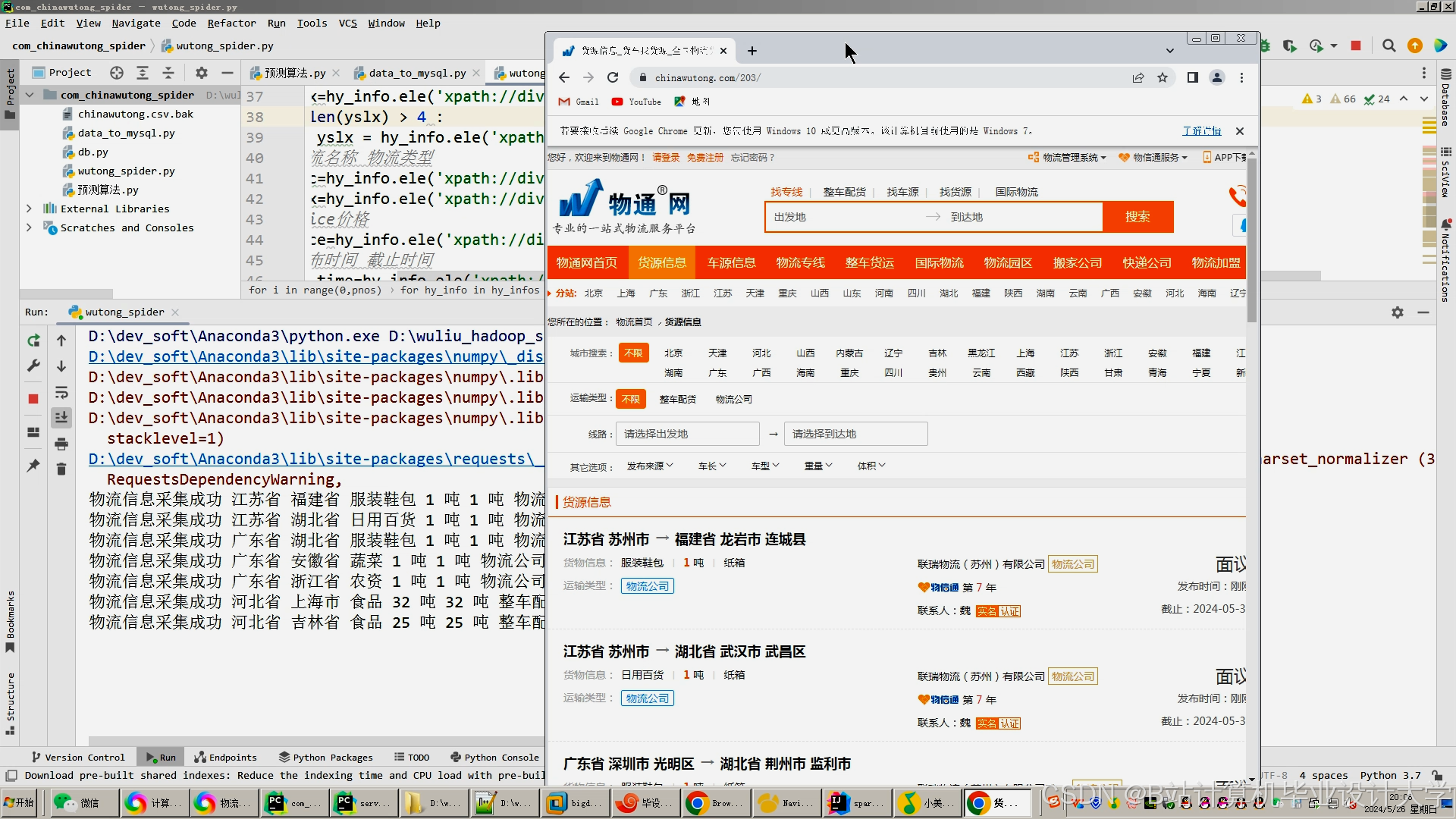

(一)数据采集层

- 来源多样:系统数据来源广泛,涵盖物流企业内部的业务系统,如订单管理系统(OMS)、运输管理系统(TMS)、仓储管理系统(WMS)等,这些系统记录了订单信息、运输轨迹、货物出入库等详细数据。同时,还整合了外部数据源,如天气数据、交通状况数据、市场行情数据等,以更全面地考虑影响物流的各种因素。

- 采集方式:采用多种数据采集方式,包括定时批量采集和实时流式采集。对于业务系统的历史数据,通过ETL工具进行定时批量抽取、转换和加载;对于实时性要求较高的数据,如运输车辆的实时位置信息,利用消息队列(如Kafka)实现实时流式采集。

(二)数据存储层

- Hadoop HDFS:作为分布式文件系统,Hadoop HDFS是数据存储的基础架构。它能够存储海量的物流数据,包括结构化数据(如订单表、运输记录表)和非结构化数据(如运输过程中的图片、视频)。HDFS的高容错性和可扩展性确保了数据的安全存储和高效访问,即使面对大规模数据增长,也能稳定运行。

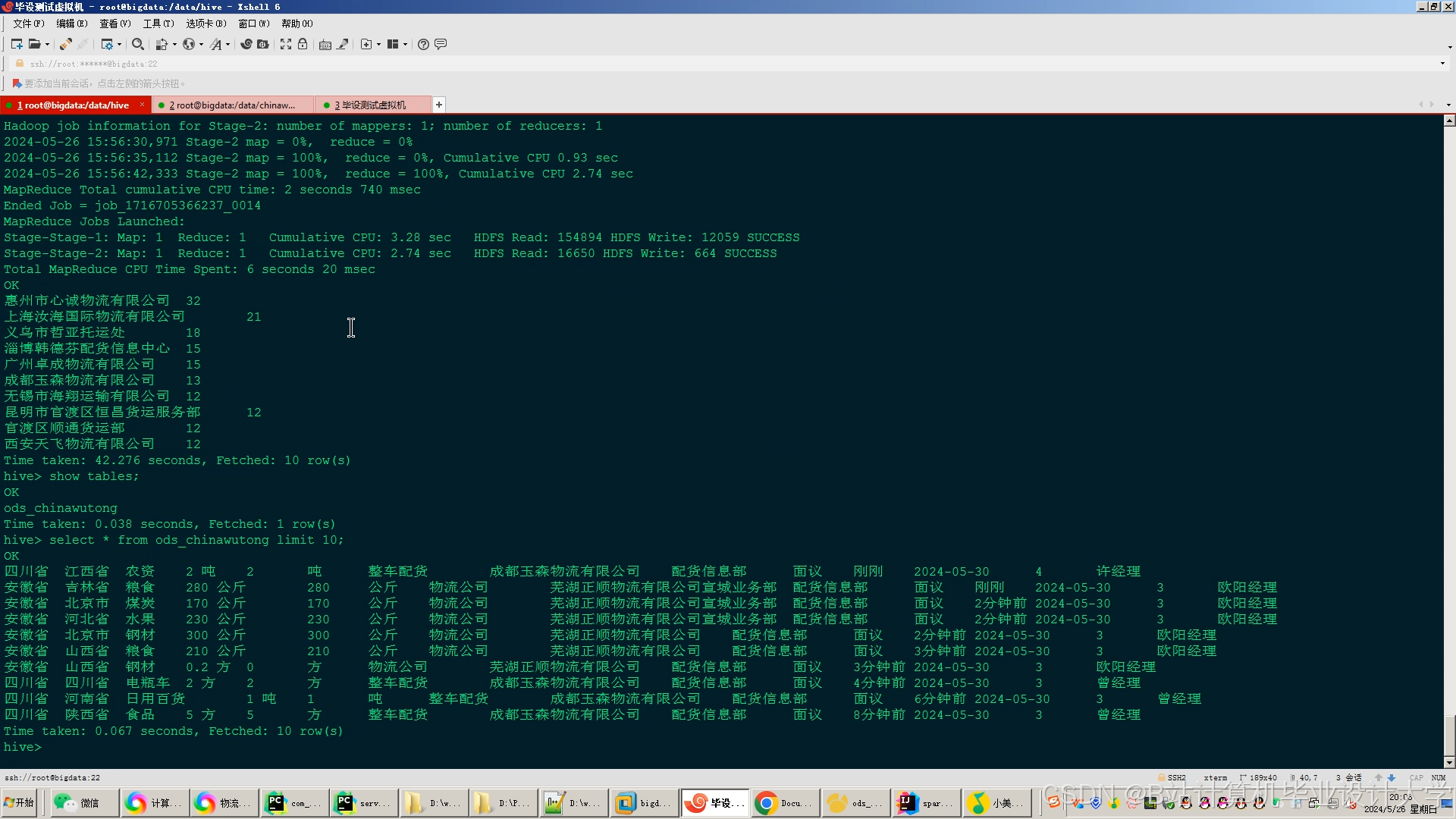

- Hive数据仓库:基于HDFS构建Hive数据仓库,将存储在HDFS上的数据进行结构化组织和管理。通过创建外部表或内部表,将不同来源的数据映射为数据库表,并定义表之间的关系。Hive提供了类似SQL的查询语言(HQL),方便数据分析人员进行数据查询和分析操作,为后续的数据处理和模型训练提供数据支持。

(三)数据处理层

- Spark核心处理:Spark作为内存计算框架,在数据处理层发挥关键作用。它能够快速读取Hive数据仓库中的数据,并进行复杂的数据处理操作,如数据清洗、数据转换、特征工程等。Spark的分布式计算能力可以并行处理大规模数据,大大提高了数据处理效率。例如,在对运输时间进行预测时,需要对运输记录数据进行清洗,去除异常值和缺失值,并对时间、距离等特征进行转换和计算。

- Spark SQL与DataFrame API:Spark SQL提供了在Spark上执行类似SQL查询的功能,数据分析人员可以使用熟悉的SQL语法对数据进行查询和分析。同时,Spark的DataFrame API提供了一种更面向对象的数据处理方式,方便进行数据操作和转换。通过结合使用Spark SQL和DataFrame API,可以更加灵活高效地处理物流数据。

(四)模型训练与预测层

- 算法选择:根据物流预测的不同需求,选择合适的机器学习算法。例如,对于运输时间预测,可以采用回归算法,如线性回归、决策树回归、随机森林回归等;对于货物需求预测,可以使用时间序列分析算法,如ARIMA模型、LSTM神经网络等。这些算法能够在Spark的机器学习库(MLlib)中方便地实现和应用。

- 模型训练与评估:使用处理好的物流数据对选定的算法进行模型训练。将数据划分为训练集、验证集和测试集,通过训练集调整模型参数,使用验证集进行模型调优,最后在测试集上评估模型的性能。常用的评估指标包括均方误差(MSE)、平均绝对误差(MAE)、决定系数(R²)等。根据评估结果,不断优化模型,提高预测准确性。

- 模型部署与预测:将训练好的模型部署到生产环境中,利用Spark的实时处理能力对新输入的物流数据进行实时预测。例如,当有新的订单产生时,系统可以实时预测该订单的运输时间和货物到达时间,并将预测结果反馈给相关人员。

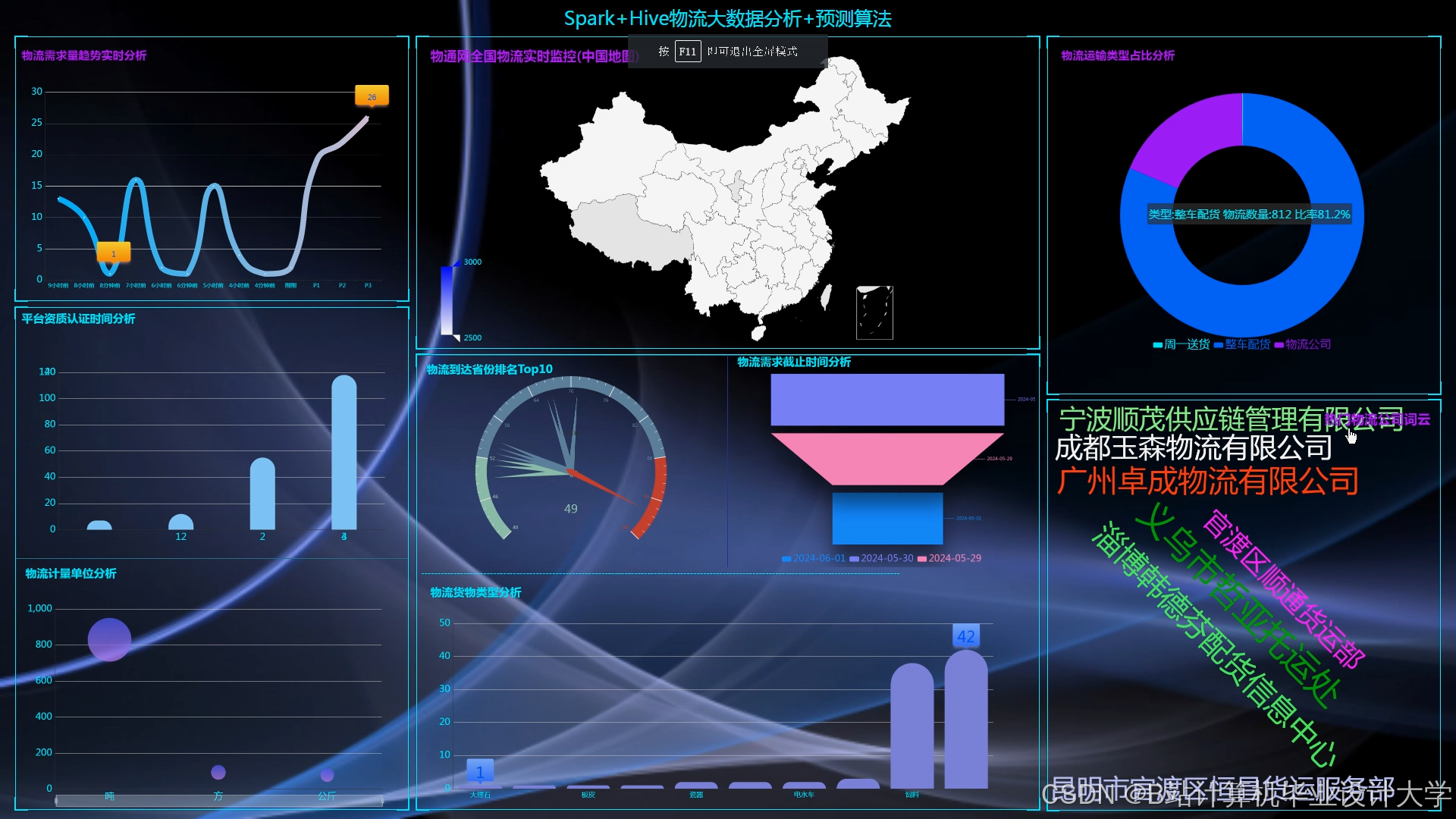

(五)应用展示层

- 可视化界面:开发直观、易用的可视化界面,将物流预测结果以图表、报表等形式展示给用户。例如,使用柱状图展示不同地区的货物需求预测情况,使用折线图展示运输时间的历史变化和预测趋势。可视化界面可以帮助用户快速理解预测结果,做出合理的决策。

- 预警与通知功能:系统具备预警与通知功能,当预测结果超出预设的阈值时,及时向相关人员发送预警信息。例如,如果预测到某条运输路线的运输时间将大幅延长,系统会立即通知物流调度人员,以便他们及时调整运输计划。

三、关键技术实现

(一)Hadoop与Hive集成

- Hive元数据管理:Hive将元数据存储在关系型数据库(如MySQL)中,包括表结构、分区信息等。通过配置Hive的元数据库,实现Hive与Hadoop HDFS的集成。在创建Hive表时,指定表的数据存储路径为HDFS上的目录,使得Hive能够访问和管理HDFS上的数据。

- Hive与Spark交互:Spark可以通过Spark SQL直接读取Hive表中的数据,无需进行复杂的数据转换和加载。在Spark程序中,创建SparkSession对象并启用Hive支持,即可使用Spark SQL查询Hive表中的数据。例如:

python

from pyspark.sql import SparkSession | |

spark = SparkSession.builder \ | |

.appName("LogisticsPrediction") \ | |

.enableHiveSupport() \ | |

.getOrCreate() | |

# 查询Hive表中的数据 | |

df = spark.sql("SELECT * FROM logistics_orders") |

(二)Spark数据处理示例

以下是一个使用Spark进行数据清洗和特征工程的示例代码,假设我们要对运输记录数据进行处理:

python

from pyspark.sql import functions as F | |

# 读取运输记录数据 | |

transport_data = spark.sql("SELECT * FROM transport_records") | |

# 数据清洗:去除运输时间为负数或零的记录 | |

cleaned_data = transport_data.filter(transport_data.transport_time > 0) | |

# 特征工程:计算运输距离与运输时间的比值作为新特征 | |

from pyspark.sql.types import DoubleType | |

def calculate_ratio(row): | |

if row.distance != 0: | |

return row.transport_time / row.distance | |

else: | |

return 0.0 | |

calculate_ratio_udf = F.udf(calculate_ratio, DoubleType()) | |

featured_data = cleaned_data.withColumn("time_distance_ratio", calculate_ratio_udf(F.col("distance"), F.col("transport_time"))) | |

# 显示处理后的数据 | |

featured_data.show() |

(三)Spark MLlib模型训练与预测

以下是一个使用Spark MLlib中的随机森林回归算法进行运输时间预测的示例代码:

python

from pyspark.ml import Pipeline | |

from pyspark.ml.feature import VectorAssembler | |

from pyspark.ml.regression import RandomForestRegressor | |

from pyspark.ml.evaluation import RegressionEvaluator | |

# 准备训练数据和测试数据 | |

(train_data, test_data) = featured_data.randomSplit([0.7, 0.3]) | |

# 定义特征向量组装器 | |

assembler = VectorAssembler( | |

inputCols=["distance", "time_distance_ratio", "vehicle_type"], # 假设这些是特征列 | |

outputCol="features" | |

) | |

# 定义随机森林回归模型 | |

rf = RandomForestRegressor(featuresCol="features", labelCol="transport_time") | |

# 构建Pipeline | |

pipeline = Pipeline(stages=[assembler, rf]) | |

# 训练模型 | |

model = pipeline.fit(train_data) | |

# 进行预测 | |

predictions = model.transform(test_data) | |

# 评估模型性能 | |

evaluator = RegressionEvaluator( | |

labelCol="transport_time", predictionCol="prediction", metricName="rmse" | |

) | |

rmse = evaluator.evaluate(predictions) | |

print(f"Root Mean Squared Error (RMSE) = {rmse}") |

四、系统优势

(一)高效处理大规模数据

Hadoop的分布式存储和Spark的内存计算能力相结合,能够快速处理海量的物流数据,满足物流行业对数据实时性和准确性的要求。无论是历史数据的批量分析还是实时数据的流式处理,系统都能高效完成。

(二)多样化的数据整合

系统能够整合来自多个不同数据源的物流相关数据,包括内部业务系统和外部环境数据。通过全面考虑各种影响因素,提高了物流预测的准确性和可靠性。

(三)灵活的模型训练与优化

Spark MLlib提供了丰富的机器学习算法和工具,支持快速模型训练和评估。用户可以根据不同的物流预测需求选择合适的算法,并通过调整模型参数和特征工程不断优化模型性能。

(四)直观的应用展示与决策支持

可视化界面和预警通知功能使得物流预测结果能够直观地展示给用户,帮助他们及时了解物流状况并做出合理决策。预警机制能够在出现问题时及时通知相关人员,减少物流风险和损失。

五、总结与展望

基于Hadoop + Spark + Hive的物流预测系统充分利用了大数据技术的优势,为物流行业提供了一种高效、准确的预测解决方案。通过整合多源数据、进行复杂的数据处理和模型训练,系统能够预测物流关键指标,为物流企业的运营决策提供有力支持。未来,随着物流行业的不断发展和大数据技术的持续创新,系统可以进一步优化算法、拓展功能,如引入深度学习算法提高预测精度、实现更智能的物流调度和优化等,以适应物流行业日益复杂多变的需求。

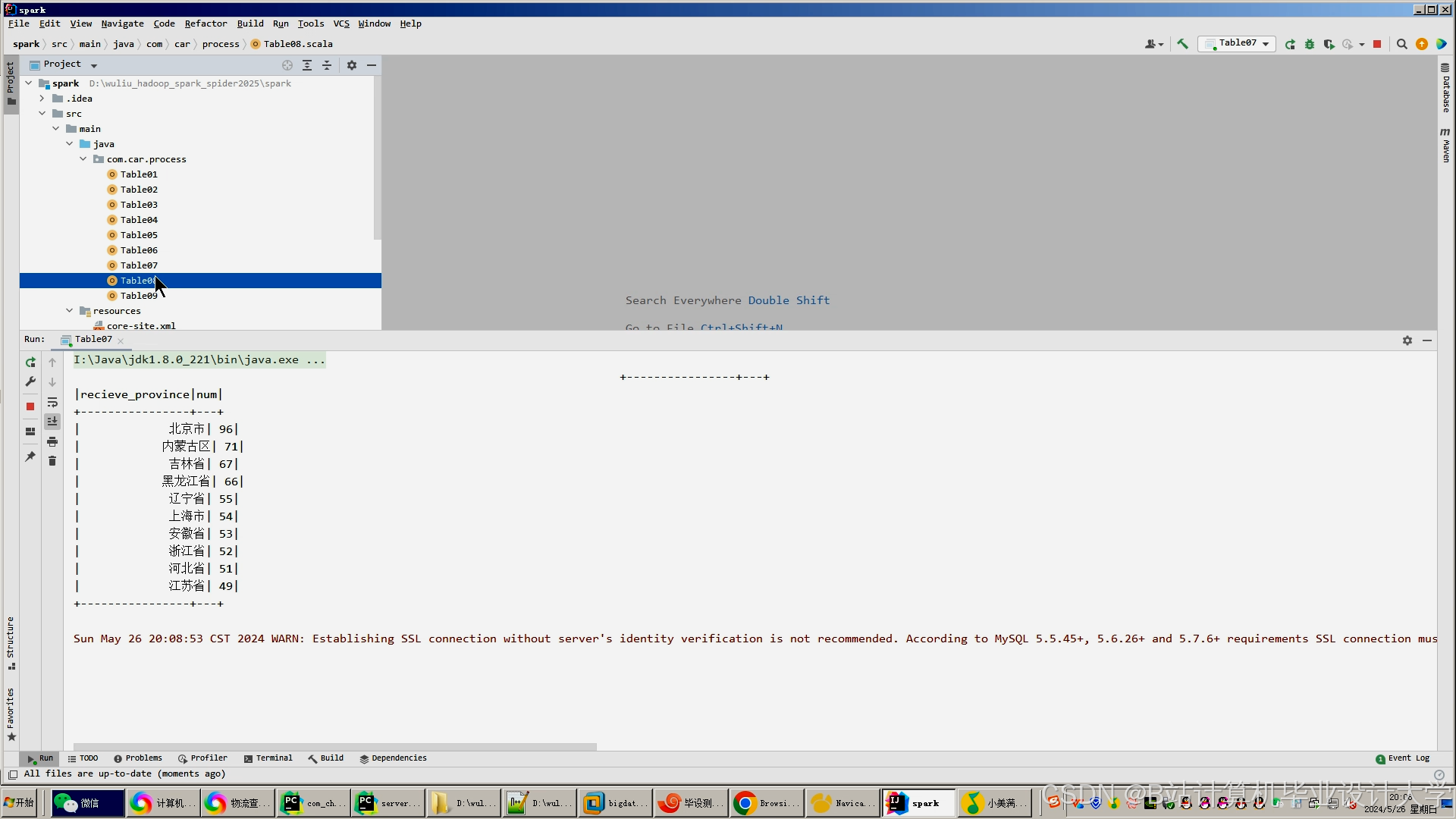

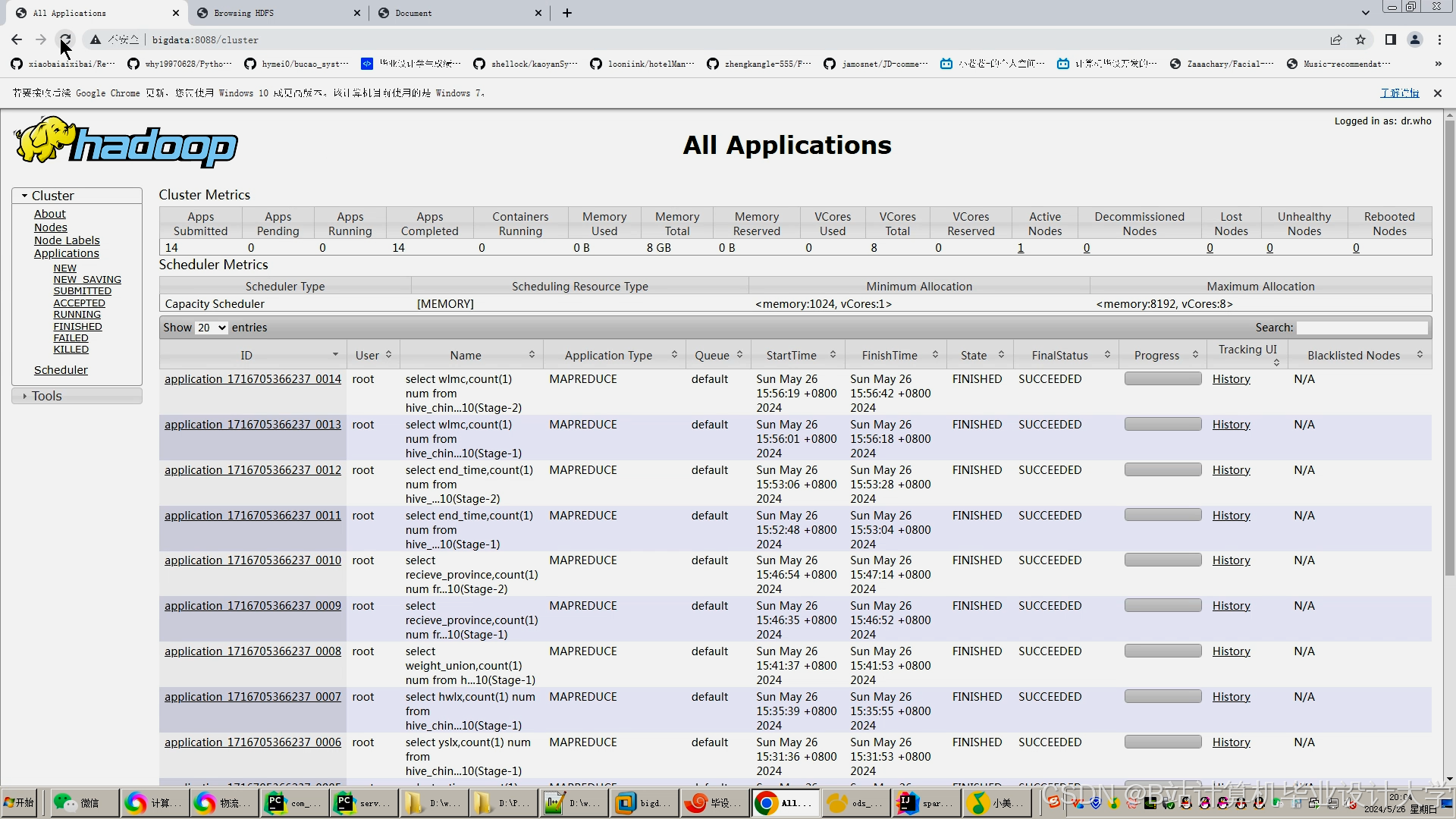

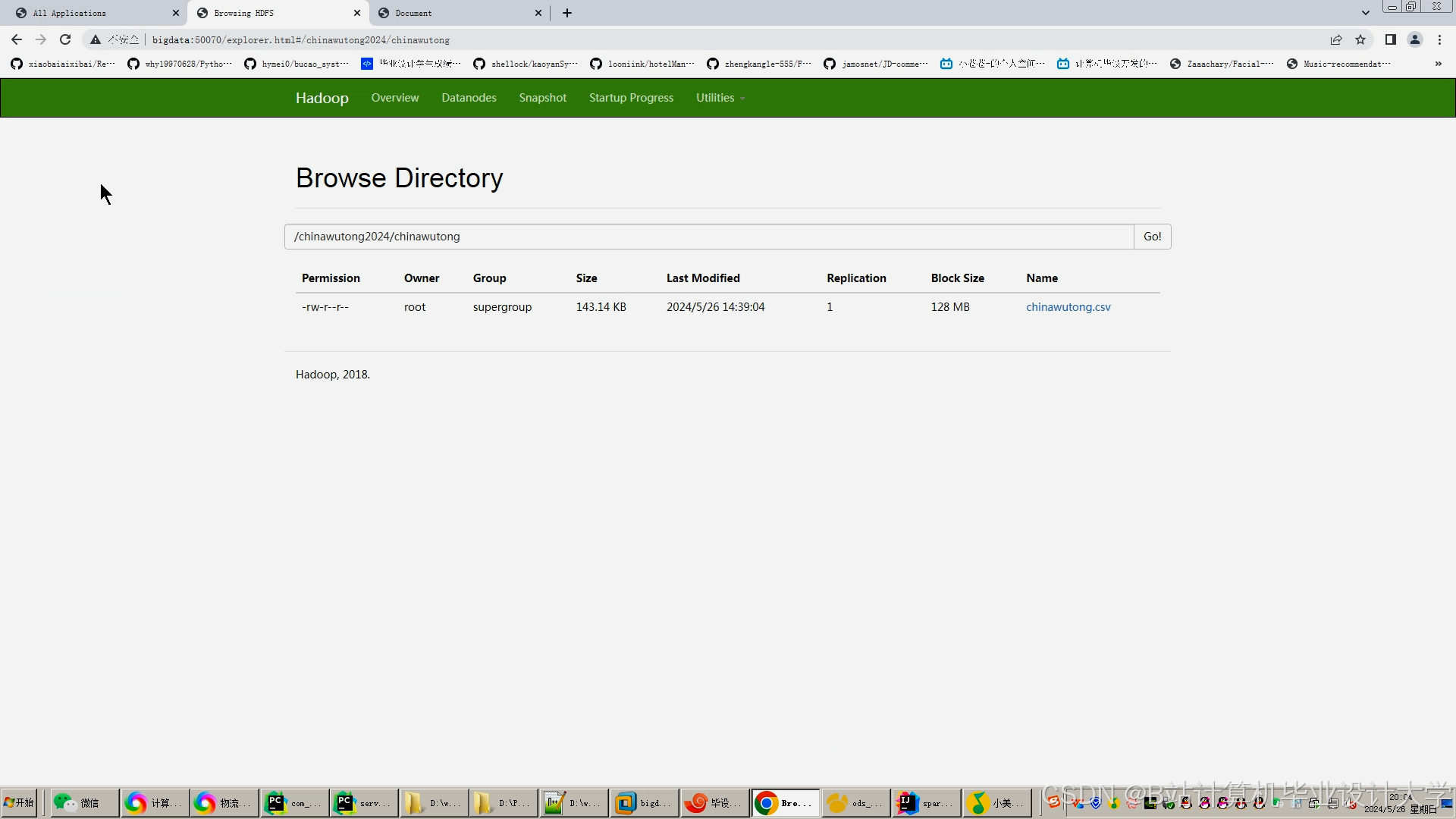

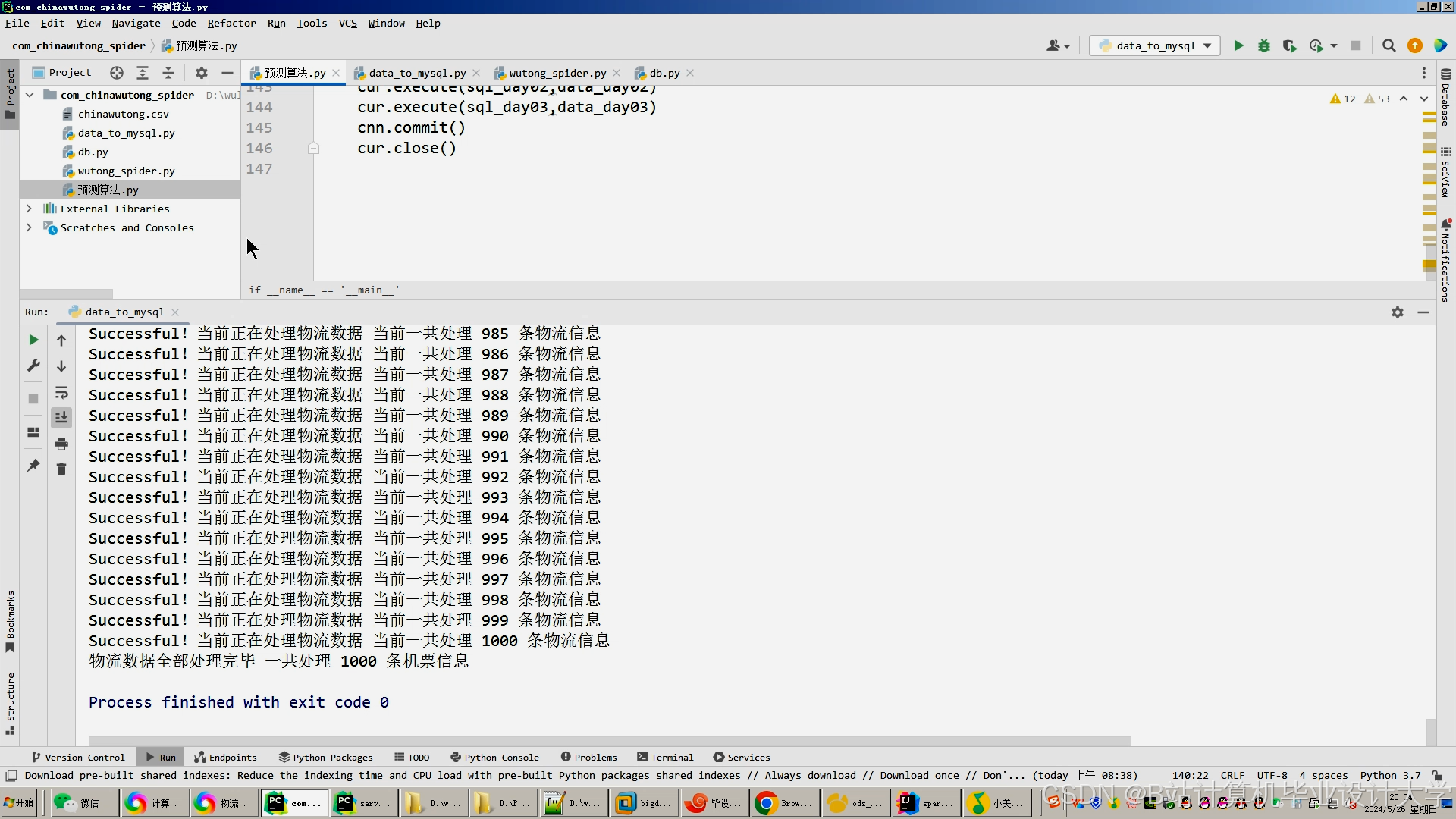

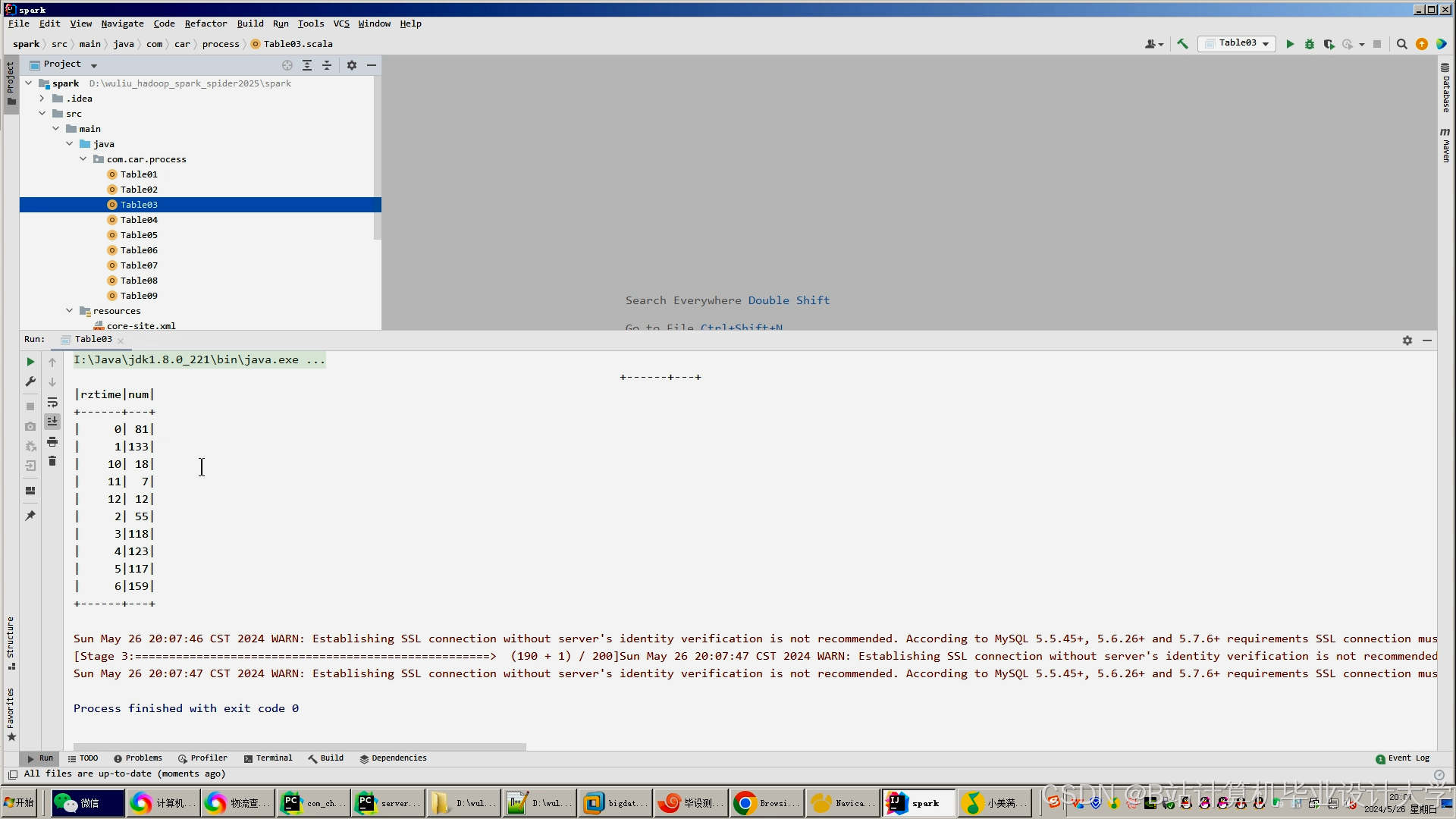

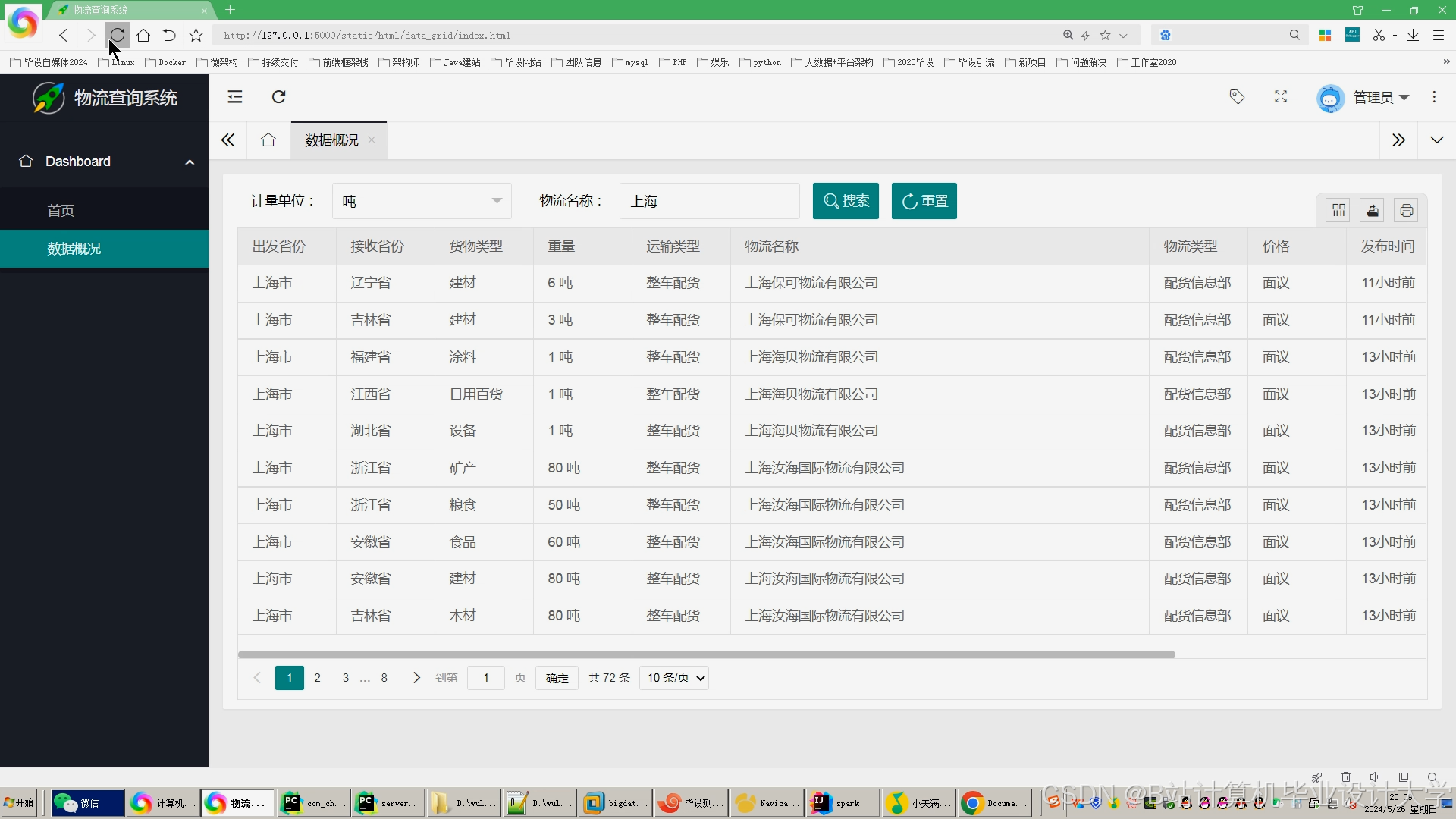

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

350

350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?