温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份针对《Hadoop+Spark+Hive共享单车预测系统及数据可视化分析》的任务书模板,涵盖数据采集、预测模型构建、可视化分析设计及系统集成等核心模块:

任务书:基于Hadoop+Spark+Hive的共享单车预测系统及可视化分析

一、项目背景与目标

1. 背景

共享单车行业面临用户需求波动大、车辆调度效率低、区域供需失衡等挑战。传统调度依赖人工经验,难以应对突发需求(如暴雨导致的短时订单激增)。需结合大数据处理框架(Hadoop+Spark)与机器学习模型,构建实时需求预测系统,并通过可视化分析支撑运营决策。

2. 目标

- 数据层:构建Hadoop+Hive数据仓库,整合单车订单、车辆状态、天气、POI(兴趣点)等多源数据。

- 预测层:基于Spark MLlib开发时空需求预测模型,实现以下功能:

- 未来1小时/24小时各区域订单量预测(精度MAPE≤15%)。

- 异常需求预警(如地铁站周边订单量突增30%以上)。

- 分析层:通过可视化工具(Grafana+ECharts)展示供需热力图、车辆周转率、用户骑行模式等关键指标,辅助调度策略优化。

二、项目任务与分工

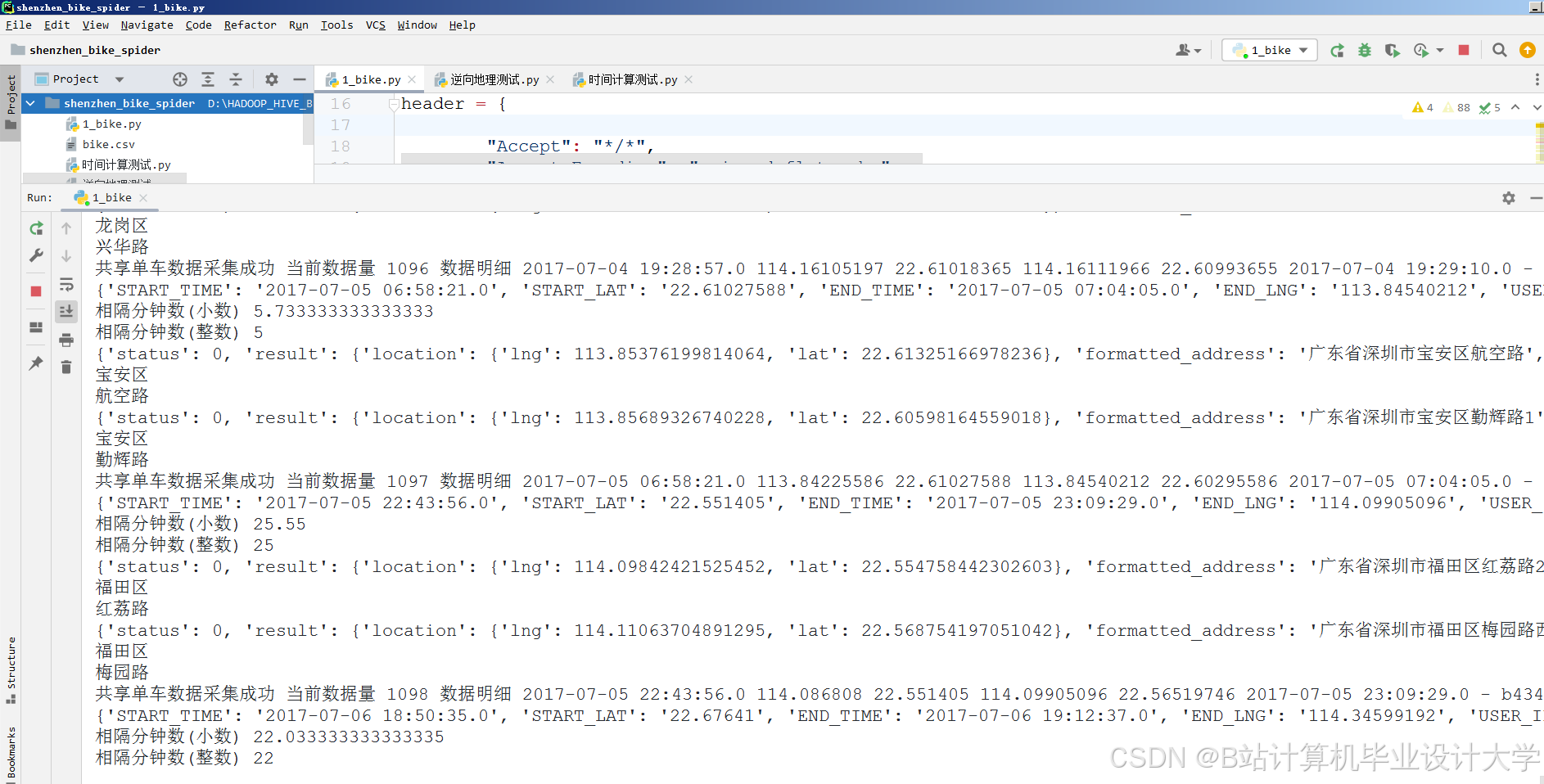

1. 多源数据采集与存储(Hadoop+Hive)

- 任务内容

- 数据源接入:

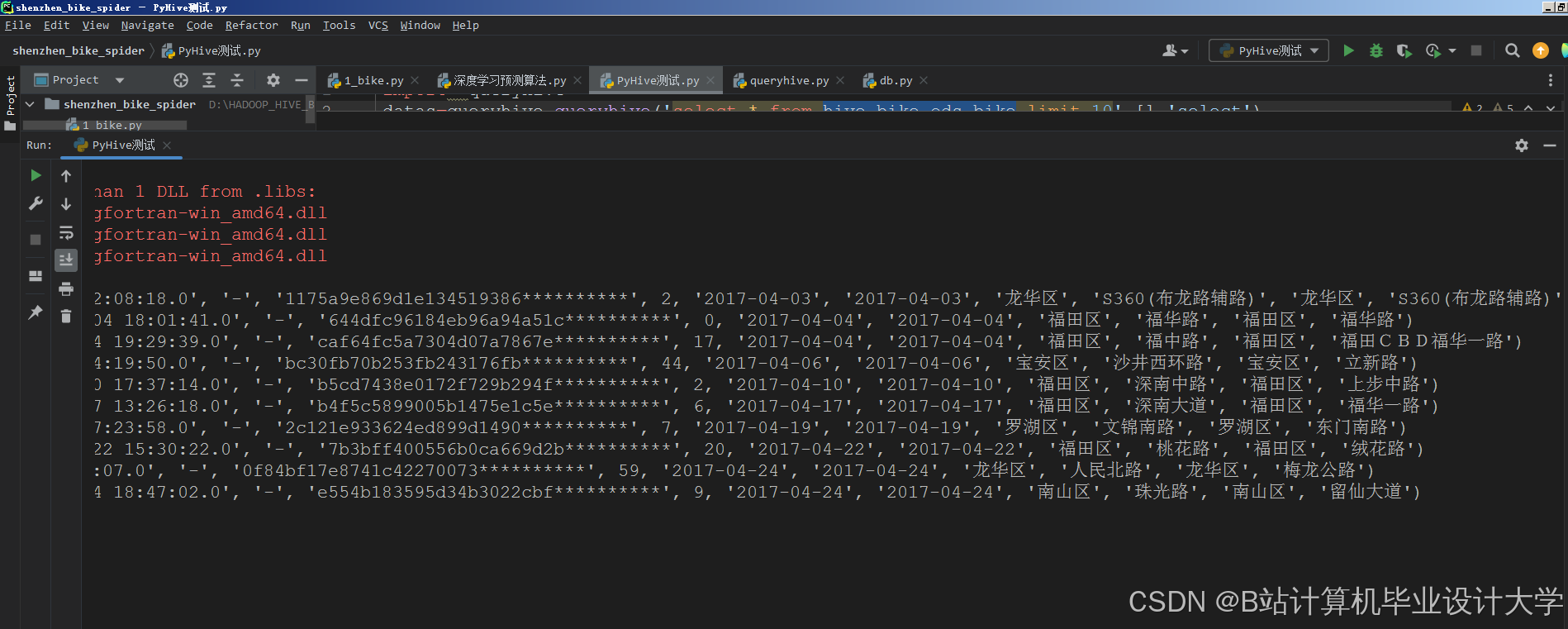

- 订单数据:订单ID、用户ID、车辆ID、起点/终点经纬度、骑行开始/结束时间、骑行时长、费用。

- 车辆状态数据:车辆ID、当前位置(经纬度)、电池电量(电动车)、锁状态(开锁/关锁)、最后上报时间。

- 外部数据:

- 天气数据(温度、降雨量、风速,影响骑行意愿)。

- POI数据(地铁站、写字楼、居民区、商圈的坐标及类型)。

- 节假日日历(如国庆节导致旅游区需求激增)。

- 数据清洗与存储:

- 处理异常数据(如骑行时长为负、经纬度超出城市范围)。

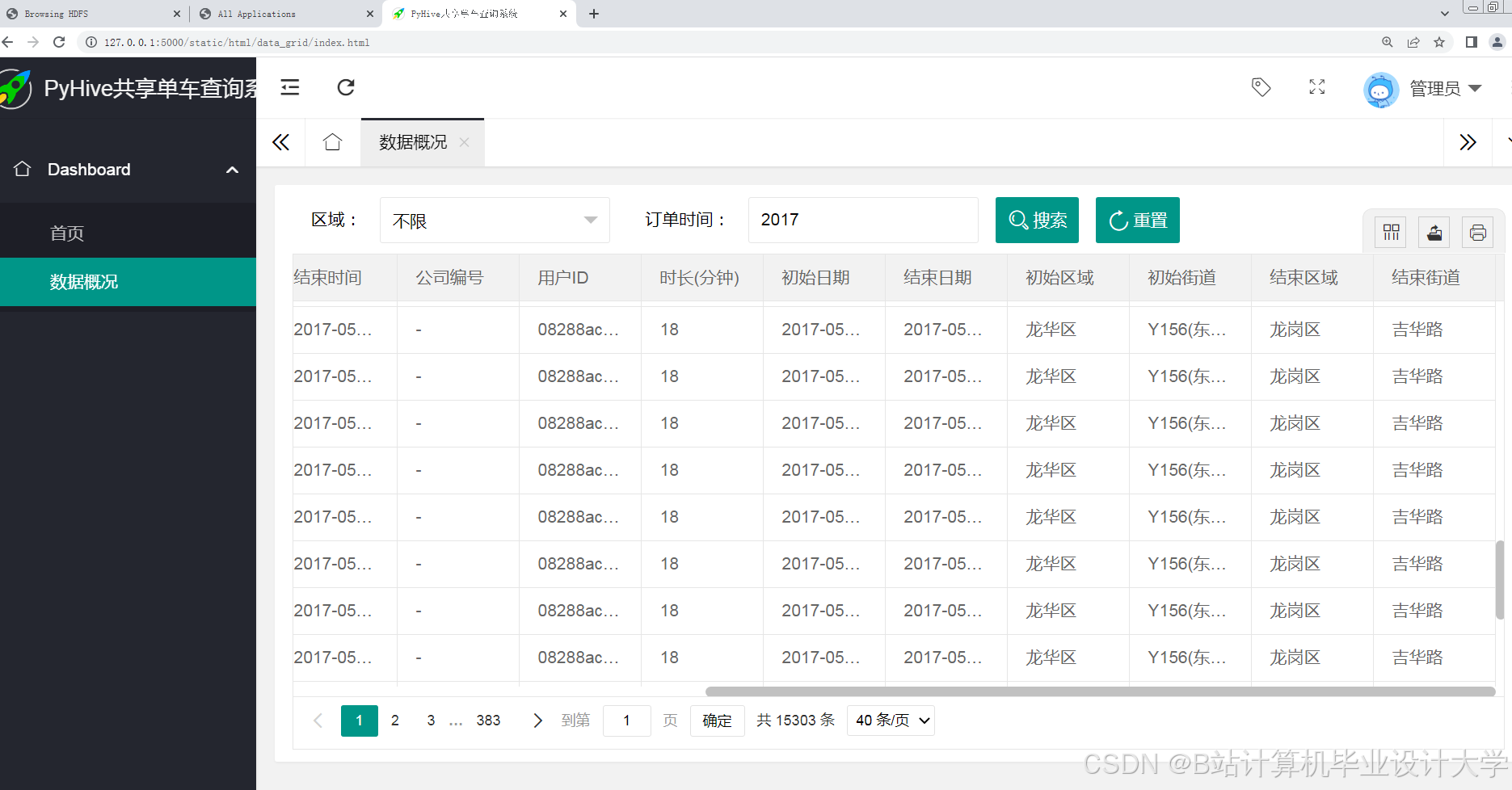

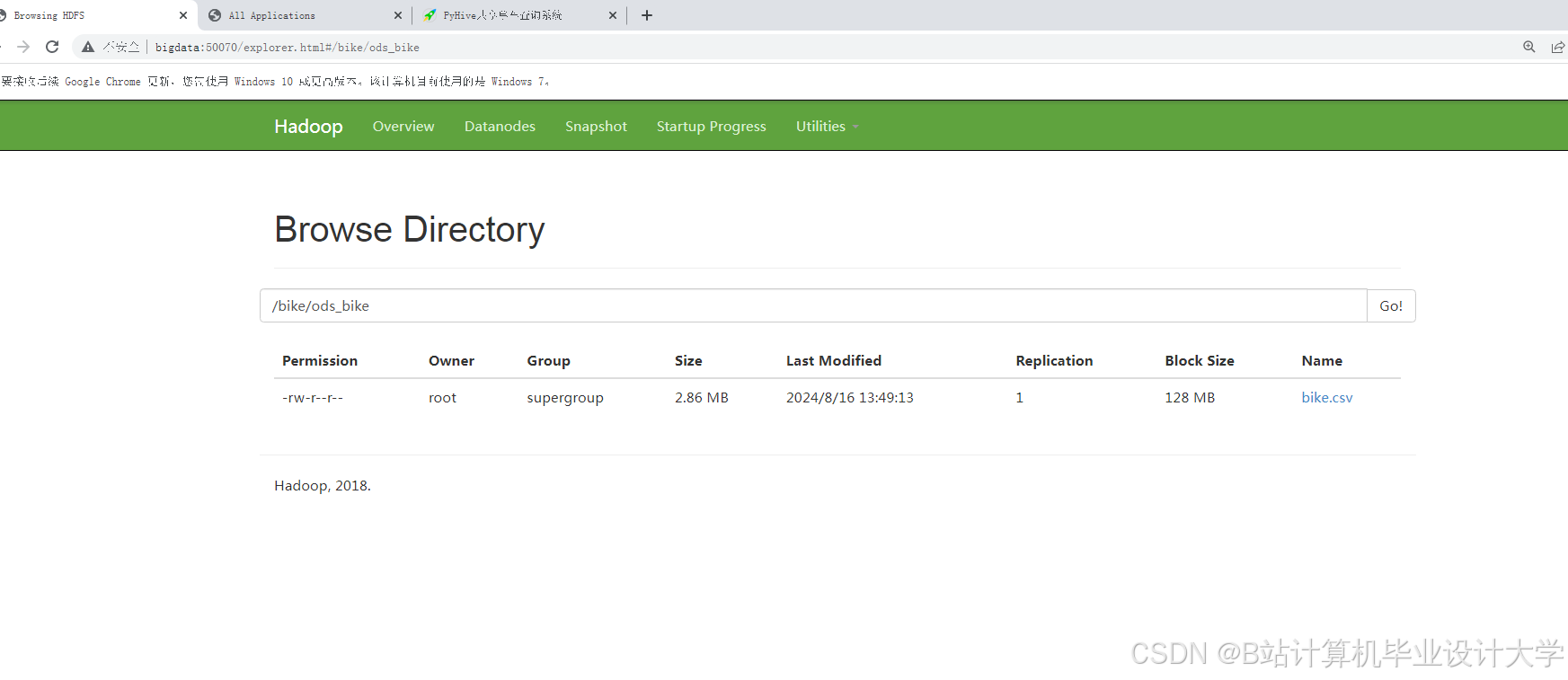

- 分层存储至Hive:

- ODS层:原始数据(保留90天历史订单和车辆状态)。

- DWD层:清洗后数据,按主题分区(订单、车辆、外部数据)。

- DWS层:聚合指标(如“区域A_每小时订单量”“车辆B_日骑行次数”)。

- ADS层:模型输入特征表(如“区域A_过去7天每小时订单量_天气类型_POI密度”)。

- 数据源接入:

- 技术工具

- 数据采集:Flume(日志文件)、Kafka(实时车辆状态流)、Sqoop(批量导入Hive)。

- 存储格式:Hive表(ORC压缩)、HBase(实时车辆位置缓存)。

2. 时空需求预测模型开发(Spark MLlib)

- 任务内容

- 特征设计:

- 时间特征:小时、星期几、是否为节假日、是否为工作日早晚高峰(7:00-9:00, 17:00-19:00)。

- 空间特征:区域ID(基于网格划分,如500m×500m网格)、周边POI类型及数量(地铁站数量、写字楼密度)。

- 历史特征:过去7天/30天同小时订单量、同比变化率。

- 外部特征:天气类型(雨/雪减少骑行)、温度(适宜温度15-25℃促进骑行)。

- 模型构建:

- 基线模型:Prophet(时间序列分解,捕捉周期性)。

- 增强模型:

- XGBoost:融合时间+空间+外部特征,处理非线性关系。

- LSTM:捕捉时空序列长期依赖(如工作日早晚高峰的周期性)。

- 融合策略:

- 短时预测(1小时):XGBoost权重=0.7,LSTM权重=0.3。

- 长时预测(24小时):Prophet权重=0.5,XGBoost权重=0.5。

- Spark实现示例:

scalaimport org.apache.spark.ml.feature.{VectorAssembler, StringIndexer}import org.apache.spark.ml.regression.{RandomForestRegressor, GBTRegressor}import org.apache.spark.ml.Pipeline// 1. 特征组装val assembler = new VectorAssembler().setInputCols(Array("hour", "region_id", "temperature", "is_weekend", "subway_count")).setOutputCol("features")// 2. 定义梯度提升树模型val gbt = new GBTRegressor().setLabelCol("order_count").setFeaturesCol("features").setMaxIter(100)// 3. 构建Pipelineval pipeline = new Pipeline().setStages(Array(assembler, gbt))// 4. 训练模型val model = pipeline.fit(trainingData)val predictions = model.transform(testData)

- 模型评估:

- 指标:MAPE(平均绝对百分比误差)、RMSE(均方根误差)。

- 对比基线:历史平均法、单一Prophet模型。

- 特征设计:

- 输出成果

- 特征工程代码库(Spark SQL/Pandas UDF)。

- 预测模型权重文件(Spark MLlib格式)、模型评估报告。

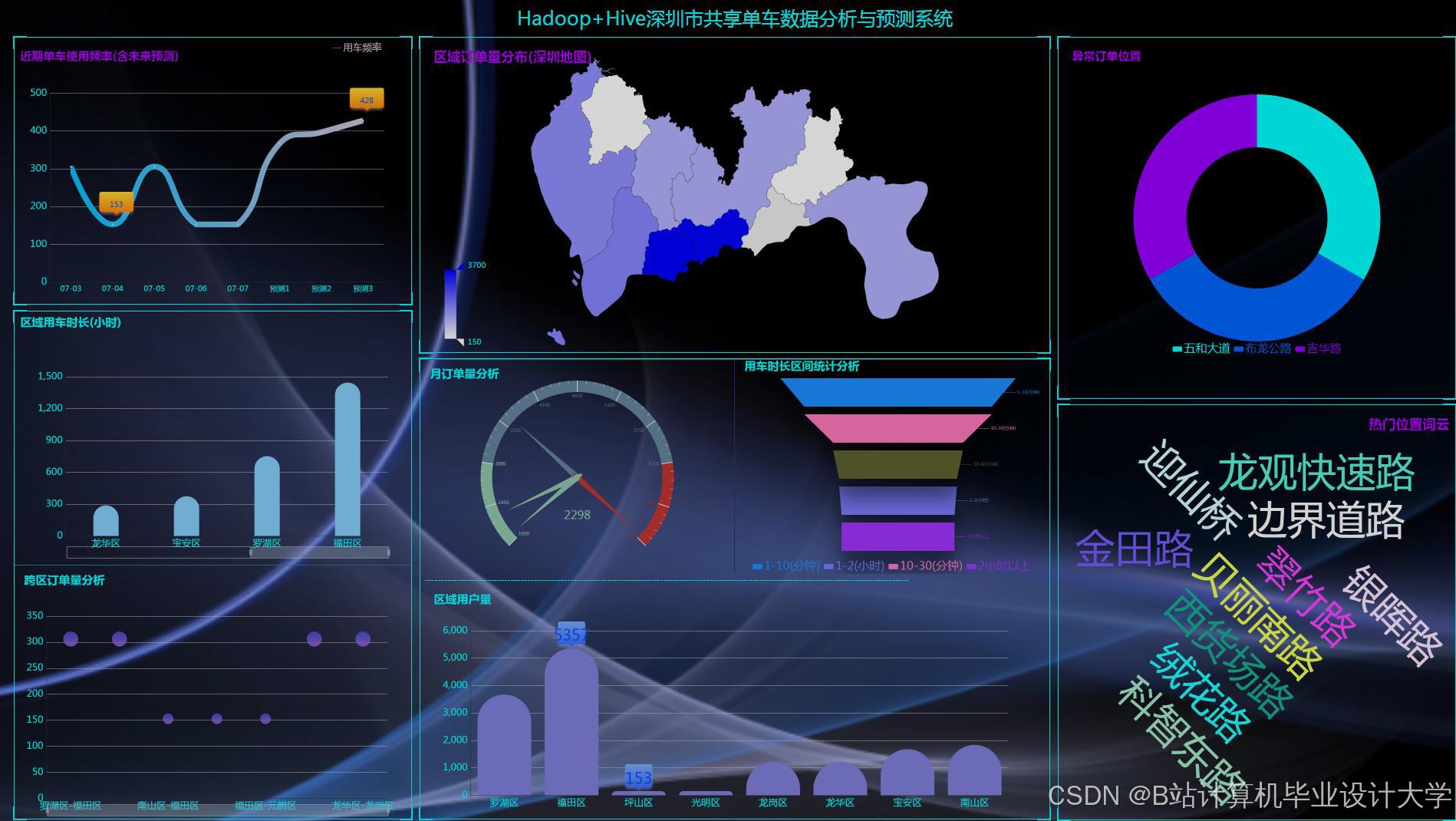

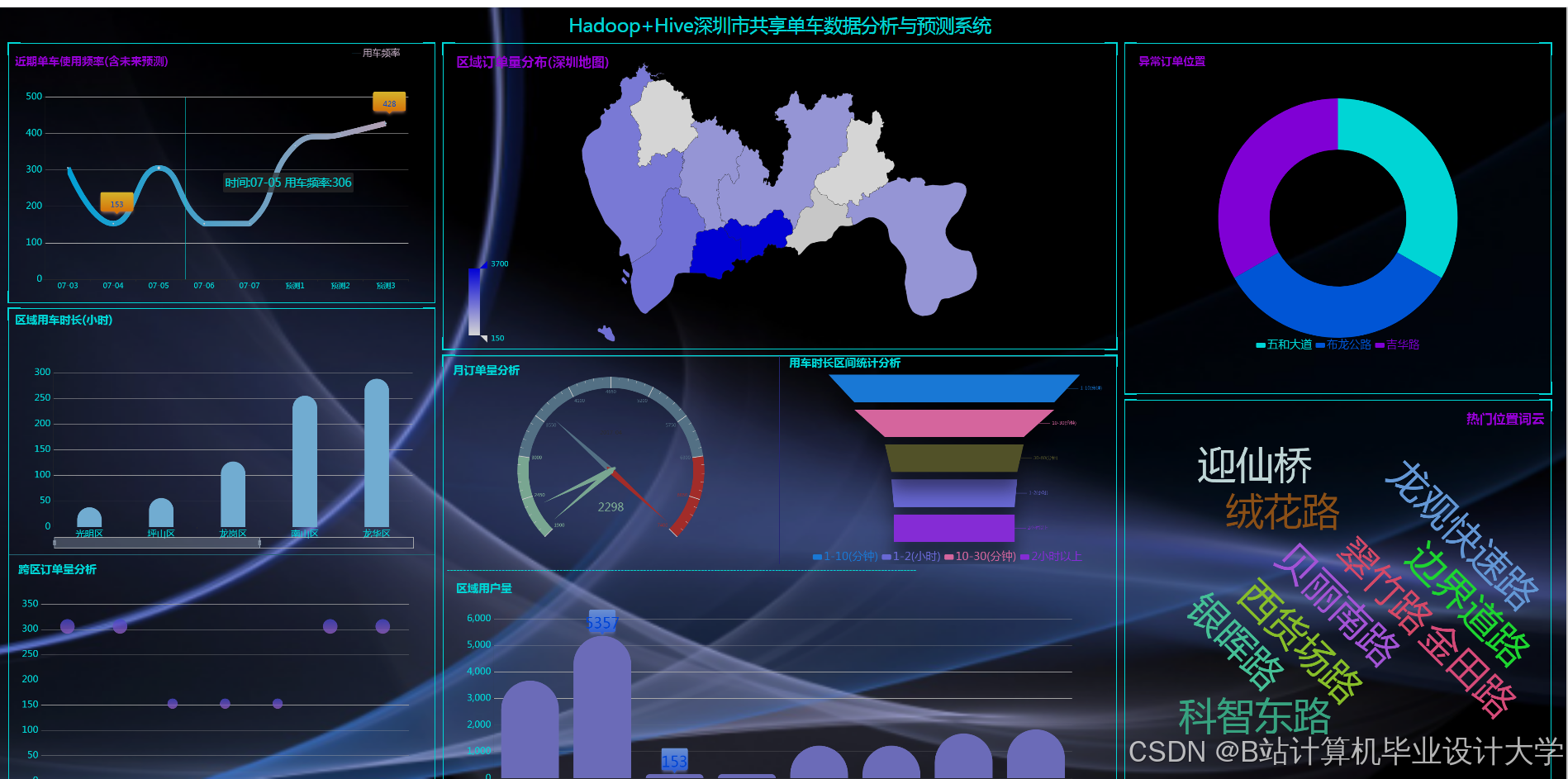

3. 共享单车数据可视化分析

- 任务内容

- 分析维度设计:

- 供需分析:

- 区域订单热力图(高德地图API叠加订单密度)。

- 车辆周转率(日骑行次数/车辆总数,识别低效车辆)。

- 用户行为分析:

- 骑行时长分布(短途(<15分钟)vs 长途(≥30分钟))。

- 用户活跃时段(工作日/周末差异)。

- 运营效率分析:

- 调度成本(单次调度车辆数×距离)。

- 故障车辆占比(通过锁状态异常识别)。

- 供需分析:

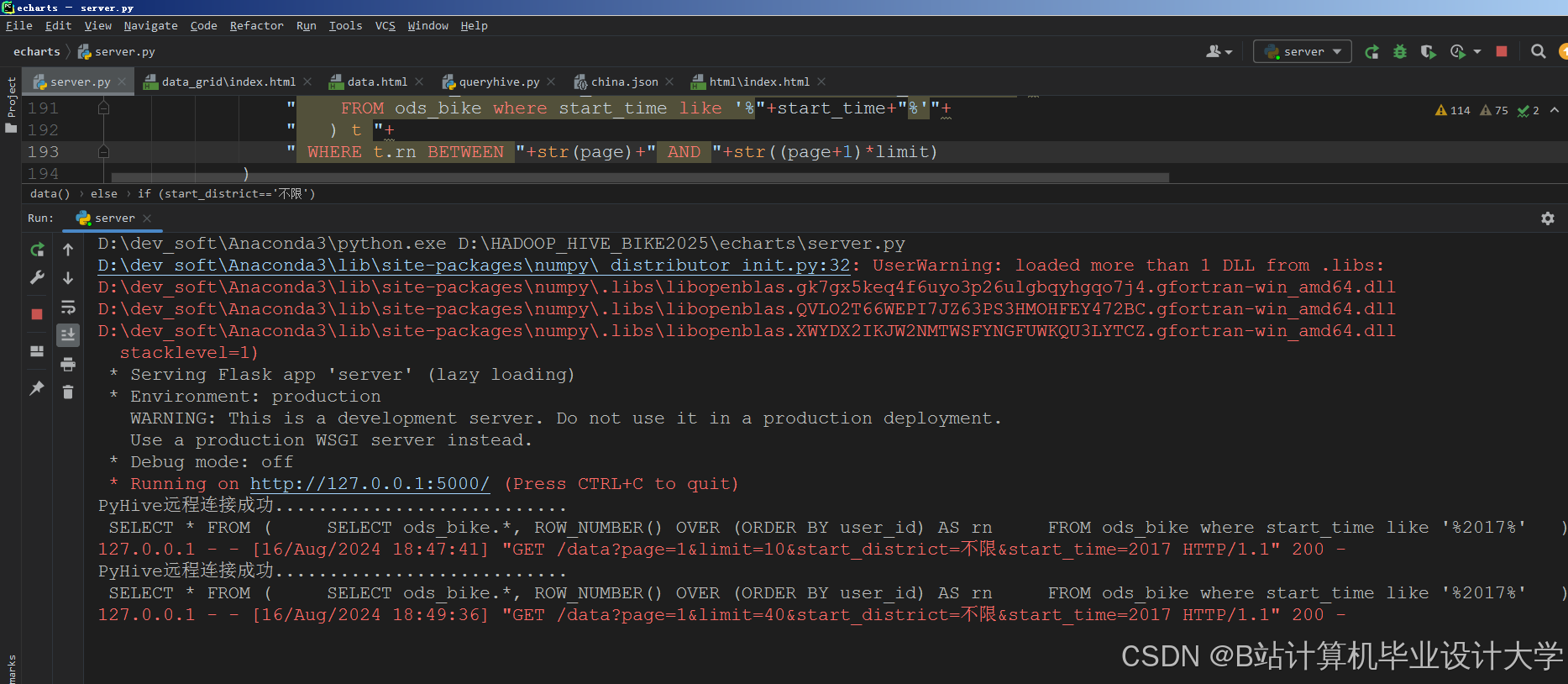

- 可视化工具实现:

- Grafana:实时看板(订单量趋势、异常预警列表)。

- ECharts:交互式热力图(支持缩放至具体网格区域)。

- Python Matplotlib:离线分析报告(用户骑行模式聚类)。

- 关键图表示例:

python# 示例:使用ECharts绘制区域订单热力图option = {tooltip: {},visualMap: { min: 0, max: 100, text: ['Low', 'High'] },series: [{type: 'heatmap',data: [[x1, y1, value1], [x2, y2, value2], ...], # (经度, 纬度, 订单量)coordinateSystem: 'geo',pointSize: 10,blurSize: 5}]}

- 分析维度设计:

- 输出成果

- 可视化看板链接(Grafana Dashboard)、离线分析报告(PDF/HTML)。

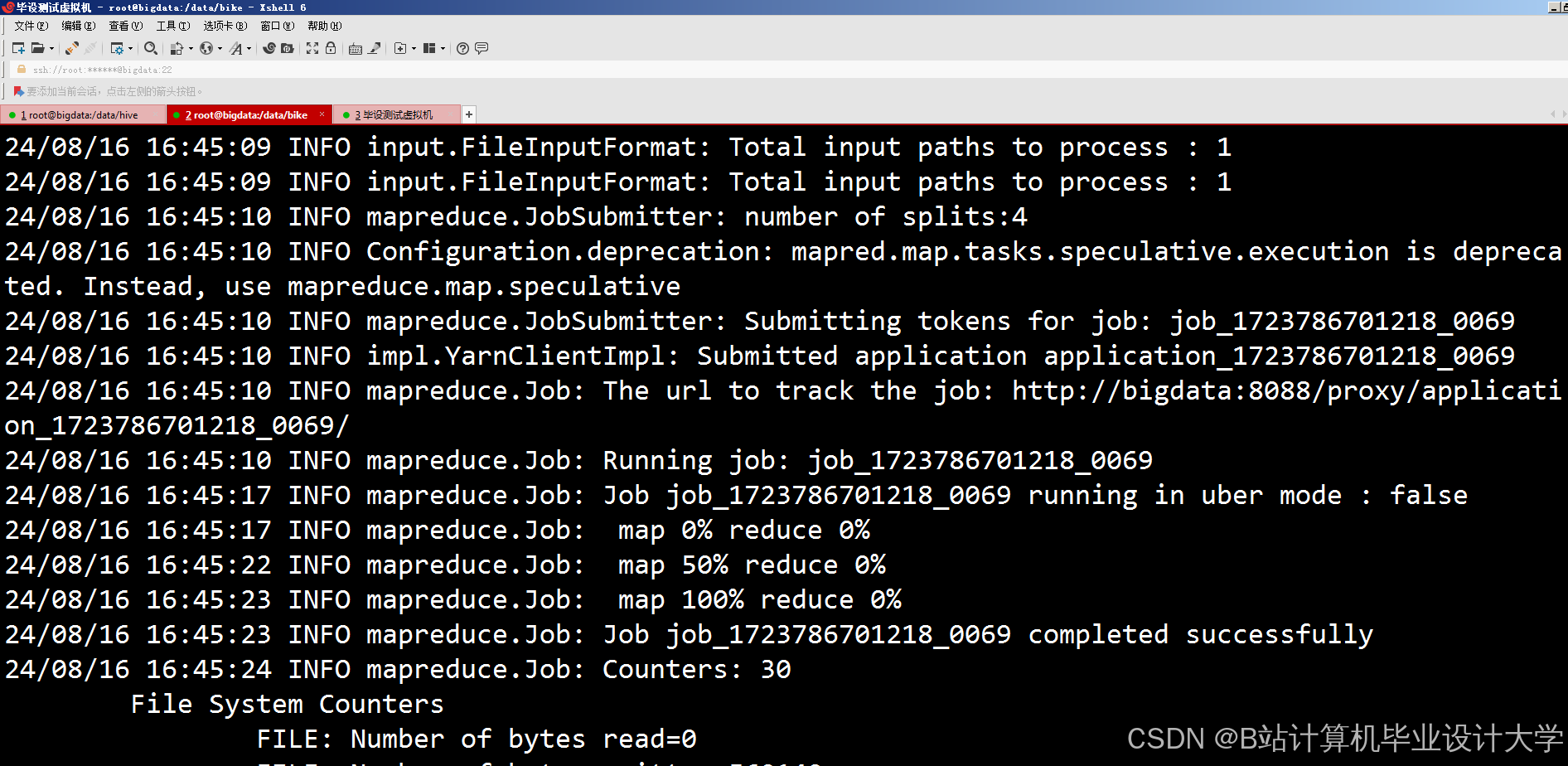

4. 系统集成与性能优化

- 任务内容

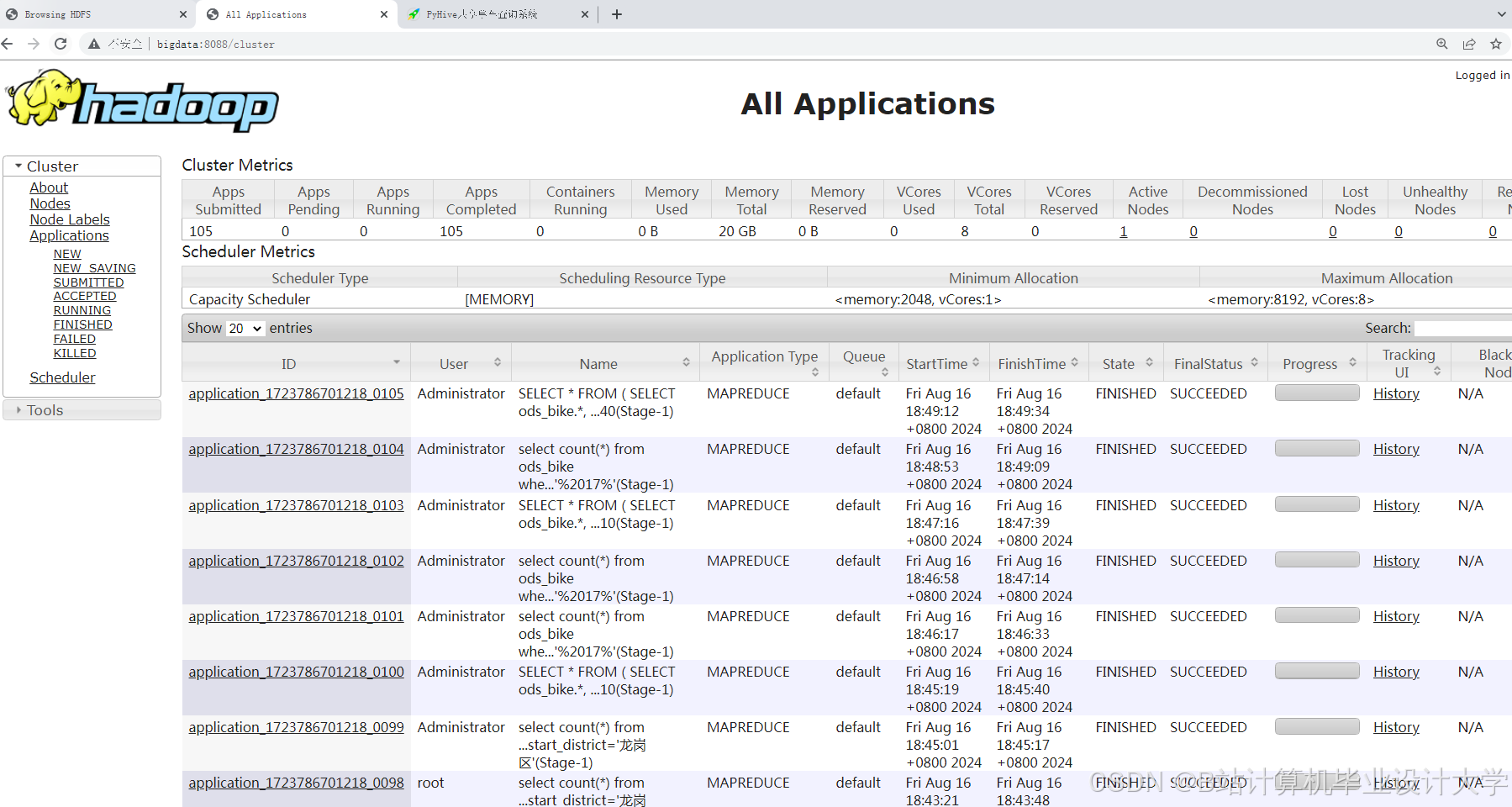

- 部署Hadoop集群(3节点)、Spark Standalone集群(2主1从)、Hive Metastore。

- 优化Spark作业性能:

- 调整

spark.executor.memory(4-8GB)、spark.sql.shuffle.partitions(100-200)。 - 对高频查询特征(如区域ID)使用Bloom Filter加速JOIN。

- 调整

- 监控系统:

- Prometheus+Grafana监控Spark任务延迟、Hive查询响应时间。

- 设置预警阈值(如单次预测耗时>3秒触发告警)。

- 输出成果

- 集群部署文档、性能优化报告(含资源占用率对比)。

三、技术栈与开发环境

| 模块 | 技术选型 |

|---|---|

| 大数据框架 | Hadoop 3.3.4, Spark 3.3.2 (Scala 2.12), Hive 3.1.3 |

| 机器学习 | Spark MLlib 3.3.2, XGBoost4J-Spark |

| 数据流处理 | Kafka 3.4.0, Spark Structured Streaming |

| 可视化 | Grafana 9.0, ECharts 5.4, Python Matplotlib |

| 开发环境 | Linux (Ubuntu 22.04), IntelliJ IDEA, JupyterLab |

四、项目里程碑计划

| 阶段 | 时间 | 交付物 |

|---|---|---|

| 数据调研与ETL开发 | 第1-2周 | Hive表结构、数据清洗脚本 |

| 特征工程与模型训练 | 第3-4周 | 特征重要性分析报告、模型权重文件 |

| 可视化看板开发 | 第5周 | Grafana Dashboard原型、ECharts热力图 |

| 系统集成与调优 | 第6周 | 集群部署脚本、性能监控看板 |

| 项目验收 | 第7周 | 用户操作手册、模型迭代计划 |

五、预期成果

- 模型性能:

- 区域订单量预测MAPE≤12%,异常需求预警召回率≥90%。

- 可视化效果:

- 支持实时刷新(每5分钟更新一次热力图),响应时间<2秒。

- 业务价值:

- 降低车辆闲置率15%,减少调度人工成本20%。

六、风险评估与应对

| 风险类型 | 应对措施 |

|---|---|

| 数据延迟 | 设置Kafka消息缓存(TTL=30分钟),重试机制 |

| 模型过拟合 | 采用交叉验证(K=5)、早停法(LSTM训练) |

| 冷启动问题 | 对新区域采用基于相似区域的迁移学习 |

| 集群资源不足 | 动态扩容Spark Worker节点,使用YARN资源调度 |

项目负责人:__________

日期:__________

此任务书可根据实际数据规模调整集群规模(如增加Spark Worker节点),并建议优先在单个城市(如北京)验证模型效果,再扩展至全国范围。可视化部分可结合业务需求增加“故障车辆分布”“用户投诉热点”等专题分析。

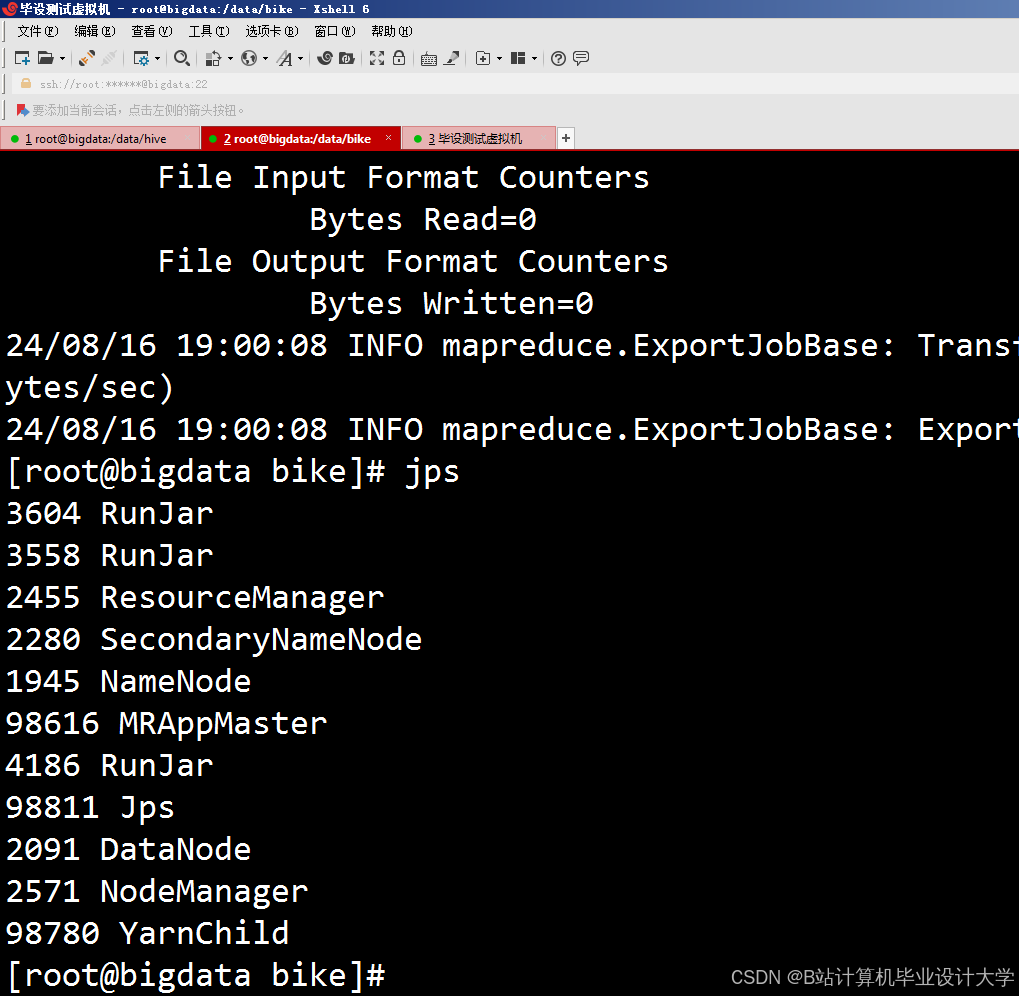

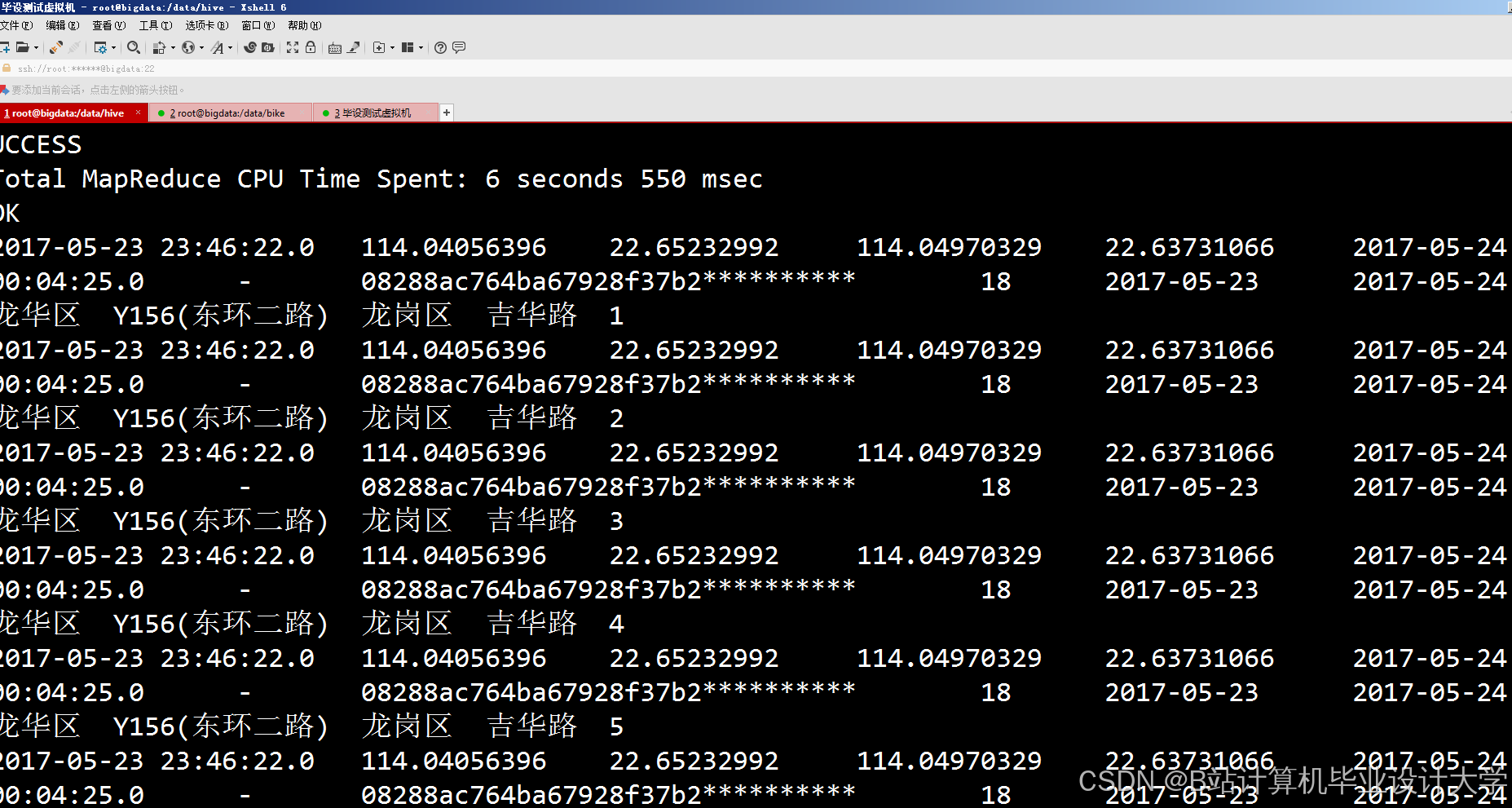

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?