温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:《Hadoop + Spark + Hive 薪资预测与招聘推荐系统》

一、任务背景

在数字化时代,招聘行业积累了海量的数据,如何从这些数据中挖掘有价值的信息,为求职者和企业提供更好的服务,成为当前面临的重要挑战。Hadoop、Spark 和 Hive 作为大数据处理的关键技术,具备强大的数据存储、处理和分析能力。利用这些技术构建薪资预测和招聘推荐系统,能够充分利用海量招聘数据,为求职者提供薪资参考,为企业推荐合适人才,具有重要的实践意义。

二、任务目标

- 数据高效处理:运用 Hadoop 的分布式存储和计算能力,高效存储和处理从各招聘渠道采集到的大量原始数据。

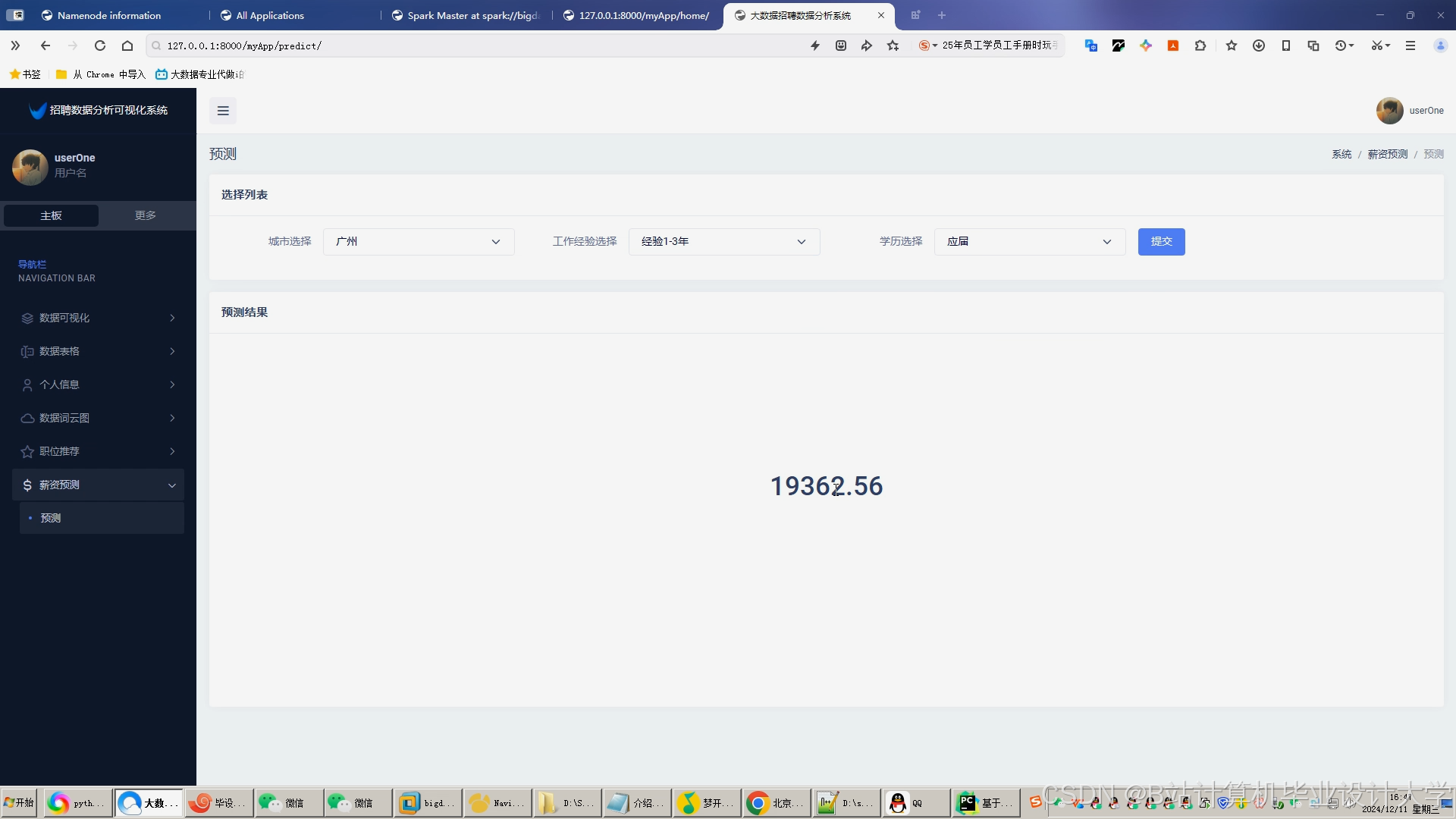

- 精准薪资预测:基于 Spark 的机器学习算法,结合 Hive 处理后的数据,构建准确的薪资预测模型,为求职者提供可靠的薪资预估。

- 精准招聘推荐:设计合理的推荐算法,利用 Spark 的快速计算能力,为企业和求职者提供精准的职位和人才推荐。

- 系统集成与优化:将各个模块集成到统一的系统中,并对系统进行性能优化,确保系统稳定、高效运行。

三、任务内容与分工

(一)数据采集与预处理小组

- 负责人:[姓名1]

- 成员:[成员1]、[成员2]

- 任务内容:

- 从主流招聘网站、企业招聘系统等多个数据源采集职位信息、求职者简历、薪资数据等。

- 利用 Hadoop 的 HDFS 存储采集到的原始数据,确保数据的安全存储和可扩展性。

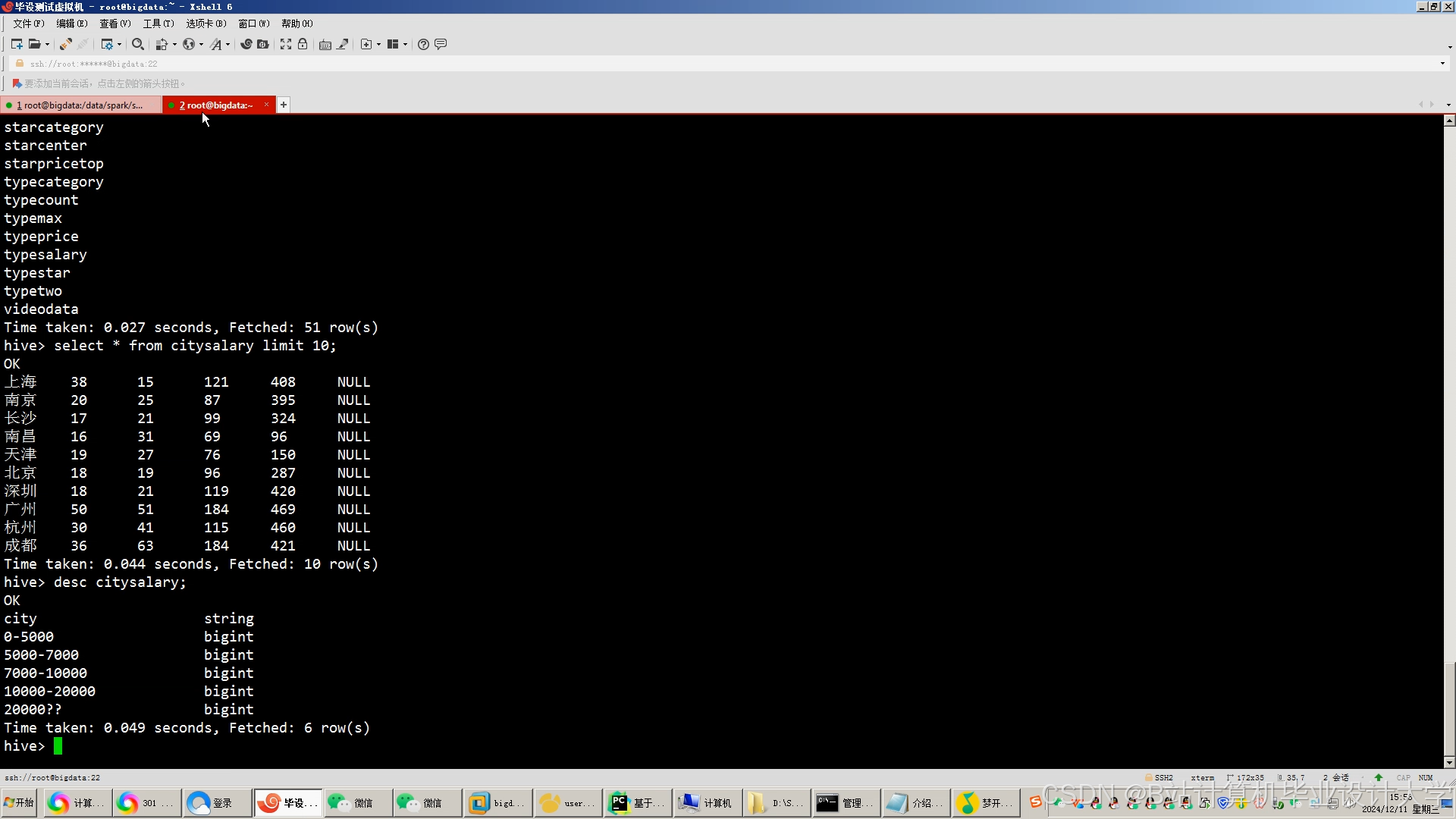

- 使用 Hive 对原始数据进行清洗、转换和加载操作,去除重复、错误数据,统一数据格式,为后续分析提供高质量的数据基础。

(二)薪资预测模型构建小组

- 负责人:[姓名2]

- 成员:[成员3]、[成员4]

- 任务内容:

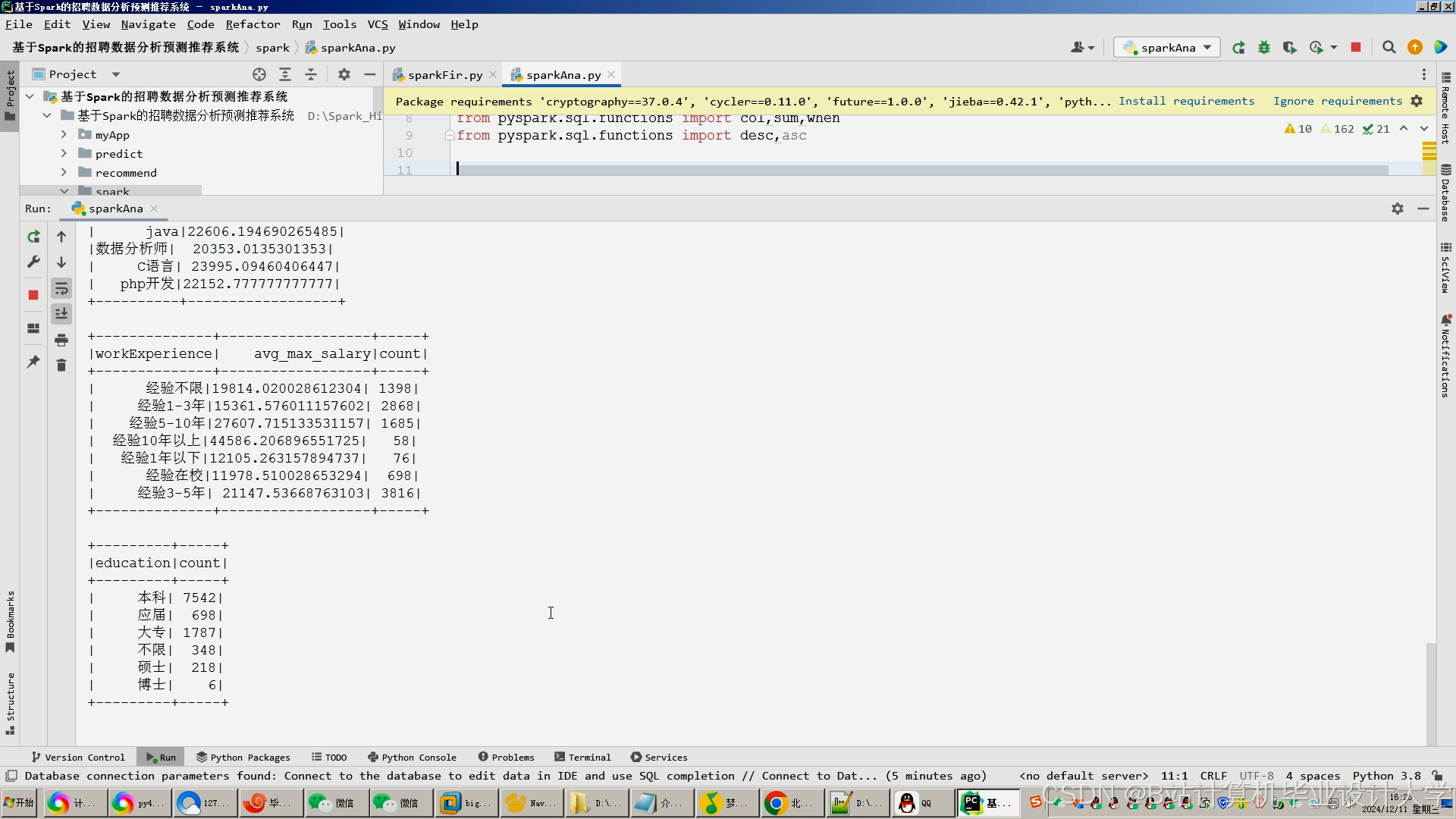

- 基于 Spark 的 MLlib 机器学习库,研究并选择适合薪资预测的算法,如线性回归、支持向量机等。

- 利用 Hive 处理后的数据作为输入,对选定的算法进行模型训练。

- 通过交叉验证、参数调整等方法对模型进行优化,提高薪资预测的准确性,并评估模型的性能指标,如均方误差、决定系数等。

(三)招聘推荐系统开发小组

- 负责人:[姓名3]

- 成员:[成员5]、[成员6]

- 任务内容:

- 分析求职者和企业的需求特点,设计个性化的推荐策略。例如,基于内容的推荐,根据求职者的技能、经验与职位要求的匹配度进行推荐;基于协同过滤的推荐,参考相似用户的行为进行推荐。

- 利用 Spark 的分布式计算能力,实现推荐算法,快速生成推荐结果。

- 开发推荐结果展示模块,以友好的界面形式向企业和求职者呈现推荐信息。

(四)系统集成与优化小组

- 负责人:[姓名4]

- 成员:[成员7]、[成员8]

- 任务内容:

- 将数据采集与预处理模块、薪资预测模型模块、招聘推荐系统模块进行集成,确保数据在各个模块之间能够流畅传输和处理。

- 对集成后的系统进行性能测试,分析系统在数据处理速度、资源利用率等方面的表现。

- 针对性能测试结果,对 Hadoop、Spark 和 Hive 的配置参数进行优化,如调整 Hadoop 的块大小、Spark 的执行内存等,提高系统的整体性能和响应速度。

四、技术路线

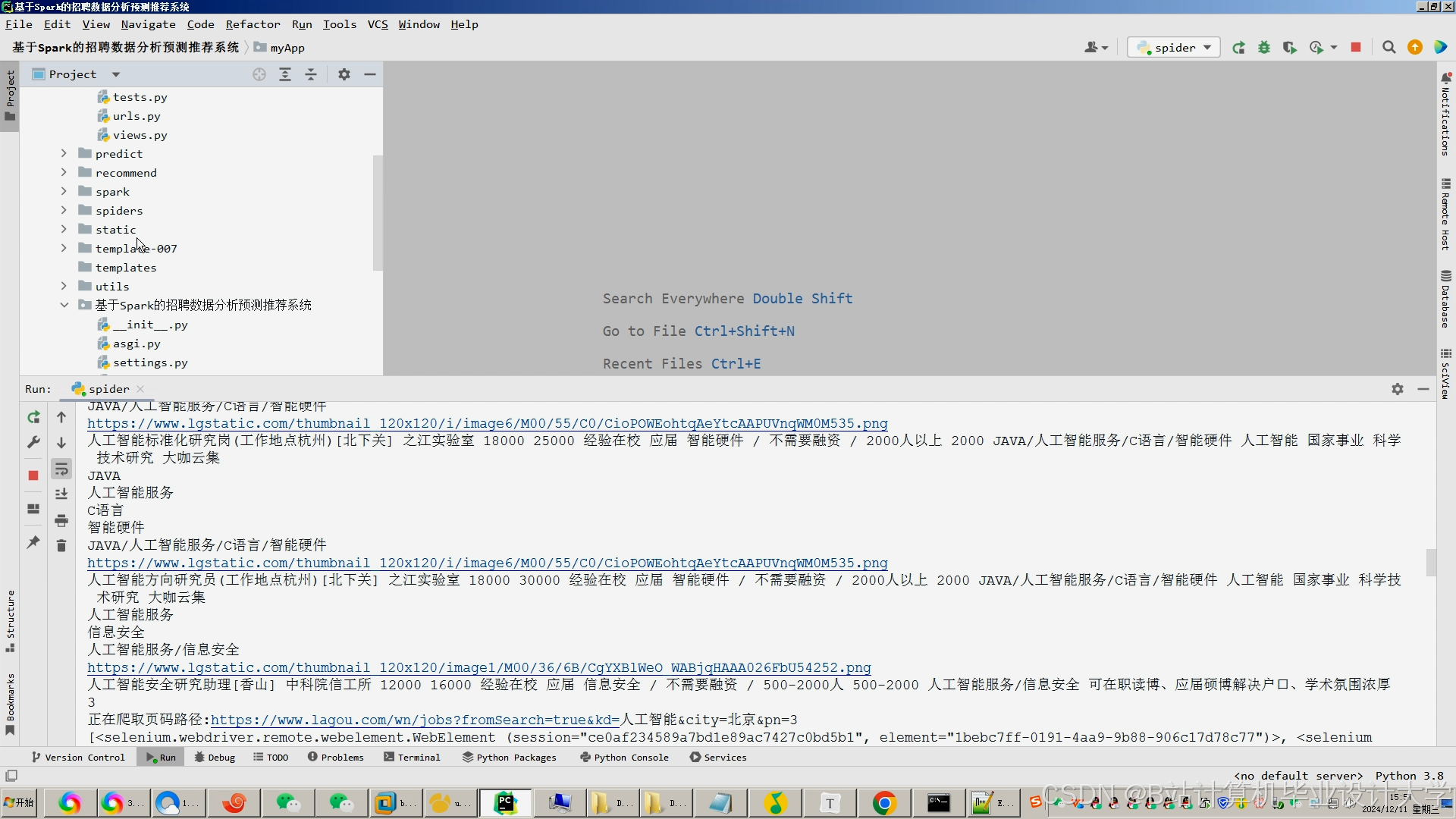

- 数据采集:使用网络爬虫技术从招聘网站和企业系统中采集数据,并将数据存储到 Hadoop 的 HDFS 中。

- 数据预处理:通过 Hive 对 HDFS 中的数据进行清洗、转换和加载,生成适合分析的格式。

- 薪资预测:利用 Spark 的 MLlib 加载预处理后的数据,训练和优化薪资预测模型。

- 招聘推荐:基于 Spark 实现推荐算法,根据用户需求生成个性化的推荐结果。

- 系统集成与优化:将各个模块集成到统一的系统中,通过调整参数和优化算法提高系统性能。

五、进度安排

| 阶段 | 时间范围 | 主要任务 |

|---|---|---|

| 需求分析与设计 | 第1 - 2周 | 与招聘行业专家和相关用户沟通,明确系统需求;完成系统的整体架构设计和模块设计。 |

| 数据采集与预处理 | 第3 - 4周 | 开发数据采集程序,从多个数据源采集数据;使用 Hadoop 和 Hive 对数据进行存储和预处理。 |

| 薪资预测模型构建 | 第5 - 7周 | 研究并选择薪资预测算法;利用 Spark 进行模型训练和优化;评估模型性能。 |

| 招聘推荐系统开发 | 第8 - 10周 | 设计推荐策略和算法;基于 Spark 实现推荐功能;开发推荐结果展示界面。 |

| 系统集成与优化 | 第11 - 12周 | 将各个模块集成到系统中;进行系统性能测试和优化。 |

| 系统测试与验收 | 第13 - 14周 | 对系统进行全面的功能测试和性能测试;根据测试结果进行修改和完善;组织专家和用户进行系统验收。 |

六、预期成果

- 功能完善的系统:完成一个集数据采集、预处理、薪资预测、招聘推荐功能于一体的系统,能够稳定运行并处理大规模的招聘数据。

- 准确的薪资预测模型:构建的薪资预测模型在测试数据上具有较高的准确性,能够为求职者提供有价值的薪资参考。

- 有效的招聘推荐结果:招聘推荐系统能够根据用户需求生成精准的推荐结果,提高企业和求职者的满意度。

- 技术文档与报告:编写详细的技术文档,包括系统设计文档、用户手册等;撰写项目总结报告,记录项目的过程和成果。

七、风险评估与应对

| 风险类型 | 风险描述 | 应对措施 |

|---|---|---|

| 数据质量风险 | 采集到的数据可能存在噪声、缺失值等问题,影响模型的准确性。 | 加强数据预处理环节,采用更完善的数据清洗和填充方法;与数据源提供方沟通,提高数据质量。 |

| 技术实现风险 | 在 Hadoop、Spark 和 Hive 的集成和使用过程中,可能会遇到技术难题,导致开发进度延迟。 | 提前进行技术储备,组织开发人员学习和培训;遇到问题时,及时查阅文档、寻求技术支持。 |

| 需求变更风险 | 在项目开发过程中,用户需求可能会发生变化,导致系统设计需要调整。 | 加强与用户的沟通,及时了解需求变化;采用敏捷开发方法,灵活调整开发计划。 |

任务下达人:[姓名]

任务承接人:[各小组负责人及成员]

日期:[具体日期]

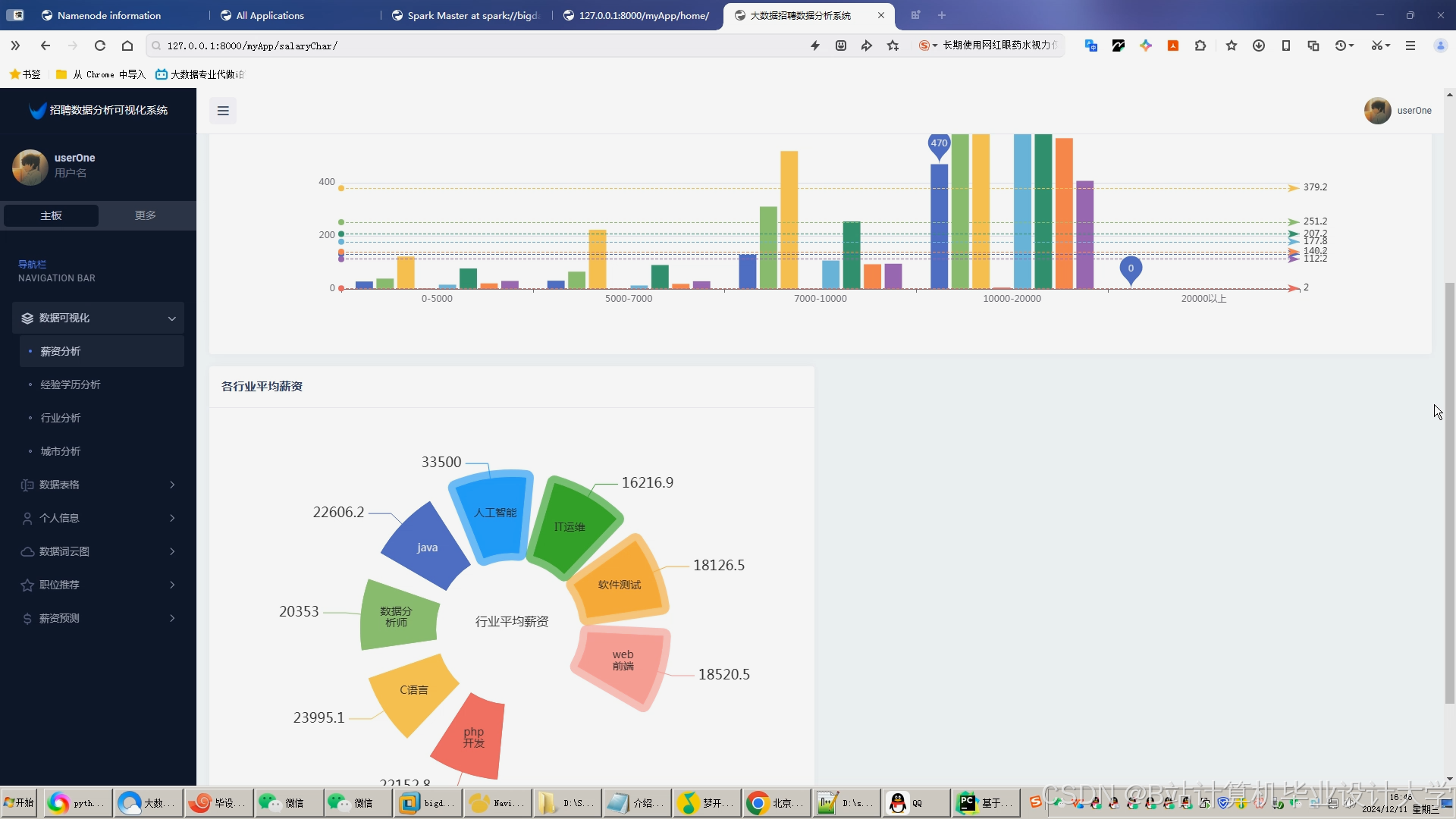

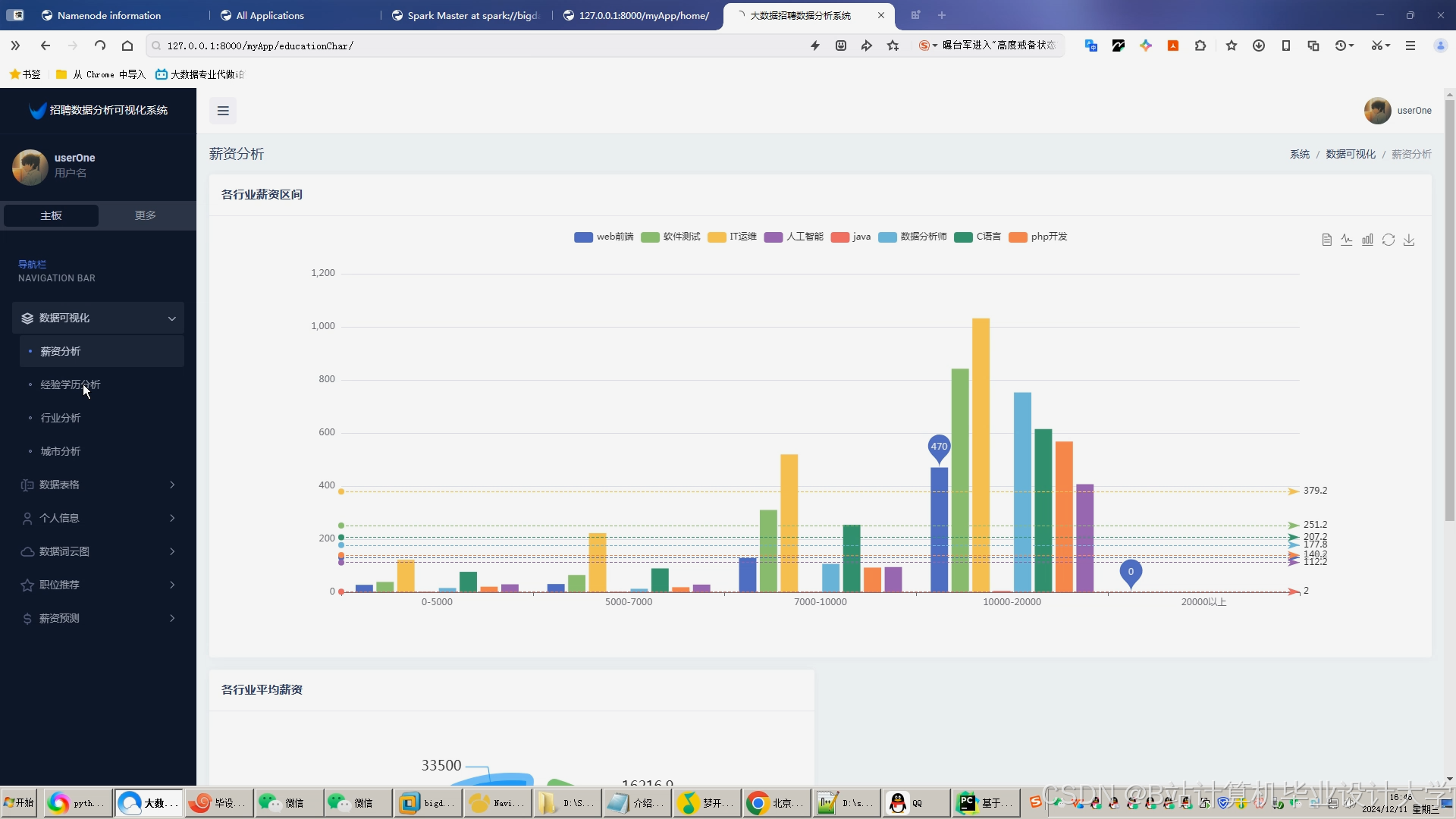

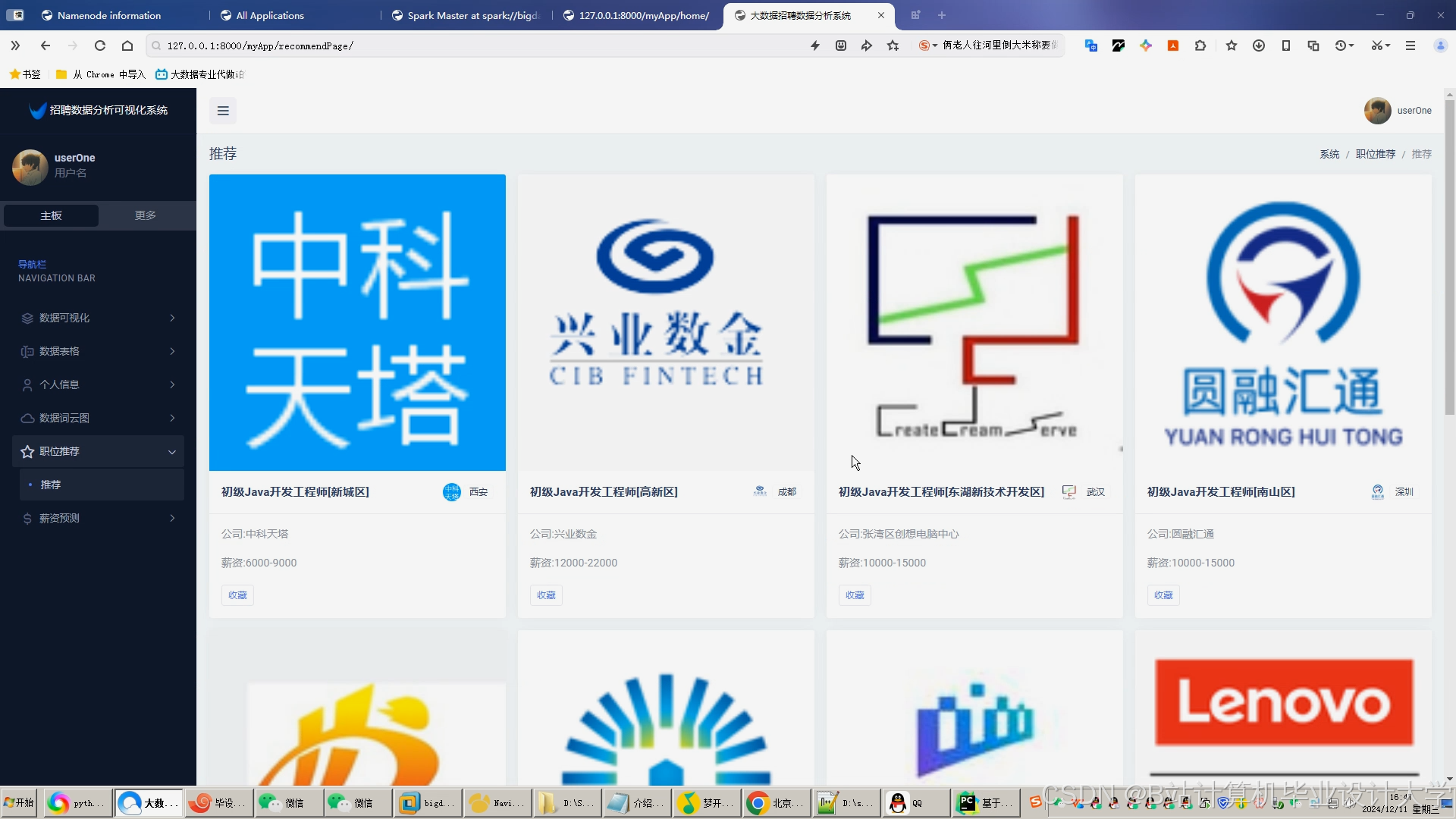

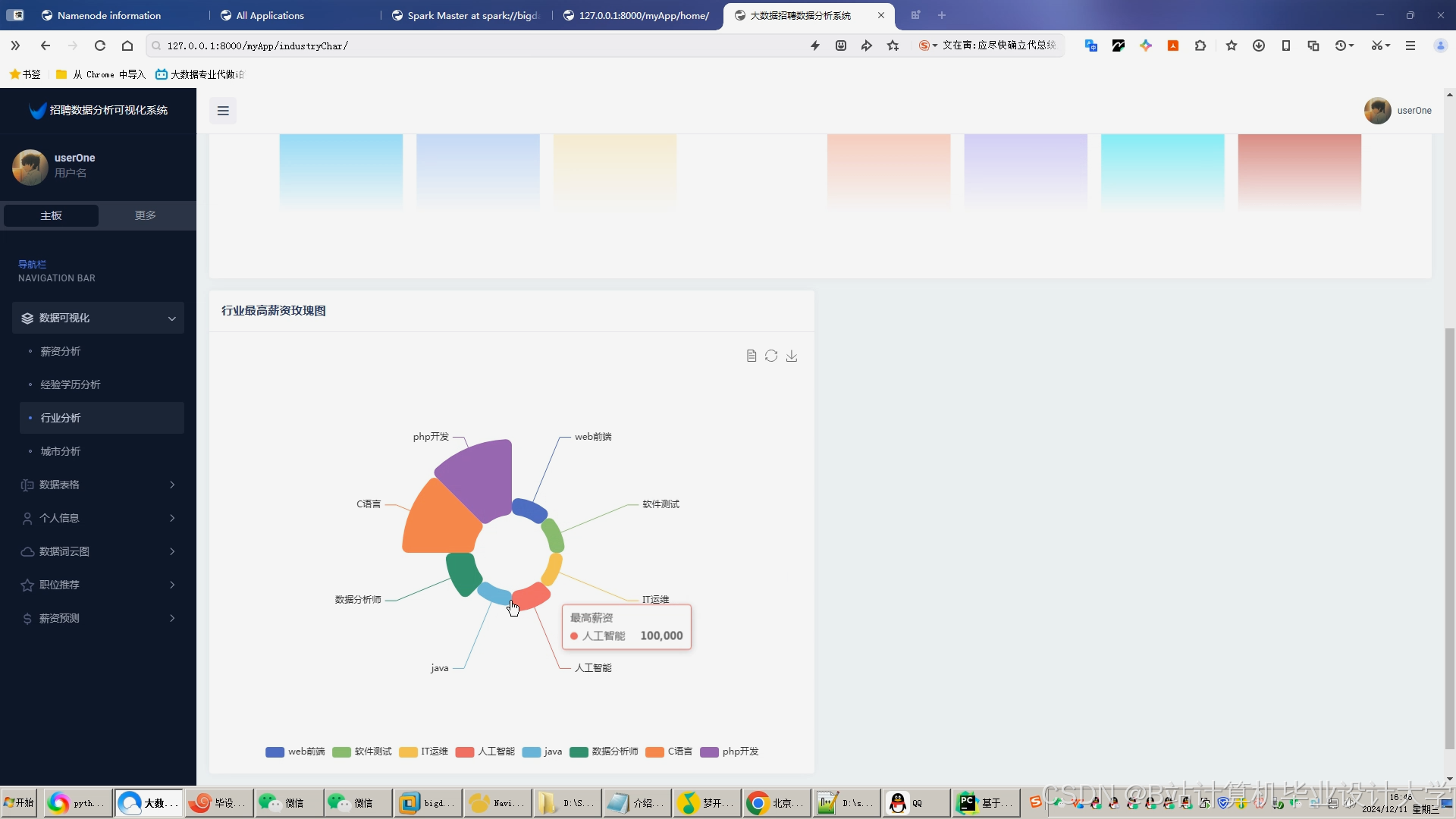

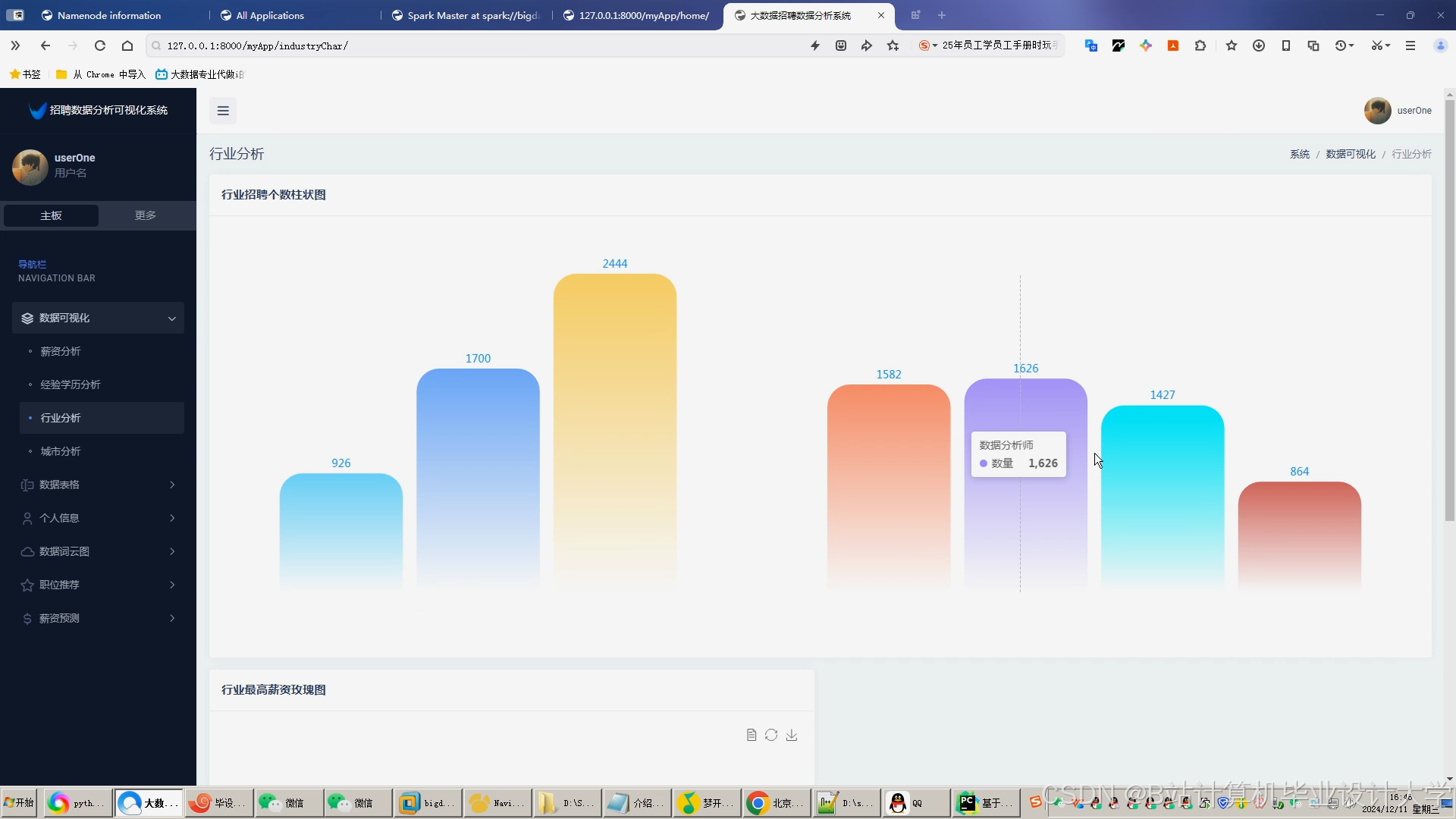

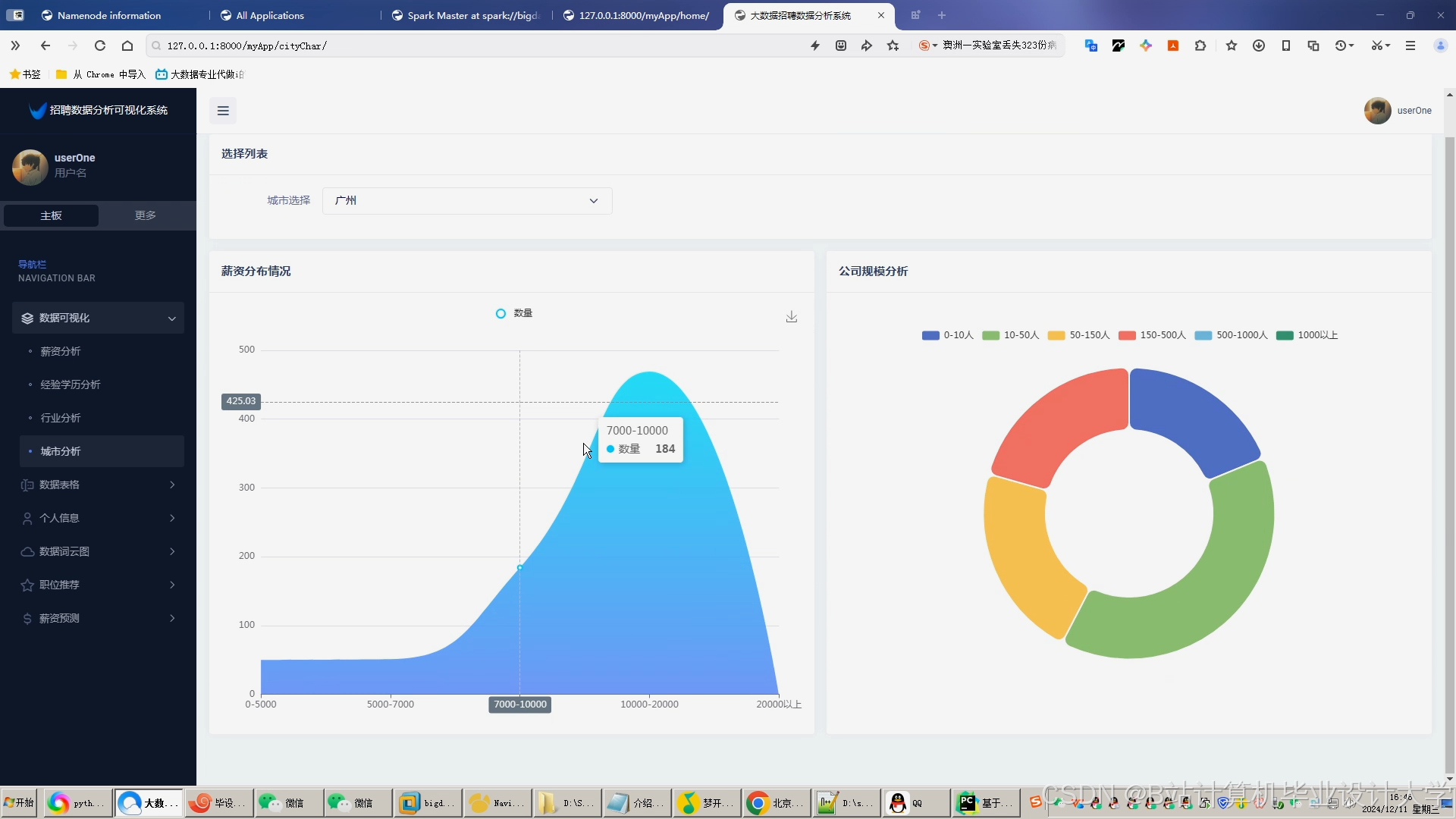

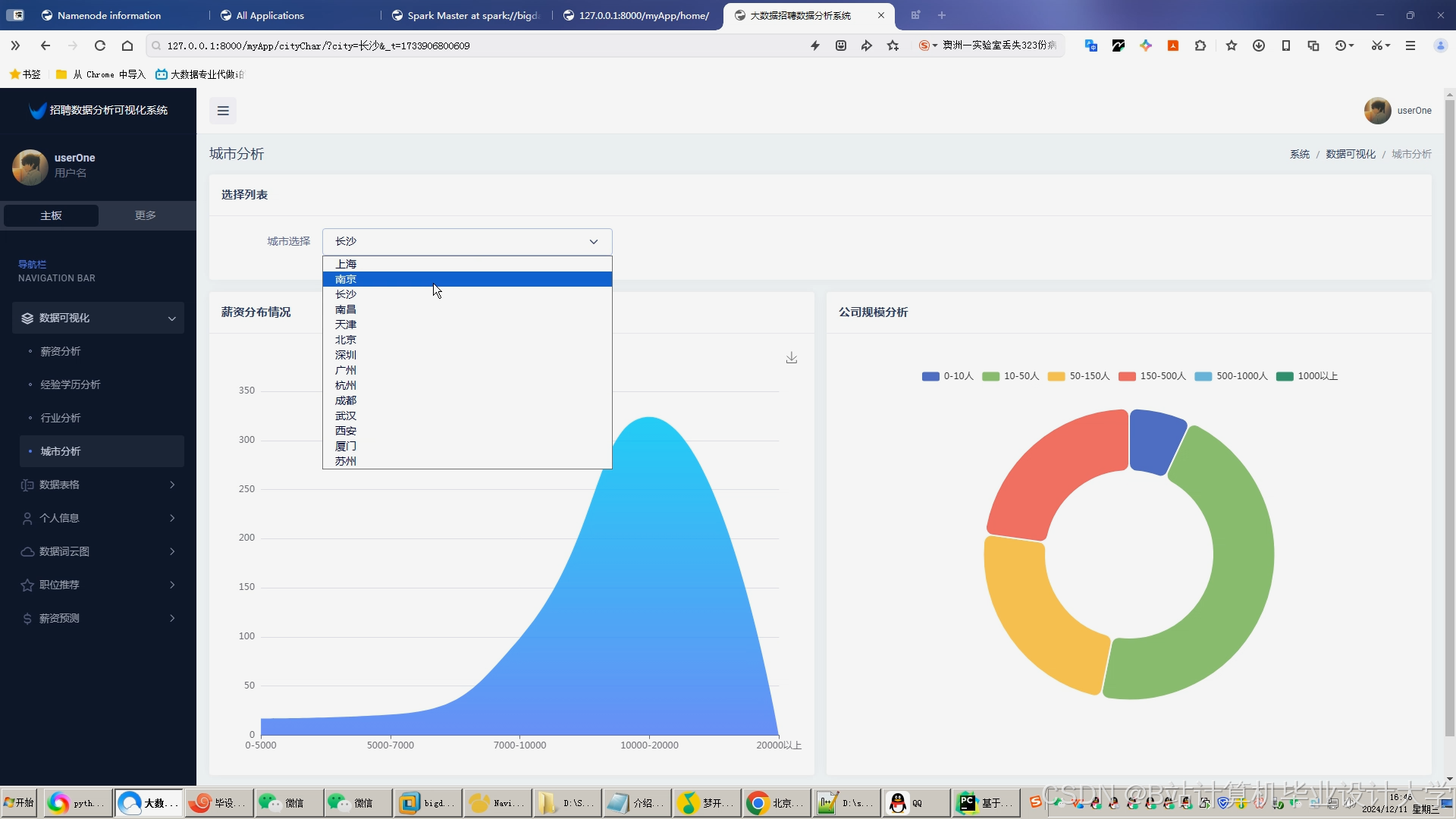

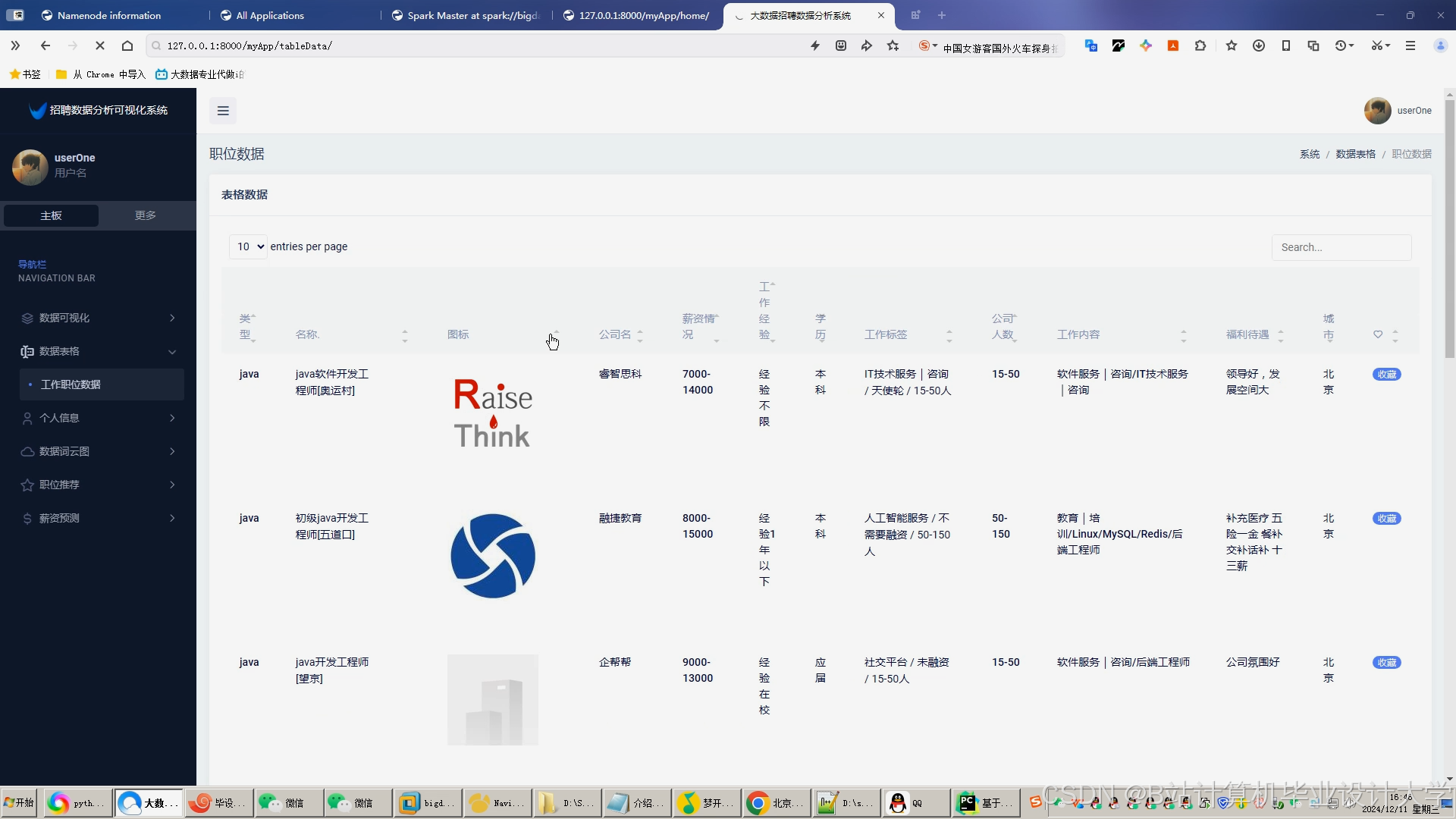

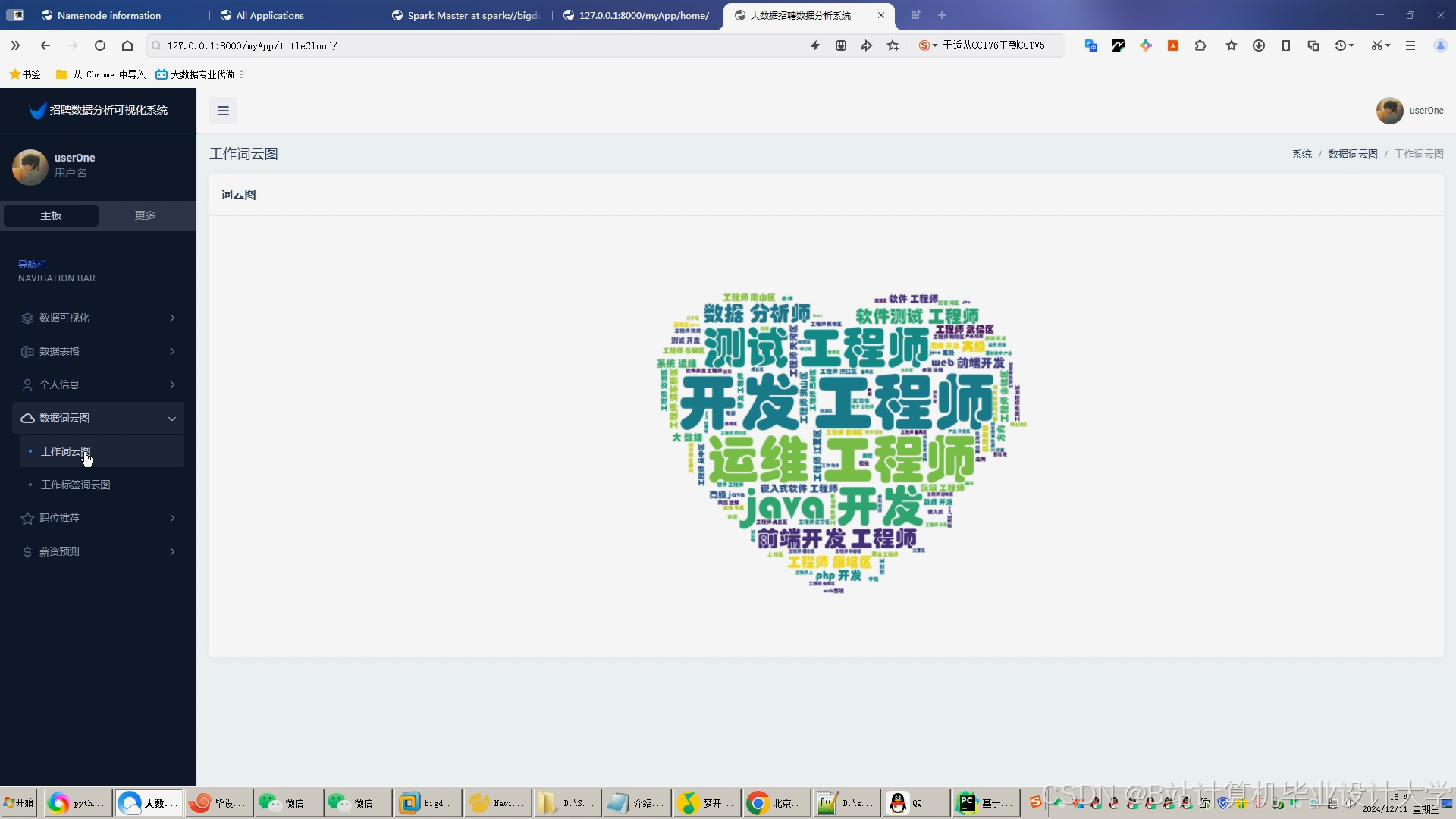

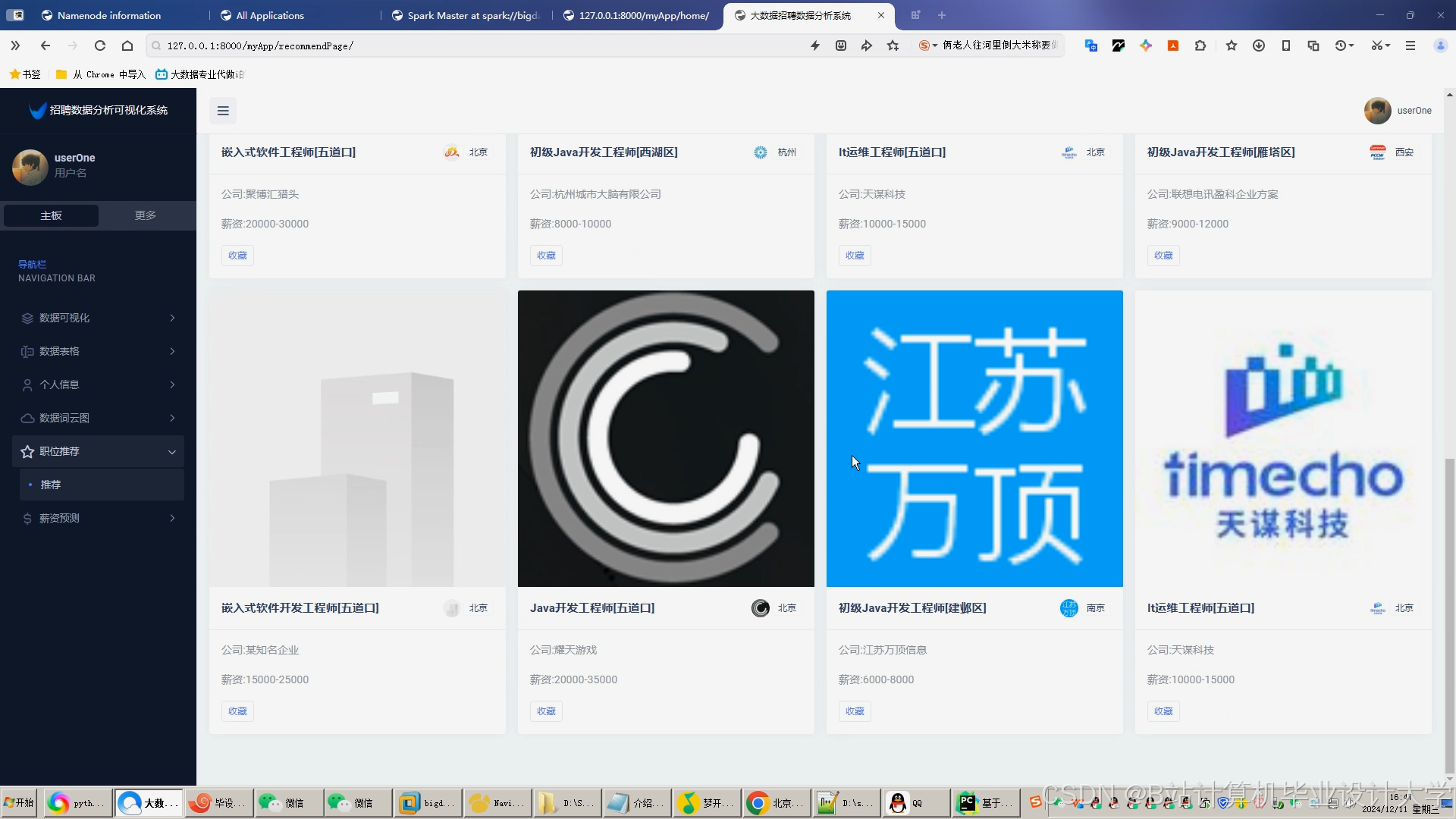

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1869

1869

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?