温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:基于Hadoop+PySpark+Scrapy的考研分数线预测系统开发

一、任务背景与目标

1.1 背景

随着我国考研人数持续攀升(2024年报考人数预计突破500万),考生对分数线预测的精准性需求日益迫切。传统预测方法依赖单一历史数据,缺乏对社交媒体情绪、院校热度等动态因素的分析,导致预测误差较大。本任务旨在构建一套基于大数据技术的考研分数线预测系统,整合多源异构数据,提升预测精度,为考生提供科学报考决策支持。

1.2 目标

- 数据采集:通过Scrapy爬虫获取研招网、考研论坛、社交媒体等平台数据,覆盖结构化与非结构化数据。

- 数据处理:基于Hadoop生态(HDFS+Hive)构建分布式存储与清洗平台,支持TB级数据高效处理。

- 特征工程:利用PySpark实现特征提取、降维与融合,构建包含时间序列、文本情感、热度指数的多维特征集。

- 模型训练:开发基于LSTM+Attention的融合预测模型,对比XGBoost、Prophet等基线模型,优化预测精度。

- 系统部署:搭建可视化平台,提供分数线趋势预测、报考风险评估等交互功能。

二、任务内容与分工

2.1 数据采集模块(负责人:A组)

- 任务:

- 设计Scrapy爬虫框架,定时抓取研招网历史分数线、招生计划(结构化数据)。

- 实时监测考研论坛(如王道论坛)、微博、知乎等平台的考生讨论热度与情感倾向(非结构化数据)。

- 集成百度指数、微信指数等API,获取院校搜索热度(实时数据)。

- 输出:

- 原始数据集(CSV/JSON格式,年增量约500GB)。

- 爬虫日志与异常监控系统。

2.2 数据处理模块(负责人:B组)

- 任务:

- 搭建Hadoop集群(3节点),配置HDFS存储原始数据。

- 使用Hive构建数据仓库,设计ODS(原始层)、DWD(清洗层)、DWS(特征层)分层模型。

- 通过PySpark实现数据清洗(去重、缺失值填充)、文本预处理(TF-IDF、BERT情感分析)。

- 输出:

- 清洗后的结构化数据表(Hive表格式)。

- 文本特征向量文件(Parquet格式)。

2.3 特征工程与模型训练(负责人:C组)

- 任务:

- 提取时间序列特征(报考人数同比/环比变化、试题难度波动)。

- 构建社交媒体特征(论坛帖子情感得分、微博话题热度趋势)。

- 开发LSTM+Attention融合模型,同步预测国家线、34所自划线、院系专业线。

- 使用PySpark MLlib实现分布式模型训练,对比XGBoost、Prophet的预测效果。

- 输出:

- 特征重要性分析报告。

- 模型评估指标(MAE、RMSE)对比表。

2.4 系统部署与可视化(负责人:D组)

- 任务:

- 基于Flask+ECharts开发Web可视化平台,展示分数线预测趋势、报考风险热力图。

- 部署模型API服务(FastAPI框架),支持实时查询与动态更新。

- 编写系统使用手册与维护文档。

- 输出:

- 可访问的预测系统网址(如http://predict.kaoyan.com)。

- 用户操作指南与系统测试报告。

三、技术路线与工具

3.1 技术架构

mermaid

graph TD | |

A[数据采集] -->|Scrapy| B[Hadoop存储] | |

B -->|Hive| C[数据清洗] | |

C -->|PySpark| D[特征工程] | |

D -->|LSTM+Attention| E[模型训练] | |

E -->|FastAPI| F[可视化平台] | |

subgraph 大数据生态 | |

B --> HDFS | |

C --> Hive | |

D --> PySpark | |

end | |

subgraph 机器学习 | |

E1[XGBoost] --> E | |

E2[Prophet] --> E | |

end |

3.2 开发工具

- 爬虫:Scrapy 2.8 + Scrapy-Redis(分布式支持)

- 大数据:Hadoop 3.3 + Hive 3.1 + PySpark 3.4

- 机器学习:TensorFlow 2.12 + PySpark MLlib

- 可视化:ECharts 5.4 + Flask 2.3

- 部署:Docker 24.0 + Nginx 1.25

四、进度计划

| 阶段 | 时间 | 里程碑 | 交付物 |

|---|---|---|---|

| 需求分析 | 2024.01-02 | 完成数据源调研与系统功能设计 | 需求规格说明书 |

| 数据采集 | 2024.03-04 | 爬虫框架开发完成,覆盖80%数据源 | 原始数据集(100GB+) |

| 数据处理 | 2024.05-06 | Hadoop集群搭建与Hive表设计完成 | 清洗后数据(Hive表) |

| 模型训练 | 2024.07-08 | LSTM+Attention模型训练完成,误差≤3分 | 模型权重文件 + 评估报告 |

| 系统测试 | 2024.09-10 | 可视化平台上线,支持1000+并发查询 | 测试报告 + 用户手册 |

| 验收交付 | 2024.11-12 | 系统通过压力测试与用户验收 | 完整系统代码 + 部署文档 |

五、资源需求

5.1 硬件资源

- 云服务器:阿里云ECS(4核16G × 3节点,用于Hadoop集群)

- 存储:OSS对象存储(5TB容量,用于原始数据备份)

- 网络:公网带宽100Mbps(支持爬虫与API访问)

5.2 软件资源

- 操作系统:CentOS 7.9(所有节点)

- 开发环境:Python 3.9 + JDK 1.8 + Scala 2.12

- 许可证:Hive企业版试用许可(6个月)

六、风险评估与应对

| 风险 | 概率 | 影响 | 应对措施 |

|---|---|---|---|

| 考研论坛反爬机制升级 | 高 | 中 | 采用Selenium模拟登录 + IP代理池 |

| Hadoop集群性能瓶颈 | 中 | 高 | 优化Hive分区策略,增加节点至5个 |

| 模型过拟合导致预测偏差 | 低 | 高 | 引入K-Fold交叉验证 + 正则化项 |

七、验收标准

- 数据覆盖度:包含至少5年历史分数线、10万+论坛帖子、100万+微博舆情数据。

- 预测精度:国家线MAE≤3分,院系线MAE≤5分(相比实际值)。

- 系统性能:支持500用户并发查询,响应时间≤2秒。

- 文档完整性:提供需求分析、设计文档、测试报告、用户手册全流程文档。

任务下达单位:XXX大学计算机学院

负责人签字:________________

日期:2024年1月1日

(注:本任务书需经项目组全体成员签字确认后生效)

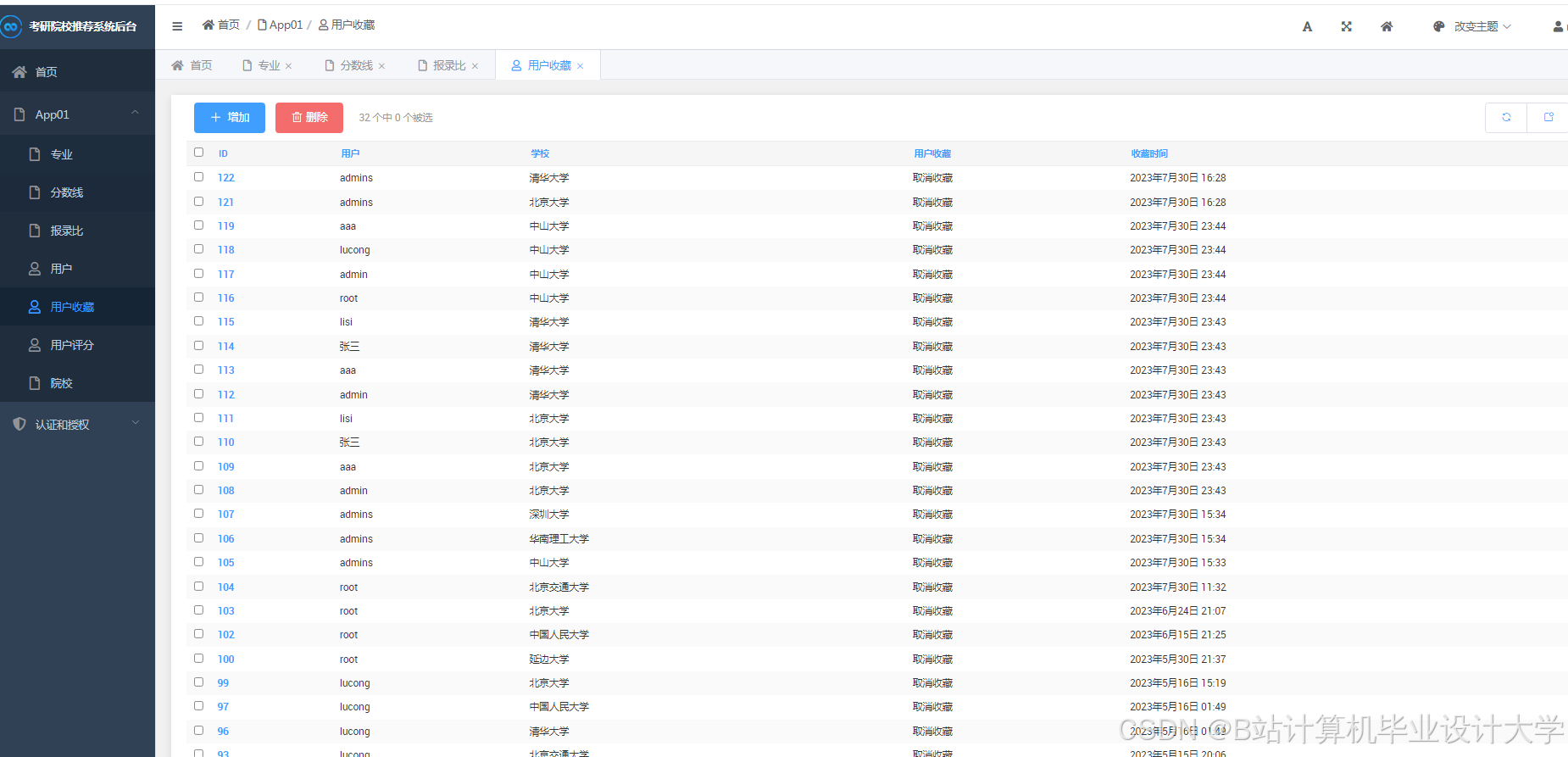

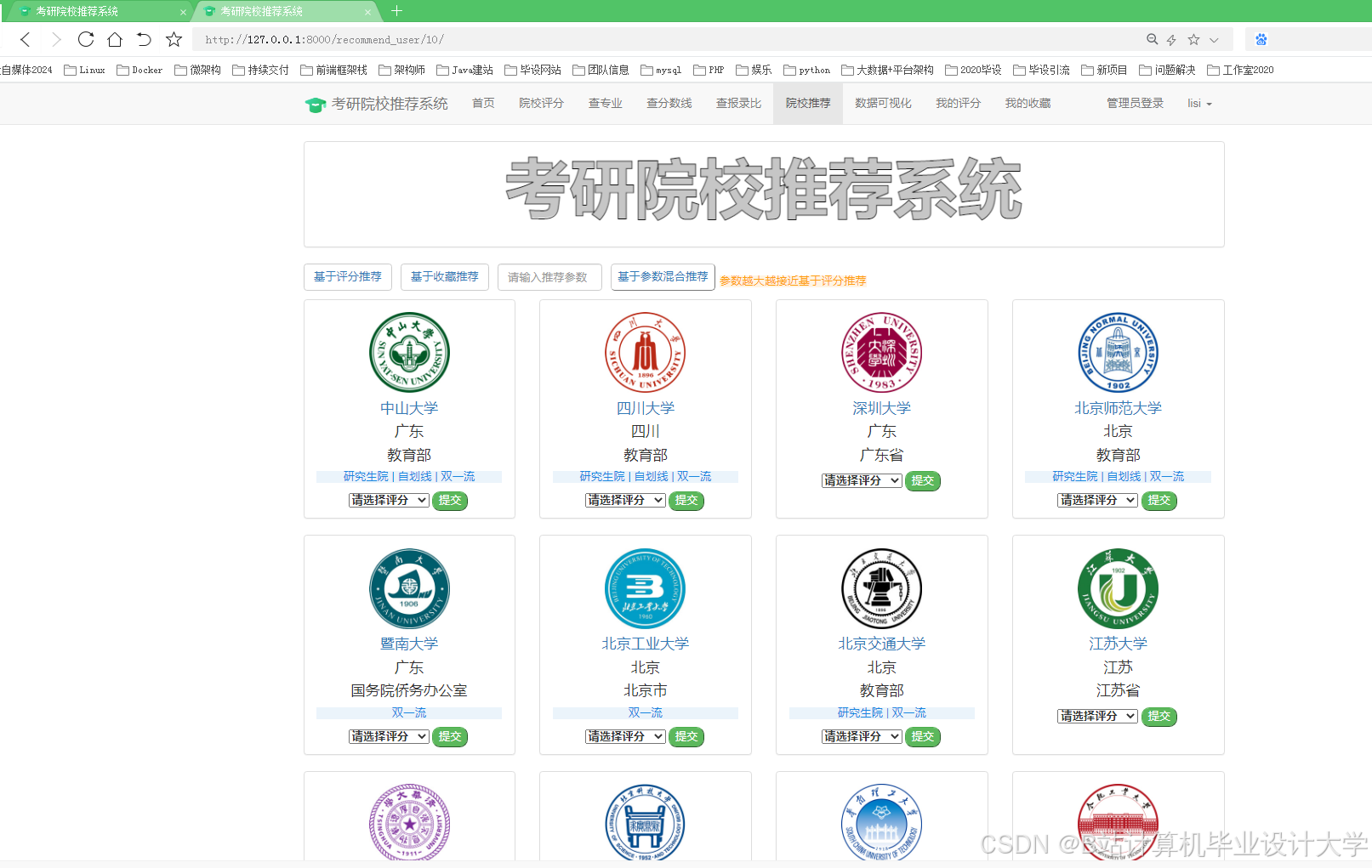

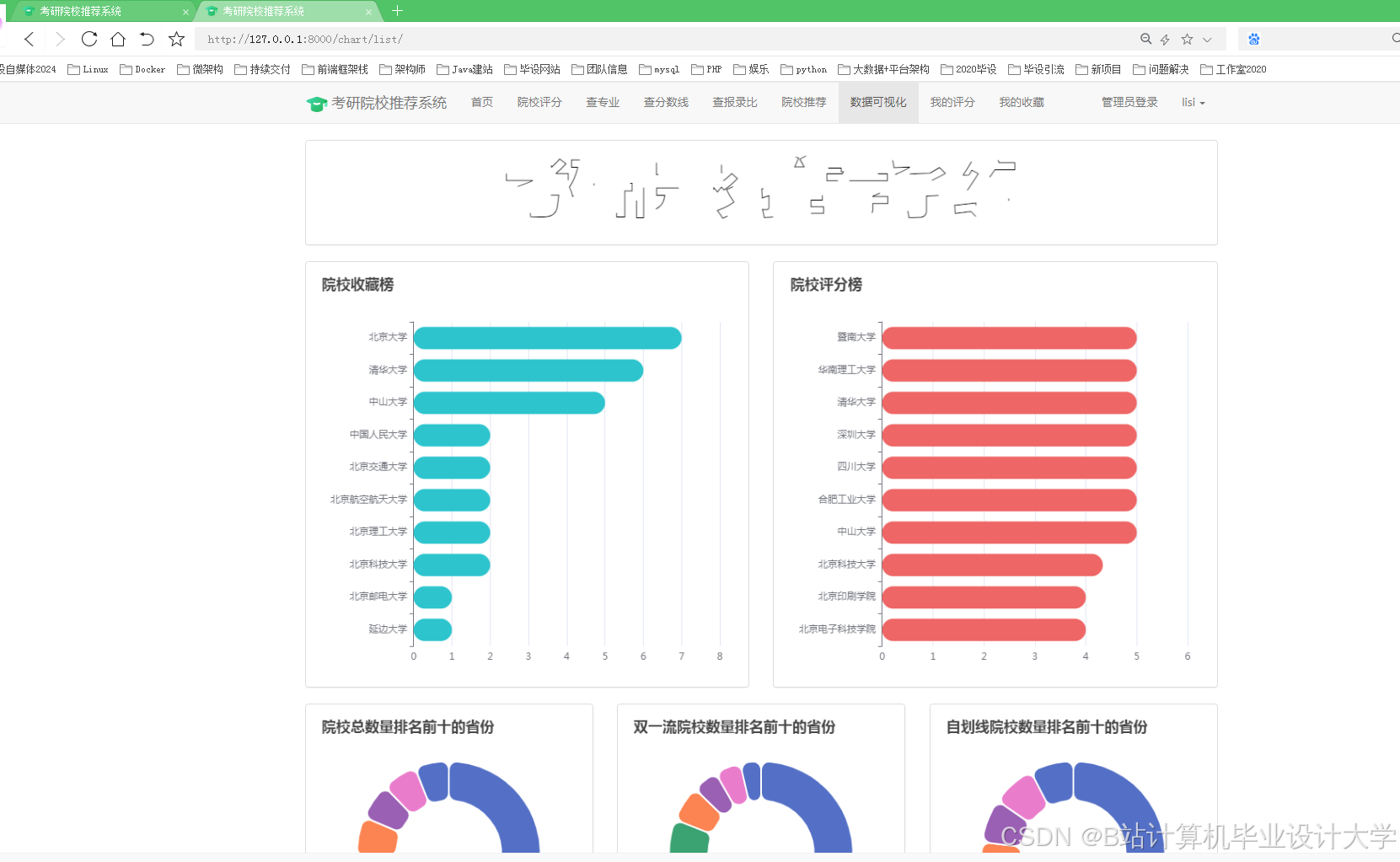

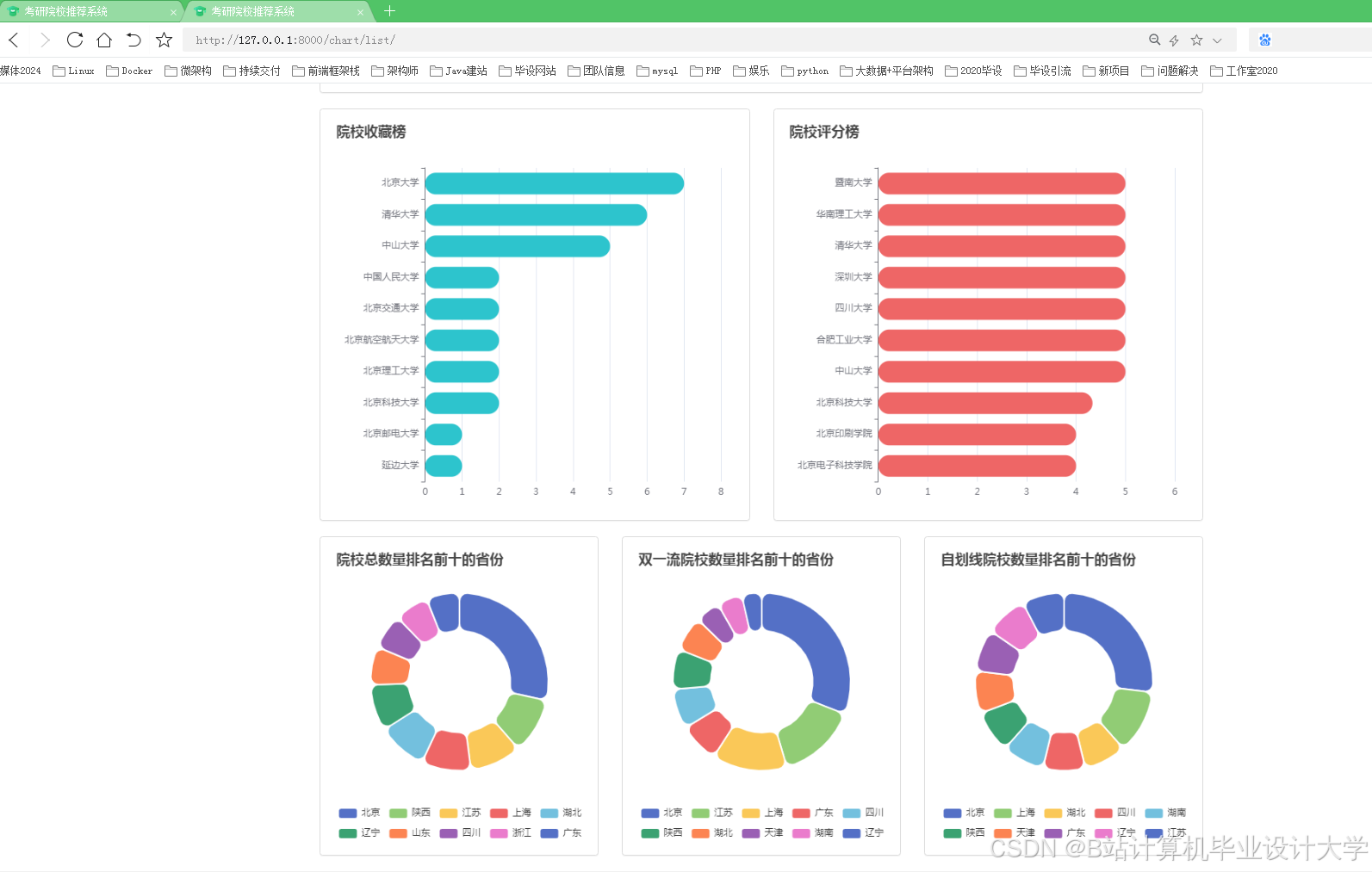

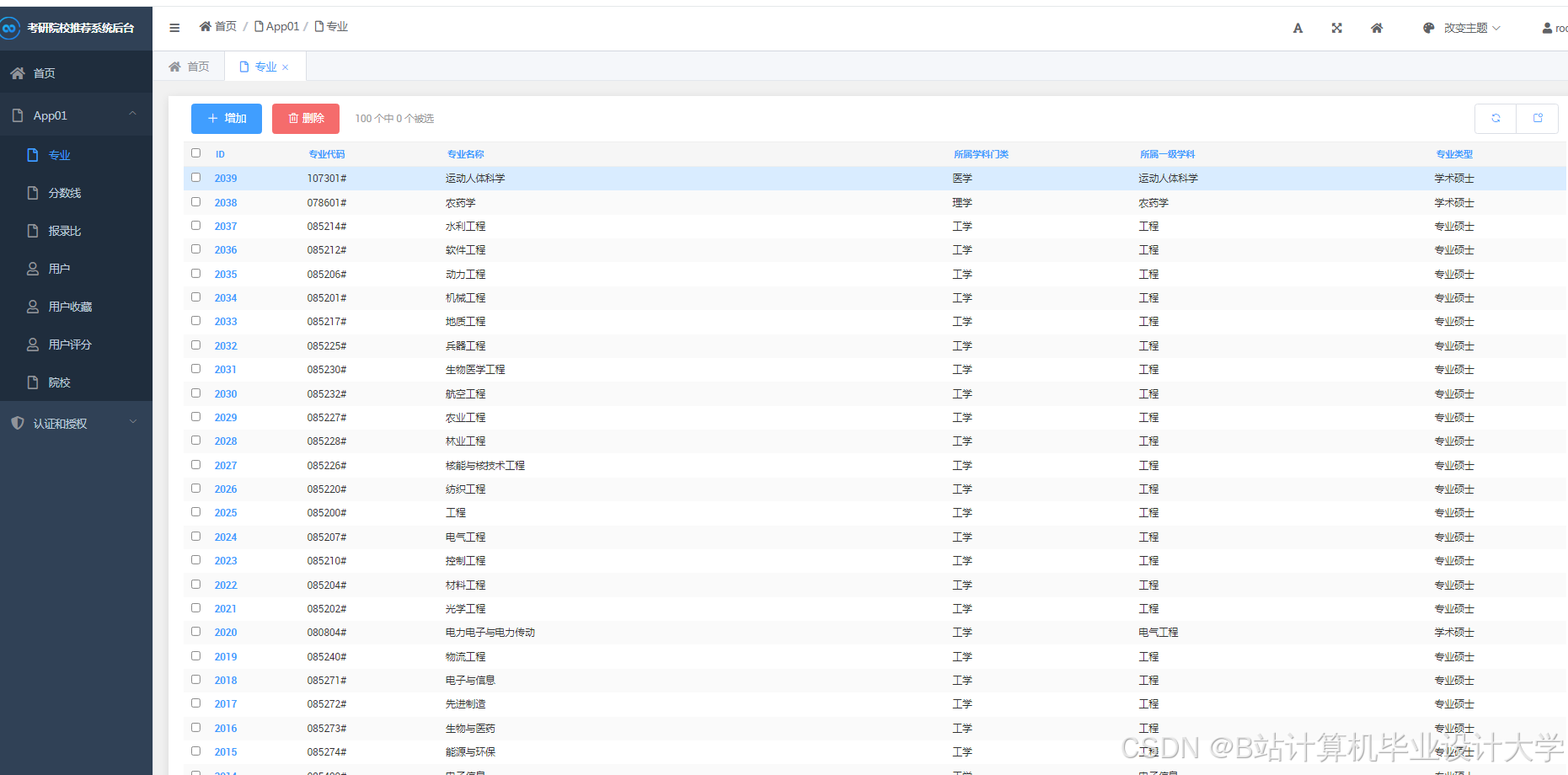

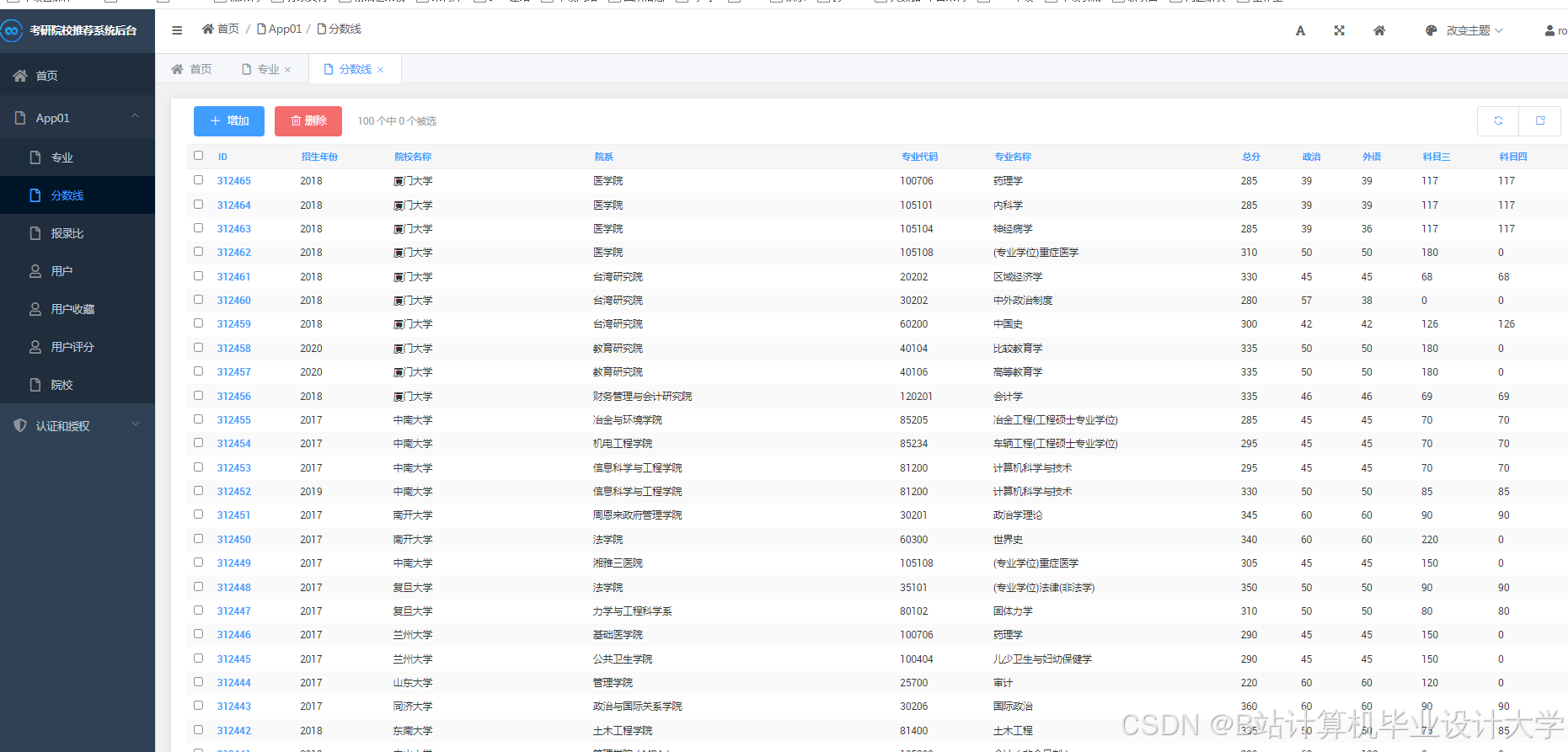

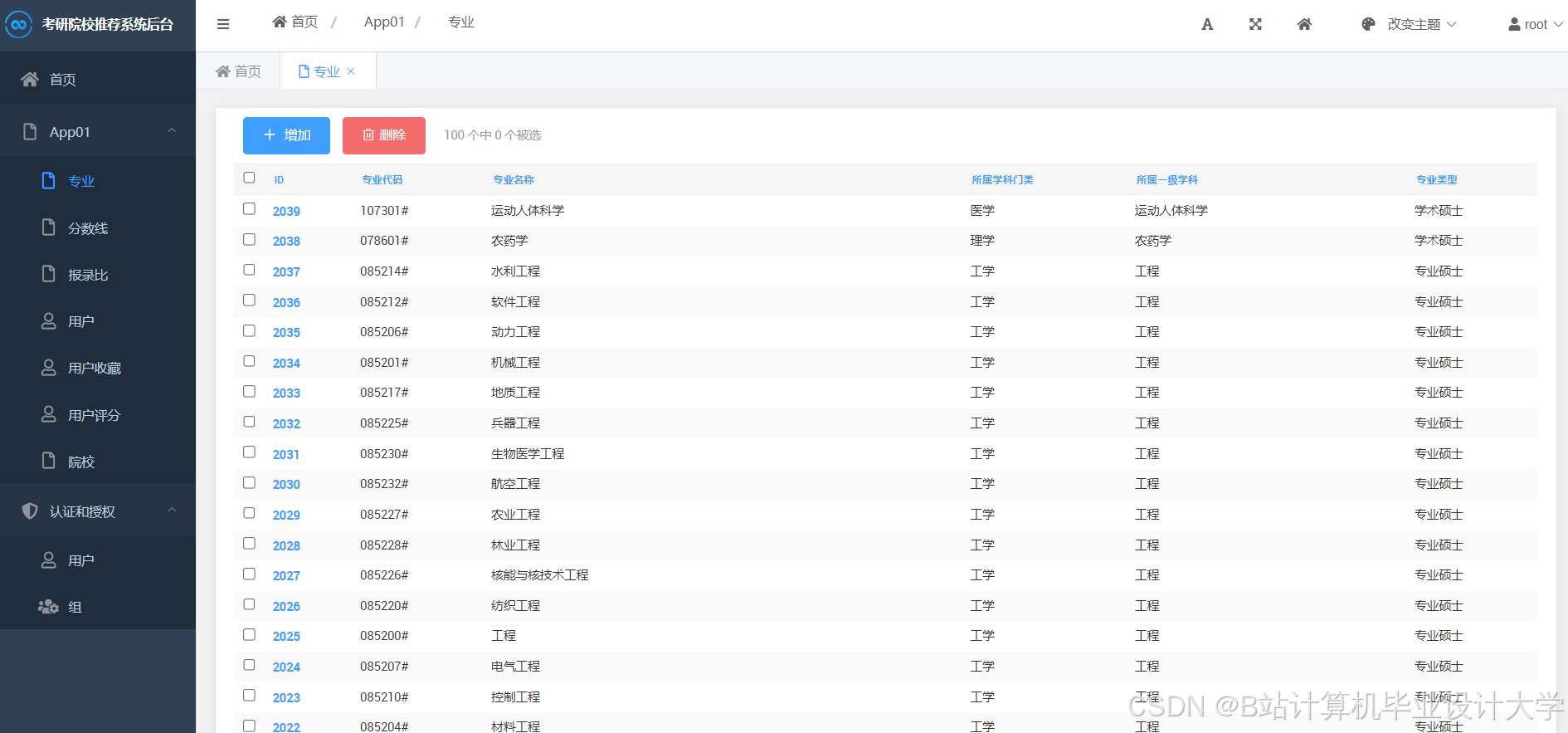

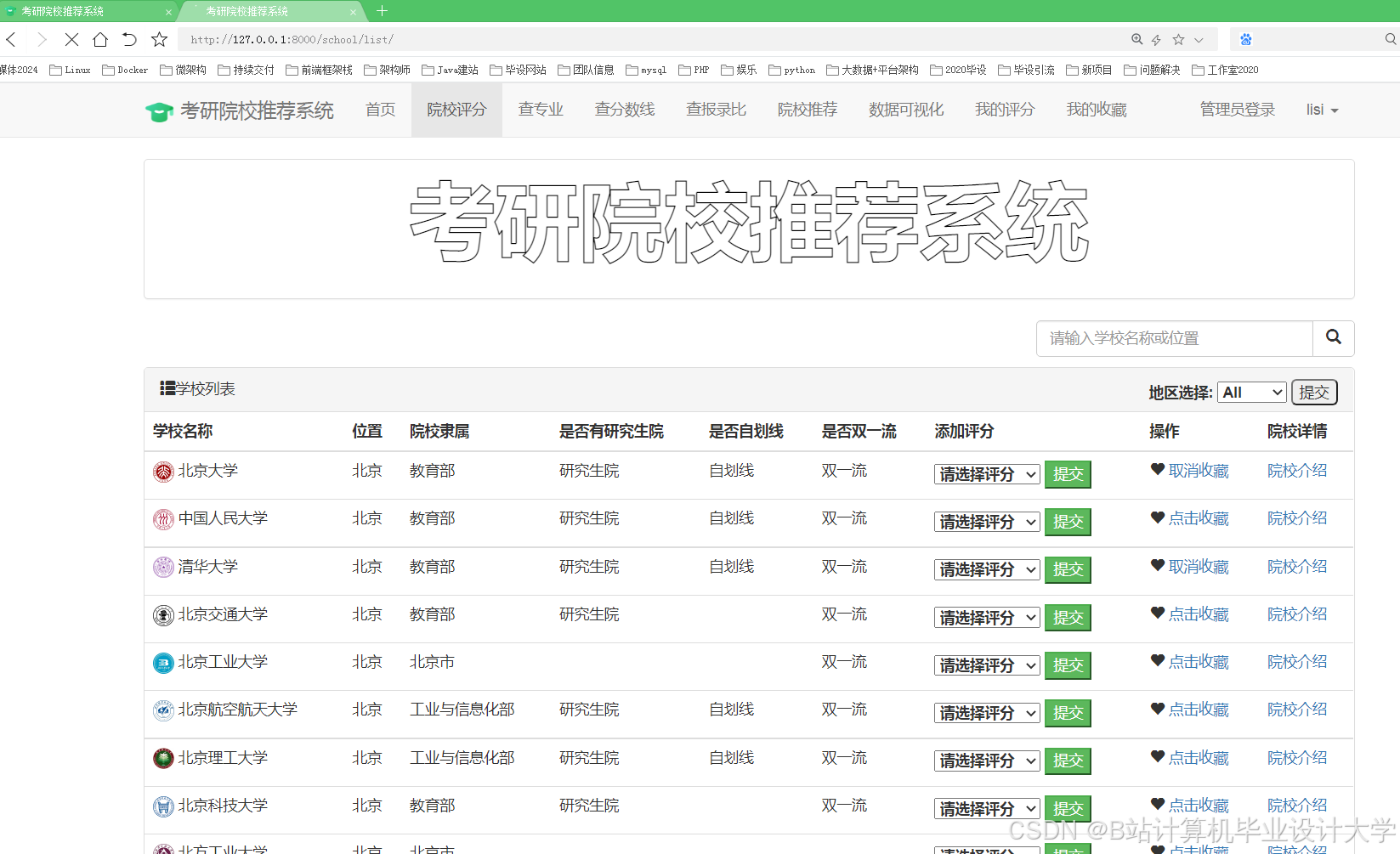

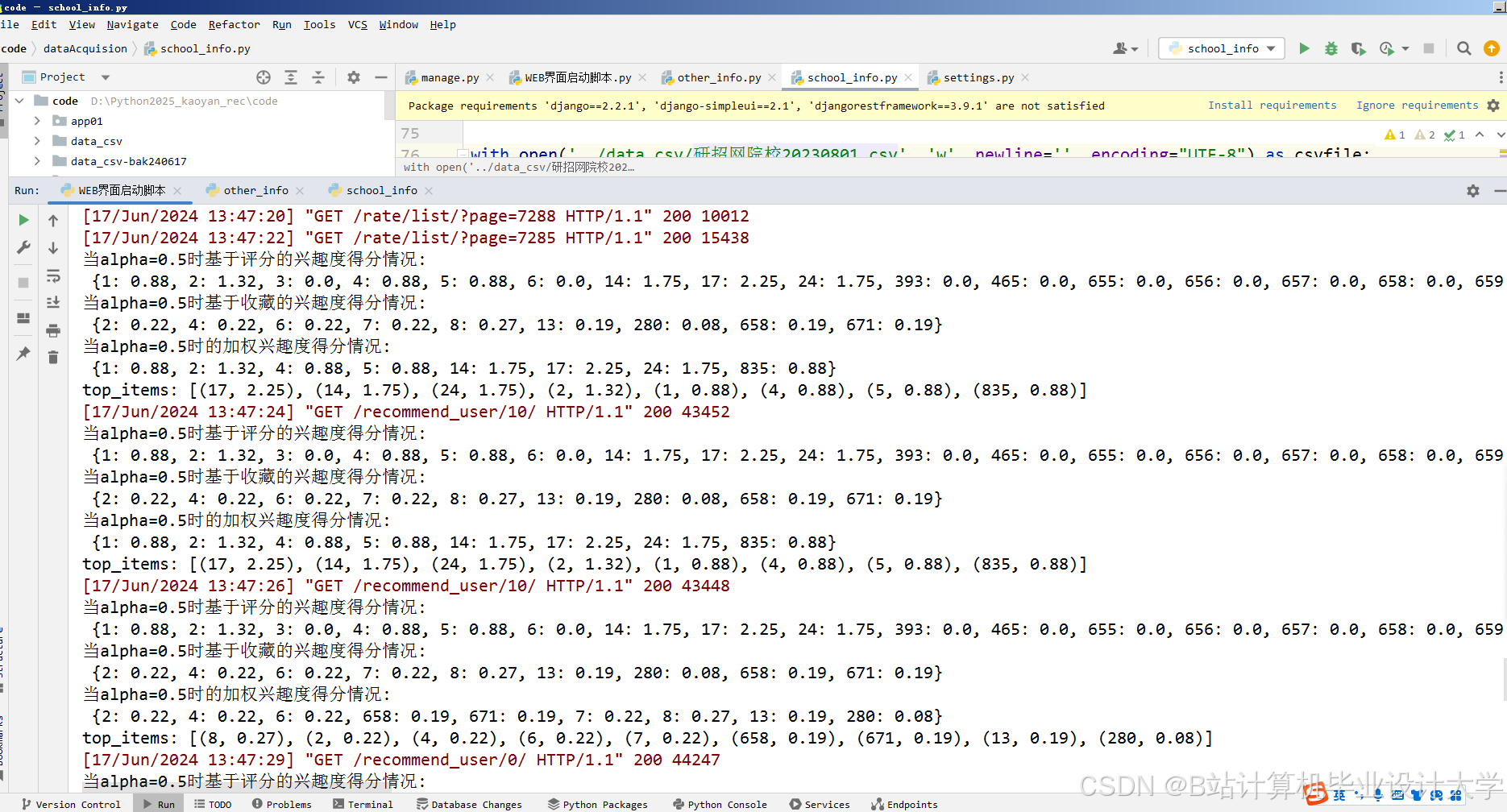

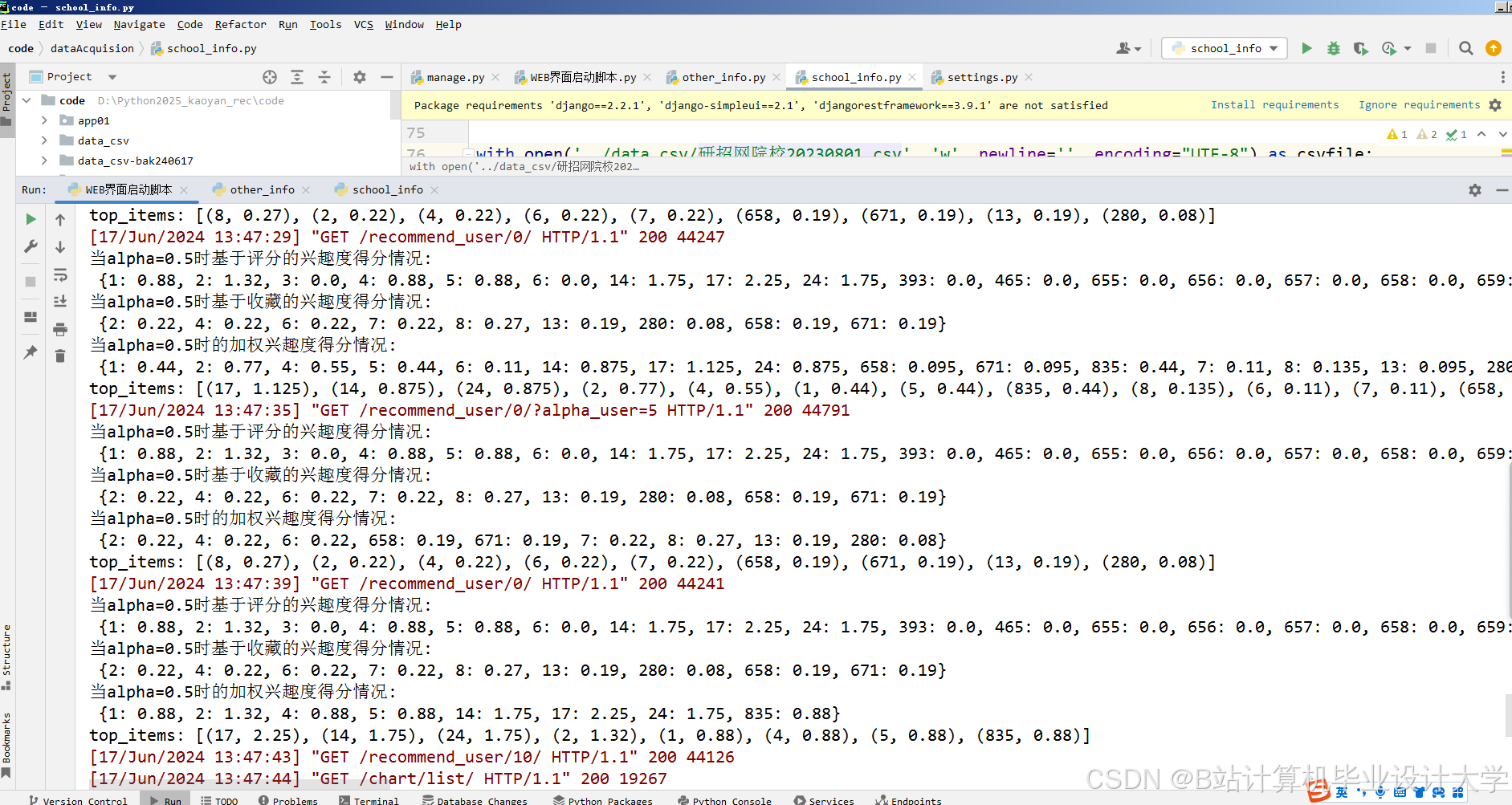

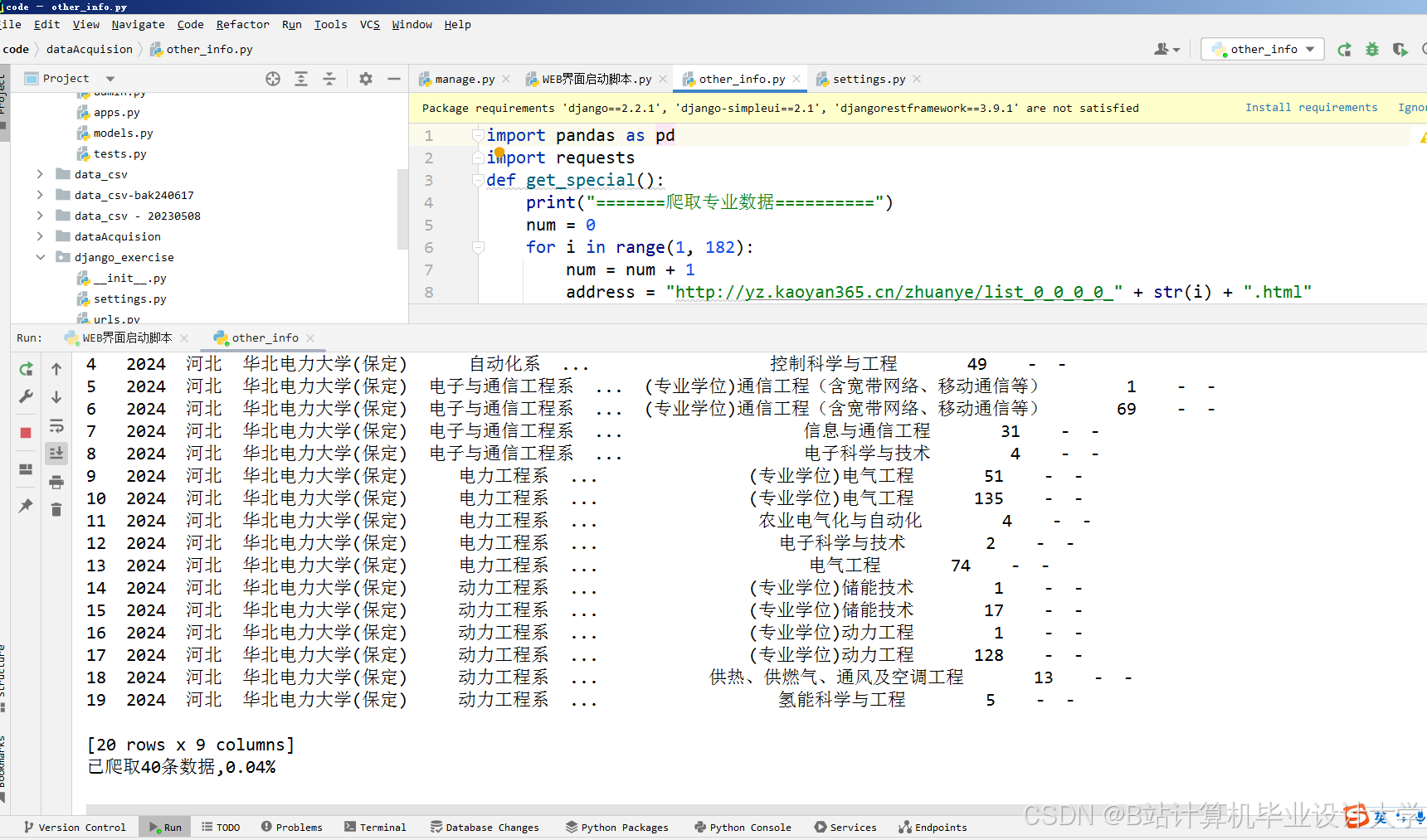

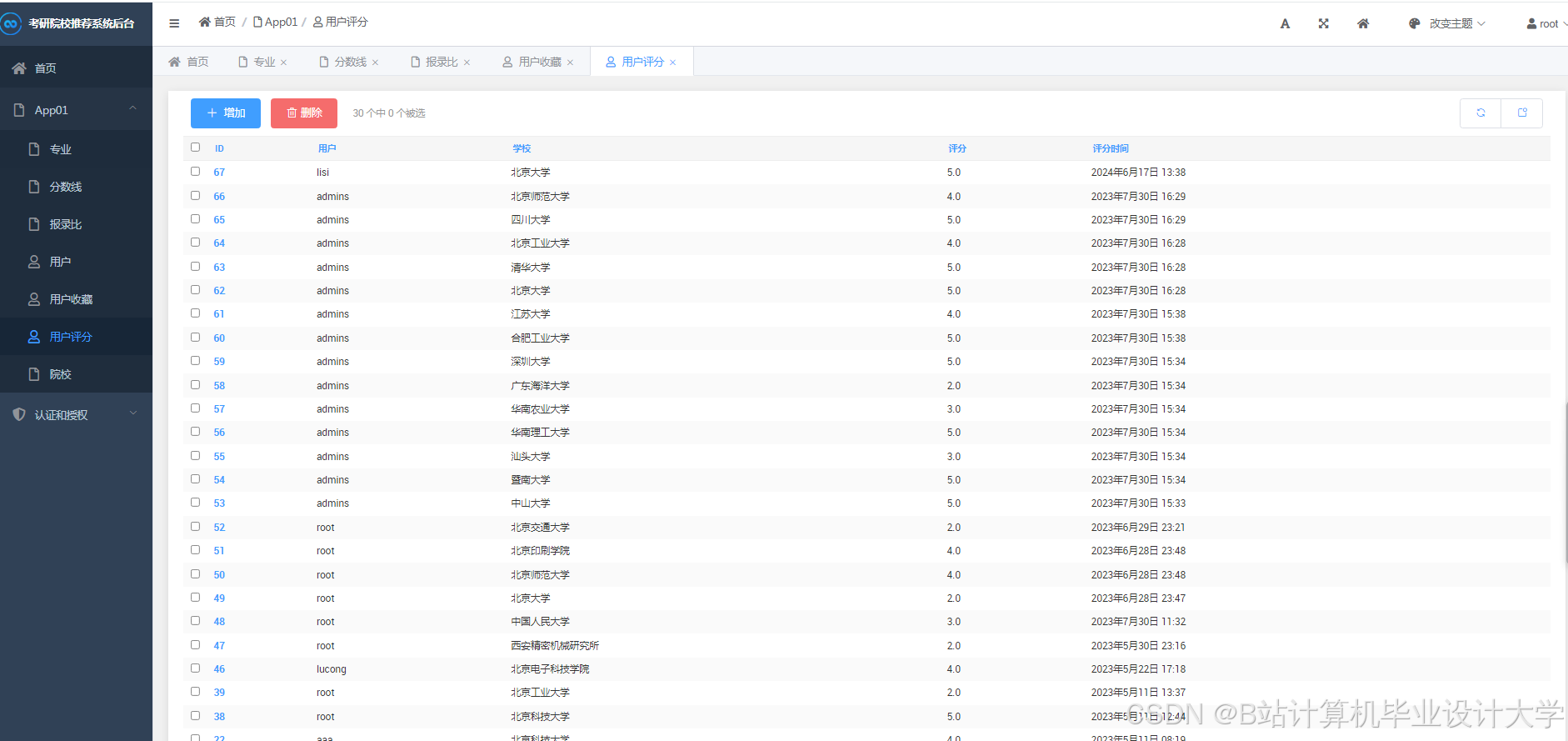

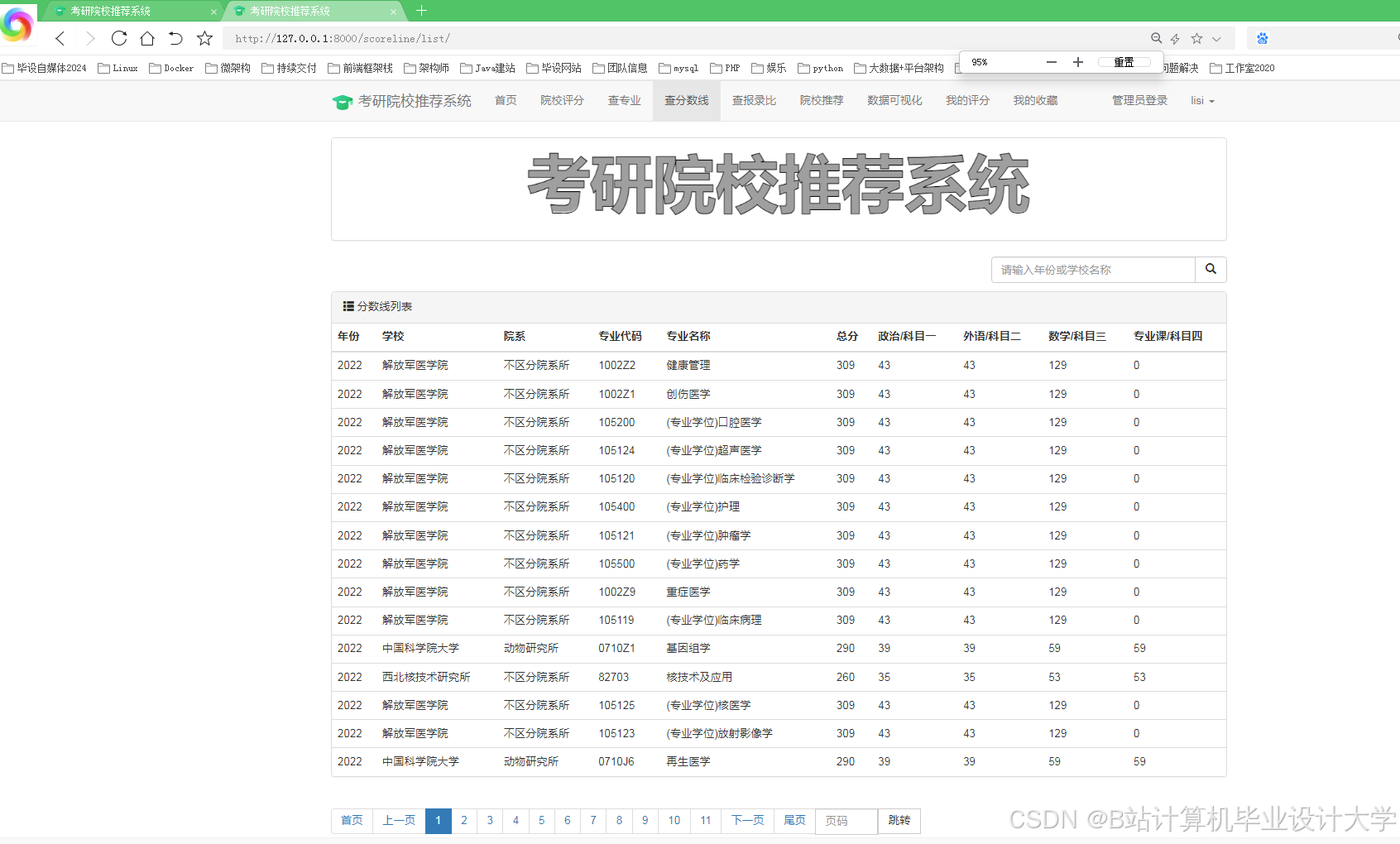

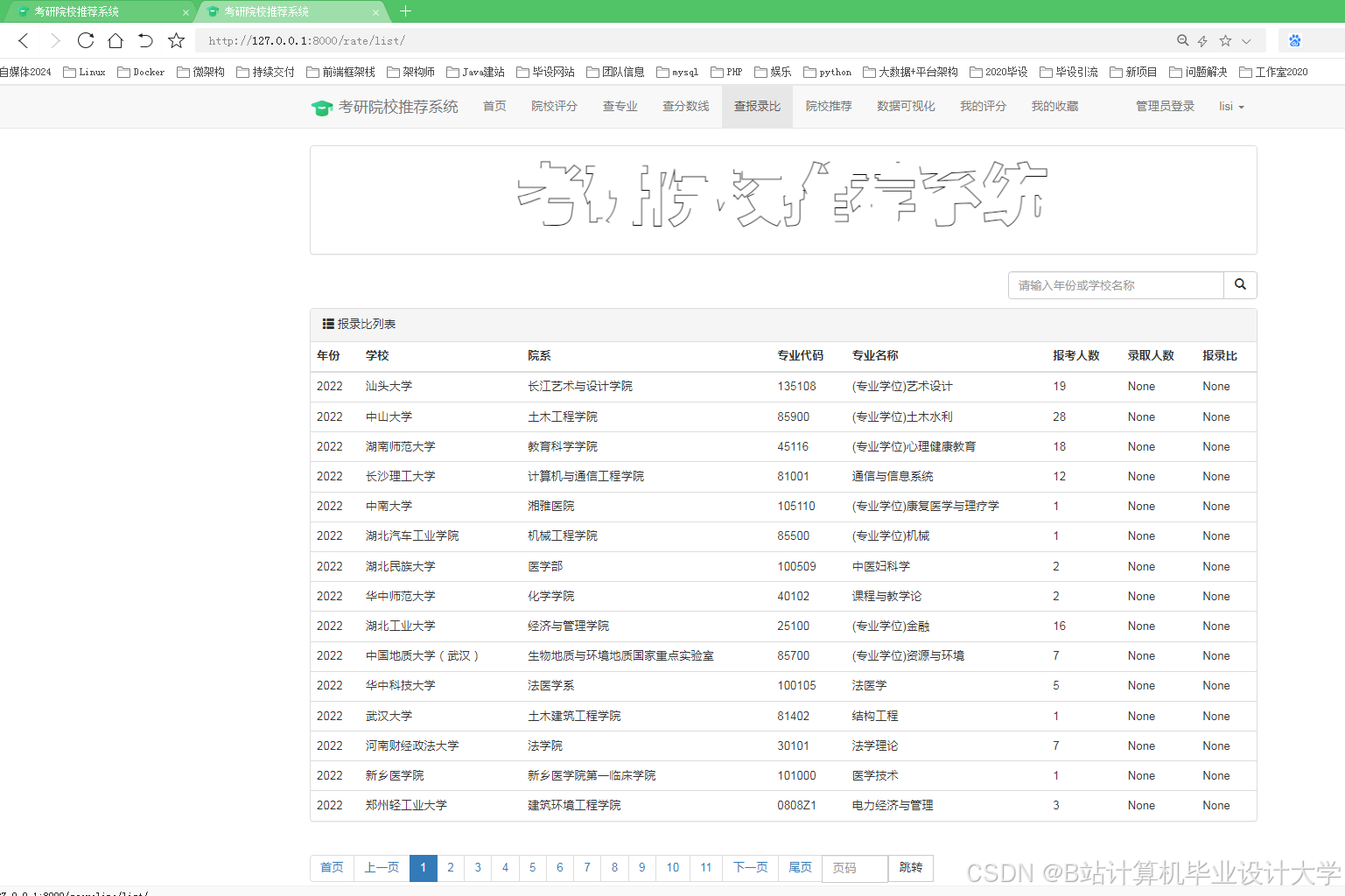

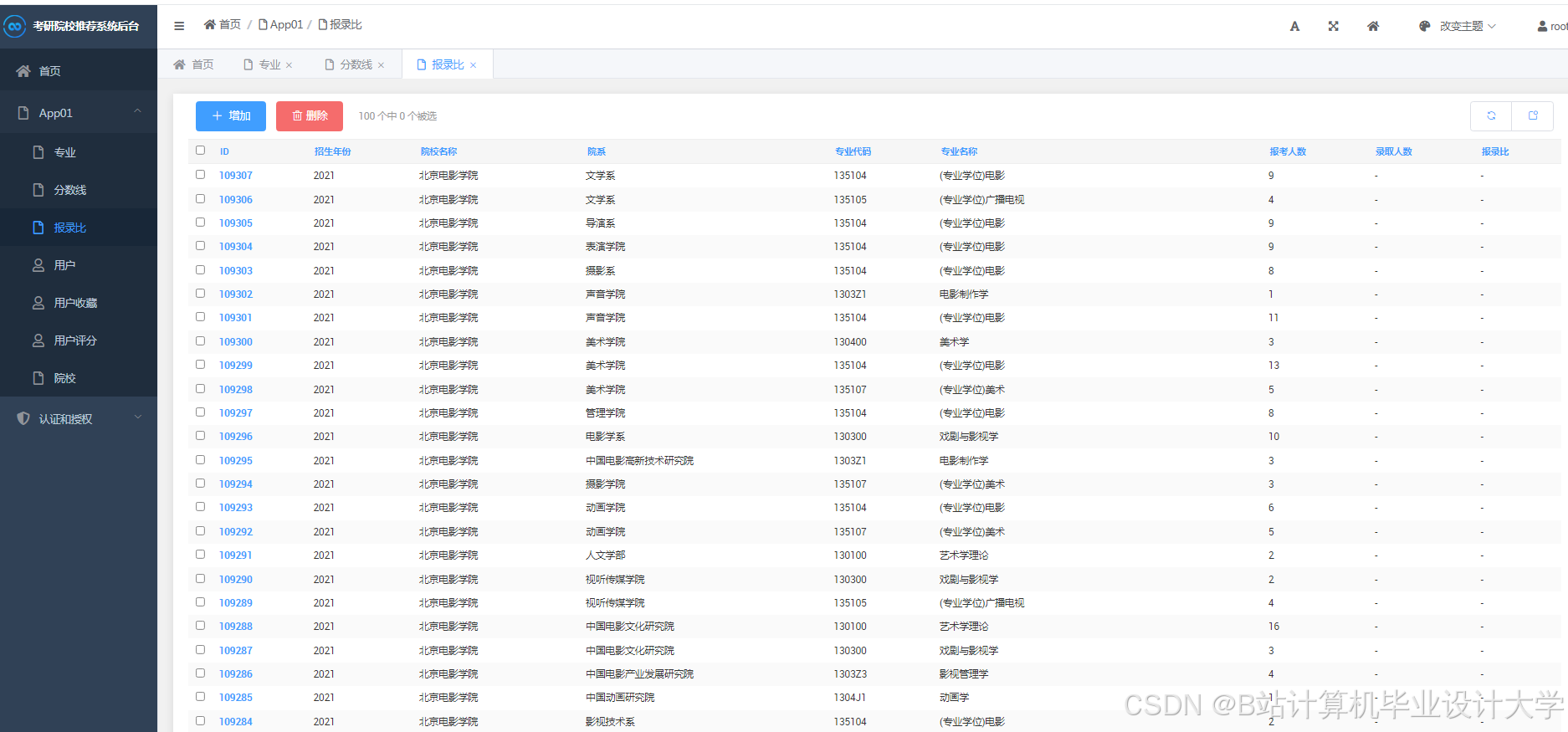

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

2507

2507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?