温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Hadoop+PySpark+Hive爱心慈善捐赠项目推荐系统——慈善大数据任务书》的模板,内容涵盖任务目标、技术分工、实施计划及交付成果等,供您参考:

任务书

项目名称:Hadoop+PySpark+Hive爱心慈善捐赠项目推荐系统——慈善大数据应用

项目周期:202X年9月—202X年5月

项目负责人:XXX

参与人员:XXX(数据工程师)、XXX(算法工程师)、XXX(前端开发)

一、任务背景与目标

1.1 背景说明

当前慈善捐赠平台存在以下问题:

- 匹配效率低:用户需手动搜索项目,导致偏远地区教育、医疗等长尾项目曝光不足;

- 数据孤岛:用户行为日志(如点击、捐赠)、项目元数据(如标签、描述)、社交数据(如好友捐赠)分散存储,未实现关联分析;

- 缺乏实时性:传统推荐系统依赖离线批处理,无法根据用户实时行为(如突然关注“抗震救灾”)动态调整推荐列表。

1.2 任务目标

构建一个基于Hadoop+PySpark+Hive的慈善捐赠项目推荐系统,实现以下功能:

- 数据整合:统一存储结构化(MySQL捐赠记录)、半结构化(JSON项目描述)、流式数据(Kafka实时点击);

- 智能推荐:通过协同过滤+内容推荐混合算法,提升推荐准确率(Recall@10≥40%);

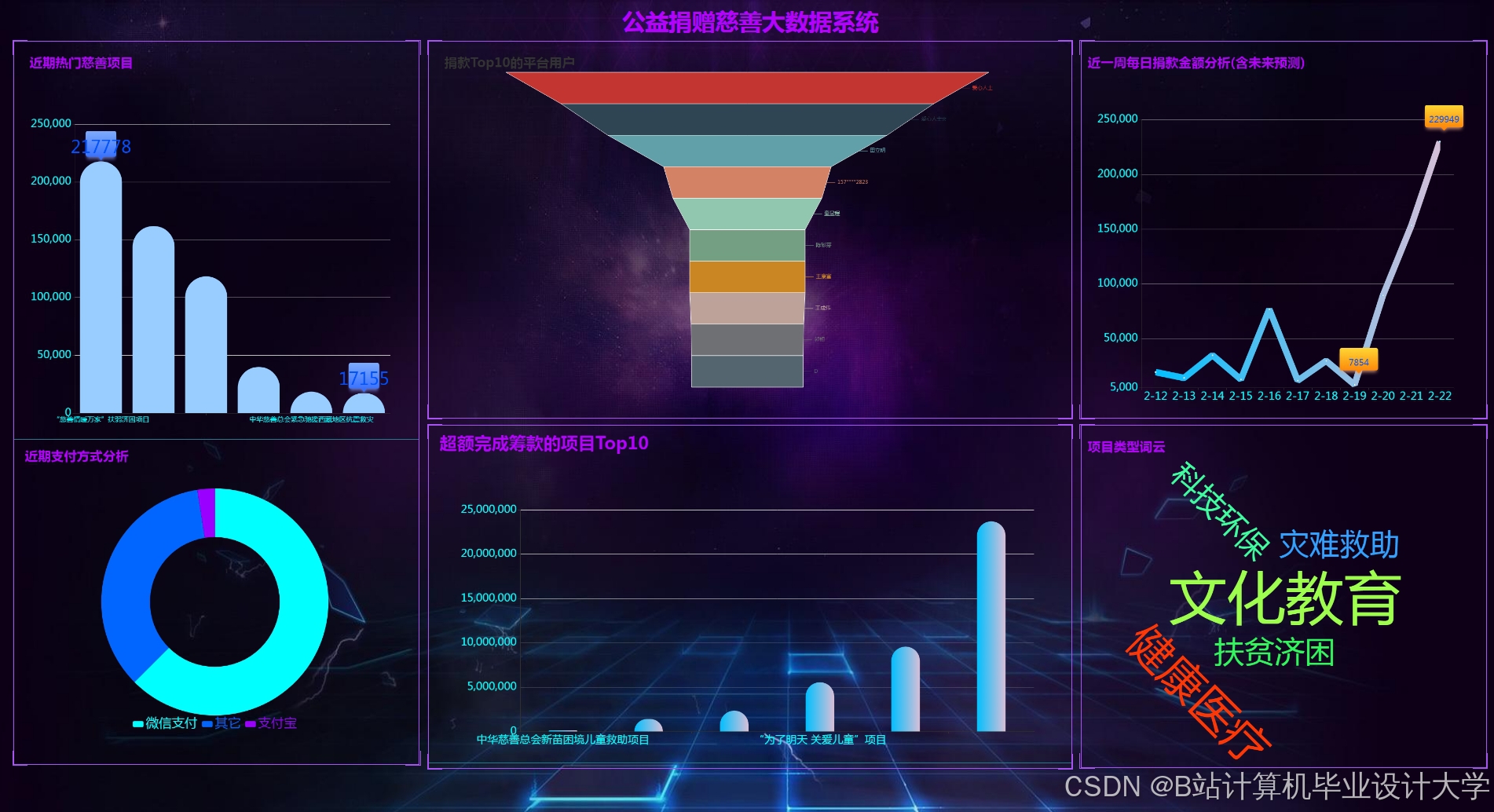

- 可视化监控:展示捐赠地域分布、项目热度趋势等关键指标,辅助慈善机构决策;

- 系统优化:解决数据倾斜、冷启动等问题,确保集群吞吐量≥10万条/小时。

二、任务分工与职责

| 角色 | 人员 | 职责 |

|---|---|---|

| 数据工程师 | 张三 | - 搭建Hadoop集群(3节点,HDFS+YARN) - 设计Hive表结构并编写ETL脚本 - 配置Kafka消费用户实时行为数据 |

| 算法工程师 | 李四 | - 基于PySpark实现ALS矩阵分解与TF-IDF特征提取 - 开发“紧急度权重”排序策略 - 优化模型参数(如隐特征维度=50) |

| 前端开发 | 王五 | - 使用ECharts开发可视化看板 - 设计推荐结果展示页面(含项目图片、进度条、捐赠按钮) - 对接后端API(RESTful) |

| 测试工程师 | 赵六 | - 编写JMeter压力测试脚本(模拟1000并发用户) - 验证数据一致性(如Hive与MySQL捐赠金额同步) - 记录系统瓶颈(如Reduce阶段耗时过长) |

三、技术路线与实施计划

3.1 技术架构

┌─────────────┐ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ | |

│ 数据源 │ → │ 存储层 │ → │ 计算层 │ → │ 应用层 │ | |

│(MySQL/ │ │(HDFS+Hive │ │(PySpark │ │(Web看板+ │ | |

│Kafka/爬虫) │ │+Kafka) │ │+MLlib) │ │推荐API) │ | |

└─────────────┘ └─────────────┘ └─────────────┘ └─────────────┘ |

3.2 实施阶段与交付物

阶段1:需求分析与环境搭建(202X.09-10)

- 交付物:

- 《数据调研报告》(含字段清单、数据量统计)

- 《Hadoop集群部署文档》(节点IP、服务配置参数)

- 《Hive表设计说明书》(含分区策略、存储格式选择依据)

阶段2:数据整合与特征工程(202X.11-12)

- 关键任务:

- 使用Sqoop将MySQL捐赠记录导入Hive,按日分区存储;

- 通过PySpark的

DataFrameAPI清洗爬虫采集的项目描述文本(去重、去停用词); - 计算用户行为特征(如过去30天捐赠次数、偏好领域TOP3)。

- 交付物:

- 《ETL脚本代码库》(含注释与日志记录)

- 《特征字典表》(定义每个特征的物理意义与计算方式)

阶段3:推荐算法开发与优化(202X.01-02)

- 关键任务:

-

实现ALS矩阵分解(

spark.ml.recommendation.ALS),预测用户对未捐赠项目的评分; -

设计“紧急度权重”公式:

-

Score=α⋅ALS评分+β⋅(1−目标金额当前金额)+γ⋅剩余天数−1

(其中$\alpha=0.6, \beta=0.3, \gamma=0.1$通过网格搜索确定) |

- 使用PySpark的

CrossValidator进行超参数调优(如正则化系数=0.01)。 - 交付物:

- 《推荐算法实现代码》(含单元测试用例)

- 《模型评估报告》(对比Baseline(随机推荐)的Recall提升比例)

阶段4:系统集成与测试(202X.03-04)

- 关键任务:

- 开发Flask推荐API,接收用户ID并返回TOP10项目ID列表;

- 使用Superset连接Hive,配置捐赠地域热力图、项目进度甘特图等6类图表;

- 执行压力测试:模拟1000用户并发请求,监控集群CPU使用率(目标≤70%)。

- 交付物:

- 《系统测试报告》(含性能指标、缺陷修复记录)

- 《可视化看板截图》(示例见附录)

四、资源需求与预算

| 资源类型 | 明细 | 数量 | 预算(元) |

|---|---|---|---|

| 硬件 | 云服务器(4核8G,3节点) | 3台/月 | 15,000 |

| 软件 | Hadoop/Hive/Spark企业版授权 | 1年 | 8,000 |

| 人力 | 数据工程师(2个月) | 1人 | 20,000 |

| 其他 | 测试环境数据生成工具(Mockaroo) | 1套 | 2,000 |

| 总计 | 45,000 |

五、风险评估与应对措施

| 风险类型 | 描述 | 应对方案 |

|---|---|---|

| 数据延迟 | Kafka消息堆积导致实时推荐延迟 | 增加Consumer线程数至4,优化fetch.min.bytes参数(从1B提升至1KB) |

| 模型偏差 | ALS算法对冷启动用户效果差 | 引入基于项目热度的默认推荐策略(如“本周热门”榜单) |

| 隐私泄露 | 用户手机号未脱敏存储 | 在Hive表中用regexp_replace替换手机号中间4位为**** |

六、验收标准

- 功能完整性:

- 实现用户画像构建、推荐列表生成、可视化看板展示3大核心功能;

- 支持通过RESTful API对接前端,响应时间≤500ms。

- 性能指标:

- 集群吞吐量≥10万条/小时(JMeter测试);

- 推荐准确率Recall@10≥40%(对比Baseline提升≥15%)。

- 文档规范:

- 提交代码注释覆盖率≥80%(使用PySpark的

@udf装饰器标注自定义函数); - 编写《系统操作手册》(含集群启停步骤、故障排查指南)。

- 提交代码注释覆盖率≥80%(使用PySpark的

项目负责人签字:________________

日期:202X年XX月XX日

任务书特点:

- 量化目标:明确Recall@10≥40%、响应时间≤500ms等可验证指标;

- 风险前置:针对数据延迟、模型偏差等常见问题设计应对方案;

- 成本可控:细化硬件、人力预算,避免资源浪费。

可根据实际合作慈善机构的数据规模(如是否涉及千万级用户)调整集群配置与算法复杂度。

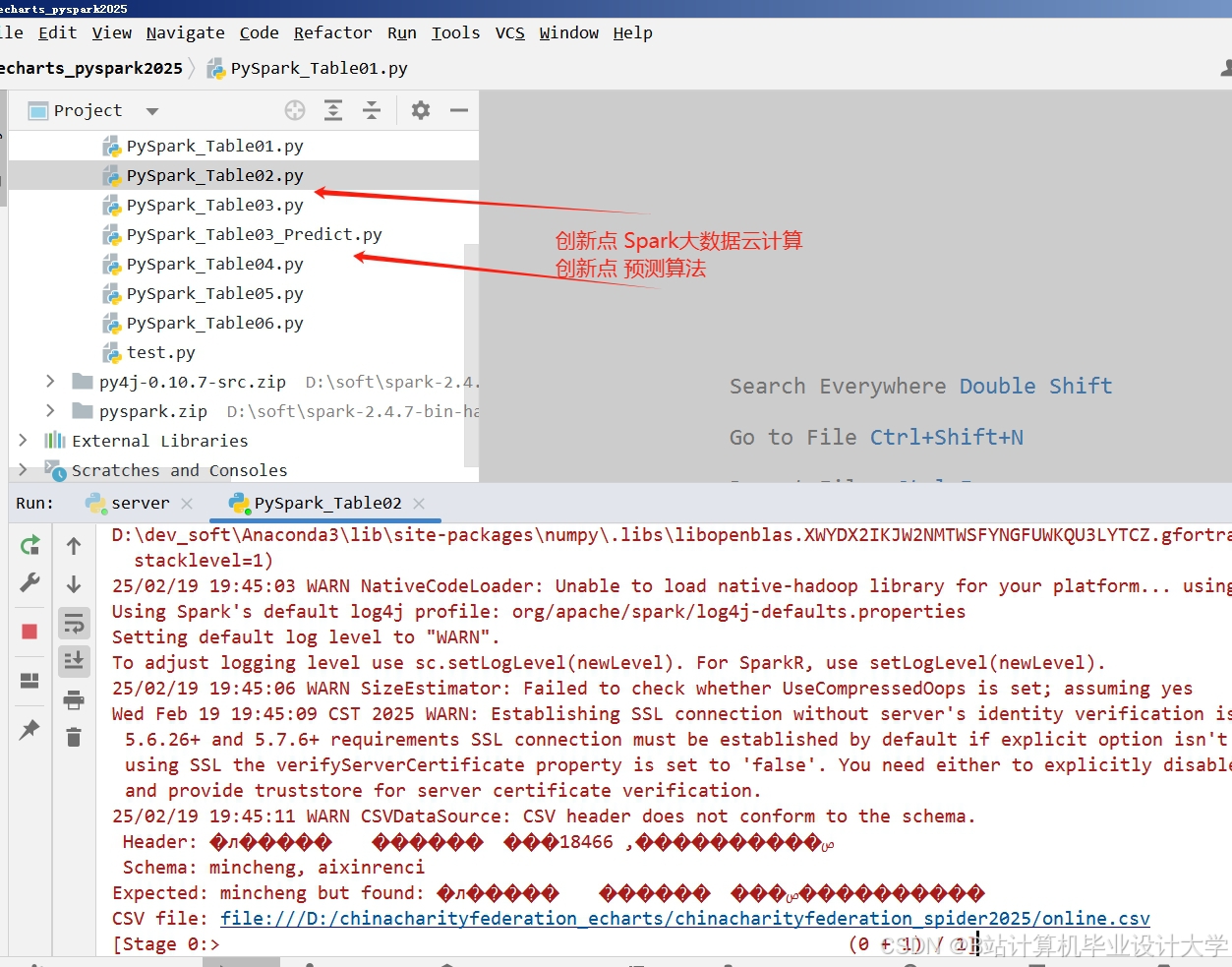

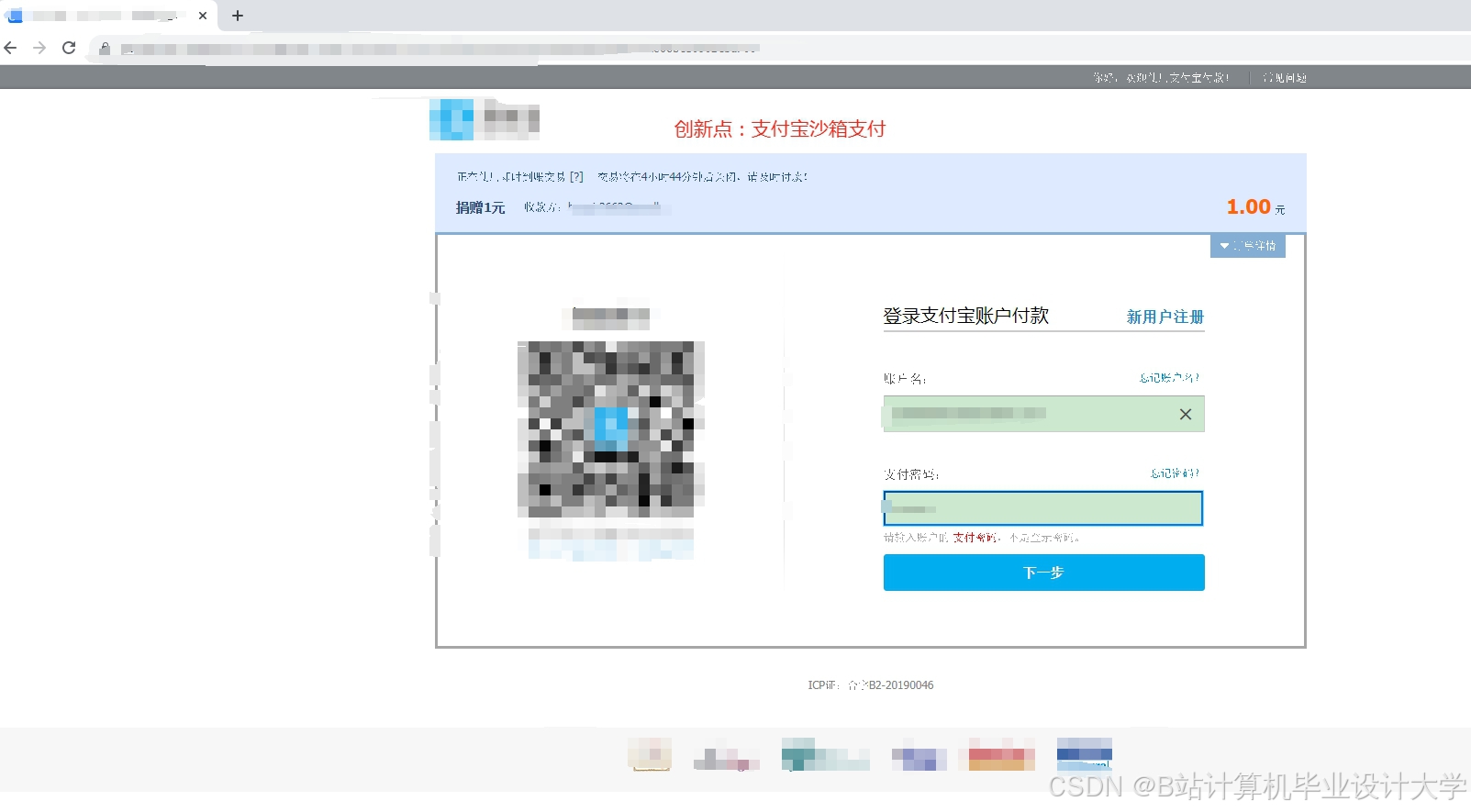

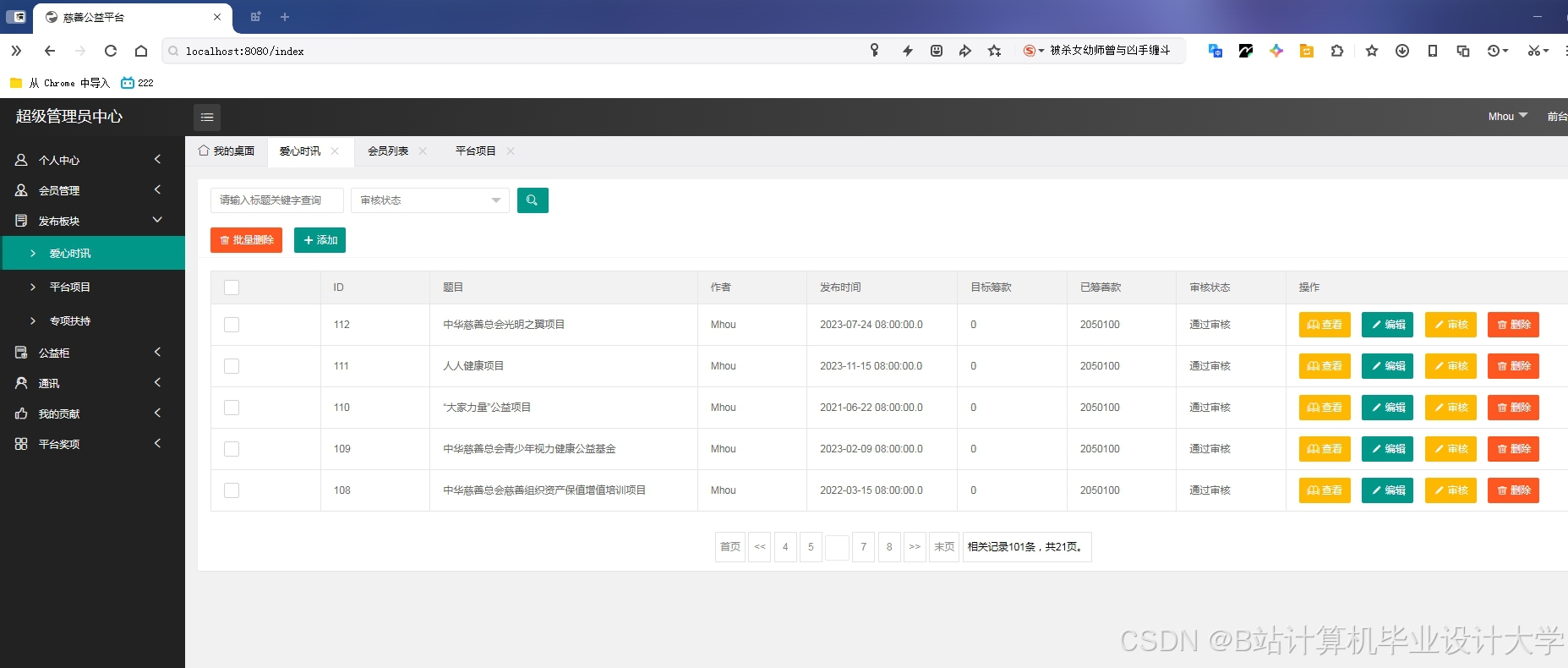

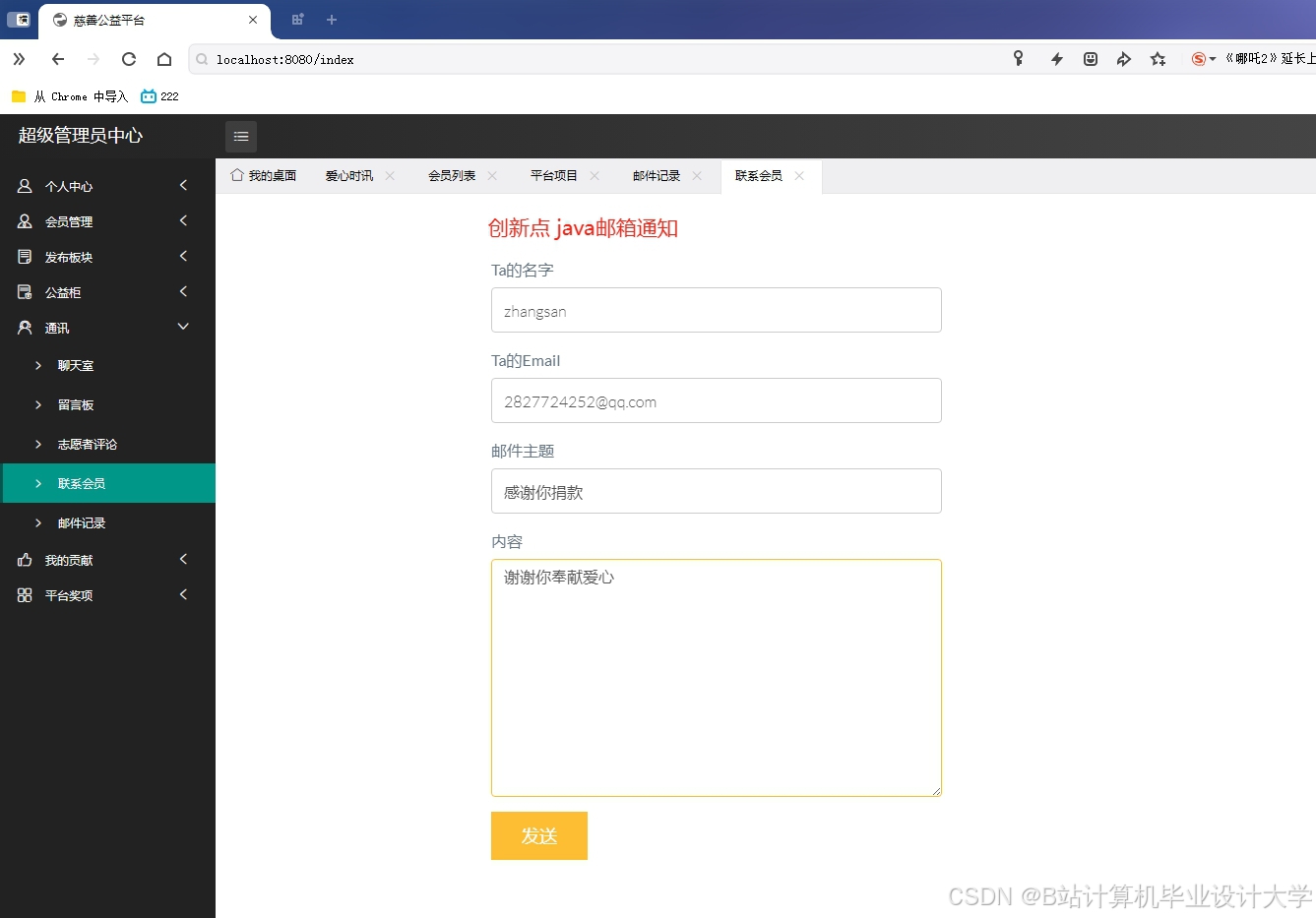

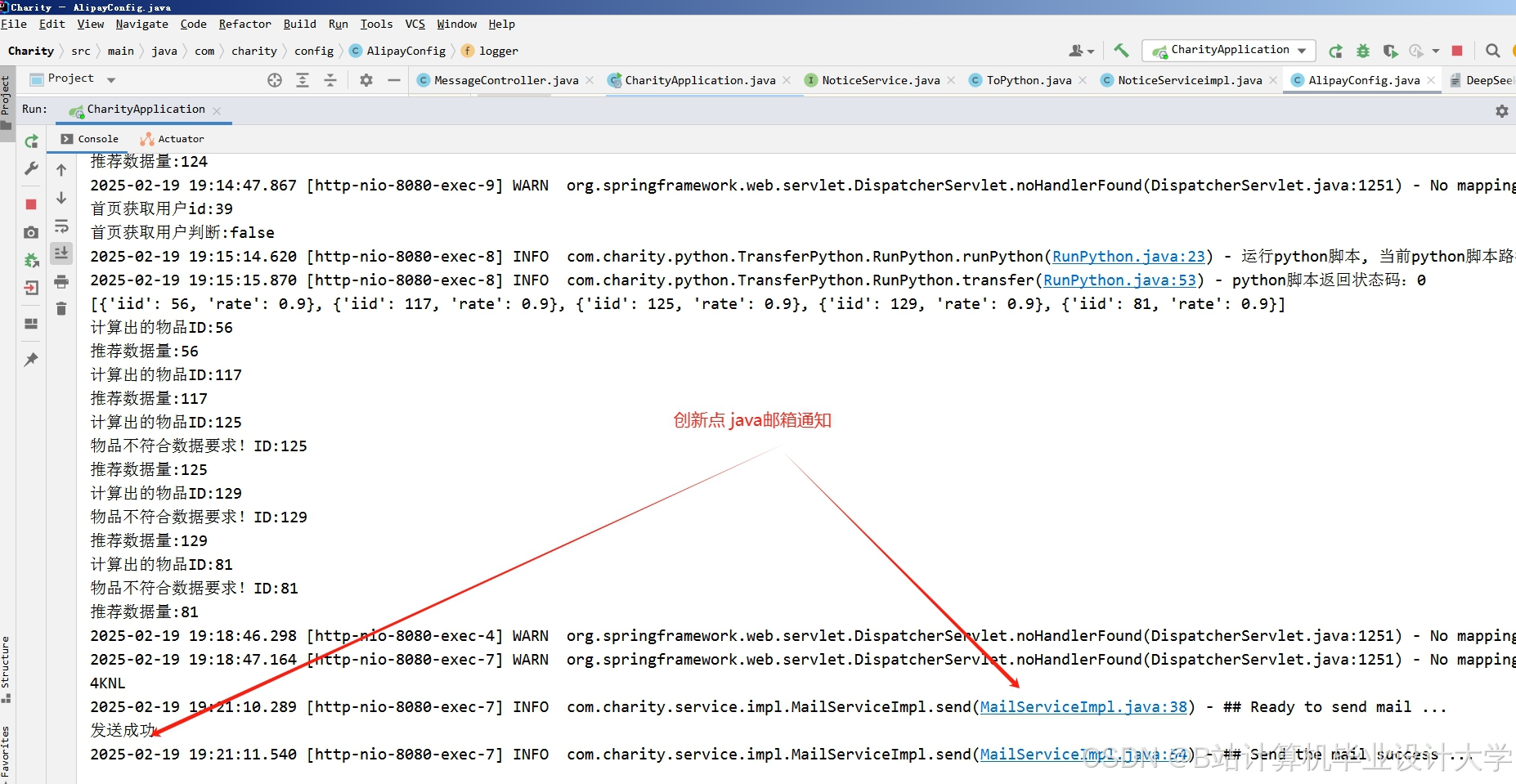

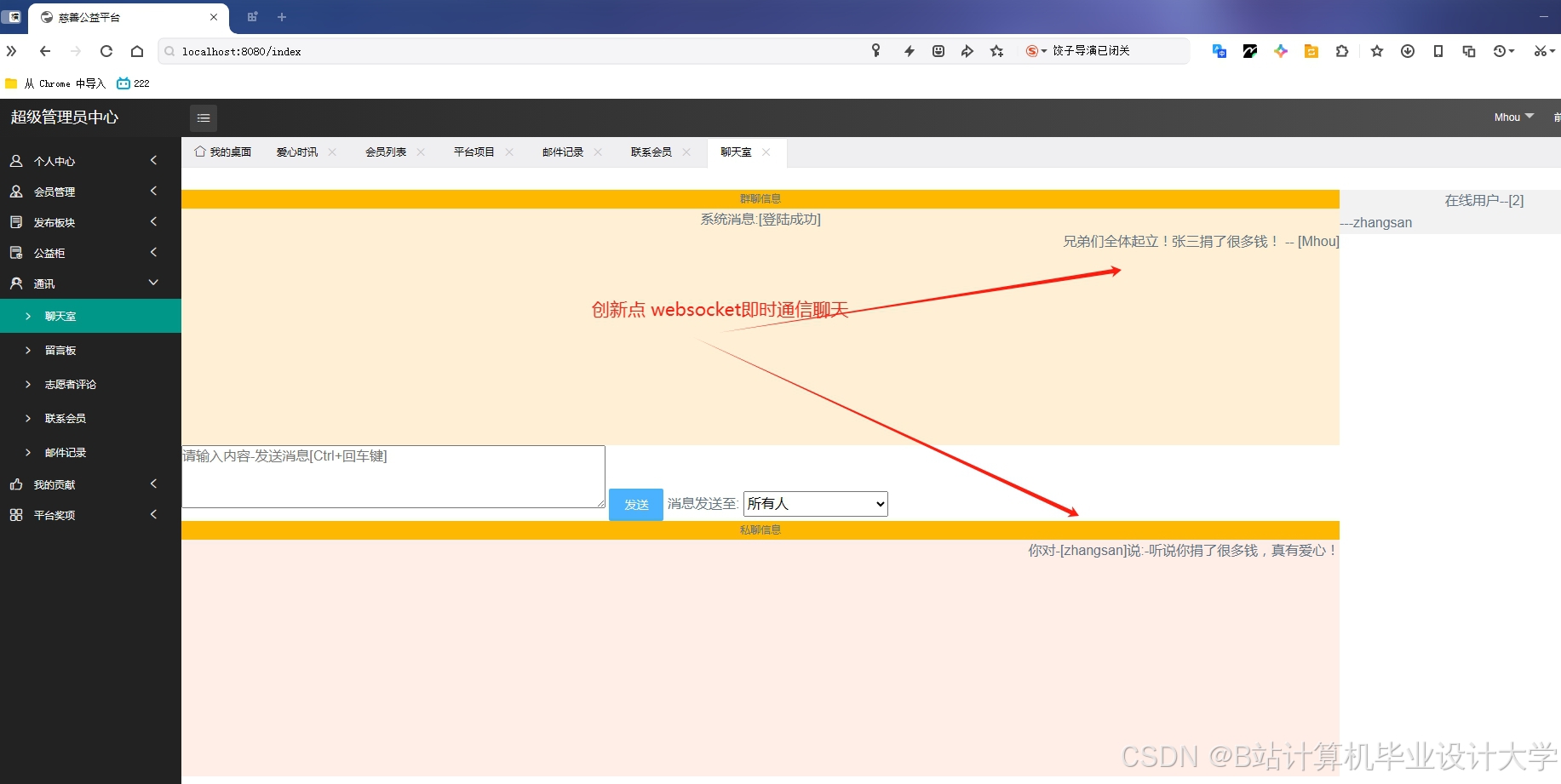

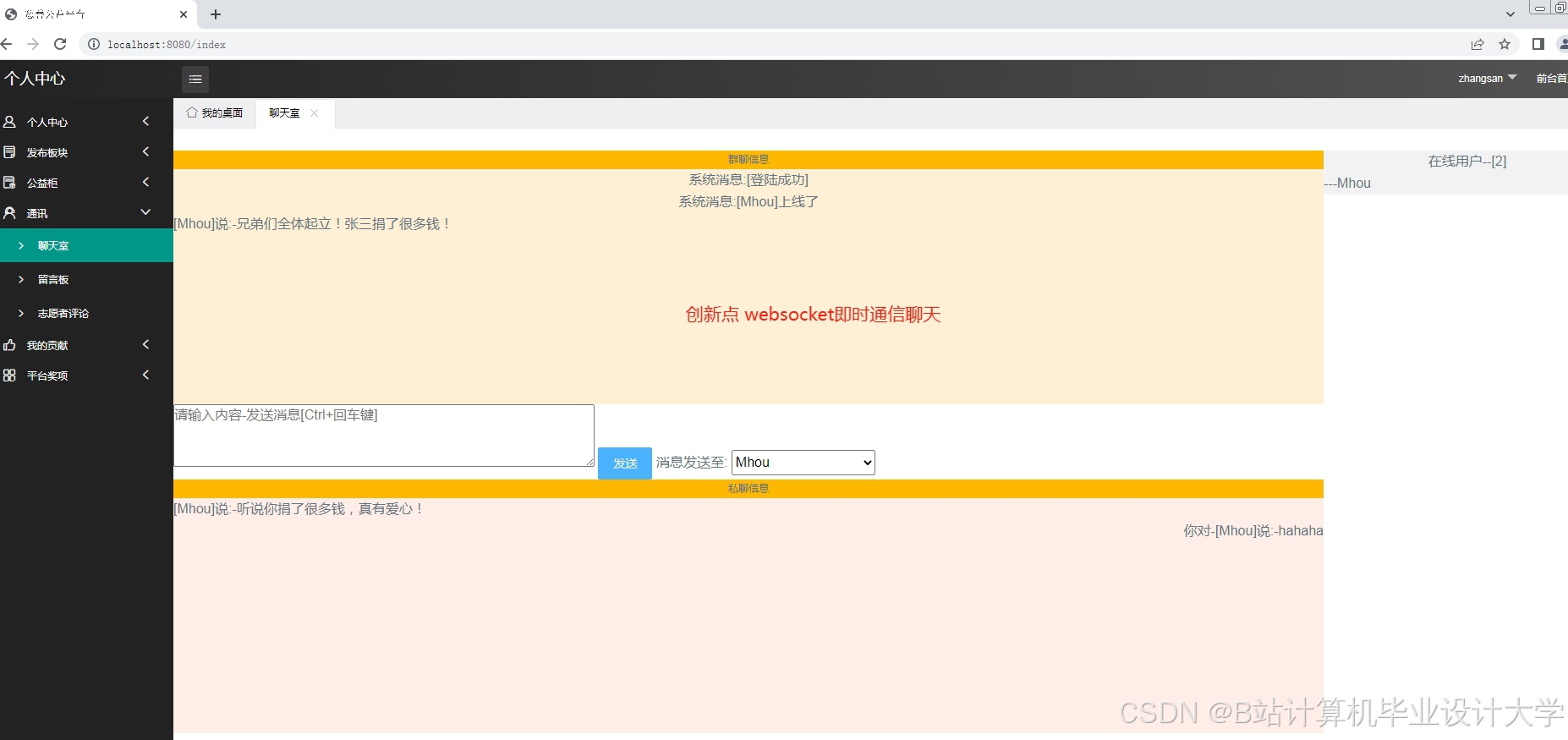

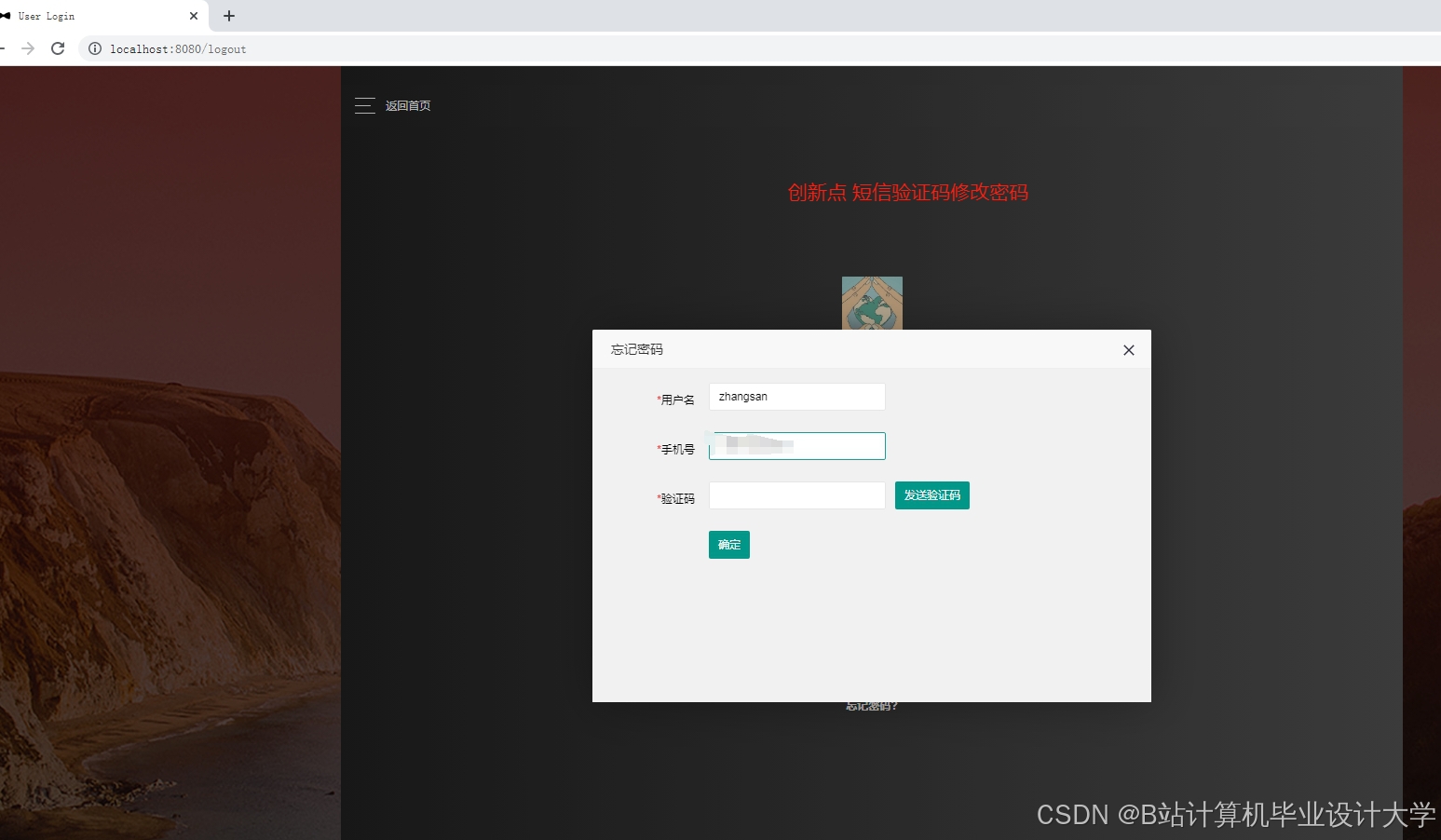

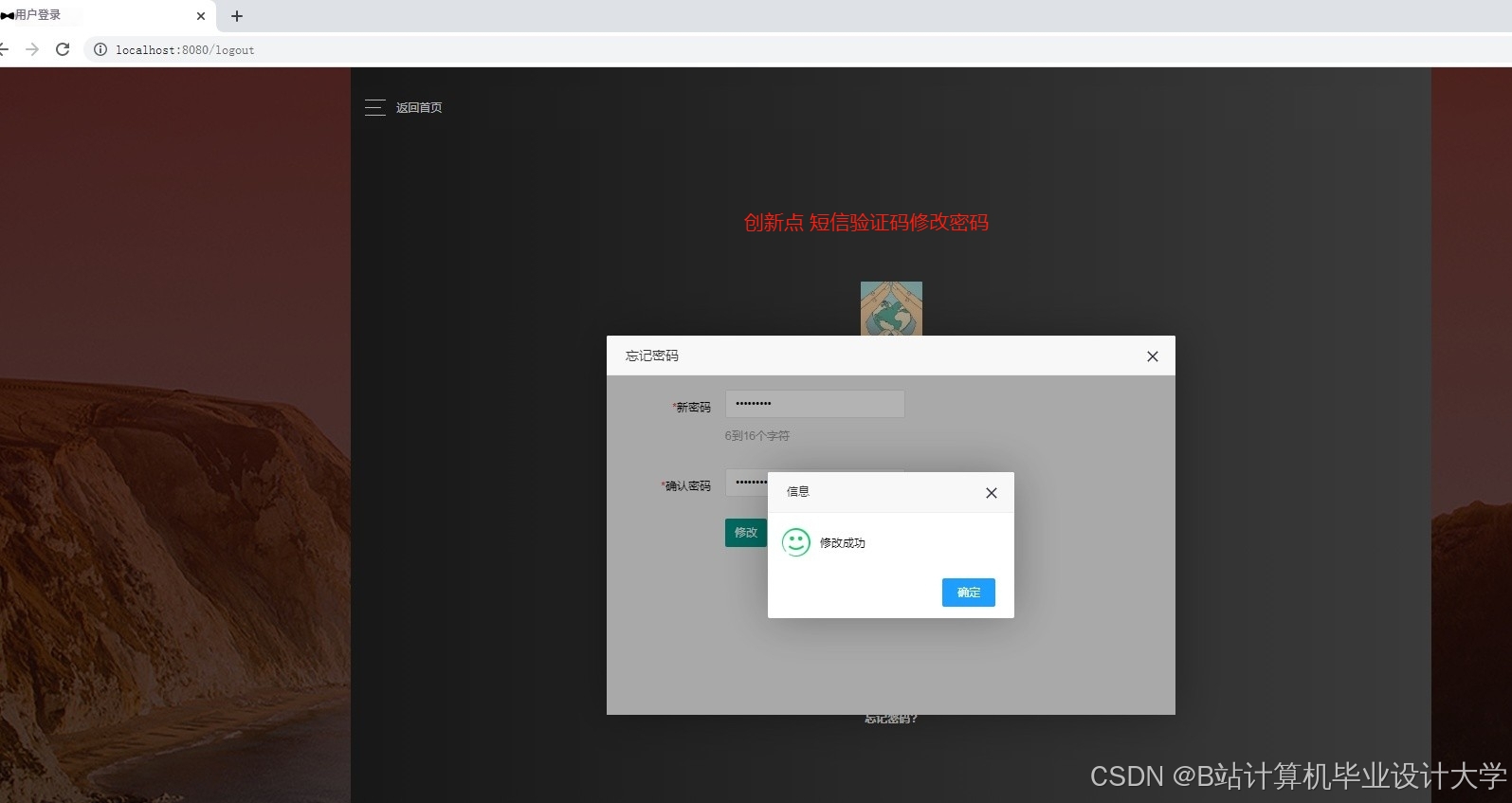

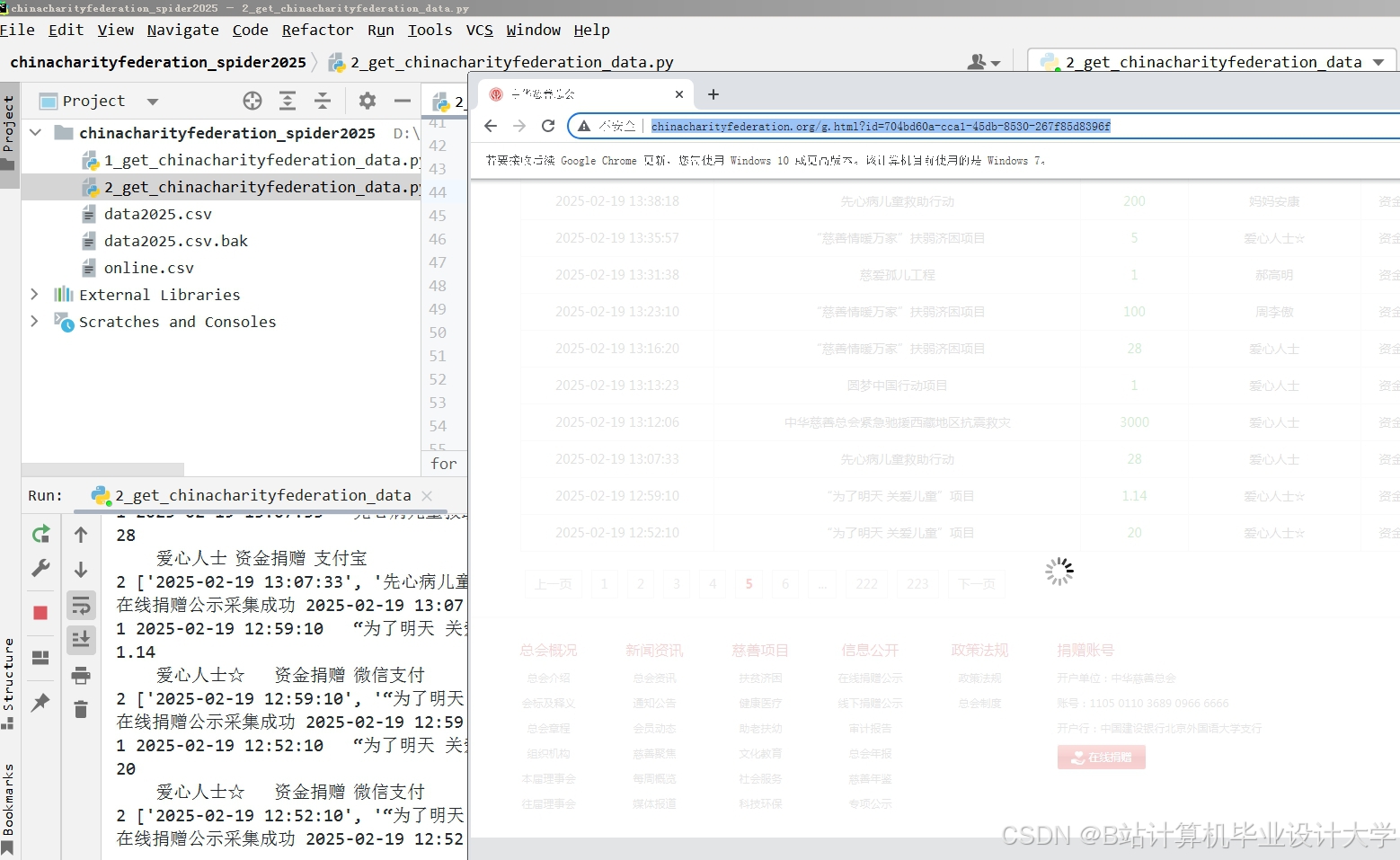

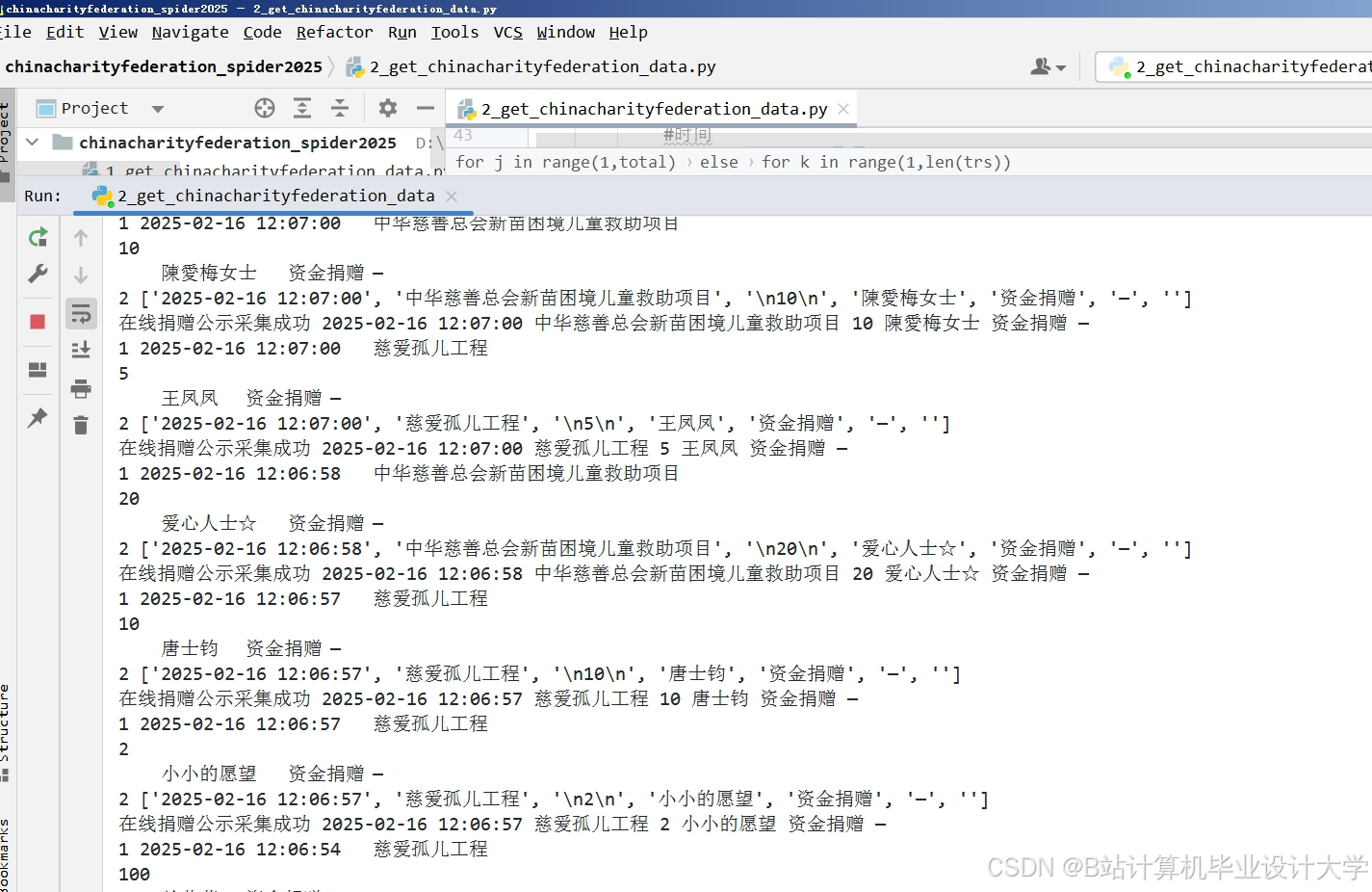

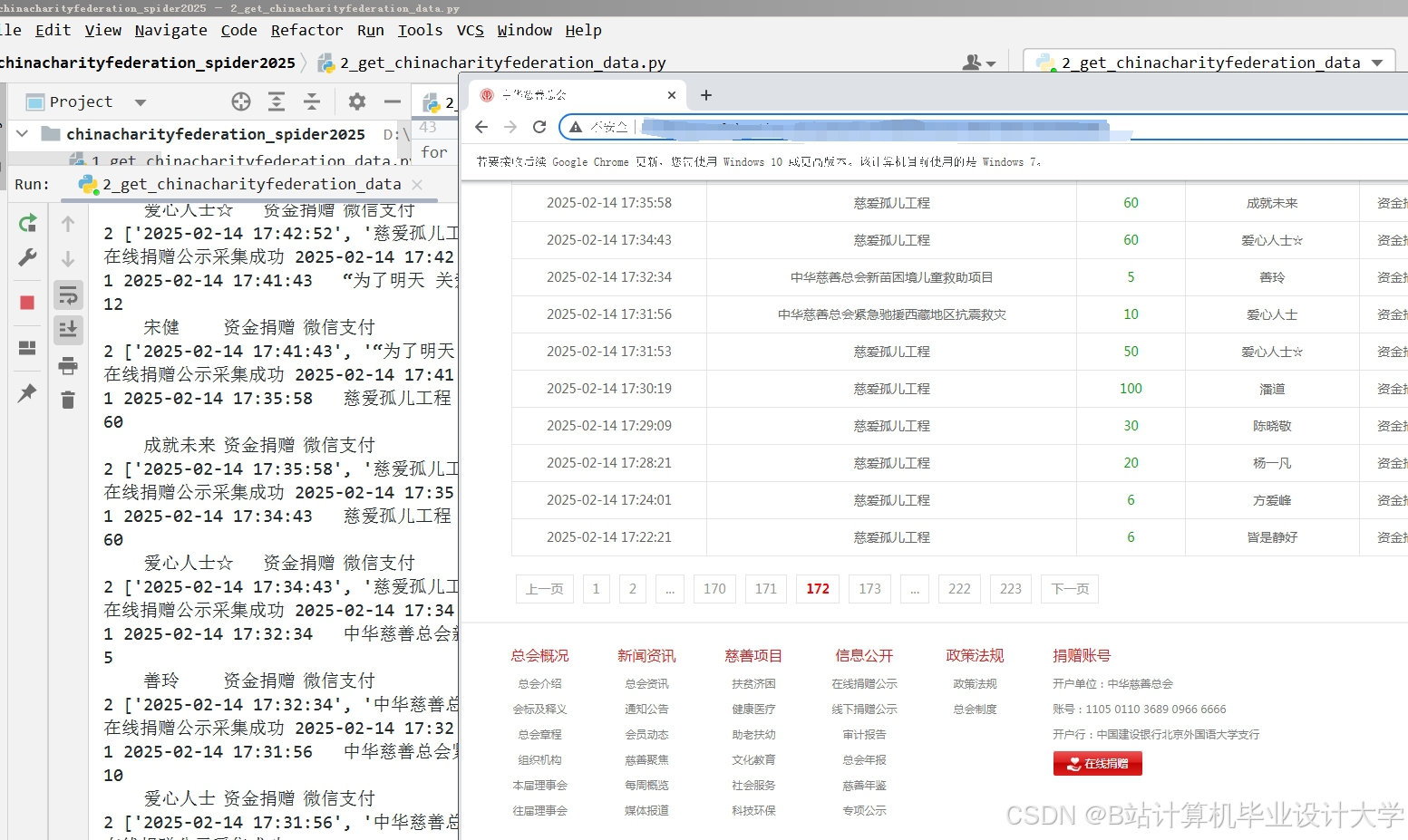

运行截图

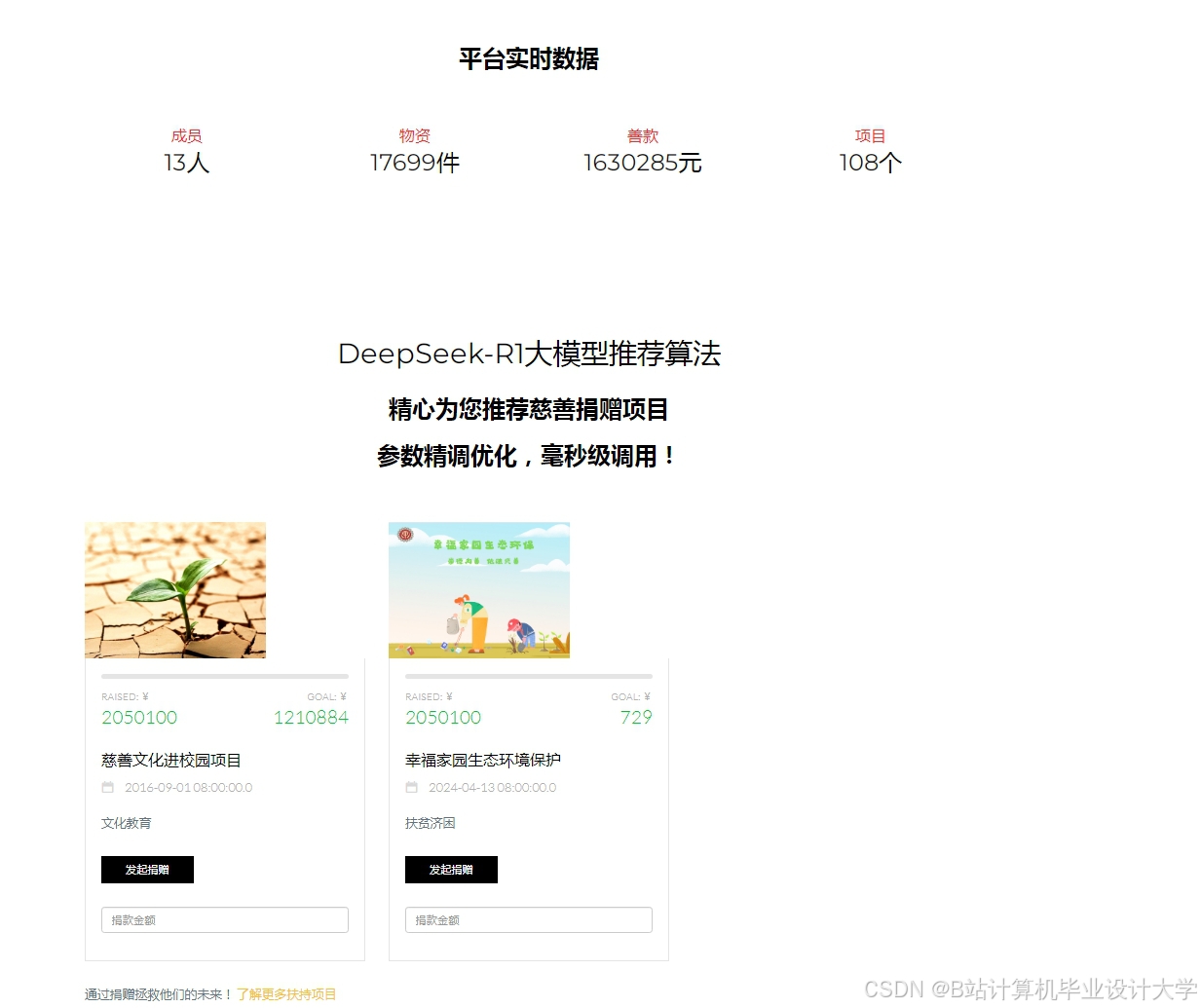

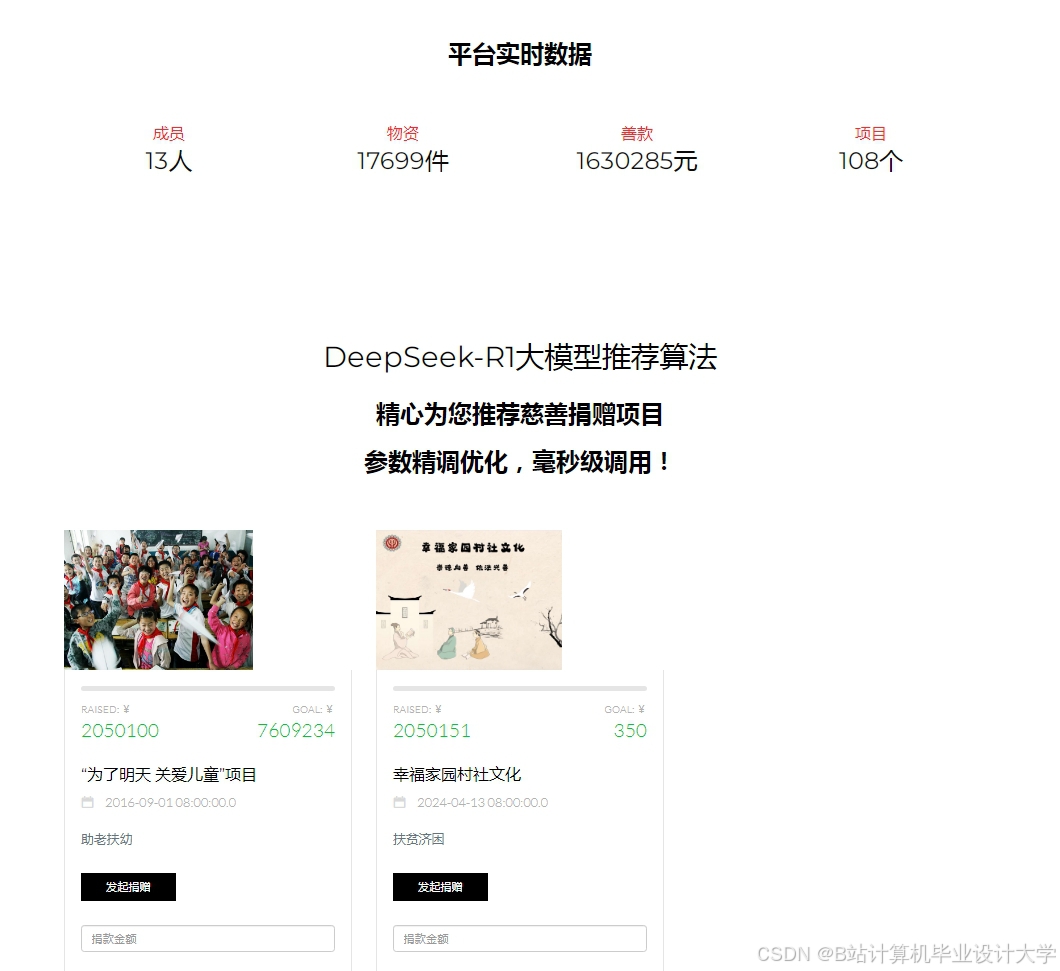

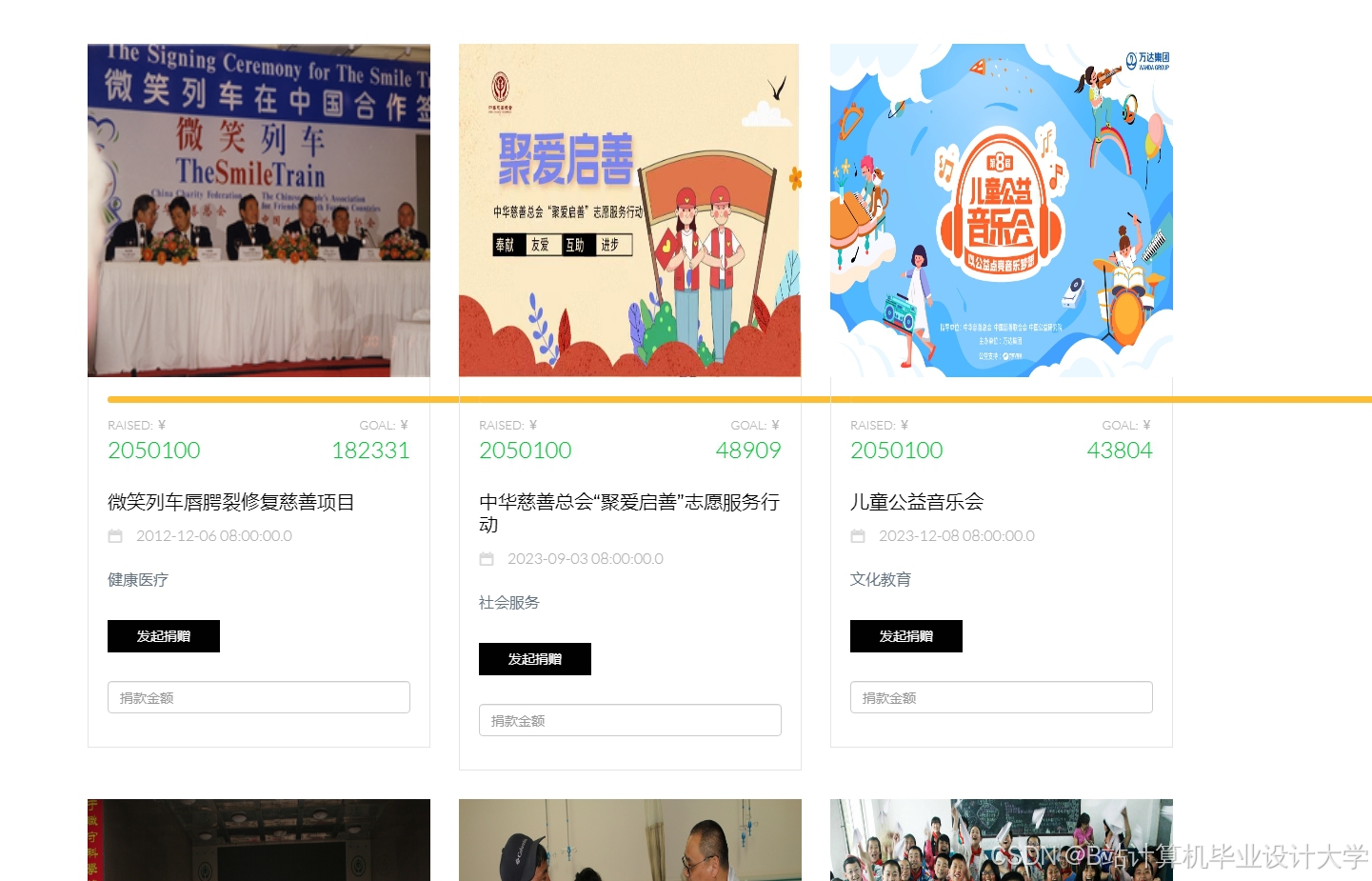

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?