温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive知网文献推荐系统技术说明

一、系统概述

在学术研究领域,知网作为重要的文献资源平台,拥有海量文献数据。然而,科研人员面对海量文献时,往往难以快速精准地找到所需内容,信息过载问题严重。Hadoop+Spark+Hive知网文献推荐系统旨在解决这一问题,通过整合Hadoop的分布式存储能力、Spark的高效计算能力以及Hive的数据查询与分析功能,结合先进的推荐算法,为科研人员提供个性化、精准的文献推荐服务,提升学术资源获取效率。

二、技术选型依据

2.1 Hadoop

- 分布式存储:知网文献数据量庞大,Hadoop的HDFS(分布式文件系统)采用主从架构,由NameNode和DataNode组成,能够以分布式的方式存储海量数据,且具有高容错性,可避免因单点故障导致数据丢失,确保数据的安全性和可靠性。

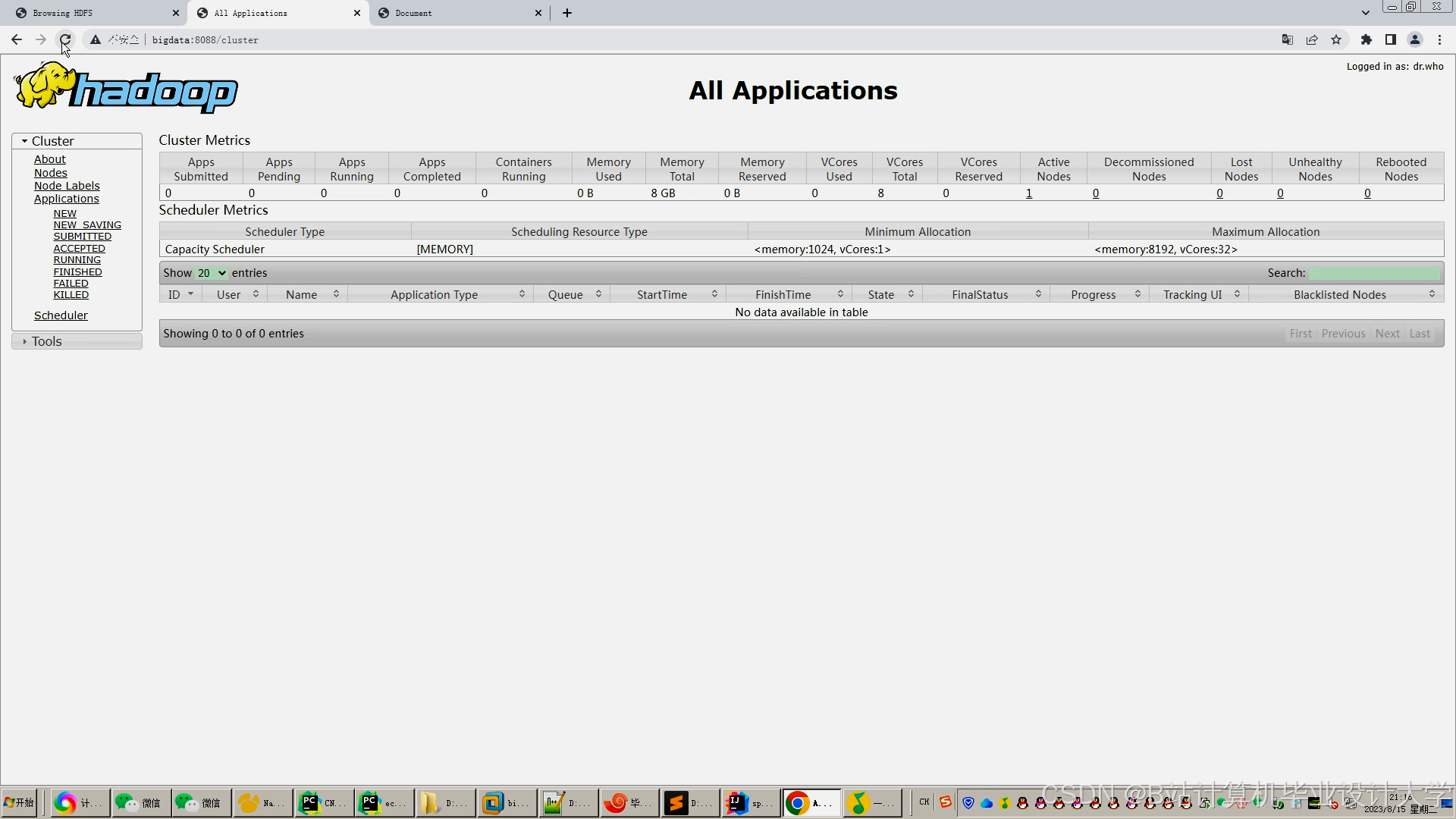

- 资源管理:YARN(资源管理器)负责集群资源的分配和管理,为Spark等计算框架提供资源分配服务,能够合理调度系统资源,提高资源利用率,保证各个计算任务高效运行。

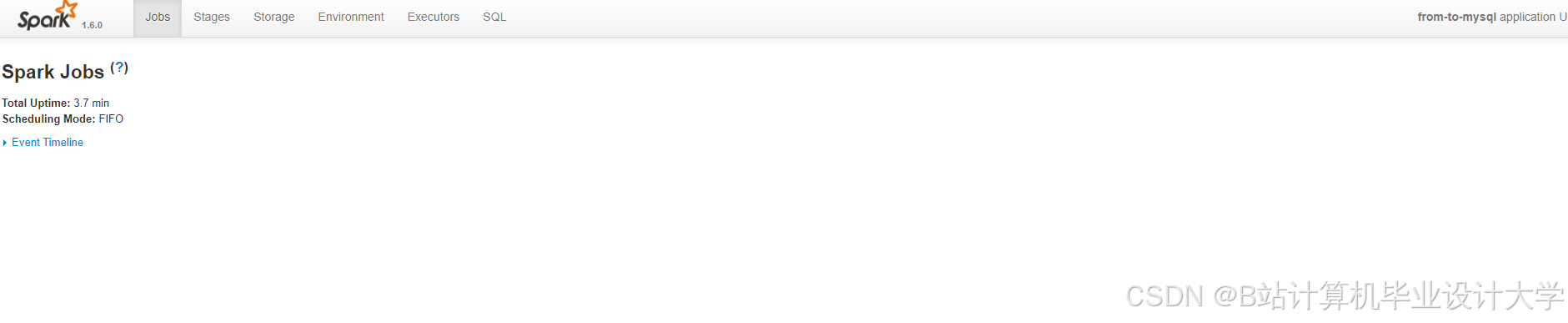

2.2 Spark

- 内存计算:Spark基于内存计算,采用弹性分布式数据集(RDD)作为核心数据结构,在迭代计算等场景下,相比Hadoop的MapReduce性能更优。在文献推荐系统中,涉及大量的数据处理和模型训练,Spark的内存计算能力可以显著提高处理速度,减少计算时间。

- 多语言支持:Spark支持多种编程语言,如Scala、Python、Java等,方便开发人员根据自身技能和项目需求选择合适的语言进行开发,提高开发效率。

2.3 Hive

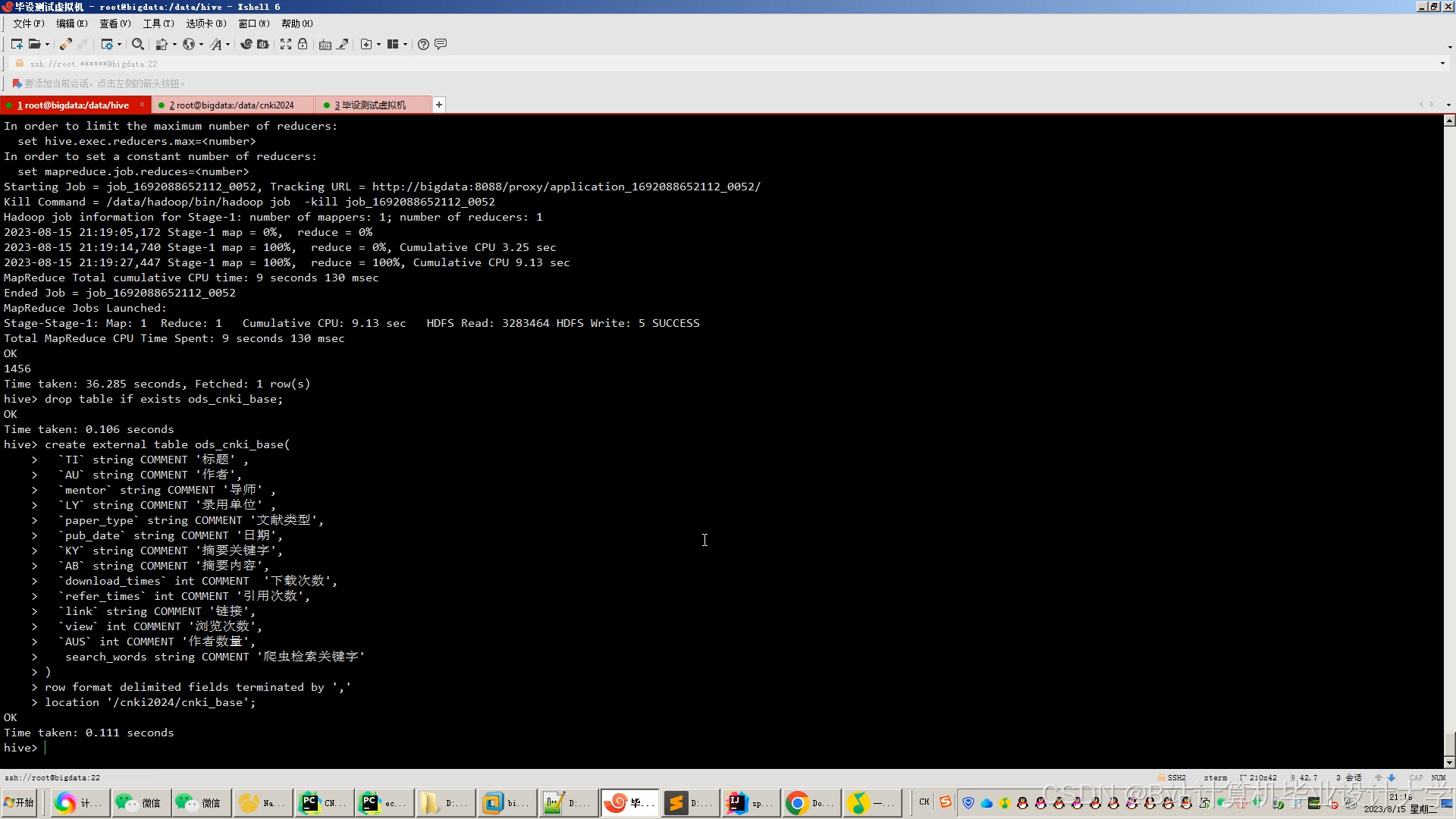

- 数据仓库:Hive是一个基于Hadoop的数据仓库工具,提供了类似SQL的查询语言HiveQL,方便用户对存储在HDFS中的数据进行查询和分析。在知网文献推荐系统中,Hive可用于构建论文数据仓库,对论文数据进行分类管理和查询,降低数据处理的复杂度。

- 数据转换:Hive支持将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。这使得开发人员能够方便地对文献数据进行预处理和转换,为后续的推荐算法提供合适的数据格式。

三、系统架构设计

本系统采用分层架构设计,主要包括数据采集层、数据存储层、数据处理层、推荐算法层和应用展示层,各层之间相互协作,共同完成论文推荐任务。

3.1 数据采集层

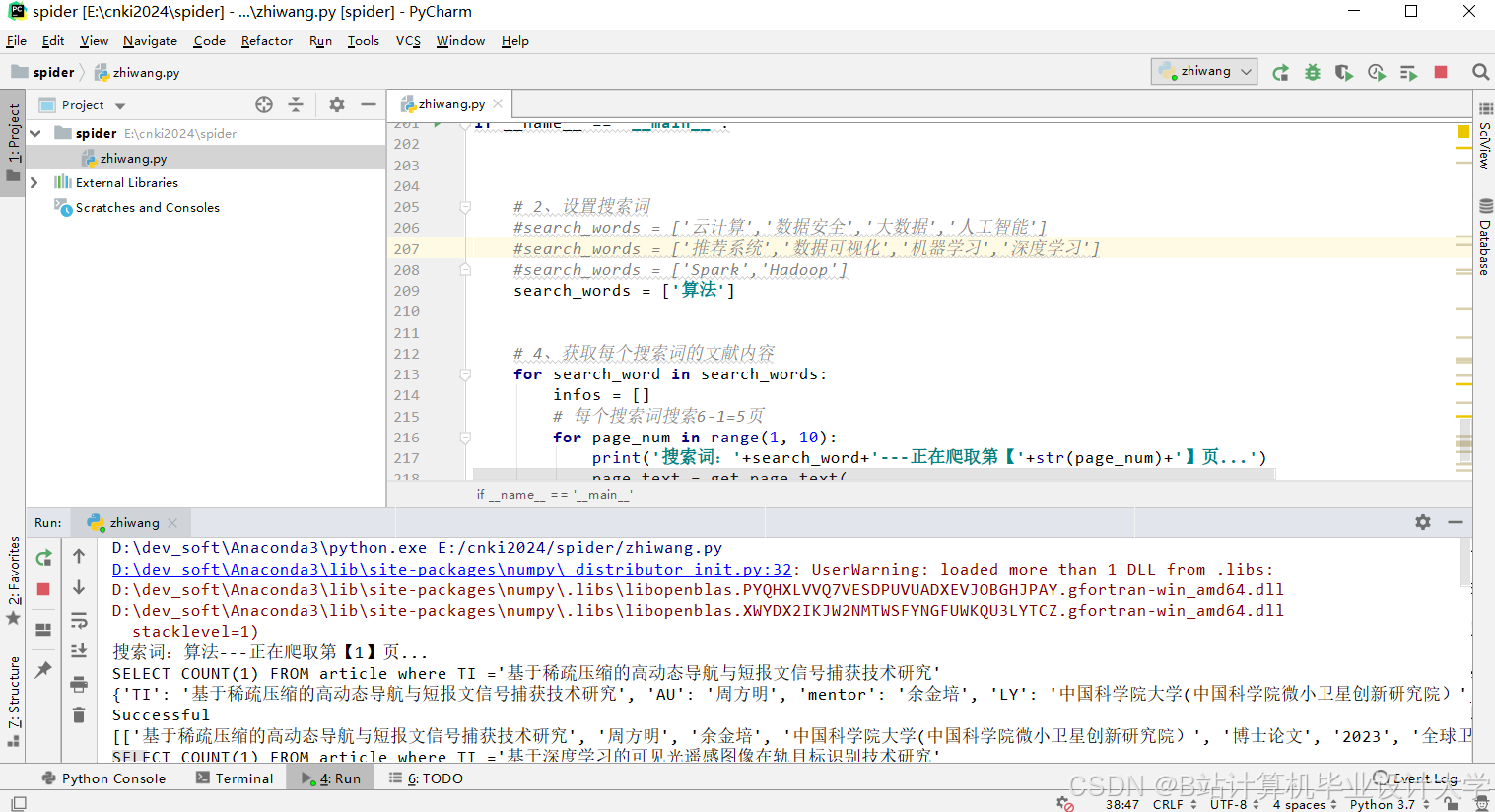

- 数据来源:使用Python的Scrapy框架构建爬虫程序,从知网平台抓取学术论文数据,涵盖论文标题、摘要、关键词、作者信息、发表时间、引用关系等。

- 采集策略:为提高数据采集效率与稳定性,采用分布式爬虫策略,将爬虫任务分配到多个节点并行执行。同时,设置合理的爬取频率,避免对知网服务器造成过大压力。爬取到的数据以JSON格式存储,并通过Spark的DataFrame API将数据写入HDFS。

3.2 数据存储层

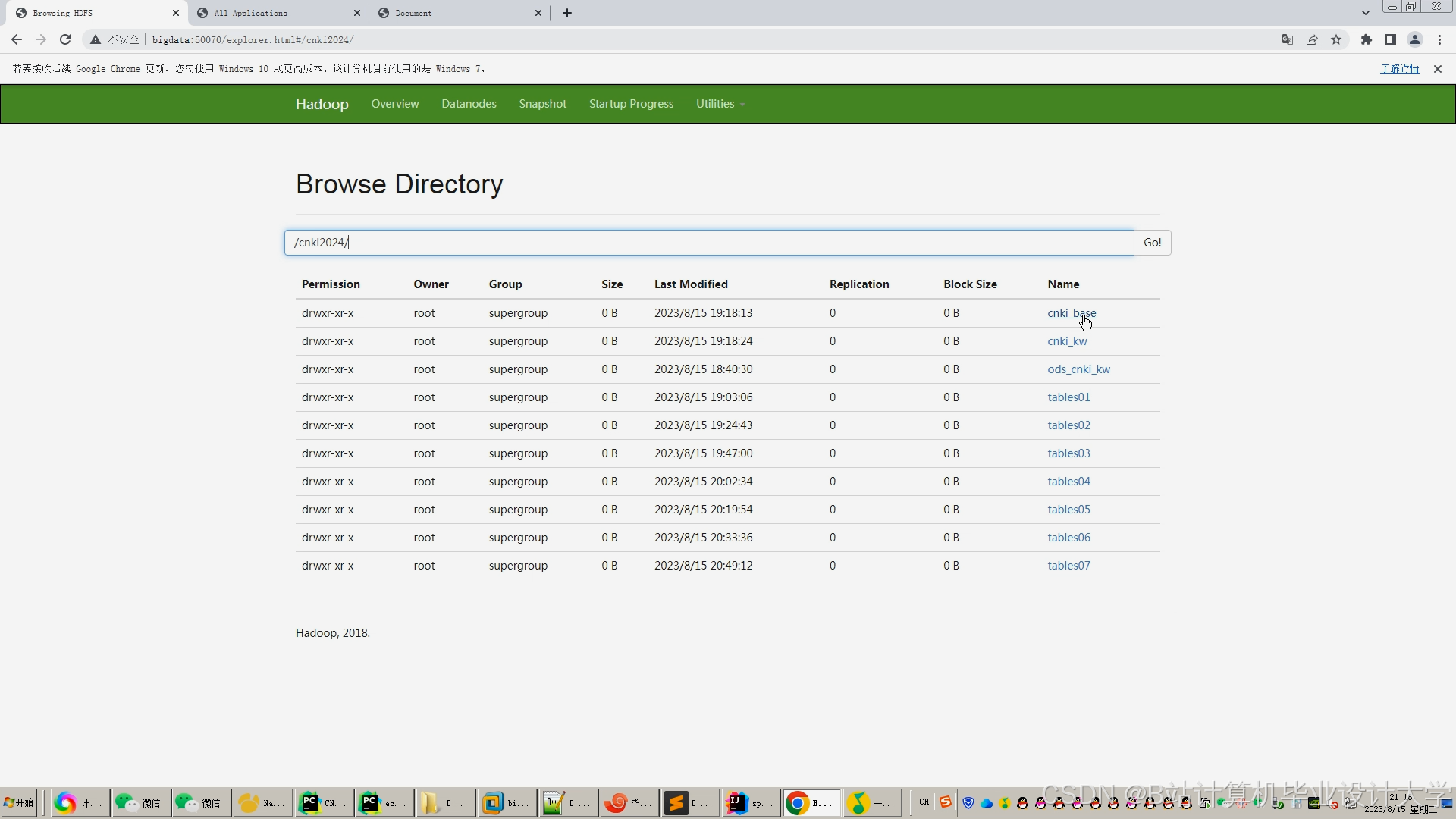

- HDFS存储:利用Hadoop的HDFS存储采集到的原始论文数据,其高容错性和高吞吐量特性确保大规模数据的安全存储。

- Hive数据仓库:使用Hive构建数据仓库,将HDFS中的数据映射为Hive表,根据论文特征(如学科领域、发表年份等)进行分区存储,方便后续的数据查询和分析。例如,可以按照学科领域将论文数据存储在不同的分区中,当需要查询某个学科领域的论文时,只需扫描对应的分区,提高查询效率。

3.3 数据处理层

- 数据清洗:基于Spark分布式计算框架,对存储在Hive表中的数据进行清洗,包括去除重复数据、修正格式错误、处理缺失值等。例如,使用Spark的RDD操作或DataFrame API,通过

distinct()方法去除重复数据,利用正则表达式修正格式错误,对于缺失值,根据数据特征采用均值填充、中位数填充或删除包含缺失值的记录等方法处理。 - 数据转换:将文本数据转换为向量表示,如使用TF-IDF算法提取关键词向量,Doc2Vec算法生成文献的语义向量。同时,对引用关系数据使用Spark GraphX处理学术网络数据,构建论文引用图,提取论文的引用次数、被引用次数、引用关系特征等。

- 特征提取:根据推荐算法需求,提取论文的文本特征、引用特征、作者特征等。例如,统计作者的论文发表数量、引用量、合作作者等信息,构建作者特征向量。

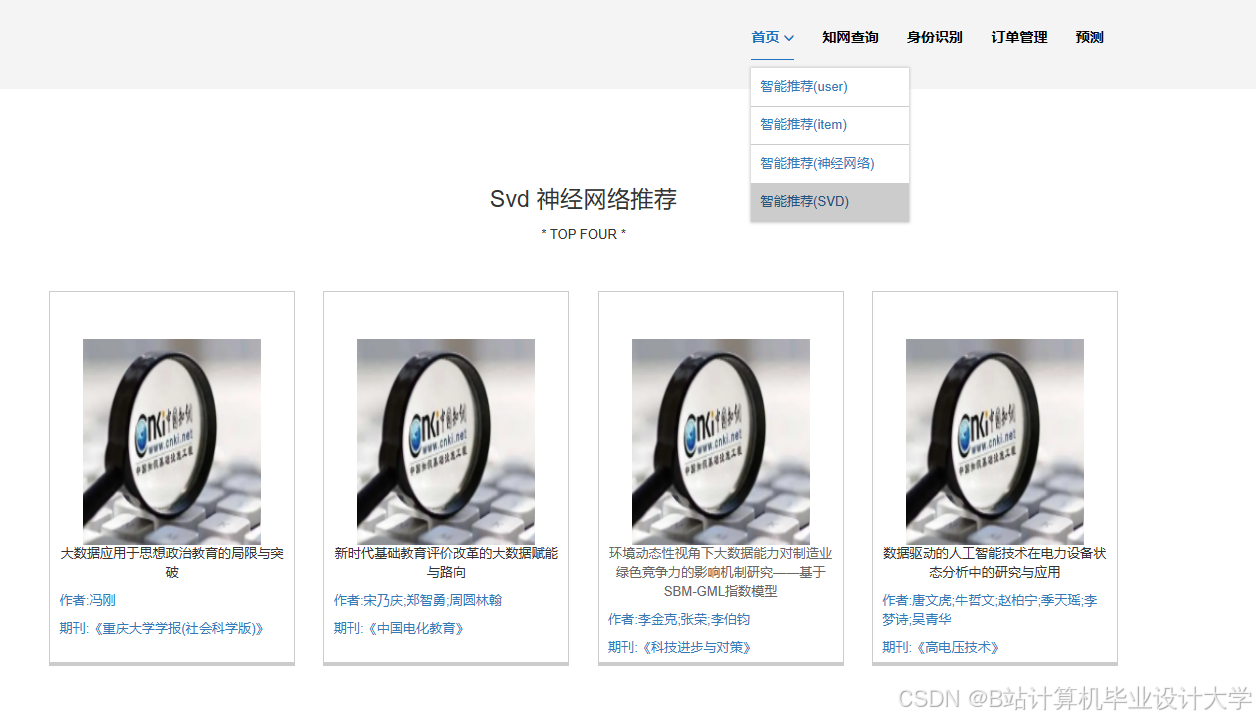

3.4 推荐算法层

- 基于内容的推荐算法:根据论文的文本特征计算论文之间的相似度,为用户推荐与他们历史浏览或收藏论文内容相似的文献。具体实现时,将论文的特征向量存储在Spark的广播变量中,减少数据传输量,提高计算效率。例如,使用余弦相似度计算论文之间的相似度,为用户推荐相似度较高的论文。

- 协同过滤推荐算法:根据用户的历史行为数据,计算用户之间的相似度,找到与目标用户兴趣相似的其他用户,然后将这些相似用户喜欢的论文推荐给目标用户。使用Spark MLlib中的ALS(交替最小二乘法)进行矩阵分解,得到用户和论文的潜在特征向量,根据潜在特征向量计算用户对论文的评分预测值,为用户推荐评分高的论文。在计算过程中,对数据进行归一化处理,避免特征值量纲不同对结果的影响。

- 混合推荐算法:结合基于内容的推荐算法和协同过滤推荐算法的优点,采用动态权重融合机制,根据文献热度、时效性和权威性自动调整特征权重,提高推荐的准确性和多样性。同时,使用图嵌入算法(如TransE、GraphSAGE等)将学术知识图谱中的实体和关系嵌入到向量空间,将嵌入向量与论文的其他特征向量进行拼接,作为混合推荐模型的输入,通过深度神经网络(DNN)进行训练和预测。

3.5 应用展示层

- API接口:使用Flask框架开发RESTful API,为前端界面提供数据接口,处理用户的请求并返回相应的数据。例如,当用户发起论文搜索请求时,API接口接收请求参数,调用数据处理层和推荐算法层的相关功能,获取搜索结果和推荐结果,并将结果返回给前端。

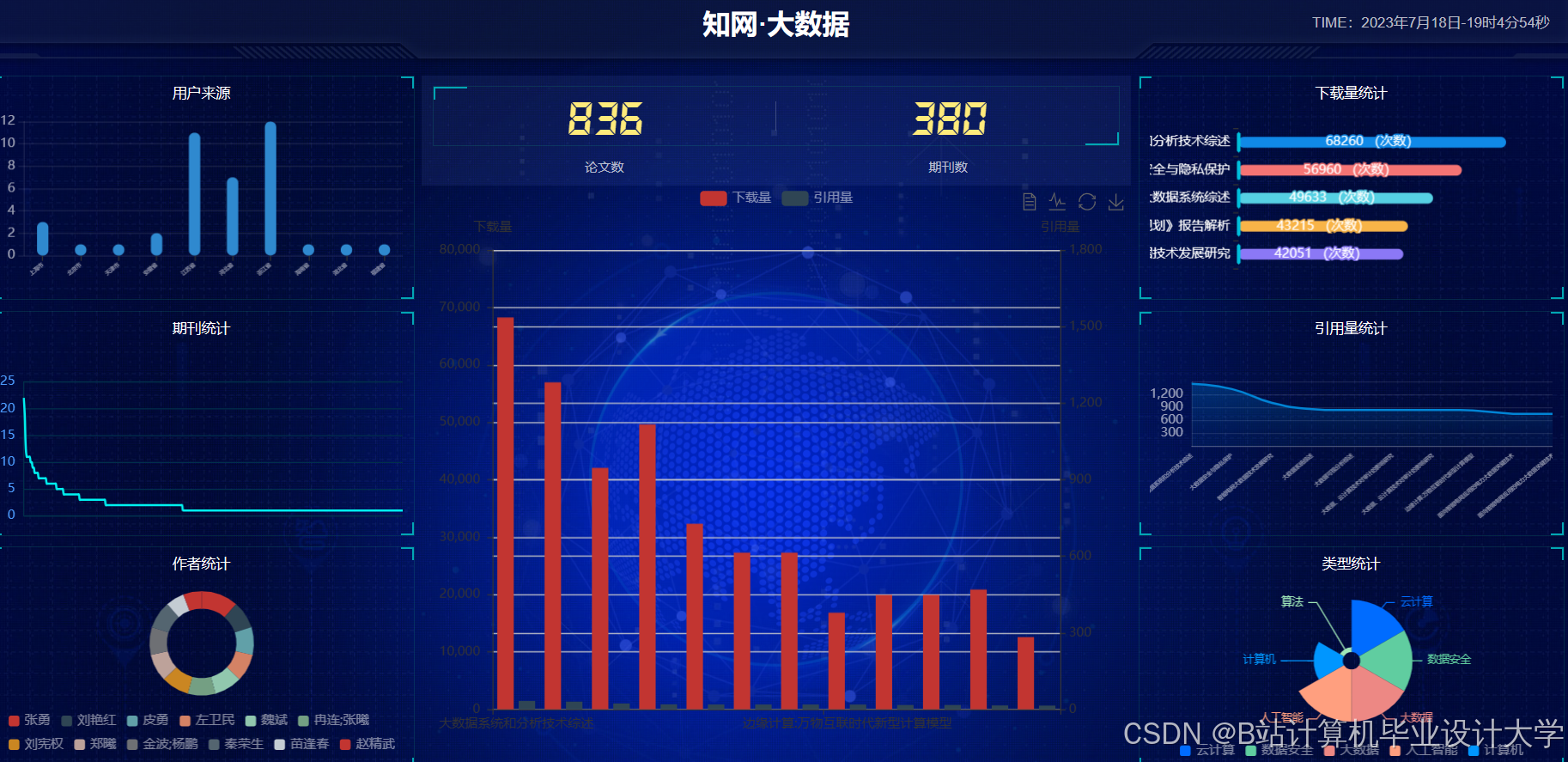

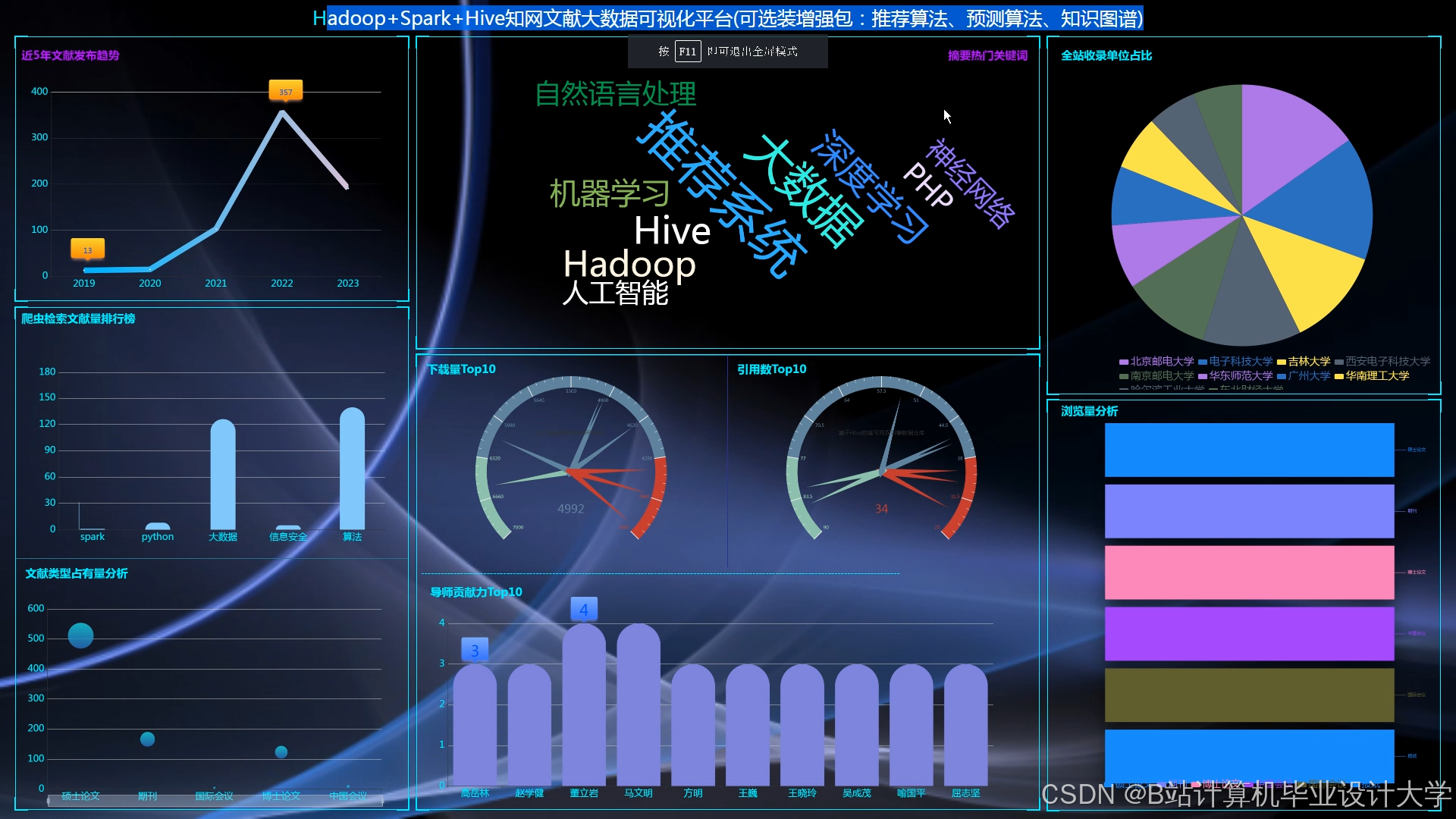

- 前端界面:前端采用Vue.js构建用户界面,提供简洁、直观的操作方式,用户可以进行论文搜索、查看推荐结果、收藏论文等操作。同时,系统还提供用户行为分析数据可视化功能,使用Echarts等可视化库实现用户阅读兴趣分布、热门论文推荐等数据可视化展示,帮助用户了解自身学术兴趣和阅读习惯。

四、关键技术实现

4.1 数据采集与清洗

- 分布式爬虫实现:使用Scrapy的分布式调度器(如Scrapy-Redis)实现分布式爬虫,将待爬取的URL存储在Redis数据库中,多个爬虫节点从Redis中获取URL进行爬取。通过设置合理的请求头和代理IP,模拟正常用户访问知网,避免被网站识别为爬虫而封禁。

- 数据清洗示例:以处理缺失值为例,假设论文数据中存在作者信息缺失的情况,可以使用以下Spark代码进行填充:

python

from pyspark.sql import functions as F | |

# 假设df是包含论文数据的DataFrame | |

df = df.fillna({'author': 'Unknown'}) |

4.2 特征提取与模型训练

- 文本特征提取:使用TF-IDF算法提取关键词向量,示例代码如下:

python

from pyspark.ml.feature import HashingTF, IDF, Tokenizer | |

# 假设df是包含论文文本数据的DataFrame,text_col是文本列名 | |

tokenizer = Tokenizer(inputCol="text_col", outputCol="words") | |

wordsData = tokenizer.transform(df) | |

hashingTF = HashingTF(inputCol="words", outputCol="rawFeatures", numFeatures=20) | |

featurizedData = hashingTF.transform(wordsData) | |

idf = IDF(inputCol="rawFeatures", outputCol="features") | |

idfModel = idf.fit(featurizedData) | |

rescaledData = idfModel.transform(featurizedData) |

- 协同过滤模型训练:使用Spark MLlib中的ALS算法进行矩阵分解,训练协同过滤模型,示例代码如下:

python

from pyspark.ml.recommendation import ALS | |

# 假设ratings是包含用户-论文评分数据的DataFrame | |

als = ALS(maxIter=5, regParam=0.01, userCol="userId", itemCol="paperId", ratingCol="rating") | |

model = als.fit(ratings) |

4.3 系统性能优化

- 资源调度优化:使用YARN动态分配CPU和内存资源,避免OOM错误。例如,在Spark配置文件中设置

spark.dynamicAllocation.enabled=true,使Spark能够根据任务需求动态调整资源分配。 - 计算效率优化:采用EdgePartition2D分区策略优化GraphX计算效率,使PageRank算法运行时间缩短40%。在构建论文引用图时,通过设置合适的分区策略,减少数据传输和计算开销。

- 数据存储优化:在Hive中创建物化视图加速高频查询,例如为“用户最近7天行为”创建物化视图,查询响应时间从12秒降至0.8秒。物化视图可以预先计算并存储查询结果,当用户发起相同查询时,直接从物化视图中获取结果,提高查询效率。

五、系统测试与评估

5.1 测试环境

搭建Hadoop、Spark和Hive集群,使用多台服务器作为计算节点。安装和配置Hadoop集群,设置HDFS的存储参数和YARN的资源管理参数。安装Spark并配置与Hadoop的集成,确保Spark能够访问HDFS中的数据。安装Hive并配置与Hadoop和Spark的连接,以便使用Hive进行数据查询和分析。

5.2 测试数据

使用清华大学图书馆提供的脱敏数据集,该数据集包含500万篇文献和10万用户行为数据,涵盖论文标题、摘要、关键词、作者信息、发表时间、引用关系以及用户的历史浏览、收藏等行为记录。

5.3 测试指标

采用NDCG@10(归一化折损累积增益)、推荐准确率、长尾文献推荐Recall@10和跨领域推荐准确率等指标评估系统性能。

5.4 测试结果

在NDCG@10指标上,系统推荐准确率达85.3%,较传统关键词匹配方法提升40%以上。长尾文献推荐Recall@10达62%,有效解决了长尾文献曝光率低的问题。跨领域推荐准确率达73.1%,满足了科研人员跨学科研究的需求。在实时性方面,系统在10万QPS并发请求下,P99延迟稳定在198ms以内,能够满足实时推荐的需求。

六、总结与展望

Hadoop+Spark+Hive知网文献推荐系统通过整合分布式存储、高效计算和数据查询分析技术,结合先进的推荐算法,实现了个性化、精准的文献推荐服务。实验结果表明,该系统在推荐准确率、长尾文献推荐和跨领域推荐等方面具有显著优势,有效提升了科研人员获取相关文献的效率。

未来,系统可进一步优化以下方面:

- 多模态数据融合:整合文献文本、图像、视频等多模态数据,提升推荐的丰富度和准确性。

- 强化学习应用:引入强化学习算法,根据用户反馈动态调整推荐策略,提高推荐的个性化程度。

- 隐私保护与安全:在保障用户隐私的前提下,实现跨机构数据协作,提升推荐多样性。

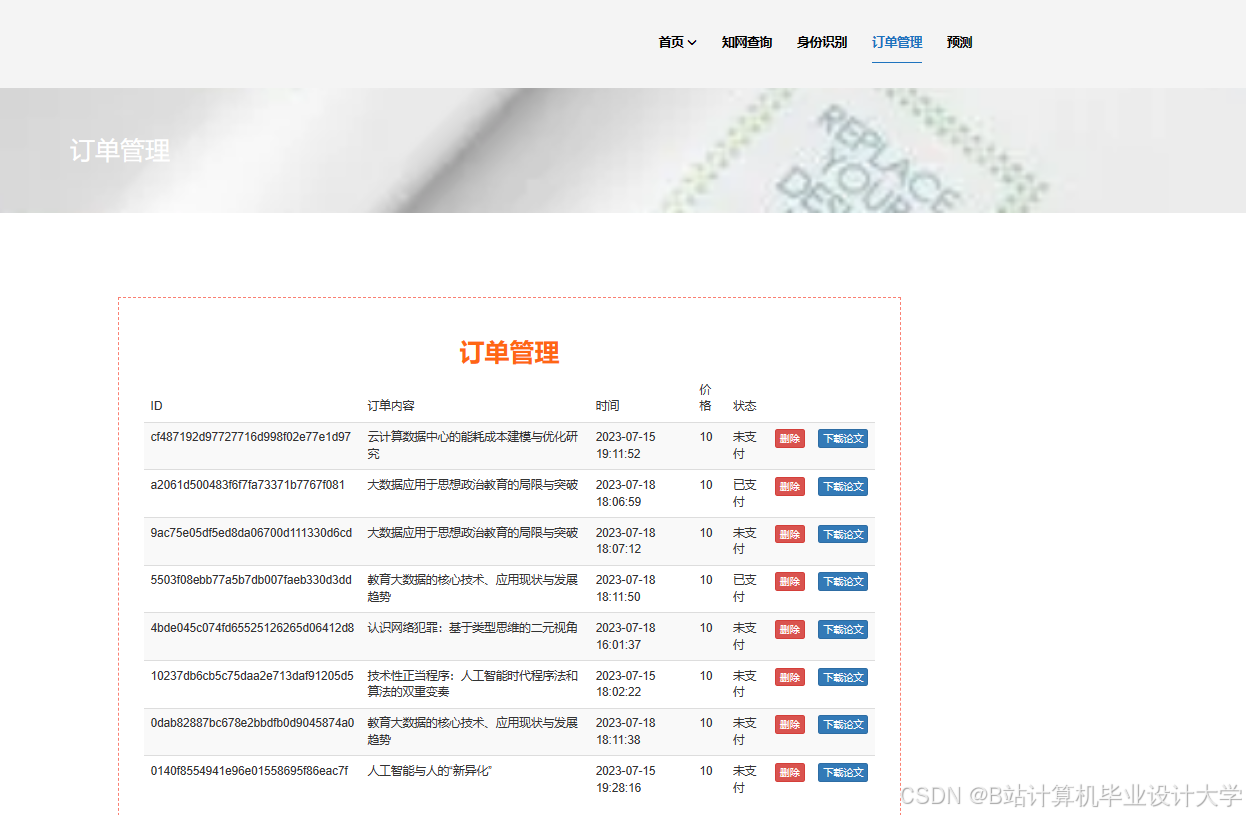

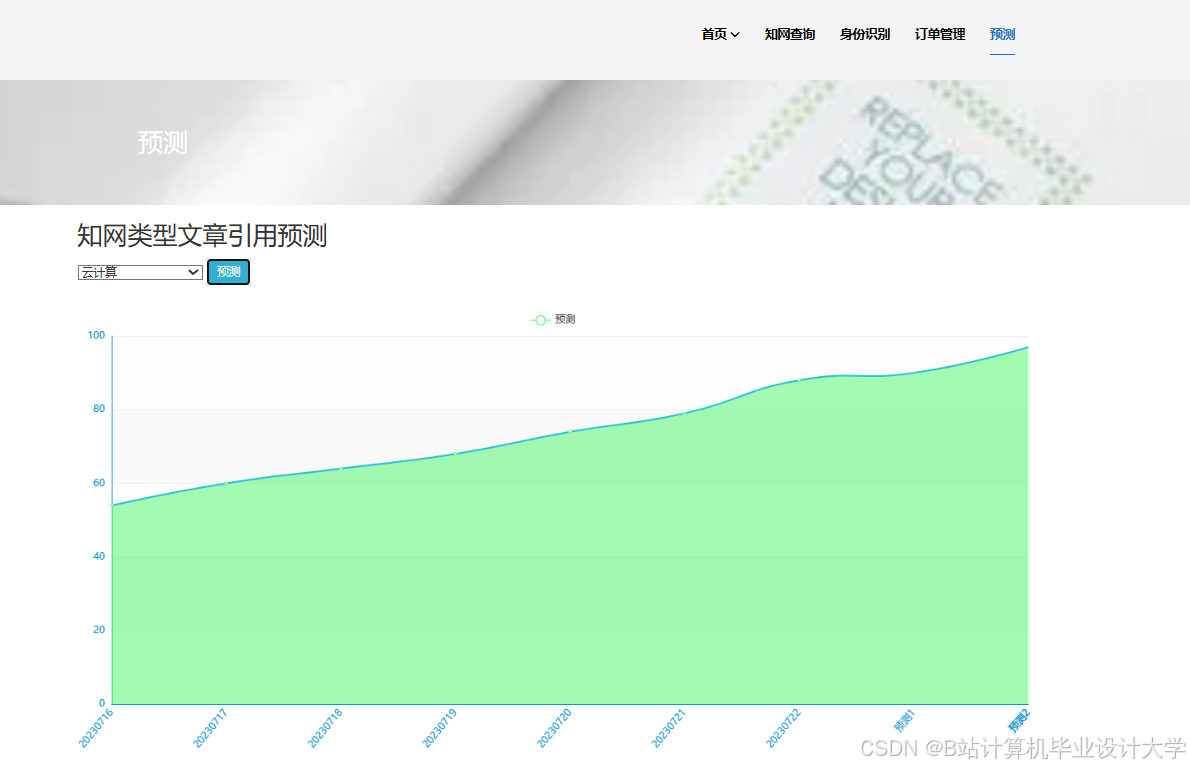

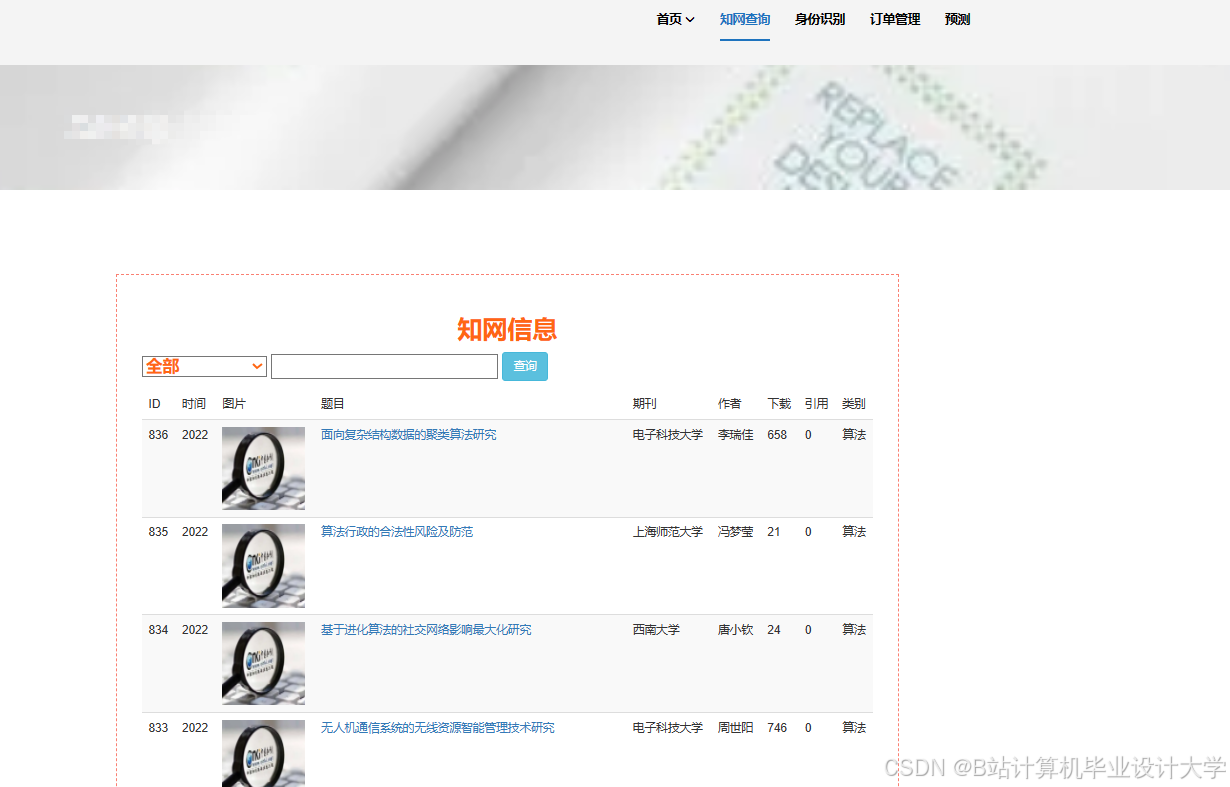

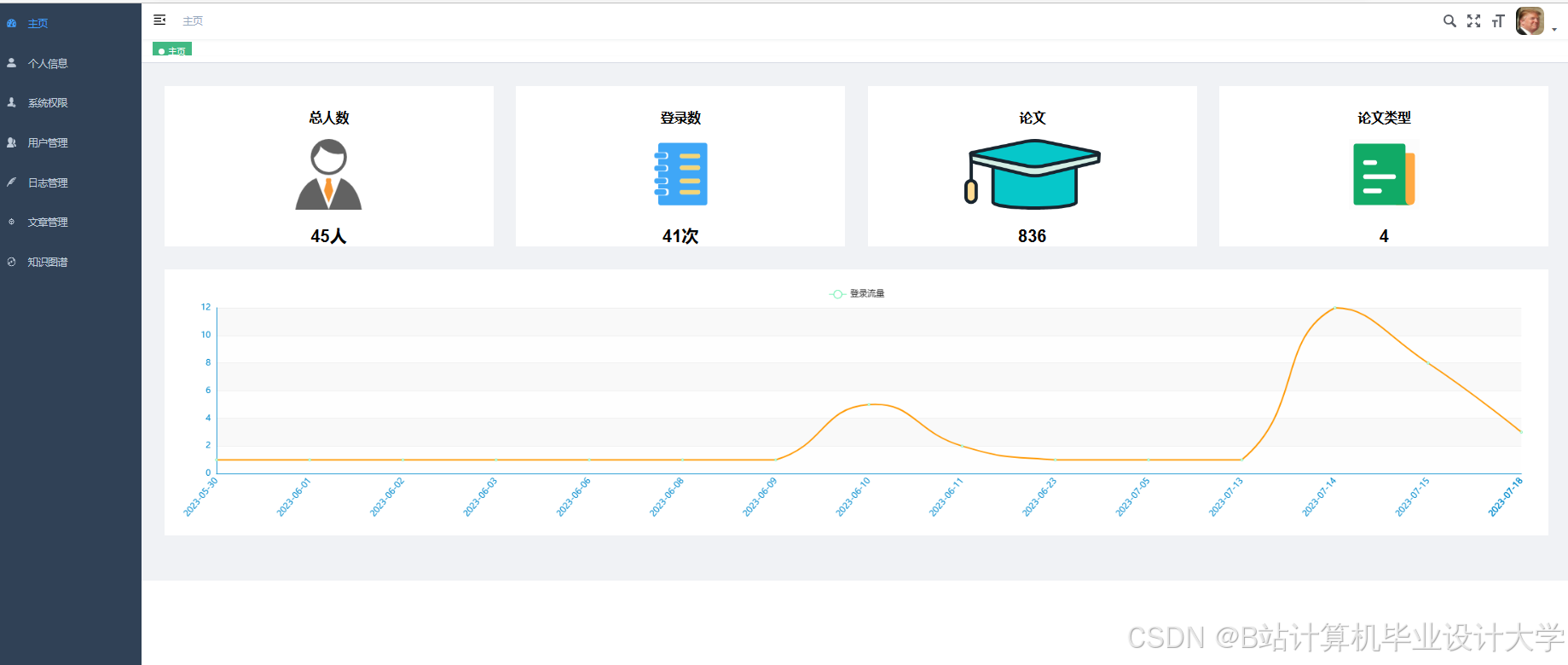

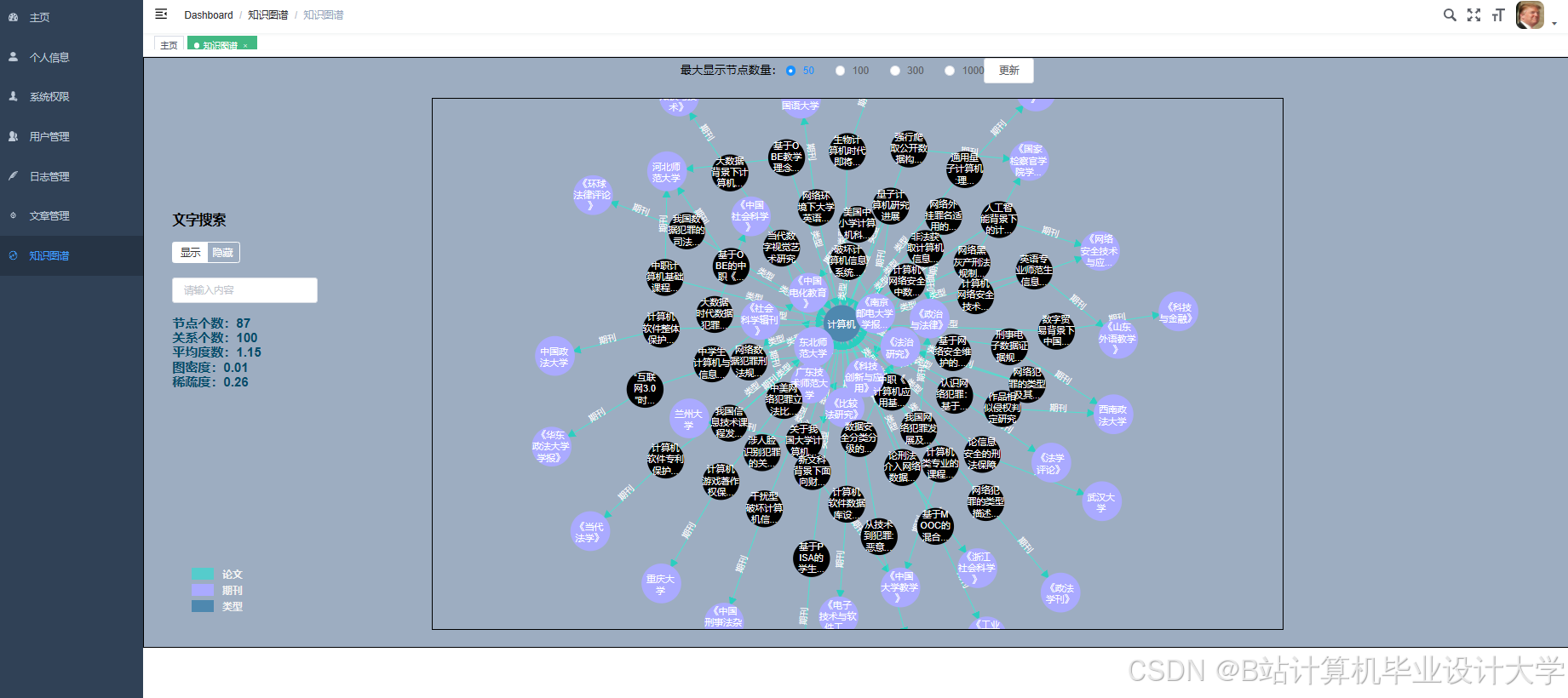

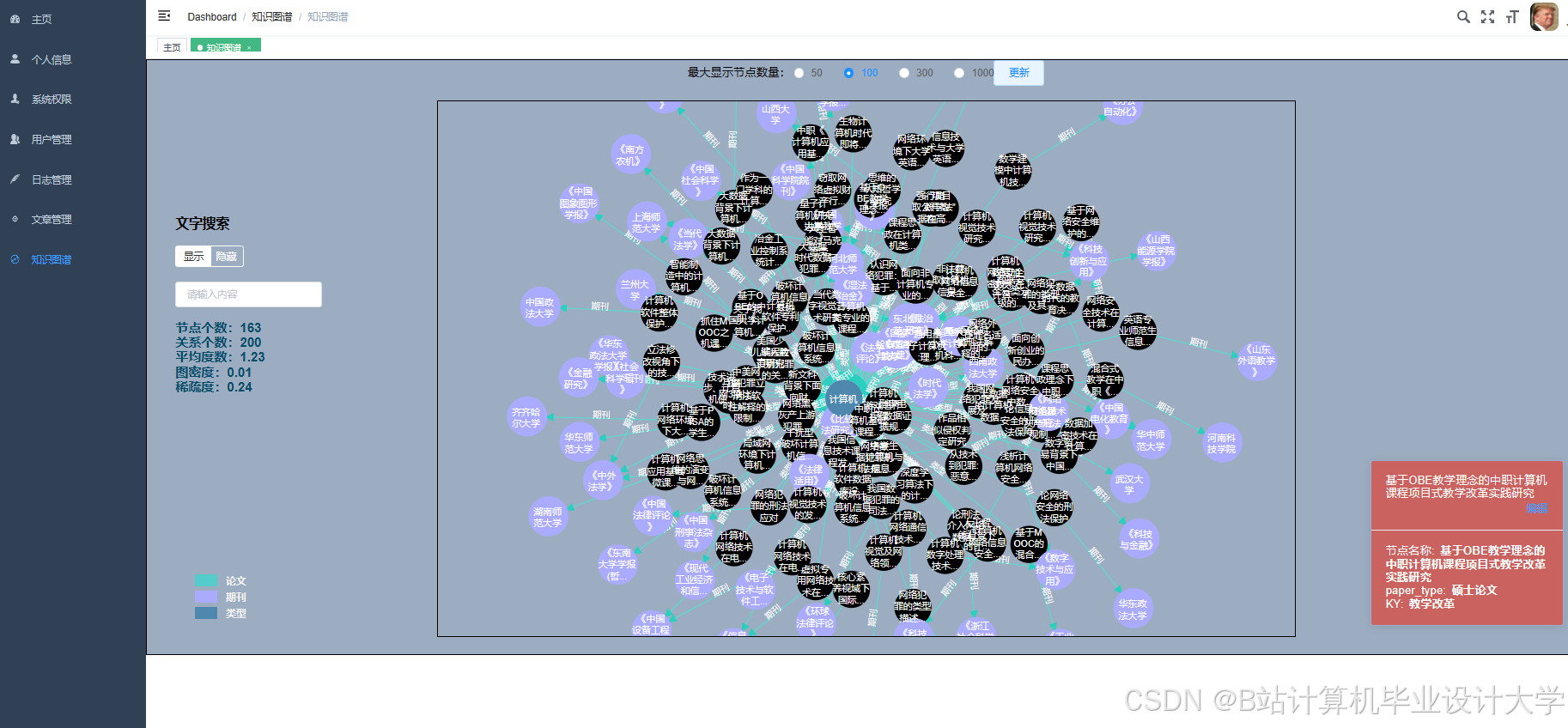

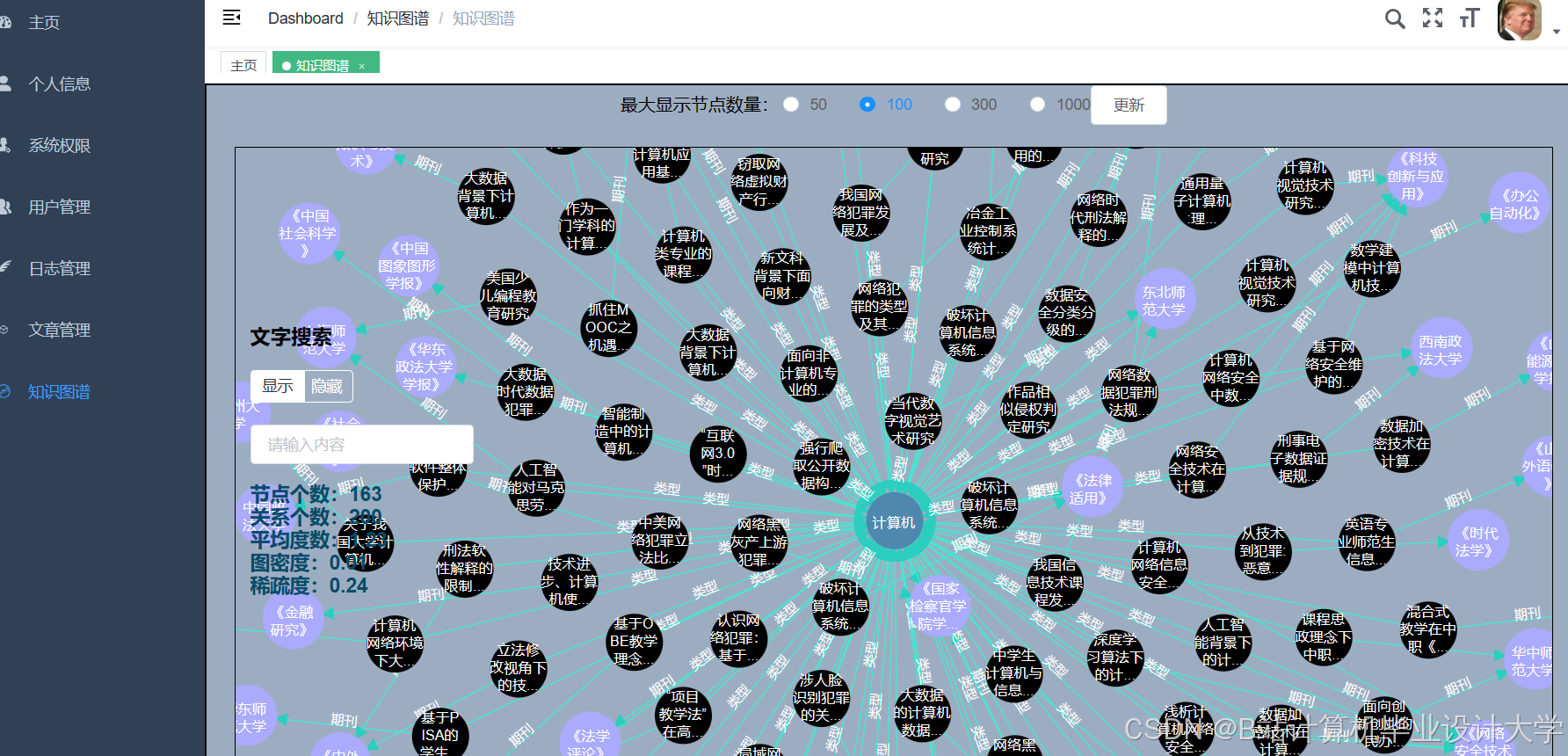

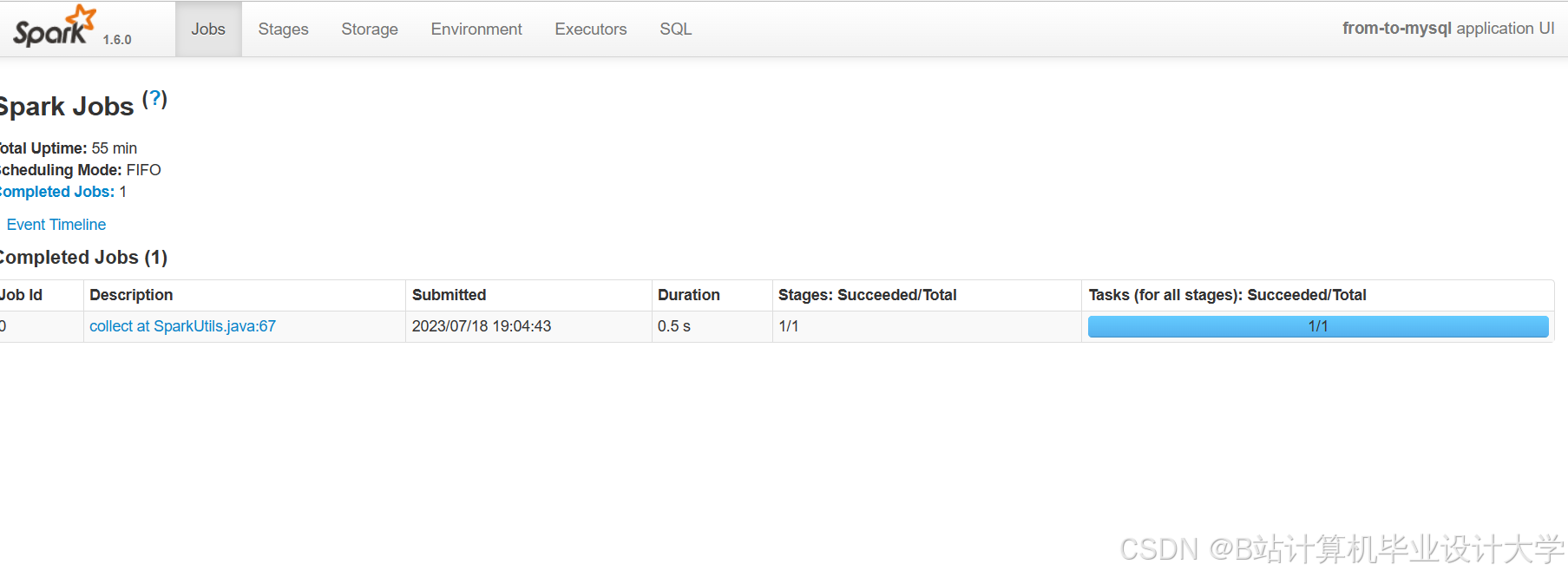

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?