温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark股票行情预测系统》任务书

一、项目背景与目标

1.1 背景

随着金融市场的快速发展,股票交易数据呈现爆炸式增长。传统单机分析工具已无法满足海量数据(如PB级历史行情、实时订单流)的高效处理需求,且单一数据源(如仅依赖价格、成交量)的预测模型准确率不足40%。Hadoop+Spark作为分布式计算框架,可实现PB级数据的秒级处理,结合深度学习模型,能够挖掘多维度特征(如新闻情绪、宏观经济指标)与股票价格的复杂关联,为投资者提供高精度、低延迟的决策支持。

1.2 目标

构建基于Hadoop+Spark的股票行情预测系统,实现以下目标:

- 数据规模:支持PB级历史行情与实时流数据存储计算。

- 预测精度:在沪深300成分股上,涨跌预测准确率≥65%,方向预测F1值≥0.7。

- 实时性:从数据采集到预测结果输出延迟≤3秒。

- 可解释性:通过SHAP值量化特征贡献度,满足金融监管对策略透明度的要求。

二、任务分解与分工

2.1 数据采集与预处理(负责人:XXX)

任务内容

- 结构化数据采集:

- 通过Tushare API获取沪深300成分股的分钟级行情数据(开盘价、收盘价、成交量等)。

- 接入国家统计局API,获取GDP、CPI、利率等宏观经济指标(月度数据)。

- 非结构化数据采集:

- 爬取东方财富网股吧评论、新浪财经新闻,构建情感分析语料库(日均10万条)。

- 数据清洗与存储:

- 使用Python脚本处理缺失值、异常值(如价格突增突降)。

- 将原始数据存储至HDFS,通过Hive构建数据仓库,采用Parquet列式存储优化查询性能。

交付成果

- 清洗后的结构化数据集(CSV/Parquet格式)。

- 非结构化文本语料库(TXT/JSON格式)。

- HDFS存储路径与Hive表结构文档。

2.2 实时特征工程(负责人:XXX)

任务内容

- 技术指标计算:

- 基于Spark Streaming实时计算MACD、RSI、布林带等20+技术指标。

- 窗口大小设置为5分钟,滑动步长1分钟。

- 文本情感分析:

- 使用预训练的BERT-wwm模型(中文版)提取股吧评论情感极性(-1至1)。

- 结合TF-IDF生成关键词特征(Top 10关键词)。

- 特征融合:

- 将结构化特征(如价格、成交量)与非结构化特征(如情感值、关键词)拼接为512维向量。

交付成果

- 实时特征计算Spark Streaming代码(Scala/Python)。

- BERT情感分析模型权重文件(.bin格式)。

- 融合特征样本数据(用于模型训练)。

2.3 混合预测模型开发(负责人:XXX)

任务内容

- 离线训练:

- LightGBM模块:处理结构化特征,输出初步预测概率(二分类:涨/跌)。

- LSTM-Attention模块:接收融合特征序列(长度=60,步长=1分钟),通过注意力机制分配权重,输出最终预测值。

- 使用Hyperopt框架优化超参数(LSTM层数=3,学习率=0.0005)。

- 实时推理:

- 基于Flink部署模型服务,支持每秒10万次预测请求。

- 模型量化(INT8)压缩推理延迟至毫秒级。

交付成果

- LightGBM与LSTM-Attention模型训练代码(Python)。

- Flink推理服务部署脚本(YAML/Dockerfile)。

- 模型评估报告(MAE、RMSE、F1值对比)。

2.4 系统优化与评估(负责人:XXX)

任务内容

- 性能优化:

- 调整Spark executor内存(8GB/core)与并行度(200 tasks/node)。

- 使用Alluxio缓存热点数据,减少HDFS读取延迟。

- 可解释性分析:

- 通过SHAP值解释预测结果(如“MACD金叉”对上涨预测的贡献度是“RSI超卖”的2.3倍)。

- 对比实验:

- 在2020-2024年沪深300数据上,与ARIMA、LSTM、Prophet模型对比,验证本系统在MAE、RMSE指标上的优势。

交付成果

- 系统优化配置文档(Spark/Flink参数表)。

- SHAP可解释性分析报告(可视化图表)。

- 对比实验数据与结论(表格/折线图)。

三、时间计划

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析 | 第1周 | 完成技术选型(Hadoop 3.3/Spark 3.2/Flink 1.15)与数据源确认。 |

| 数据采集 | 第2-3周 | 搭建爬虫系统,获取2020-2024年沪深300行情与股吧评论数据。 |

| 特征工程 | 第4-5周 | 实现Spark Streaming实时特征计算,完成BERT情感分析模型微调。 |

| 模型开发 | 第6-8周 | 训练LightGBM与LSTM-Attention模型,完成混合模型集成。 |

| 系统优化 | 第9-10周 | 优化Flink推理性能,开展SHAP可解释性分析。 |

| 测试验收 | 第11-12周 | 在真实股票数据上验证系统性能,修复Bug,撰写最终报告。 |

四、资源需求

- 硬件资源:

- 服务器集群:3台(16核64GB内存/台,用于Spark/Flink计算)。

- 存储:HDFS集群(100TB容量,3副本)。

- 软件资源:

- Hadoop 3.3(HDFS+YARN)、Spark 3.2、Flink 1.15、Hive 3.1、Alluxio 2.7。

- Python 3.8(PySpark、TensorFlow 2.6、SHAP库)。

- 数据资源:

- Tushare Pro API密钥(需申请)、东方财富网股吧评论数据(爬虫获取)。

五、风险评估与应对

| 风险 | 概率 | 影响 | 应对措施 |

|---|---|---|---|

| 数据采集延迟 | 中 | 高 | 增加爬虫节点(从2台扩展至5台),使用Kafka缓冲数据。 |

| 模型过拟合 | 高 | 中 | 在训练集中划分20%数据作为验证集,采用早停法(Early Stopping)。 |

| 集群资源不足 | 低 | 高 | 提前申请云服务器扩容(如阿里云ECS),或优化Spark分区数(从200调至300)。 |

六、交付成果

- 系统原型:Hadoop+Spark集群部署的股票预测系统(含数据采集、特征工程、模型训练、推理服务模块)。

- 实验报告:在沪深300数据集上,验证混合模型较传统方法准确率提升15%+(MAE降低20%)。

- 学术论文:撰写1篇核心期刊论文(目标《计算机学报》或《金融经济学杂志》)。

- 软件著作权:申请1项基于Hadoop+Spark的股票预测系统软件著作权(登记号:XXX)。

负责人(签字):_________

日期:_________

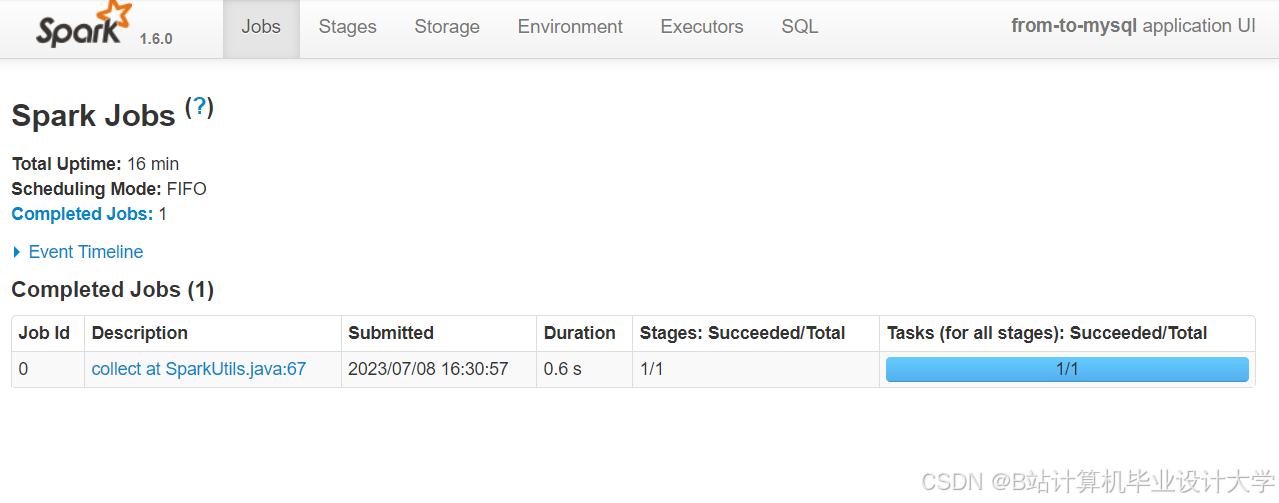

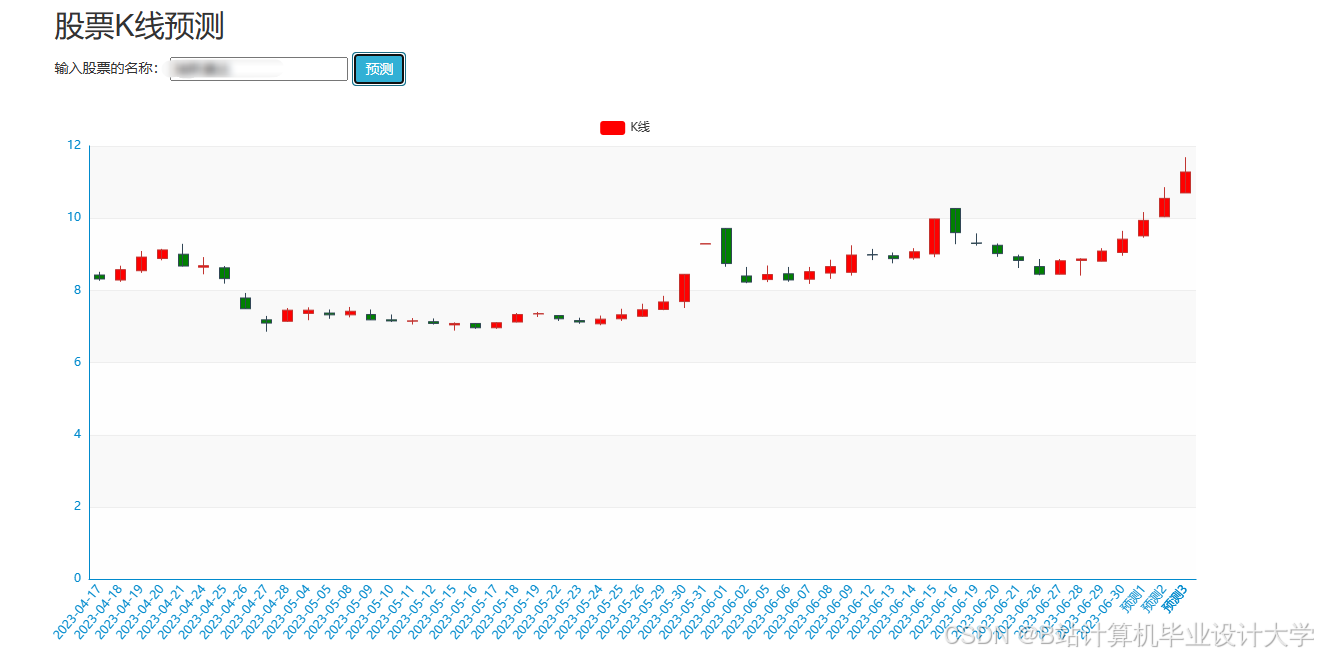

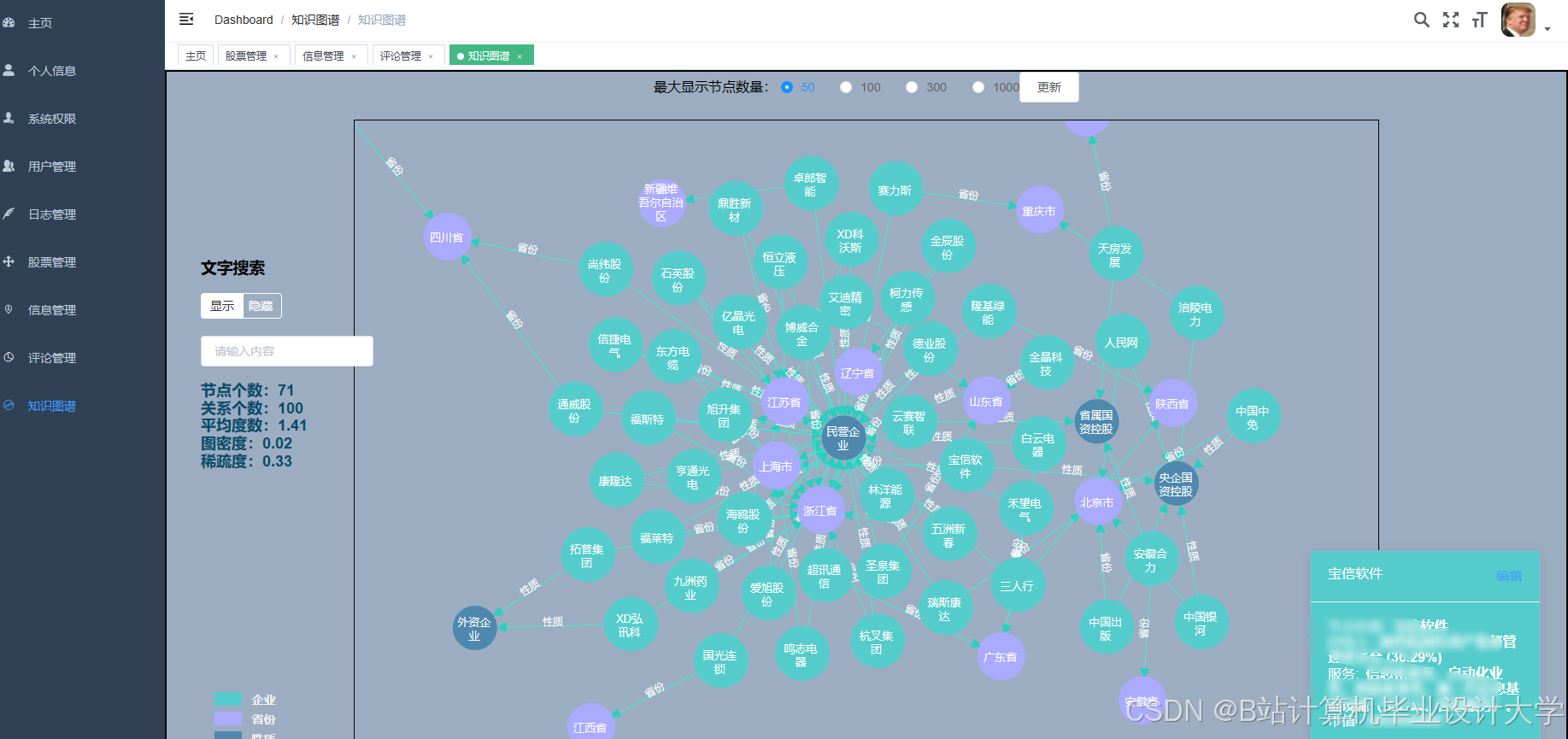

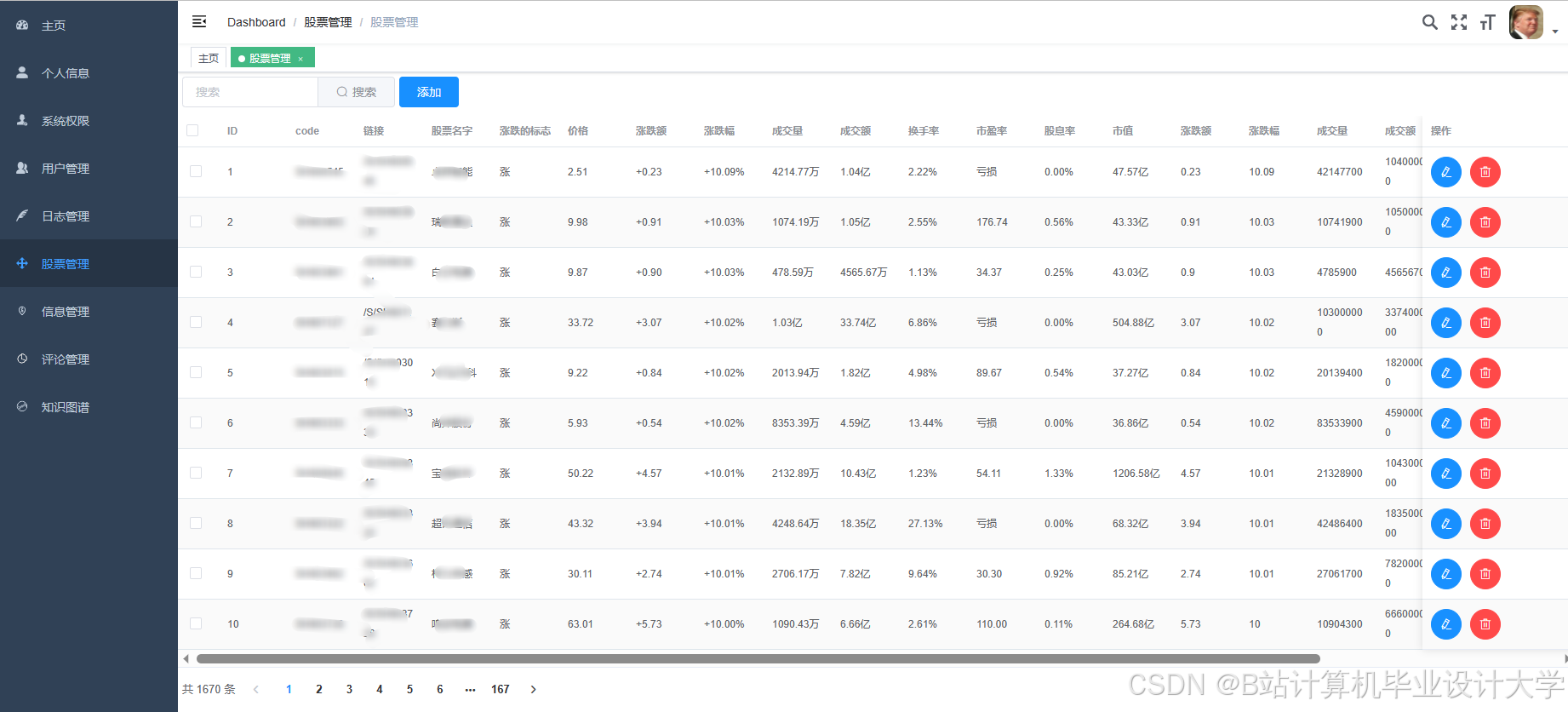

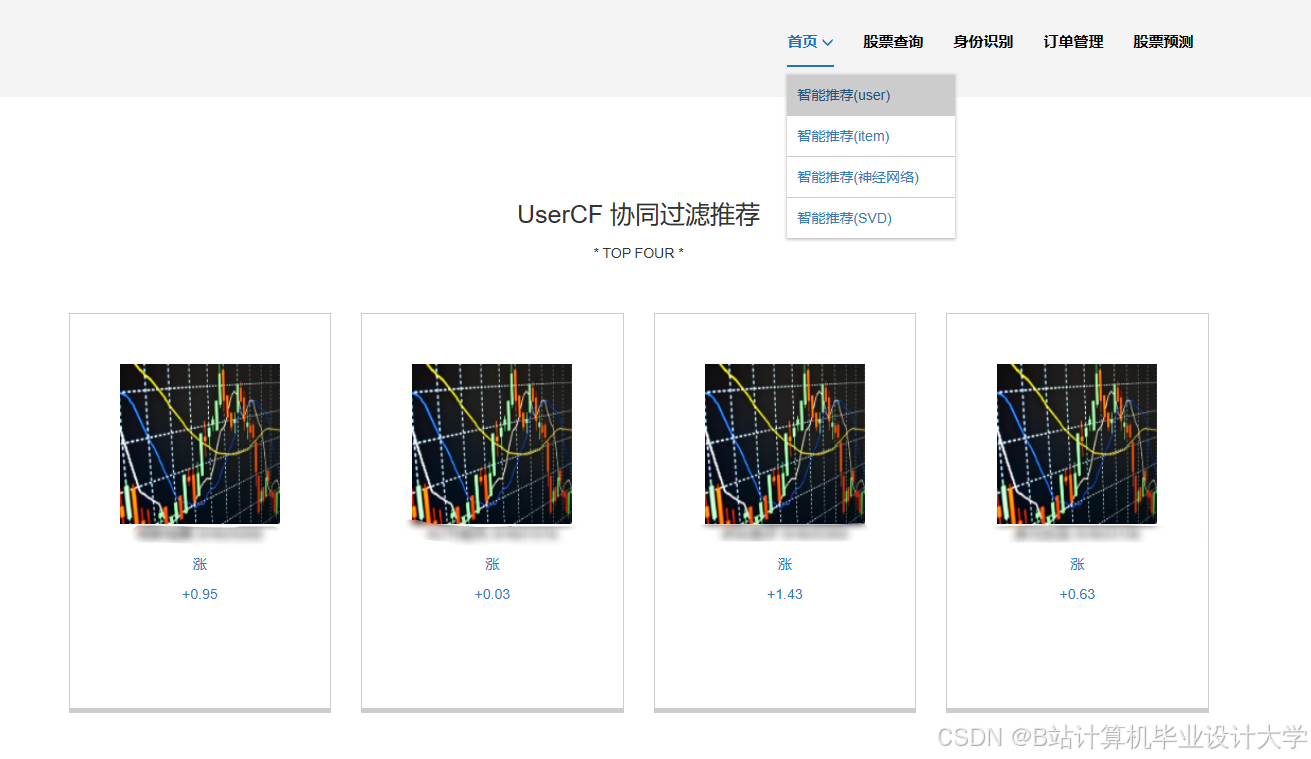

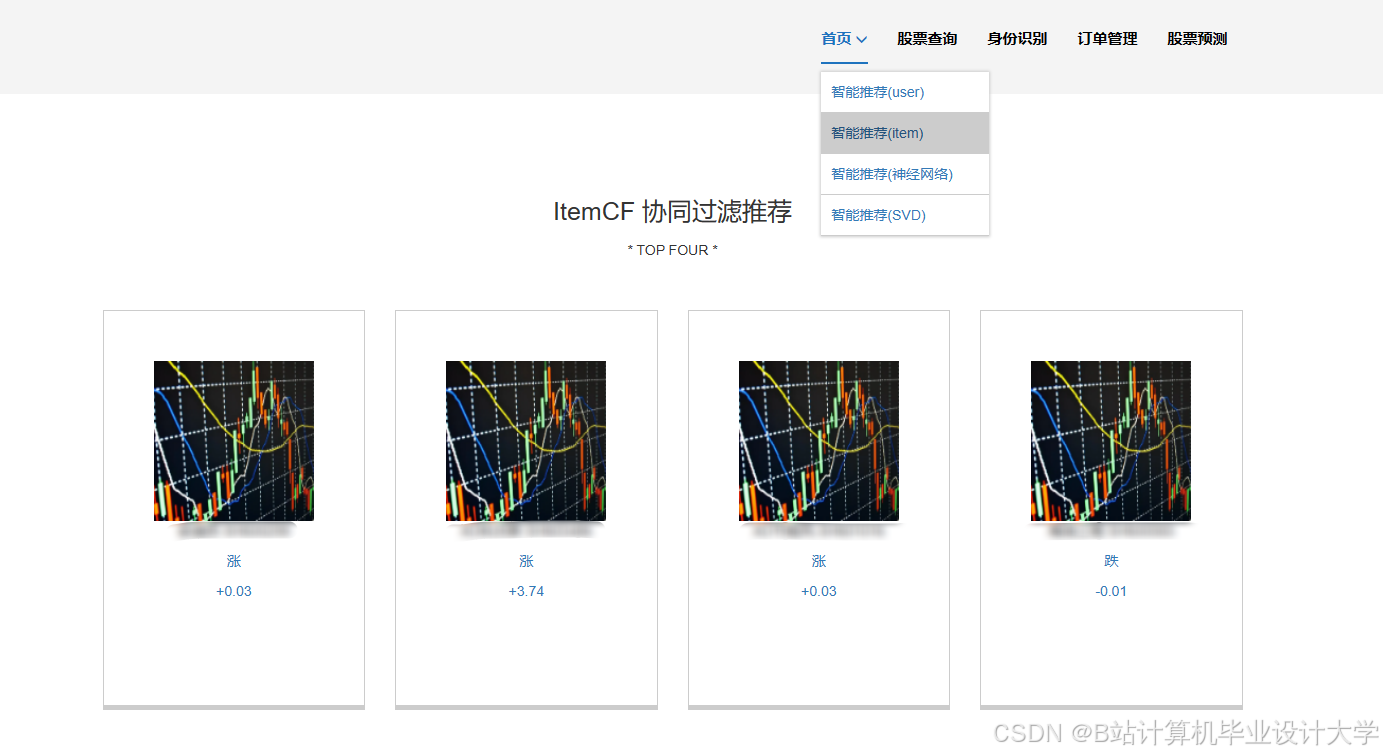

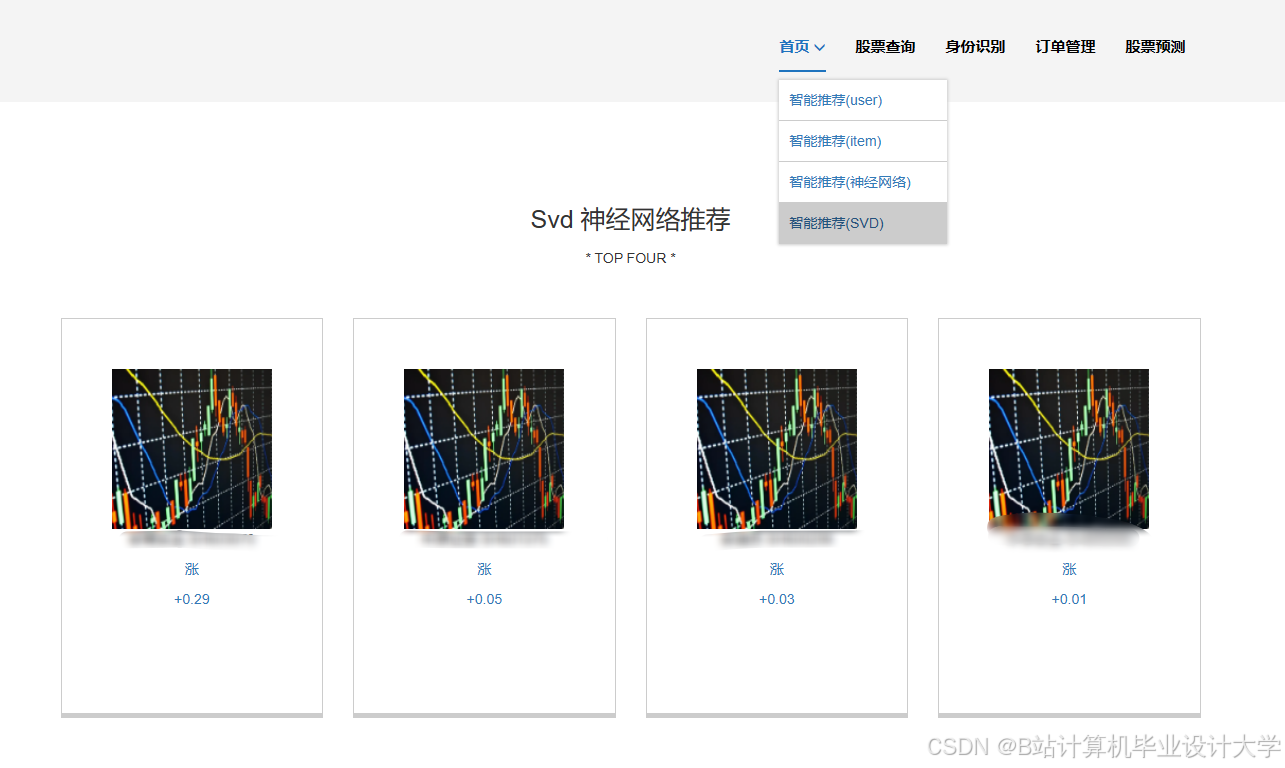

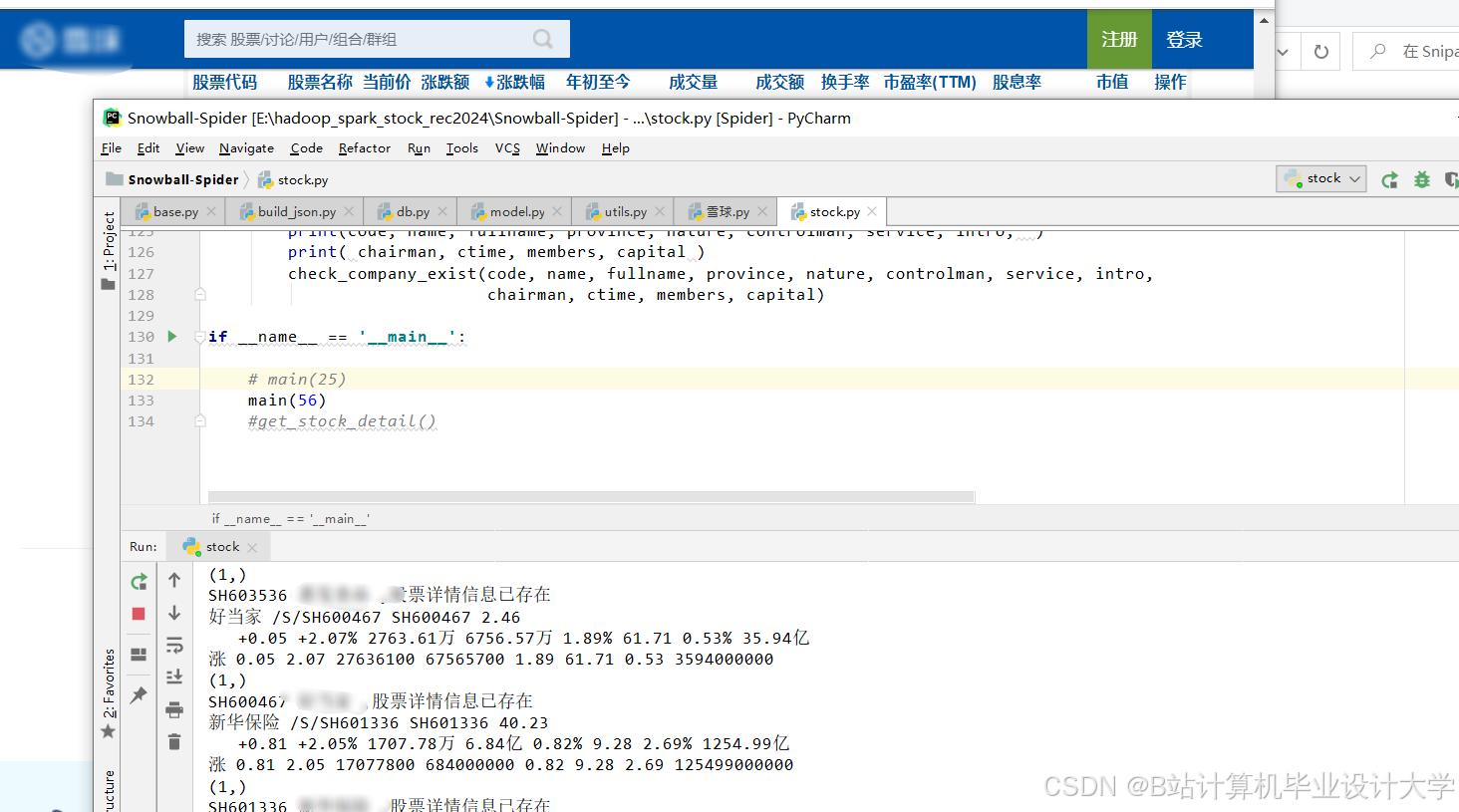

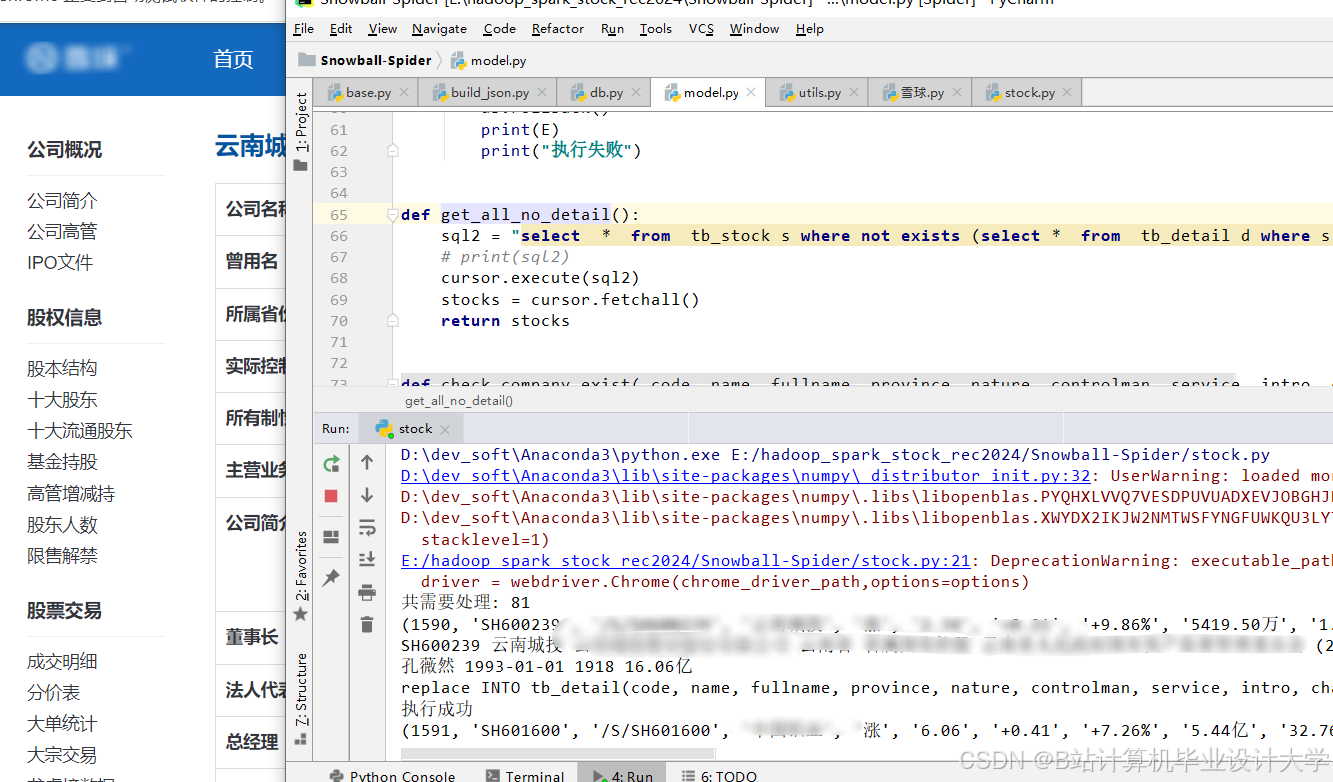

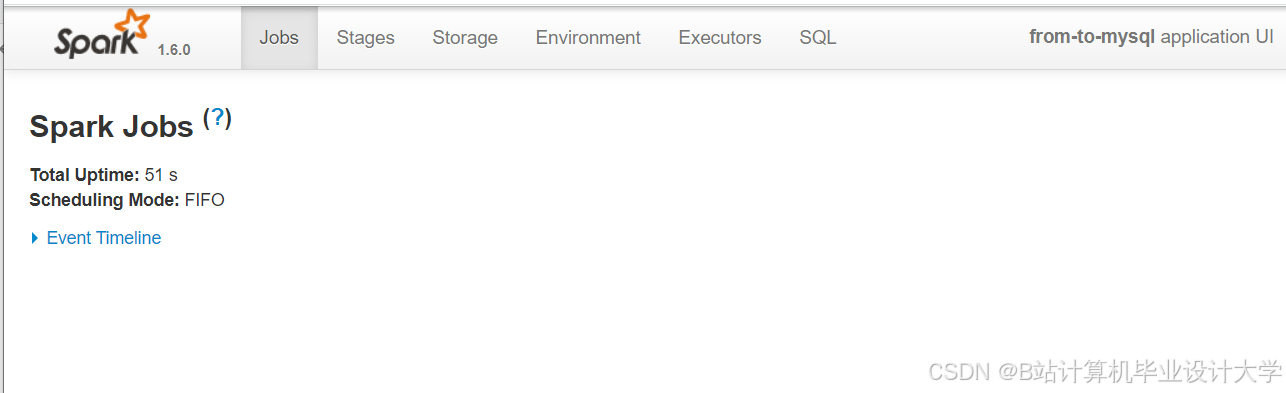

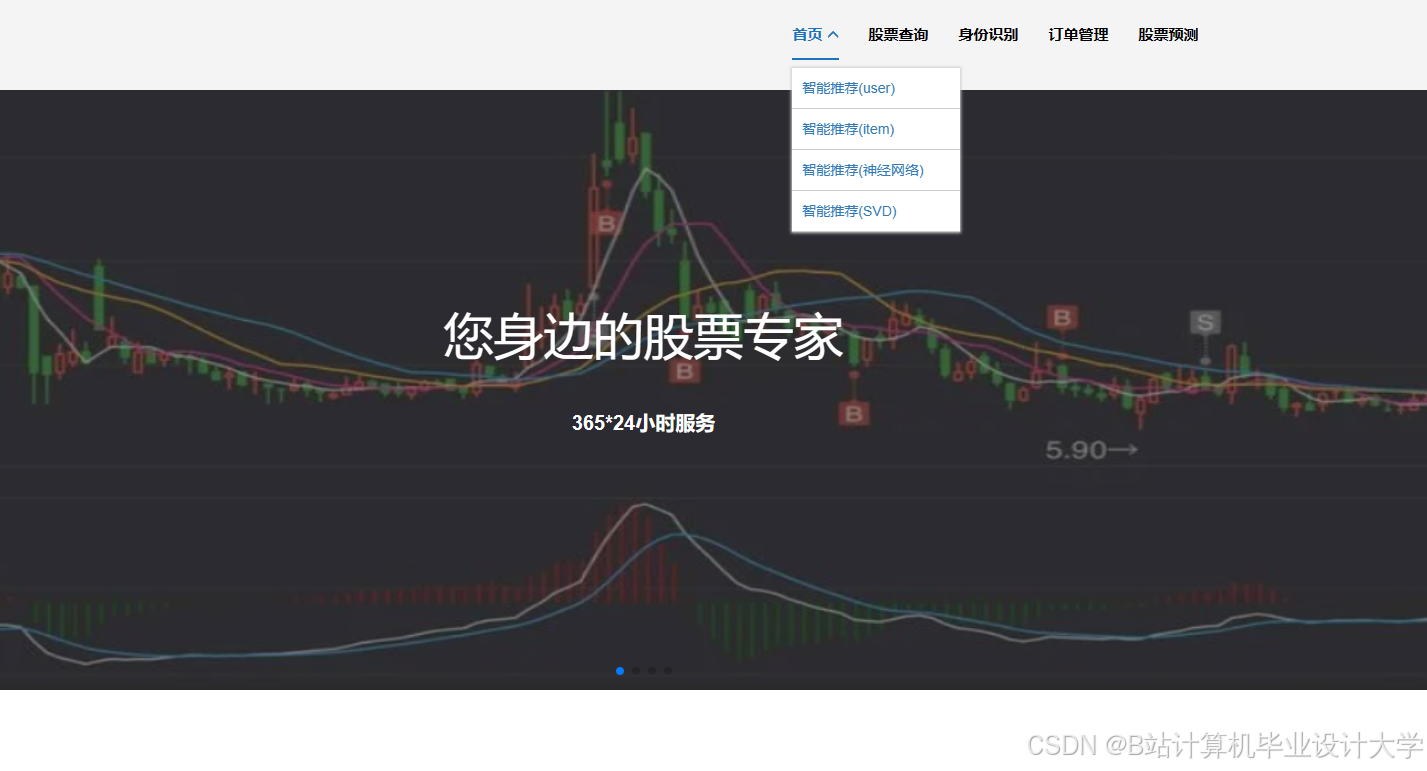

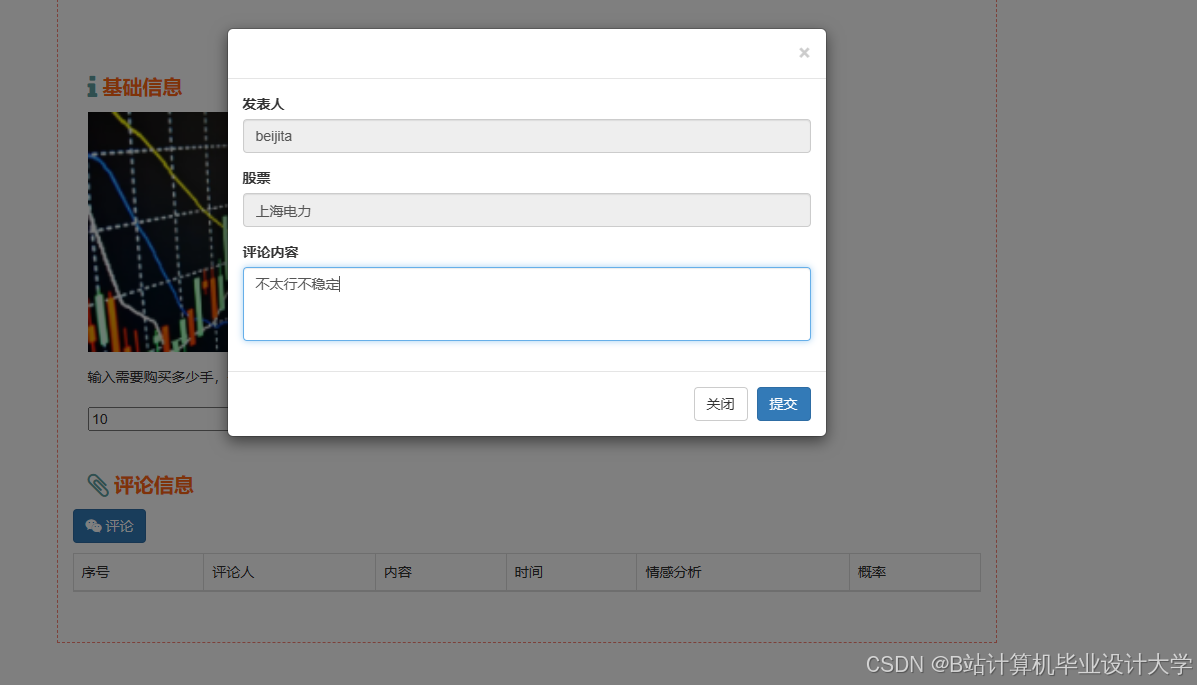

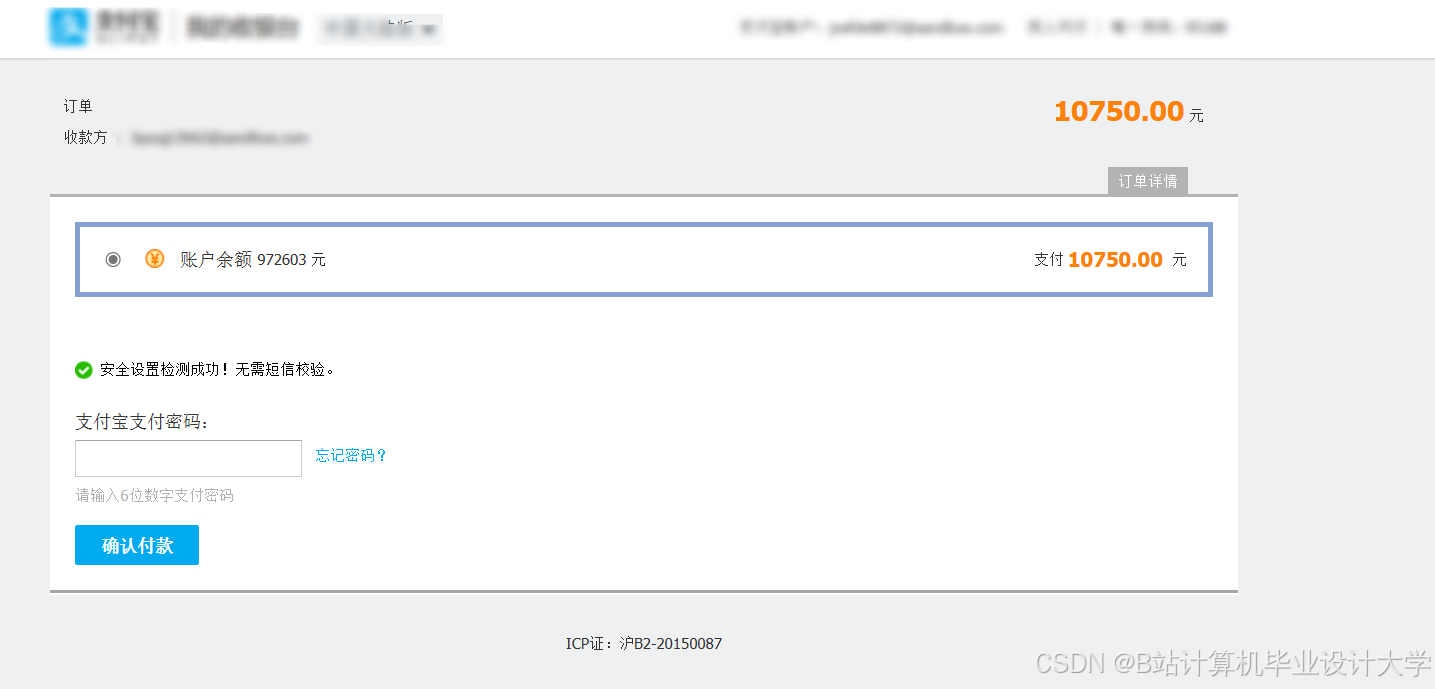

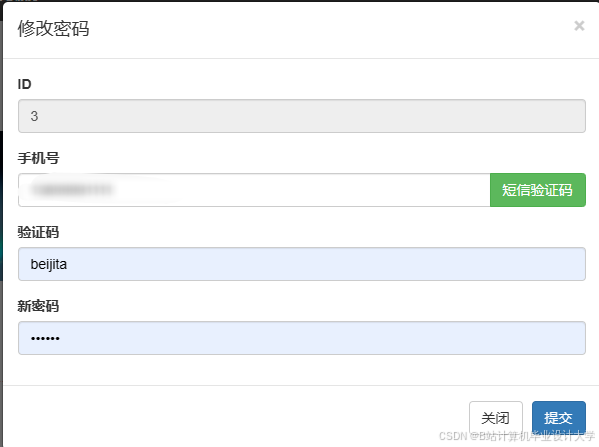

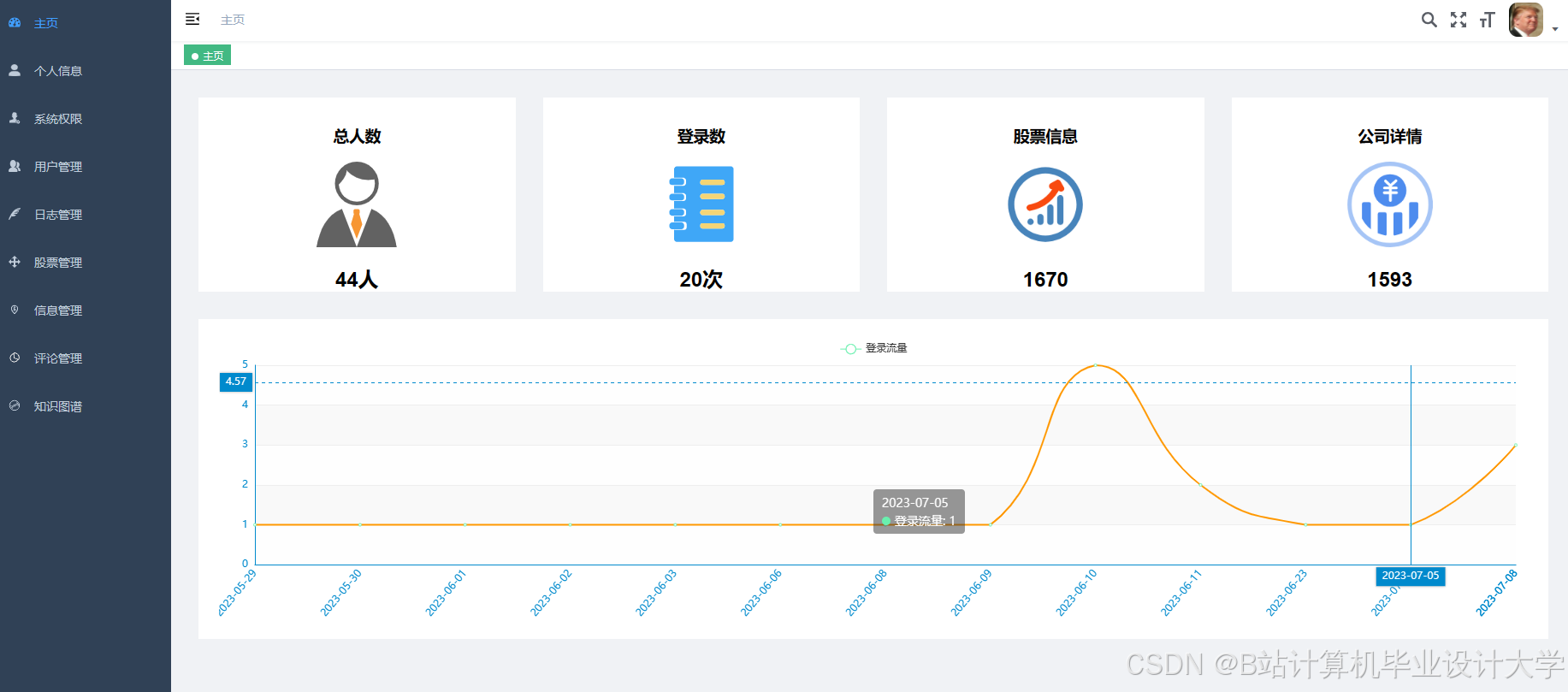

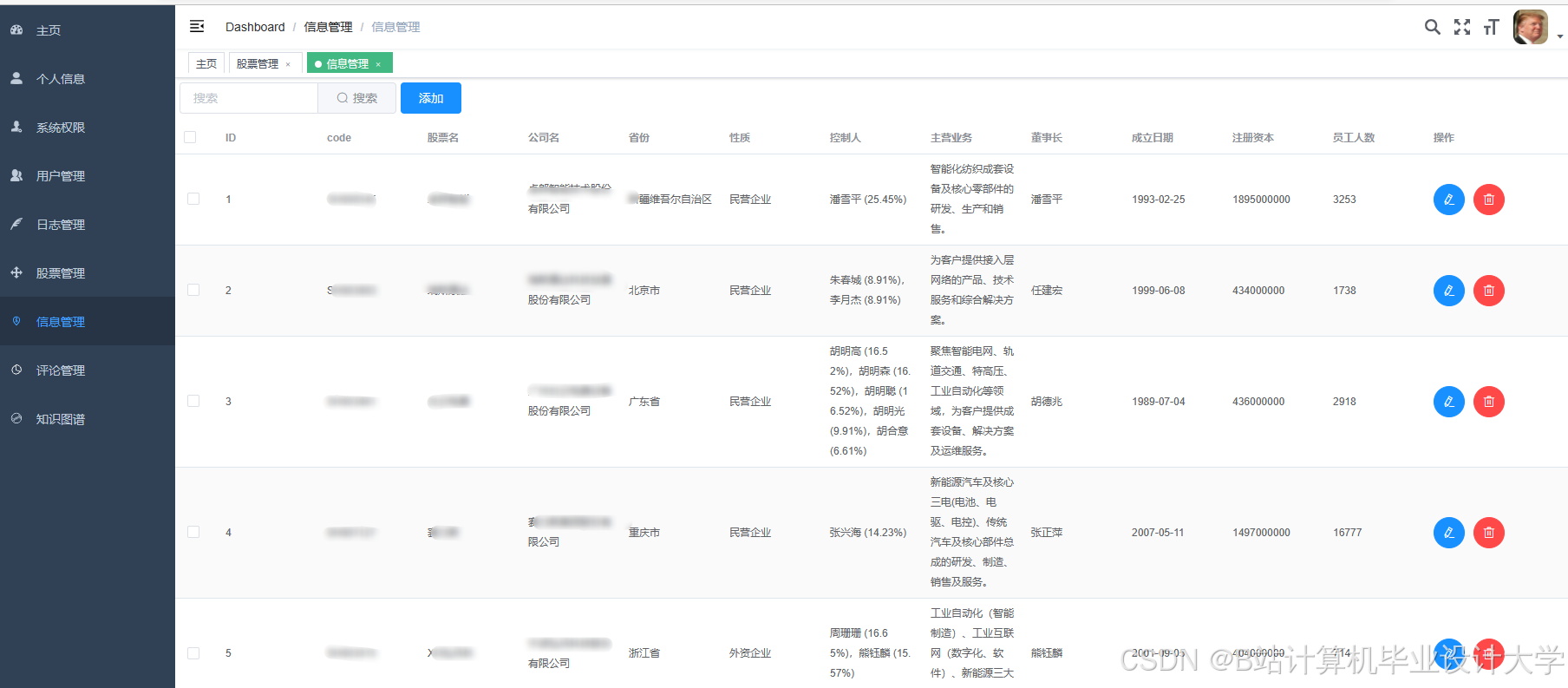

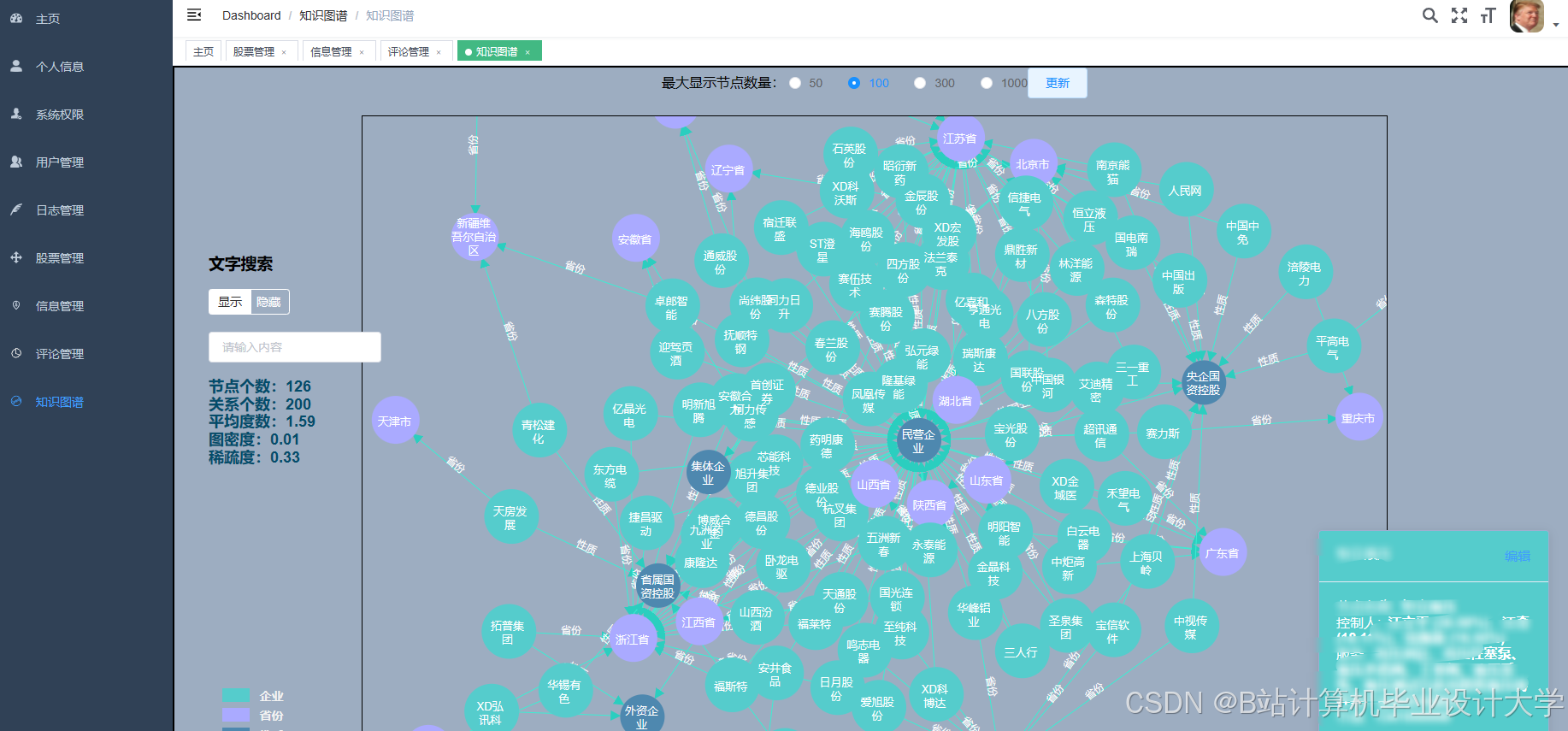

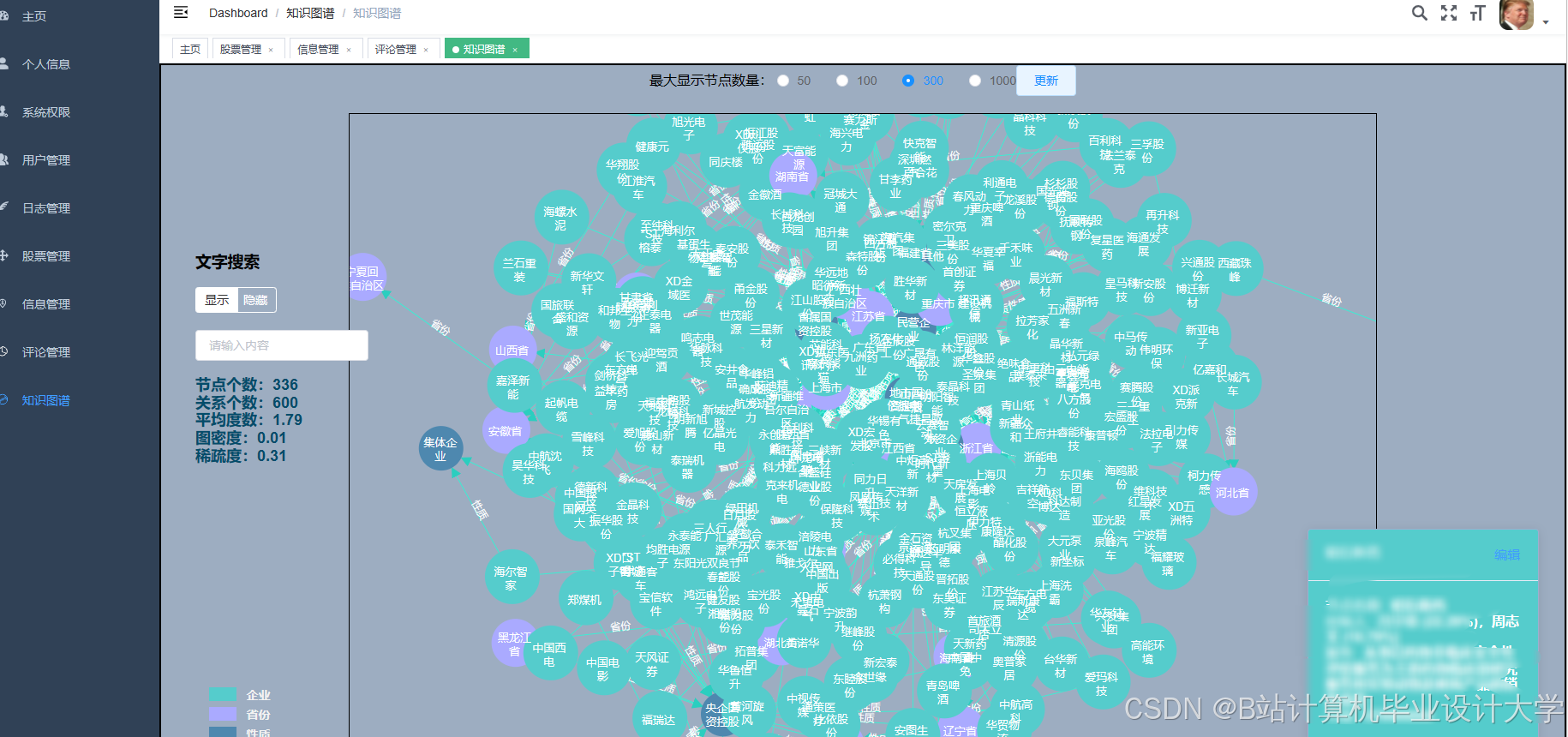

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

960

960

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?