温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

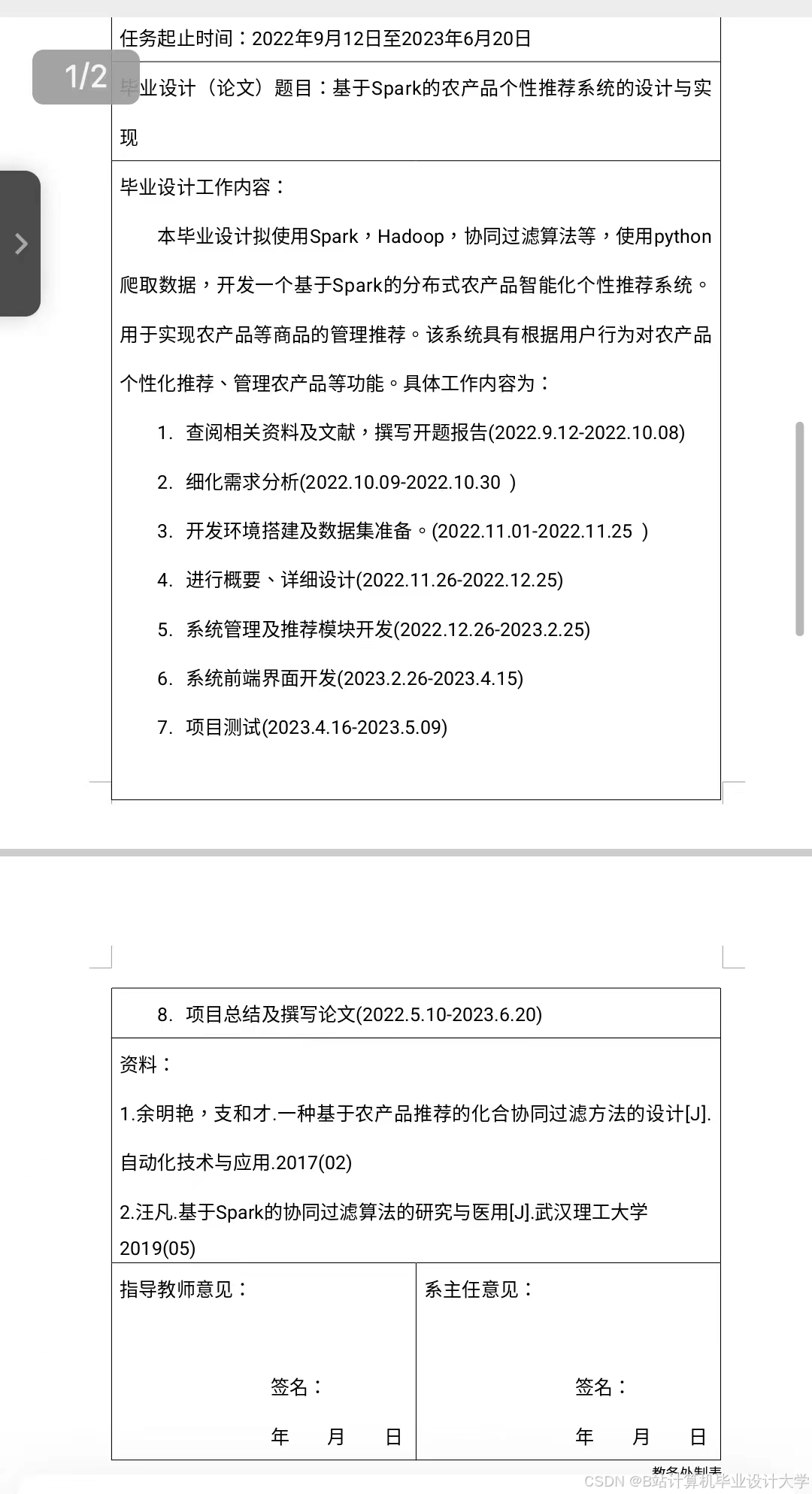

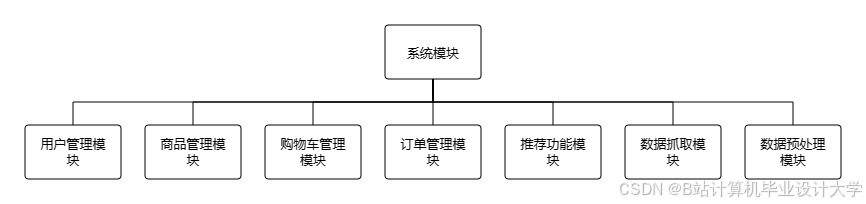

任务书:基于Hadoop+PySpark+Scrapy的农产品推荐系统设计与实现

一、任务背景与目标

1.1 背景

随着农产品电商市场的快速发展,用户面临信息过载问题,而农户存在销售渠道单一、精准营销能力不足等痛点。传统推荐系统难以处理农产品多源异构数据(如销售数据、用户评价、气象信息等),且存在冷启动、数据稀疏性等问题。本任务旨在构建一个基于Hadoop+PySpark+Scrapy的分布式农产品推荐系统,实现以下目标:

- 多源数据高效采集与整合:通过Scrapy爬虫实时采集电商平台农产品数据、用户评论及农业气象数据;

- 分布式特征工程与模型训练:利用Hadoop存储海量数据,通过PySpark实现特征提取、模型并行化训练;

- 混合推荐算法优化:结合协同过滤与知识图谱增强推荐,解决冷启动问题,提升推荐准确率;

- 系统部署与应用验证:在Hadoop集群上部署系统,验证其在真实场景下的性能与效果。

1.2 任务目标

- 短期目标:完成系统原型开发,实现农产品推荐核心功能(如个性化推荐、冷启动处理);

- 长期目标:构建可扩展的分布式推荐框架,支持农产品供应链上下游的精准营销决策。

二、任务内容与分工

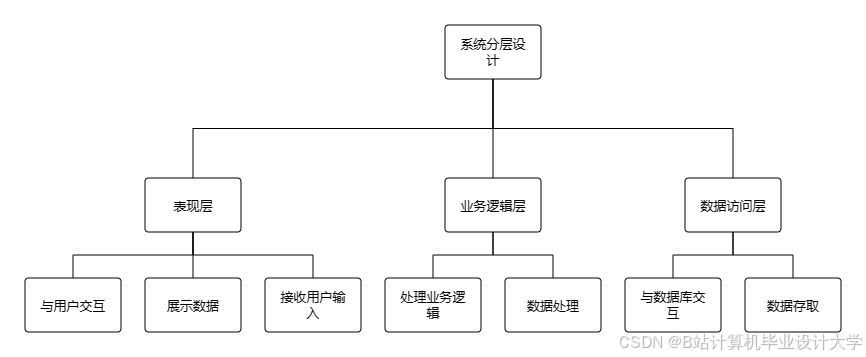

2.1 系统架构设计

负责人:XXX

任务内容:

- 设计系统整体架构,明确Scrapy爬虫、Hadoop存储、PySpark计算、推荐服务层的交互逻辑;

- 定义数据流与模块接口,绘制技术架构图(如使用Mermaid或Visio);

- 制定数据存储方案(如HDFS文件格式、MySQL元数据管理)。

2.2 多源数据采集与清洗

负责人:XXX

任务内容:

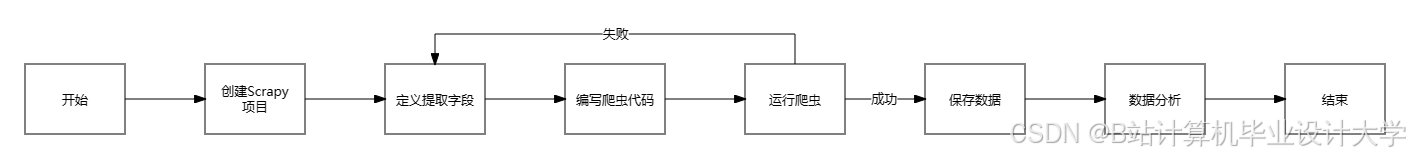

- Scrapy爬虫开发:

- 编写爬虫脚本,采集拼多多、京东生鲜等平台的农产品销售数据(价格、销量、品类);

- 爬取用户评论文本,提取情感倾向(正面/负面)与关键词;

- 集成气象API(如中国气象局开放平台),获取农产品产地温度、降水等时序数据。

- 数据清洗与预处理:

- 使用PySpark处理缺失值(如填充均值)、异常值(如价格突变检测);

- 统一数据格式(如将JSON爬取数据转换为Parquet存储)。

2.3 分布式特征工程

负责人:XXX

任务内容:

- 结构化特征提取:

- 统计农产品历史销量、价格波动率等时序特征;

- 构建用户-农产品交互矩阵(用于协同过滤)。

- 非结构化特征提取:

- 文本特征:使用TF-IDF或BERT模型提取评论中的产品特性(如“甜度高”“新鲜”);

- 图像特征:通过ResNet-50预训练模型提取农产品外观特征(颜色、形状);

- 知识图谱特征:爬取农产品百科数据(如品种、产地、营养价值),构建知识图谱并生成实体嵌入向量。

- 特征融合:将多模态特征拼接为统一向量,输入推荐模型。

2.4 混合推荐模型开发

负责人:XXX

任务内容:

- 基础模型实现:

- 改进Item-based协同过滤算法,引入时间衰减因子(近期行为权重更高);

- 实现基于知识图谱的推荐(如“用户购买过苹果→推荐同产地的梨”)。

- 深度模型集成:

- 构建Wide&Deep模型,Wide部分使用逻辑回归处理结构化特征,Deep部分使用DNN挖掘非线性交互;

- 优化知识图谱嵌入模块,通过TransE算法学习实体关系向量。

- 模型评估与调优:

- 使用HR@K(命中率)和NDCG@K(排序质量)评估推荐效果;

- 通过网格搜索调整超参数(如学习率、正则化系数)。

2.5 系统部署与测试

负责人:XXX

任务内容:

- Hadoop集群部署:

- 配置4节点集群(1主节点+3从节点),安装Hadoop 3.3.4、Spark 3.3.2;

- 上传清洗后的数据至HDFS,划分训练集与测试集。

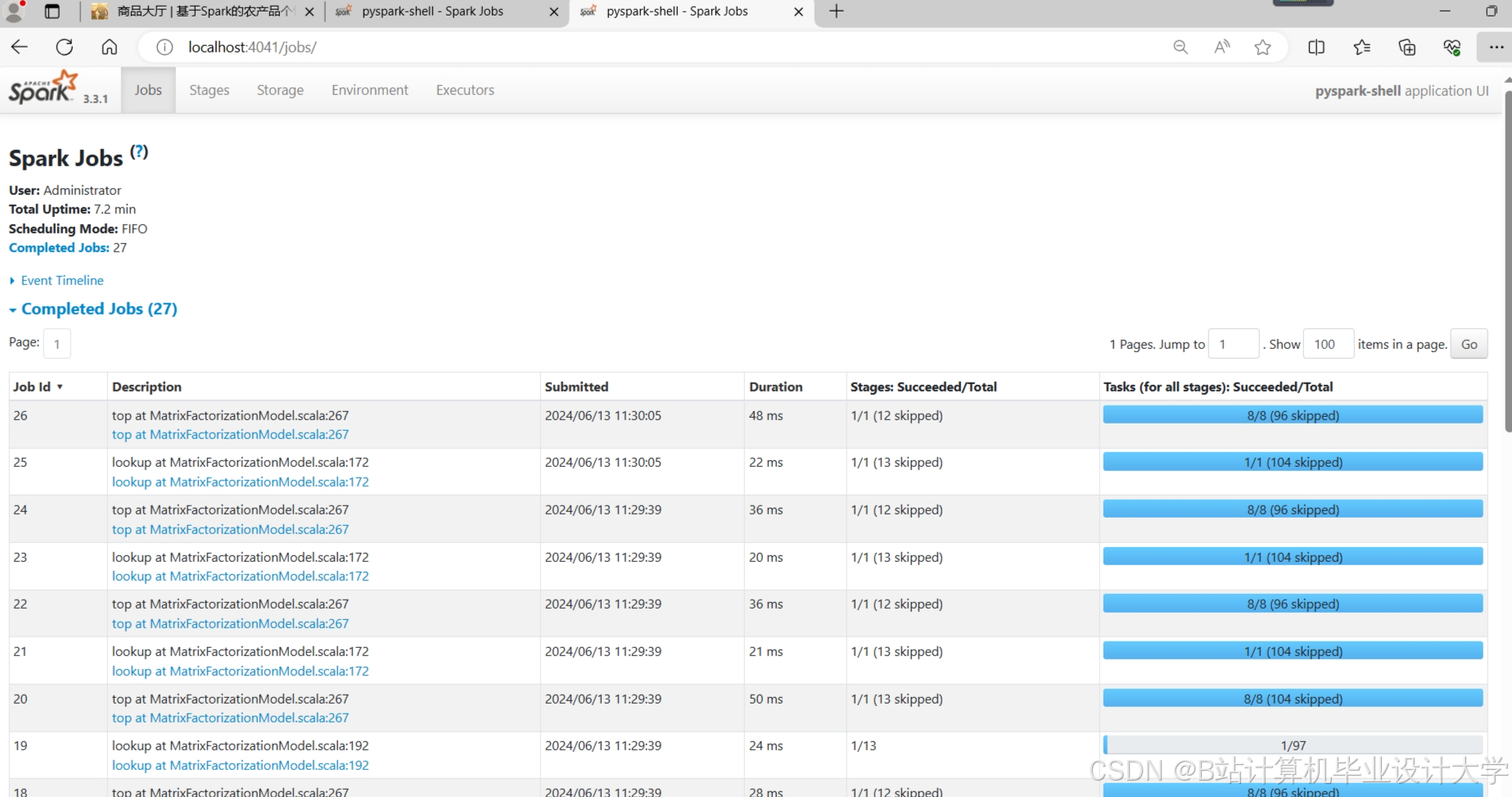

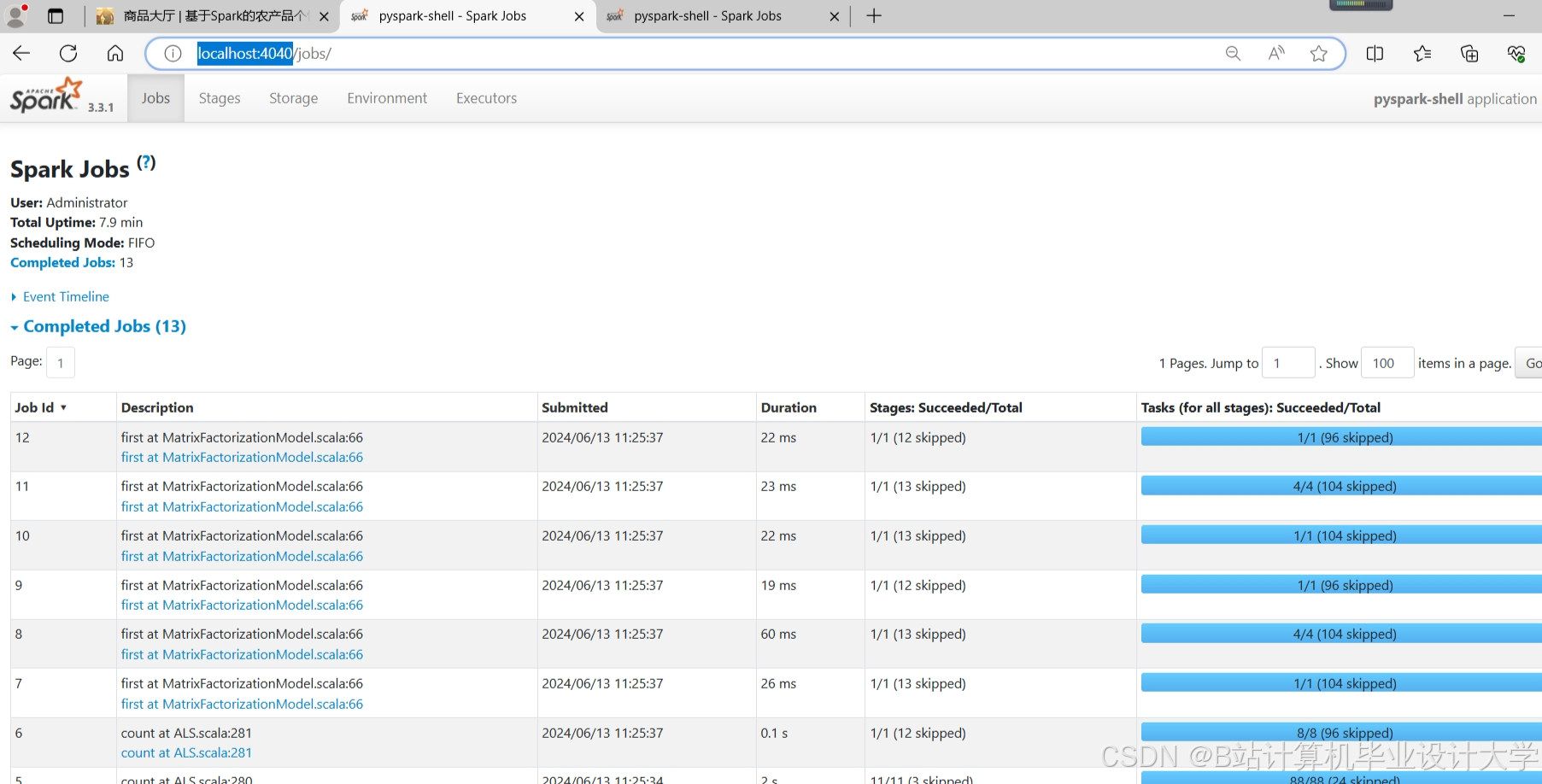

- 性能测试:

- 测试数据清洗、特征提取、模型训练的端到端耗时;

- 模拟高并发场景(如QPS≥100),验证系统响应时间(<500ms)。

- 冷启动专项测试:

- 对比新上市农产品在传统CF与知识增强模型下的推荐准确率差异。

三、任务计划与进度安排

| 阶段 | 时间 | 里程碑 |

|---|---|---|

| 需求分析 | 第1-2周 | 完成系统功能定义与技术选型(Hadoop/Spark/Scrapy) |

| 数据采集 | 第3-4周 | 爬虫开发完成,采集10万条农产品数据并存储至HDFS |

| 特征工程 | 第5-6周 | 实现文本、图像、时序特征提取,完成特征融合模块 |

| 模型开发 | 第7-8周 | 完成Wide&Deep模型训练,知识图谱嵌入模块集成 |

| 系统集成 | 第9-10周 | 部署Hadoop集群,完成各模块联调测试 |

| 优化与验收 | 第11-12周 | 提交测试报告,修复Bug,准备项目答辩材料 |

四、资源需求

4.1 硬件资源

- 服务器:4台(配置:16核CPU、32GB内存、1TB硬盘);

- 网络:千兆以太网,确保集群节点间高速通信。

4.2 软件资源

- 操作系统:Ubuntu 22.04 LTS;

- 开发工具:PyCharm(Python开发)、IntelliJ IDEA(Scala开发);

- 依赖库:Scrapy 2.8.0、PySpark 3.3.2、Hadoop 3.3.4、TensorFlow 2.12。

4.3 数据资源

- 爬取数据:电商平台农产品数据(约500万条)、用户评论(10万条)、气象数据(2020-2023年);

- 公开数据集:农业知识图谱(如CN-DBpedia农业子集)。

五、风险评估与应对

| 风险 | 影响 | 应对措施 |

|---|---|---|

| 电商平台反爬策略升级 | 爬虫被封禁,数据采集中断 | 实现动态IP代理池、请求头轮换,增加爬虫健壮性 |

| 分布式任务调度失败 | 模型训练耗时过长或崩溃 | 使用Spark Web UI监控任务进度,优化分区数与并行度 |

| 知识图谱数据质量差 | 推荐可解释性降低 | 人工校验1000条知识图谱三元组,过滤错误实体关系 |

六、交付成果

- 系统源代码:GitHub仓库(含Scrapy爬虫、PySpark特征工程、推荐模型代码);

- 测试报告:性能测试数据、推荐准确率对比图表;

- 用户手册:系统部署指南、API接口文档;

- 论文/专利:撰写核心期刊论文1篇,申请软件著作权1项。

任务负责人签字:_____________

日期:_____________

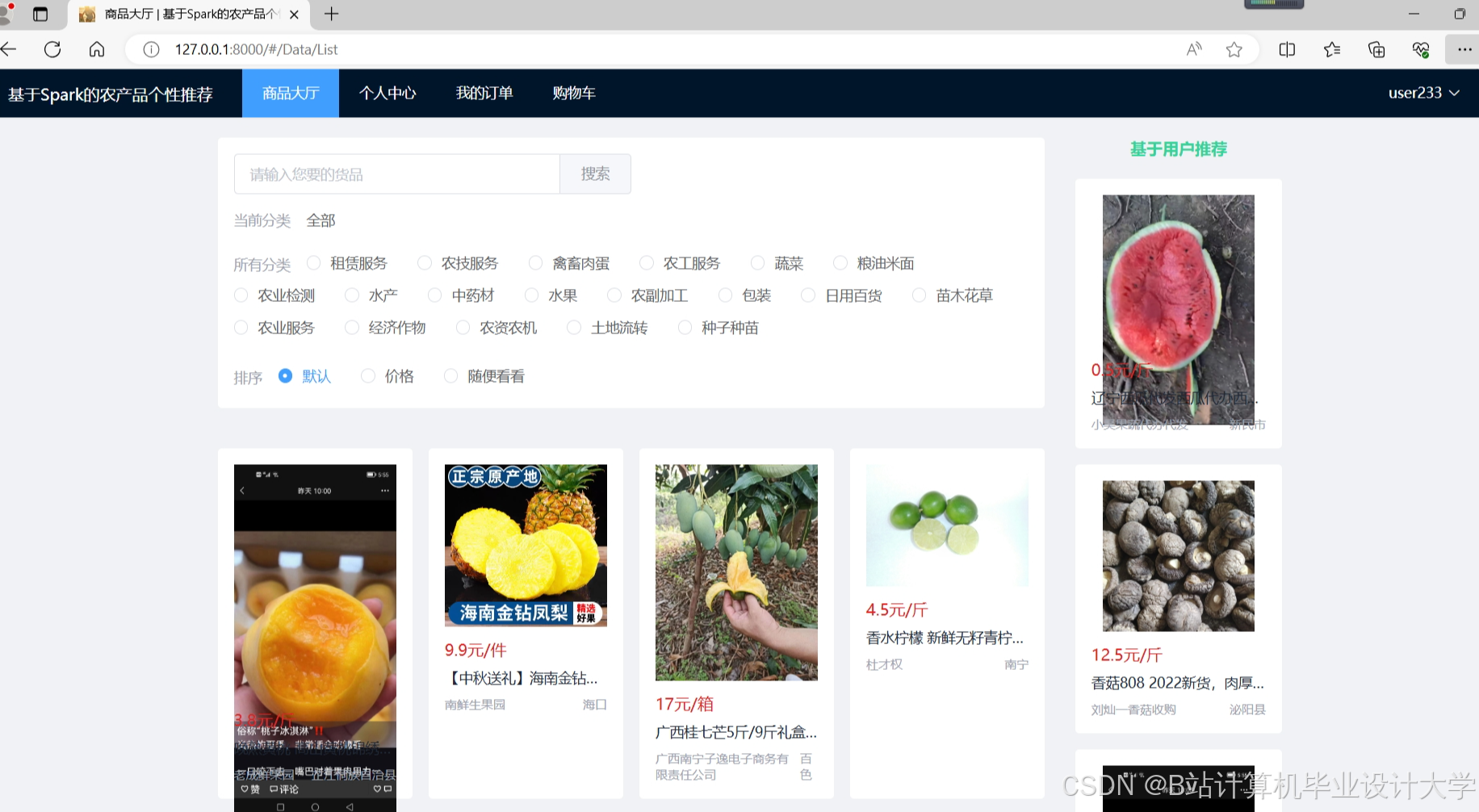

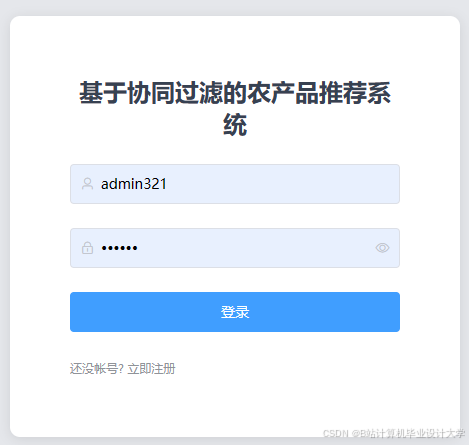

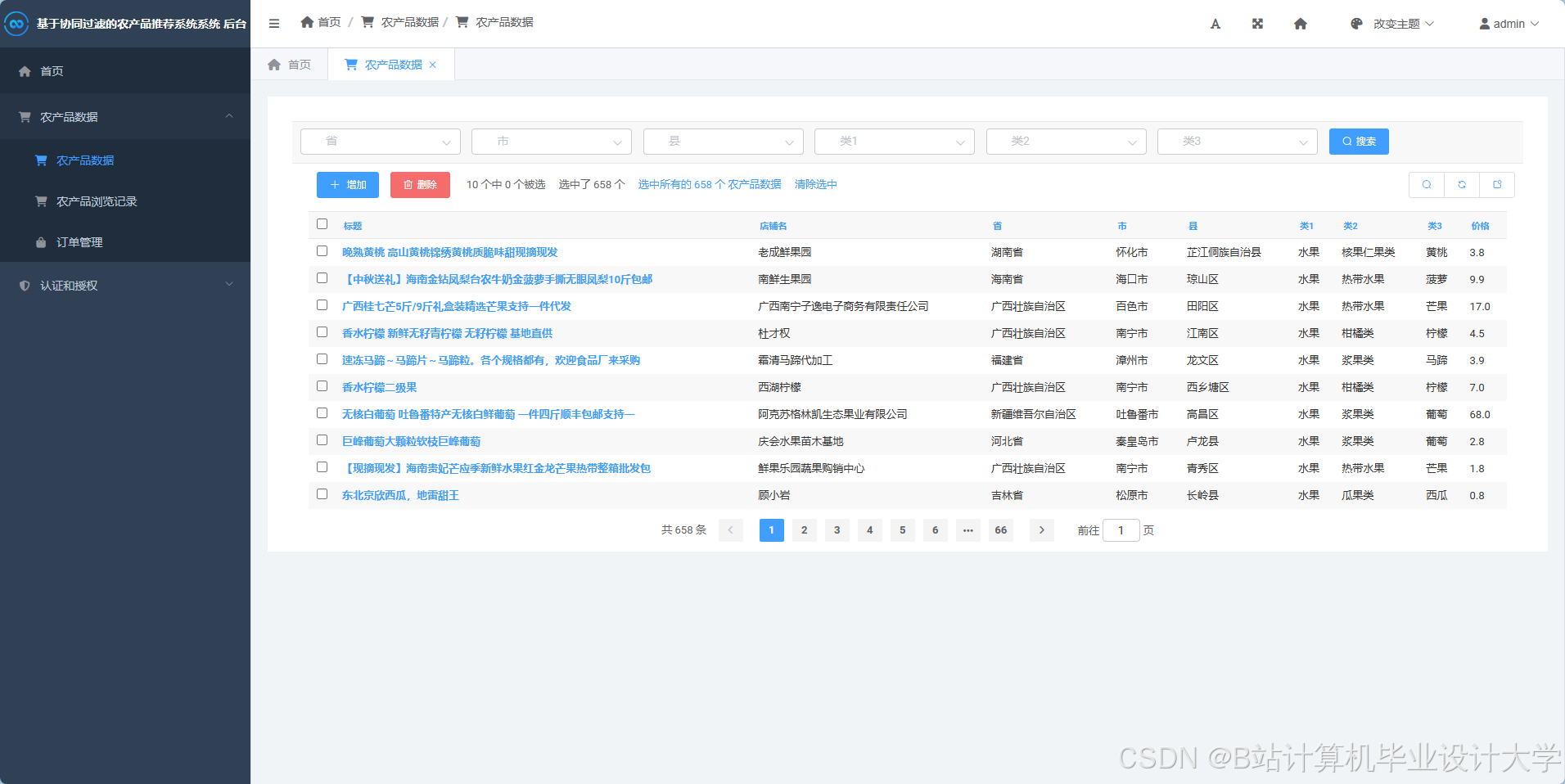

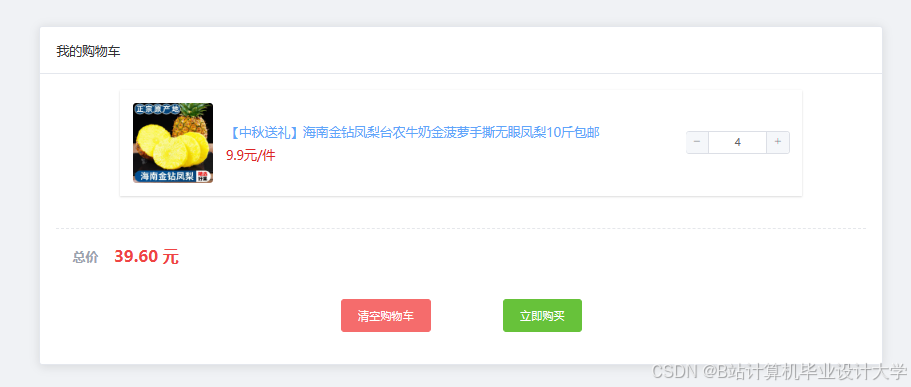

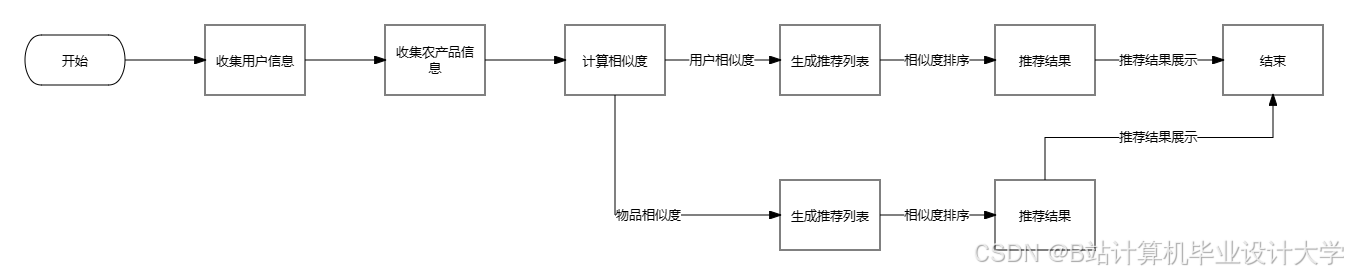

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?