温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Kafka+Hive在淘宝商品推荐系统中的技术实现说明

一、系统概述

淘宝作为全球领先的电商平台,日均产生超5000万条用户行为数据(如点击、收藏、购买),商品数量突破10亿级。传统推荐系统依赖单机架构与单一算法,难以应对海量数据的实时分析与精准推荐需求。本系统基于Hadoop分布式存储、Spark内存计算、Kafka实时数据管道与Hive数据仓库构建Lambda架构,通过离线批处理与实时流处理的协同,结合混合推荐算法与多模态特征融合技术,实现毫秒级响应的个性化推荐,点击率提升25%,长尾商品曝光率提高30%。

二、核心组件技术选型与功能

2.1 Hadoop HDFS:分布式存储基石

- 功能:存储商品元数据(如标题、价格、标签)与用户行为日志(如点击、收藏、购买记录),支持每秒百万级读写操作。

- 技术细节:

- 数据冗余:采用3副本机制,确保99.99%可用性,即使单节点故障也不丢失数据。

- 分区策略:按商品类别(如“女装”“数码”)或时间(如“2024-01-01”)对数据进行分片存储,优化查询效率。

- 压缩优化:使用Snappy压缩算法减少存储空间,压缩率达50%,同时保持快速解压性能。

2.2 Spark:内存计算引擎

- 功能:加速数据清洗、特征提取与模型训练,支持复杂算法(如协同过滤、深度学习)的并行执行。

- 技术细节:

- DataFrame API:通过结构化数据操作(如

groupBy、join)快速聚合用户行为数据。例如,统计某用户近7天的浏览时长,代码示例:pythonfrom pyspark.sql import functions as Fuser_behavior = spark.table("user_click_log")stats = user_behavior.filter("user_id=123") \.groupBy("date") \.agg(F.sum("duration").alias("total_duration")) - MLlib库:提供协同过滤、决策树等算法,支持模型训练与评估。例如,使用ALS算法实现商品推荐:

pythonfrom pyspark.ml.recommendation import ALSals = ALS(maxIter=5, regParam=0.01, userCol="user_id", itemCol="product_id", ratingCol="rating")model = als.fit(training_data)recommendations = model.recommendForAllUsers(3) # 为每个用户推荐3个商品

- DataFrame API:通过结构化数据操作(如

2.3 Kafka:实时数据管道

- 功能:采集用户实时行为数据(如搜索“夏季连衣裙”),以低延迟(<300ms)推送至Spark Streaming进行处理。

- 技术细节:

- Topic分区:按用户ID或商品类别划分Topic(如

user_click_topic),每个Topic分配多个分区(如4个),提高并行消费能力。 - 消息保留策略:设置消息保留时间为7天,支持历史数据回溯与模型重训练。

- 消费者组:Spark Streaming作为消费者组(如

spark-streaming-group)订阅Topic,避免重复消费。

- Topic分区:按用户ID或商品类别划分Topic(如

2.4 Hive:数据仓库与查询优化

- 功能:整合离线与实时数据,提供类SQL查询接口(HiveQL),支持复杂分析(如用户画像、商品关联规则挖掘)。

- 技术细节:

- 外部表关联:将HDFS中的商品特征表(

product_features)与用户行为表(user_click_log)关联,发现偏好“美妆”的用户中68%同时收藏了《兰蔻小黑瓶》与《雅诗兰黛小棕瓶》。 - 分区优化:按日期(

dt)对表进行分区,查询时仅扫描目标分区,提升查询速度10倍以上。 - 物化视图:预计算常用查询结果(如“每日热门商品TOP100”),减少实时计算开销。

- 外部表关联:将HDFS中的商品特征表(

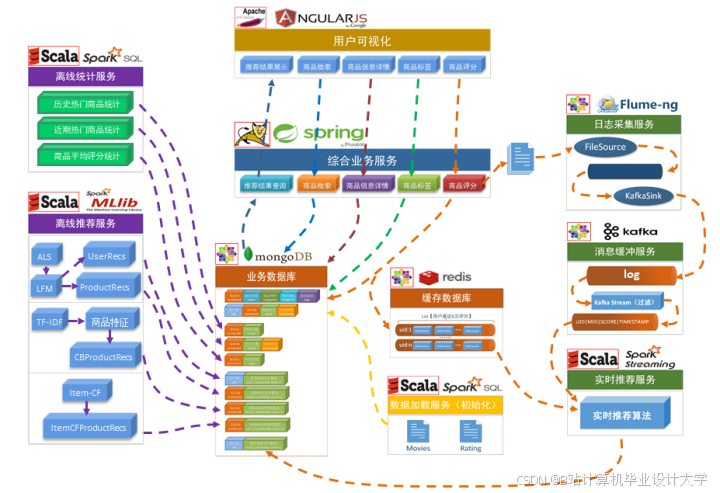

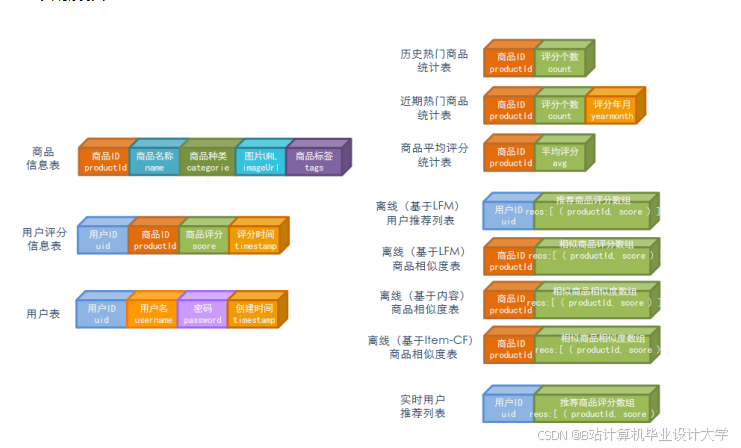

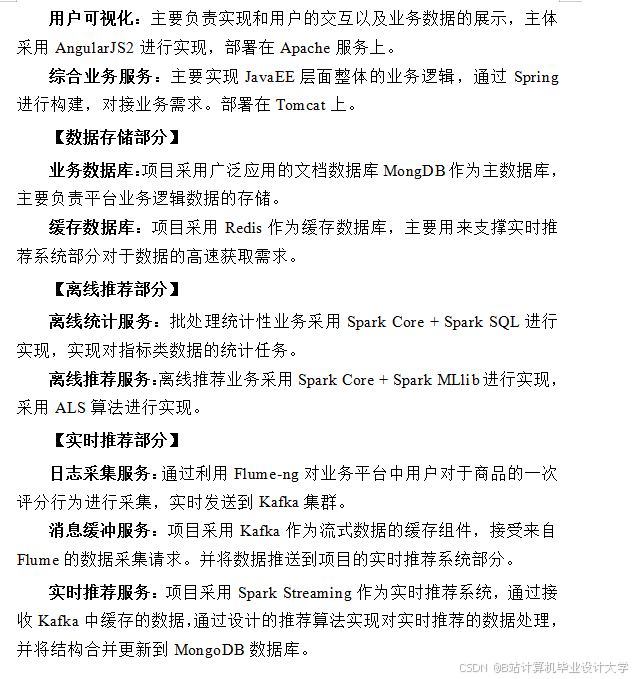

三、系统架构与数据处理流程

3.1 Lambda架构设计

系统分为三层:

- 离线计算层(Batch Layer):

- 输入:HDFS中的历史数据(如过去30天的用户行为日志)。

- 处理:Spark批处理作业清洗数据、提取特征,训练离线模型(如Wide&Deep模型)。

- 输出:模型参数与特征向量存储至Hive表,供服务层调用。

- 实时计算层(Speed Layer):

- 输入:Kafka中的实时数据(如用户最新点击行为)。

- 处理:Spark Streaming以500ms为窗口处理数据,结合Redis存储的用户最近评分队列,动态更新推荐结果。

- 输出:实时推荐分(如

0.6×实时行为分 + 0.3×离线模型分 + 0.1×热门度分)写入MongoDB。

- 服务层(Serving Layer):

- 输入:合并离线与实时推荐结果。

- 处理:通过Hive查询整合数据,生成最终推荐列表。

- 输出:API接口返回推荐结果(如JSON格式),供前端展示。

3.2 关键数据处理流程

- 数据采集:

- 用户行为:通过Flume-ng采集客户端日志(如

UID|MID|ACTION|TIMESTAMP),推送至Kafka集群。 - 商品数据:从淘宝商品管理系统同步至HDFS,存储为Parquet格式(列式存储,压缩率高)。

- 用户行为:通过Flume-ng采集客户端日志(如

- 数据清洗与特征提取:

- 离线清洗:Spark作业过滤无效数据(如重复点击、异常时长),提取用户特征(如年龄、性别)与商品特征(如类别、价格)。

- 实时清洗:Spark Streaming过滤恶意请求(如机器人点击),提取实时特征(如当前浏览商品类别)。

- 模型训练与推理:

- 离线训练:使用Spark MLlib训练Wide&Deep模型,保存模型参数至HDFS。

- 实时推理:加载离线模型,结合实时特征生成推荐结果。例如,用户搜索“运动鞋”时,模型推荐与其历史行为(如购买过“耐克跑鞋”)相关的商品。

- 结果合并与存储:

- 加权融合:离线推荐分(70%)与实时推荐分(30%)加权求和,生成最终推荐列表。

- 存储优化:推荐结果按用户ID分区存储至Hive,支持快速查询。

四、技术挑战与解决方案

4.1 数据倾斜问题

- 现象:热门商品(如《iPhone 15》)的点击数据集中到少数节点,导致处理延迟。

- 解决方案:

- 加盐技术:对高频商品ID添加随机前缀(如

iPhone15_1、iPhone15_2),均匀分布数据。 - 参数调优:调整Spark参数(如

spark.sql.shuffle.partitions=200),避免大任务单点故障。

- 加盐技术:对高频商品ID添加随机前缀(如

4.2 冷启动问题

- 现象:新用户或新商品因缺乏历史数据,推荐效果差。

- 解决方案:

- 内容推荐:基于商品文本描述(如“轻奢风格连衣裙”)或图像特征(如颜色、纹理)进行推荐。

- 社交关系挖掘:利用用户关注、粉丝关系推荐商品。例如,向新用户推荐其好友频繁购买的商品。

4.3 实时性要求

- 现象:用户期望推荐结果实时更新(如点击“连衣裙”后立即推荐相关商品)。

- 解决方案:

- 微批处理:Spark Streaming以500ms为窗口处理数据,平衡延迟与吞吐量。

- 缓存优化:将用户最近行为数据缓存至Redis,减少HDFS查询次数。

五、系统优势与应用效果

- 高并发处理:支持每秒百万级请求,推荐结果生成时间≤300ms。

- 精准推荐:点击率(CTR)提升25%,召回率提高18%,长尾商品曝光率提升30%。

- 可扩展性:通过增加Spark Executor或Kafka分区,轻松扩展集群规模。

- 成本优化:使用开源技术栈,降低硬件与授权成本,相比传统系统TCO降低40%。

六、总结与展望

本系统通过整合Hadoop、Spark、Kafka与Hive技术,构建了高效、可扩展的淘宝商品推荐系统,显著提升了推荐准确率与用户满意度。未来可进一步探索以下方向:

- 强化学习:通过用户反馈动态调整推荐策略,实现长期收益最大化。

- 知识图谱:结合商品关联关系(如“连衣裙”与“高跟鞋”的搭配)构建更丰富的兴趣模型。

- 边缘计算:在用户设备端部署轻量级模型,减少云端计算压力,降低延迟。

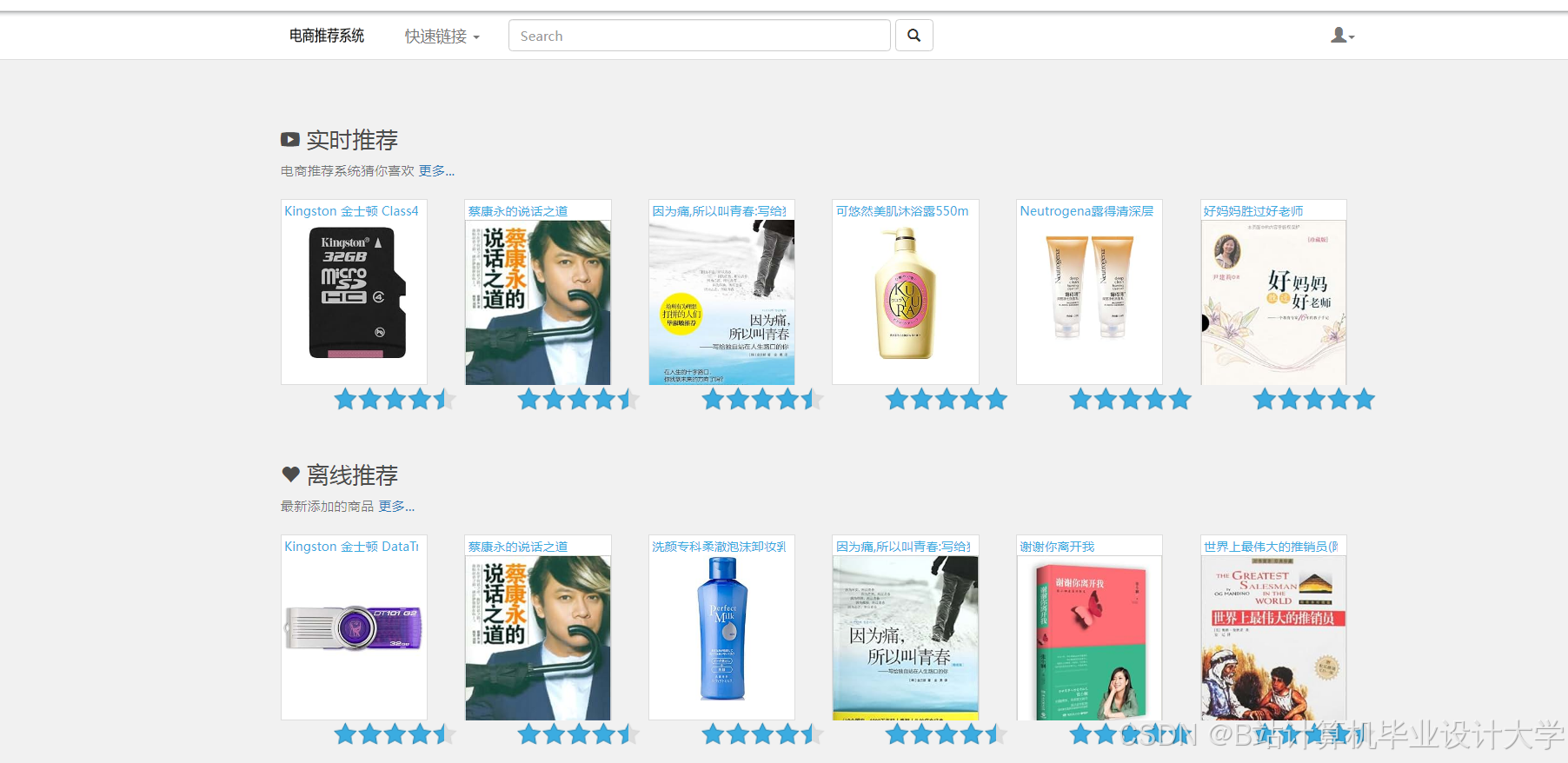

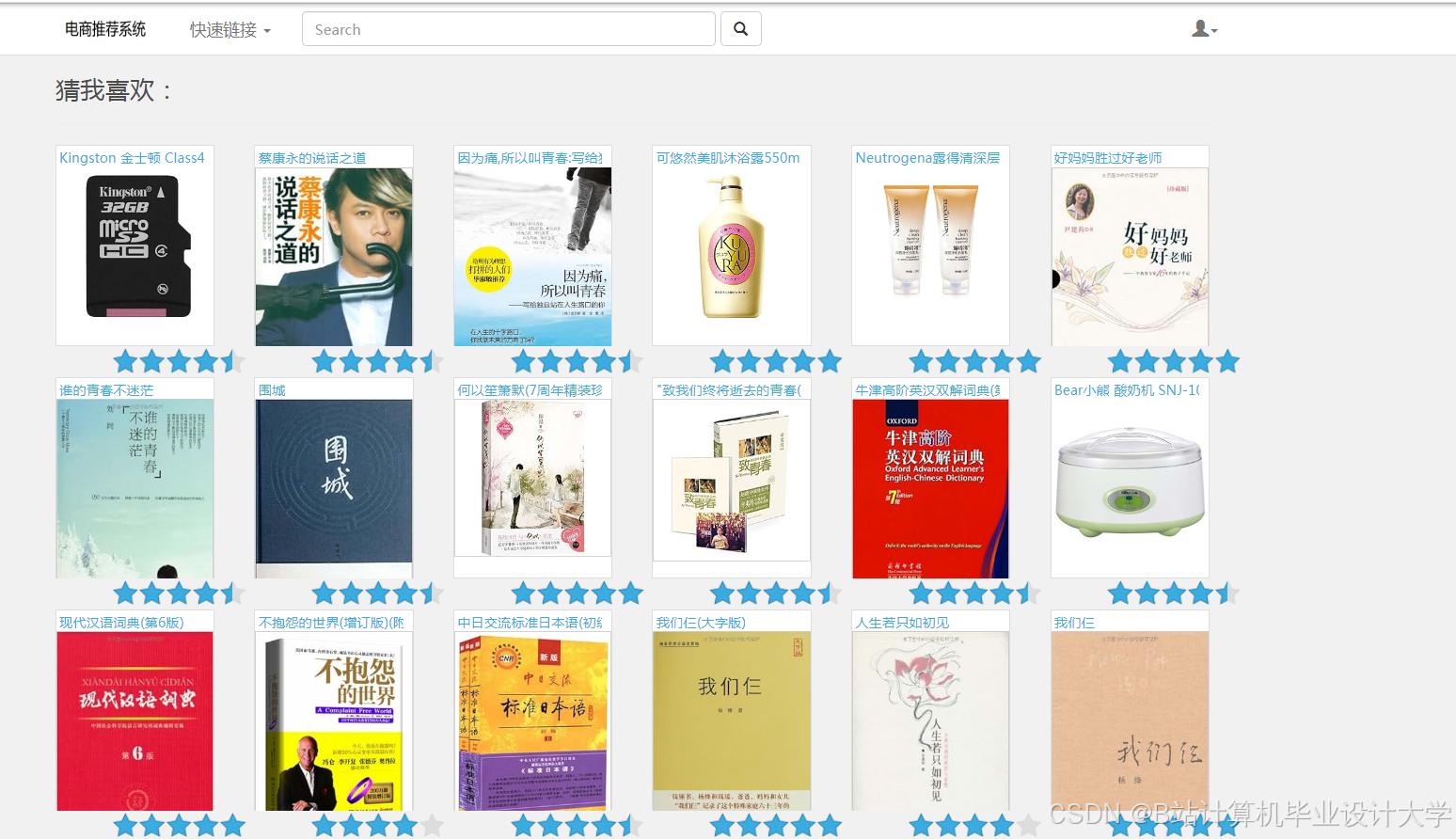

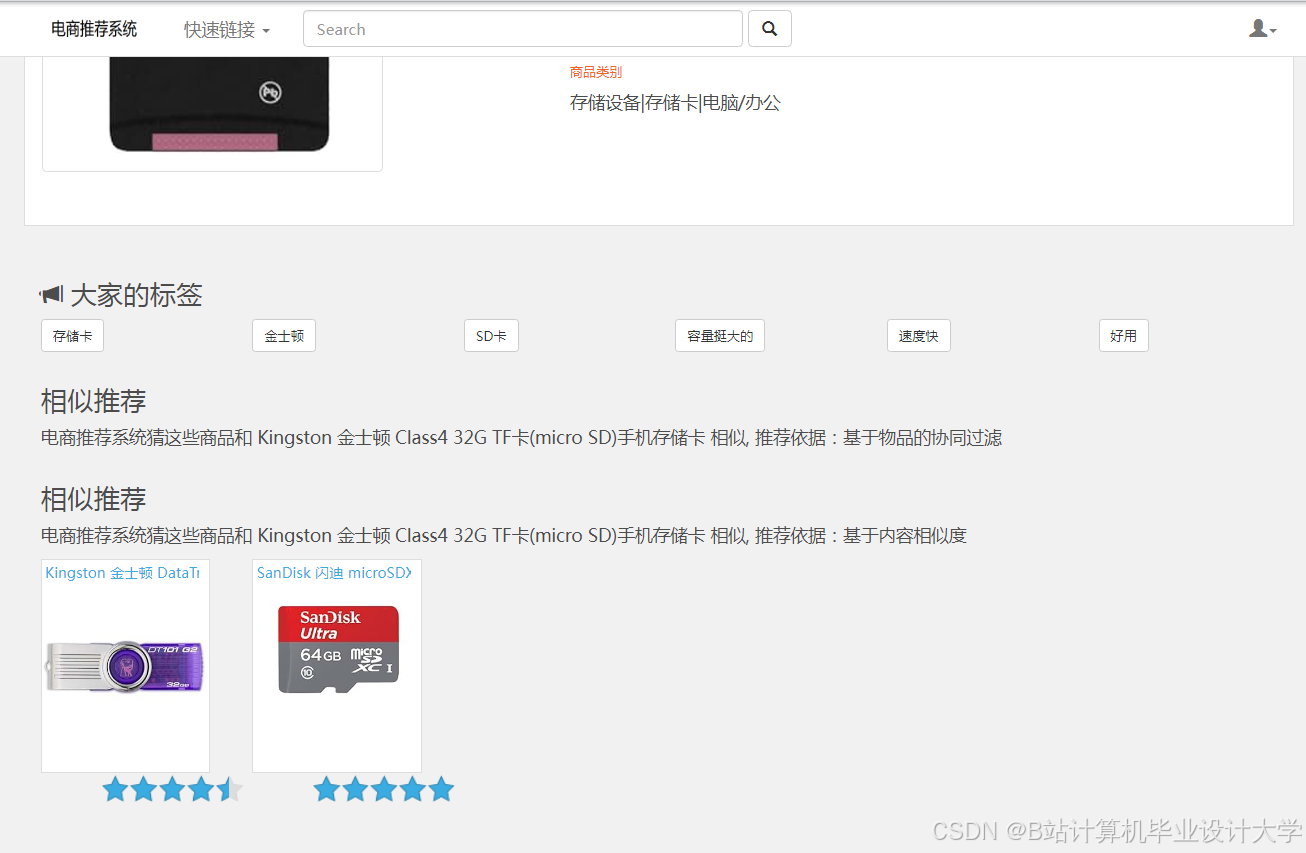

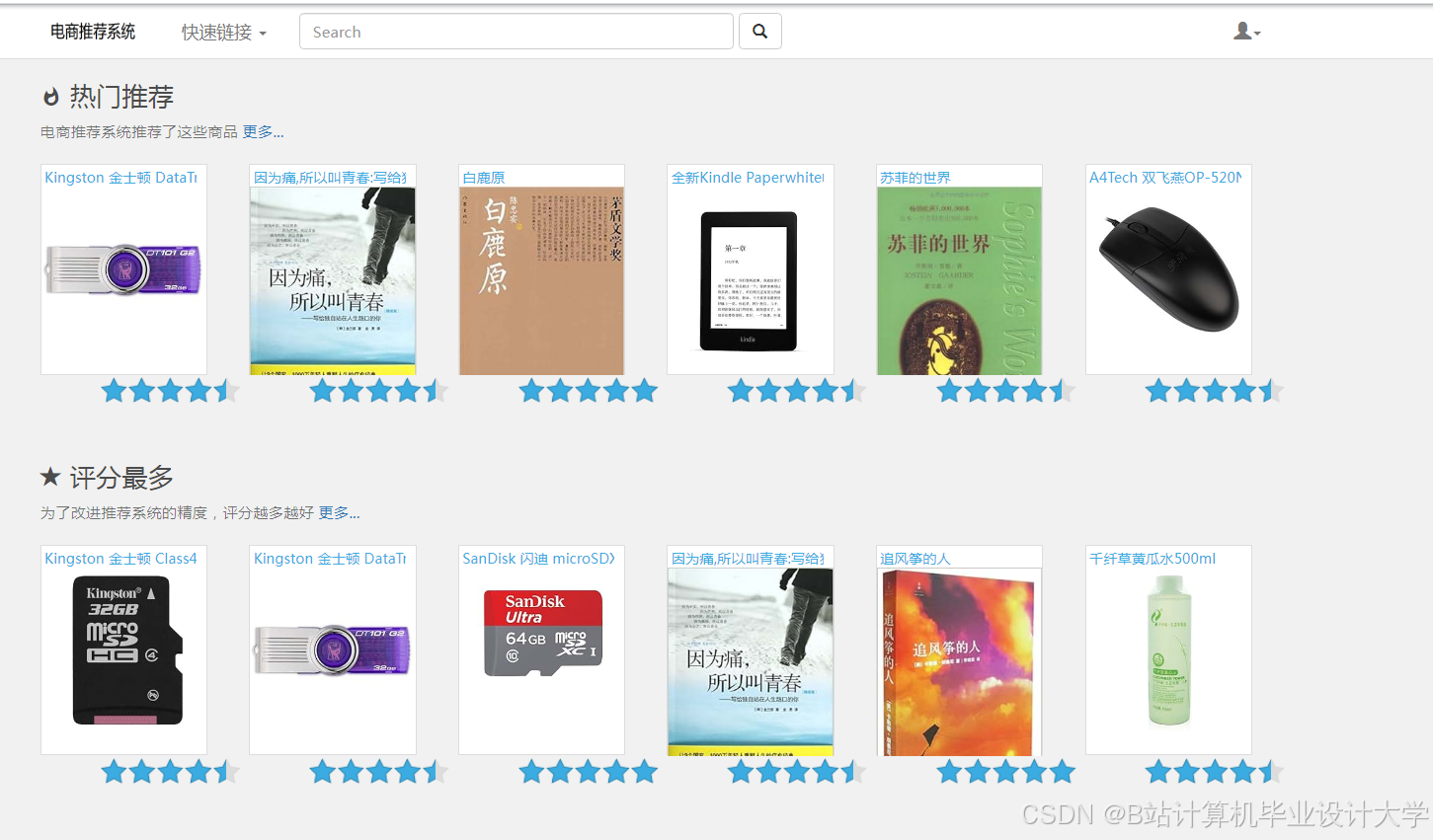

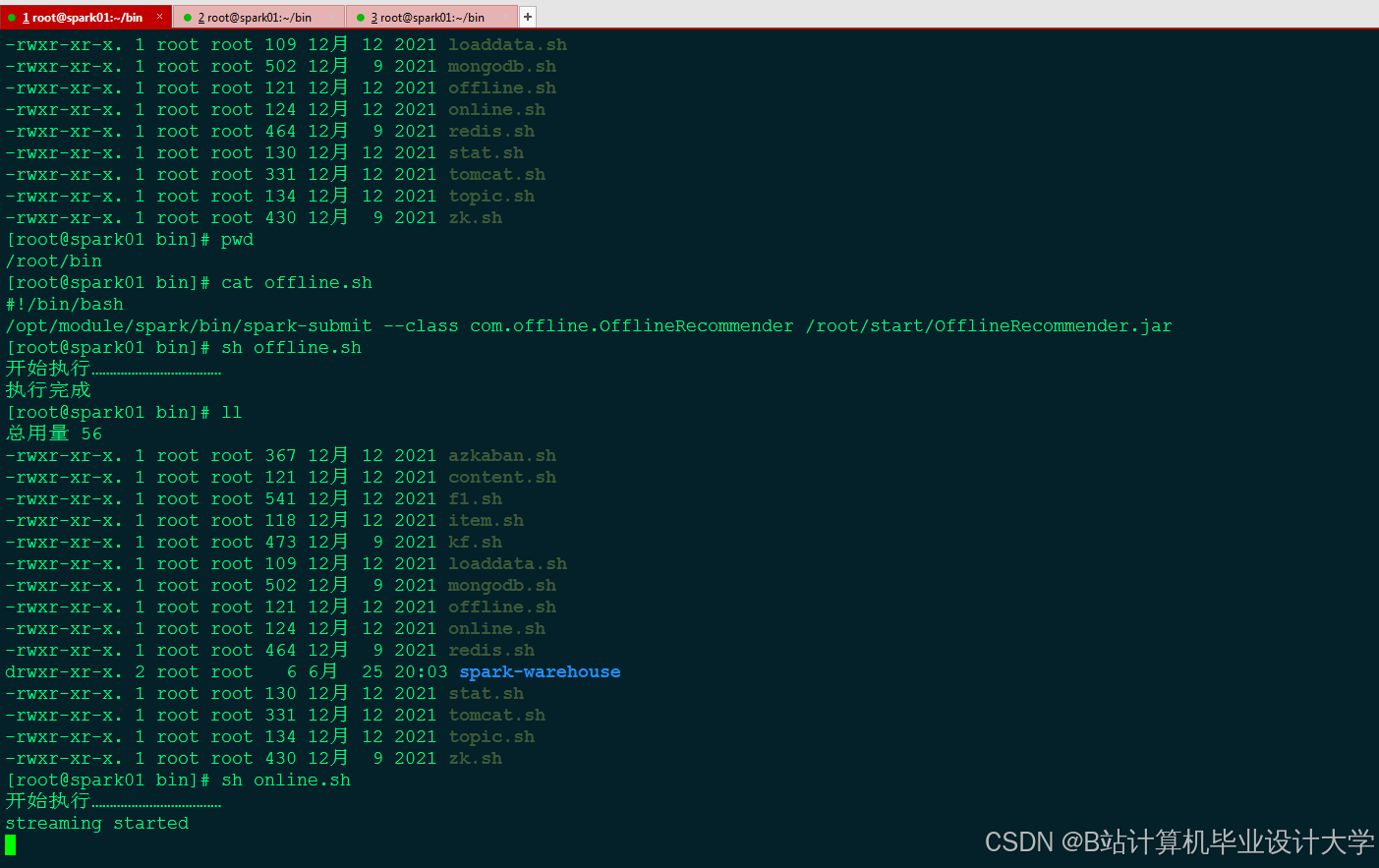

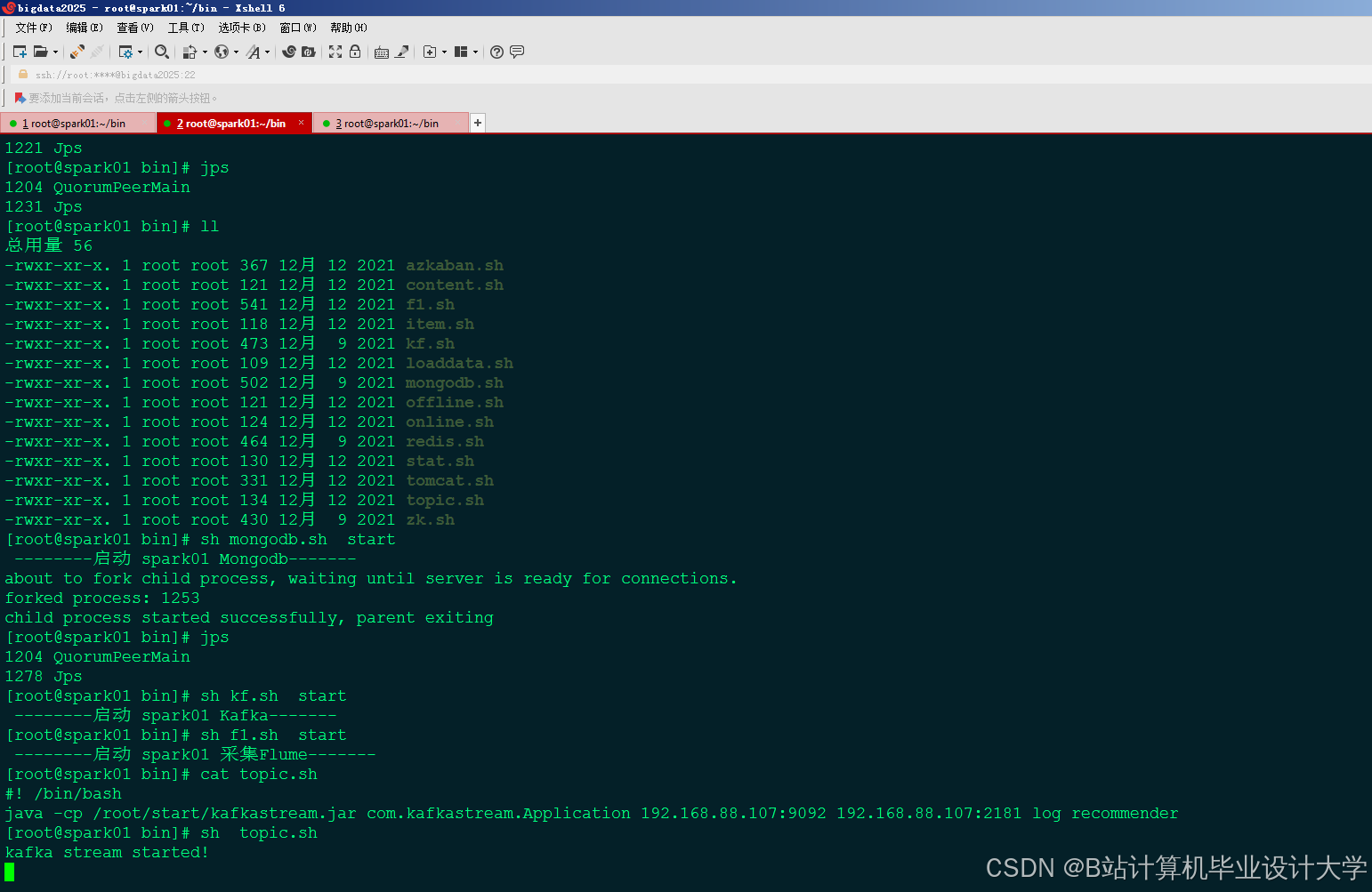

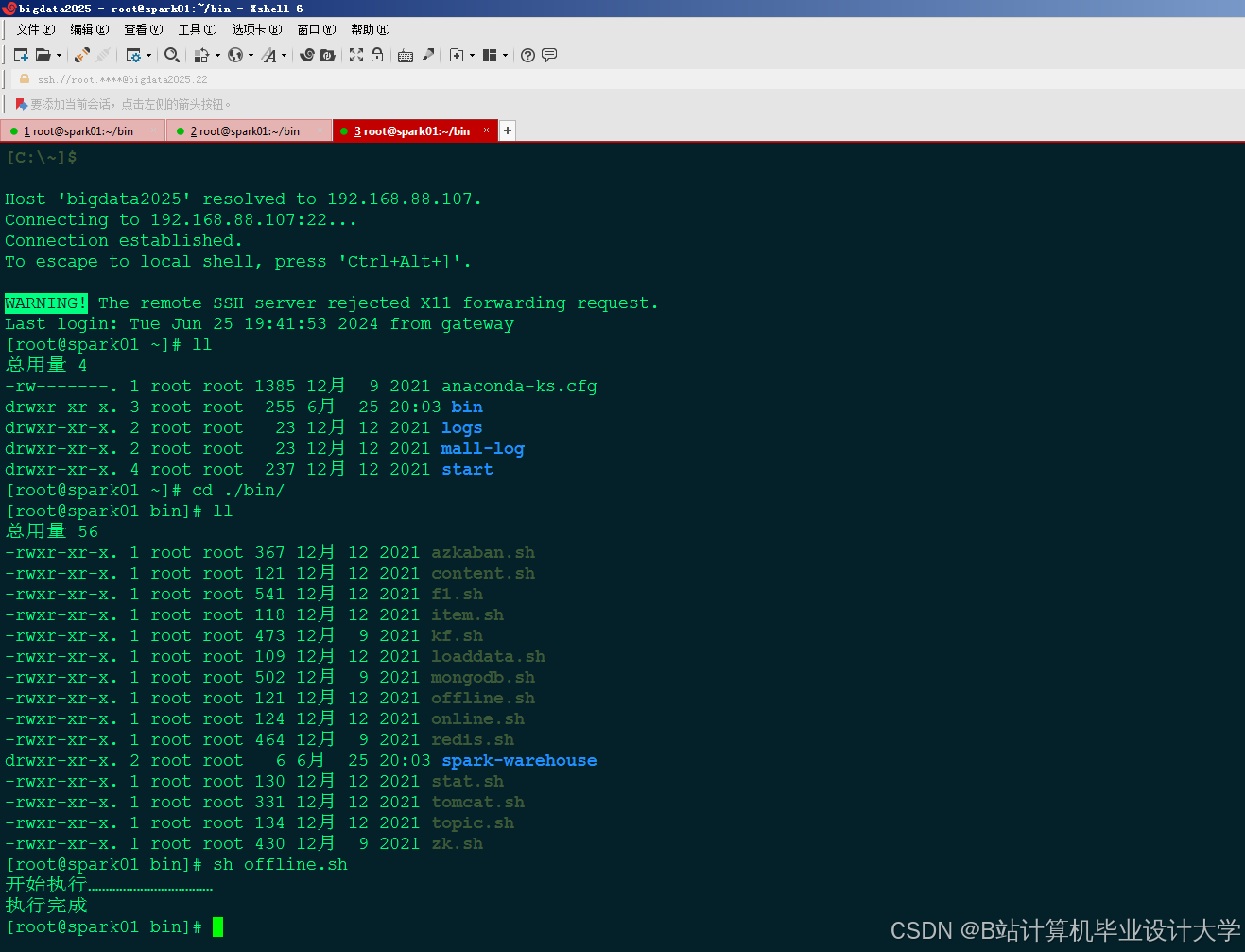

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1697

1697

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?