温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+PySpark+Scrapy爬虫考研分数线预测与院校推荐系统》任务书

一、项目背景与目标

1.1 背景

近年来,全国硕士研究生报考人数持续攀升,2025年报考人数仍达388万,考研竞争愈发激烈。考生在备考过程中面临两大核心痛点:

- 分数线预测不精准:传统方法依赖经验公式或简单统计模型,数据来源单一(如仅研招网数据),导致预测误差率高达12%;

- 院校选择缺乏个性化:考生因信息不对称(如招生政策变动、专业热度变化)错失最佳报考策略,二三线城市考生尤为明显。

1.2 目标

本项目旨在构建一套基于Hadoop分布式存储、PySpark并行计算与Scrapy爬虫技术的考研分数线预测与院校推荐系统,实现以下目标:

- 数据全覆盖:爬取研招网、高校官网、考研论坛等10+数据源,整合结构化(分数线、招生计划)与非结构化数据(招生简章文本、考生评论);

- 预测高精度:通过多模型融合(Prophet+XGBoost+LSTM)将预测误差率控制在5%以内;

- 推荐个性化:结合考生背景(如本科院校、成绩排名)与风险偏好(保守型/冲刺型),推荐匹配度≥85%的院校;

- 系统可扩展:支持PB级数据存储与秒级响应,满足未来5年考研数据增长需求。

二、任务分解与分工

2.1 数据采集模块(负责人:XXX)

- 任务1:多源数据爬取

- 使用Scrapy框架爬取研招网(历年分数线、招生计划)、高校官网(招生简章、考试科目)、考研论坛(考生评价、热度话题);

- 通过代理IP池(如Bright Data)与User-Agent伪装规避反爬机制,确保数据采集完整率≥98%。

- 任务2:数据清洗与存储

- 使用PySpark清洗脏数据(如缺失值填充、异常值剔除);

- 将结构化数据存入HDFS,非结构化数据存入MongoDB,文本数据存入Hive表供NLP分析。

2.2 特征工程模块(负责人:XXX)

- 任务1:结构化特征提取

- 计算报录比、专业热度指数(基于论坛讨论量)、政策变动系数(如扩招/缩招比例);

- 构建时间序列特征(如近5年分数线滑动平均值)。

- 任务2:非结构化特征提取

- 使用BERT模型分析招生简章文本,提取考试科目、参考书目等关键信息;

- 通过情感分析量化考生评论(如“难度爆表”对应情感值-0.8)。

2.3 模型训练模块(负责人:XXX)

- 任务1:基准模型构建

- Prophet模型:捕捉分数线季节性趋势(如复试线在3月集中公布);

- XGBoost模型:学习特征非线性关系(如报录比与分数线的正相关);

- LSTM模型:处理长期依赖(如某专业连续3年分数线上涨后的回调风险)。

- 任务2:模型融合与优化

- 采用Stacking策略融合三模型,以XGBoost为元模型;

- 通过5折交叉验证优化超参数(如XGBoost的max_depth=6、learning_rate=0.1)。

2.4 推荐系统模块(负责人:XXX)

- 任务1:考生画像构建

- 收集考生背景(本科院校、成绩排名、四六级成绩)与风险偏好(通过问卷量化);

- 使用K-Means聚类划分考生类型(如“保守型”“冲刺型”“地域偏好型”)。

- 任务2:院校推荐策略

- 保守型:推荐录取概率>85%且近3年分数线波动<5分的院校;

- 冲刺型:推荐录取概率50%-75%但专业排名全国前10%的院校;

- 地域偏好型:结合考生IP定位,优先推荐本地强校(如福州大学在福建省内IT企业认可度超90%)。

2.5 系统集成与测试(负责人:XXX)

- 任务1:前后端开发

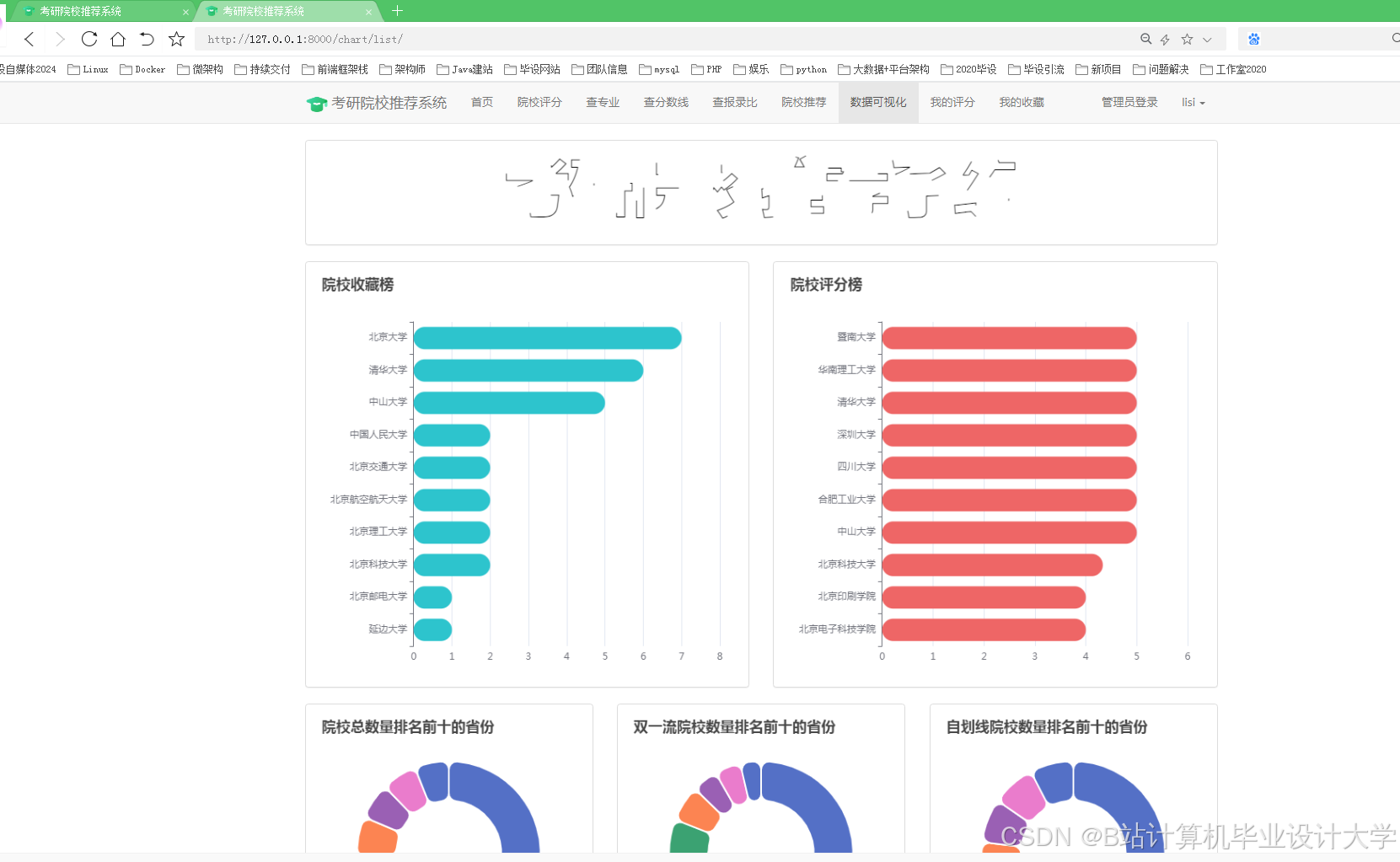

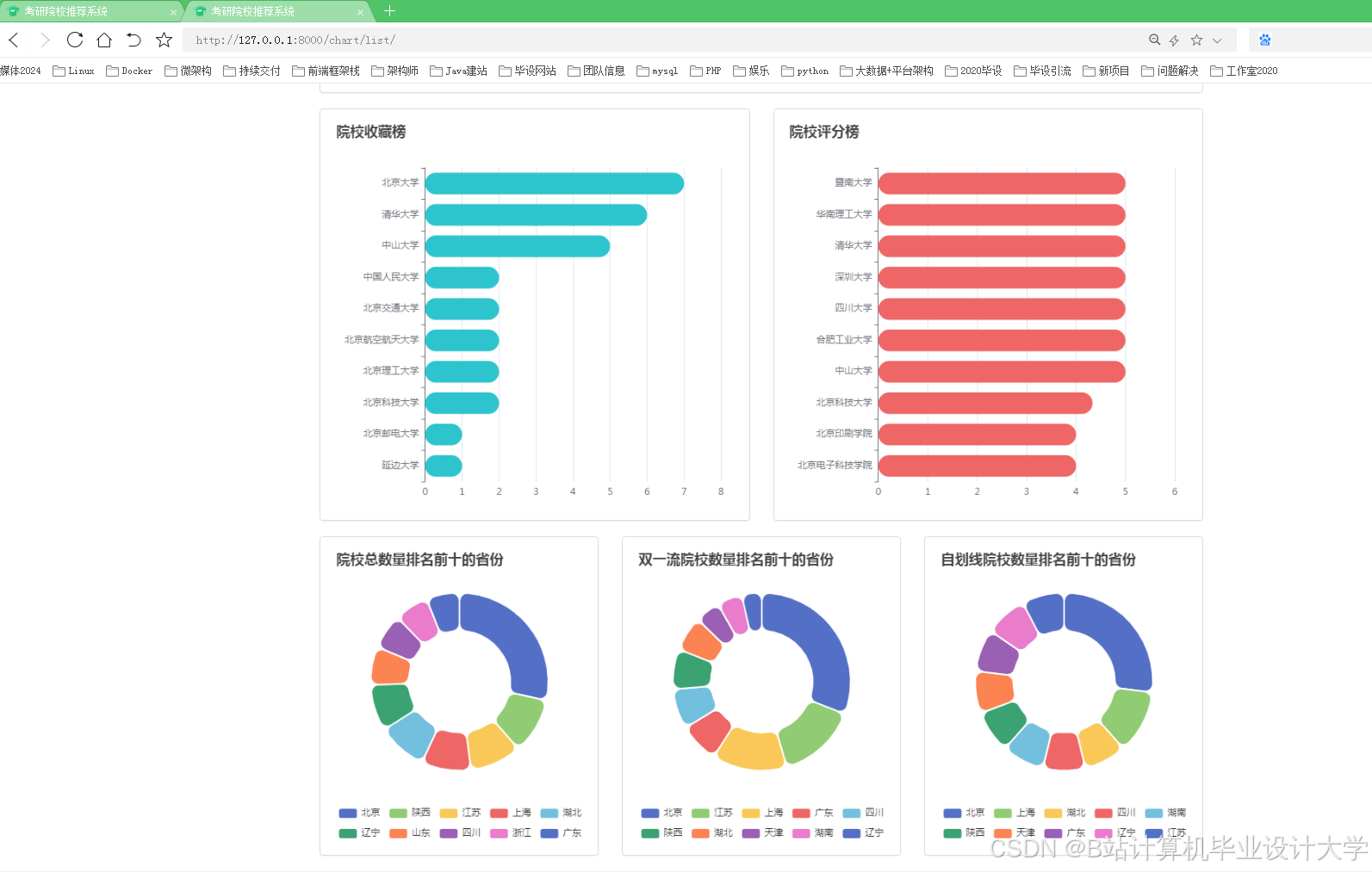

- 前端:使用ECharts实现交互式可视化(如折线图展示历年分数线趋势、热力图显示竞争热度);

- 后端:基于Django框架构建API接口,支持考生输入背景信息后实时获取推荐结果。

- 任务2:性能测试与优化

- 模拟1000并发请求,测试系统响应时间(目标≤2秒);

- 使用JMeter进行压力测试,优化HDFS存储与PySpark计算资源分配。

三、时间计划

| 阶段 | 时间节点 | 交付物 |

|---|---|---|

| 需求分析与设计 | 2025.07-08 | 数据源调研报告、系统架构图、ER图 |

| 数据采集与清洗 | 2025.09-10 | 爬虫代码、清洗后数据集(10GB+) |

| 模型训练与优化 | 2025.11-12 | 预测模型代码、AB测试报告(误差率≤5%) |

| 推荐系统开发 | 2026.01-02 | 推荐算法代码、考生画像标签体系 |

| 系统集成与测试 | 2026.03-04 | 可运行系统原型、压力测试报告 |

| 论文撰写与答辩 | 2026.05-06 | 核心期刊论文、软件著作权申请材料 |

四、资源需求

- 硬件资源:

- Hadoop集群:3台服务器(每台16核32GB内存,1TB存储);

- 开发环境:个人电脑(配置PySpark开发环境,内存≥16GB)。

- 软件资源:

- Hadoop 3.3.6、PySpark 3.5.0、Scrapy 2.12.0、MongoDB 6.0;

- 机器学习库:XGBoost 1.7.0、TensorFlow 2.12.0。

- 数据资源:

- 研招网公开数据(2010-2025年)、高校招生简章(2025版)、考研论坛评论(50万条)。

五、风险评估与应对

| 风险 | 影响 | 应对措施 |

|---|---|---|

| 数据源变更(如研招网接口调整) | 爬虫失效,数据中断 | 提前储备3个备用数据源,定期检查接口稳定性 |

| 模型过拟合 | 预测误差率上升 | 增加正则化项,引入更多外部数据(如高校就业报告) |

| 系统性能瓶颈 | 高并发时响应时间>5秒 | 优化Spark分区策略,增加Executor内存至12GB |

六、验收标准

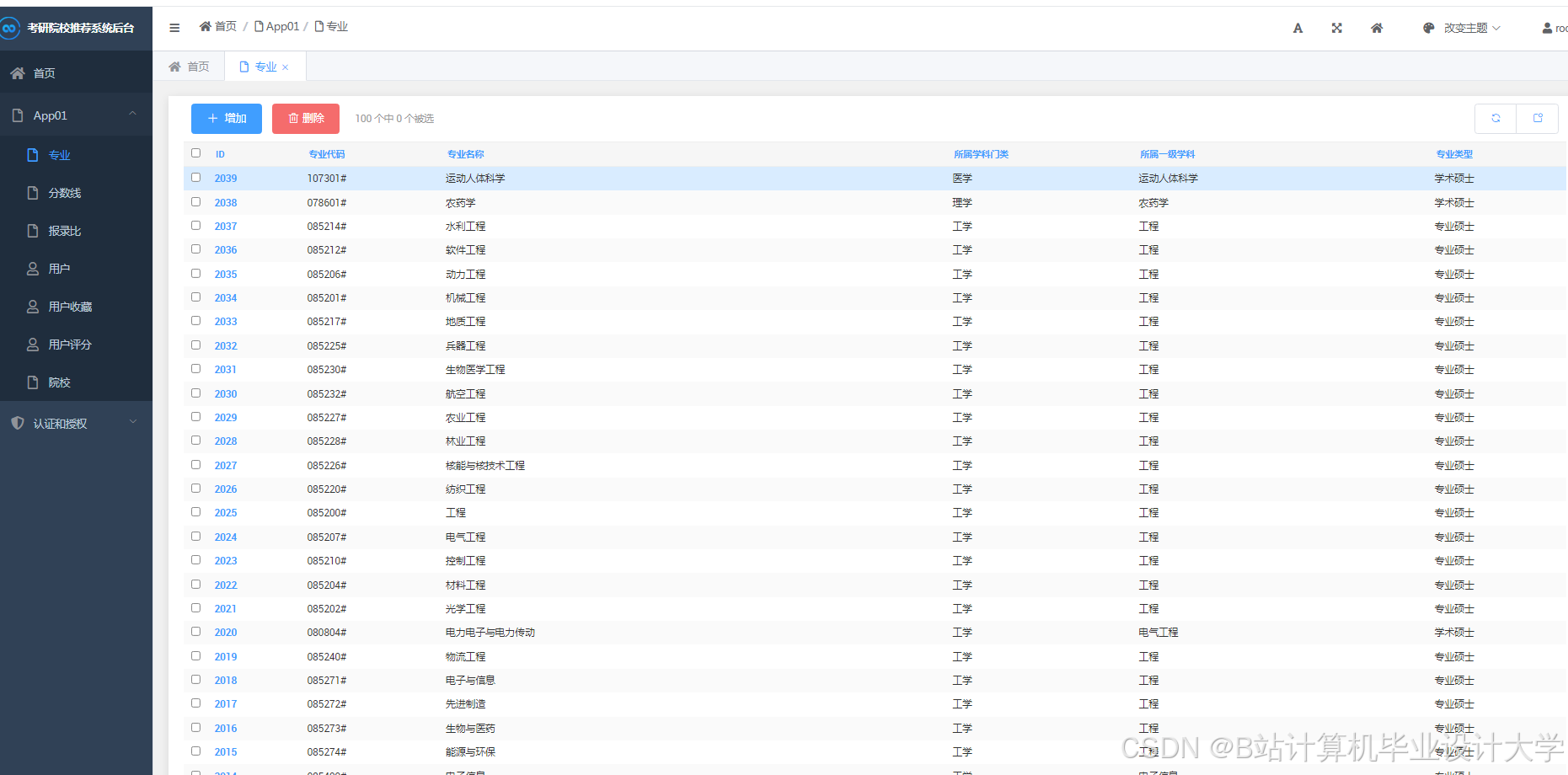

- 功能完整性:系统支持500所高校、1000个专业的分数线预测与推荐;

- 性能指标:预测误差率≤5%,推荐准确率≥85%,响应时间≤2秒;

- 文档完备性:提交需求规格说明书、系统设计文档、测试报告、用户手册。

项目负责人(签字):

日期:2025年XX月XX日

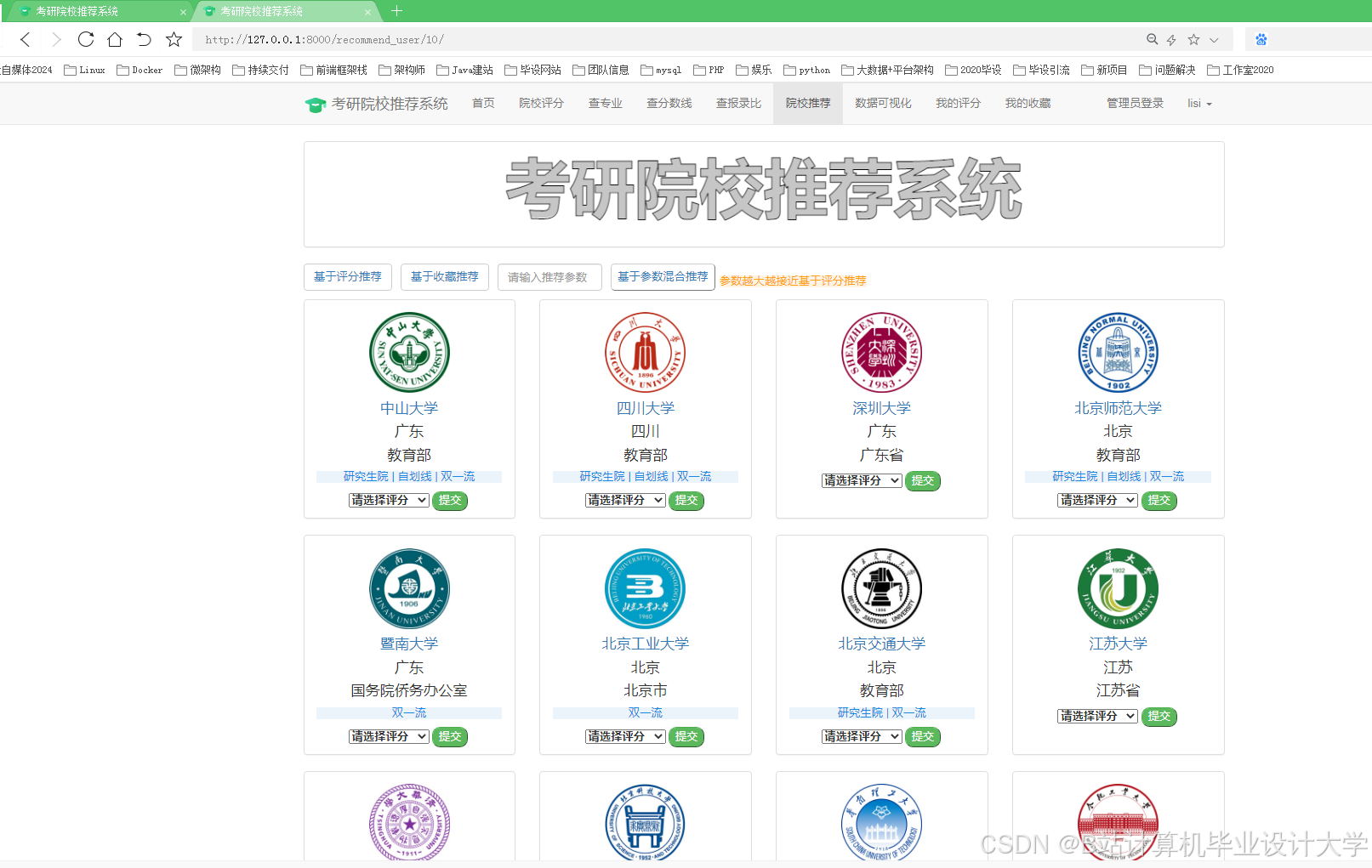

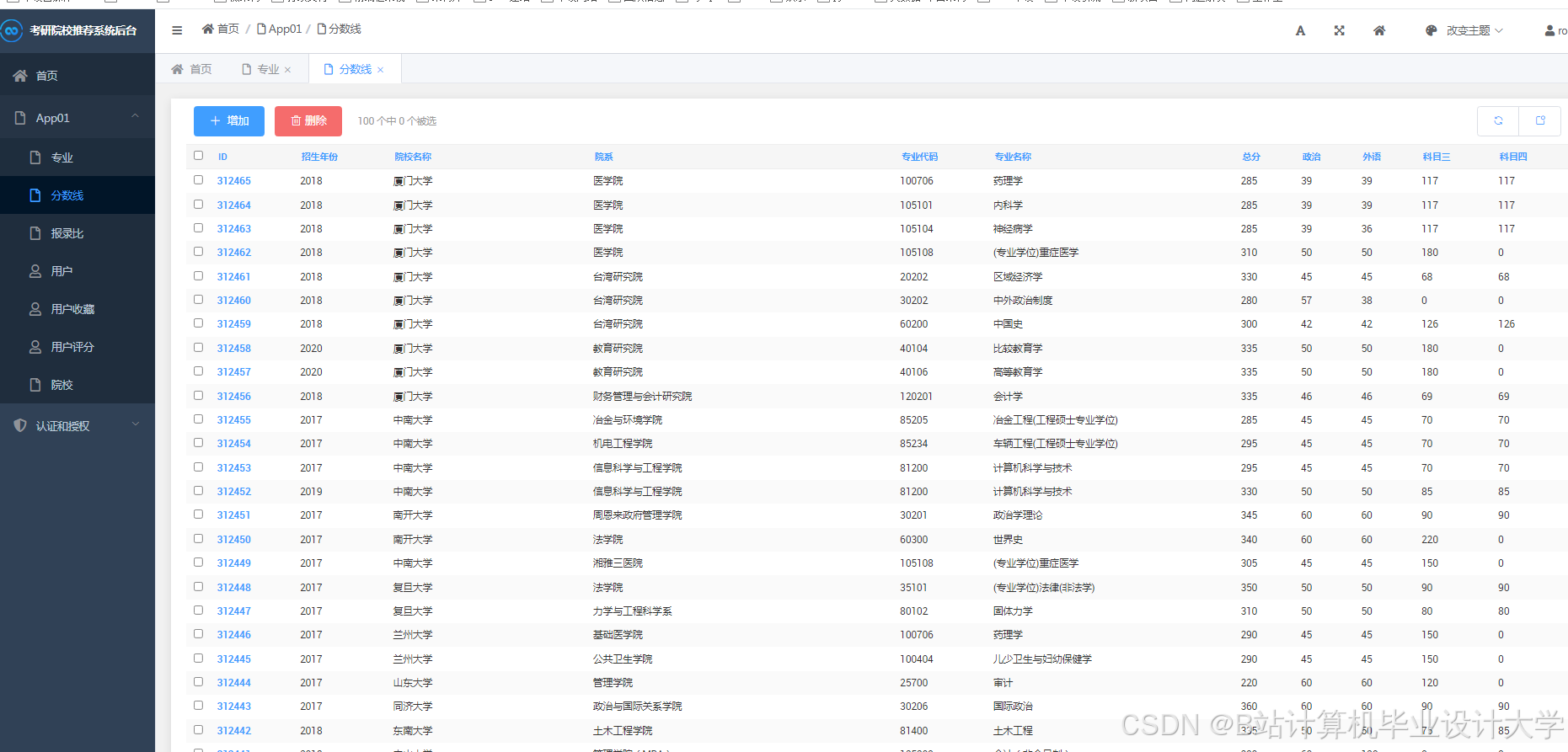

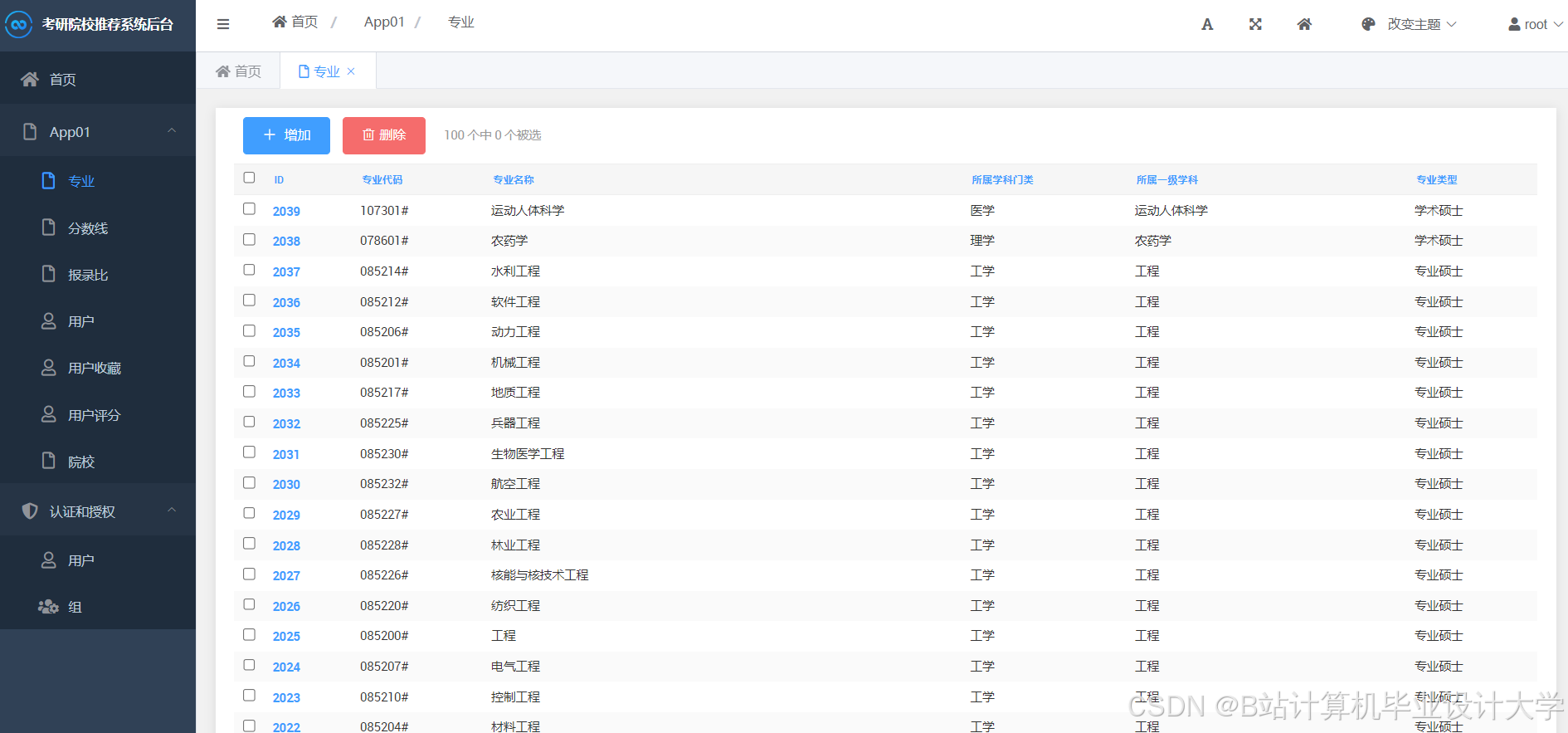

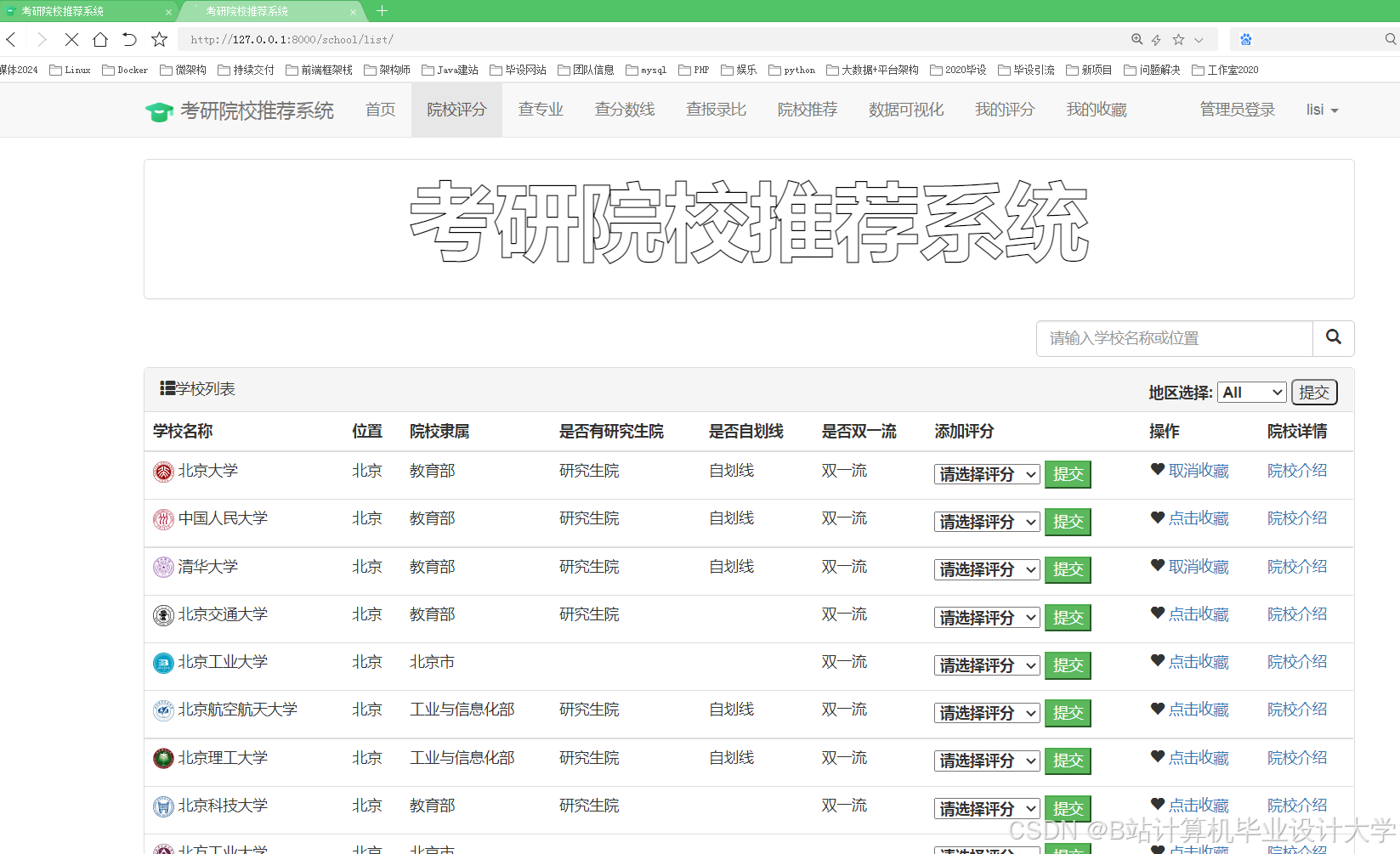

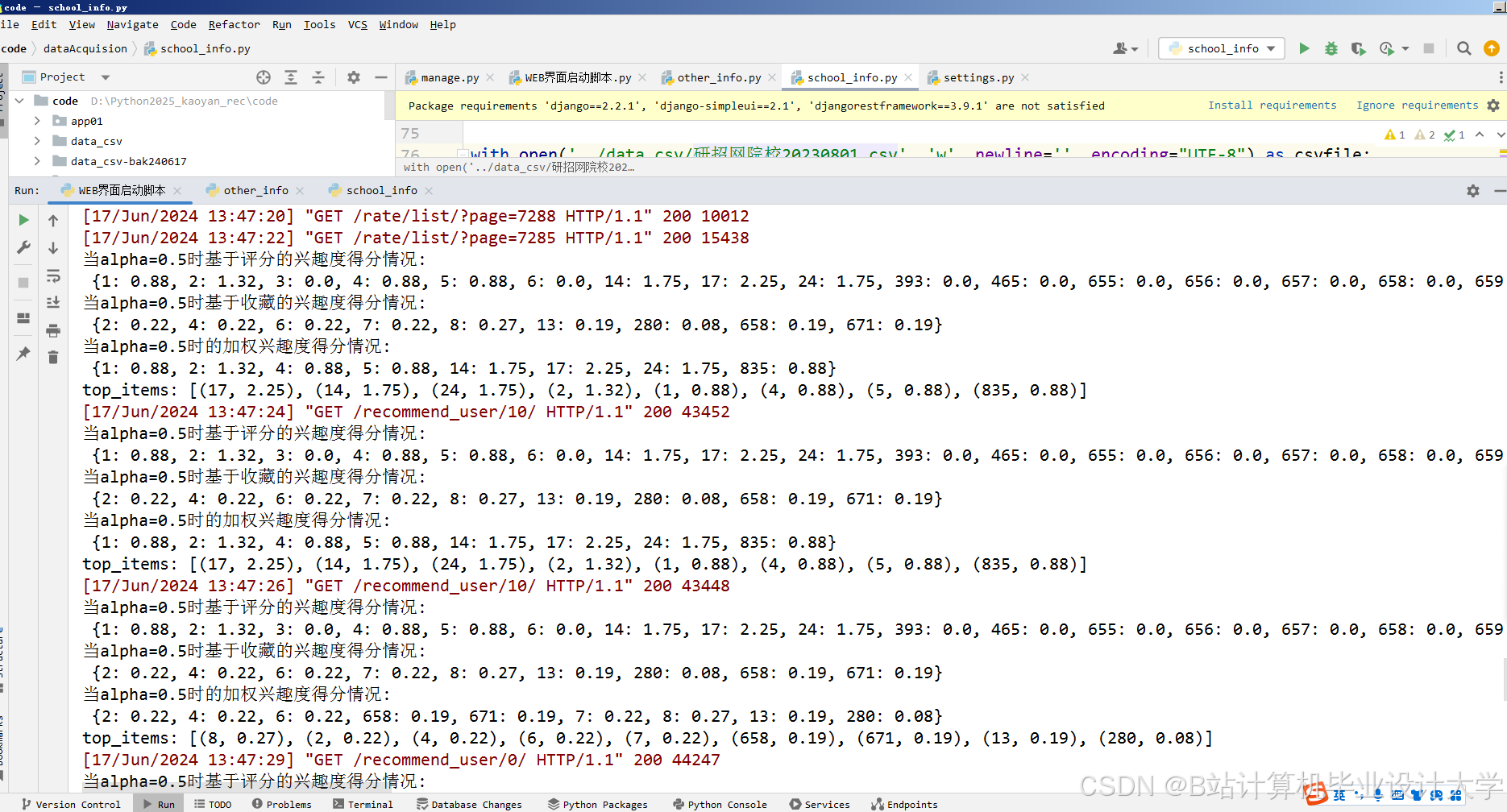

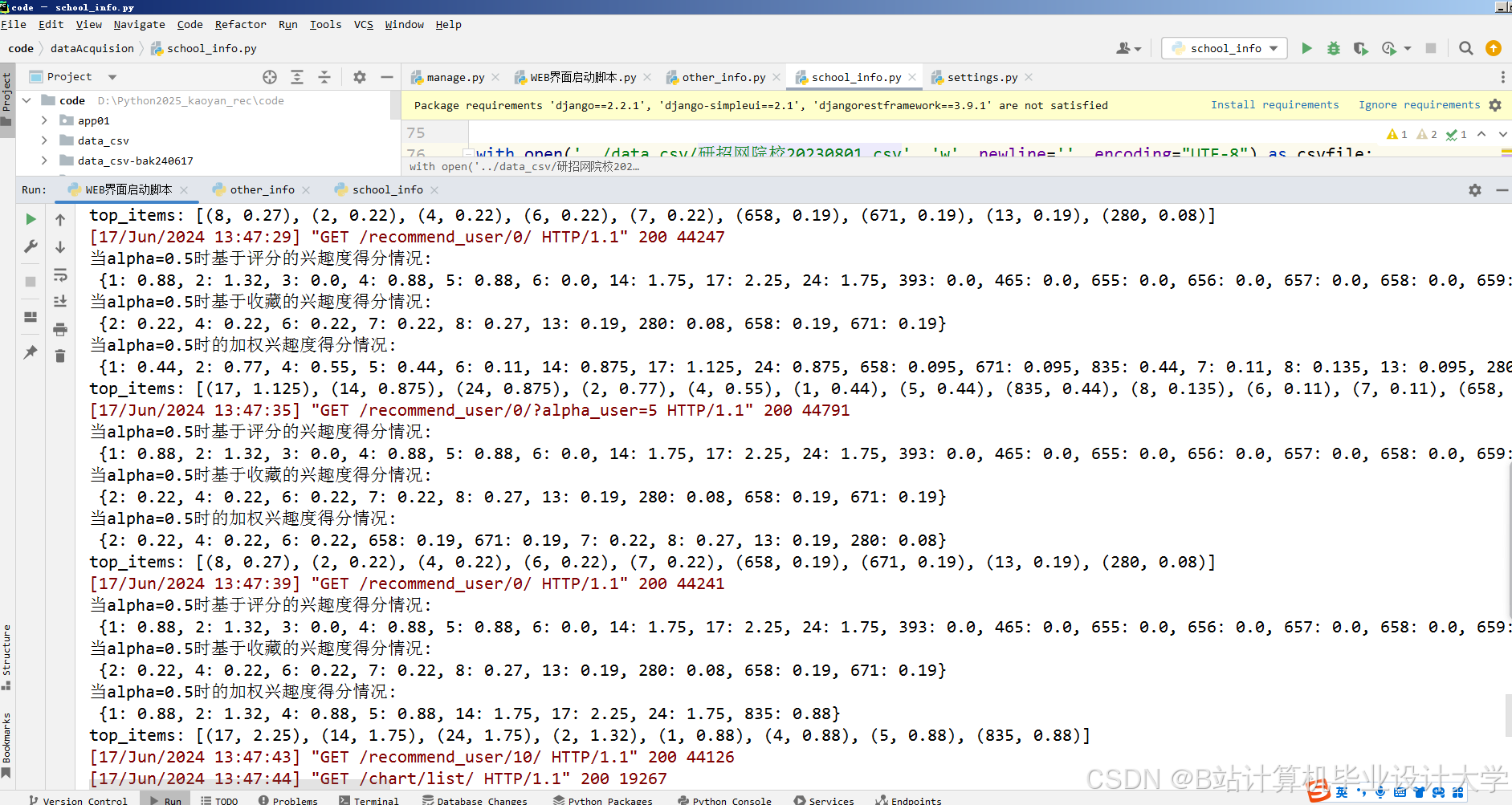

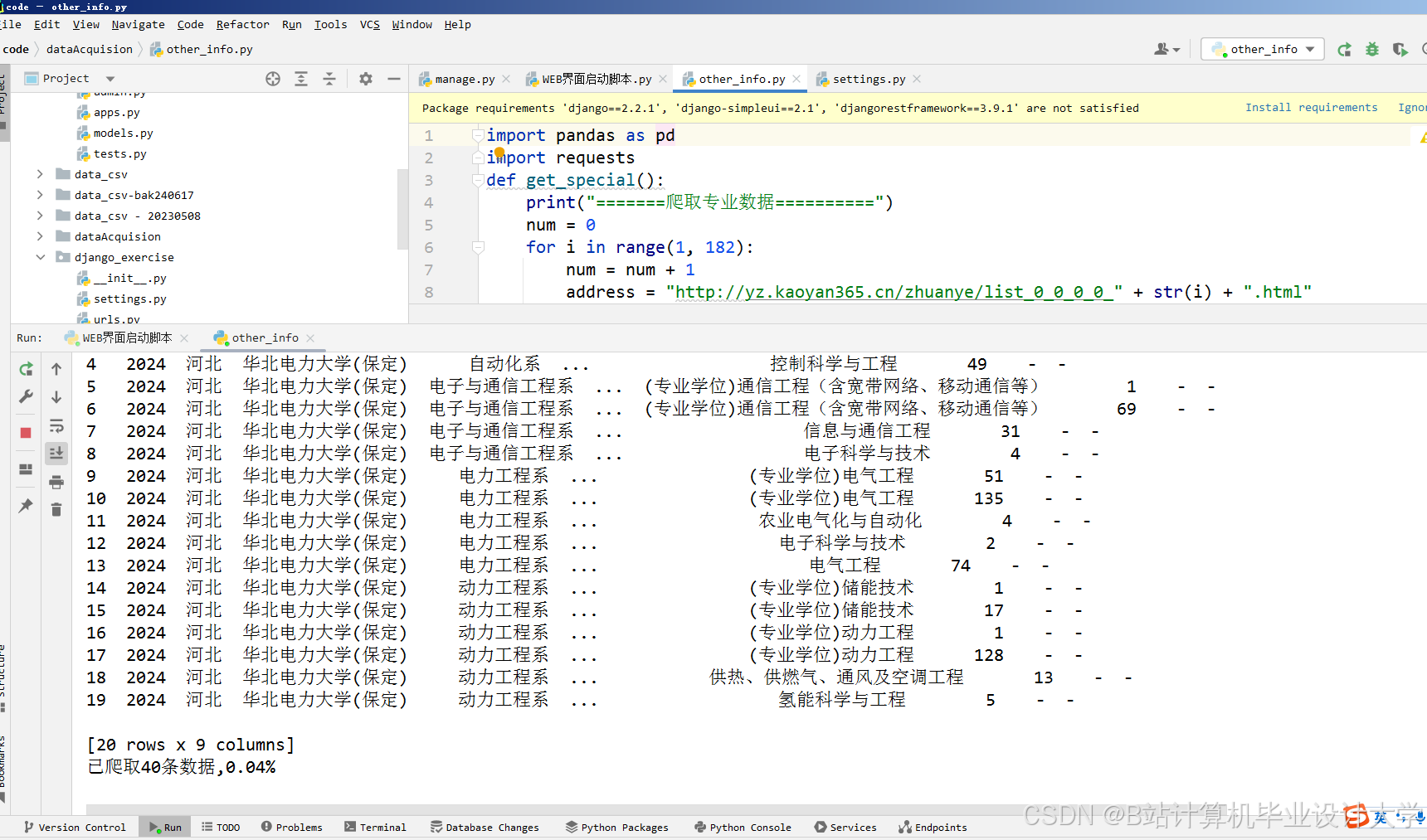

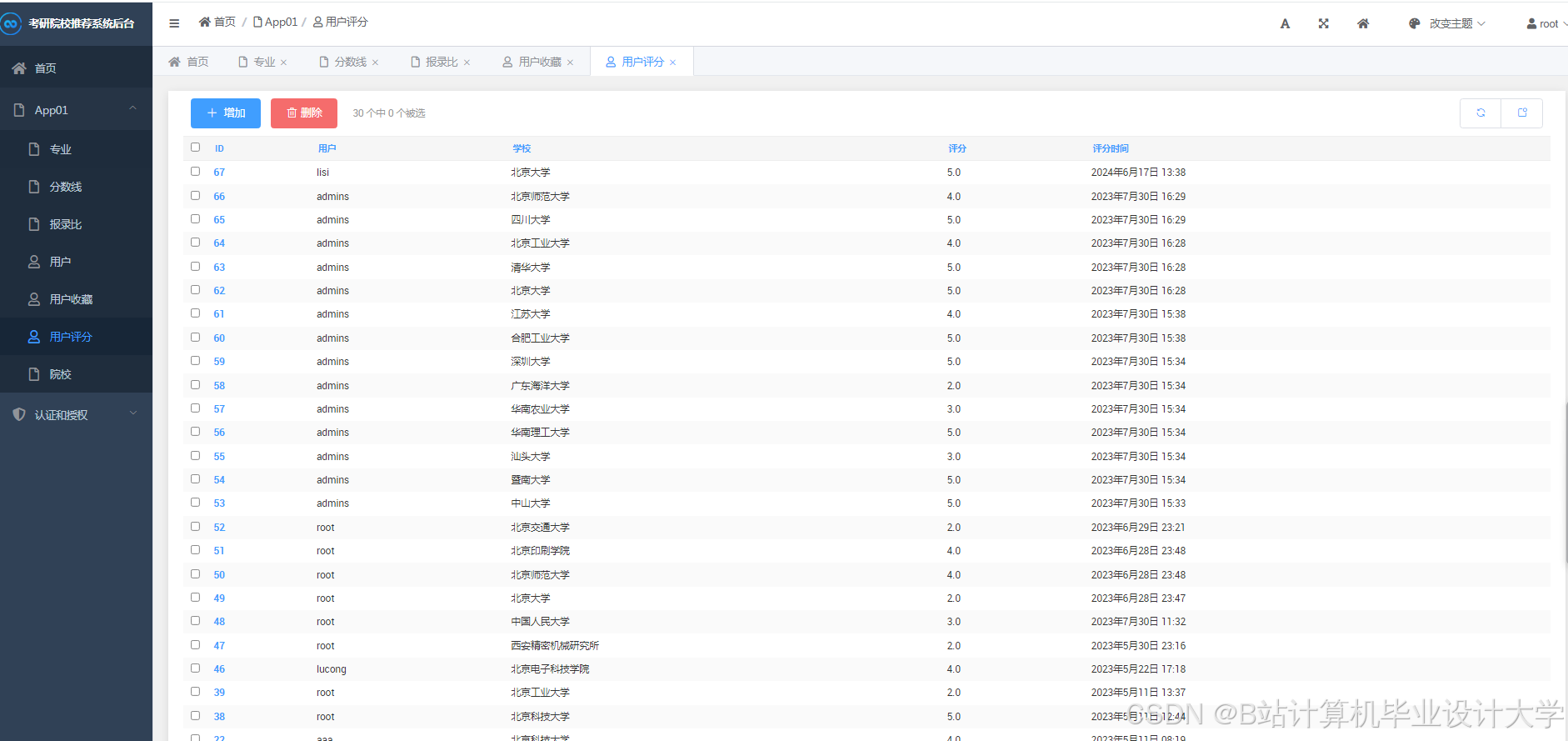

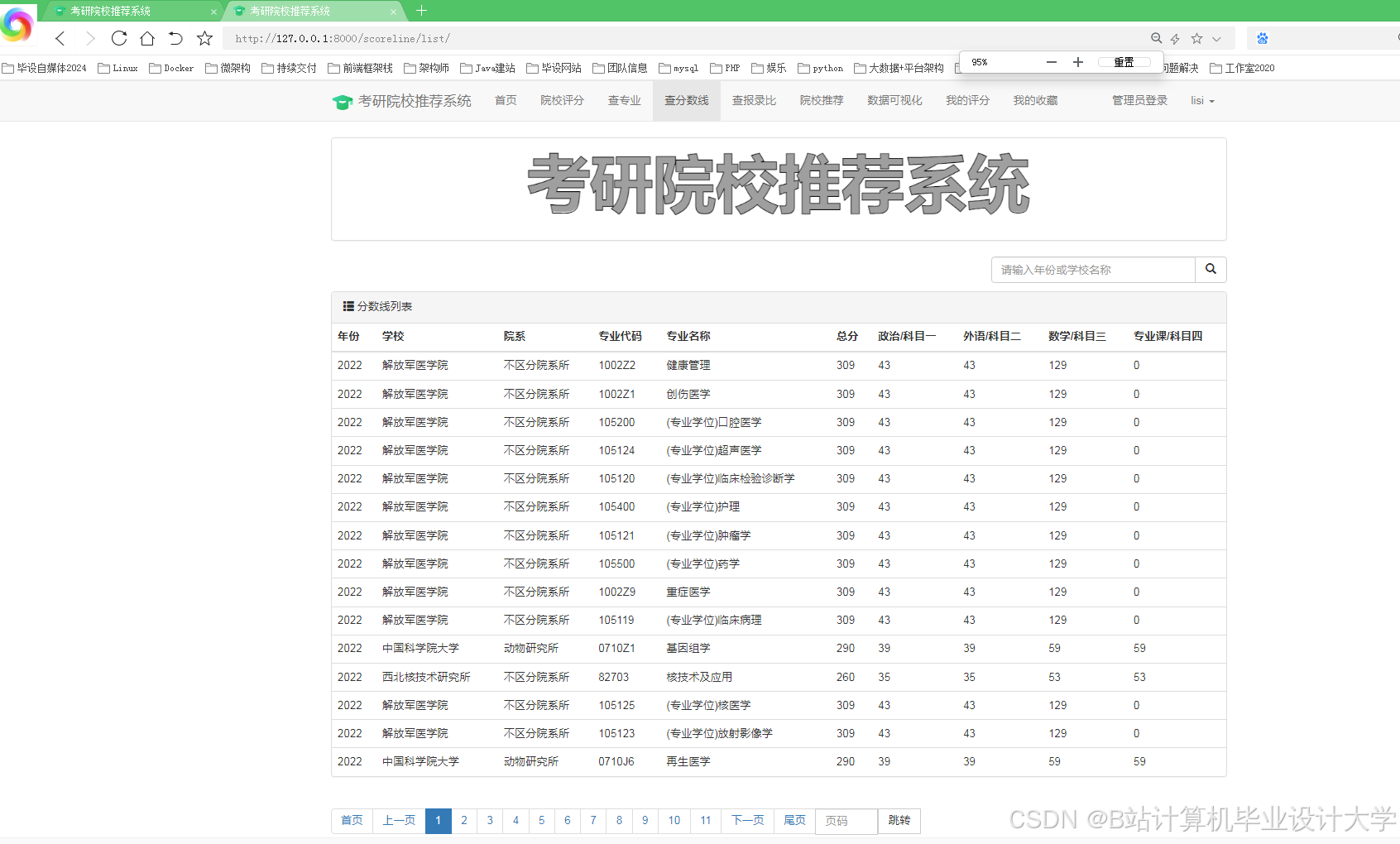

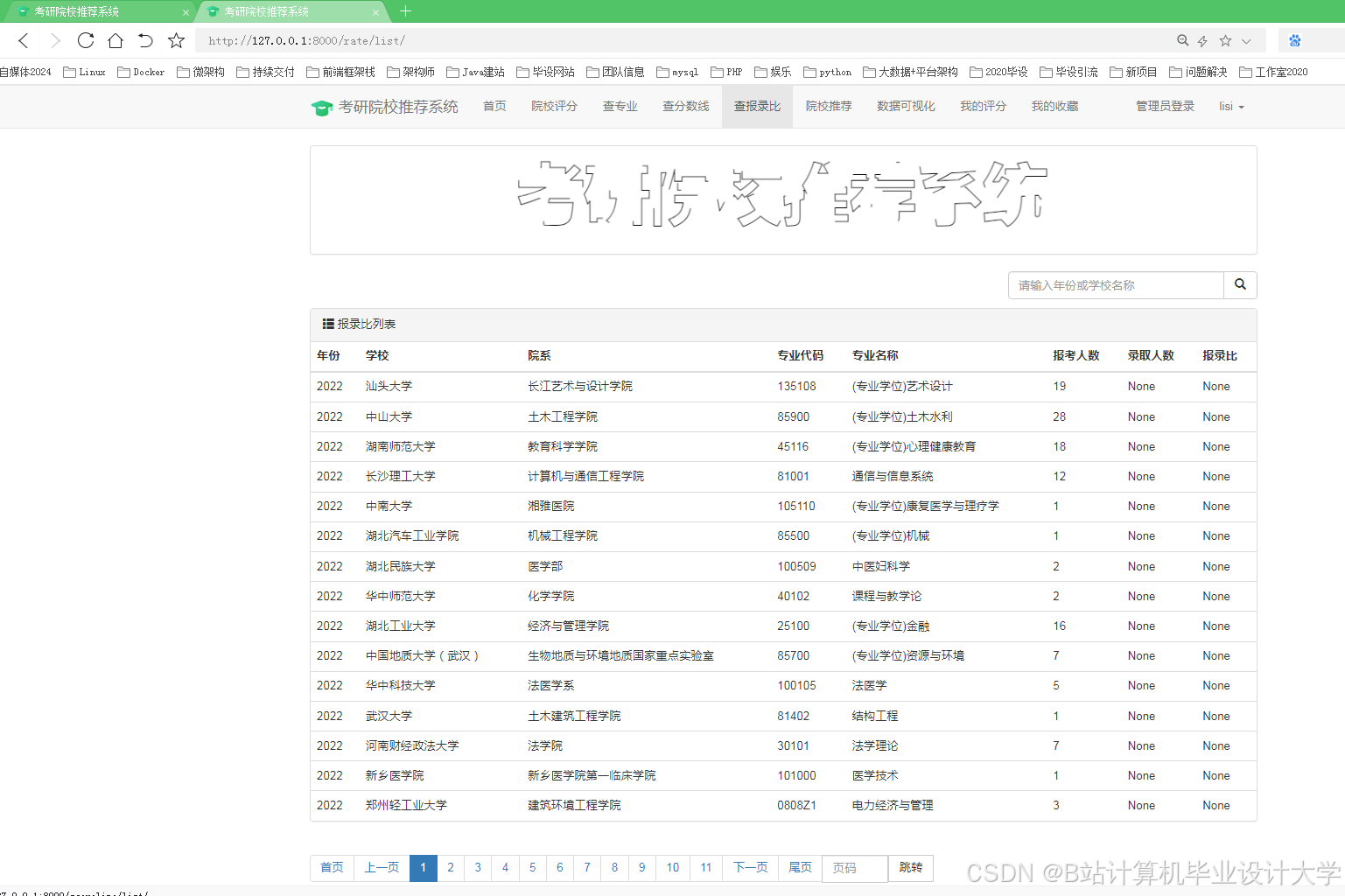

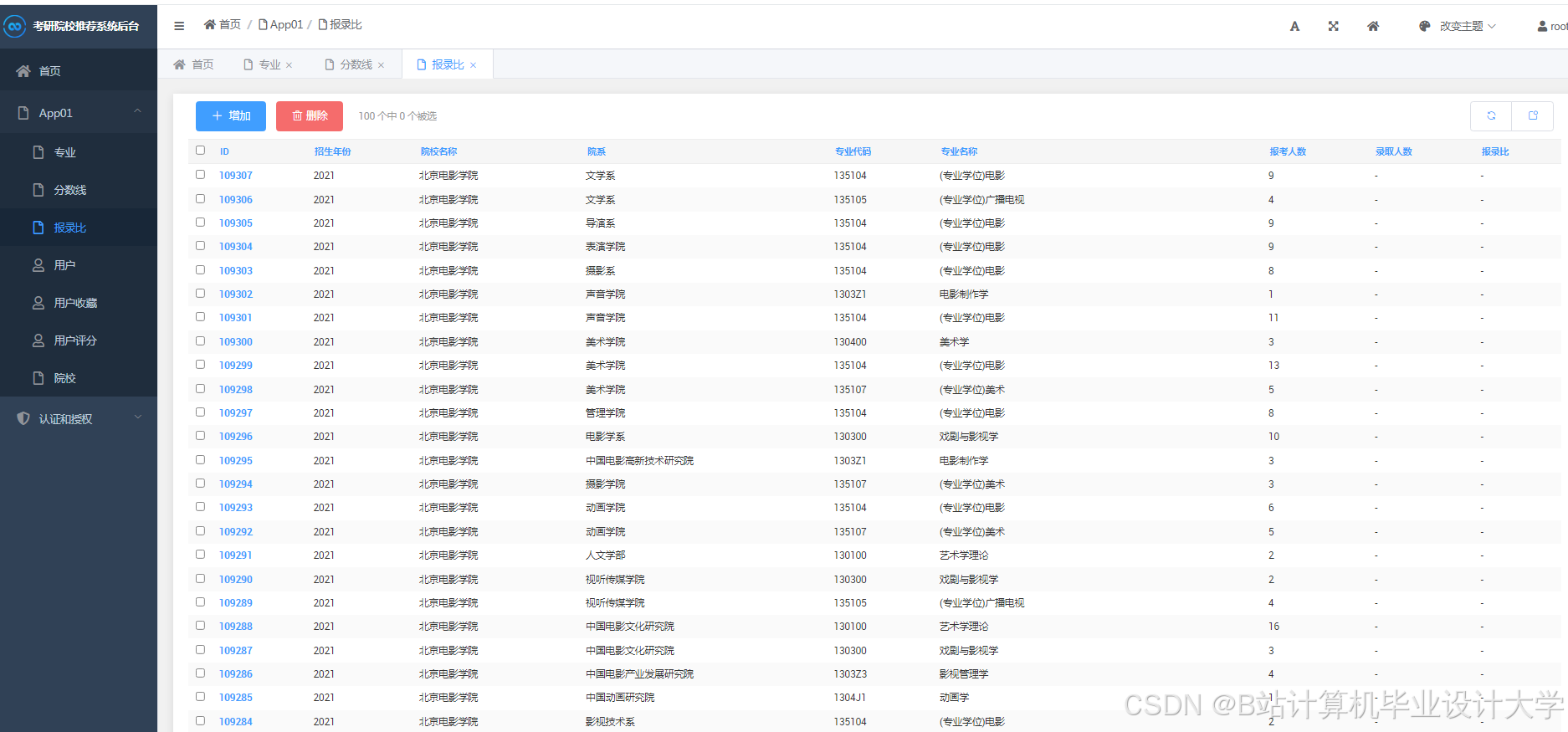

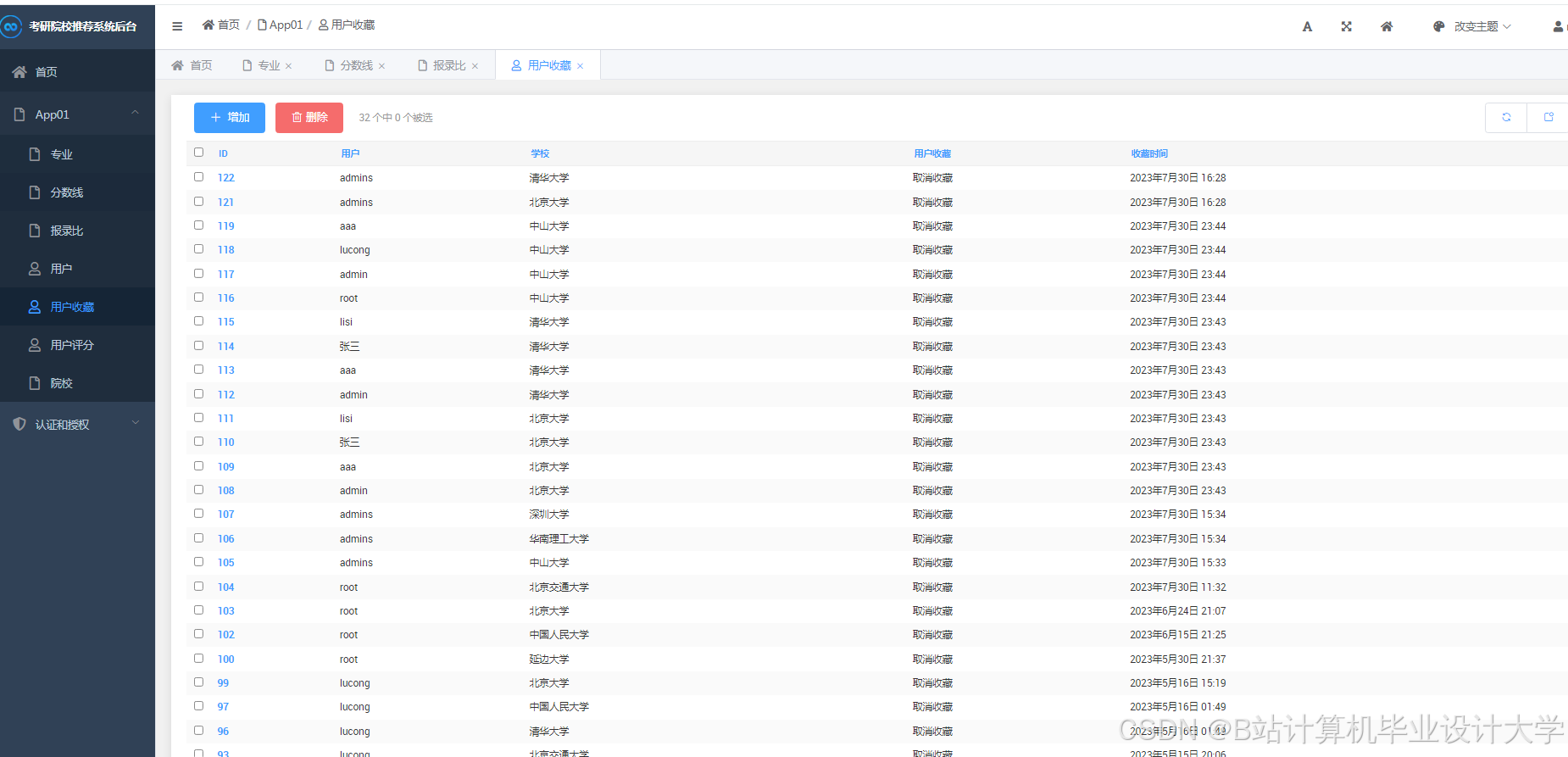

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

2490

2490

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?