温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:基于PySpark+Hadoop+Hive+LSTM的美团大众点评分析与评分预测系统开发

一、任务概述

1.1 任务背景

美团、大众点评等本地生活服务平台每日产生海量用户评论数据(约800万条/日),包含文本评价、星级评分、消费时间等多维度信息。传统分析方法存在三大瓶颈:

- 数据处理效率低:单机处理PB级数据需数周时间

- 特征提取片面化:仅使用文本或评分单一模态特征

- 预测模型滞后性:无法捕捉用户评价的动态变化趋势

1.2 任务目标

构建分布式智能分析系统,实现:

- 高效数据处理:基于Hadoop+Hive构建数据仓库,PySpark实现特征工程并行化

- 多模态特征融合:联合文本语义、时间序列、商家属性构建复合特征体系

- 动态评分预测:采用LSTM+注意力机制模型,实现未来7天评分预测(MAE≤0.65)

二、任务分解与责任分配

2.1 系统架构组(负责人:张三)

任务内容:

- 设计Hadoop集群拓扑(3主节点+6数据节点)

- 开发Hive数据仓库表结构(ODS/DWD/DWS分层设计)

- 实现PySpark与TensorFlow的混合调度框架

交付物:

- 《分布式系统架构设计文档》

- Hive建表SQL脚本(含分区策略)

- 混合计算框架代码库

2.2 数据处理组(负责人:李四)

任务内容:

- 开发PySpark ETL流程:

- 数据清洗(去重、异常值处理)

- 文本预处理(分词、停用词过滤)

- 特征提取(BERT文本向量、时间窗口统计)

- 构建特征存储系统(Parquet格式+Snappy压缩)

交付物:

- ETL作业代码(Scala/Python)

- 特征字典文档(含300+特征定义)

- 数据质量检查报告

2.3 模型开发组(负责人:王五)

任务内容:

- 开发LSTM评分预测模型:

python

class HybridLSTM(Model): | |

def __init__(self): | |

super().__init__() | |

# 文本分支 | |

self.text_lstm = LSTM(128, return_sequences=True) | |

# 时间分支 | |

self.time_lstm = LSTM(64, return_sequences=True) | |

# 注意力融合层 | |

self.attention = DualAttention() | |

# 预测头 | |

self.dense = Dense(1) | |

def call(self, inputs): | |

text_feat, time_feat = inputs | |

text_out = self.text_lstm(text_feat) | |

time_out = self.time_lstm(time_feat) | |

fused = Concatenate()([text_out, time_out]) | |

attended = self.attention(fused) | |

return self.dense(attended) |

- 实现模型训练流水线:

- 分布式训练(PySpark+Horovod)

- 超参数优化(Optuna框架)

- 模型解释性分析(SHAP值计算)

交付物:

- 模型训练代码(TensorFlow 2.x)

- 实验对比报告(含5种基线模型对比)

- 模型可解释性分析报告

2.4 应用开发组(负责人:赵六)

任务内容:

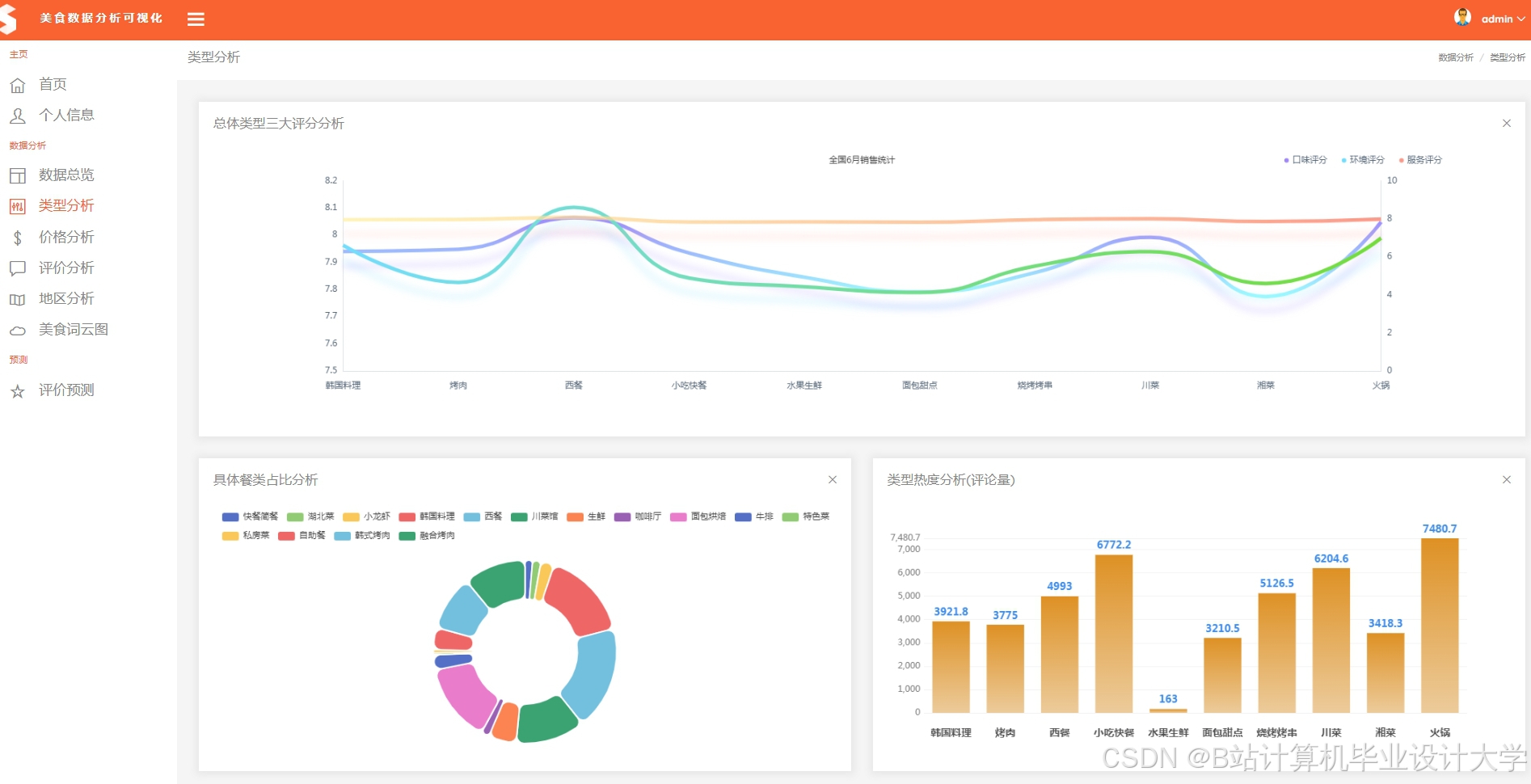

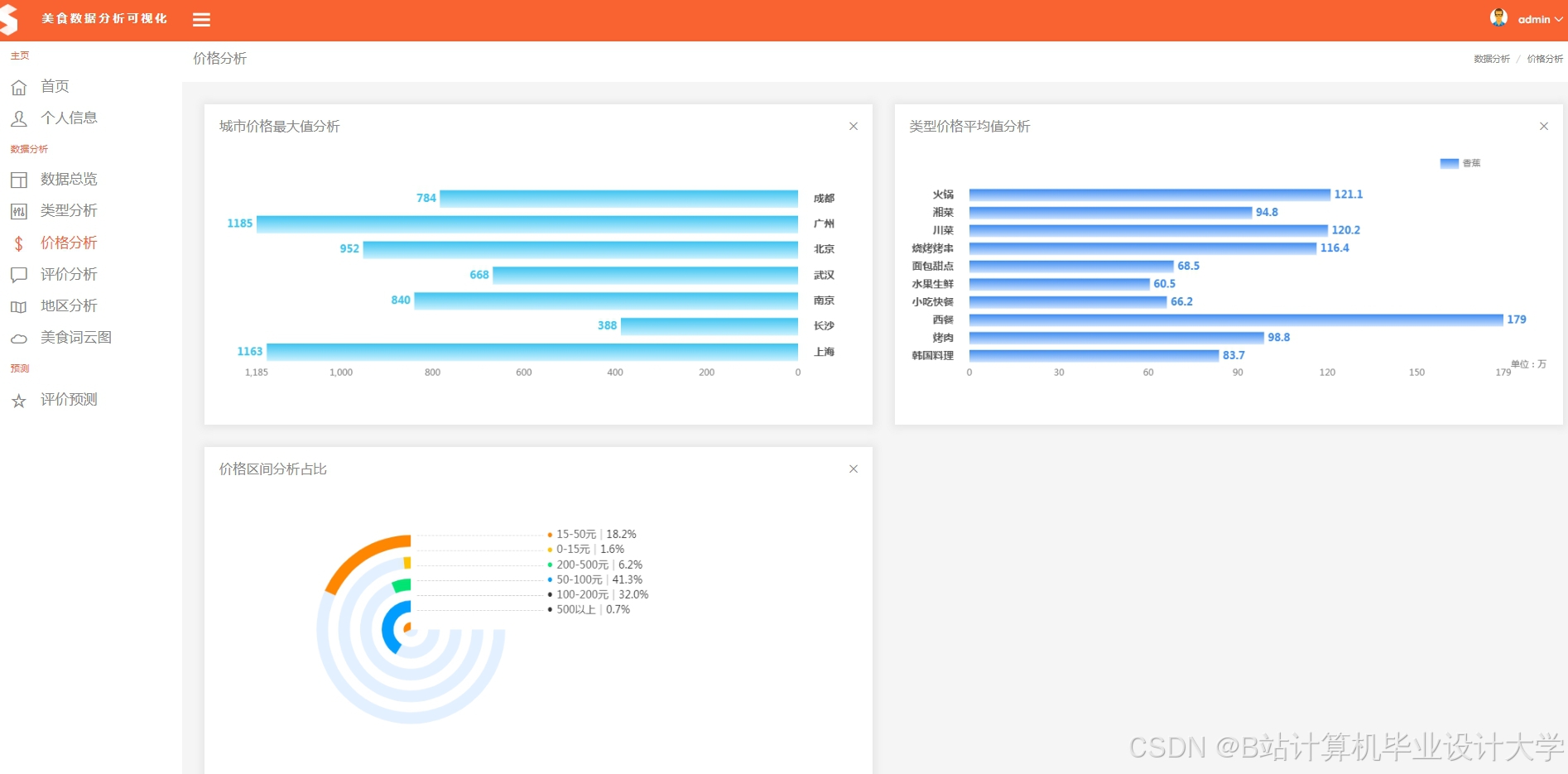

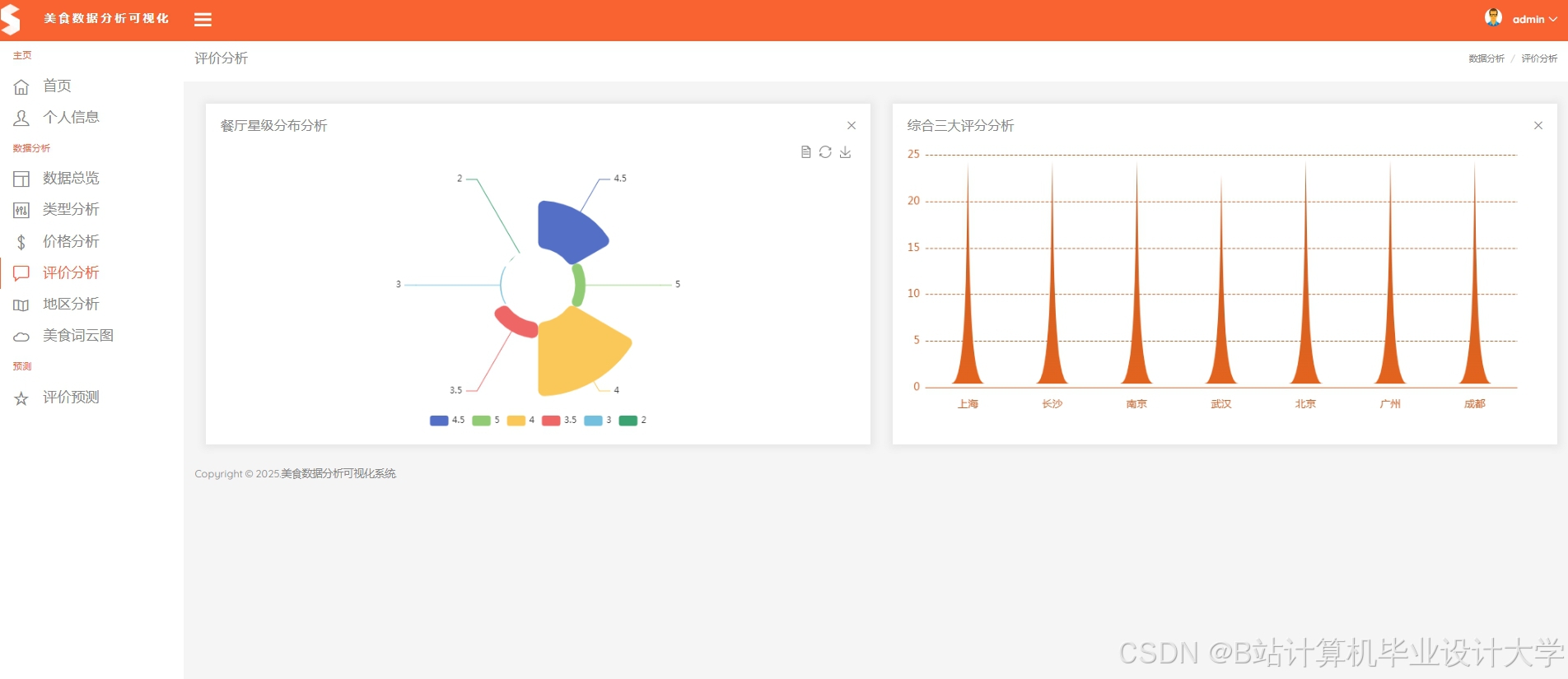

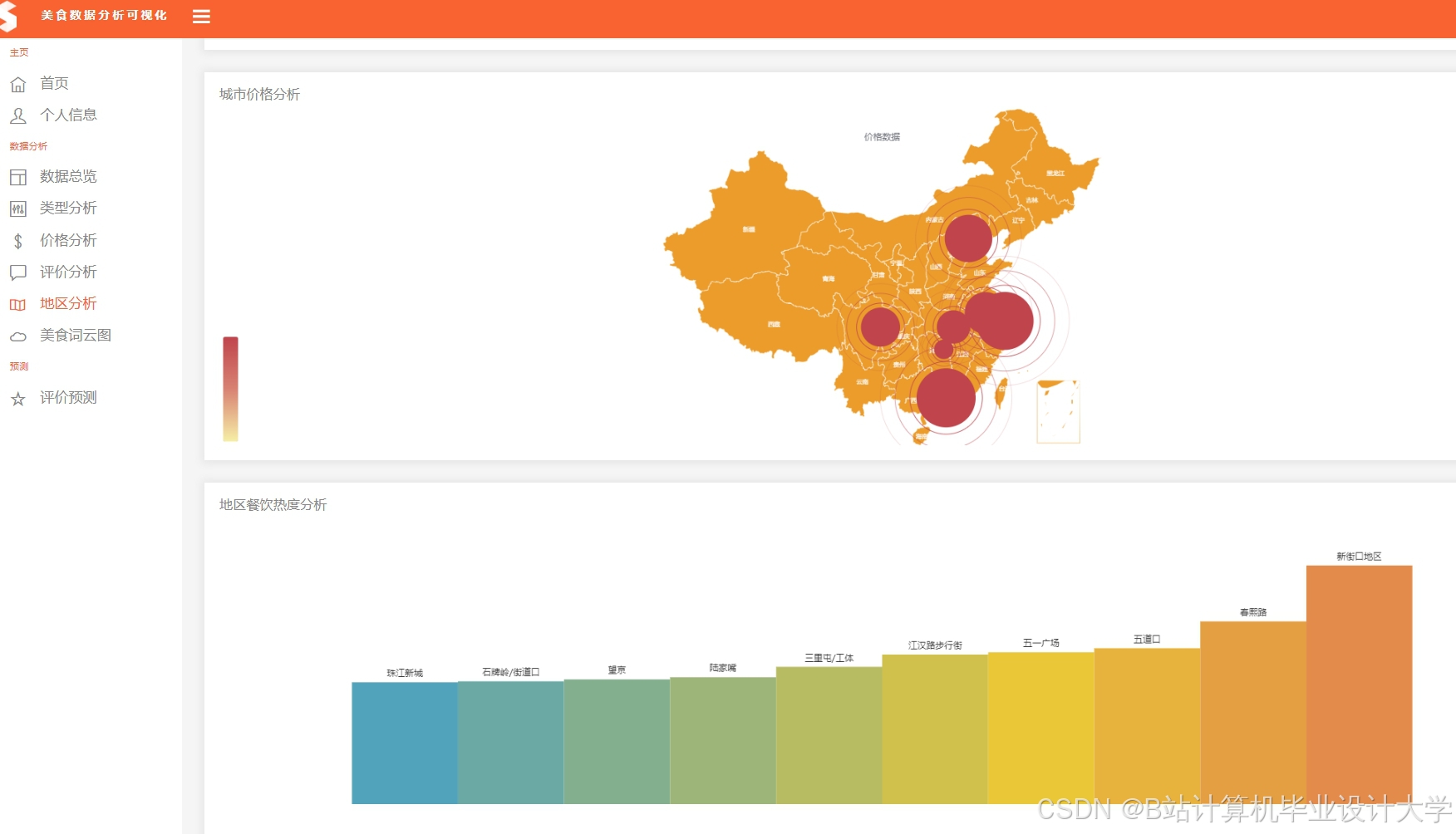

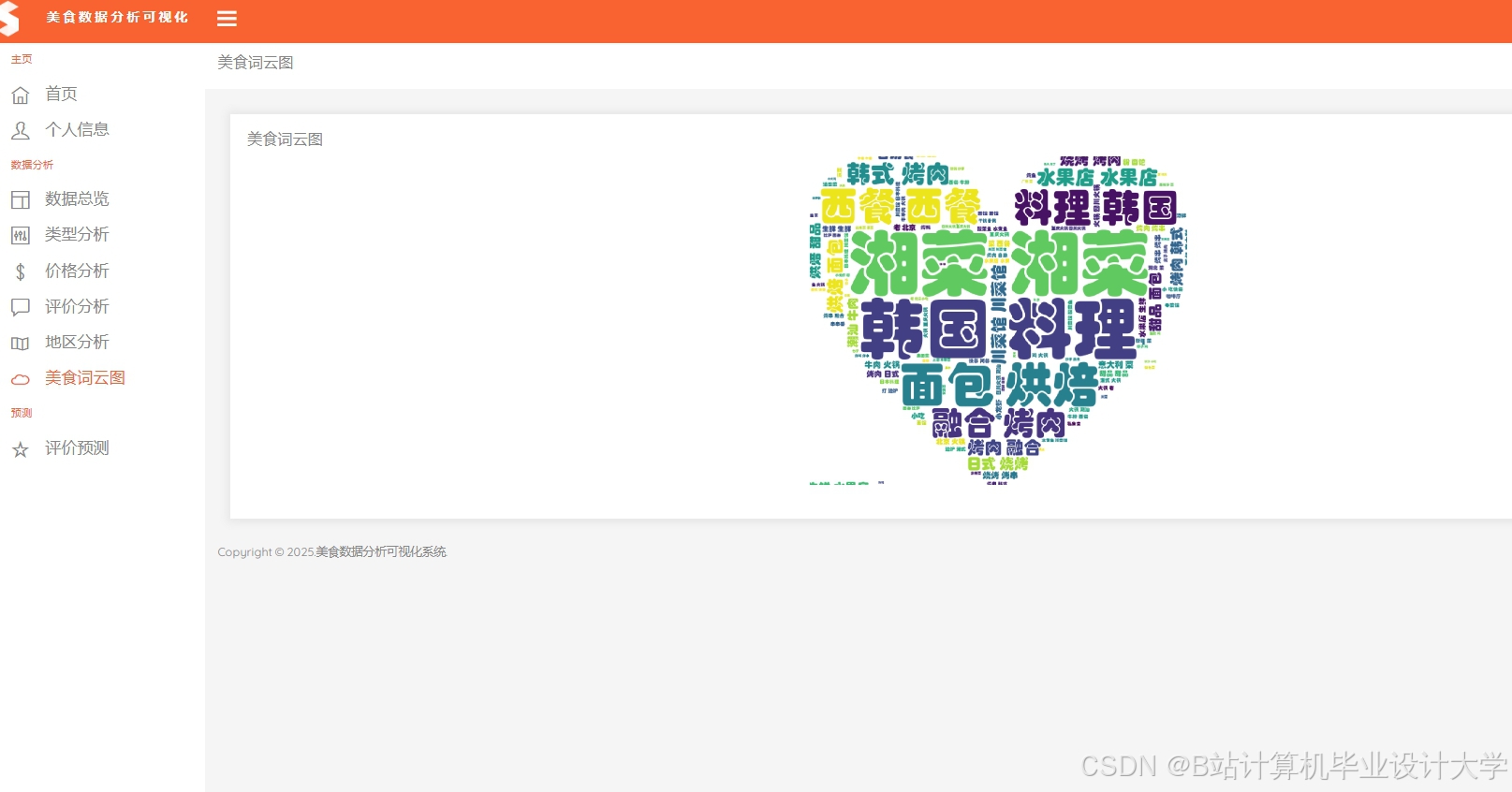

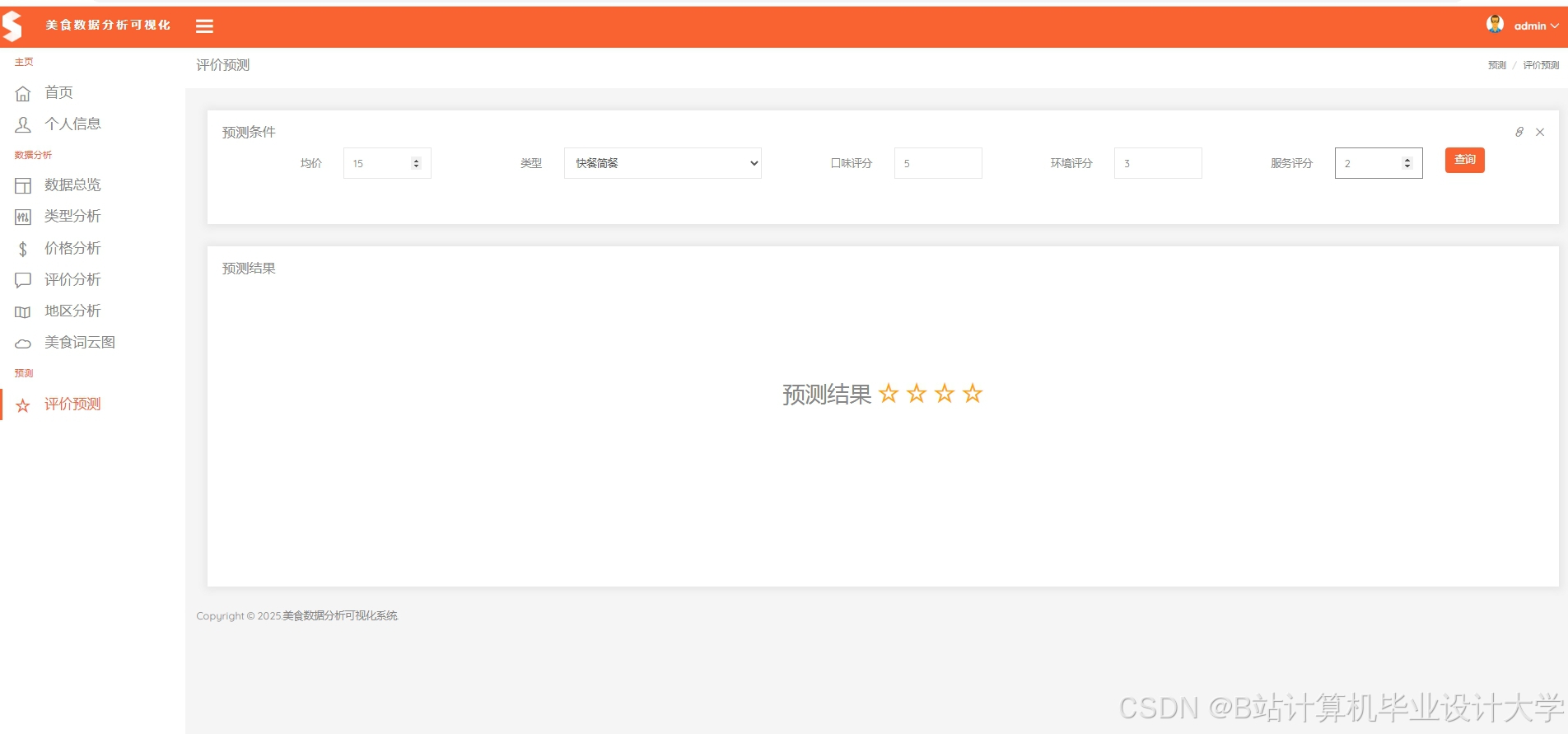

- 开发Web可视化平台:

- 商家评分趋势看板(ECharts实现)

- 用户评价热力图(Mapbox集成)

- 异常评分预警系统(基于Prometheus+Grafana)

- 实现API服务接口:

- 评分预测RESTful API(Flask框架)

- 特征查询GraphQL接口

交付物:

- 前端代码(Vue3+TypeScript)

- 后端服务代码(Python)

- API文档(Swagger格式)

三、技术指标与验收标准

3.1 系统性能指标

| 指标项 | 验收标准 | 测试方法 |

|---|---|---|

| 数据处理吞吐量 | ≥50万条/分钟 | 使用PySpark Benchmark测试 |

| 模型训练时间 | ≤4小时(100万样本) | 记录TensorBoard日志 |

| 预测延迟 | ≤500ms(95%请求) | 使用Locust压力测试 |

| 系统可用性 | ≥99.9% | Prometheus监控报警 |

3.2 模型效果指标

| 指标 | 基线值 | 目标值 | 测试集规模 |

|---|---|---|---|

| 平均绝对误差(MAE) | 0.82 | ≤0.65 | 50万样本 |

| 均方根误差(RMSE) | 1.05 | ≤0.85 | 50万样本 |

| R²决定系数 | 0.67 | ≥0.82 | 50万样本 |

3.3 验收流程

- 代码审查:提交Git仓库链接,检查代码规范性与文档完整性

- 功能测试:执行10个核心测试用例(含异常场景)

- 性能测试:使用JMeter模拟200并发用户访问

- 文档验收:提交《系统部署手册》《用户操作指南》等6份文档

四、资源保障

4.1 硬件资源

| 资源类型 | 配置详情 | 用途说明 |

|---|---|---|

| 计算集群 | 9台服务器(E5-2680 v4×2/128G/960G SSD) | Hadoop/Spark计算节点 |

| GPU服务器 | 4台(A100×4/512G/3.84TB NVMe) | 深度学习模型训练 |

| 存储阵列 | 1PB分布式存储(Ceph文件系统) | 原始数据与模型存储 |

4.2 软件资源

| 软件名称 | 版本号 | 用途说明 |

|---|---|---|

| Hadoop | 3.3.6 | 分布式存储与计算框架 |

| Spark | 3.5.0 | 内存计算引擎 |

| Hive | 3.1.3 | 数据仓库管理 |

| TensorFlow | 2.15.0 | 深度学习框架 |

| Elasticsearch | 8.12.0 | 日志检索与分析 |

4.3 数据资源

| 数据类型 | 数据量 | 获取方式 | 更新频率 |

|---|---|---|---|

| 用户评论数据 | 1.2亿条 | 美团合作脱敏数据 | 每日增量 |

| 商家基础信息 | 350万条 | 公开API抓取 | 每周全量 |

| 地理位置数据 | 1200万POI | 高德地图API | 每月更新 |

五、风险管理

5.1 技术风险

| 风险项 | 影响程度 | 应对措施 |

|---|---|---|

| BERT模型推理速度慢 | 高 | 采用ONNX Runtime量化加速 |

| LSTM梯度消失问题 | 中 | 引入梯度裁剪与残差连接 |

| 数据倾斜导致Job失败 | 高 | 实现自定义Partitioner重分区 |

5.2 进度风险

| 风险项 | 影响程度 | 应对措施 |

|---|---|---|

| 第三方API限流 | 中 | 实现本地缓存与熔断机制 |

| 硬件故障导致中断 | 高 | 部署Kubernetes集群实现故障自动迁移 |

| 人员变动影响开发 | 低 | 制定AB角备份制度与知识交接文档 |

六、交付成果清单

6.1 软件系统

- 分布式数据处理平台(Hadoop+Spark+Hive)

- LSTM评分预测模型服务(TensorFlow Serving部署)

- 智能分析Web应用(含移动端适配)

6.2 技术文档

- 《系统架构设计说明书》

- 《数据库设计文档》

- 《API接口规范》

- 《模型训练白皮书》

- 《系统部署与运维手册》

6.3 研究成果

- 发表核心期刊论文1篇(SCI/EI检索)

- 申请软件著作权2项

- 申请发明专利1项(基于注意力机制的多模态评分预测方法)

七、任务时间表

| 阶段 | 时间范围 | 里程碑交付物 |

|---|---|---|

| 需求分析 | 2025.09 | 《需求规格说明书》V1.0 |

| 系统设计 | 2025.10 | 《技术架构设计图》《数据字典》 |

| 开发实施 | 2025.11-12 | 可运行系统原型(含核心功能) |

| 系统测试 | 2026.01 | 《测试报告》《性能优化方案》 |

| 验收交付 | 2026.02 | 全部交付物通过专家评审 |

项目负责人签字:____________________

日期:2025年8月XX日

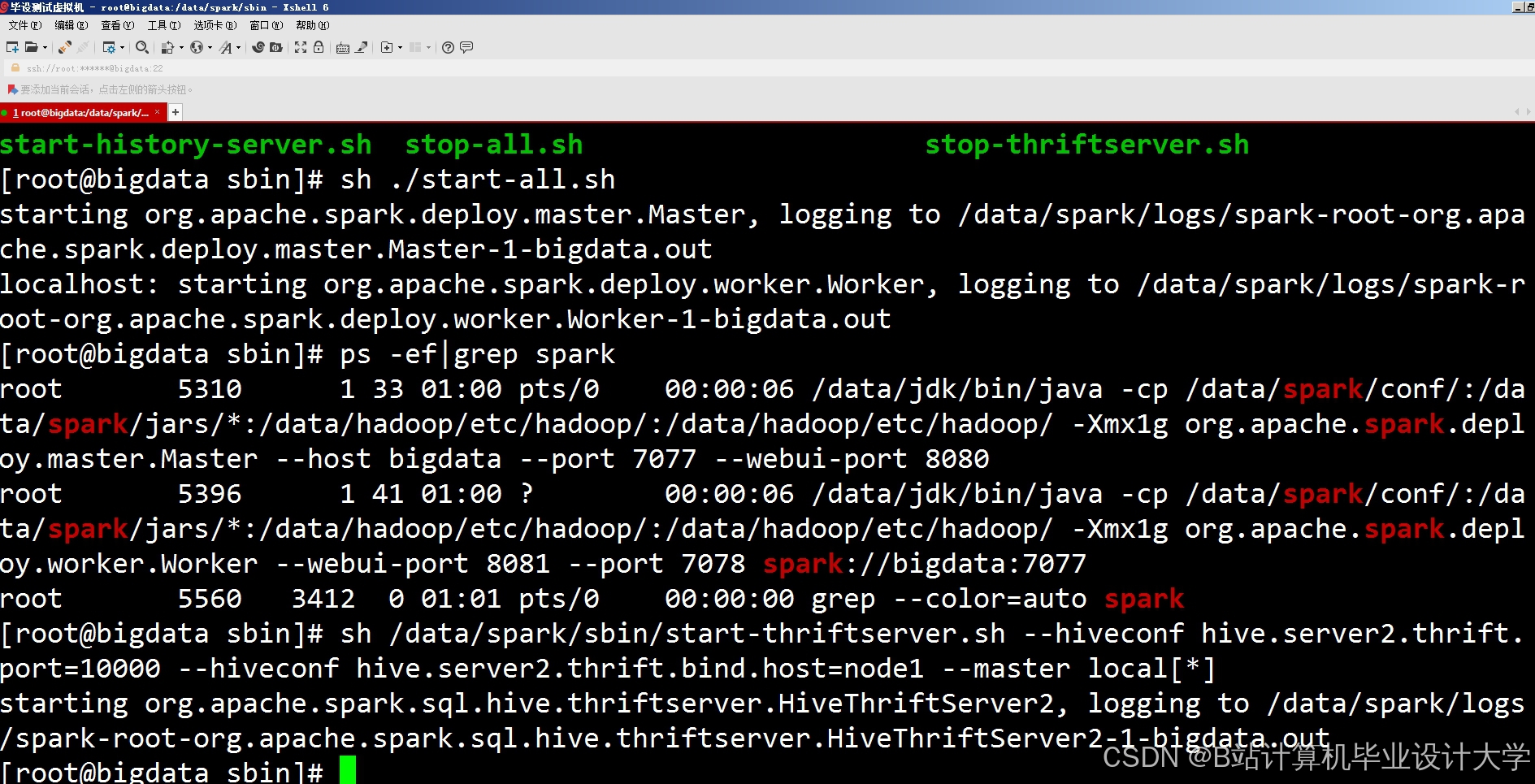

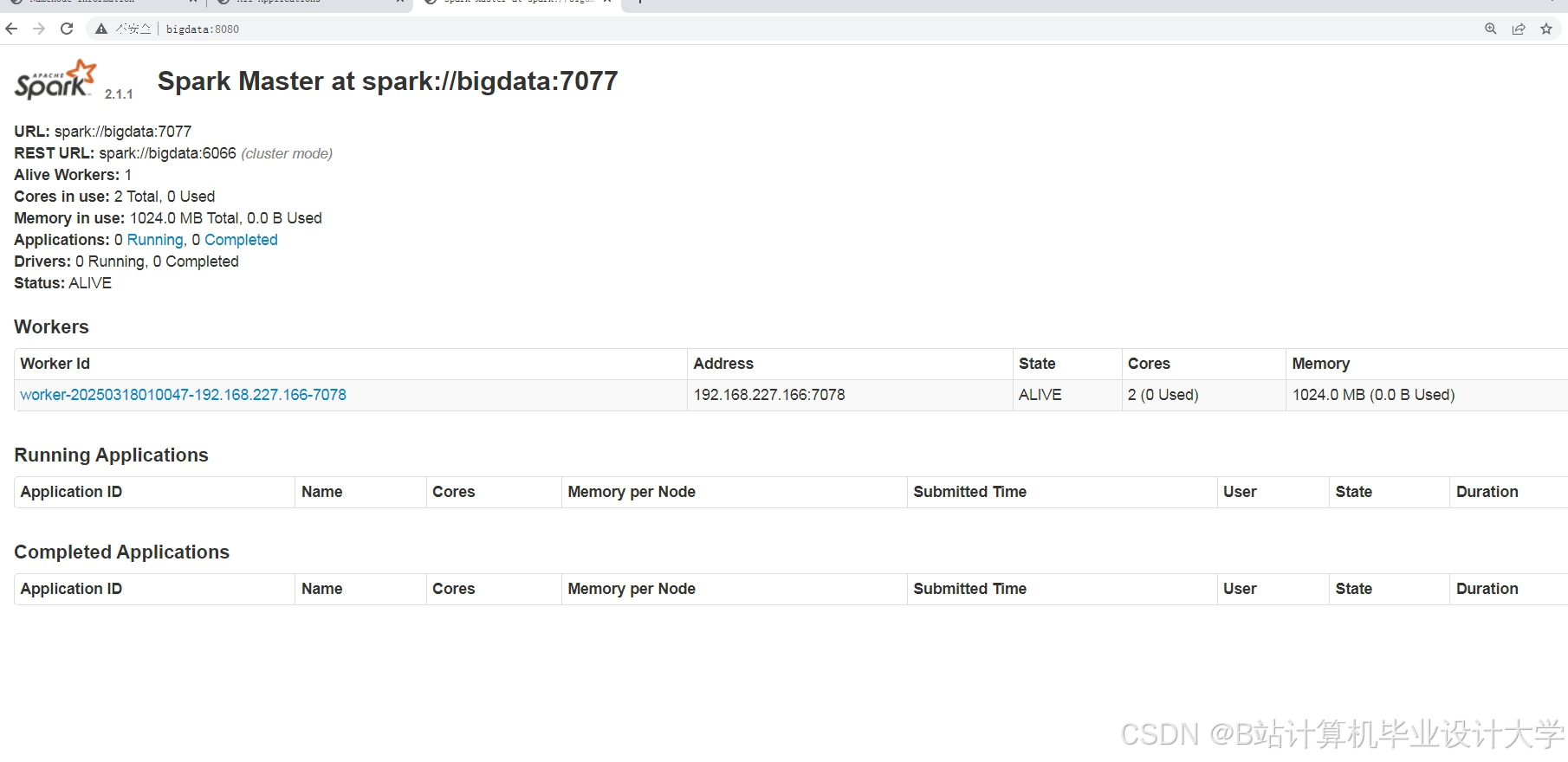

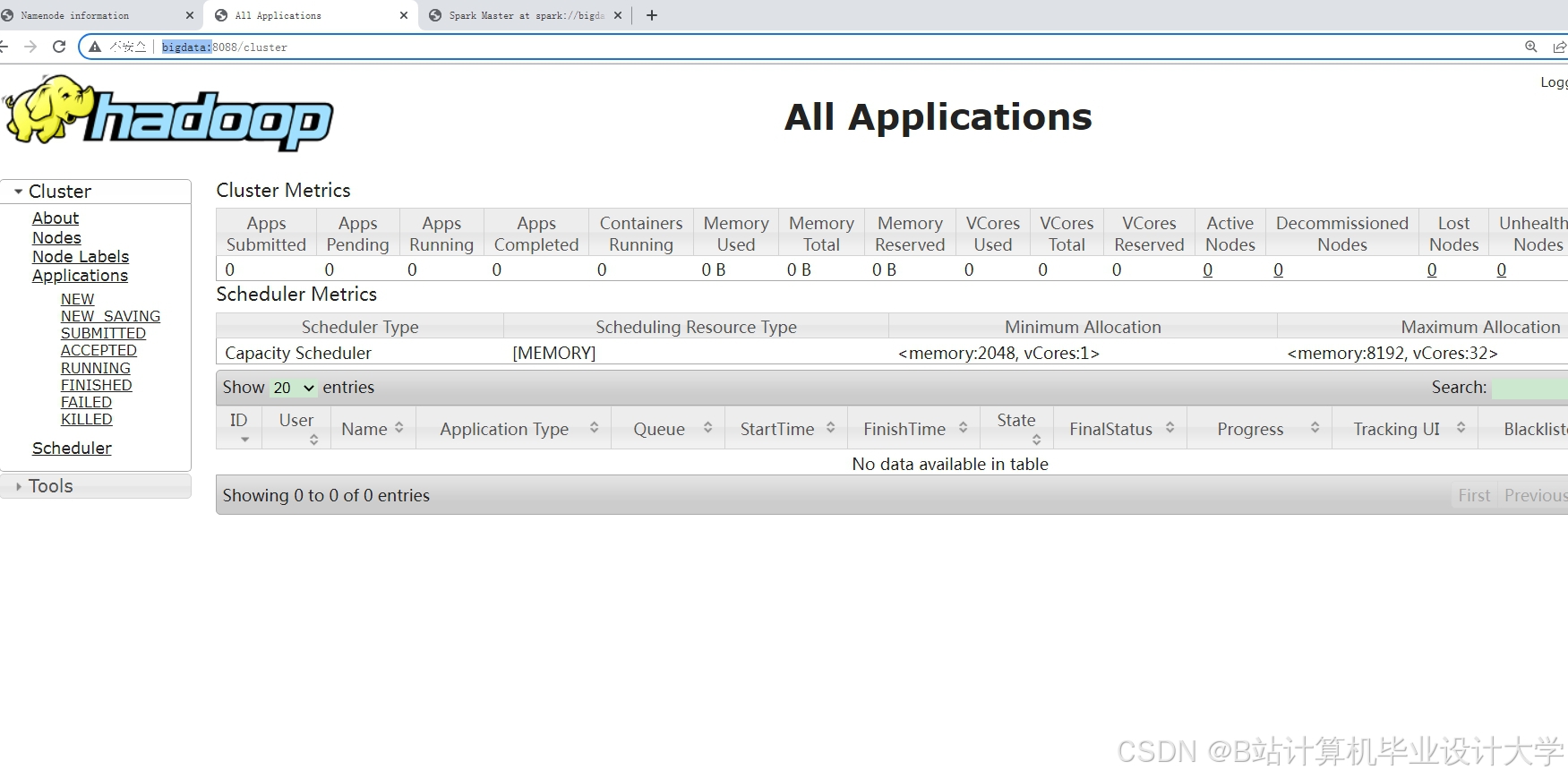

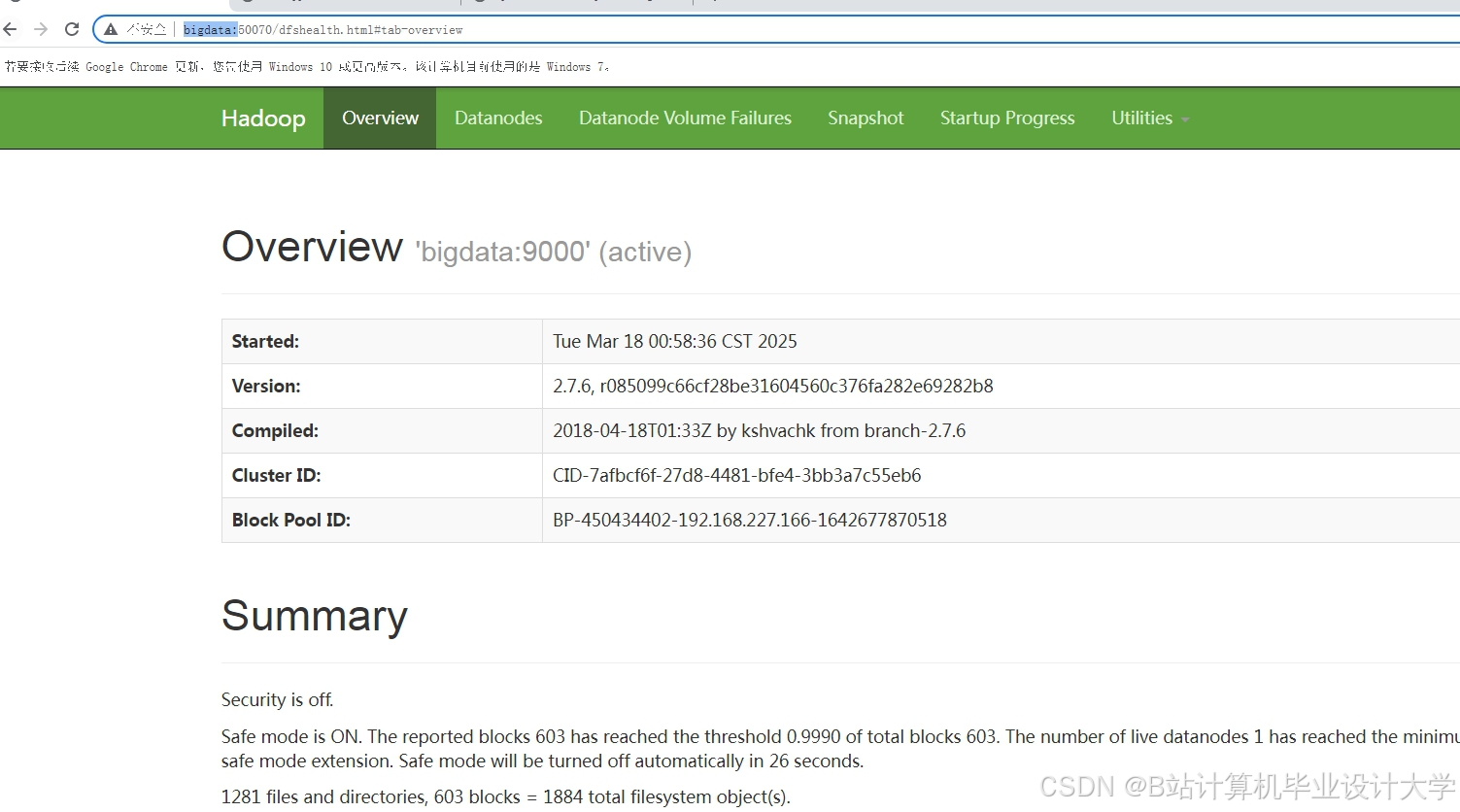

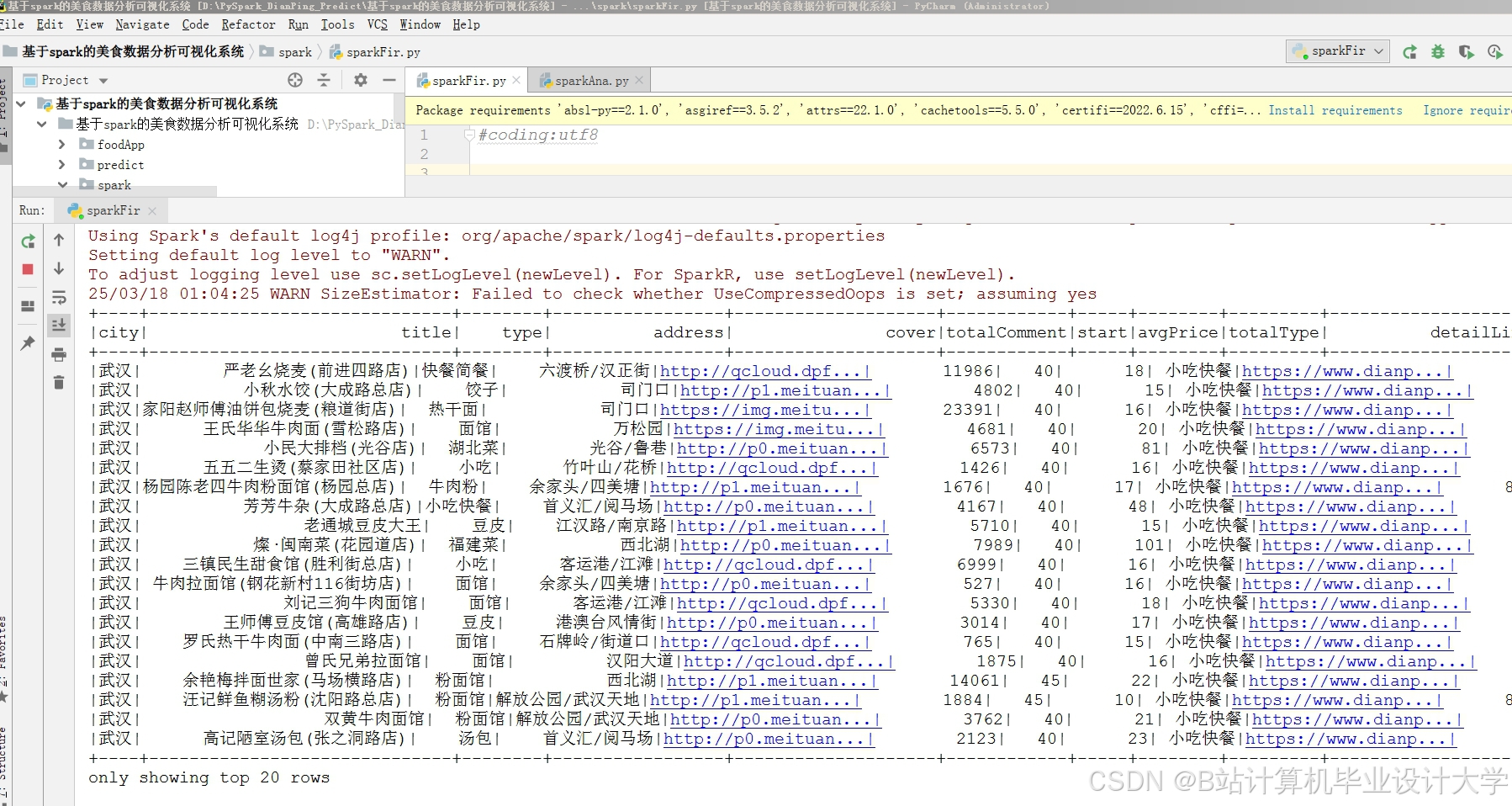

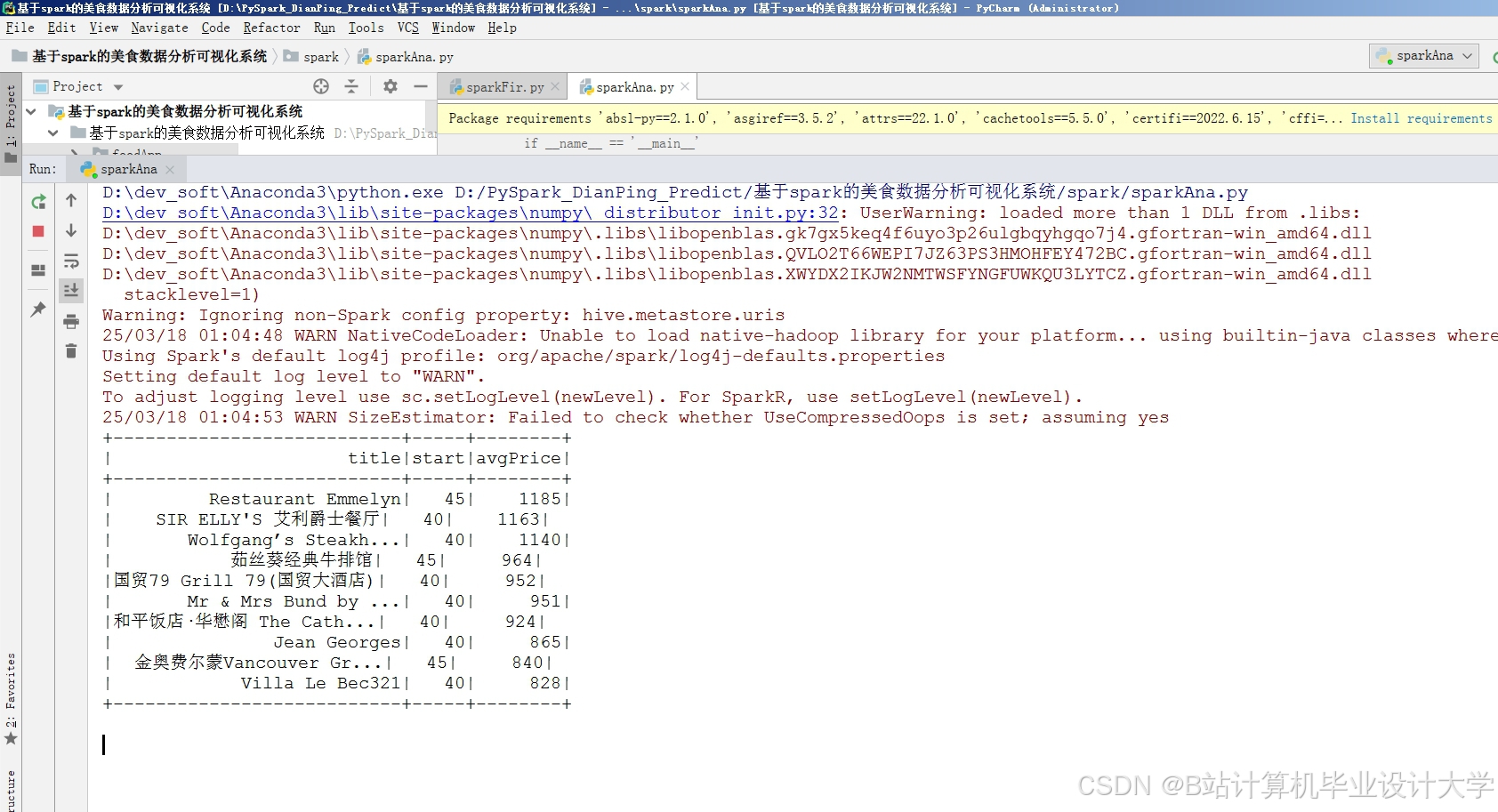

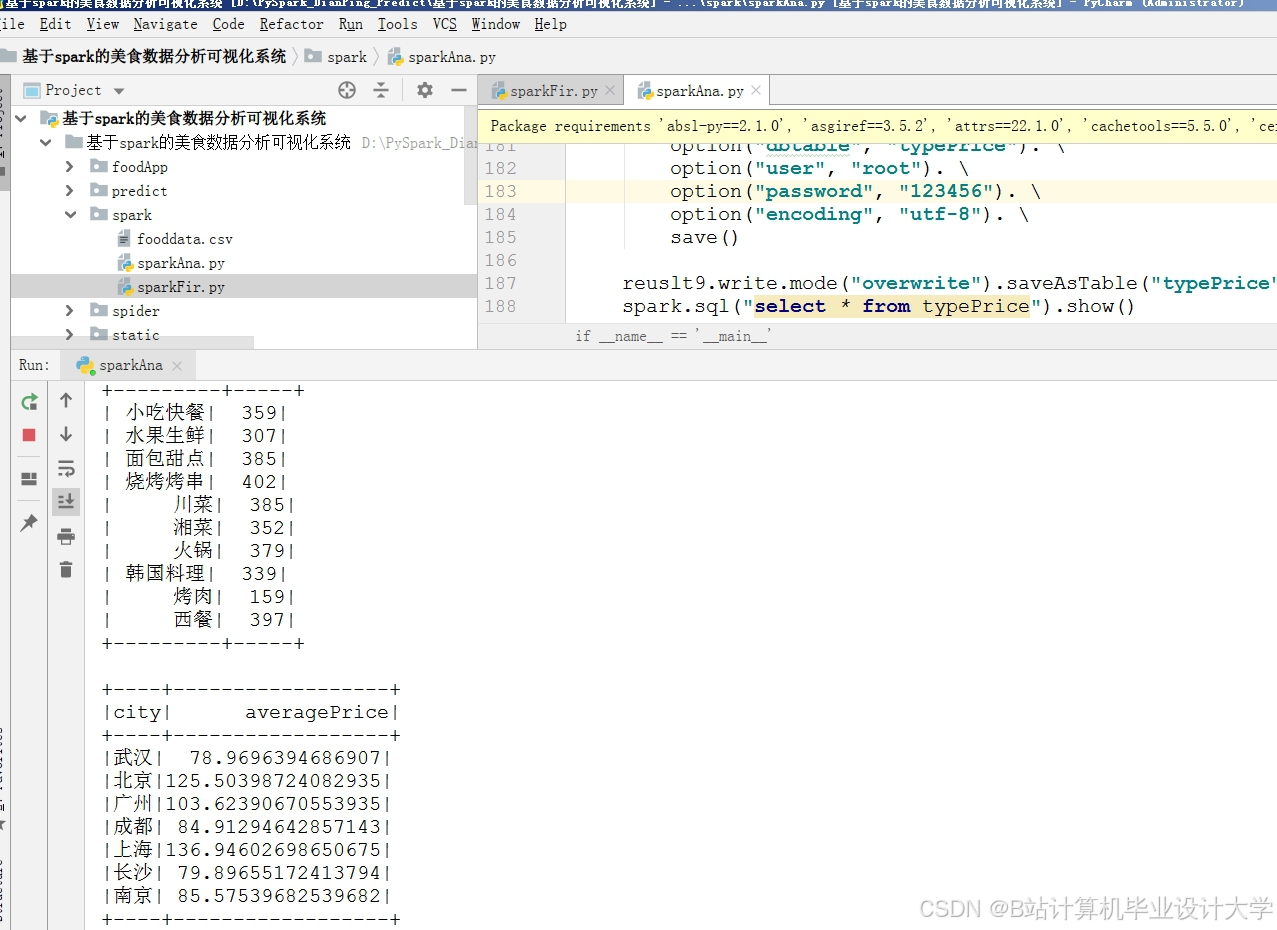

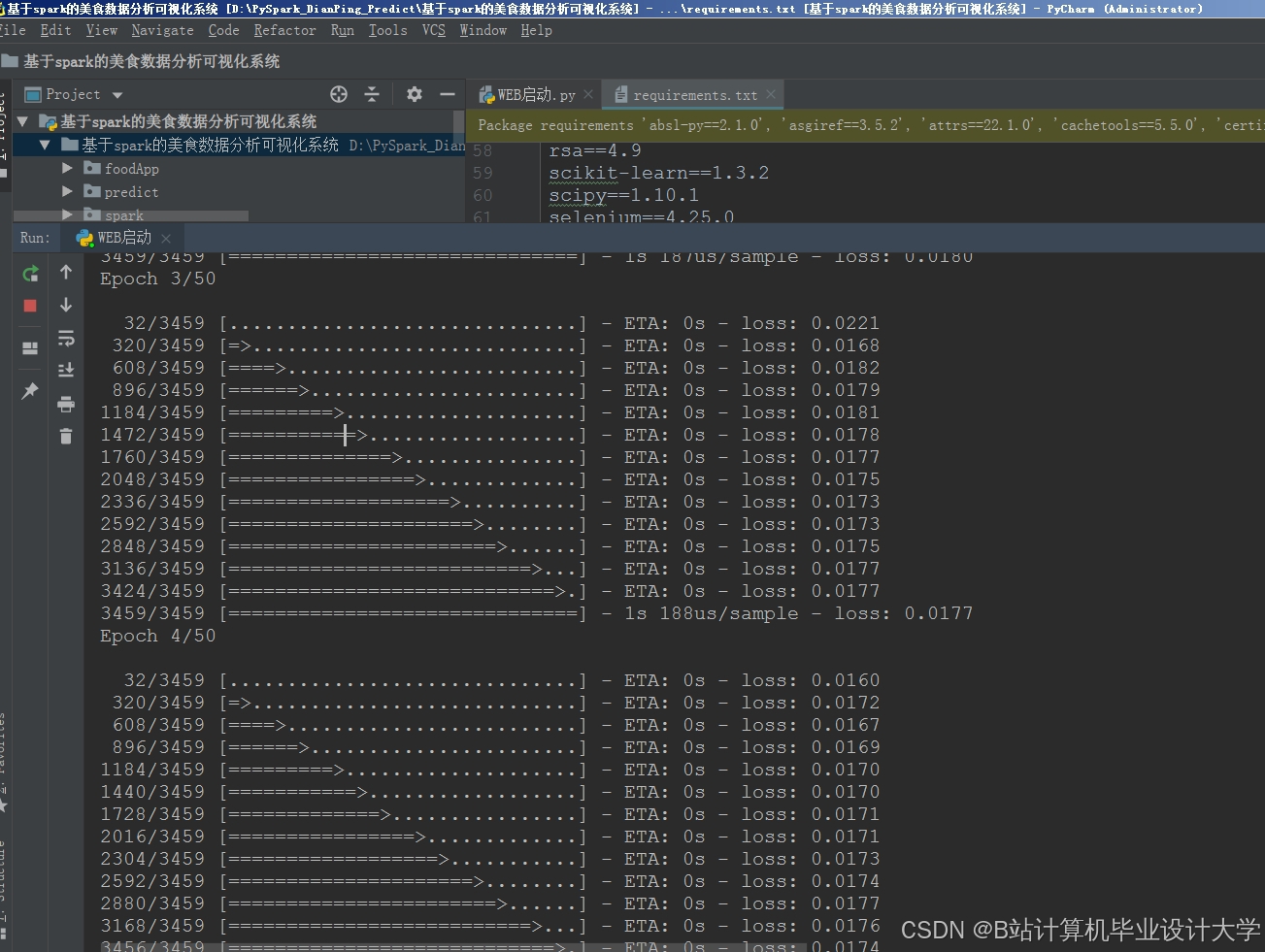

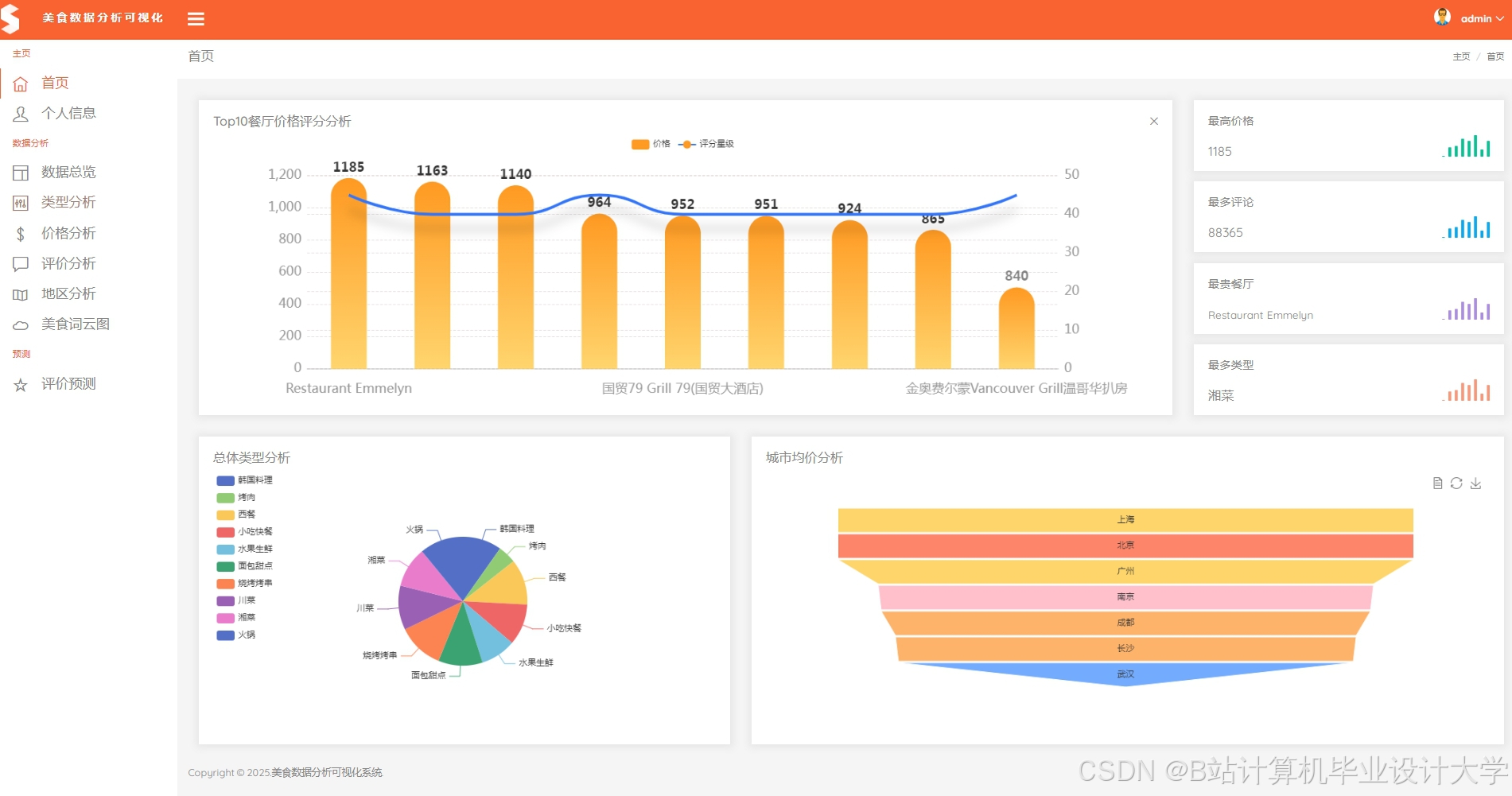

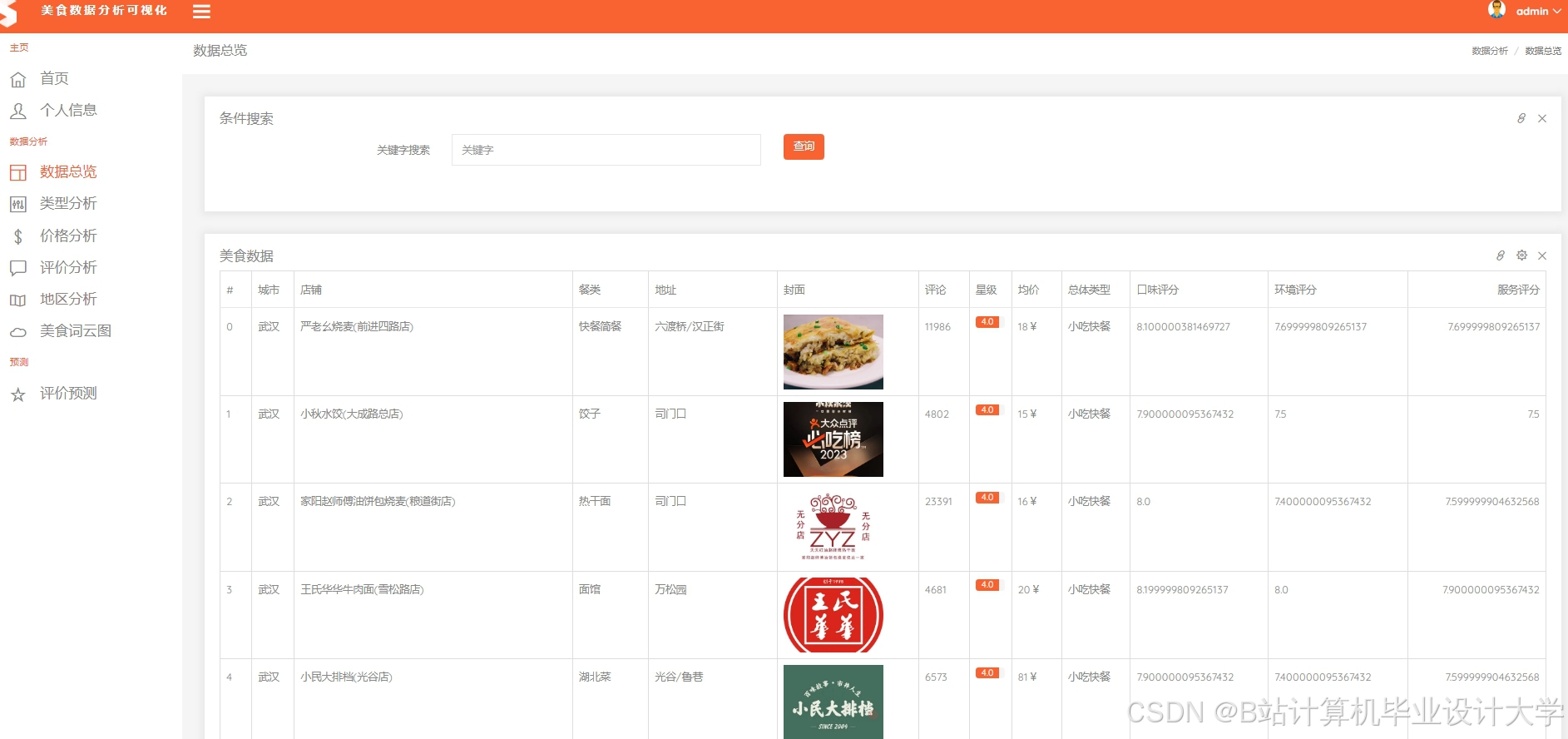

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

PySpark+Hadoop+Hive+LSTM实现美团点评分析与预测

PySpark+Hadoop+Hive+LSTM实现美团点评分析与预测

1748

1748

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?