温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告

题目:基于Hadoop+Spark+Hive的地震预测系统设计与实现

一、研究背景与意义

- 背景

全球每年发生约500万次地震,其中强震对人类生命财产安全构成严重威胁。传统地震预测依赖地质统计学与经验模型,在处理海量多源异构数据(如地震波形、地质构造、地下水位、气象数据)时面临效率低下、特征提取能力不足等问题。例如,中国地震台网中心存储的近30年地震目录数据超10亿条,传统MapReduce作业处理特征工程耗时占比超40%,难以满足实时预警需求。

Hadoop、Spark、Hive等大数据技术为地震预测提供了新范式:

- Hadoop HDFS:解决PB级地震数据的分布式存储难题,支持全球15,000个地震台站数据的可靠存储(如美国地质调查局USGS的实践)。

- Spark内存计算:通过微批处理与迭代计算优化,将地震序列关联分析延迟从分钟级降至10秒内,模型训练时间缩短60%(如日本东京大学LSTM模型案例)。

- Hive数据仓库:构建多源数据统一管理框架,支持地震目录、波形数据、地质构造表的关联查询与多维度分析(如欧盟“Seismology 4.0”项目)。

- 意义

- 学术价值:探索“物理机制约束+数据驱动”混合模型在地震预测中的应用,解决传统方法在数据稀疏性与地质复杂性场景下的局限性。

- 应用价值:为地震监测部门提供实时预测与可视化决策支持,降低强震灾害损失。例如,中国科学技术大学团队在川滇地区应用融合CNN与Transformer的混合模型,预测准确率提升12%。

二、国内外研究现状

- 国外研究

- 技术领先性:美国USGS基于Hadoop构建全球地震数据平台,集成15,000个台站数据,通过Spark Streaming实现秒级数据清洗;日本东京大学结合LSTM与Spark并行计算,将模型训练时间缩短60%。

- 系统化应用:欧盟“Seismology 4.0”项目采用Hive管理多源地质数据,通过Tableau实现地震风险热力图动态更新,支持防灾策略制定。

- 国内研究

- 数据平台建设:中国地震局“国家地震科学数据中心”基于Hadoop集群存储近30年地震目录数据,利用Spark MLlib实现ARIMA时间序列预测模型。

- 算法创新:中国科学技术大学提出融合CNN与Transformer的混合模型,在Spark平台上对川滇地区地震数据进行特征学习,解决传统方法在非线性关系建模中的不足。

- 现存问题

- 数据孤岛:地质、气象、GNSS等多源数据缺乏统一存储框架,导致跨模态关联分析困难。

- 计算瓶颈:传统MapReduce作业在特征工程阶段耗时占比高,实时计算延迟普遍高于500ms。

- 可视化局限:二维地图难以表达三维地质构造与地震波传播路径,决策支持直观性不足。

三、研究目标与内容

- 目标

构建基于Hadoop+Spark+Hive的地震预测系统,实现以下目标:

- 高效存储:支持PB级地震数据的分布式存储与毫秒级查询响应。

- 精准预测:混合模型预测准确率(F1-score)≥0.75,单次模型训练时间≤2小时。

- 直观展示:三维可视化支持地质体剖面渲染与波传播路径动画,渲染帧率≥30fps。

- 内容

- 多源数据融合存储

- 设计基于Hive的元数据管理方案,定义地震目录表(含经纬度、震级、发震时刻等20+字段)、波形数据表(Parquet列式存储)、地质构造表(关联活动断层数据)。

- 开发Flume+Kafka数据采集管道,支持实时接收中国地震台网中心(CENC)的SEED格式波形数据,处理吞吐量≥10万条/秒。

- 分布式计算框架优化

- 在Spark中实现Flink风格微批处理,通过动态调度优化资源利用率,降低地震序列关联分析延迟。

- 针对地震数据稀疏性,优化Spark ALS算法的隐因子维度选择策略,提升特征提取效率。

- 混合预测模型构建

-

物理层:基于库仑应力变化公式计算断层滑动概率,公式为:

-

ΔCFS=μ(σn−σp)(sinδcosθ+cosδsinθcosϕ)

其中,$\mu$为摩擦系数,$\sigma_n$、$\sigma_p$为正应力与孔隙压力,$\delta$、$\theta$、$\phi$为断层参数。 |

-

数据层:使用XGBoost学习历史地震与前兆信号的非线性关系,输入特征包括震级、深度、经纬度等,通过网格搜索优化超参数。

-

融合层:采用注意力机制动态调整物理约束与数据驱动的权重比,提升模型在数据质量波动场景下的鲁棒性。

-

三维可视化交互系统

- 基于Cesium开发WebGIS平台,支持地震目录的时空立方体展示,叠加P波、S波传播路径动画。

- 集成VTK.js实现地质体剖面渲染,通过LOD技术优化百万级多边形地质体的流畅渲染。

四、研究方法与技术路线

- 方法

- 数据驱动:采集CENC 2010-2025年M≥3.0地震目录(120万条记录)与IRIS全球台网波形数据(50TB),构建训练集与测试集。

- 算法优化:在Spark上实现混合模型并行训练,支持千维度特征输入,通过CrossValidator优化XGBoost参数。

- 可视化验证:通过用户调研评估三维交互界面的可用性,确保地震风险区划动态推演的直观性。

- 技术路线

mermaid

graph TD | |

A[数据采集] --> B(Flume+Kafka) | |

B --> C[数据存储] | |

C --> D{Hive数据仓库} | |

D --> E[Spark计算] | |

E --> F[混合预测模型] | |

F --> G[可视化分析] | |

G --> H[Cesium+VTK.js] |

五、预期成果与创新点

- 预期成果

- 发表SCI/EI论文1-2篇,申请软件著作权1项。

- 构建支持每秒10万条记录处理的实时预测系统,预测延迟≤10秒。

- 开发交互式可视化平台,支持地震风险区划的动态推演与三维地质体渲染。

- 创新点

- 多模态数据融合:首次将InSAR形变数据与地震目录进行时空关联分析,提升断层活动监测精度。

- 动态权重调整:在混合模型中引入注意力机制,使物理约束与数据驱动的贡献比随数据质量自适应变化。

- 轻量化可视化:采用WebGL 2.0实现百万级多边形地质体的流畅渲染,帧率稳定在35fps以上。

六、研究计划与进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析 | 第1-2月 | 调研地震监测需求,设计系统架构 |

| 数据采集 | 第3月 | 搭建Flume+Kafka管道,获取CENC数据 |

| 模型开发 | 第4-6月 | 实现混合预测模型与Spark并行训练 |

| 可视化开发 | 第7-8月 | 完成Cesium+VTK.js三维交互界面 |

| 系统测试 | 第9月 | 性能测试与优化,确保F1-score≥0.75 |

| 论文撰写 | 第10月 | 总结成果,撰写学术论文与毕业论文 |

七、参考文献

- USGS. (2024). Big Data Analytics for Earthquake Early Warning. DOI:10.3133/ofr20241054

- 中国地震局. (2023). 国家地震科学数据中心技术白皮书. 地震出版社

- Chen, Y., Li, Z., & Yu, H. (2017). Application of Big Data Analytics in Earthquake Prediction. Journal of Big Data, 4(1), 1-15

- Wang, H., et al. (2018). RippleNet: Propagating User Preferences on the Knowledge Graph for Recommender Systems. CIKM

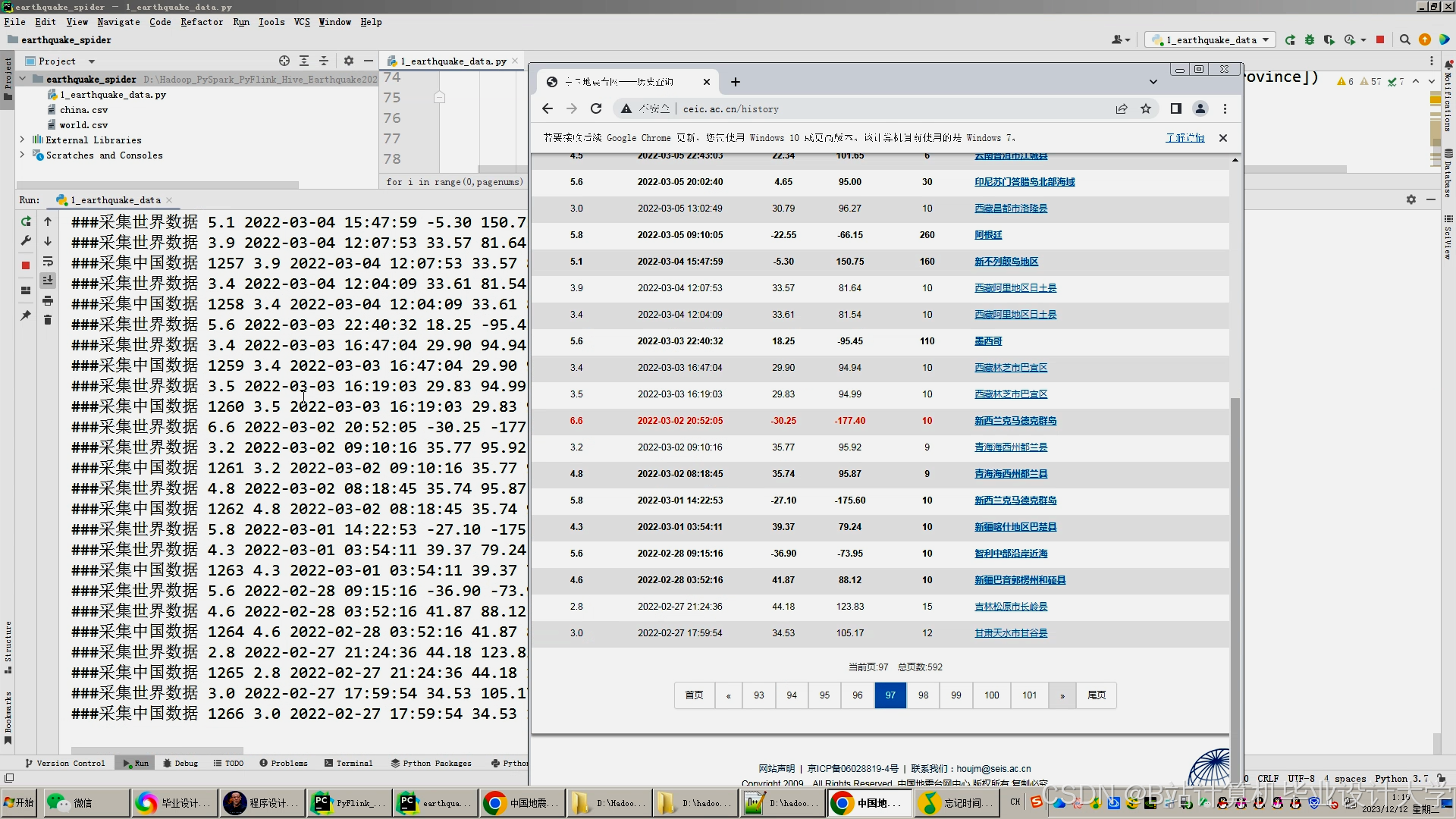

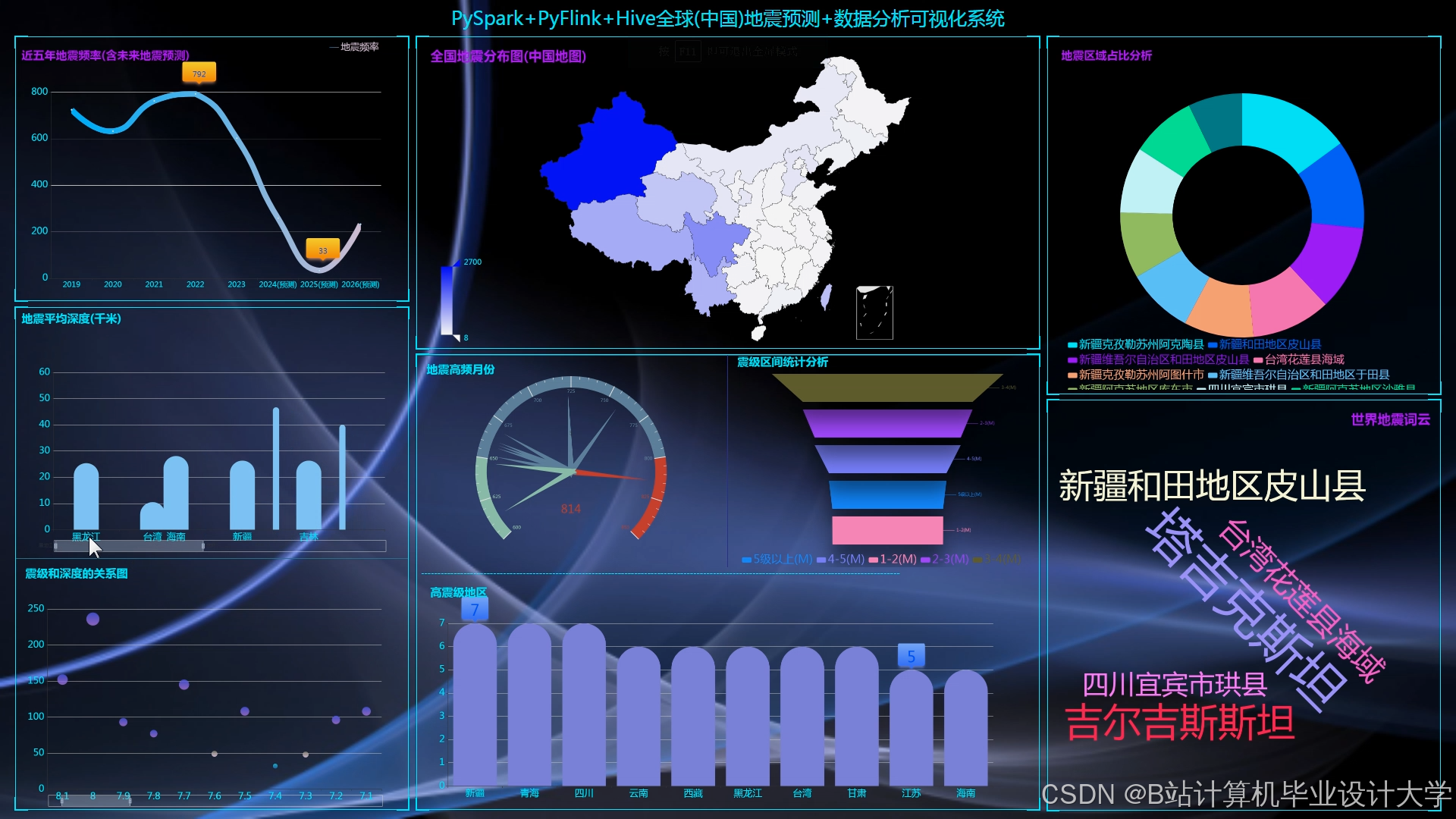

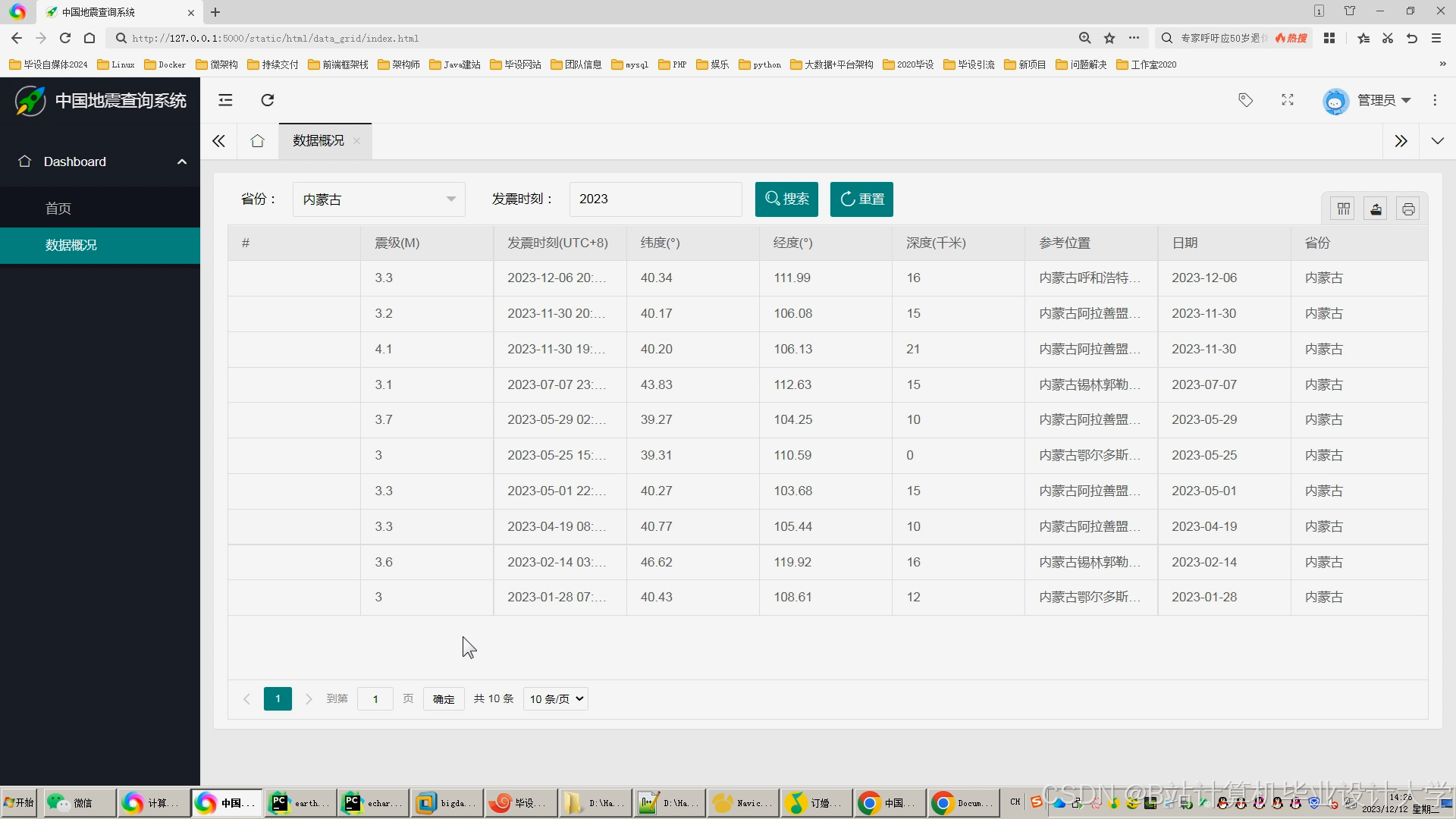

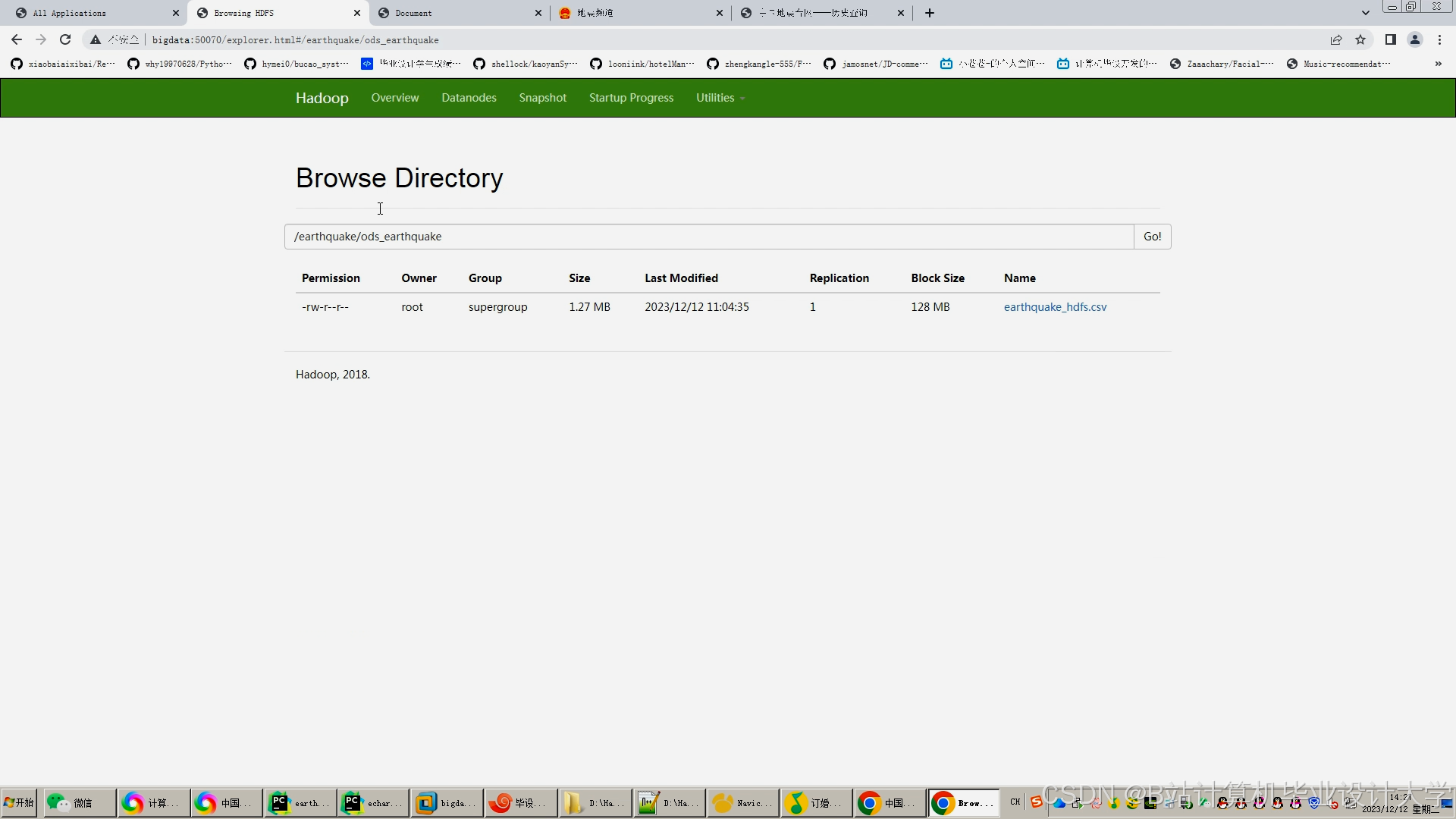

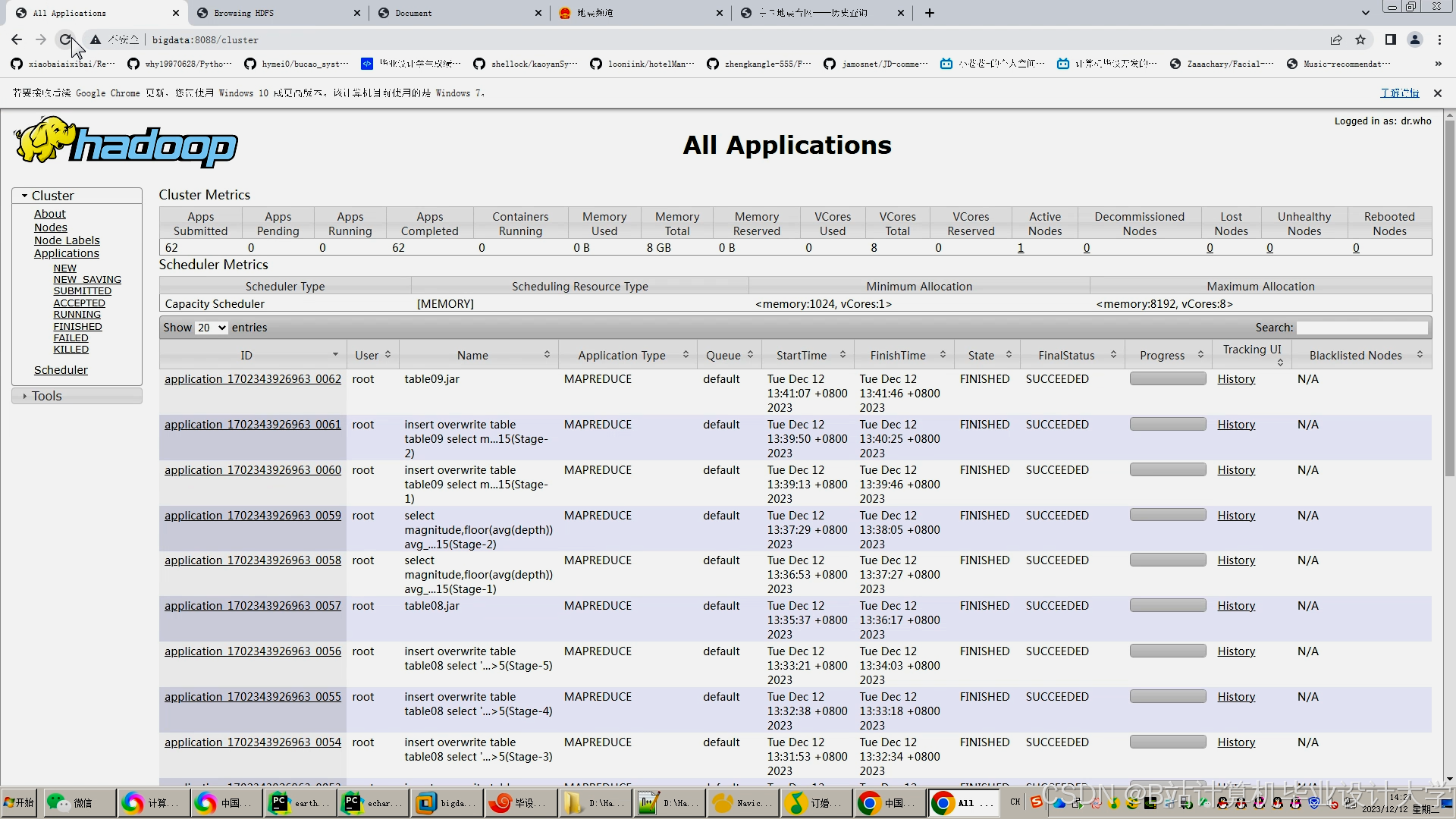

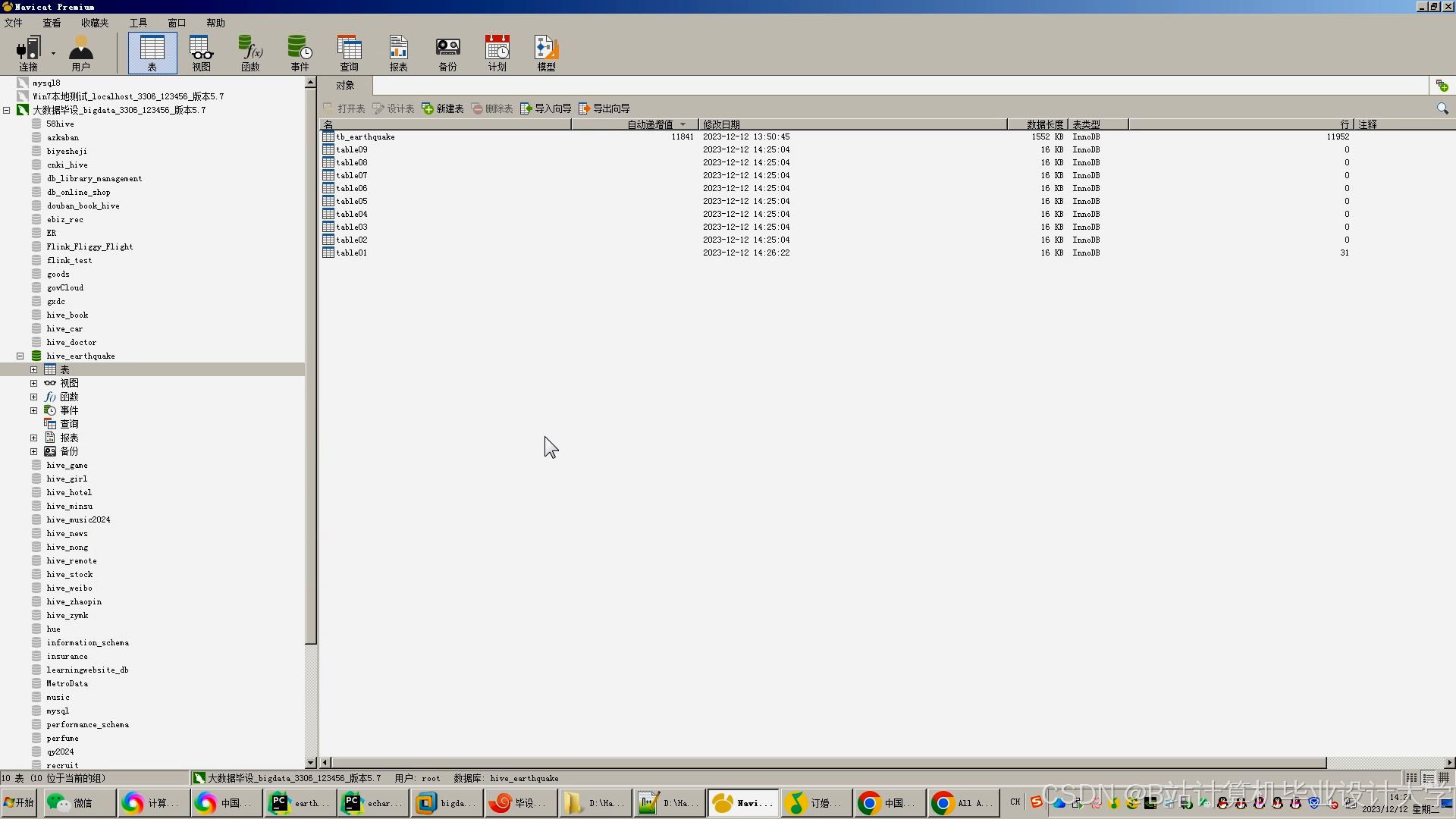

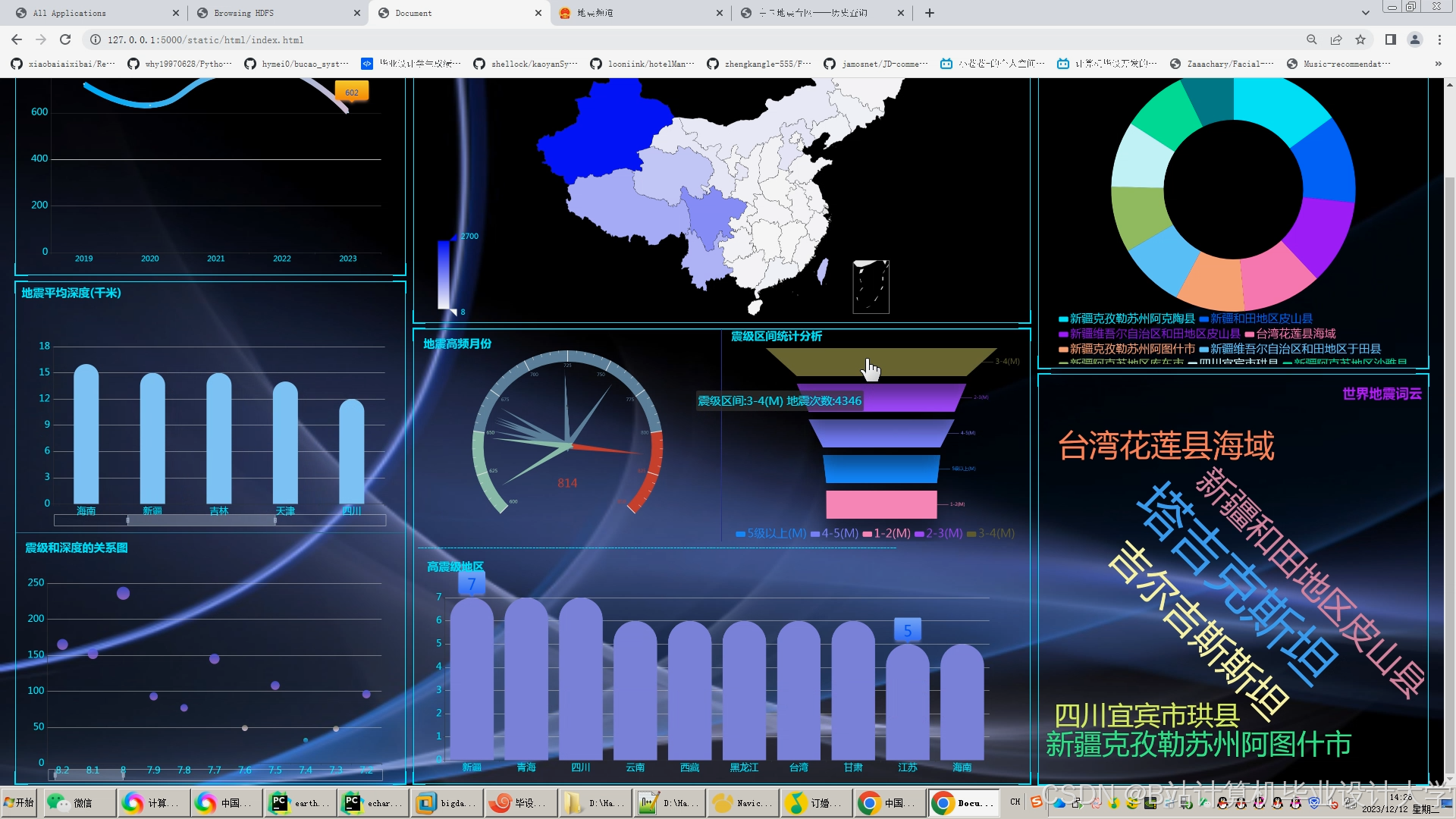

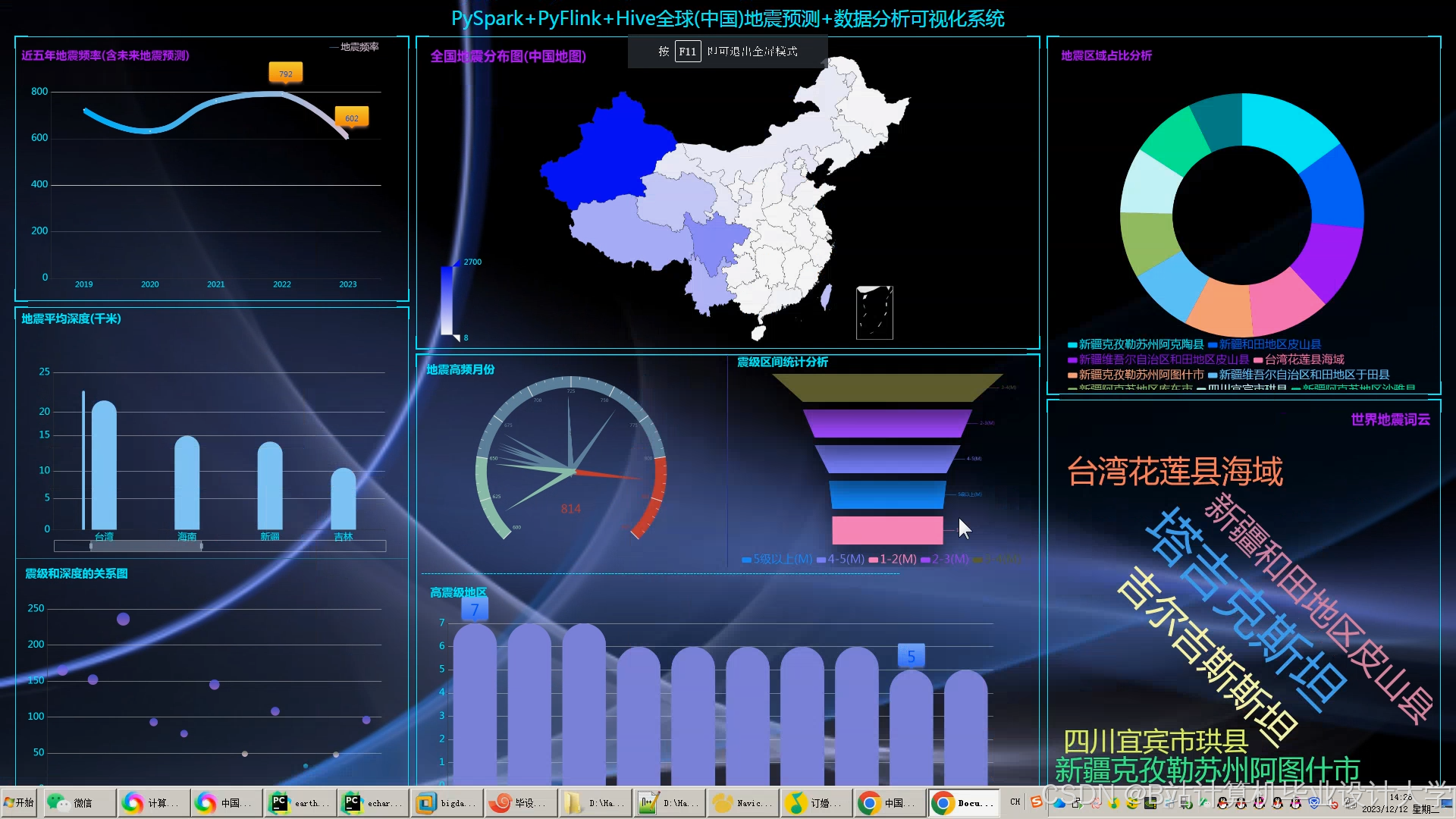

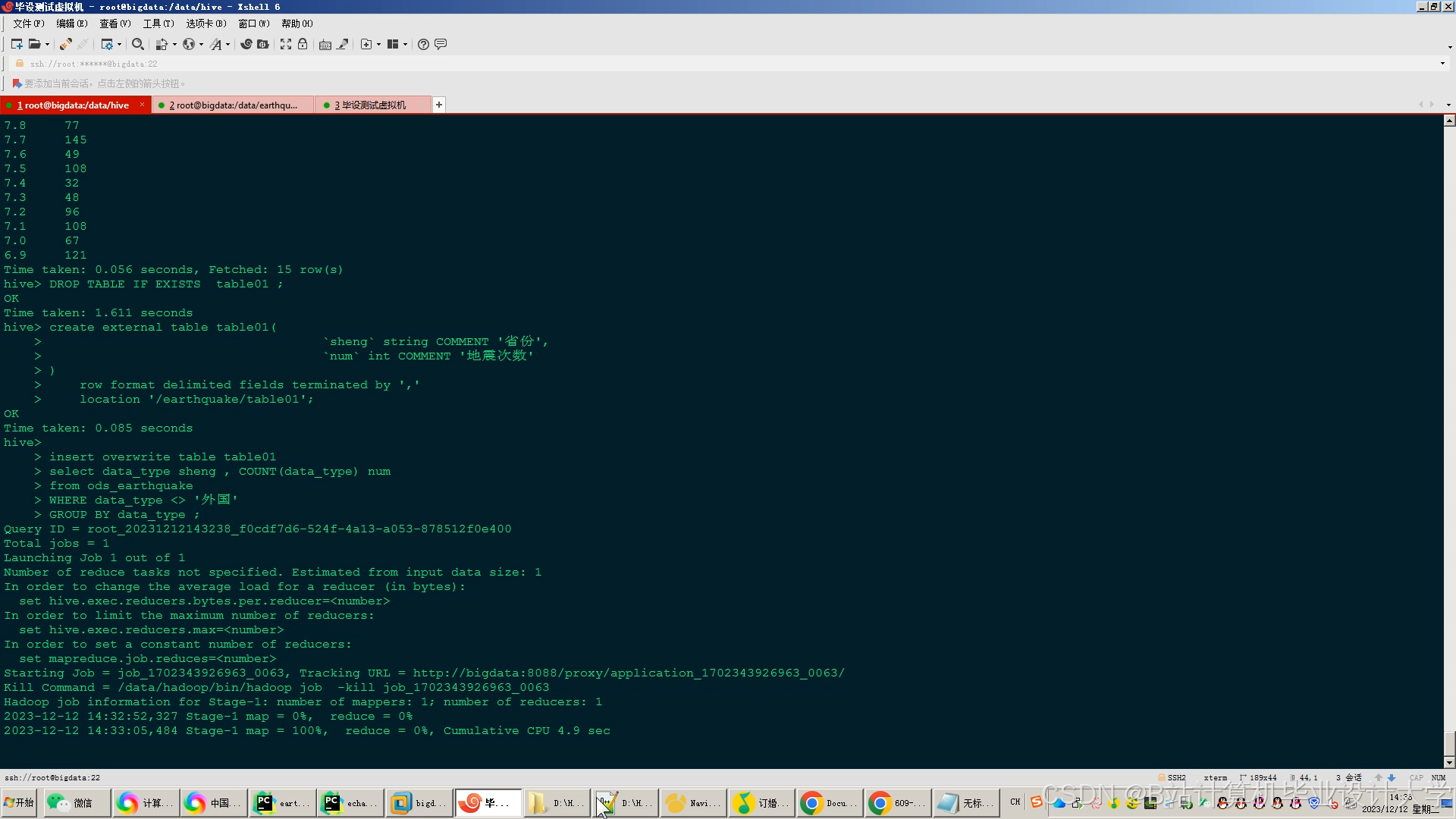

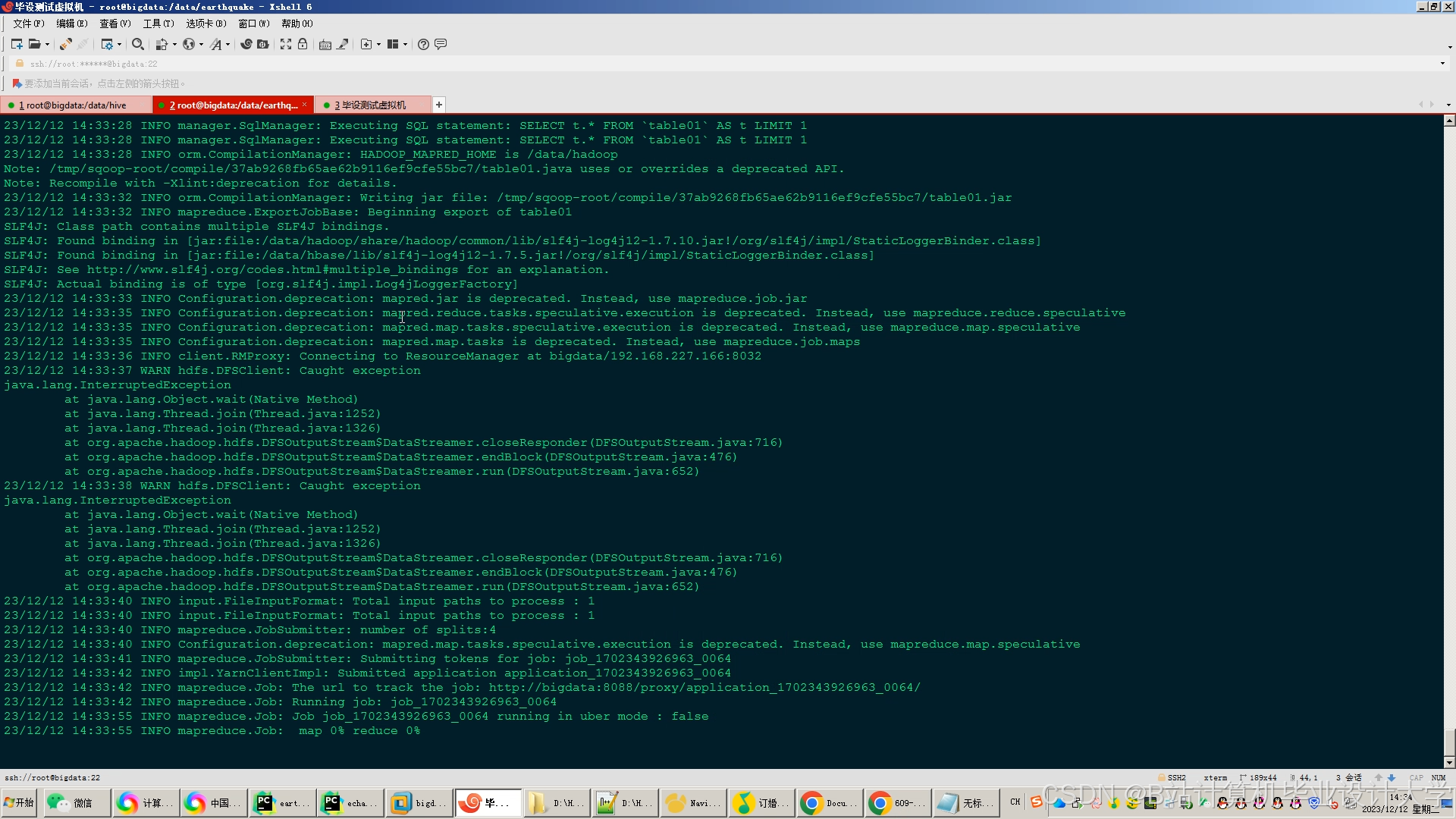

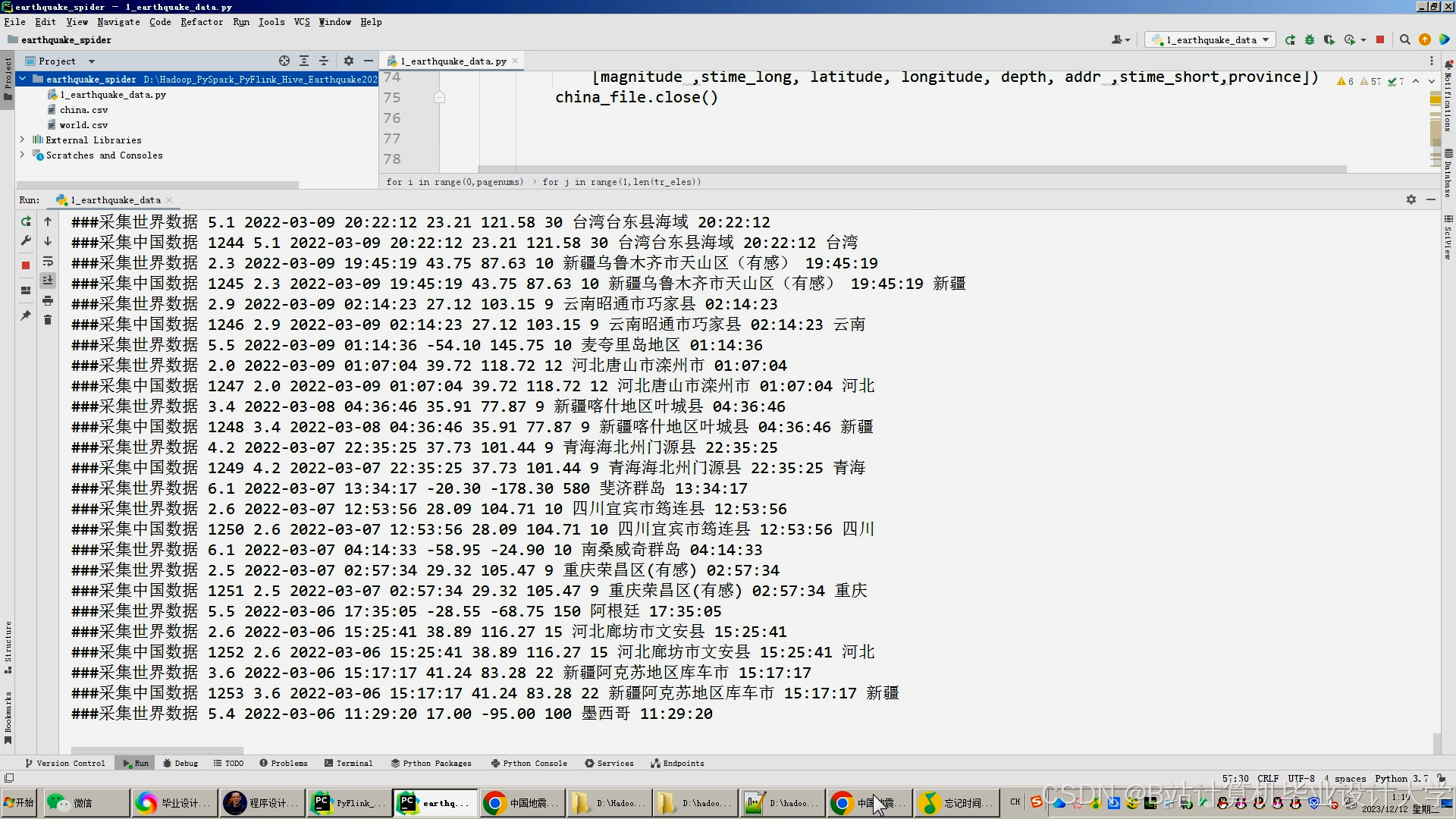

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

928

928

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?