温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Python+Spark+Hadoop考研分数线预测系统》任务书

一、任务背景与目标

1.1 背景分析

随着我国高等教育普及化进程加速,考研竞争愈发激烈。2024年全国考研报名人数达474万,较2020年增长52.6%,而招生计划年均增幅仅5%-8%。考生在备考过程中面临信息不对称问题,亟需科学预测目标院校及专业分数线以制定合理策略。传统预测方法依赖人工经验或简单统计模型,存在数据维度单一、处理效率低、预测误差大等缺陷。例如,某机构采用ARIMA模型预测某高校计算机专业分数线,误差率高达12%,导致考生决策失误。

大数据与人工智能技术的发展为解决该问题提供了新路径。基于海量历史数据和机器学习算法的预测模型,可整合报考人数、招生计划、专业热度等多维度信息,实现动态精准预测。本研究旨在构建一个分布式、高并发的考研分数线预测系统,为考生提供科学决策支持。

1.2 任务目标

- 核心功能目标:

- 构建覆盖全国500所高校、1000个专业的考研数据仓库,支持PB级数据存储与查询。

- 实现基于Spark的分布式特征工程与模型训练,将预测误差率控制在5%以内。

- 开发个性化院校推荐模块,根据考生背景匹配度推荐3-5所目标院校。

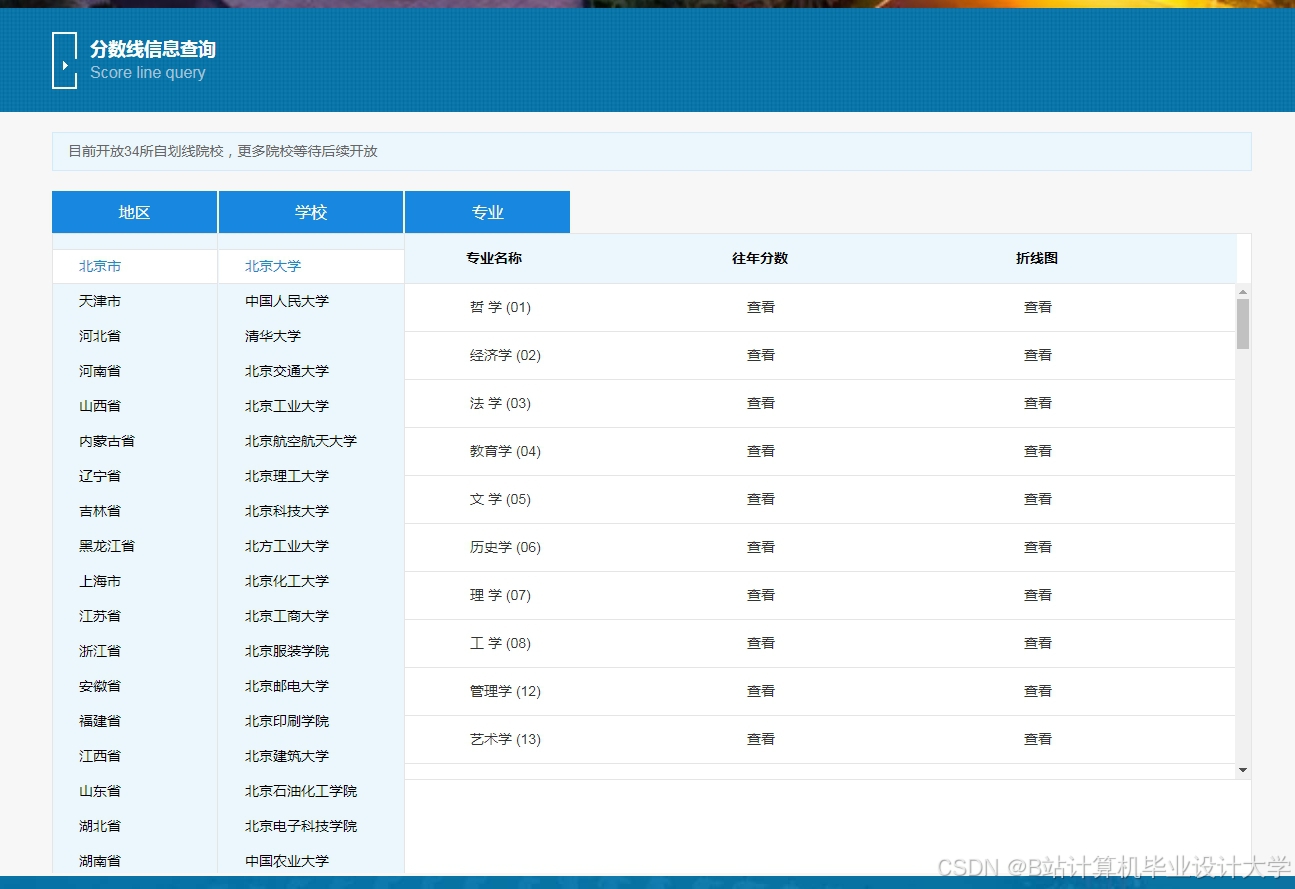

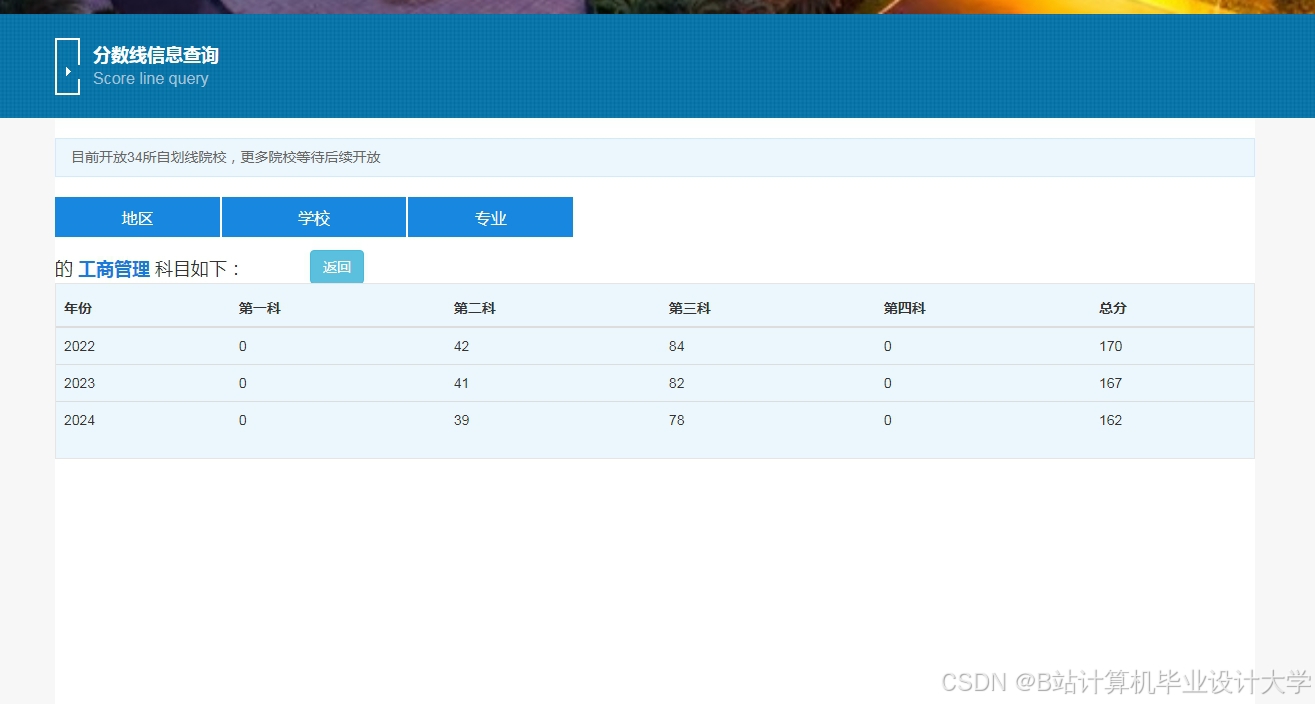

- 提供交互式可视化分析界面,支持分数线趋势、竞争热度等数据的动态展示。

- 技术性能目标:

- 系统响应时间:单次预测请求≤500ms,支持1000并发用户。

- 数据处理效率:10亿条原始数据清洗与特征提取时间≤2小时。

- 模型更新频率:支持每日增量训练,确保预测时效性。

二、任务内容与分解

2.1 数据采集与存储模块

任务内容:

- 数据源整合:

- 结构化数据:从教育部官网、研招网采集历年分数线、报录比、招生计划等数据。

- 非结构化数据:爬取考研论坛、高校官网的文本信息(如考生评价、招生政策解读)。

- 分布式存储设计:

- 使用Hadoop HDFS存储原始数据,配置3节点集群(1主2从),副本数设为2。

- 通过Hive构建数据仓库,定义外部表映射HDFS文件,支持SQL查询。

交付成果:

- 完成50+数据源的爬虫配置文件(Scrapy框架)。

- 提交HDFS存储架构设计图及Hive表结构定义文档。

2.2 数据预处理与特征工程模块

任务内容:

- 数据清洗:

- 处理缺失值:对分数线、报录比等关键字段,采用线性插值法填充缺失值。

- 异常值检测:基于3σ原则识别并修正分数线异常波动(如某专业分数线突增50分)。

- 特征提取:

- 基础特征:院校层次(985/211/普通)、地域(一线城市/省会/其他)、专业类型(学术型/专业型)。

- 衍生特征:考生评价情感值(通过SnowNLP分析论坛文本)、政策变动系数(根据招生简章变化量化)。

- 降维处理:

- 使用Spark MLlib的PCA算法将特征维度从100+降至20-30维,保留95%以上方差。

交付成果:

- 提交数据清洗规则文档及特征工程Python脚本。

- 完成特征重要性分析报告(基于XGBoost模型输出)。

2.3 预测模型构建与优化模块

任务内容:

- 算法选型与实现:

- 时间序列模型:Prophet算法,用于分析分数线的年度周期性变化。

- 机器学习模型:随机森林(处理非线性关系)、XGBoost(提升训练效率)。

- 深度学习模型:LSTM网络,捕捉分数线的长期依赖性(如某专业分数线连续3年上涨)。

- 模型融合:

- 采用Stacking集成策略,以XGBoost为基模型,LSTM为元模型,综合各算法优势。

- 参数调优:

- 通过5折交叉验证和网格搜索优化超参数(如XGBoost的max_depth、LSTM的hidden_size)。

交付成果:

- 提交模型训练日志及超参数配置文件。

- 完成模型评估报告(对比RMSE、MAE、R²等指标)。

2.4 院校推荐与可视化模块

任务内容:

- 推荐算法设计:

- 基于考生特征向量(本科成绩、专业背景等)与院校特征向量(知名度、就业前景等)的余弦相似度,实现Top-N推荐。

- 引入冷启动策略:对新用户采用基于内容的推荐(如优先推荐本科专业相关院校)。

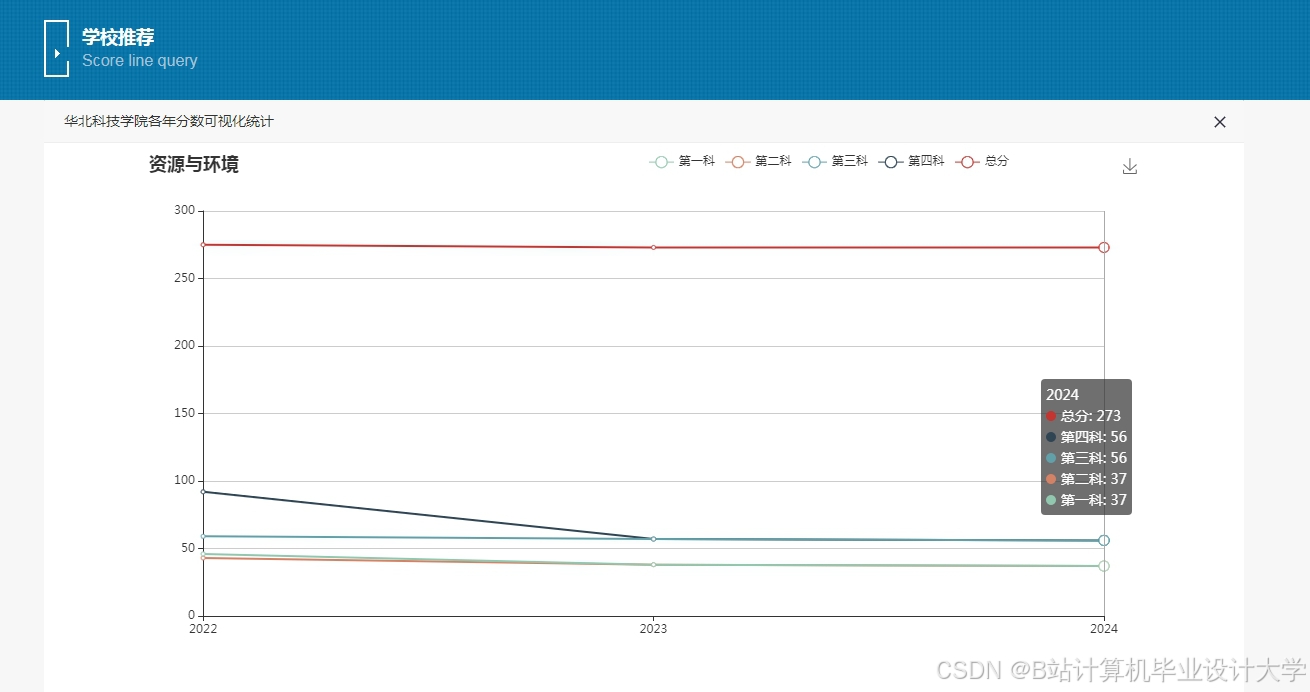

- 可视化开发:

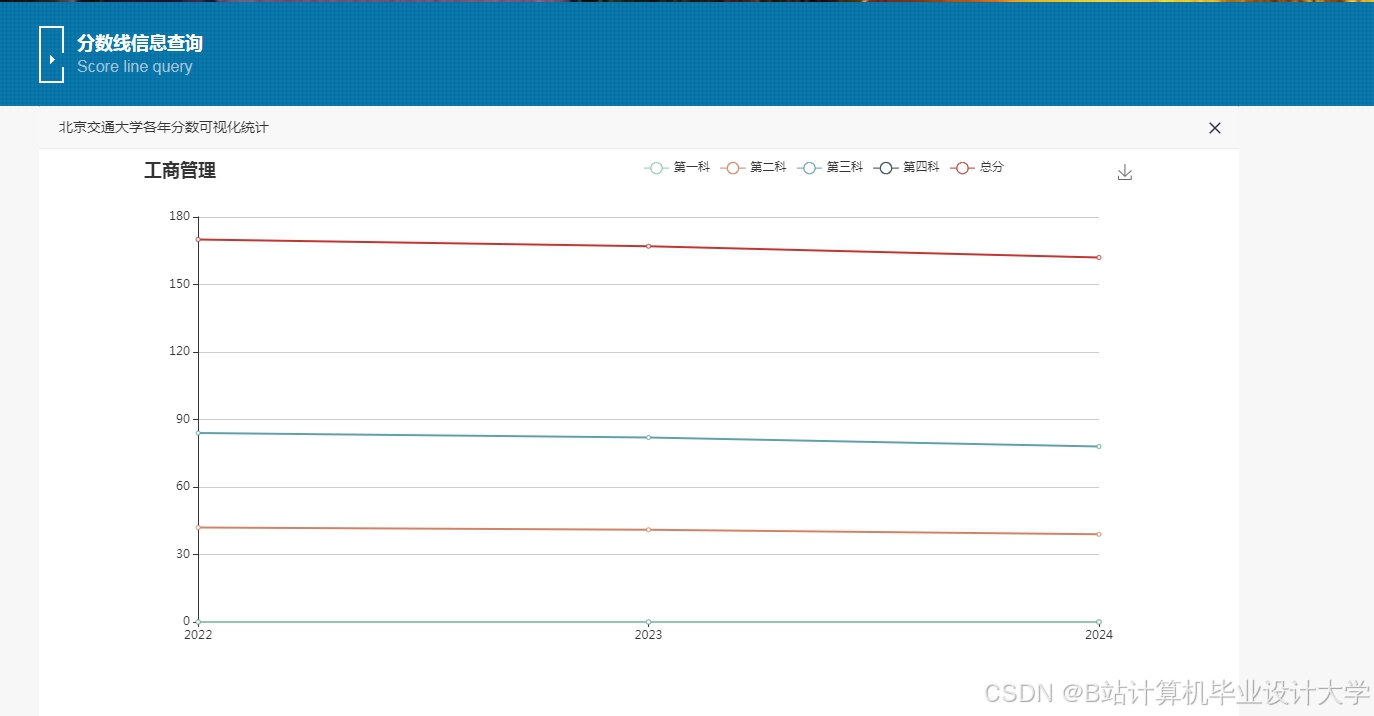

- 集成ECharts,开发分数线趋势图(折线图)、竞争热度地图(热力图)、推荐院校列表(表格)。

- 支持时间轴筛选(如查看某专业近5年分数线)、地域钻取(如点击省份查看该地高校数据)。

交付成果:

- 提交推荐算法伪代码及可视化界面原型图。

- 完成用户交互测试报告(收集20名用户反馈)。

2.5 系统集成与测试模块

任务内容:

- 接口开发:

- 使用Flask框架构建RESTful API,定义/predict(预测)、/recommend(推荐)、/visualize(可视化)等端点。

- 性能测试:

- 使用JMeter模拟1000并发用户,测试系统响应时间、吞吐量等指标。

- 优化Spark任务调度策略(如动态资源分配),减少数据处理延迟。

- 安全加固:

- 实现JWT认证,保护API接口免受未授权访问。

- 对敏感数据(如考生个人信息)进行AES加密存储。

交付成果:

- 提交API文档及接口测试用例。

- 完成系统性能优化报告(对比优化前后指标)。

三、任务计划与进度

| 阶段 | 时间 | 关键任务 | 交付成果 |

|---|---|---|---|

| 1 | 2025.07-2025.08 | 需求分析、技术选型、环境搭建 | 需求规格说明书、技术架构图 |

| 2 | 2025.09-2025.10 | 数据采集、存储层开发 | 爬虫脚本、HDFS集群配置文档 |

| 3 | 2025.11-2025.12 | 数据预处理、特征工程 | 清洗规则文档、特征重要性报告 |

| 4 | 2026.01-2026.02 | 模型训练、推荐算法开发 | 模型评估报告、推荐算法伪代码 |

| 5 | 2026.03-2026.04 | 可视化开发、系统集成 | 界面原型图、API文档 |

| 6 | 2026.05 | 测试优化、论文撰写 | 测试报告、学术论文初稿 |

四、资源需求与保障

4.1 硬件资源

- 服务器:3台(配置:16核CPU、64GB内存、2TB硬盘),用于部署Hadoop/Spark集群。

- 云存储:阿里云OSS(500GB容量),用于备份原始数据。

4.2 软件资源

- 操作系统:CentOS 7.6(64位)。

- 开发工具:PyCharm(Python开发)、IntelliJ IDEA(Java开发,用于Spark任务)。

- 依赖库:Scrapy 2.12、Hadoop 3.3.6、Spark 3.5.0、TensorFlow 2.15。

4.3 人员配置

- 项目负责人:1名(统筹规划、技术指导)。

- 开发工程师:3名(数据采集、模型训练、前端开发)。

- 测试工程师:1名(性能测试、缺陷跟踪)。

五、风险评估与应对

5.1 数据质量风险

- 风险描述:部分高校招生简章格式不统一,导致爬虫解析失败。

- 应对措施:制定数据清洗规则,对异常格式数据进行人工校验与修正。

5.2 技术实现风险

- 风险描述:Spark任务因数据倾斜导致运行超时。

- 应对措施:采用salting技术对键进行随机加盐,分散数据分布。

5.3 进度延误风险

- 风险描述:模型调优耗时超出预期,影响后续测试。

- 应对措施:设置里程碑检查点,提前预留10%缓冲时间。

六、验收标准与方式

6.1 验收标准

- 功能完整性:系统实现数据采集、预测、推荐、可视化等全部核心功能。

- 性能达标:单次预测响应时间≤500ms,模型预测误差率≤5%。

- 文档完备:提交需求分析、设计文档、测试报告等全套技术资料。

6.2 验收方式

- 功能测试:由测试团队按照测试用例逐项验证系统功能。

- 性能测试:使用JMeter模拟高并发场景,检查系统吞吐量与响应时间。

- 用户验收:邀请20名考生代表试用系统,收集反馈意见并优化。

项目负责人(签字): 日期:

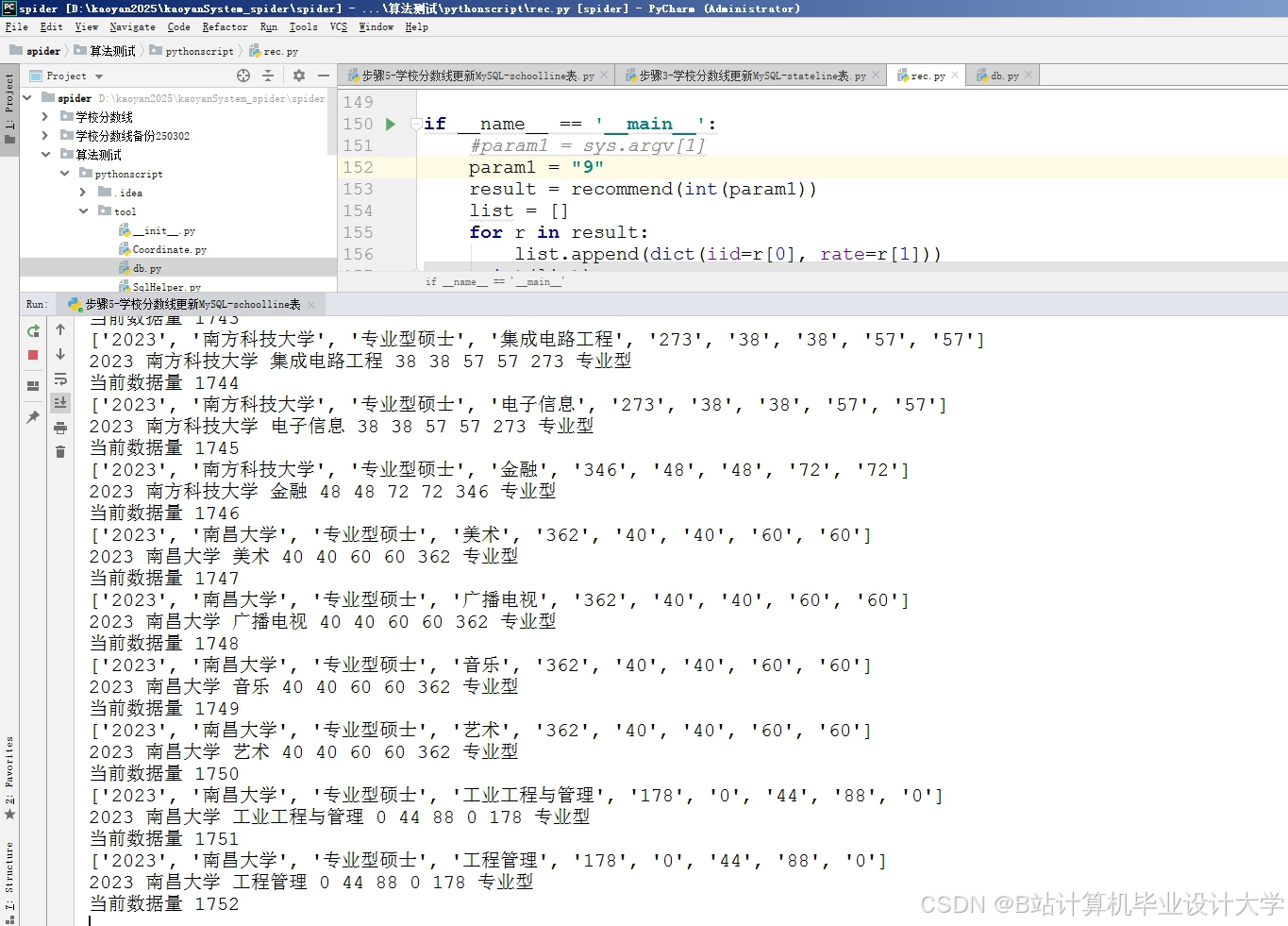

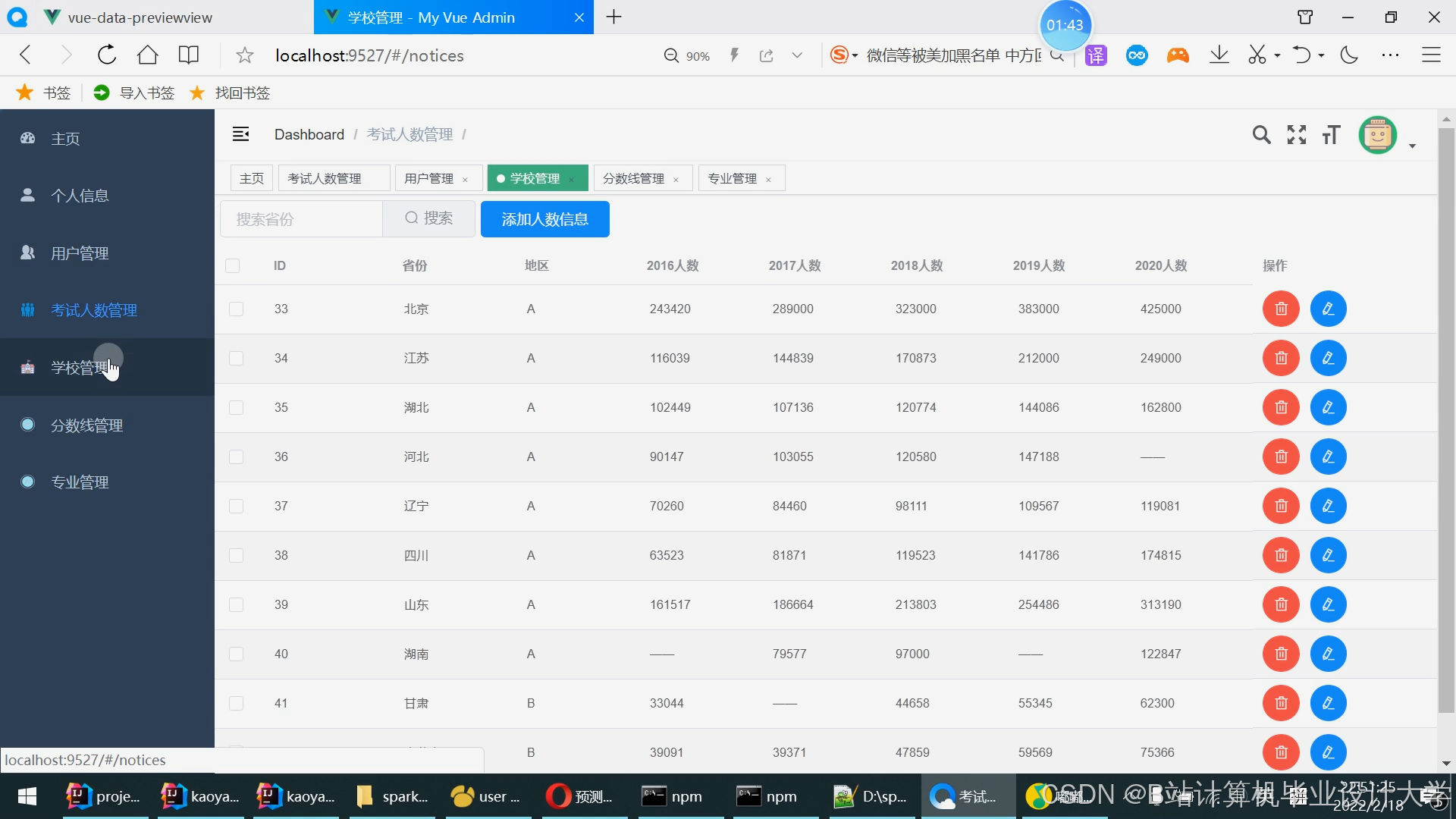

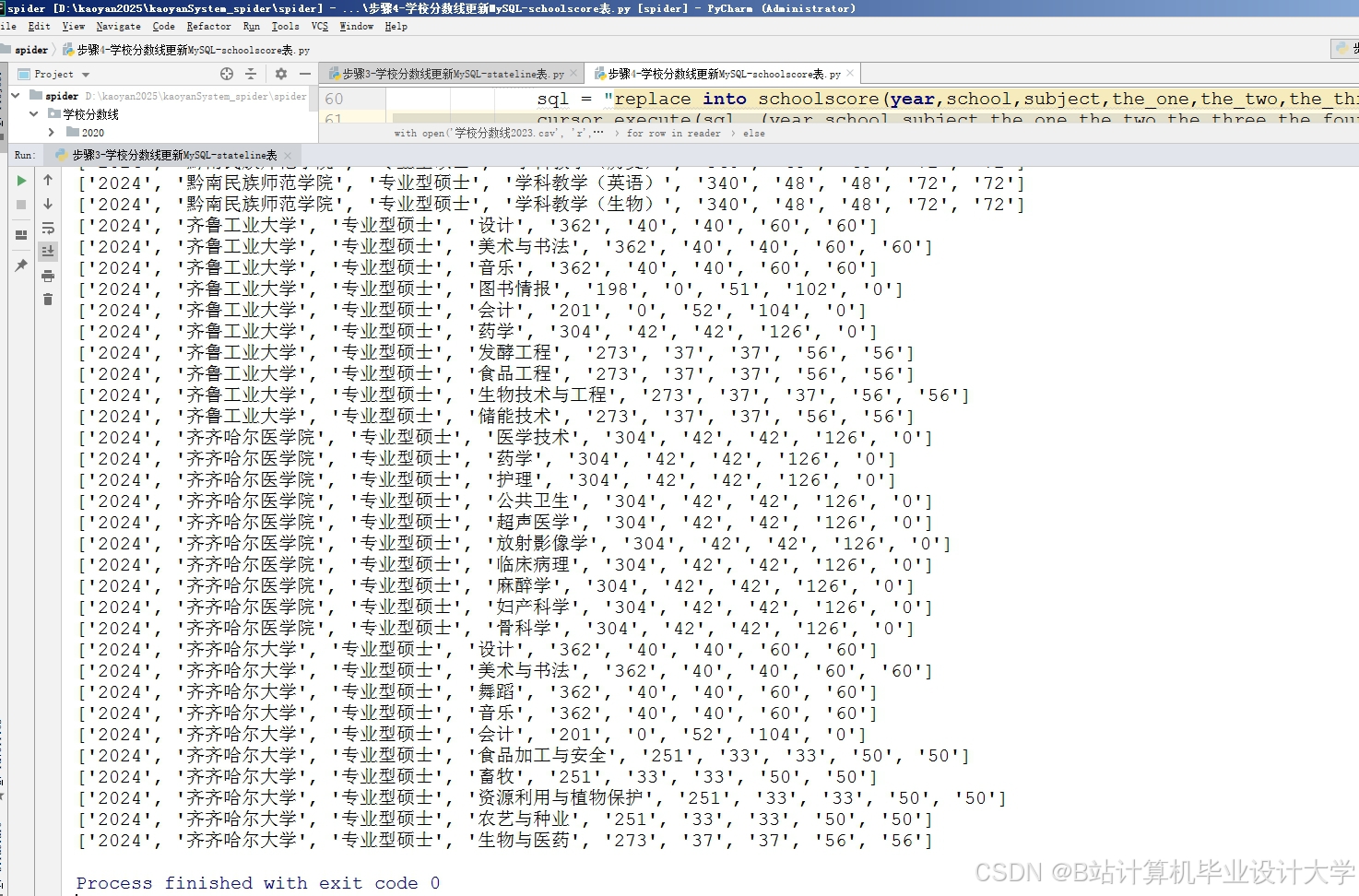

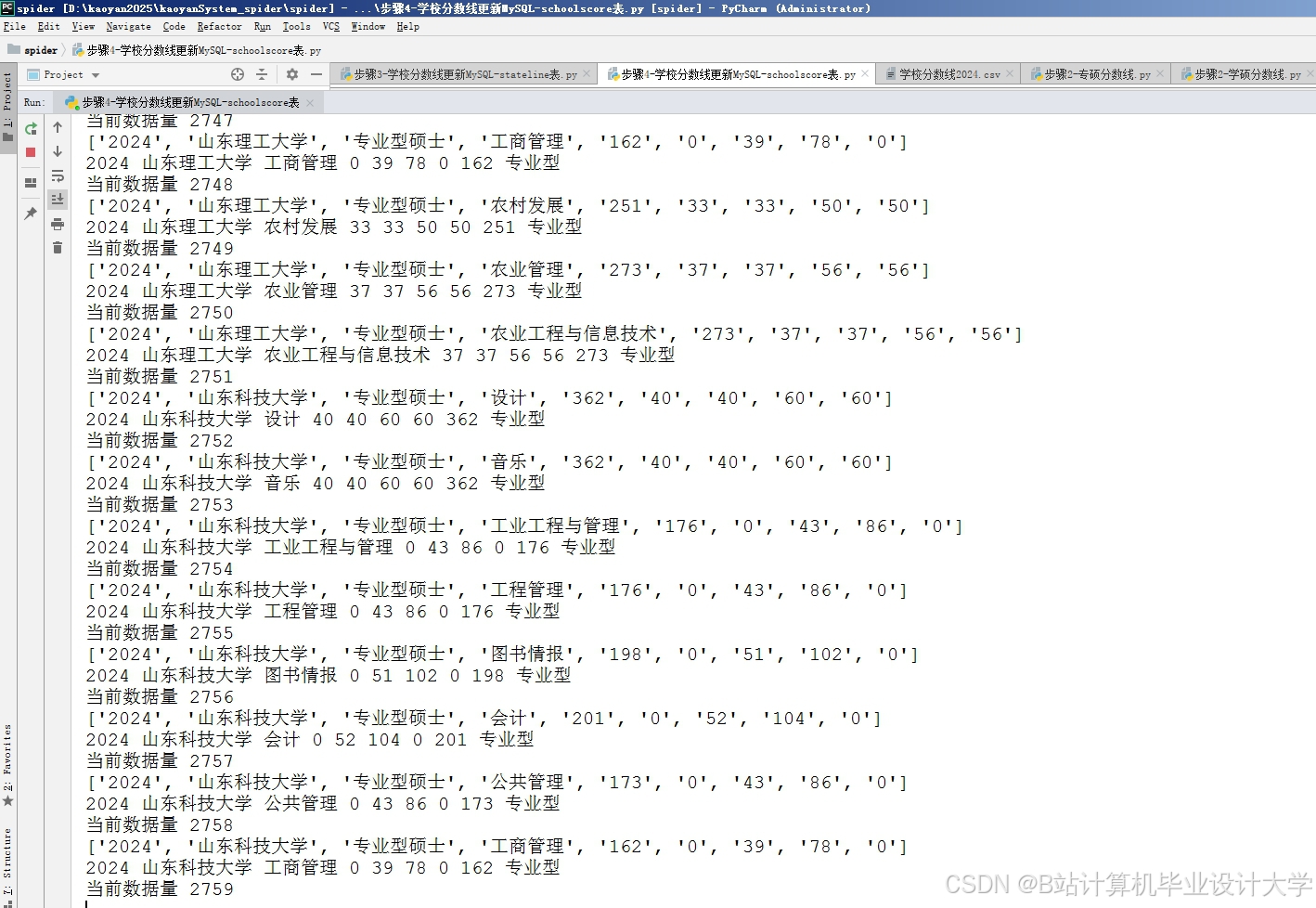

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

988

988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?