温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive 知网论文推荐系统技术说明

一、系统概述

在学术研究领域,面对知网等平台海量的论文文献,科研人员常陷入信息过载困境,难以快速获取符合自身需求的论文。Hadoop+Spark+Hive 知网论文推荐系统应运而生,该系统整合 Hadoop 的分布式存储能力、Spark 的高效计算能力以及 Hive 的数据查询与分析功能,旨在为科研人员提供个性化、精准的论文推荐服务,提升学术资源获取效率。

二、核心技术组件

(一)Hadoop

- HDFS(Hadoop Distributed File System)

- 作为 Hadoop 的核心存储组件,HDFS 采用主从架构,由 NameNode 和 DataNode 组成。NameNode 负责管理文件系统的命名空间和客户端对文件的访问,DataNode 则存储实际的数据块。

- 在知网论文推荐系统中,HDFS 用于存储海量的论文原始数据,包括论文的文本内容、元数据(如标题、作者、发表时间等)、引用关系数据等。其高容错性和高吞吐量的特性,确保了大规模数据的安全存储和高效访问。例如,当某个 DataNode 出现故障时,HDFS 能够自动将该节点上的数据块复制到其他正常节点,保证数据的完整性。

- YARN(Yet Another Resource Negotiator)

- YARN 是 Hadoop 的资源管理框架,负责集群资源的分配和管理。它将资源管理和作业调度分离,提高了集群的利用率和灵活性。

- 在系统中,YARN 为 Spark 等计算框架提供资源分配服务,确保各个计算任务能够获得足够的资源,高效运行。例如,当 Spark 提交一个数据处理任务时,YARN 会根据集群的资源使用情况,为该任务分配合适的 CPU、内存等资源。

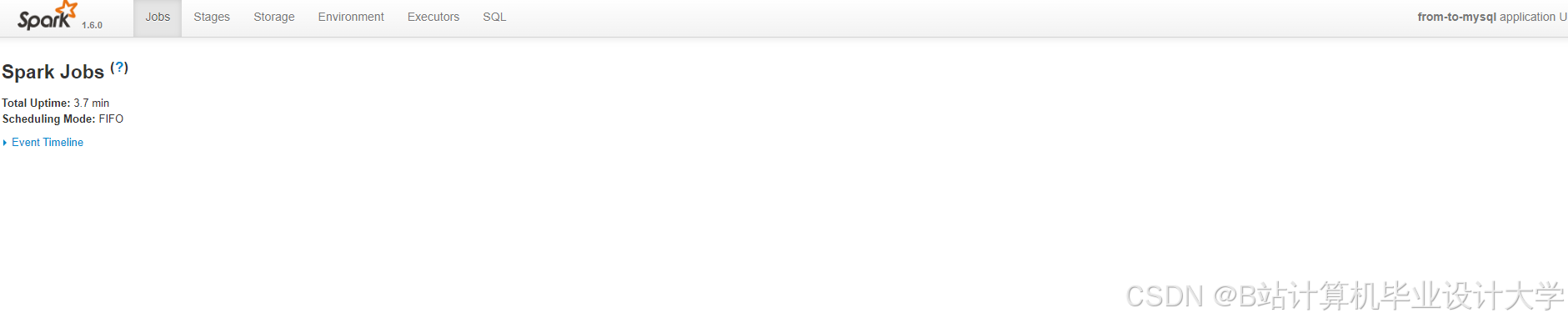

(二)Spark

- 核心架构与特性

- Spark 基于内存计算,采用弹性分布式数据集(RDD)作为核心数据结构,具有快速、通用、易用等特点。它支持多种编程语言,如 Scala、Python、Java 等,方便开发人员进行数据处理和分析。

- 在知网论文推荐系统中,Spark 主要用于对存储在 HDFS 中的论文数据进行高效处理。例如,对论文文本进行分词、词性标注、特征提取等操作,以及实现各种推荐算法。由于其内存计算特性,Spark 能够显著提高数据处理速度,相比传统的 MapReduce 计算框架,处理速度可提升数倍甚至数十倍。

- 与 Hadoop 的集成

- Spark 可以直接读取 HDFS 中的数据,无需将数据加载到本地内存,实现了与 Hadoop 的无缝集成。在系统中,Spark 通过 Hadoop 的输入输出格式接口,读取 HDFS 上的论文数据文件,进行处理后将结果写回 HDFS 或 Hive 数据仓库。

(三)Hive

- 数据仓库功能

- Hive 是一个基于 Hadoop 的数据仓库工具,它提供了类似 SQL 的查询语言 HiveQL,方便用户对存储在 HDFS 中的数据进行查询和分析。Hive 将结构化的数据文件映射为一张数据库表,并提供简单的 SQL 查询功能,可以将 SQL 语句转换为 MapReduce 任务进行运行。

- 在知网论文推荐系统中,Hive 用于构建论文数据仓库,对论文数据进行分类管理和查询。例如,根据论文的学科领域、发表年份等维度对数据进行分区存储,方便后续的数据分析和推荐算法实现。开发人员可以使用 HiveQL 对论文数据进行统计分析,如计算不同学科领域的论文数量、作者的发文量等。

- 与 Spark 的协同工作

- Spark 可以通过 Spark SQL 访问 Hive 中的数据,实现数据的共享和交互。在系统中,Spark 可以直接读取 Hive 表中的数据,进行处理后将结果写回 Hive 表,方便后续的数据查询和分析。同时,Hive 也可以利用 Spark 的计算能力,通过设置 Hive 的执行引擎为 Spark,提高查询效率。

三、数据处理流程

(一)数据采集

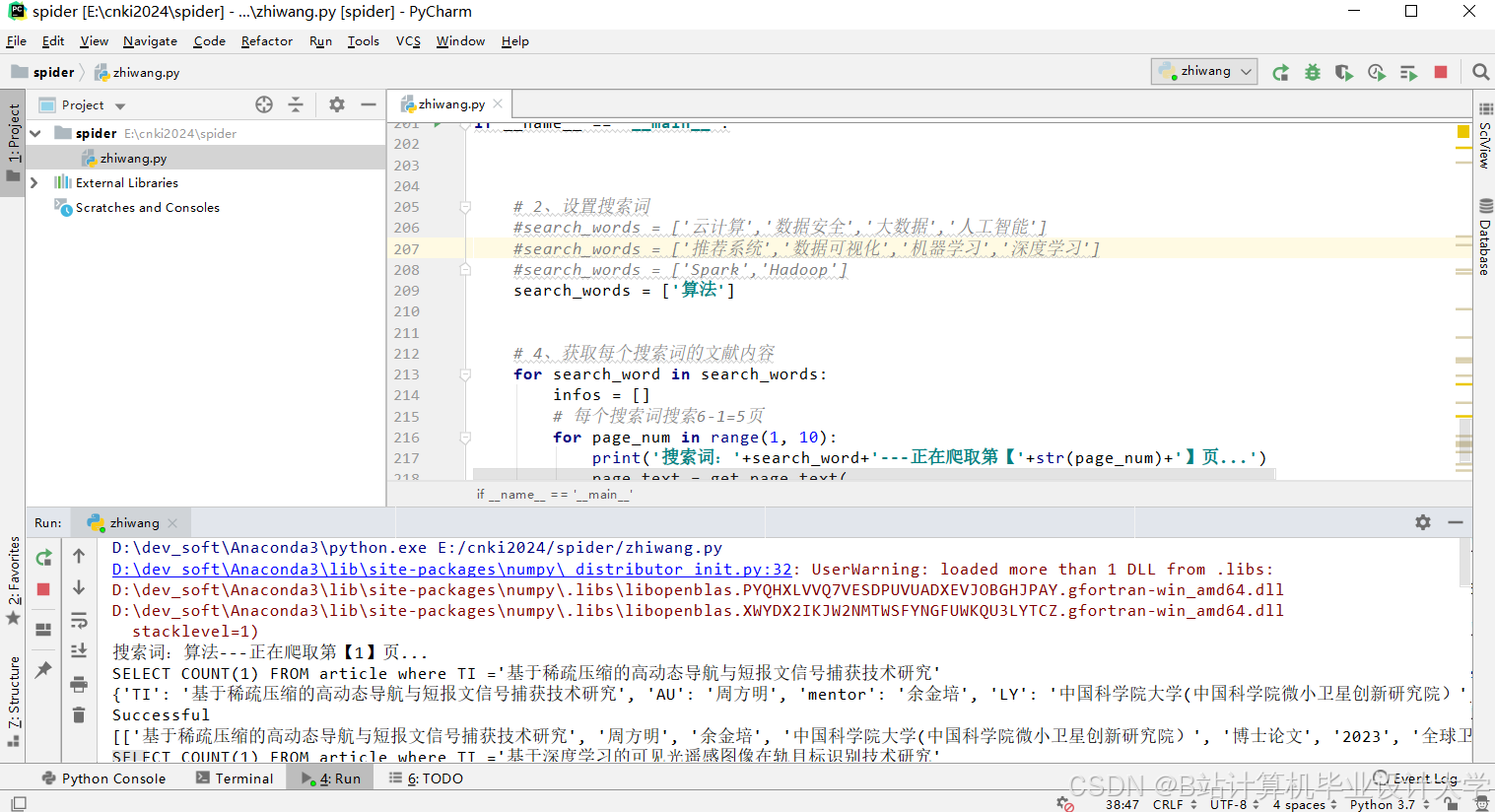

使用 Python 的 Scrapy 框架构建爬虫程序,从知网平台抓取学术论文数据。爬虫程序模拟用户登录、搜索等操作,获取论文的标题、摘要、关键词、作者信息、发表时间、引用关系等数据。为提高数据采集效率和稳定性,采用分布式爬虫策略,将爬虫任务分配到多个节点并行执行。同时,设置合理的爬取频率,避免对知网服务器造成过大压力。采集到的数据以 JSON 格式存储,并通过 Spark 的 DataFrame API 将数据写入 HDFS。

(二)数据预处理

- 数据清洗

- 利用 Spark 对采集到的原始数据进行清洗,去除重复数据、修正格式错误、处理缺失值等。例如,对于重复的论文记录,根据论文的唯一标识符(如 DOI)进行去重操作;对于格式错误的数据,如日期格式不统一,使用 Spark 的日期处理函数进行格式转换;对于缺失值,根据具体情况采用填充默认值、删除记录等方法进行处理。

- 特征提取

- 对论文文本进行特征提取,为后续的推荐算法提供数据支持。使用 TF-IDF 算法提取论文的关键词特征,计算每个词在论文中的重要程度;利用 Doc2Vec 算法生成论文的语义向量,捕捉论文的语义信息。同时,提取论文的引用特征,如引用次数、被引用论文的特征等,以及作者特征,如作者的学术影响力、研究方向等。

(三)数据存储

将预处理后的数据存储到 Hive 数据仓库中。根据数据的特征和查询需求,设计合理的表结构,对数据进行分区存储。例如,按照论文的学科领域和发表年份进行分区,方便后续的数据查询和分析。同时,将提取的特征数据存储在专门的特征表中,与论文的基本信息表进行关联,为推荐算法提供丰富的数据支持。

四、推荐算法实现

(一)基于内容的推荐算法

- 原理

基于内容的推荐算法通过分析论文的内容特征,如关键词、摘要等,为用户推荐与他们历史浏览或收藏论文内容相似的论文。其核心思想是计算论文之间的相似度,根据相似度进行推荐。 - 实现

在系统中,使用 Spark 计算论文之间的余弦相似度。首先,将论文的关键词向量或语义向量存储在 Spark 的广播变量中,减少数据传输量。然后,对于每个用户,获取其历史浏览或收藏的论文集合,计算这些论文与其他论文的相似度,将相似度较高的论文推荐给用户。

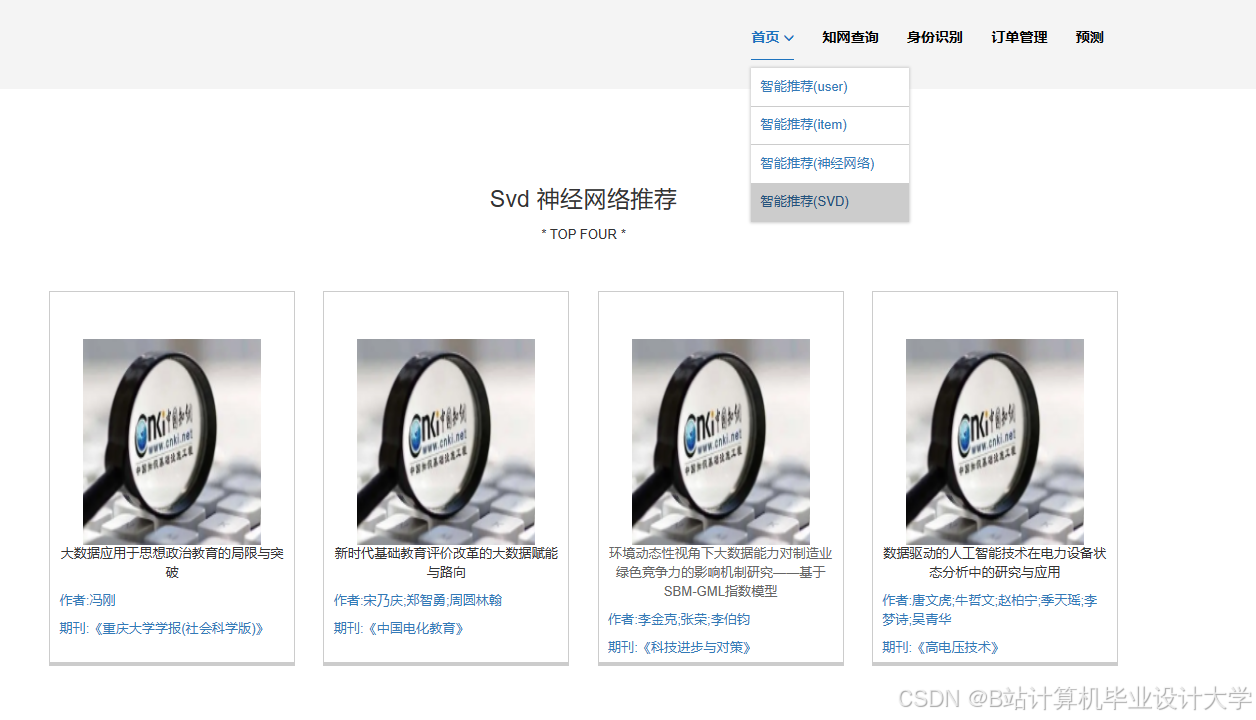

(二)协同过滤推荐算法

- 原理

协同过滤推荐算法根据用户的历史行为数据,找到与目标用户兴趣相似的其他用户,然后将这些相似用户喜欢的论文推荐给目标用户。主要分为基于用户的协同过滤和基于物品的协同过滤两种方法。 - 实现

使用 Spark MLlib 中的 ALS(交替最小二乘法)进行矩阵分解,得到用户和论文的潜在特征向量。根据潜在特征向量计算用户对论文的评分预测值,为用户推荐评分高的论文。在计算过程中,对数据进行归一化处理,避免特征值量纲不同对结果的影响。同时,为了提高推荐的准确性,可以结合用户的个人信息(如学科领域、研究方向等)对推荐结果进行优化。

(三)混合推荐算法

- 原理

混合推荐算法结合了基于内容的推荐算法和协同过滤推荐算法的优点,以提高推荐的准确性和多样性。通过一定的权重将两种算法的推荐结果进行融合,或者采用更复杂的融合策略,如基于模型的方法、基于特征的方法等。 - 实现

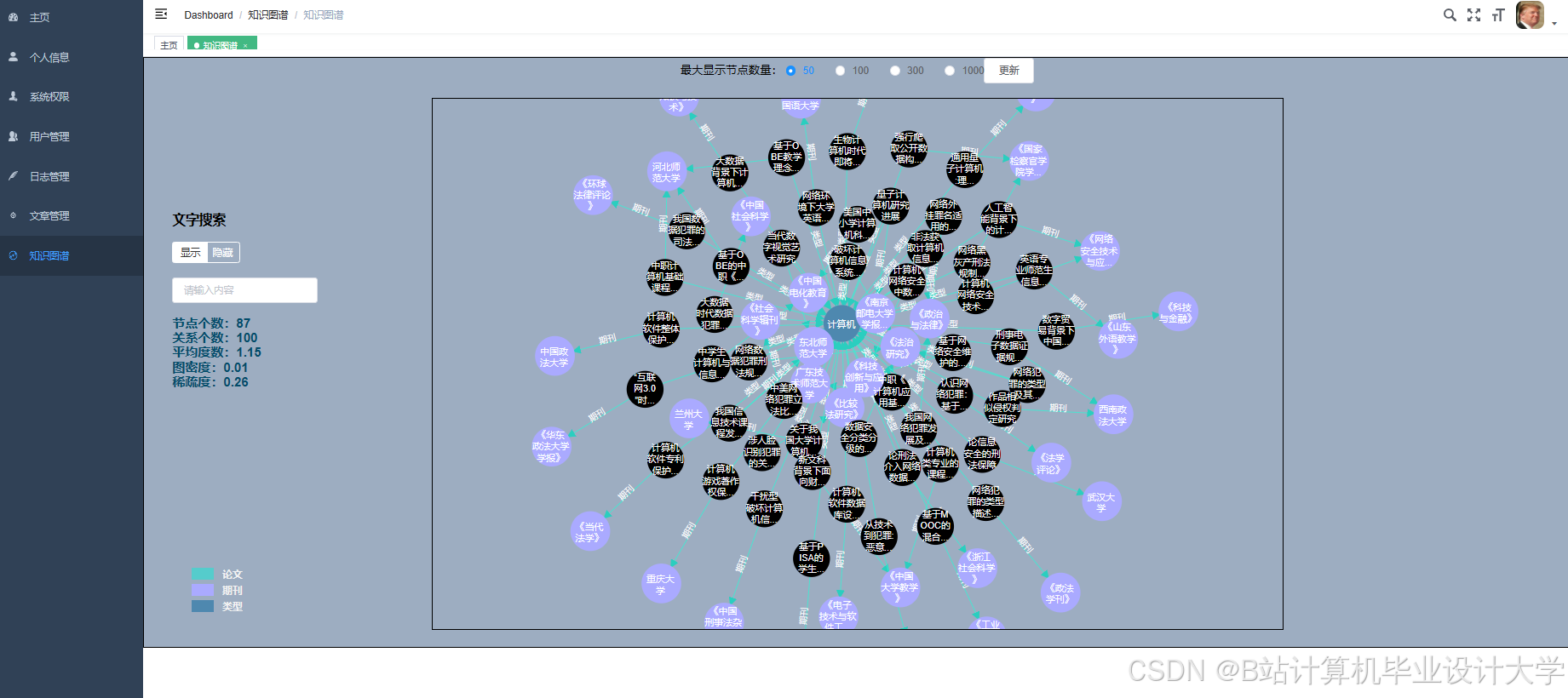

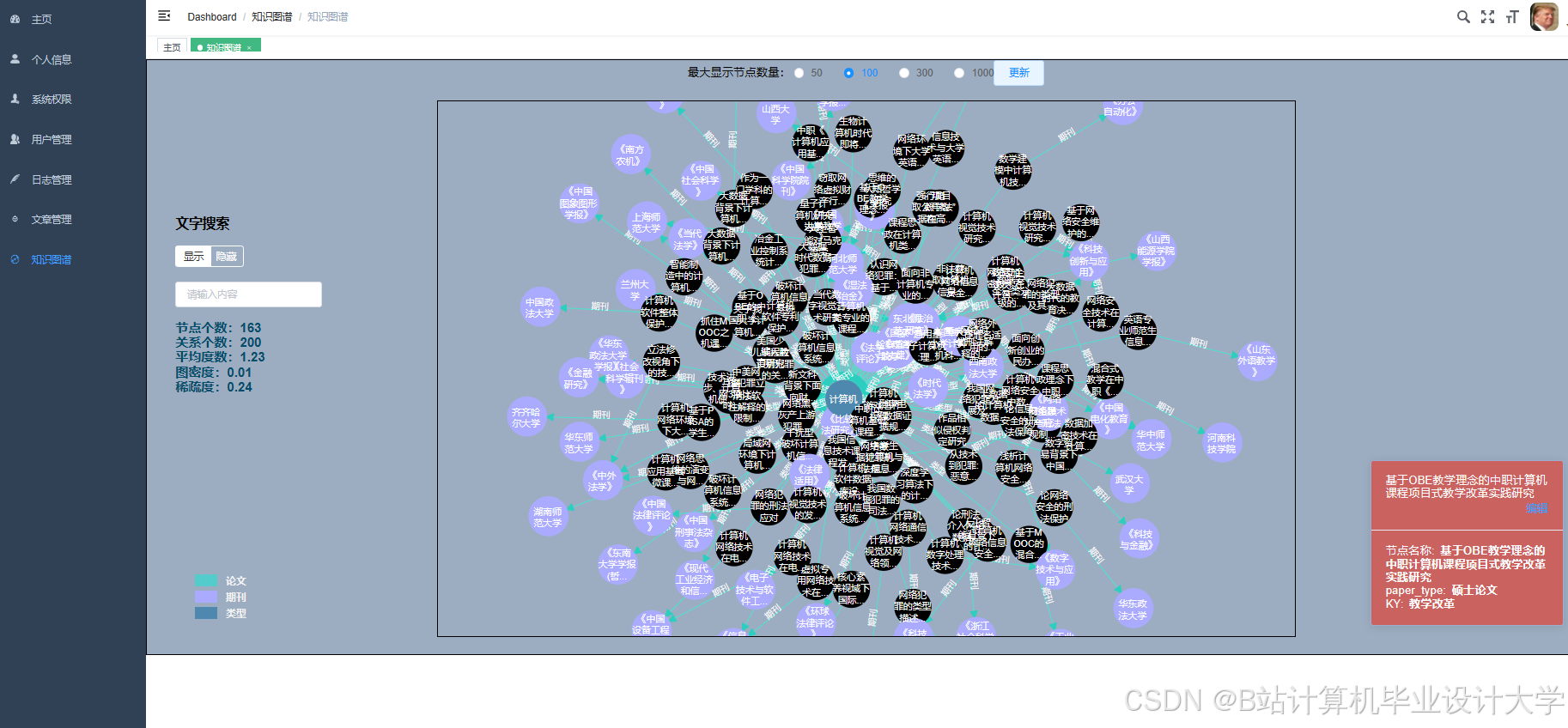

在系统中,根据实验结果和业务需求,确定基于内容的推荐算法和协同过滤推荐算法的权重。将两种算法的推荐结果进行加权融合,得到最终的推荐列表。同时,引入知识图谱嵌入(KGE)技术,将论文、作者、机构等实体及其关系嵌入到低维向量空间中,丰富推荐特征,进一步优化推荐结果。

五、系统优势

(一)高效的数据处理能力

利用 Hadoop 的分布式存储和 Spark 的内存计算特性,系统能够高效处理海量的论文数据。无论是数据采集、预处理还是推荐算法的实现,都能够在较短的时间内完成,满足科研人员对实时性的需求。

(二)精准的推荐效果

通过结合多种推荐算法和知识图谱嵌入技术,系统能够充分考虑论文的内容特征、用户的历史行为和学术关系等多方面因素,为用户提供个性化的、精准的论文推荐服务,提高科研人员获取相关文献的效率。

(三)良好的可扩展性

系统的架构设计具有良好的可扩展性,能够方便地添加新的数据源、推荐算法和功能模块。当论文数据量不断增加或业务需求发生变化时,系统可以通过增加节点、优化算法等方式进行扩展,保证系统的性能和稳定性。

六、总结

Hadoop+Spark+Hive 知网论文推荐系统通过整合多种大数据技术,实现了对知网论文的高效处理和个性化推荐。该系统具有高效的数据处理能力、精准的推荐效果和良好的可扩展性,为科研人员提供了便捷的学术资源获取途径,有助于促进学术知识的传播和创新。未来,随着技术的不断发展和学术需求的不断变化,系统将进一步优化和完善,为用户提供更加优质的服务。

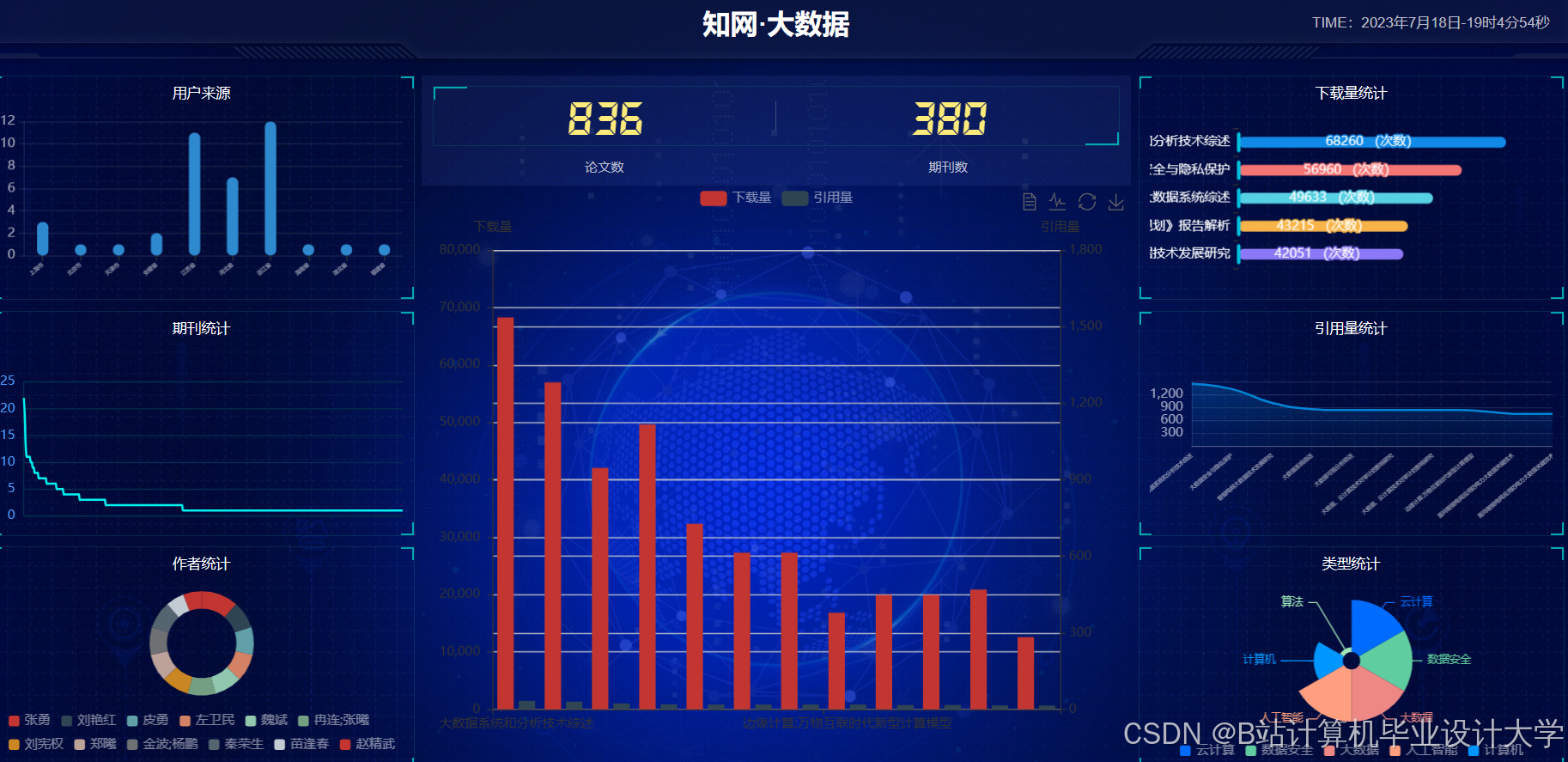

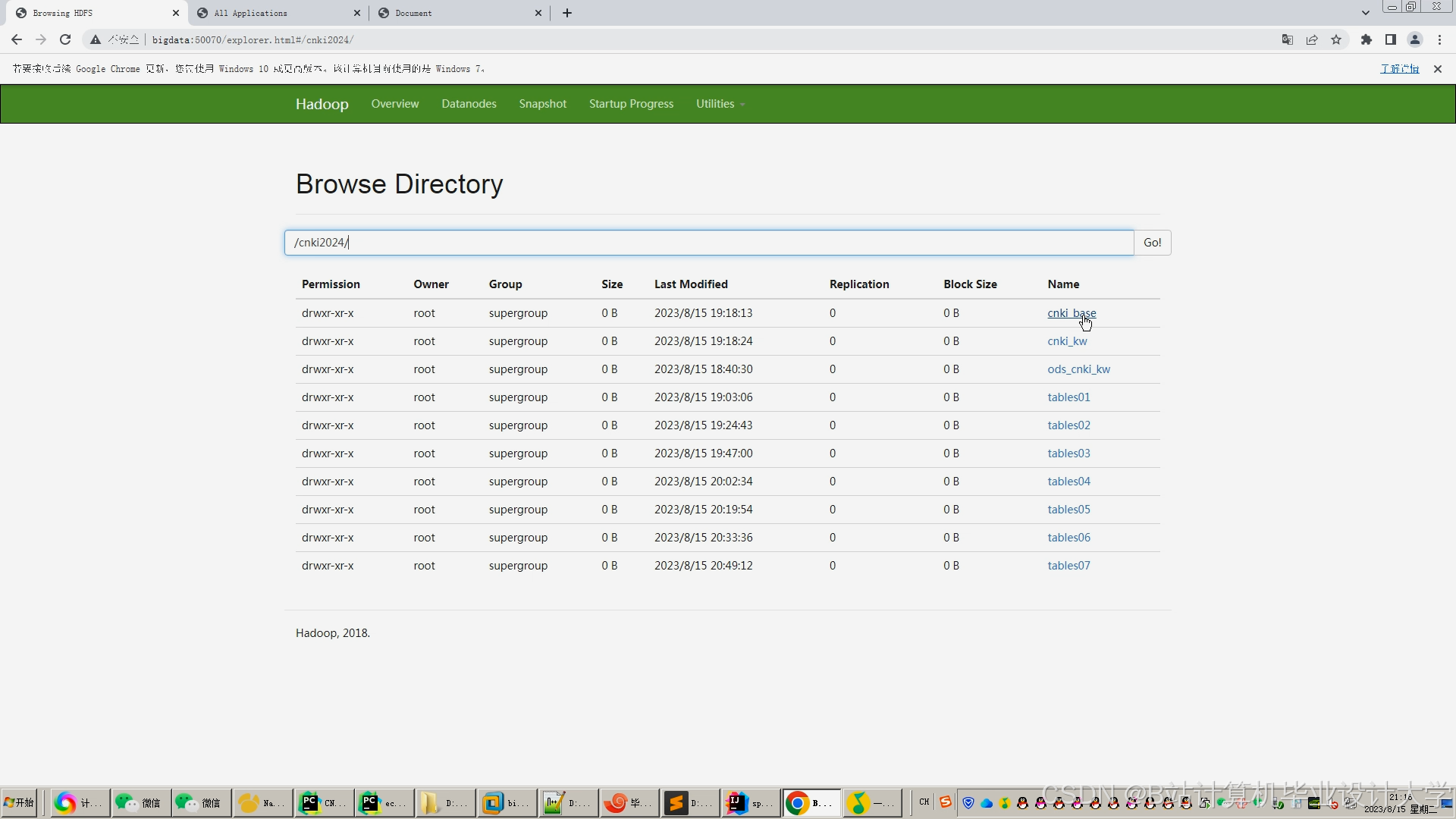

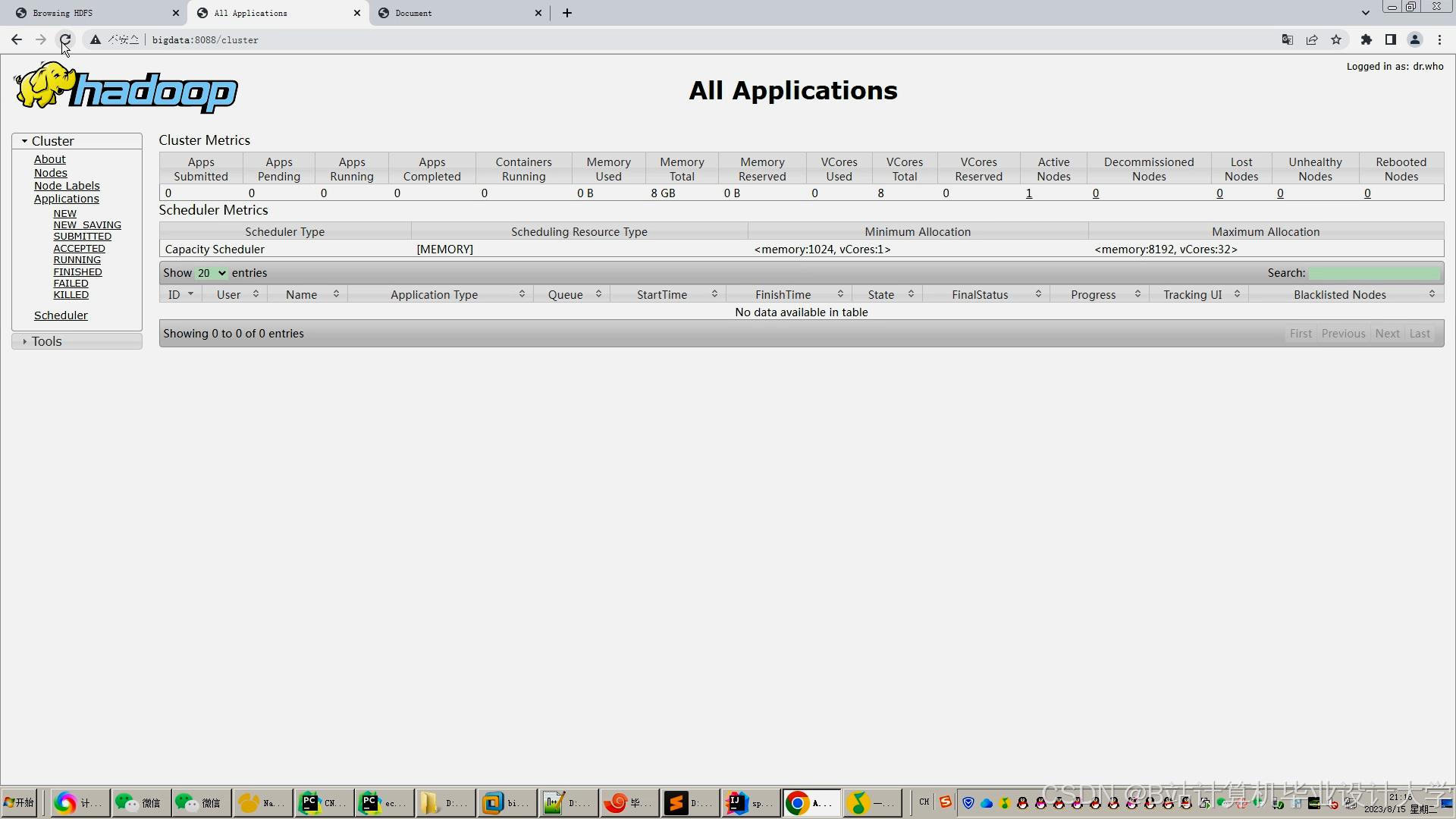

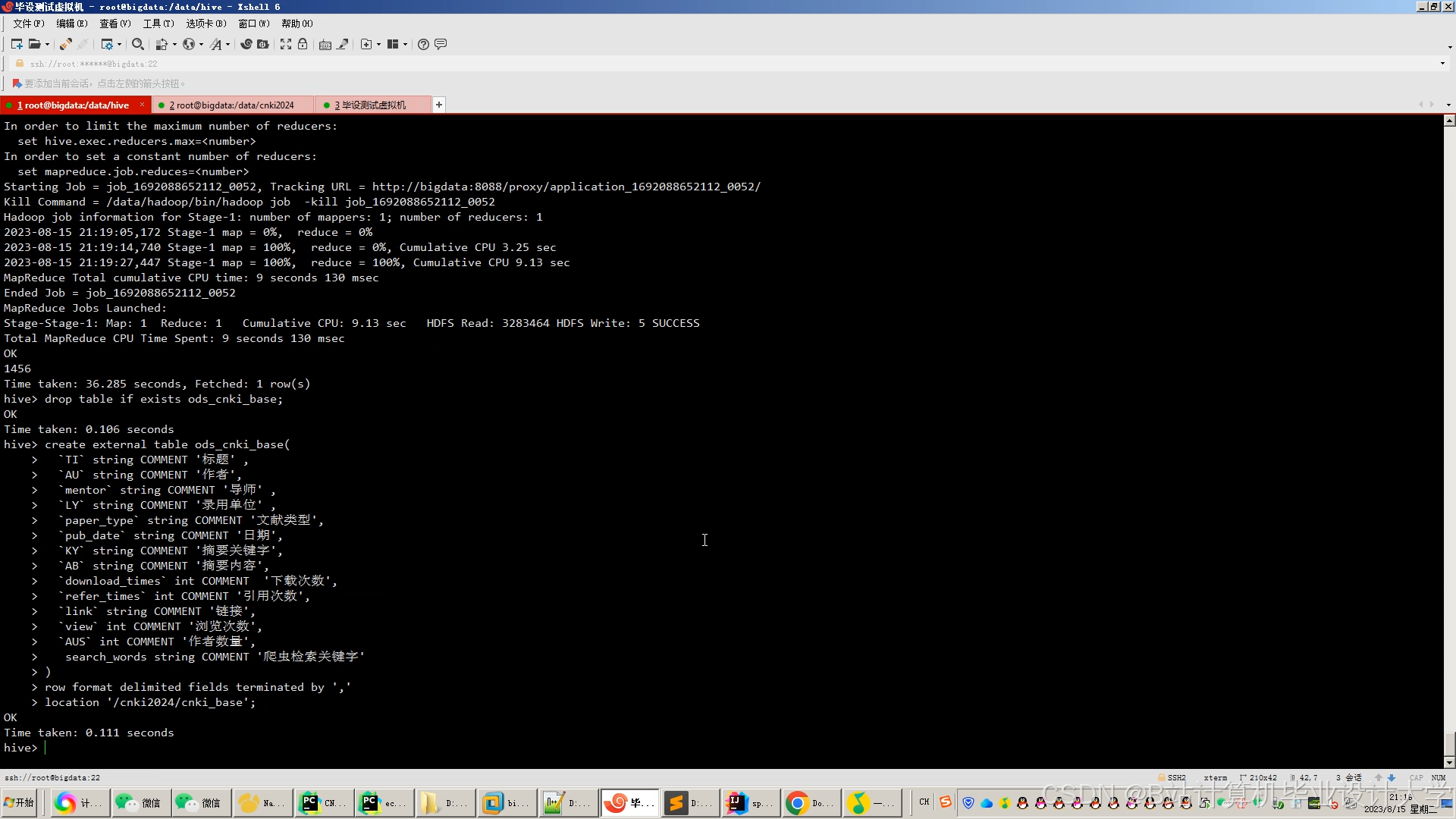

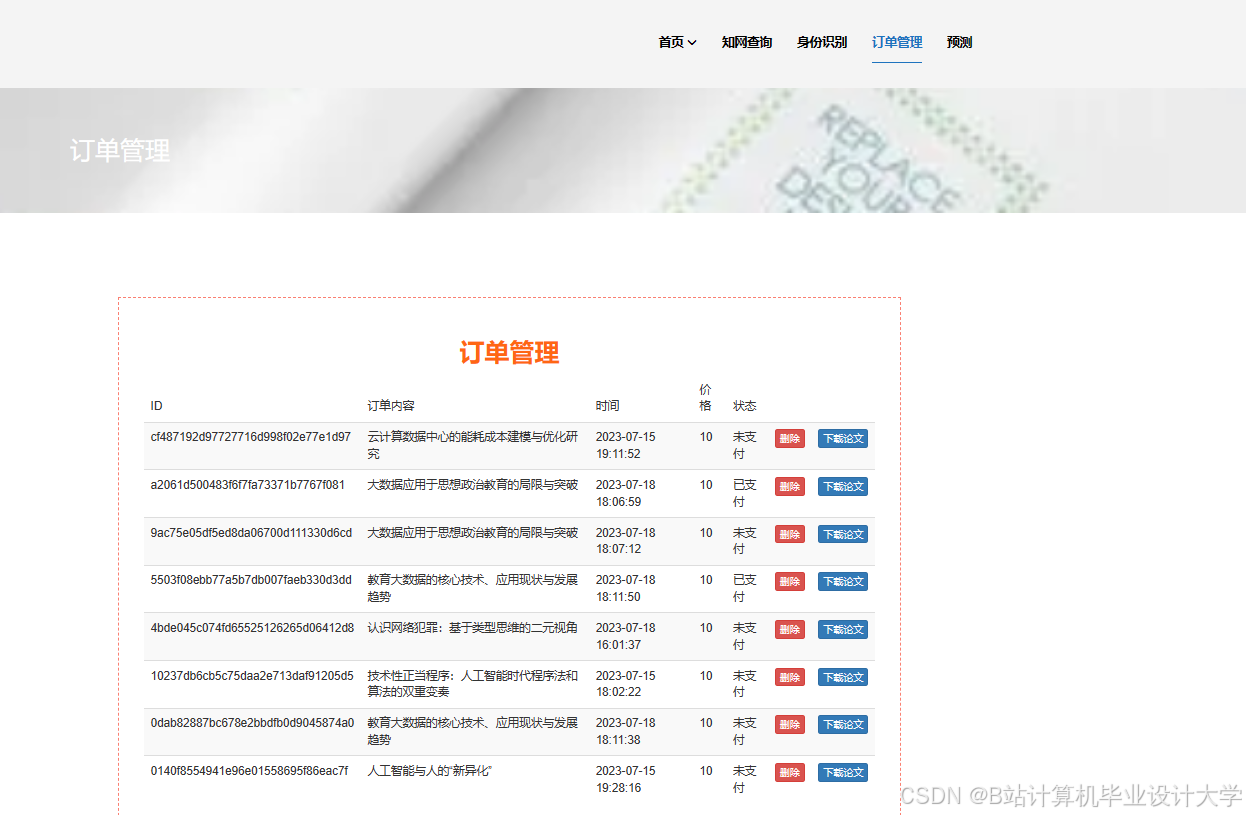

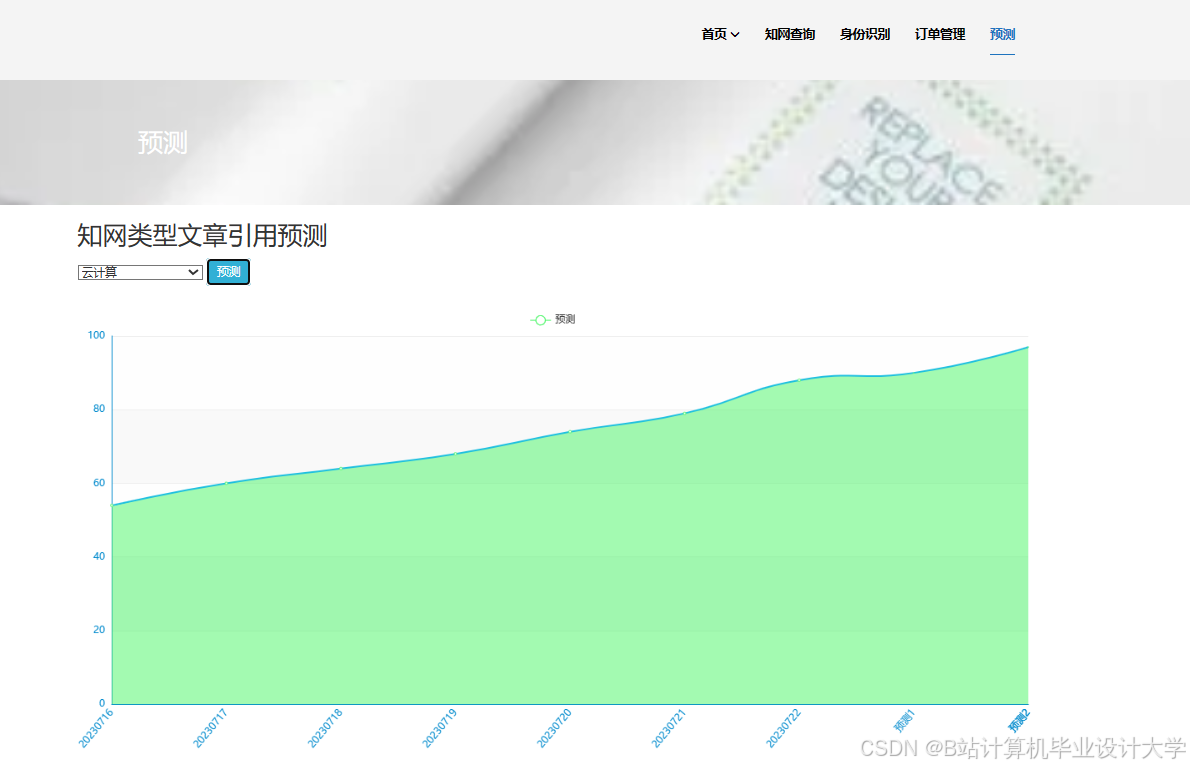

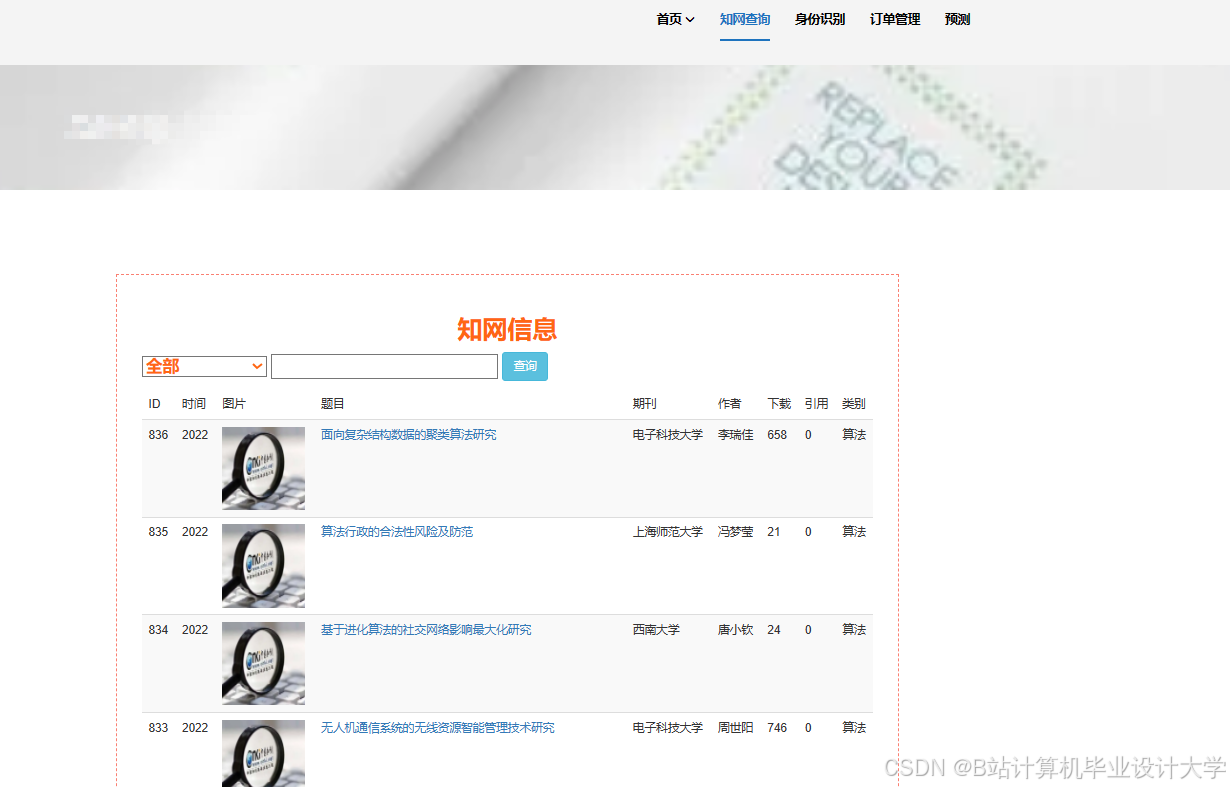

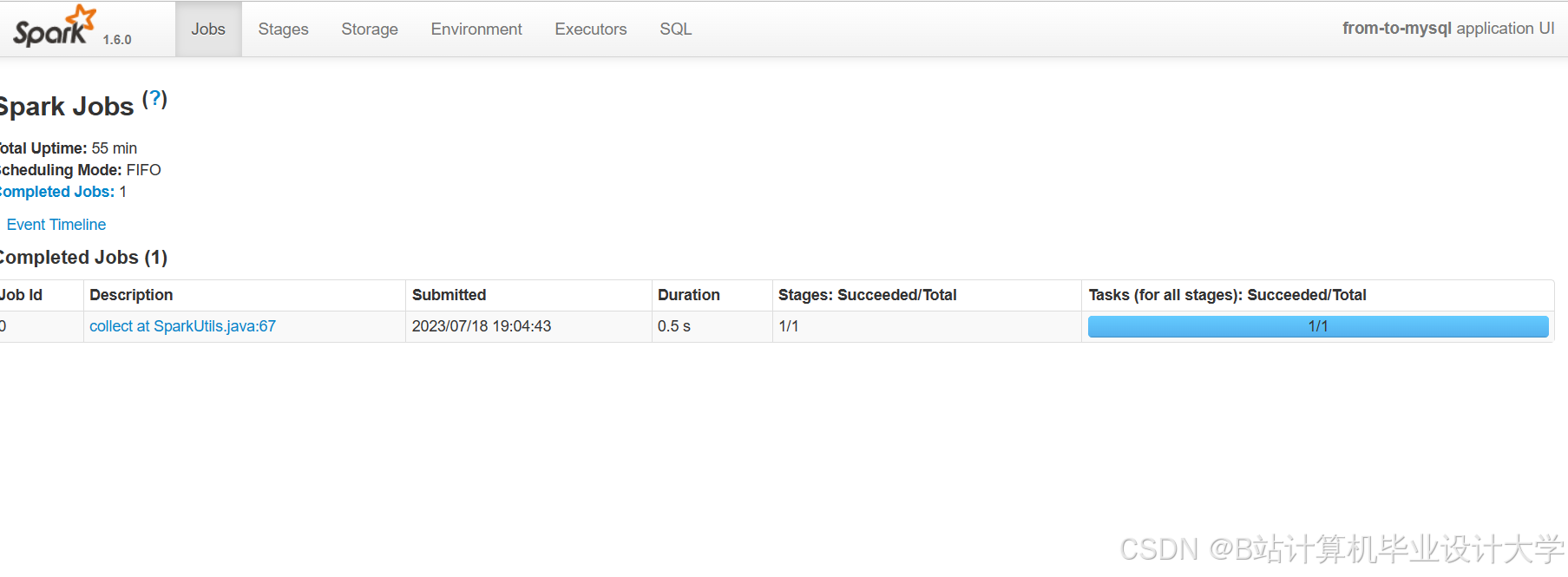

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

117

117

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?