温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《PyFlink + PySpark + Hadoop + Hive 物流预测系统》开题报告

一、选题背景与意义

(一)选题背景

在当今数字化时代,物流行业作为连接生产与消费的关键环节,其发展水平直接影响着经济的运行效率。随着电子商务的蓬勃发展,物流业务量呈现出爆发式增长,物流数据也变得日益庞大和复杂。这些数据涵盖了订单信息、运输轨迹、仓储状态、天气情况等多个维度,蕴含着丰富的潜在价值。

然而,传统的物流预测方法在处理大规模、多源异构的物流数据时,面临着计算效率低、数据处理能力不足、预测精度不高等问题。Hadoop 作为一个成熟的分布式存储和计算框架,能够高效地存储和管理海量物流数据;Hive 作为基于 Hadoop 的数据仓库工具,提供了方便的数据查询和分析功能;PySpark 作为 Spark 的 Python API,以其内存计算优势,大大加快了数据处理速度;PyFlink 则为实时数据处理提供了强大的支持,能够处理物流业务中的实时数据流。将这几种技术相结合,构建物流预测系统,有助于挖掘物流数据中的潜在规律,提高物流预测的准确性和及时性。

(二)选题意义

- 理论意义:本研究将多种大数据处理技术(Hadoop、Hive、PySpark、PyFlink)集成应用于物流预测领域,丰富了物流预测系统的理论体系,为相关领域的研究提供了新的思路和方法,有助于推动大数据技术在物流行业的应用研究。

- 实践意义:通过构建基于 PyFlink + PySpark + Hadoop + Hive 的物流预测系统,能够为物流企业提供更加精准、实时的物流预测服务,帮助企业优化物流资源配置、降低运营成本、提高物流效率和服务质量。同时,该系统有助于物流企业更好地应对市场变化和客户需求,增强企业的市场竞争力。

二、研究目标与内容

(一)研究目标

- 设计并实现一个基于 PyFlink + PySpark + Hadoop + Hive 的物流预测系统架构,能够高效处理海量物流数据,包括实时数据流和历史数据。

- 完成系统中各模块的功能开发,涵盖数据采集与存储、数据预处理、特征工程、模型训练与预测、结果可视化等环节。

- 通过实验验证系统的性能和预测效果,对比传统物流预测方法,证明本系统在预测精度和实时性方面的优势。

(二)研究内容

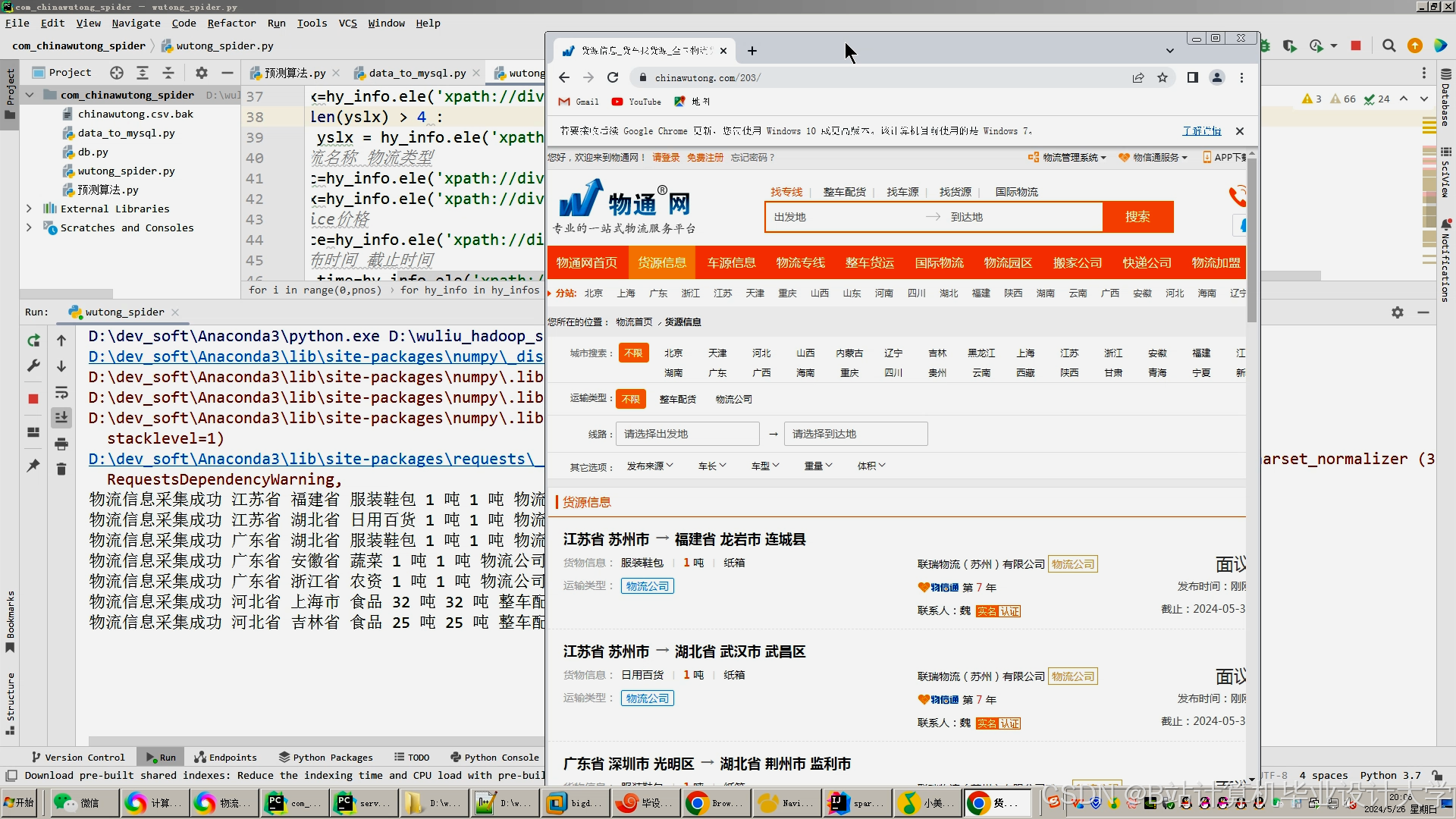

- 物流数据采集与存储

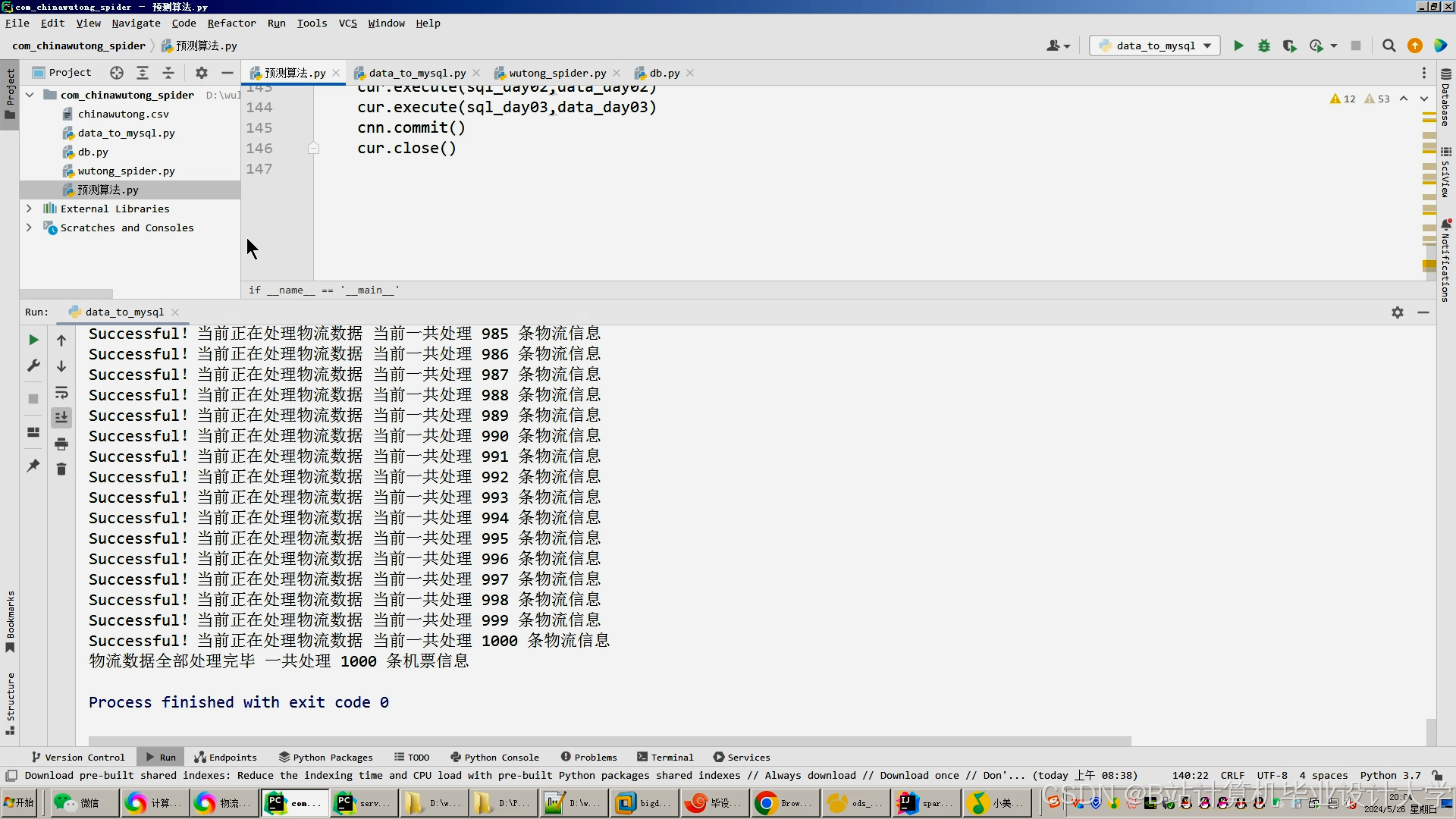

- 研究从物流企业的各个业务系统(如订单管理系统、运输管理系统、仓储管理系统等)采集数据的方法,包括实时数据(如运输车辆的位置信息、订单状态更新等)和历史数据(如历史订单记录、运输成本等)。

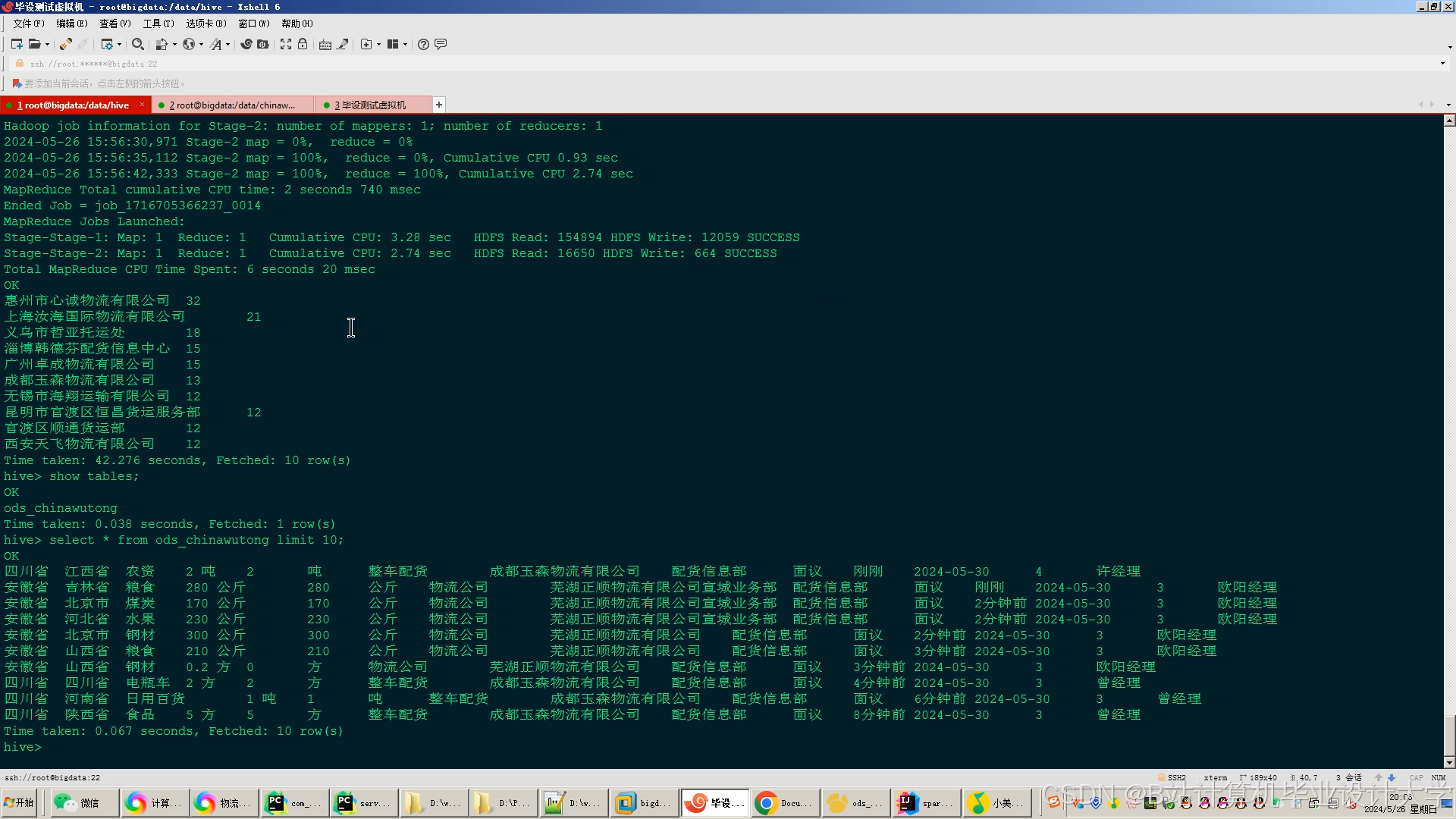

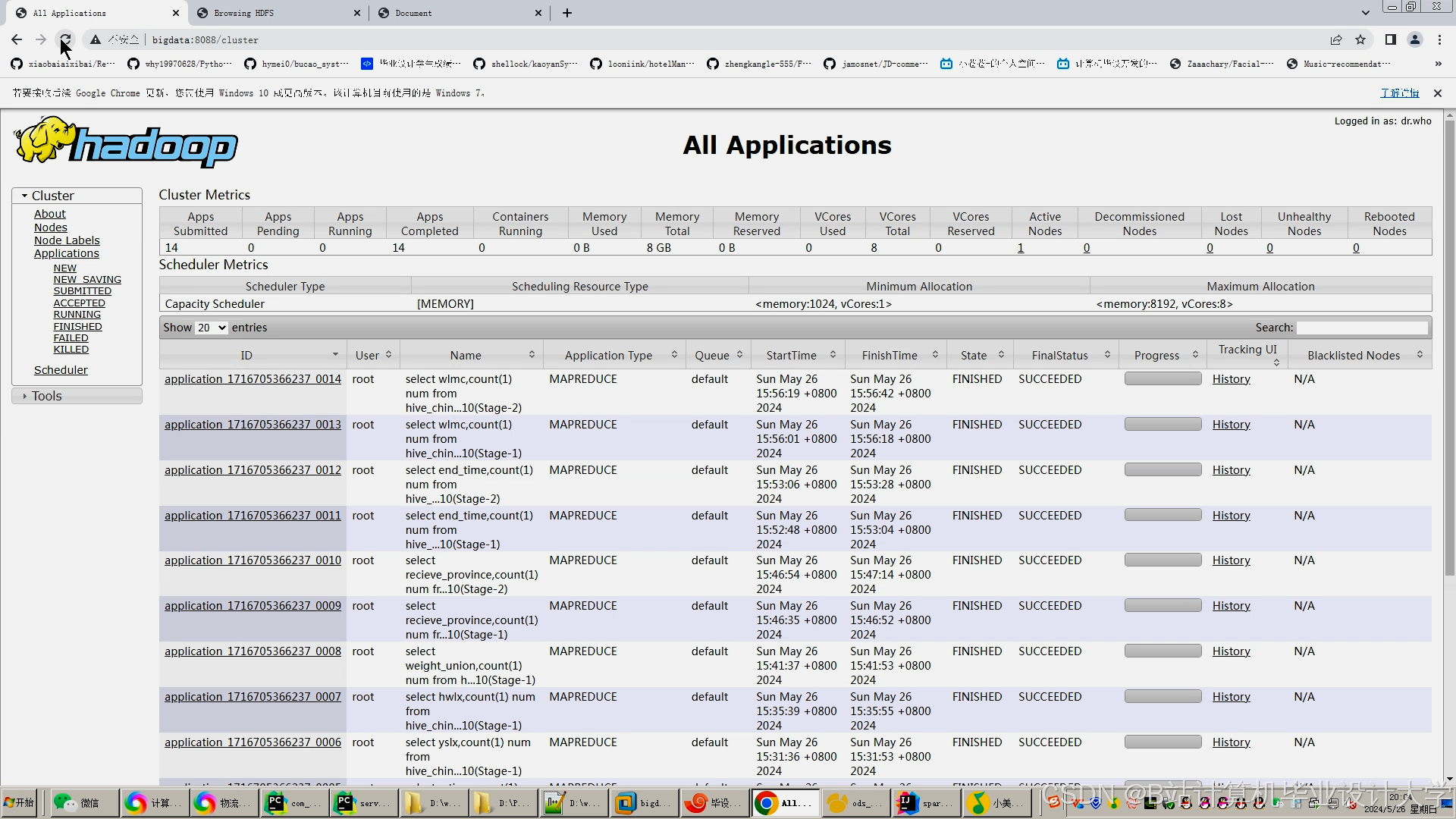

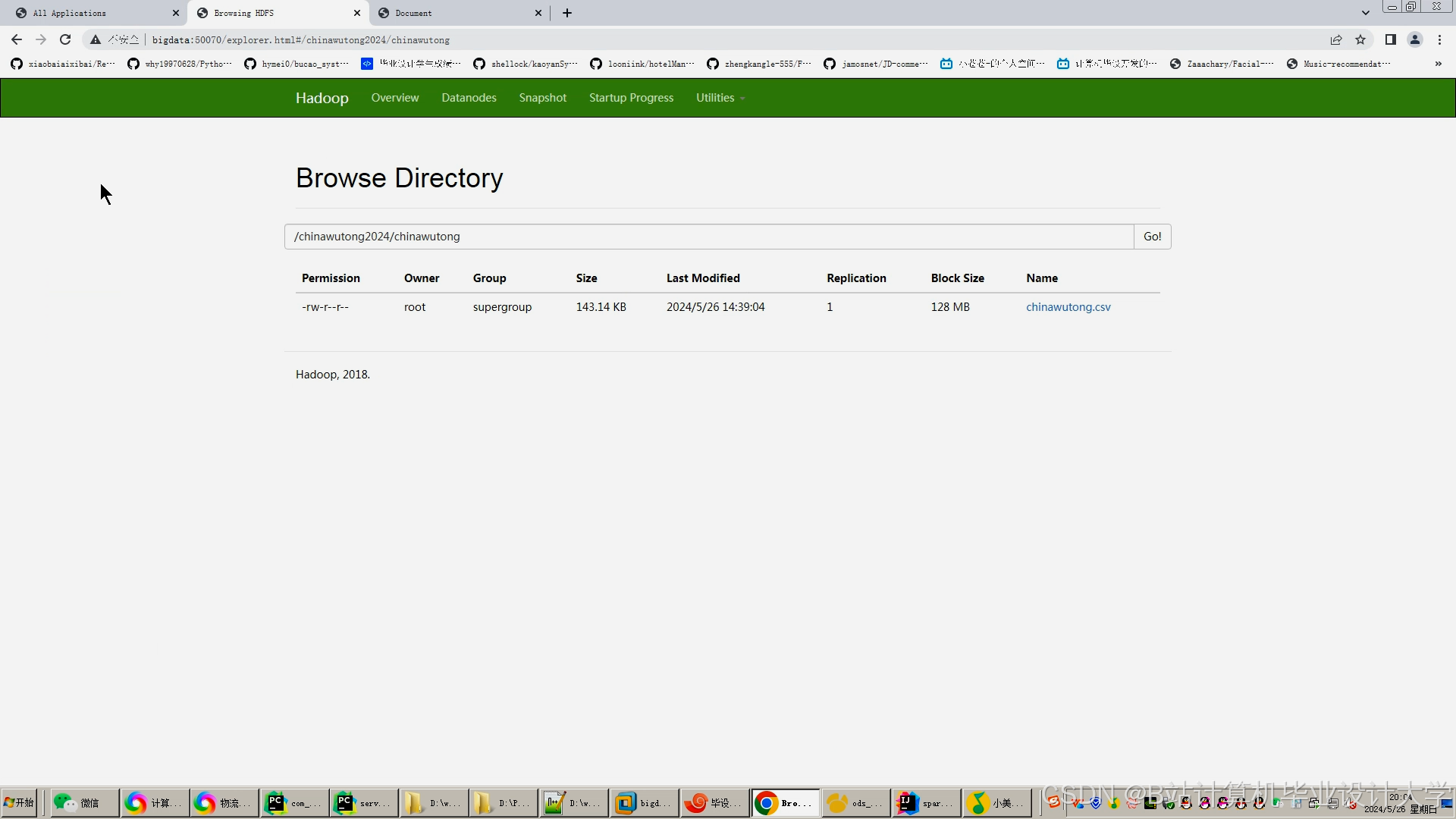

- 利用 Hadoop 的分布式文件系统(HDFS)存储采集到的海量物流数据,并使用 Hive 建立数据仓库,对数据进行分类存储和管理,方便后续的数据查询和分析。

- 数据预处理与特征工程

- 使用 PySpark 对存储在 Hive 中的数据进行清洗、转换和预处理,去除噪声数据和异常值,处理缺失值,将数据转换为适合模型训练的格式。

- 进行特征工程,从物流数据中提取有价值的特征,如订单的发货地、收货地、货物重量、运输距离、运输时间等,并对特征进行编码、归一化等处理,以提高模型的预测性能。

- 基于 PyFlink 的实时数据处理与预测

- 研究如何使用 PyFlink 处理物流业务中的实时数据流,如实时运输轨迹数据、订单状态变更数据等。

- 设计实时预测模型,结合历史数据和实时数据,对物流业务中的关键指标(如运输时间、货物到达时间、运输成本等)进行实时预测,并及时将预测结果反馈给物流企业。

- 基于 PySpark 的批量预测与模型优化

- 使用 PySpark 对历史数据进行批量处理,训练预测模型,如时间序列预测模型、机器学习模型(如回归模型、决策树模型等)。

- 通过交叉验证、网格搜索等方法对模型进行优化,调整模型参数,提高模型的预测精度和泛化能力。

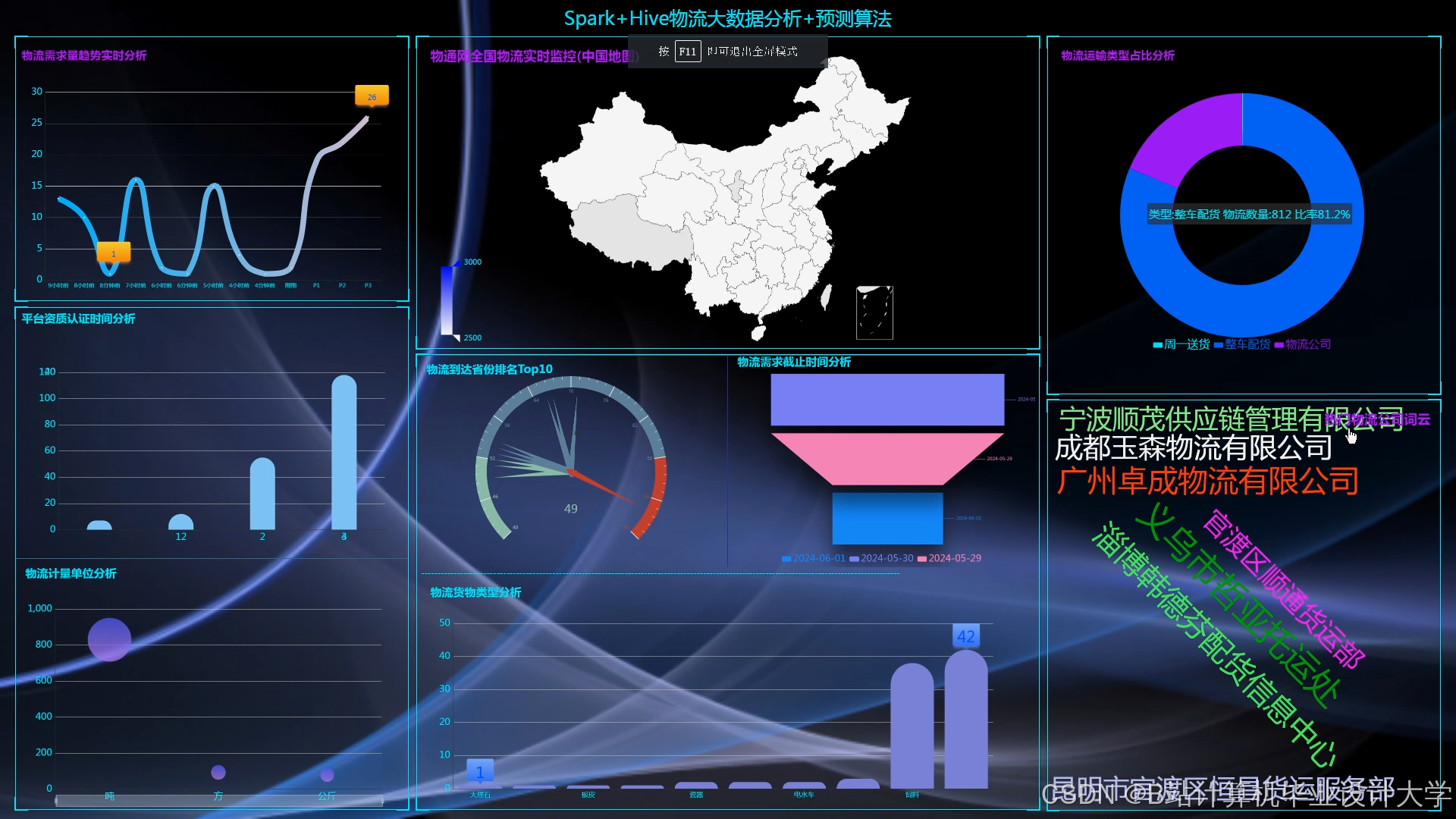

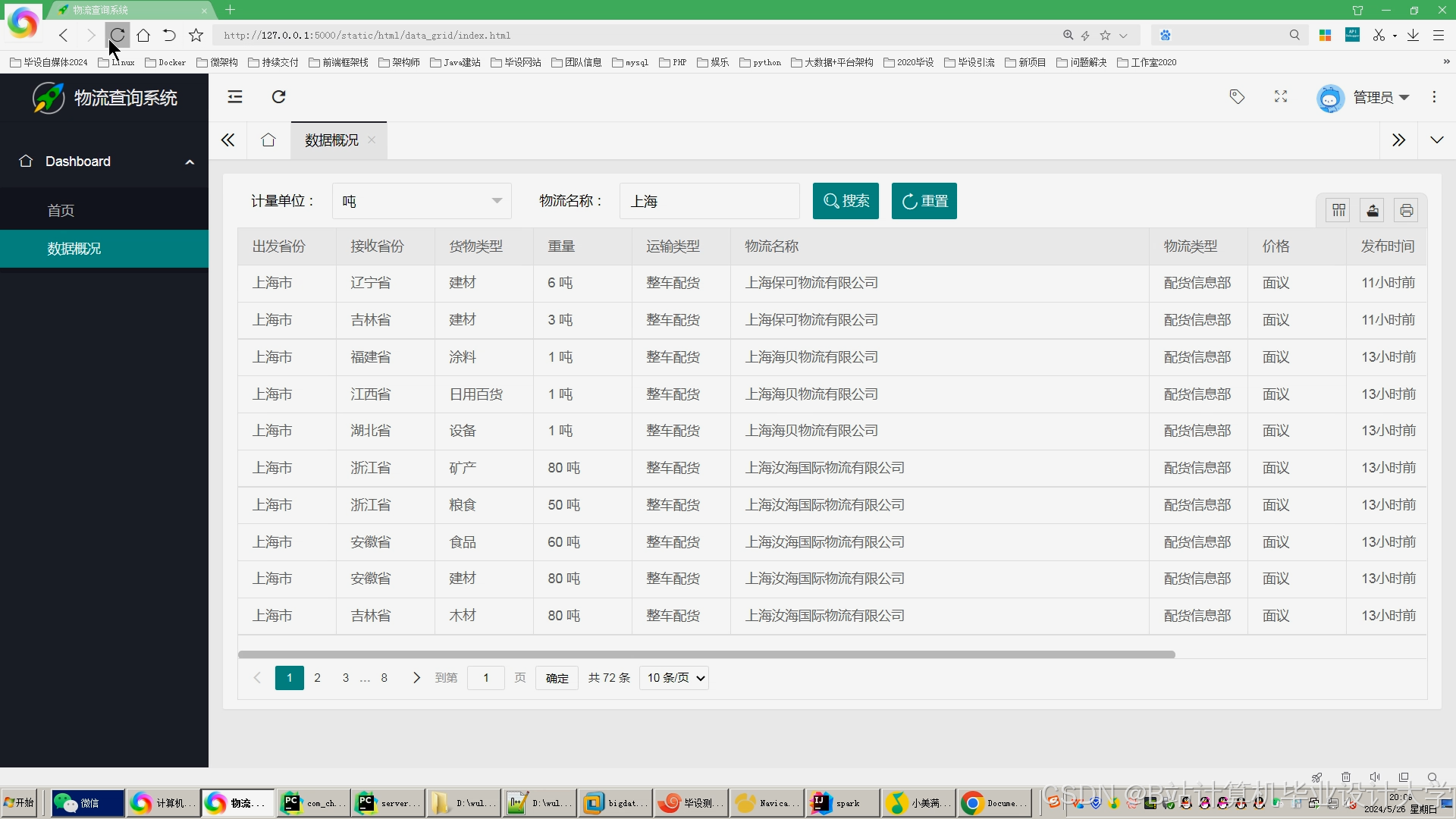

- 预测结果可视化与系统评估

- 开发预测结果可视化模块,将预测结果以图表、报表等形式直观地展示给物流企业,方便企业管理人员进行决策。

- 设计合理的评估指标,如平均绝对误差(MAE)、均方根误差(RMSE)、准确率等,通过实验对比本系统与传统物流预测方法的预测效果,验证系统的有效性。

三、研究方法与技术路线

(一)研究方法

- 文献研究法:查阅国内外相关文献,了解物流预测系统、大数据处理技术和实时数据处理技术的研究现状和发展趋势,为本文的研究提供理论支持。

- 实验研究法:搭建实验环境,实现基于 PyFlink + PySpark + Hadoop + Hive 的物流预测系统,并通过实际物流数据进行实验,对比不同算法和模型参数下的预测效果,优化系统性能。

- 案例分析法:选取具有代表性的物流企业作为案例,分析其现有物流预测系统的优缺点,为本文系统的设计提供参考。

(二)技术路线

- 环境搭建:搭建 Hadoop 集群、Hive 服务、PySpark 环境和 PyFlink 环境,配置相关的软件环境和依赖库,确保系统能够正常运行。

- 数据采集与存储:使用数据采集工具(如 Flume、Kafka 等)从物流企业的各个业务系统采集数据,并将数据存储到 HDFS 中,通过 Hive 建立数据仓库进行管理。

- 数据预处理与特征工程:利用 PySpark 对 Hive 中的数据进行预处理和特征工程,生成适合模型训练的特征数据集。

- 模型训练与预测:对于批量预测,使用 PySpark 训练预测模型;对于实时预测,使用 PyFlink 处理实时数据流并进行预测。根据不同的业务需求选择合适的模型和算法。

- 预测结果可视化与系统评估:开发可视化界面展示预测结果,并使用评估指标对系统的预测效果进行评估。根据评估结果,对系统进行进一步优化和改进。

四、预期成果与创新点

(一)预期成果

- 完成基于 PyFlink + PySpark + Hadoop + Hive 的物流预测系统的设计与实现,包括系统的架构设计、各模块的功能实现和代码编写。

- 撰写一篇高质量的学术论文,详细阐述系统的设计思路、实现方法和实验结果,争取在相关领域的学术期刊或会议上发表。

- 对系统进行性能测试和评估,形成实验报告,证明本系统相比传统物流预测方法在预测精度和实时性上的优势。

(二)创新点

- 技术融合创新:将多种大数据处理技术(Hadoop、Hive、PySpark、PyFlink)有机结合应用于物流预测领域,充分发挥了不同技术的优势,实现了对海量物流数据的高效处理和实时预测。

- 实时与批量预测结合:系统同时支持实时预测和批量预测,能够根据物流业务的不同需求,及时提供准确的预测结果,提高了物流预测的灵活性和实用性。

- 多源异构数据处理:综合考虑物流业务中的多种数据源和数据类型,通过数据预处理和特征工程,将多源异构数据转化为适合模型训练的特征,提高了预测模型的准确性和泛化能力。

五、研究计划与进度安排

(一)研究计划

- 第1 - 2个月:查阅相关文献,了解物流预测系统、大数据处理技术和实时数据处理技术的研究现状和发展趋势,确定研究方案和技术路线。

- 第3 - 4个月:搭建 Hadoop 集群、Hive 服务、PySpark 环境和 PyFlink 环境,完成实验环境的配置;研究数据采集方法,从物流企业的业务系统采集数据,并将数据存储到 HDFS 中,通过 Hive 建立数据仓库。

- 第5 - 6个月:利用 PySpark 对 Hive 中的数据进行预处理和特征工程,生成适合模型训练的特征数据集;研究批量预测模型和算法,使用 PySpark 进行模型训练。

- 第7 - 8个月:研究 PyFlink 在实时数据处理和预测中的应用方法,设计实时预测模型;使用 PyFlink 处理实时数据流并进行预测,将预测结果与批量预测结果进行对比分析。

- 第9 - 10个月:开发预测结果可视化模块,展示预测结果;设计评估指标对系统的预测效果进行评估,根据评估结果对系统进行优化和改进;撰写学术论文和实验报告,准备论文答辩。

(二)进度安排

| 阶段 | 时间跨度 | 主要任务 |

|---|---|---|

| 文献调研与方案确定 | 第1 - 2月 | 查阅文献,确定研究方案和技术路线 |

| 环境搭建与数据采集 | 第3 - 4月 | 搭建集群环境,采集物流数据并存储到HDFS,建立Hive数据仓库 |

| 数据预处理与批量模型训练 | 第5 - 6月 | 数据预处理和特征工程,使用PySpark训练批量预测模型 |

| 实时预测模型开发与验证 | 第7 - 8月 | 研究PyFlink实时预测方法,设计并实现实时预测模型,进行结果对比分析 |

| 系统优化与论文撰写 | 第9 - 10月 | 开发可视化模块,评估系统性能,撰写学术论文和实验报告,准备答辩 |

六、参考文献

[以下列出在开题报告撰写过程中参考的相关文献,按照规范的参考文献格式进行编排。]

[1] 刘宝林. 物流预测与决策[M]. 清华大学出版社, 2010.

[2] White T. Hadoop: The Definitive Guide[M]. O'Reilly Media, Inc., 2012.

[3] Thusoo A, Sarma J S, Jain N, et al. Hive: A Warehousing Solution Over a Map-Reduce Framework[J]. Proceedings of the Vldb Endowment, 2009, 2(2): 1626 - 1629.

[4] Zaharia M, Xin R S, Wendell P, et al. Apache Spark: A Unified Engine for Big Data Processing[J]. Communications of the ACM, 2016, 59(11): 56 - 65.

[5] [作者姓名]. [论文题目][D]. [学校名称], [年份].

[6] [作者姓名]. [论文题目][C]//[会议名称]. [年份].

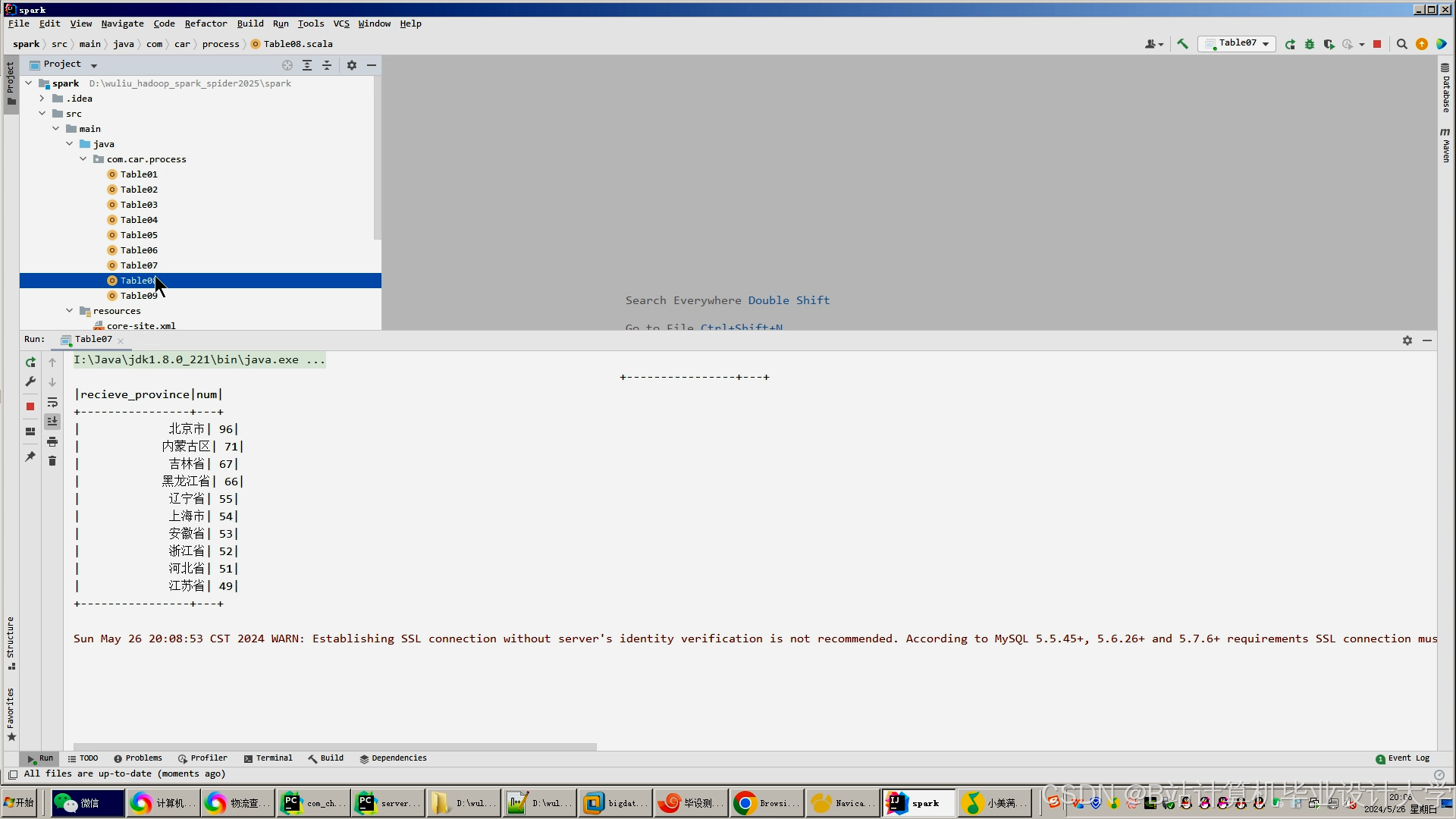

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

PyFlink+PySpark等构建物流预测系统

PyFlink+PySpark等构建物流预测系统

283

283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?