温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《PyFlink+PySpark+Hadoop+Hive物流预测系统》开题报告

一、选题背景与意义

(一)选题背景

随着电子商务的蓬勃发展,物流行业迎来了前所未有的机遇与挑战。物流数据的规模和复杂性急剧增加,涵盖了订单信息、运输轨迹、仓储状态等多方面的内容。这些数据蕴含着丰富的价值,能够为物流企业的决策提供有力支持。然而,传统的物流数据处理和分析方法面临着数据量大、处理速度慢、分析维度单一等问题,难以满足现代物流企业对实时性和精准性的要求。

(二)选题意义

构建基于 PyFlink、PySpark、Hadoop 和 Hive 的物流预测系统具有重要的现实意义。该系统能够高效地存储和处理海量物流数据,通过实时数据处理和离线数据分析相结合的方式,实现对物流需求的精准预测,提高物流企业的运营效率和服务质量,降低成本,提升客户满意度。同时,该系统的研究和实践可以为物流行业的智能化、高效化发展提供有益的探索和借鉴。

二、国内外研究现状

(一)国外研究现状

在国外,物流预测领域已经取得了一定的研究成果。一些大型物流企业和科研机构利用先进的大数据技术和机器学习算法,构建了物流预测模型,实现了对物流运输时间、成本等方面的预测。例如,美国的一些物流企业通过收集和分析大量的运输数据,利用深度学习算法构建预测模型,提高了物流运输的效率和准确性。此外,国外在物流数据存储和管理方面也有较为成熟的技术和经验,如采用分布式文件系统和数据仓库技术,实现了对海量物流数据的高效存储和查询。

(二)国内研究现状

国内物流预测领域的研究也在不断深入。许多高校和科研机构开展了相关的研究工作,取得了一些阶段性的成果。一些物流企业也开始重视物流数据的分析和利用,尝试构建物流预测系统。然而,与国外相比,国内在物流预测技术的应用和推广方面还存在一定的差距,部分企业在数据处理能力和分析手段上还有待提高。同时,国内在物流预测系统的集成和应用方面还需要进一步探索和创新。

三、研究目标与内容

(一)研究目标

设计并实现一个基于 PyFlink、PySpark、Hadoop 和 Hive 的物流预测系统,该系统能够实时处理和分析物流数据,准确预测物流时间、成本等关键指标,为物流企业提供决策支持。具体目标包括:

- 设计稳定、可扩展的系统架构,集成 PyFlink、PySpark、Hadoop 和 Hive 技术,实现对海量物流数据的高效存储、处理和分析。

- 对物流数据进行全面的清洗、转换和特征提取,提高数据质量,为后续的预测模型提供准确的数据输入。

- 构建物流需求预测模型和运输时间预测模型,实现对物流业务的精准预测,预测准确率达到[X]%以上。

- 系统能够快速响应数据处理请求,实时数据处理延迟不超过[X]秒,批量数据处理时间在可接受范围内。

- 将物流预测系统应用于实际的物流业务场景中,为物流企业的运营决策提供支持,提高物流效率和服务质量。

(二)研究内容

- 系统架构设计

根据物流预测系统的需求,设计系统的总体架构,包括数据采集层、数据存储层、数据处理与分析层、模型应用层等,明确各层的功能和相互关系。 - 数据处理模块开发

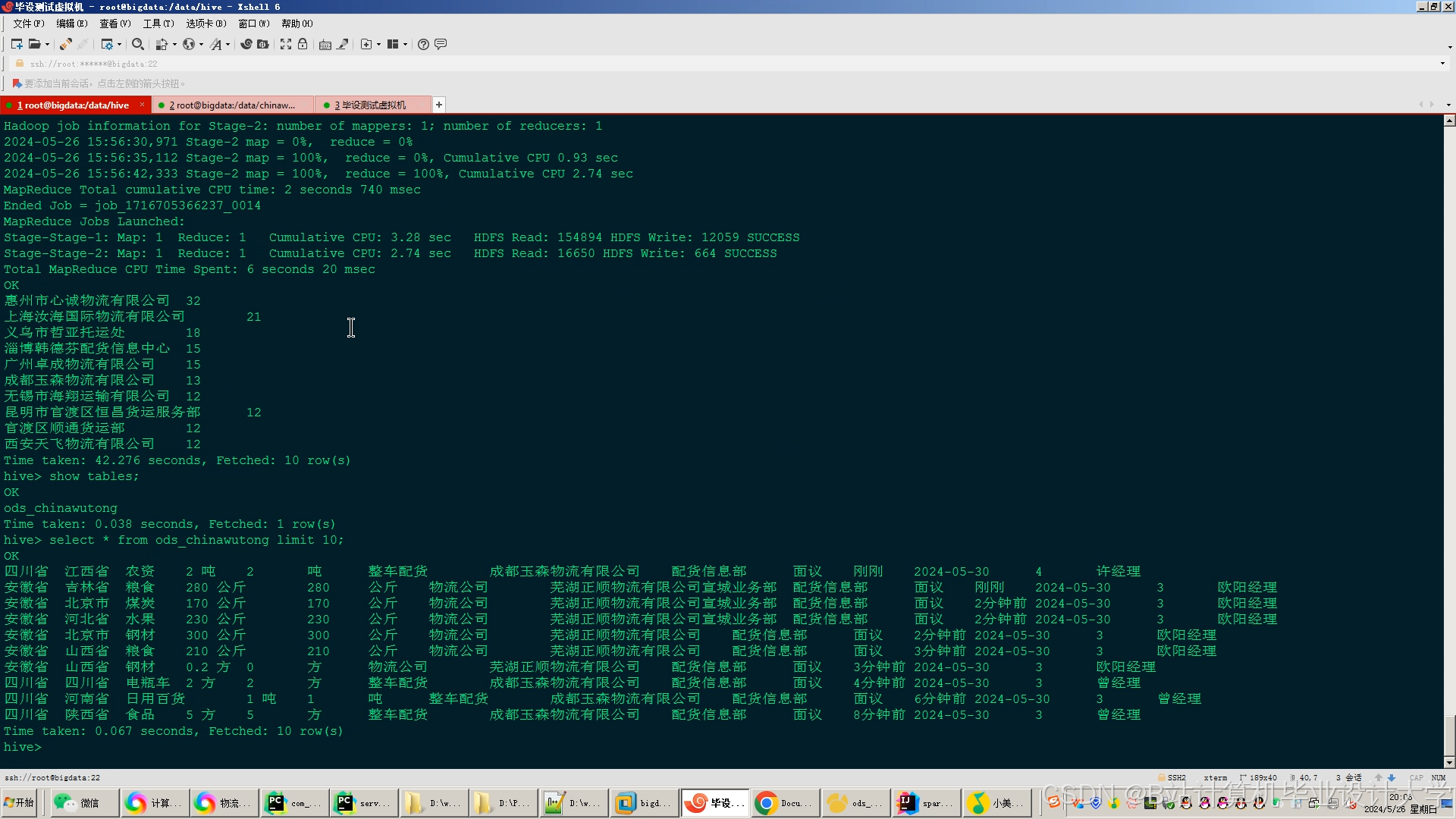

使用 Hadoop 和 Hive 搭建数据存储环境,实现物流数据的存储和管理。利用 PySpark 进行数据清洗、转换和特征提取,包括数据去重、缺失值处理、数据格式转换等操作。开发数据质量监控模块,实时监测数据质量,及时发现和处理数据异常。 - 实时数据处理模块开发

使用 PyFlink 实现实时物流数据流的接入和处理,计算关键指标和特征,如订单量、运输速度等。设计实时数据缓存机制,提高实时数据处理的效率和准确性。开发实时数据可视化界面,实时展示物流数据的变化趋势。 - 预测模型构建与训练

研究适合物流预测的机器学习算法,如时间序列分析、回归分析、深度学习等。使用 PySpark MLlib 或第三方机器学习库构建物流需求预测模型和运输时间预测模型。对训练数据集进行划分,采用交叉验证等方法对模型进行训练和评估,优化模型参数,提高预测准确性。 - 系统集成与测试

将数据处理模块、实时数据处理模块和预测模型进行集成,构建完整的物流预测系统。开发系统的前端界面和后端服务,实现用户与系统的交互。对系统进行全面的测试,包括功能测试、性能测试、安全测试等,确保系统的稳定性和可靠性。

四、研究方法与技术路线

(一)研究方法

- 文献研究法:查阅国内外相关的文献资料,了解物流预测领域的研究现状和发展趋势,为系统的设计和实现提供理论支持。

- 实验研究法:通过实际的数据采集和处理,构建物流预测模型,并进行实验验证,评估系统的性能和预测准确性。

- 系统开发法:采用分层架构设计,利用 PyFlink、PySpark、Hadoop 和 Hive 等技术进行系统的开发和实现。

(二)技术路线

- 环境搭建:安装 Hadoop、Hive、Flink、Spark 及相关 Python 库(如 pyflink、pyspark),搭建系统的运行环境。

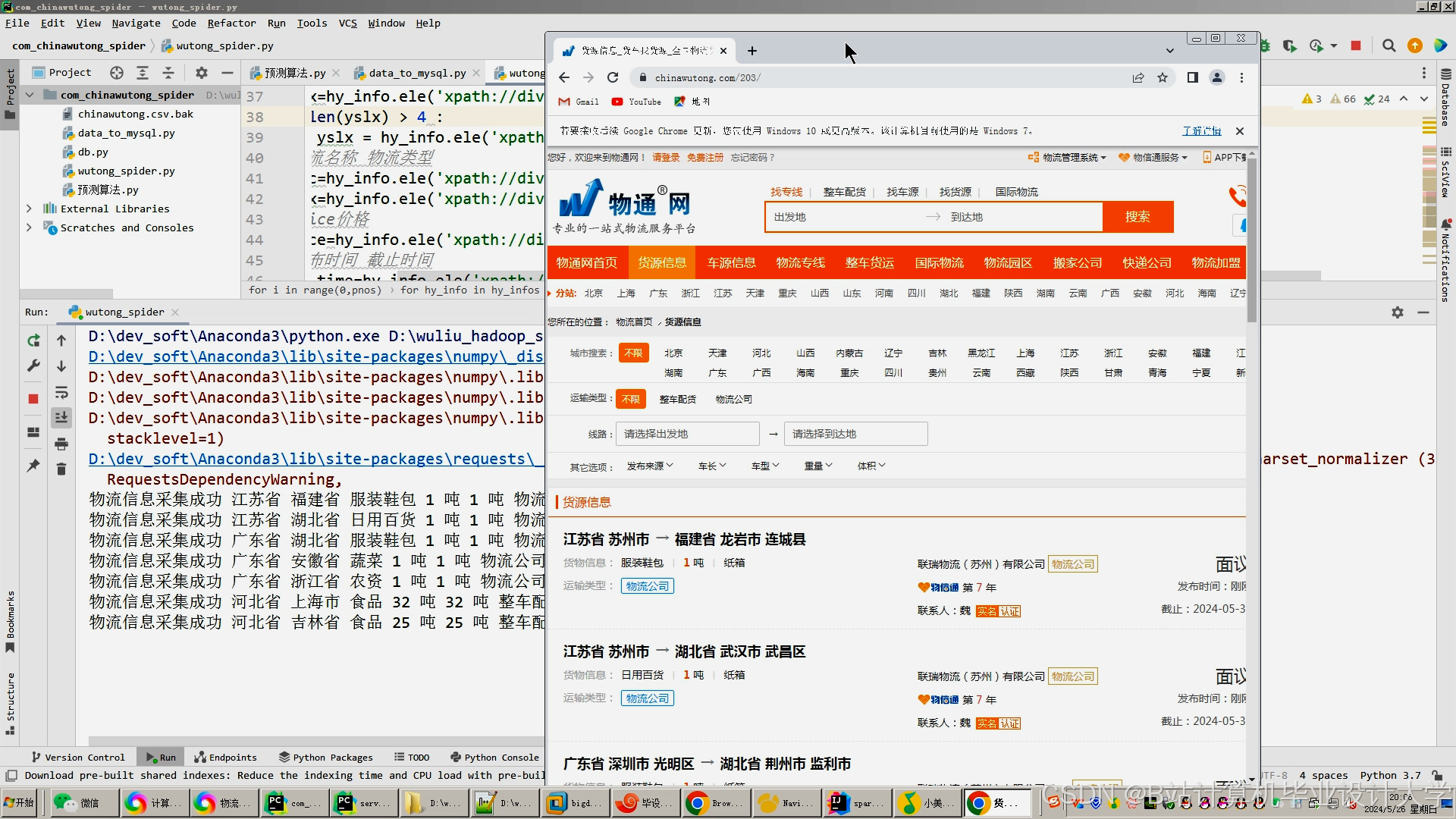

- 数据采集与存储:通过物流企业的信息系统、传感器等设备采集物流数据,如订单信息、运输信息、仓库信息等。使用 Flume 将采集到的数据实时写入 HDFS,同时利用 Hive 创建相应的数据表,将数据加载到 Hive 中,方便后续的查询和分析。

- 数据处理:使用 PyFlink 进行实时数据处理,提取关键特征;PySpark 进行离线数据处理,进行数据清洗、特征工程等操作。

- 模型构建与训练:基于处理后的数据,选择合适的机器学习算法构建物流预测模型,如时间序列模型、回归模型等。通过模型训练和评估,选择最优模型进行物流时间、成本、路径等指标的预测。

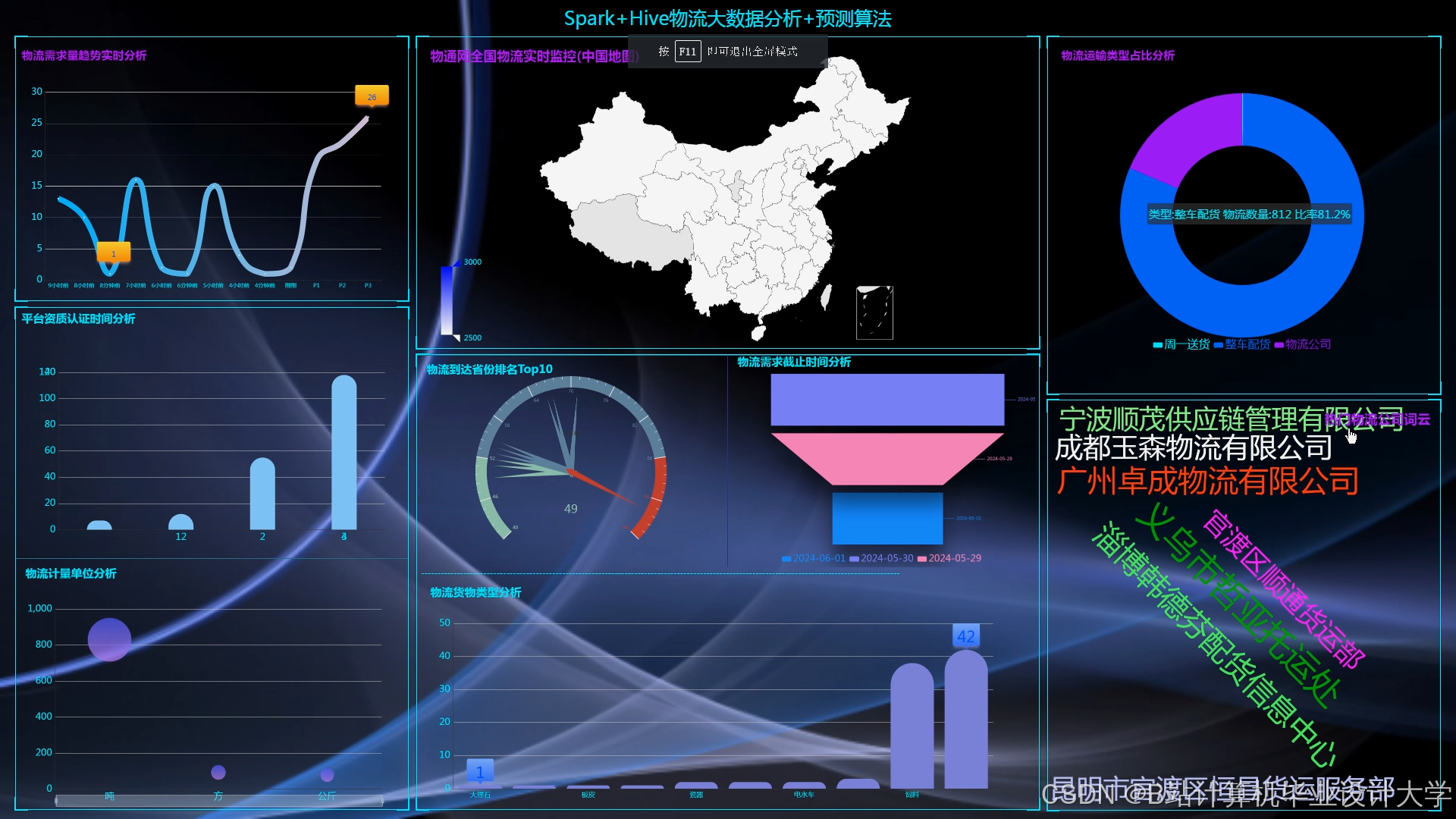

- 系统集成与可视化:将数据处理模块、实时数据处理模块和预测模型进行集成,构建完整的物流预测系统。采用 Echarts 等可视化工具,将物流预测结果以直观的图表形式展示给用户。

五、预期成果与创新点

(一)预期成果

- 完成《PyFlink+PySpark+Hadoop+Hive 物流预测系统》的开发,包括系统的源代码、项目文档(如需求文档、设计文档、测试报告等)、系统演示 PPT 等。

- 撰写一篇关于物流预测系统研究和应用的学术论文,总结项目的研究成果和实践经验。

- 系统能够在实际的物流业务场景中应用,为物流企业提供准确的物流预测结果,提高物流企业的运营效率和服务质量。

(二)创新点

- 技术集成创新:将 PyFlink、PySpark、Hadoop 和 Hive 等先进技术相结合,构建了一个高效、可扩展的物流预测系统。PyFlink 专注于实时数据处理,PySpark 适用于离线数据处理和机器学习模型训练,Hadoop 提供分布式存储能力,Hive 提供数据仓库功能,实现了数据的实时处理、离线分析和高效存储。

- 预测模型优化:在构建物流预测模型时,综合考虑了多种机器学习算法,并通过交叉验证等方法对模型进行优化,提高了预测的准确性和鲁棒性。

- 可视化展示创新:采用 Echarts 等可视化工具,将物流预测结果以直观的图表形式展示给用户,提供了交互式数据探索和分析功能,方便用户快速发现数据中的规律和趋势。

六、进度安排

(一)第 1 - 2 周

项目启动,环境搭建,数据准备。安装 Hadoop、Hive、Flink、Spark 及相关 Python 库,收集并整理物流数据,包括订单信息、运输信息、仓库信息等,进行预处理和存储。

(二)第 3 - 4 周

分布式存储与数据仓库构建。使用 Hadoop HDFS 存储大规模物流数据,使用 Hive 构建数据仓库,定义数据表结构,实现数据的加载、查询和管理。

(三)第 5 - 8 周

实时数据处理与预测模型输入模块开发。使用 PyFlink 编写实时数据流处理程序,提取物流数据中的关键特征,如订单状态、运输距离、运输时间等。将实时特征数据传递给预测模型,实现物流时间的实时预测。

(四)第 9 - 12 周

离线数据处理与预测模型训练模块开发。使用 PySpark 处理离线物流数据,进行特征工程,提取更多有助于预测的特征。利用机器学习算法(如回归模型、时间序列模型等)训练预测模型,并进行模型评估和调优。

(五)第 13 - 16 周

数据可视化模块开发。选择合适的数据可视化工具(如 Echarts、Tableau 等),开发数据可视化界面。展示物流时间、成本、路径等关键指标,提供交互式数据探索和分析功能。

(六)第 17 - 18 周

系统集成与测试,撰写项目报告。将实时数据处理、离线数据处理、预测模型和数据可视化模块集成到一个统一的系统中。进行系统功能测试和性能测试,确保系统的稳定性和准确性。同时,撰写项目报告,总结项目的研究成果和实践经验。

七、可能遇到的问题及解决方案

(一)技术集成困难

PyFlink、PySpark、Hadoop 和 Hive 等技术集成可能存在兼容性问题,导致系统开发过程中出现各种错误。解决方案是加强团队成员的技术培训,及时关注技术发展动态,选择成熟稳定的技术方案。在开发过程中,进行充分的测试和调试,及时发现和解决技术集成问题。

(二)数据质量问题

物流数据可能存在数据质量差、数据不完整等问题,影响预测模型的准确性。解决方案是建立严格的数据质量监控机制,对数据进行预处理和清洗,去除重复数据、纠正错误数据、填充缺失值等。同时,定期对数据质量进行评估和检查,确保数据质量符合要求。

(三)项目进度延迟

项目开发过程中可能出现进度延迟的情况,影响项目的按时完成。解决方案是制定合理的项目进度计划,加强项目进度管理,明确各阶段的任务和时间节点。定期对项目进度进行检查和评估,及时发现和解决影响项目进度的问题。合理分配资源,确保项目开发过程中的各项工作能够顺利进行。

八、参考文献

[此处列出在开题报告撰写过程中参考的相关文献,包括书籍、论文、技术文档等]

以上开题报告仅供参考,在实际项目实施过程中,可能会根据研究进展和实际情况进行适当调整和完善。

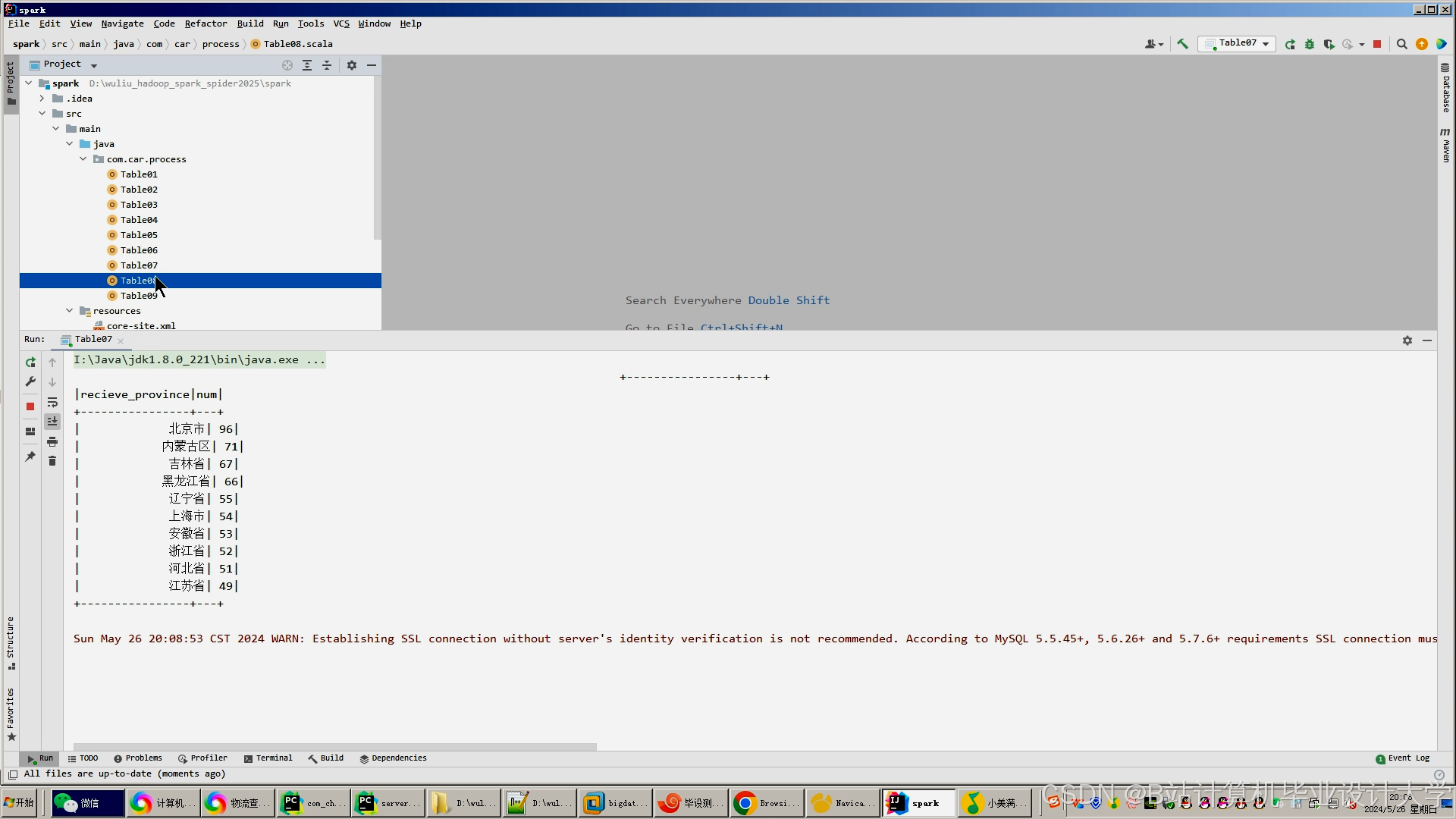

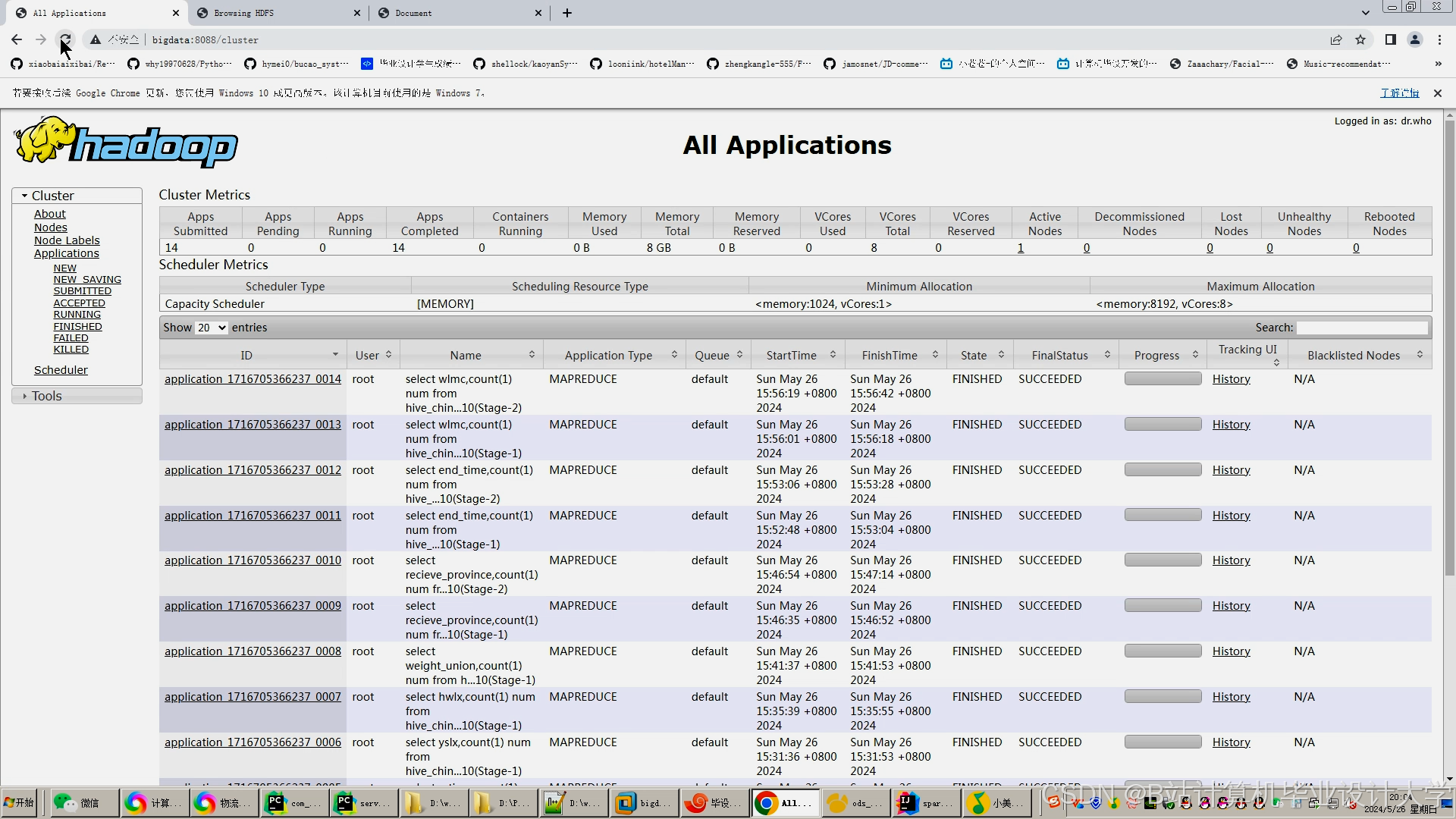

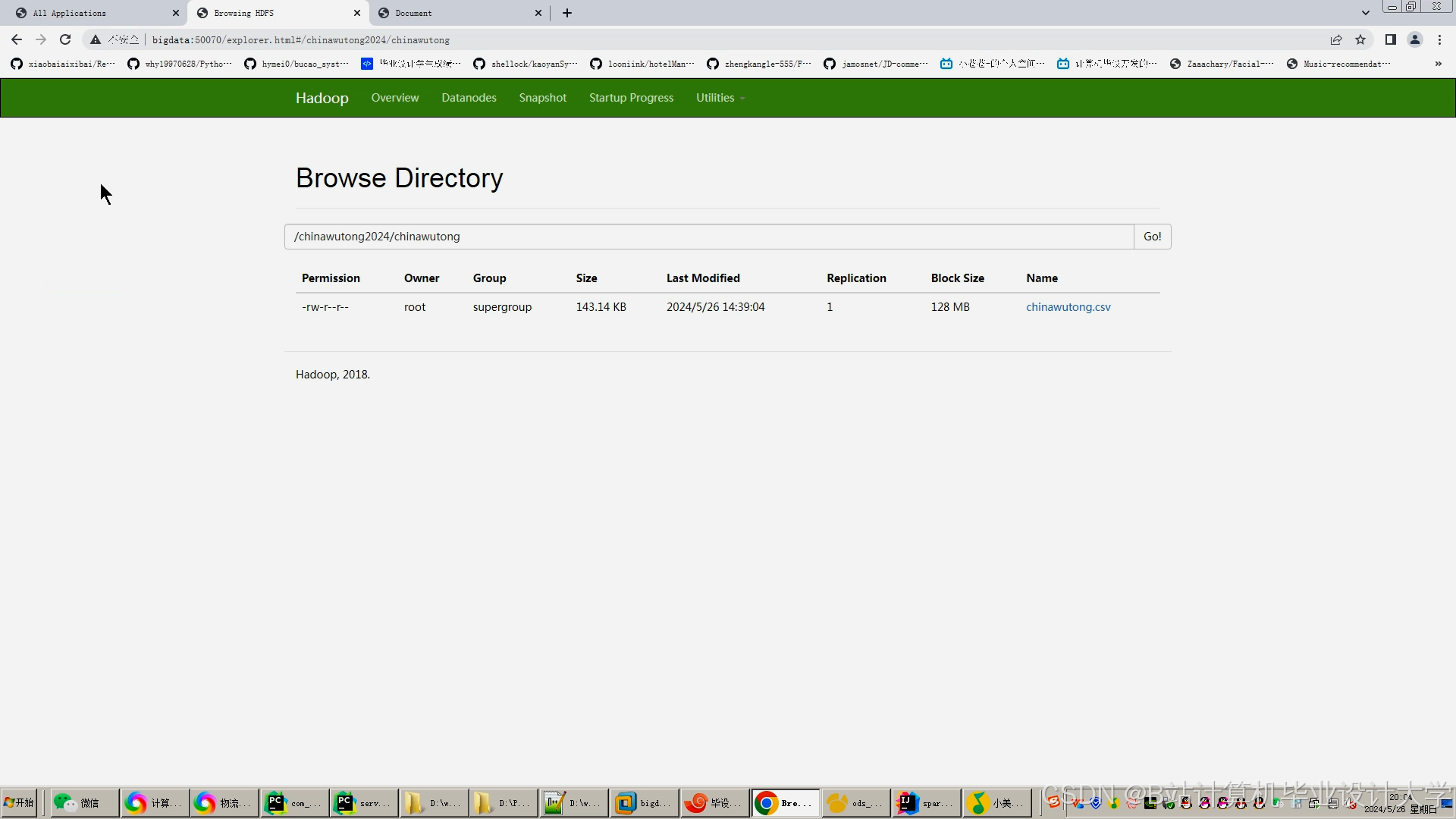

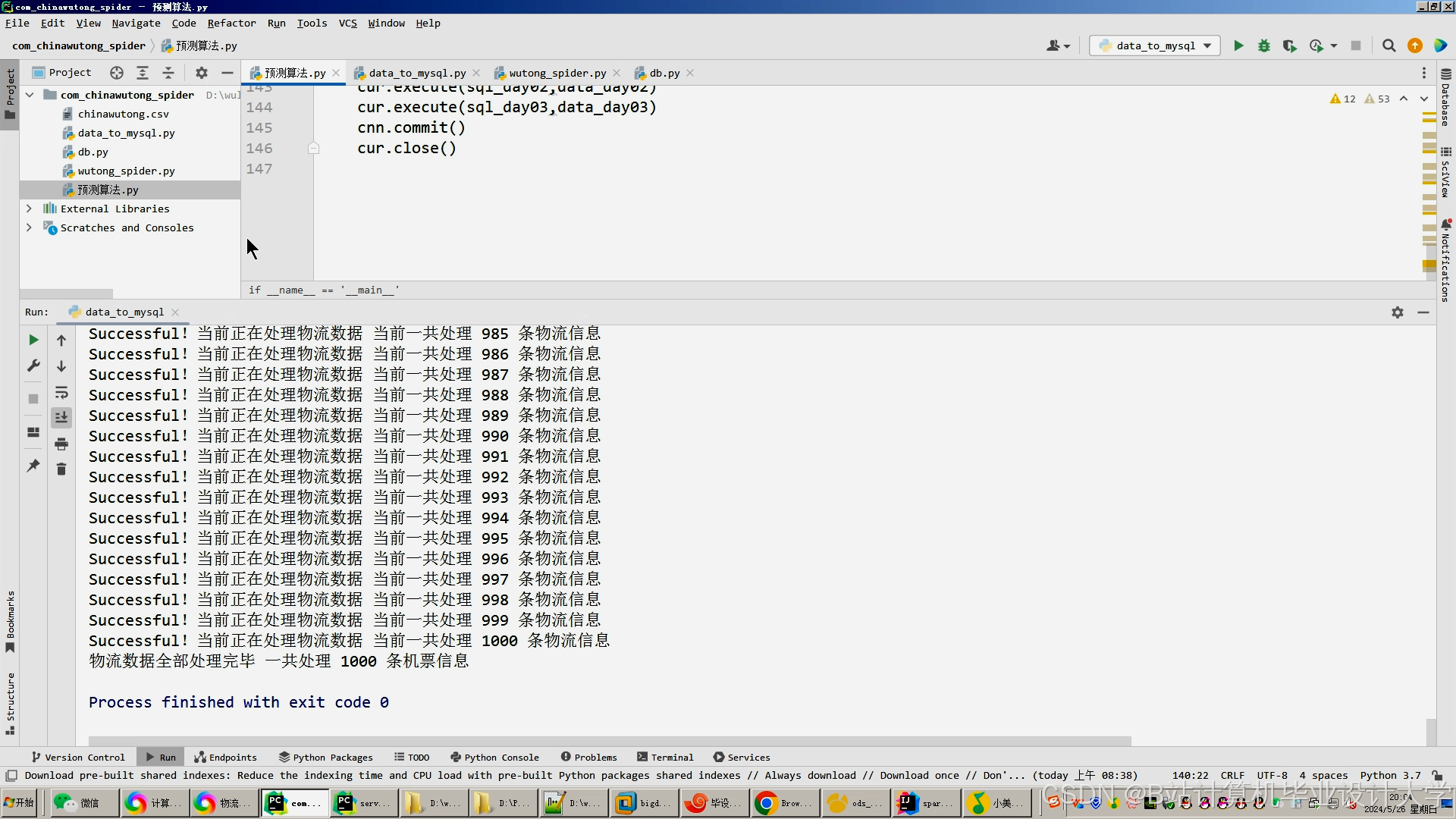

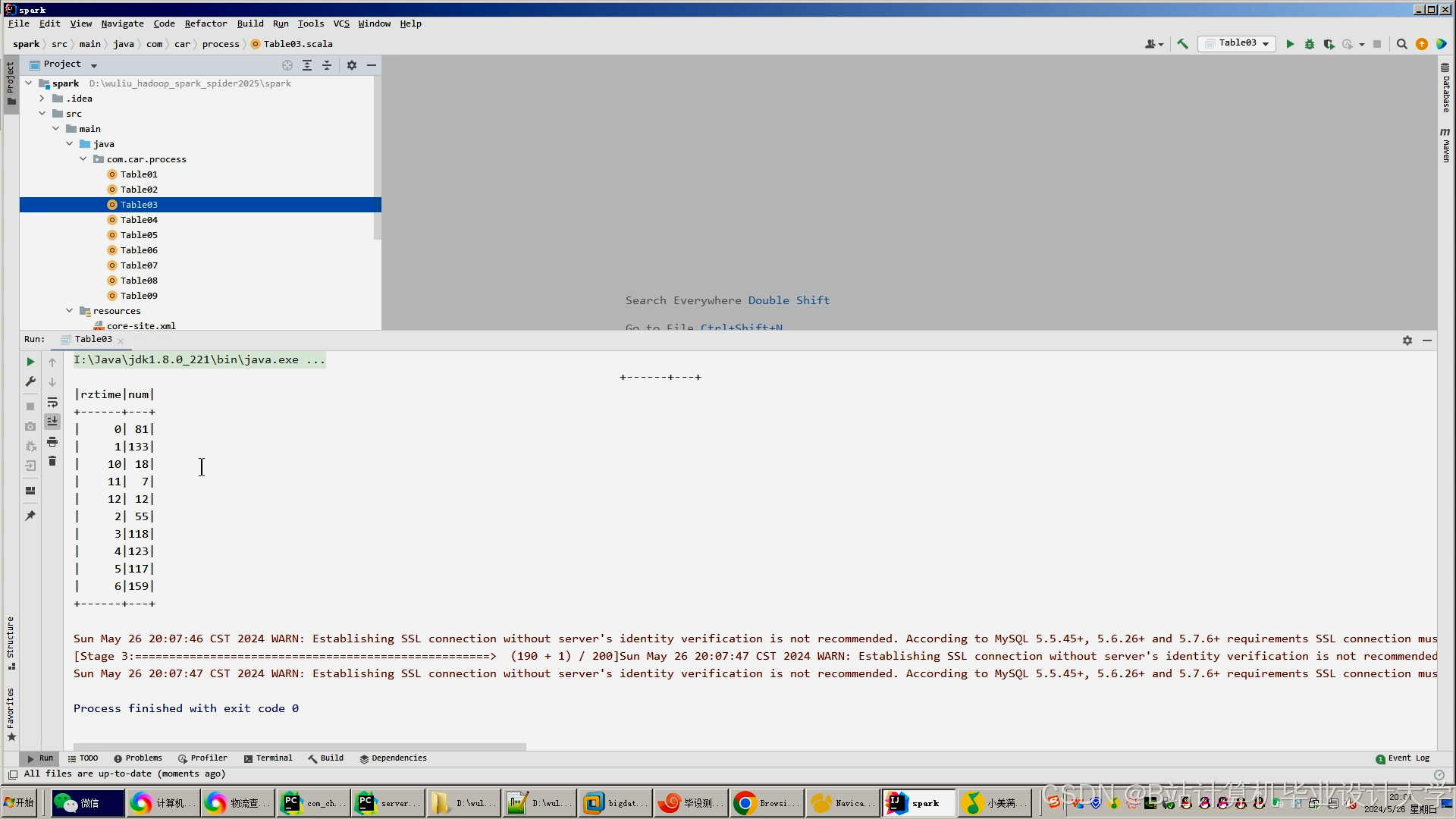

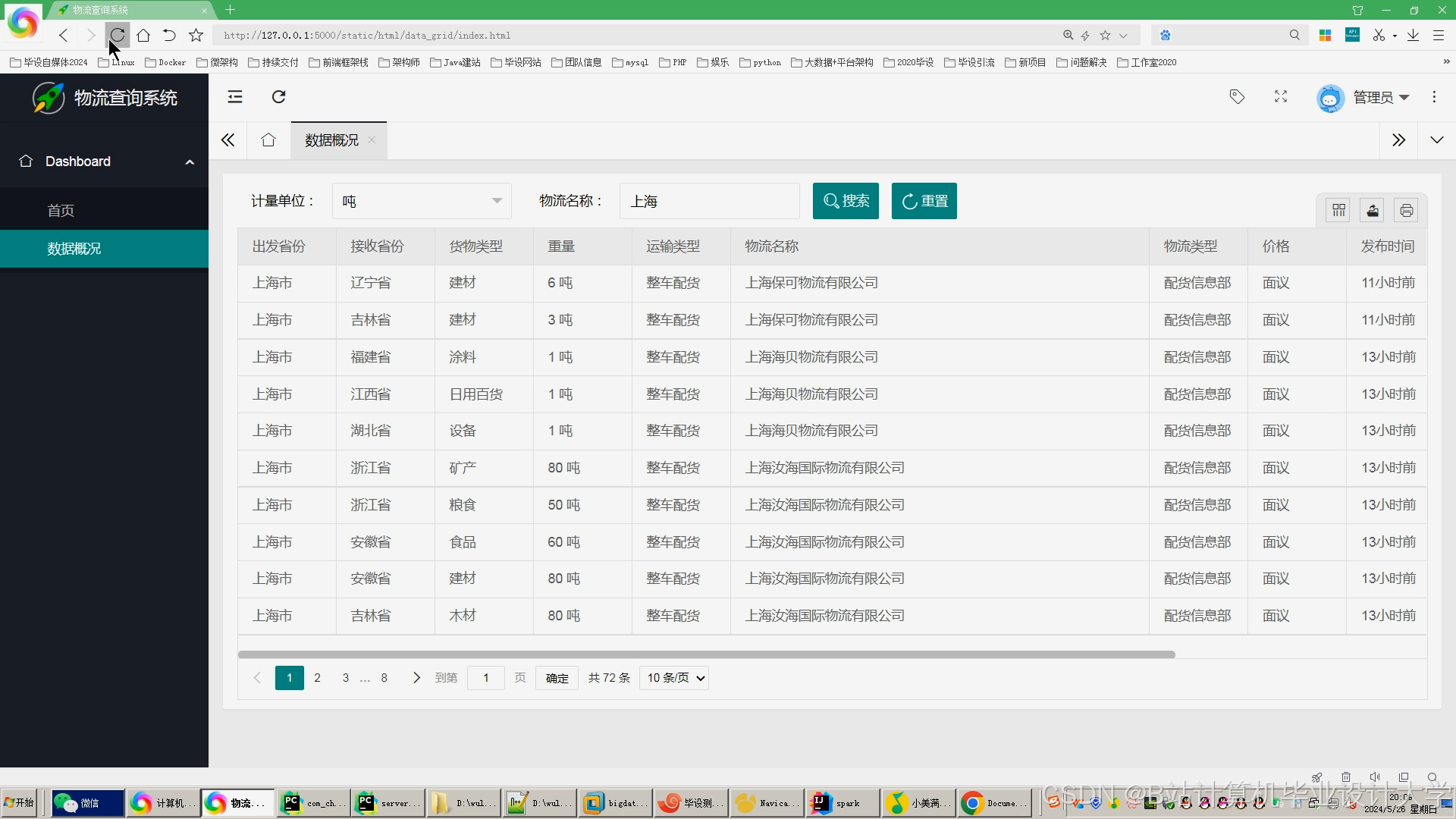

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

283

283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?