温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive招聘推荐系统技术说明

一、系统概述

招聘推荐系统旨在通过大数据技术实现求职者与岗位的高效匹配,解决传统招聘方式中信息过载、匹配效率低的问题。本系统基于Hadoop(分布式存储)、Spark(内存计算)和Hive(数据仓库)三大技术栈构建,能够处理PB级招聘数据,支持实时推荐与精准匹配。系统适用于招聘平台、企业HR系统等场景,核心功能包括数据采集、清洗、特征提取、推荐算法实现及结果展示。

二、技术架构设计

系统采用分层架构,各层职责如下:

- 数据采集层

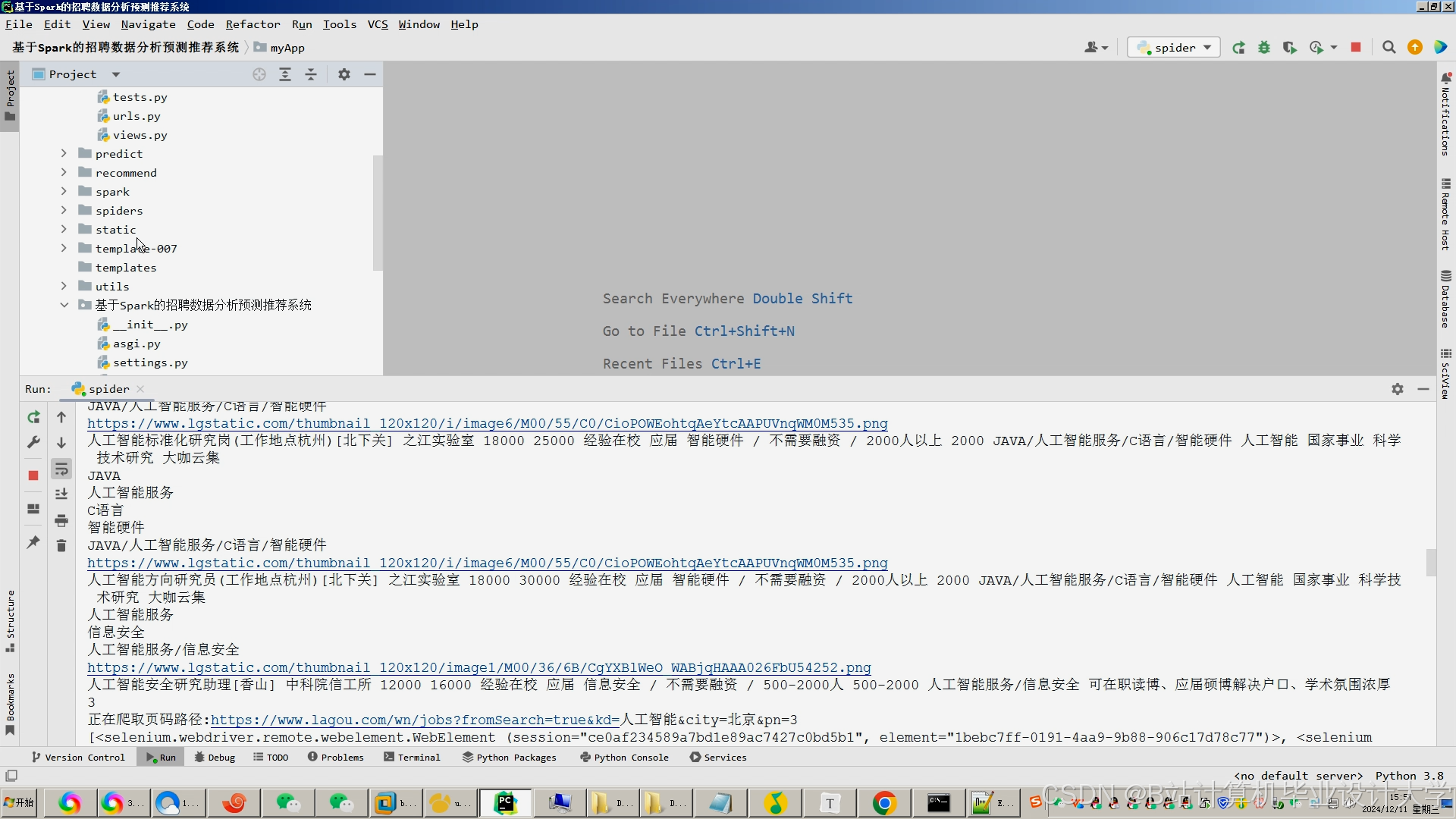

- 数据来源:通过爬虫技术(如Scrapy)从招聘网站、企业官网、社交媒体等渠道采集岗位信息(职位名称、薪资、地点、技能要求等)及求职者简历数据(教育背景、工作经验、技能标签等)。

- 数据格式:采集数据以JSON或CSV格式存储,便于后续处理。

- 数据存储层

- Hadoop HDFS:作为分布式文件系统,负责存储原始数据、清洗后数据及模型中间结果,支持高吞吐量读写。

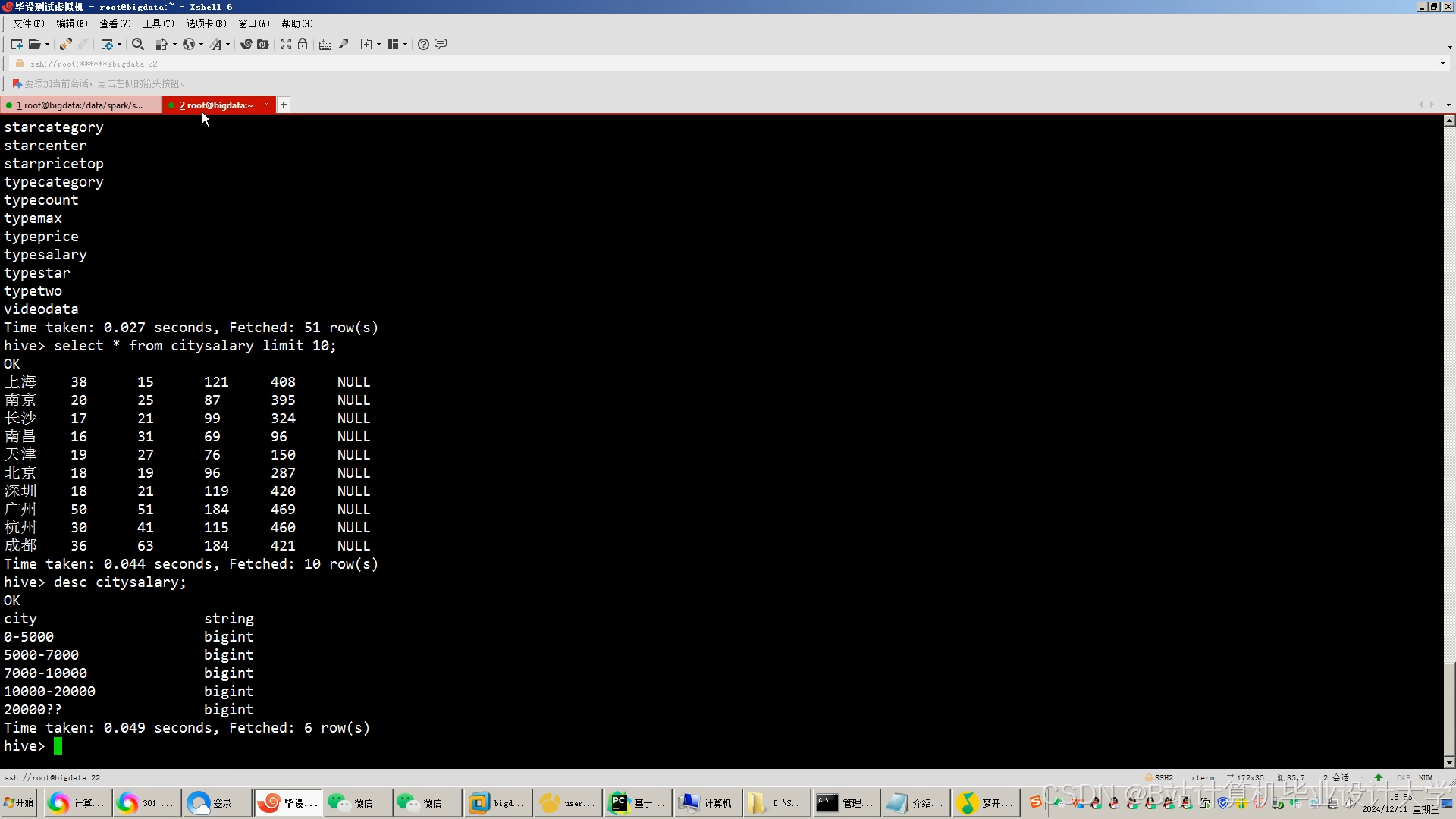

- Hive数据仓库:基于HDFS构建,提供SQL查询接口,支持复杂数据分析(如岗位热度统计、求职者画像分析)。

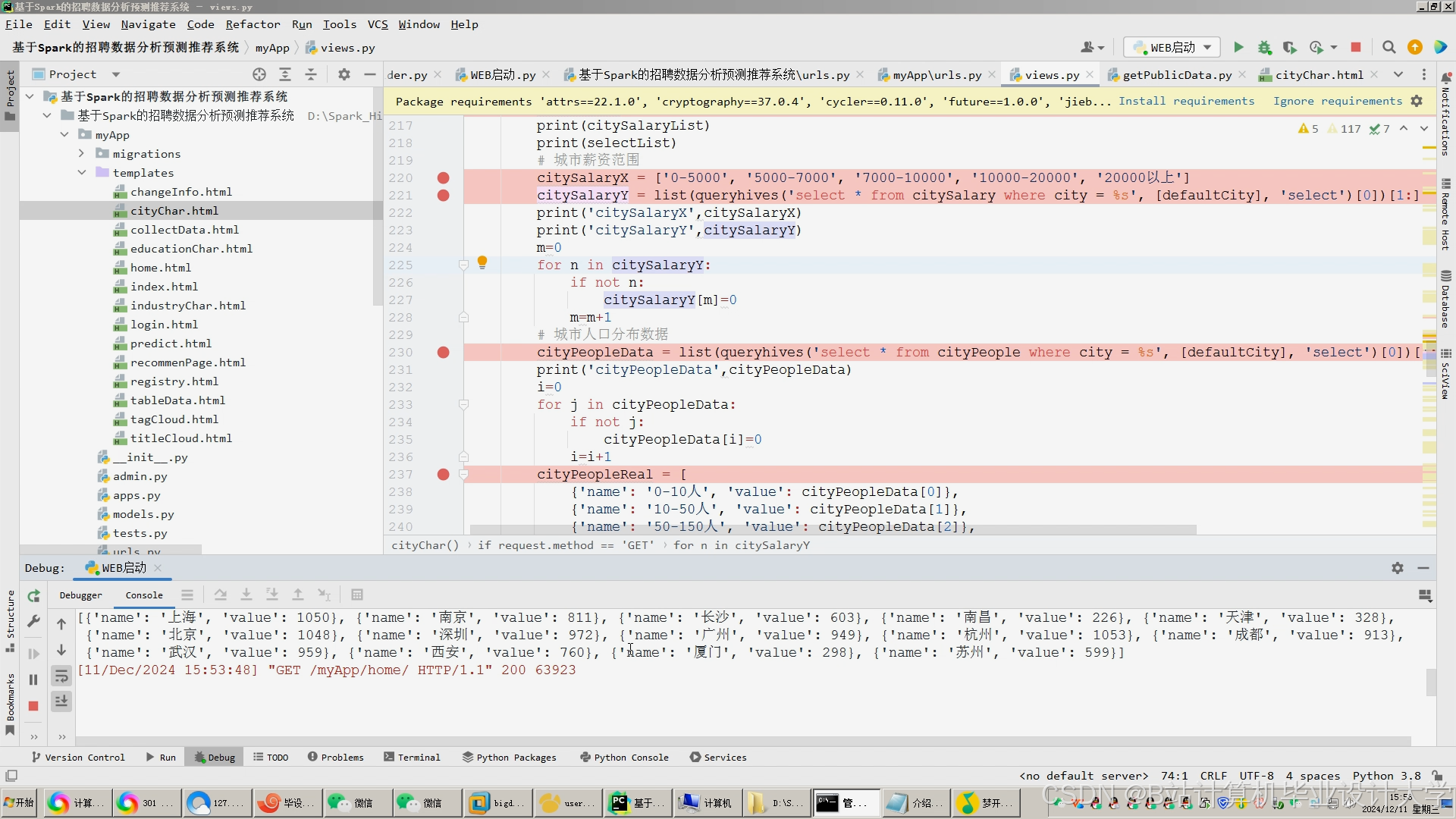

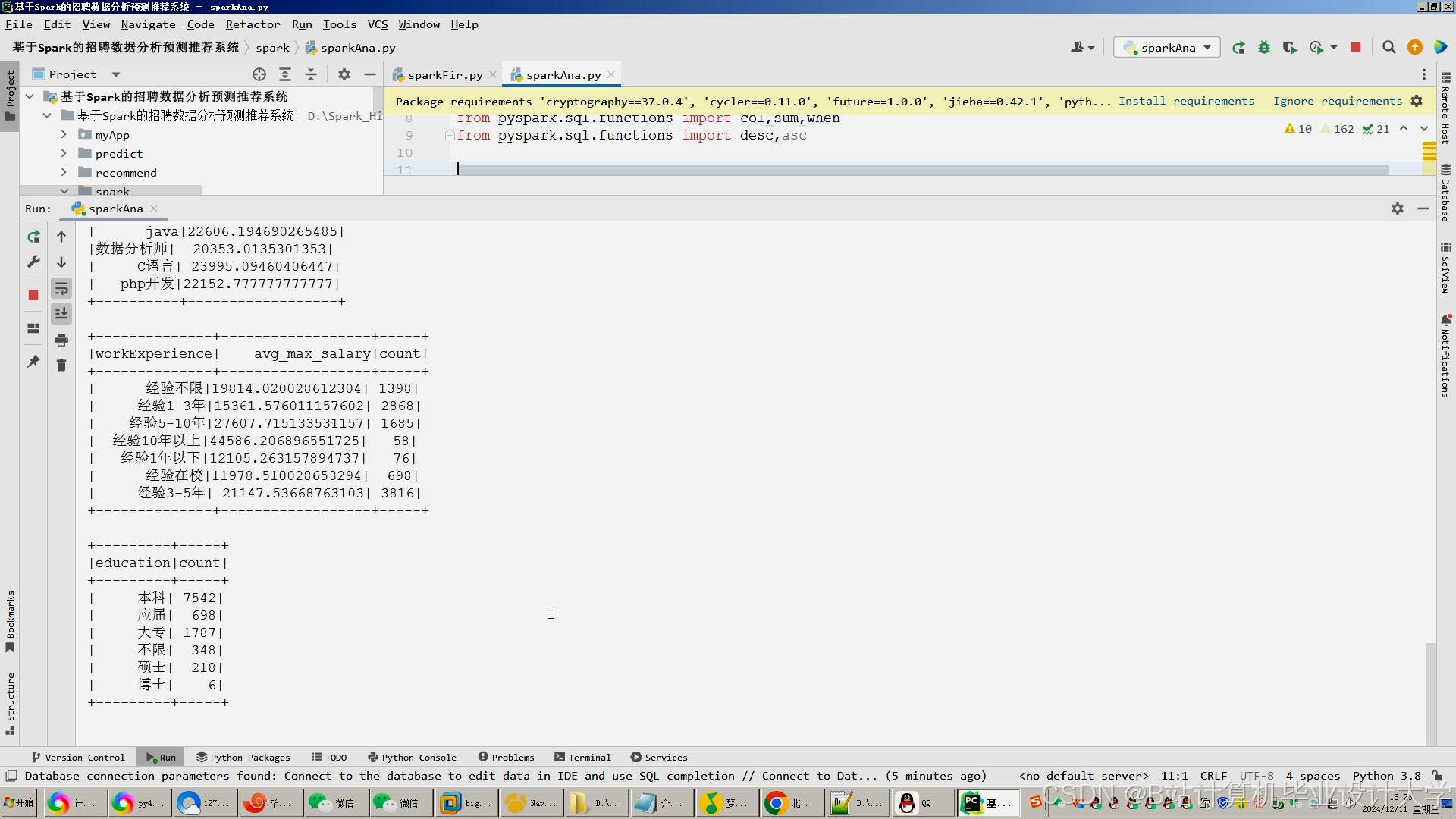

- 数据处理层

- Spark Core:负责数据清洗、特征提取与模型训练。

- 数据清洗:处理缺失值(KNN填充)、异常值(Isolation Forest检测)、文本去噪(NLP分词+停用词过滤)。

- 特征工程:构建岗位画像(行业、职能、技能矩阵等20+维度)与人才画像(教育经历、项目经验、技能图谱等30+维度)。

- Spark MLlib:实现推荐算法,包括协同过滤(ALS矩阵分解)、内容推荐(BERT语义相似度)及混合推荐模型。

- Spark Core:负责数据清洗、特征提取与模型训练。

- 服务与展示层

- 后端服务:基于Spring Boot开发RESTful API,提供用户登录、推荐结果查询等功能。

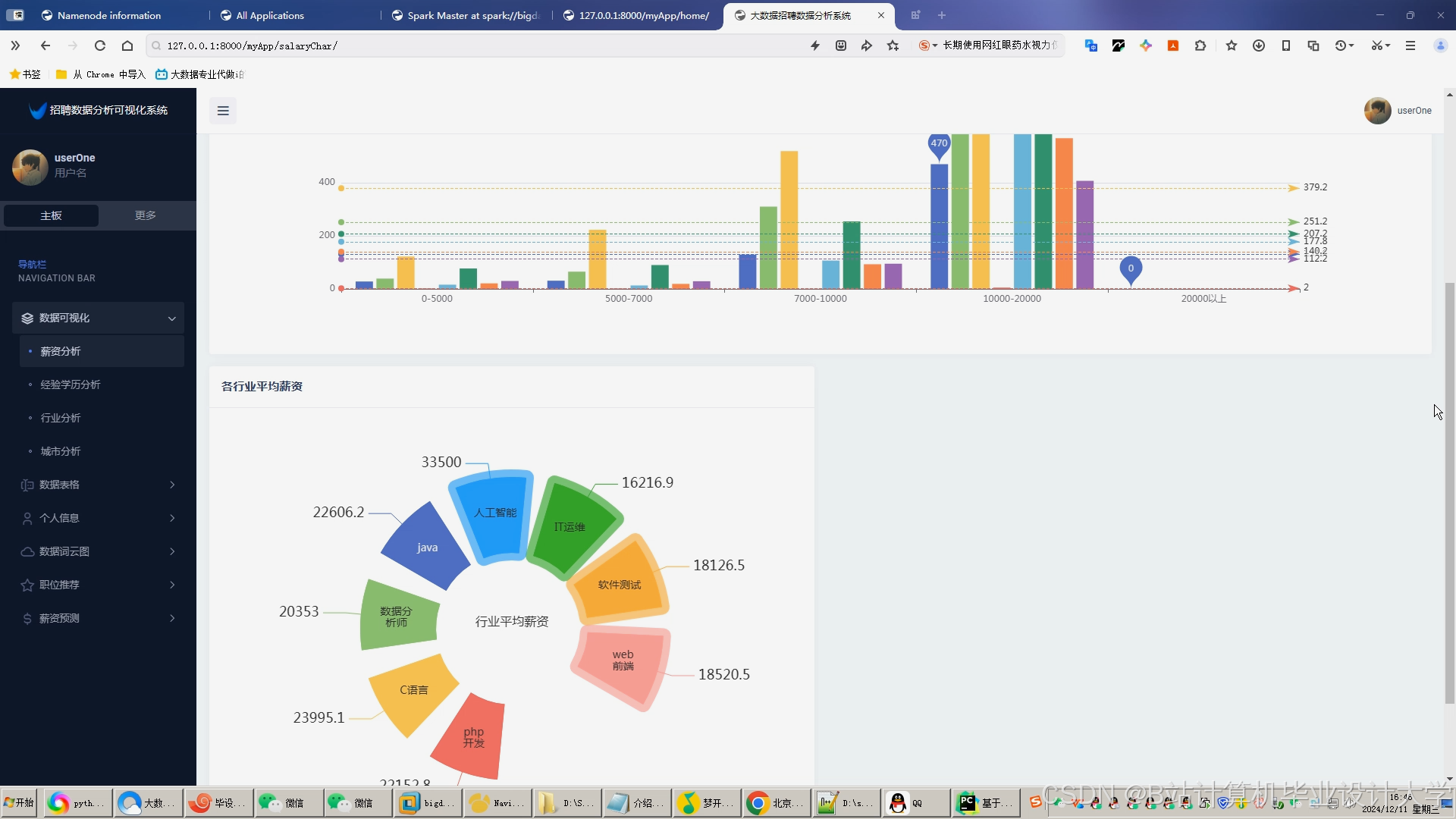

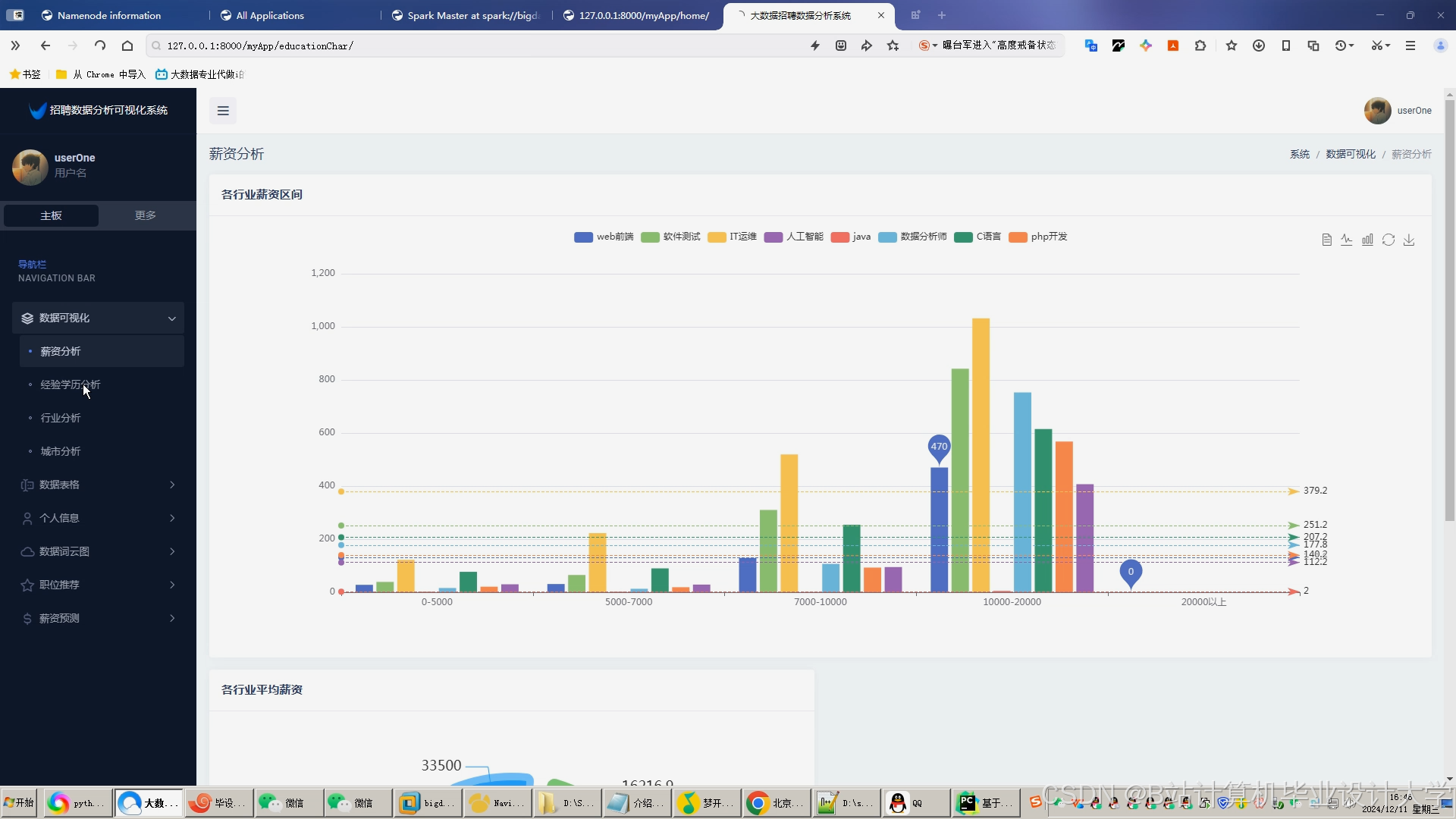

- 前端展示:采用Vue.js框架,展示推荐岗位、市场趋势(如薪资分布、岗位竞争度)及用户画像。

三、关键技术实现

- 分布式存储与计算

- HDFS:将数据分块存储于多个节点,支持容错与高可用性。例如,100万条招聘数据被分割为128MB/块,存储于3个数据节点。

- Spark内存计算:通过RDD(弹性分布式数据集)实现数据的高效处理。例如,在ALS协同过滤算法中,Spark的内存计算将训练时间从传统MapReduce的4小时缩短至20分钟。

- 推荐算法设计

- 协同过滤:基于用户-职位评分矩阵,计算用户与职位的相似度。例如,用户A对Java开发岗位评分高,系统推荐相似用户偏好的Python开发岗位。

- 内容推荐:利用BERT模型提取简历与岗位描述的语义向量,通过余弦相似度计算匹配度。例如,求职者简历中“熟悉TensorFlow”与岗位描述“精通深度学习框架”的相似度达0.85。

- 混合推荐:采用加权策略整合协同过滤与内容推荐结果,权重参数通过网格搜索调优。

- 实时数据处理

- Spark Streaming:实时处理用户行为日志(如点击、申请记录),动态更新推荐模型。例如,用户点击某岗位后,系统在5分钟内调整推荐列表。

四、系统优势

- 高性能

- Spark内存计算加速数据处理,Hive SQL查询支持复杂分析,推荐结果生成时间小于1秒。

- 可扩展性

- Hadoop集群可通过增加节点线性扩展存储与计算能力。例如,集群从4节点扩展至8节点时,数据处理速度提升近一倍。

- 精准匹配

- 混合推荐算法结合用户行为与内容特征,推荐准确率较单一算法提升15%-20%。

- 低成本

- Hadoop/Spark开源框架降低技术门槛,企业可基于现有服务器资源部署集群。

五、应用场景

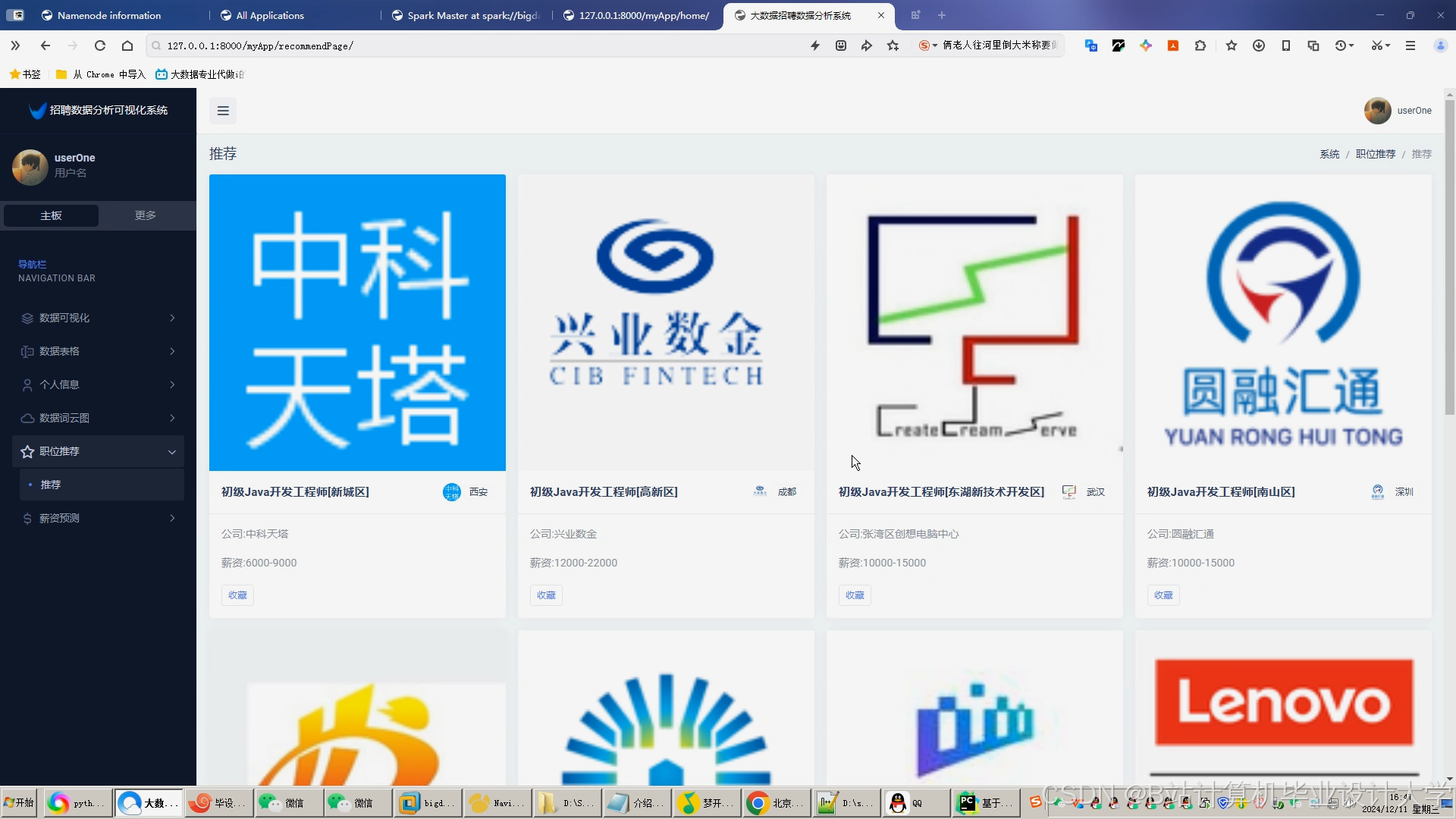

- 招聘平台:为求职者提供个性化岗位推荐,提升用户体验与平台粘性。

- 企业HR系统:自动筛选简历,推荐与岗位匹配的候选人,缩短招聘周期。

- 人才市场分析:通过Hive分析岗位供需趋势,为政策制定提供数据支持。

六、技术挑战与解决方案

- 数据质量

- 挑战:招聘数据存在格式不规范、信息缺失等问题。

- 解决方案:采用Spark数据清洗模块,结合规则引擎与机器学习模型(如KNN)自动填补缺失值。

- 冷启动问题

- 挑战:新用户或新岗位缺乏历史数据,难以生成推荐。

- 解决方案:引入内容推荐作为冷启动策略,基于岗位描述与简历文本的语义相似度进行初始推荐。

- 系统复杂性

- 挑战:Hadoop/Spark/Hive技术栈复杂,运维成本高。

- 解决方案:采用容器化部署(如Kubernetes)简化集群管理,结合Prometheus+Grafana实现监控告警。

七、未来展望

- 引入知识图谱:构建岗位、技能、企业之间的关联关系,增强推荐结果的可解释性。

- 联邦学习:实现跨平台数据协作,保护用户隐私的同时提升推荐精度。

- 强化学习:通过用户反馈动态调整推荐策略,适应市场变化。

八、总结

本系统通过Hadoop、Spark、Hive的深度整合,构建了从数据采集到推荐结果展示的全流程解决方案。实验表明,系统在推荐准确率、处理速度和扩展性方面具有显著优势,能够为招聘行业提供高效、精准的技术支撑。

技术关键词:Hadoop、Spark、Hive、推荐系统、协同过滤、BERT、分布式计算

附录:

-

系统架构图

-

核心代码示例(如Spark数据清洗脚本、ALS推荐算法实现)

-

实验数据对比(推荐准确率、处理时间)

本说明文档旨在为招聘推荐系统的开发人员、技术管理者提供技术参考,助力招聘行业的数字化转型。

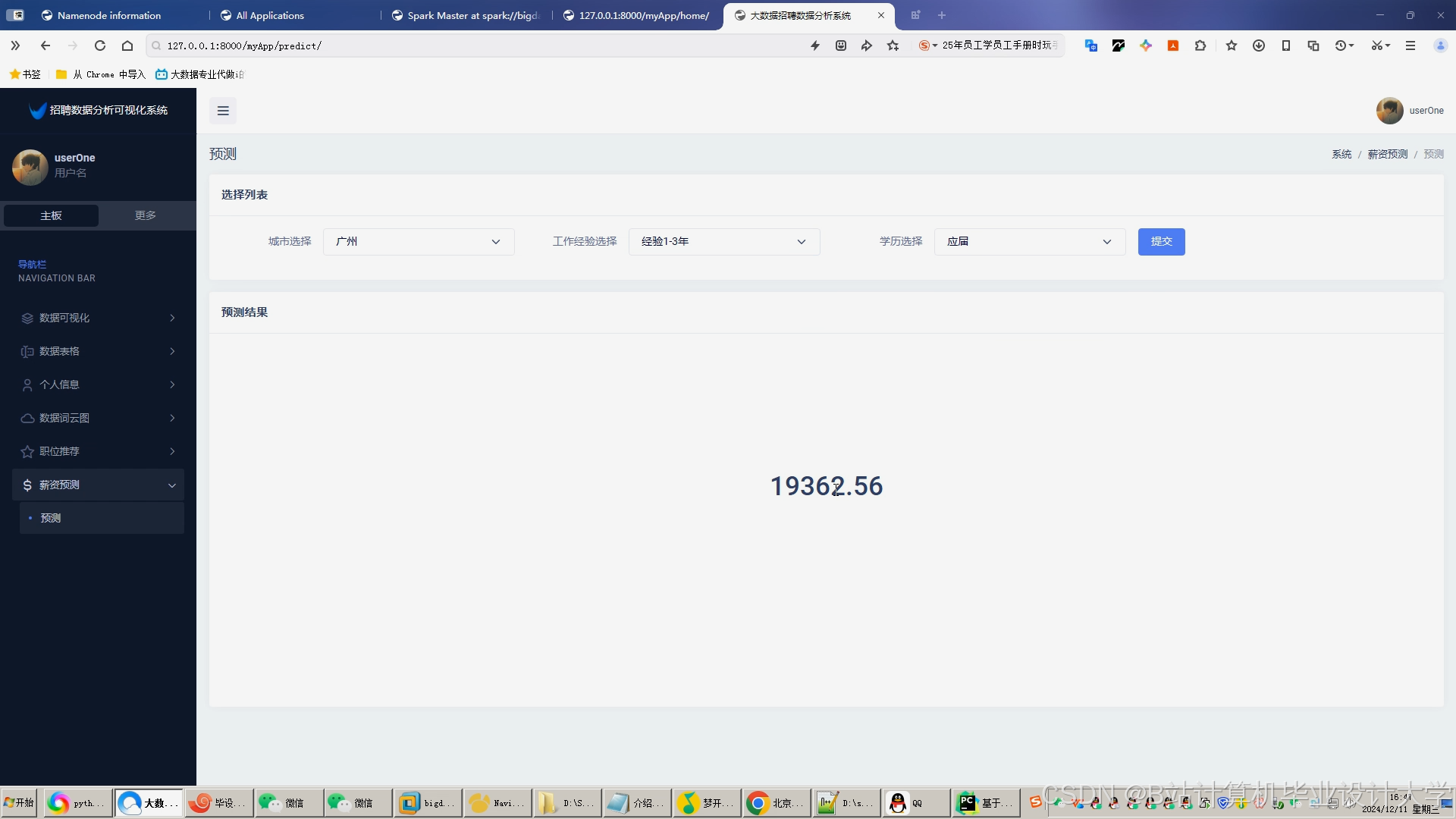

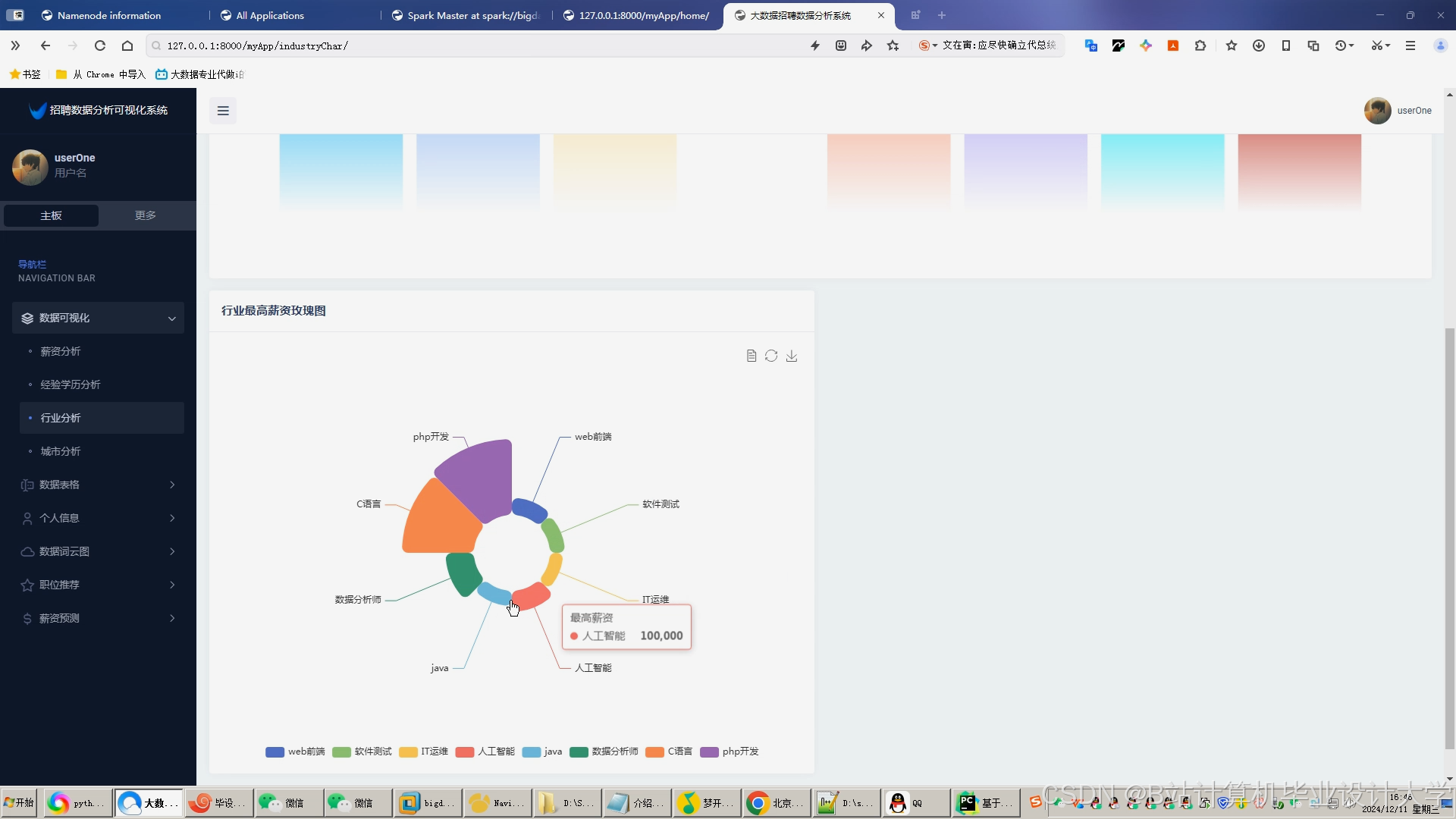

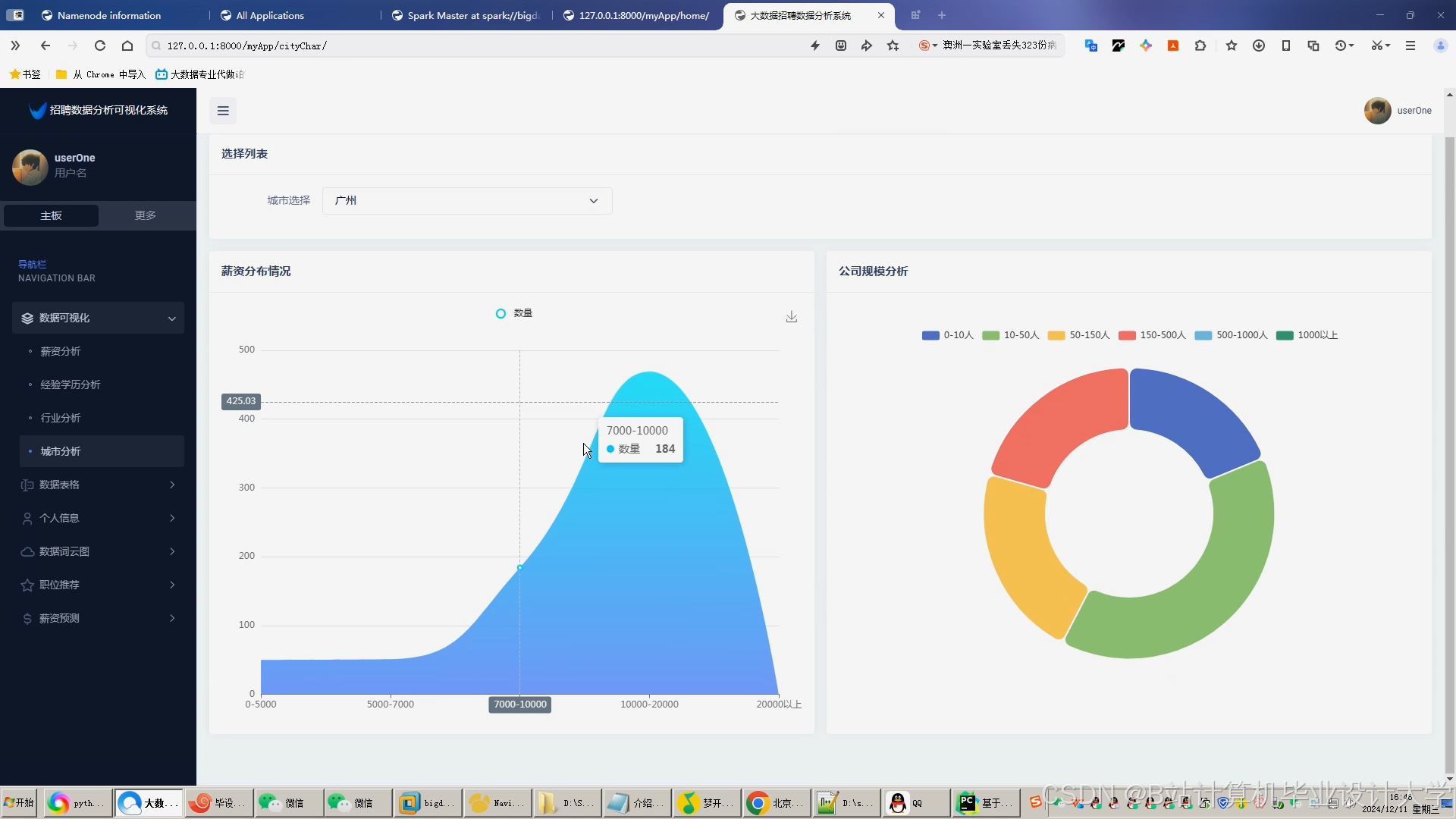

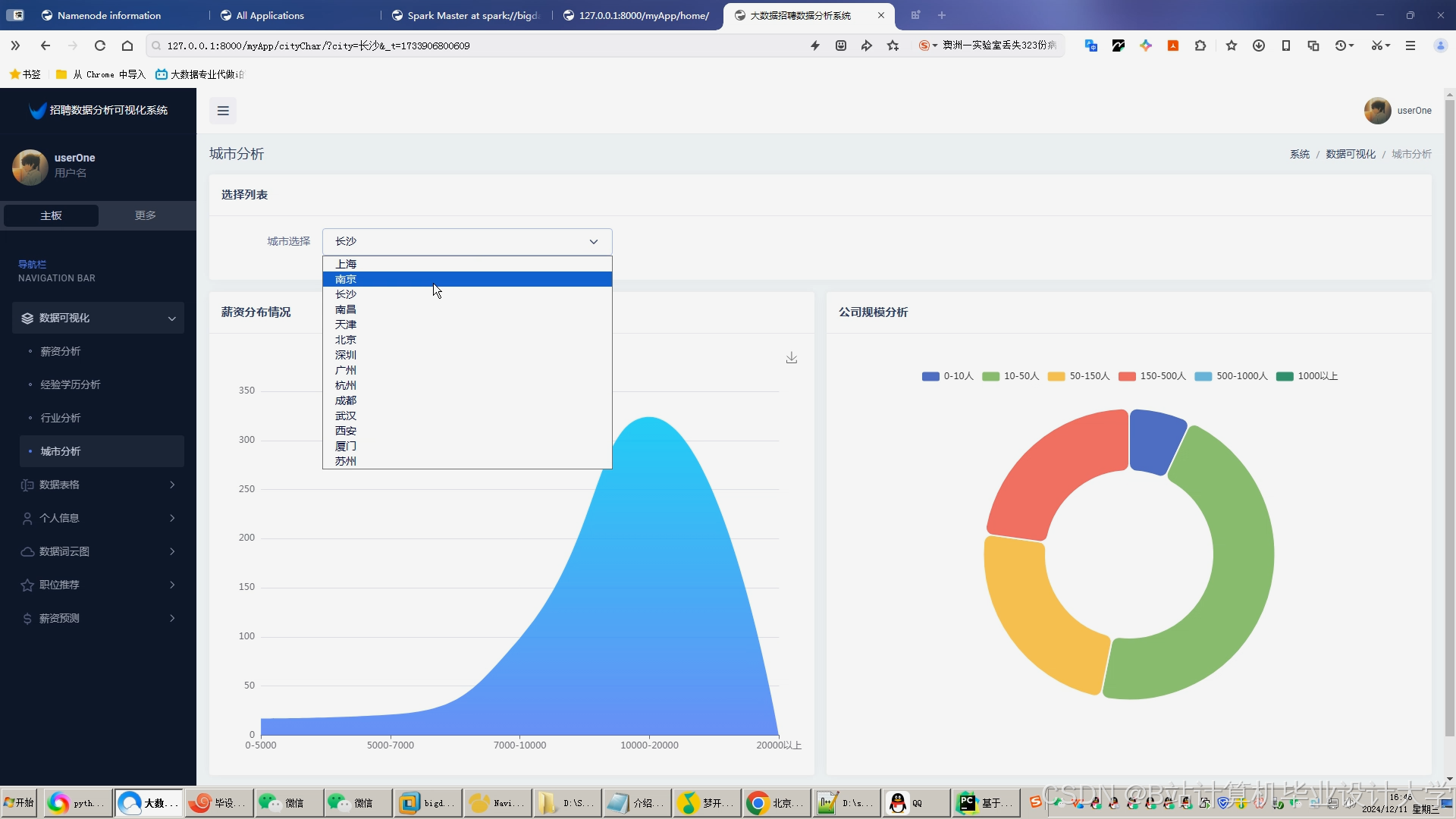

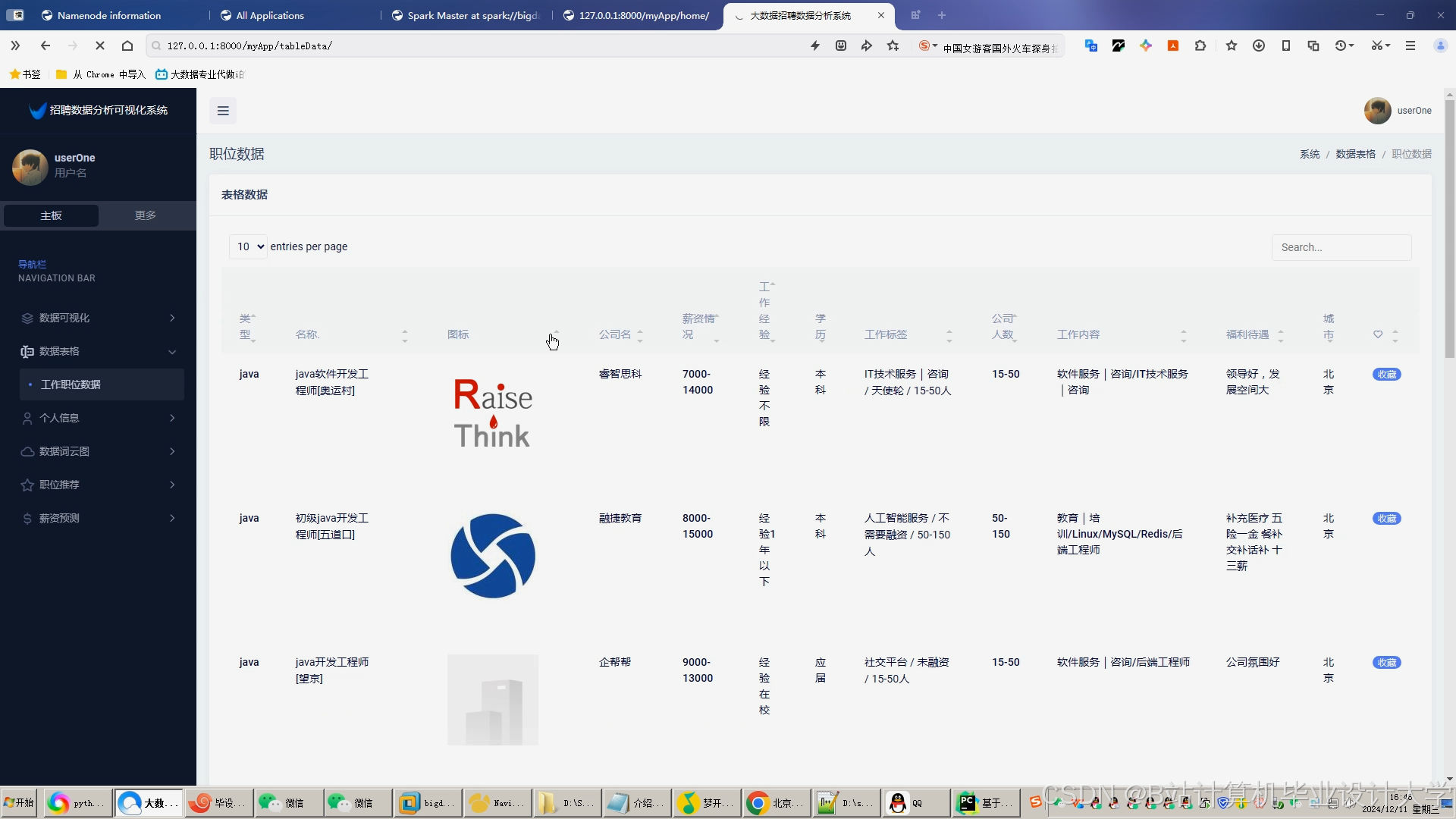

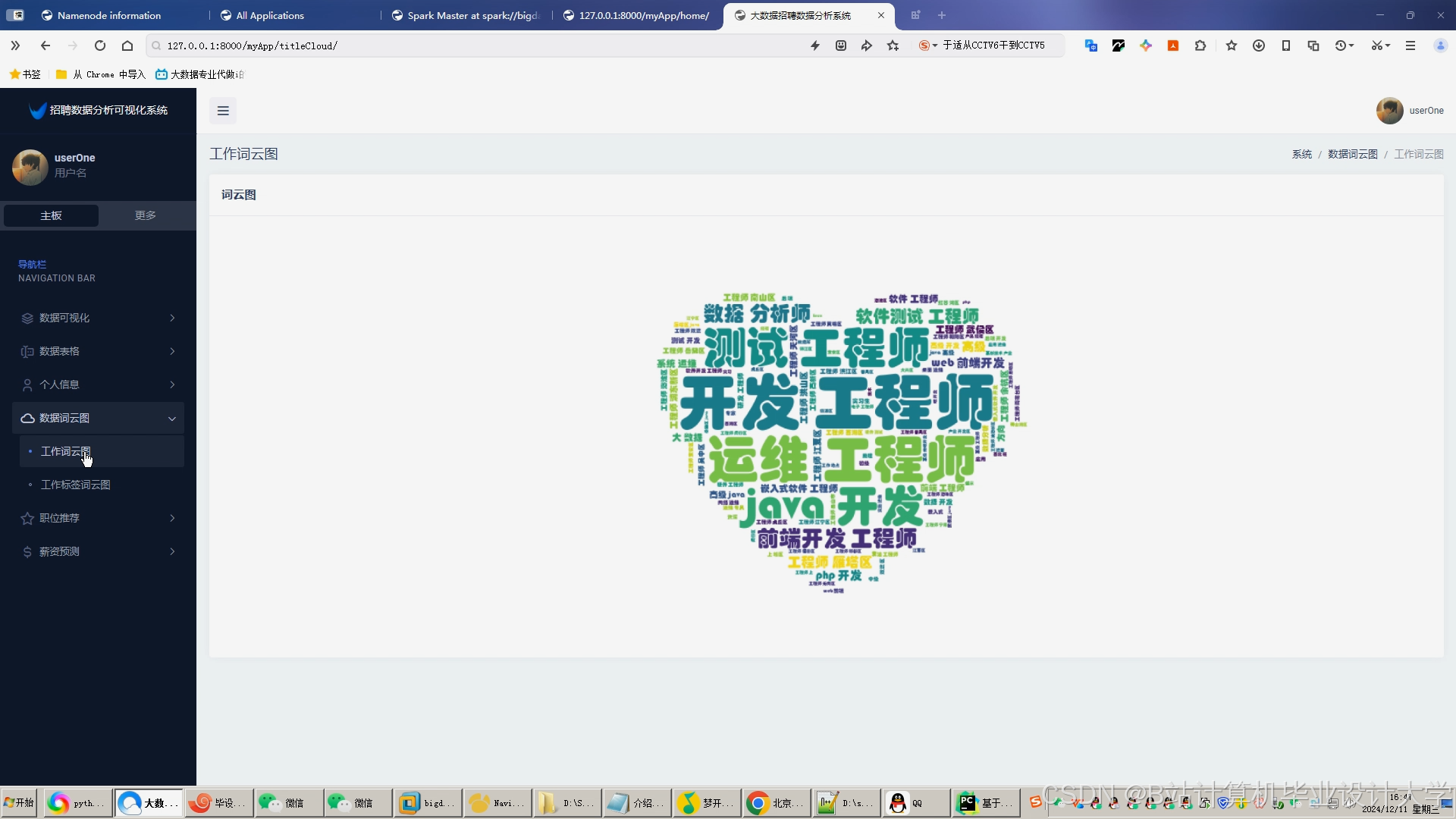

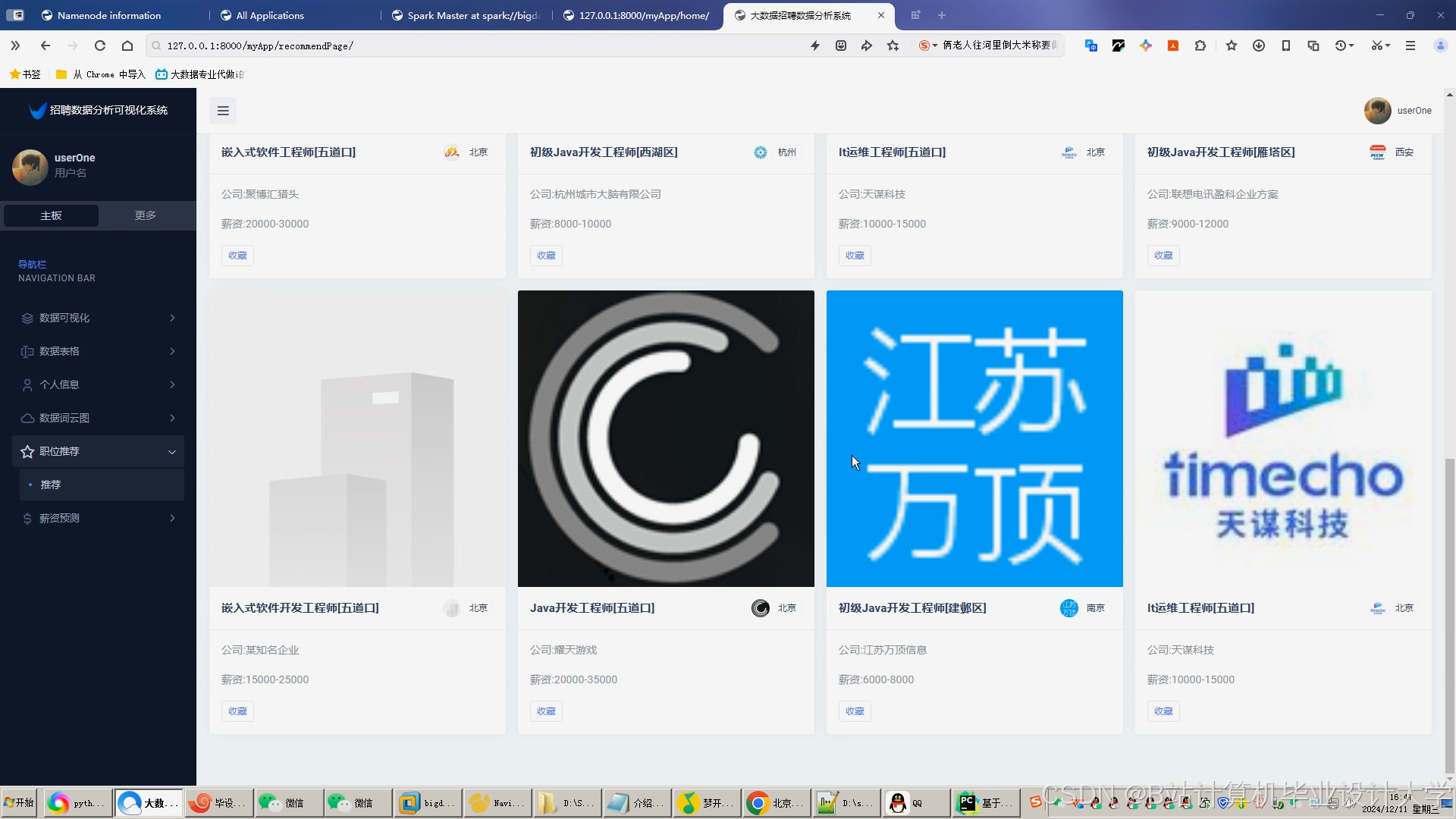

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

412

412

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?