推荐语:自动驾驶领域的视觉-语言-动作(VLA)模型虽前景可期,却在非结构化边界场景中表现欠佳,主要归因于针对性基准数据的稀缺。为此,这篇研究推出Impromptu VLA解决方案。核心贡献在于构建了Impromptu VLA数据集:该数据集包含8万余条精细构建的视频片段,提炼萃取自8个开源大规模数据集中的200余万条原始素材。

自动驾驶技术虽已在结构化环境(如路标清晰、车流规律的城市道路与高速公路)中取得显著进展,但其普适化愿景要求我们必须突破既有边界,迈向复杂多变的非结构化道路域。这些非结构化场景涵盖:

● 乡村小径与动态施工区域

● 标识模糊路段

● 灾后修复区域

此类场景构成自动驾驶的下一个关键突破口——当前系统在此面临最严峻考验,唯有实现技术突破方能真正达成"全地形自主通行"的核心目标。

成功突破该前沿领域的核心障碍在于弥补专项数据的严重匮乏。尽管现有众多驾驶数据集为自动驾驶技术的发展奠定了基础,但这些数据主要覆盖常规结构化交通场景,导致非结构化环境下的多样性挑战形成显著盲区——包括道路边界模糊、非常规动态障碍物出现、临时交通规则适应及险峻路面应对等复杂工况。若缺乏大规模精标注且针对性反映此类复杂条件的数据集,训练鲁棒性AI驾驶系统并严格评估其场景适应性的能力将持续受到严重制约。

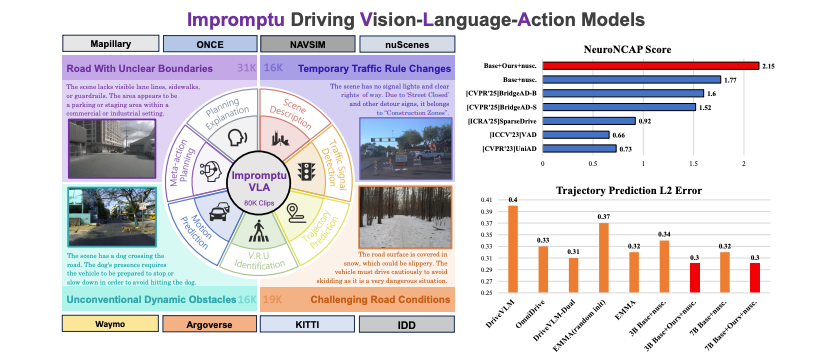

为填补此数据空白,研究人员推出Impromptu VLA数据集——专为推进非结构化道路自动驾驶研究而构建的新型大规模基准(如图1所示)。该数据集从8个多样性公开来源的逾200万条初始视频片段中提炼萃取,最终包含约8万条经精细筛选与验证的片段。这些数据涵盖四大非结构化挑战场景:边界模糊道路、临时交通规则变动、非常规动态障碍物及复杂路况,并通过多任务标注系统与路径规划轨迹数据增强;其构建采用先进流程:先利用视觉-语言模型(VLMs)进行思维链推理实现场景细粒度理解,再经人工全面核验确保高质量可靠标注。

通过全面实验评估严谨验证了Impromptu VLA数据集的有效性:基于该数据集微调的视觉-语言模型(VLA)在主流自动驾驶基准测试中性能显著提升。在具挑战性的闭环NeuroNCAP测试[41](表2)中,采用Impromptu VLA增强的3B模型平均得分从基准模型1.77/5.00提升至2.15/5.00,碰撞率关键性降低(72.5%→65.5%);在nuScenes开环轨迹预测评估[7]中,预训练使L2误差显著下降——微调模型的平均L2误差降至0.30m,性能逼近EMMA+等专用方法(0.29m),尽管后者往往依赖更大规模专有数据集[88,26]。此外,在本数据集特有的多维度Q&A验证体系评估中,模型在非结构化场景下的感知、预测与规划能力均呈现显著可量化提升。

图片1|构建的Impromptu VLA数据集涵盖8万余条精选视频片段(源自8个开源数据集),聚焦挑战当前自动驾驶系统的四类关键非结构化边界场景;该数据集支持场景理解、行为预测、元规划与轨迹规划等多任务关联训练。核心实验表明:基于Impromptu VLA训练的VLA模型在闭环与开环指标上均实现显著性能跃升。

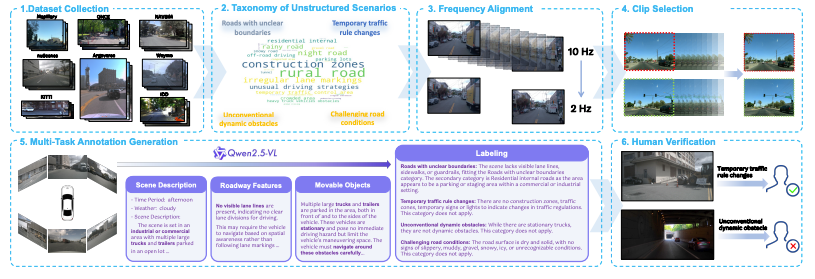

图片2|Impromptu VLA数据集处理与标注流程:本流程图展示数据集构建的序列化过程:始于原始数据收集与场景分类体系定义,经频率校准、关键片段筛选,至基于Qwen2.5-VL的多任务标注生成(含场景描述、对象/特征分析及标记),终至严格人工核验流程。

非结构化驾驶场景分类体系

构建Impromptu VLA数据集的核心目标在于突破对非结构化场景的模糊单一化认知,转而建立针对此类环境特有挑战的细化理解框架。为实现这一目标,并将数据集聚焦于真正突破当前自动驾驶系统技术瓶颈的场景,研究团队率先展开数据驱动的探索流程,构建起简洁且系统化的非结构化道路场景分类体系。

构建场景分类体系的方法论始于对采集数据的广泛无偏探索:首先通过等距采样从聚合的多源标准化数据集中抽取约10%片段构成代表性子集,随后依托高性能视觉-语言模型Qwen2.5-VL 72B进行开放式描述性分析。区别于预定标签协议的传统问答模式,利用该模型的先进图像理解能力,最终提示其对每段场景生成详尽的文本描述。

后续阶段采用多层级高度自动化流程将描述文本精炼为有效的非结构化挑战类别:首先通过编程化识别滤除常规驾驶场景,执行基于视觉-语言模型(VLM)的二次分类——利用精心设计的提示词指令,使Qwen2.5-VL作为场景分类器评估原始描述是否属于非常规案例。为确保该VLM过滤机制的可靠性,实施提示词迭代优化:在约1000条场景描述的验证子集上,由两位标注员独立进行"常规/非常规"人工标注,通过持续比对模型分类结果与人类共识标签,直至达成高度一致性标准。

研究人员对全量数据中筛选出的非常规场景进行语义级分析,识别重复模式并聚合语义相似的非结构化场景。这种聚类过程使潜在子类别得以自下而上地浮现(例如"道路边缘模糊"、"临时道路施工"、"动物闯入道路"或"积雪导致的低能见度"等),通过迭代优化与机器学习簇群整合——基于对各类场景中核心驾驶复杂度来源的抽象归纳——最终凝练形成下述四大核心类别:

1. 边界模糊道路:指可通行区域边界不明确或未定义的场景(如乡村土路、越野路径、标线褪失/缺失道路),此类场景严重干扰车道线检测及可行驶区域分割等感知任务。

2. 临时交通规则变动:指因施工区域、人工交通指挥或临时标识导致标准交通规则动态变更的场景,要求自动驾驶系统适应特殊指令与非常规道路布局的复杂情境。

3. 非常规动态障碍物:指典型城市驾驶中罕见、需特定应对策略的动态参与者或障碍(包括大型/运动轨迹不规则车辆、意外位置出现的交通弱势群体或动物遭遇等),此类场景均会引发突发性威胁。

4. 复杂路况:涵盖因恶劣路面(如坑洼、泥泞、积雪、结冰)或环境因素(如浓雾、暴雨、低照度、强眩光)导致能见度严重受损或车辆动力学特性受影响的场景,显著增加隐患识别与安全导航的难度。

数据标注与处理

完成非结构化场景分类体系定义(见第2.2节)后,精选数据将经历图3所示的多个处理与标注阶段:

关键片段筛选与稳定性过滤:所有收集的序列首先标准化至统一时间频率(2Hz),解决多源数据不一致问题(表1)。研究人员将片段配置与NAVSIM[14]对齐,保留历史1.5秒与未来5秒数据,并从每个数据包中筛选中心关键片段进行标注。为最小化瞬时关键片段预测的假阳性干扰,采用时序稳定性打包机制:将相邻片段打包为最长15秒的"局部过滤包",仅当某场景特征(初步识别于关键片段层)在该包内持续出现达到最小片段数(如>1次),才被视为稳定特征并传递至后续标注阶段。需特别说明:这些"局部过滤包"仅用于稳定性校验,最终数据集主体仍由独立标注的关键片段构成。

基于思维链的场景分类与结构化信息提取:采用Qwen2.5-VL 72B模型配合思维链(CoT)提示对选定关键片段进行分类,实现超越简单描述的富结构化信息提取。该分层推理流程依次分析:全局场景上下文(R1:描述)、静态道路特征(R2)、动态物体(R3),最终形成基于证据的四类非结构化场景判定(R4)。结构化CoT输出不仅提供场景类别,更为后续任务标注奠定丰富的上下文基础。

多任务标注生成:基于思维链(CoT)流程提取的场景类别与结构化信息,参照Senna等综合标注框架,通过规则驱动与大型语言模型(LLM)协同方法为每个关键片段生成六维任务标注:1)场景描述——通过目标式VLM查询生成包含环境背景、时间、天气及交通状况的综合描述;2)交通信号检测——经VLM查询识别活跃信号灯的存在状态与类型;3)交通弱势群体识别——依据地面真实数据标定行人、骑行者等VRU的存在、类型及与主车距离;4)运动意图预测——利用VLM生成场景关键参与者的预期运动意图;5)元动作规划——基于场景上下文提示VLM生成主车高阶规划指令(如左加速、直行保持);6)规划解释——由VLM生成文本解释,阐明主车应对场景的潜在或实际操作逻辑;7)端到端轨迹预测——通过结构化历史车辆状态及对应未来目标轨迹构建支持数据。

全量人工核验:所有生成的标注数据——包括核心非结构化场景分类及后续多任务标签——均经过细致的人工核验流程。标注员逐帧审阅关键片段及相关标签,执行二值化判定(接受/驳回)或必要时进行微调修正,确保数据集整体高保真度。为在全面人工审查前量化评估VLM对既定非结构化类别的分类性能,我们从nuScenes数据集中等距采样200张图像组成子集进行测试:比对VLM分类结果与专家人工标注显示,多个类别获得优异F1分数——"临时交通规则变动"达0.90,"非常规动态障碍物"为0.81,"复杂路况"达0.91;而"边界模糊道路"类别因在该nuScenes子集中出现频次过低未获有效F1值。这些验证结果充分印证了基于VLM的标注流程可靠性。

数据集统计

最终构建的Impromptu VLA数据集包含大量针对非结构化道路特性精选的标注片段,图2展示了源自各源数据集片段总量及其在四种非结构化场景类别中的分布情况,同步呈现轨迹分布覆盖度。为最大化数据集在感知与规划模型训练评估中的效用,每个片段生成的富多任务标注被结构化为规划导向的问答对——该格式受DriveVLM[58]与EMMA[25]等框架启发,在语言模型的序列空间内直接关联视觉输入、文本输出与行动轨迹预测。采用标准化评估方案:通过80:20比例将全部精选片段划分为训练集与验证集,并在每个场景类别内实施分层抽样,确保验证集完整保留所有已定义非结构化道路挑战的代表性分布。

突破现有端到端自动驾驶基准测试的边界

闭环评估:选用NeuroNCAP框架[41]——该综合闭环评估系统基于nuScenes数据集仿真各类高挑战性现实驾驶场景,支持在多工况下评测自动驾驶车辆的规划控制系统在安全性与效能层面的表现。NeuroNCAP评估主要通过碰撞率和NeuroNCAP分数(NNS) 量化性能:遵循5星评级逻辑,若无碰撞发生得5.0分;若发生碰撞则按公式 NNS = 4.0 · max(0, 1 − vi/vr) 计算得分。其中vi为实际撞击速度(主车与碰撞参与者的相对速度矢量模),vr表示未采取规避动作时的参考撞击速度。这意味着若无法避免碰撞,分数将随实际撞击速度vi逼近或超过vr值而从潜在4分线性递减至0。碰撞率则直接统计致撞场景的百分比,两类指标均按交互类型(如正向/侧向)分类记录。

采用两种不同训练流程的对比研究方法:以Qwen2.5VL 3B模型作为基线模型。第一流程(表2中标注为"Base+Impromptu+nuScenes")的具体实施包括:首先在Impromptu VLA数据集训练集上微调基线VLM,随后基于此适配模型进一步在nuScenes训练集进行精调;第二流程("Base+nuScenes")则不经Impromptu VLA训练,直接在nuScenes训练集上微调基线VLM。最终两种模型均在NeuroNCAP基准上进行评估。

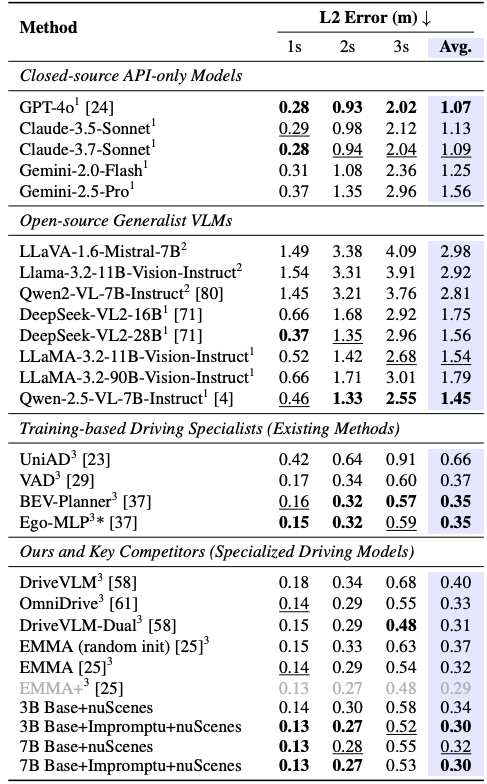

开环评估:除闭环仿真外,通过开环评估专项检验视觉-语言模型(VLA)在采用Impromptu VLA后的轨迹预测精度。该评估同样基于nuScenes数据集,聚焦端到端轨迹预测任务:性能核心指标为未来1/2/3秒时间节点处预测轨迹与真实轨迹的L2距离(米),辅以平均L2误差。实验方法延续闭环测试的对比范式——针对Qwen2.5VL 3B与7B模型,对比两种训练策略:1)Base+nuScenes:基线VLM直接在nuScenes数据集微调;2)Base+Impromptu+nuScenes:基线VLM先在Impromptu VLA上微调,再迁移至nuScenes精调。此设计旨在分离本数据集预训练对多场景轨迹预测任务的增益效应。结合多种先进方法的横向对比结果详见表3。

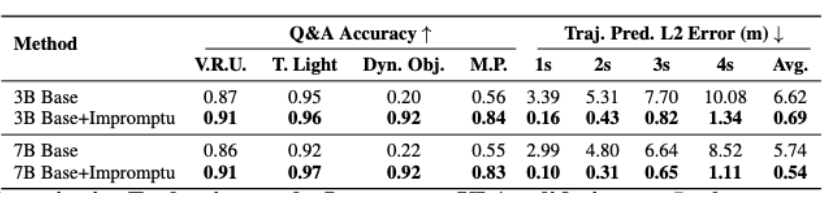

如表3所示,基于nuScenes基准的开环轨迹预测结果表明:当模型采用Impromptu VLA数据集进行预训练后,性能显著提升。这种轨迹精度的增益在1秒、2秒及3秒预测时域中持续显现。尤为值得注意的是,经此训练的3B/7B模型达到了与EMMA+[25](平均L2误差0.29米)等领先方法相媲美的竞争力区间——尽管EMMA+依托Waymo提供的数百万场景专有数据集训练而成。这一结果有力佐证了Impromptu VLA数据集(含8万片段)大幅提升轨迹预测能力的有效性。

表格1|nuScenes数据集开环轨迹预测L2误差(单位:米)表头说明。每列最优结果以粗体标注,次优结果加下划线。

Impromptu VLA框架下视觉-语言模型的能力诊断评估

为探究第二个核心问题——即Impromptu VLA数据集具体提升自动驾驶哪些能力维度(感知/预测/规划),以及验证集作为诊断基准的效能——利用其规划导向的问答任务展开诊断评估套件:通过面向特定任务场景的对比方法,评测基础视觉-语言模型(VLM)与基于本数据集调优版本的性能差异。

图片3|Impromptu VLA验证集定量评估:各问答任务性能对比(对比3B/7B版Qwen2.5-VL基础模型与本方案微调模型在验证集的表现,各能力维度准确率↑:交通弱势群体感知(V.R.U.)、交通信号灯识别(T. Light)、动态物体预测(Dyn. Obj.)、元规划指令理解(M.P.)及轨迹规划(L2);最优值以粗体标注)

这篇工作提出的Impromptu VLA数据集包含逾8万条视频片段,配备多任务问答标注及对应行动轨迹,作为专为解决非结构化环境自动驾驶数据匮乏问题构建的精细基准。实验表明:基于该数据集训练的视觉-语言模型(VLA)实现性能突破性提升——在NeuroNCAP基准测试中展现出增强的闭环安全性能与驾驶评分,并在nuScenes开环轨迹预测任务中取得精度跃升。本数据集特有的诊断验证套件进一步证实:模型在应对复杂非结构化道路场景时,其感知、预测与规划能力获得可量化增强,确立了该数据集作为诊断工具的效能。Impomptu VLA数据集为开发更鲁棒、自适应且具备现实场景复杂工况应对能力的自动驾驶系统提供了关键资源。

局限性与展望:注意到基于Qwen2.5-VL的标注生成机制可能引入特定模型偏差,但通过全量人工核验流程及其在提升非结构化场景VLA性能的实际效用,可确认其作为核心研究资源的重大价值。

1088

1088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?