softmax主要用于输出层,作用是将所得一维矩阵中每个元素的大小量化成概率值。更符合人类直观感受所预测准确率。

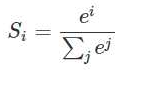

其公式为:

如在mnist中应用。xw+b所得是一个[0,1,2,3,4,5,6,7,8,9]一维矩阵,此时加入pre = tf.nn.softmax(xw+b)得出是[0,1/45,2/45,3/45,4/45…9/45]元素为各个数字的概率大小。在其后的loss函数中,利用loss=tf.reduce_mean(tf.squere(y-pre))。这里y是one-hot类型。假设y是数字3,则其one-hot为[0,0,0,1,0,0,0,0,0,0]。

关于softmax函数

Softmax在输出层的应用及示例

Softmax在输出层的应用及示例

最新推荐文章于 2025-04-25 17:27:05 发布

博客介绍了softmax主要用于输出层,可将一维矩阵元素量化成概率值,更符合人类对预测准确率的直观感受。还给出了其公式,并以mnist为例,展示了softmax的应用及后续loss函数的计算,其中y为one - hot类型。

博客介绍了softmax主要用于输出层,可将一维矩阵元素量化成概率值,更符合人类对预测准确率的直观感受。还给出了其公式,并以mnist为例,展示了softmax的应用及后续loss函数的计算,其中y为one - hot类型。

333

333

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?