引言

Wenpeng Yin等发表在arXiv上的论文,原文地址:地址

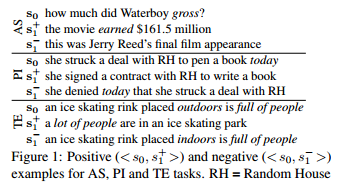

这应该是第一篇提出Attention用于CNN的文章,主要用来解决句子对的问题,作者在answer selection (AS),、paraphrase identification(PI)、textual entailment (TE)三个任务上进行实验,均取得了不错的结果。

作者提出,在以往的很多模型中,都是在特定的任务中对句子进行微调或者独立为每个句子生成语义表示,还有利用语言学上的方法,这些方法都没有考虑到句子间的一些相互依赖的信息,如

其中 s 0 s_0 s0为原始问句, s 1 + s^+ _1 s1+与 s 1 − s^- _1 s1−为对应任务中的正确与错位候选句子,可以看到,在句子对中要找到对应的答案,所需要关注的位置是各不相同的,比如在AS中需要关注 gross 与 earned 等。

模型

BCNN: Basic Bi-CNN

基础的CNN模型,没有Attention,用于对句子对建模。模型中构建了两个并列的CNN层分别对句子进行特征提取,两个层之间共享卷积参数,后续再进行pool等常规操作,最后用一个logistic regression进行分类。

Input layer

上图中,输入句子长度 s s s分别为5和7,词向量维度为

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

716

716

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?