6.创建和启动DAGScheduler

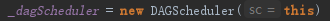

DAGScheduler主要用于在任务正式交给TaskSchedulerImpl提交之前做一些准备工作,包括:创建Job,将DAG中的RDD划分到不同的Stage,提交Stage,等等。创建DAGScheduler的代码如下:

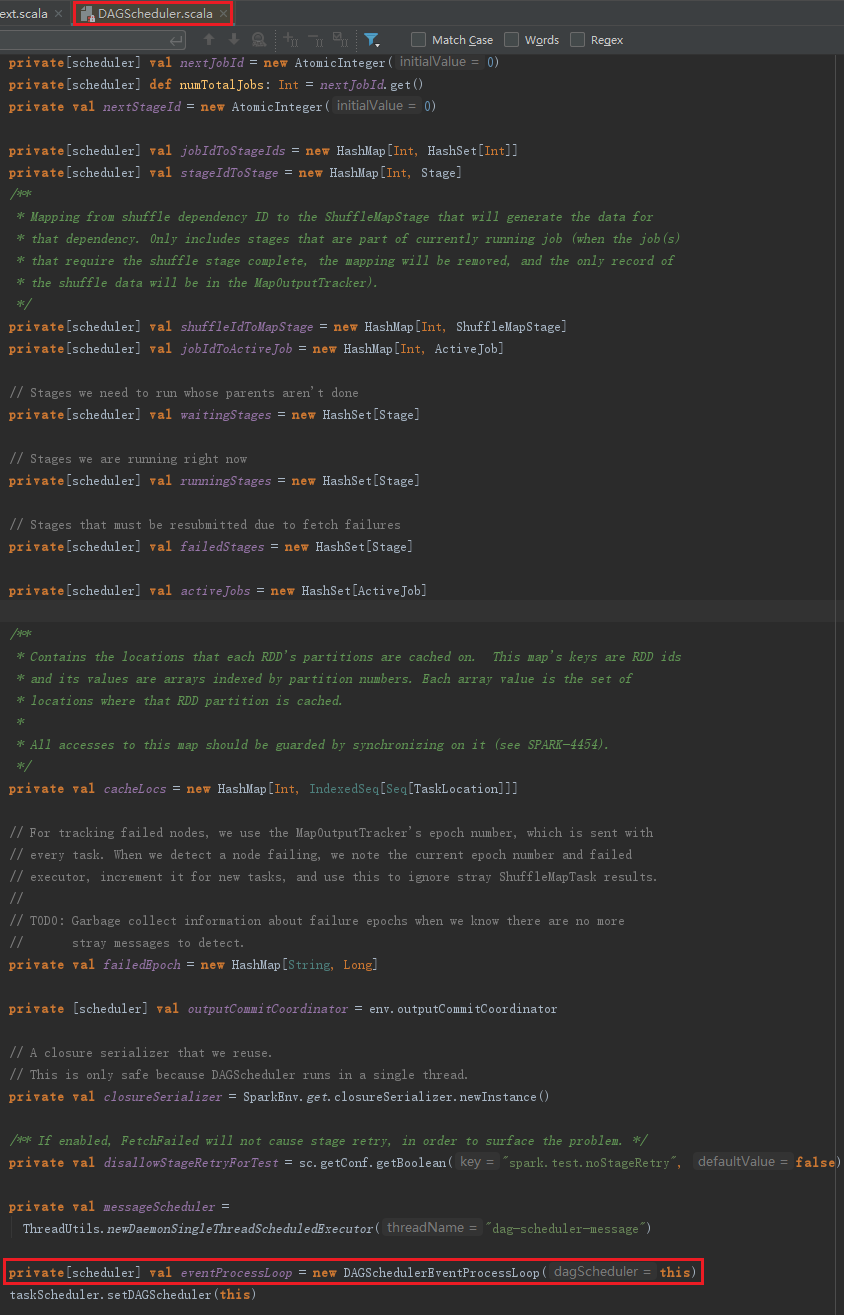

DAGScheduler的数据结构主要维护jobId和stageId的关系、Stage、ActiveJob、以及缓存的RDD的partitions的位置信息,见代码:

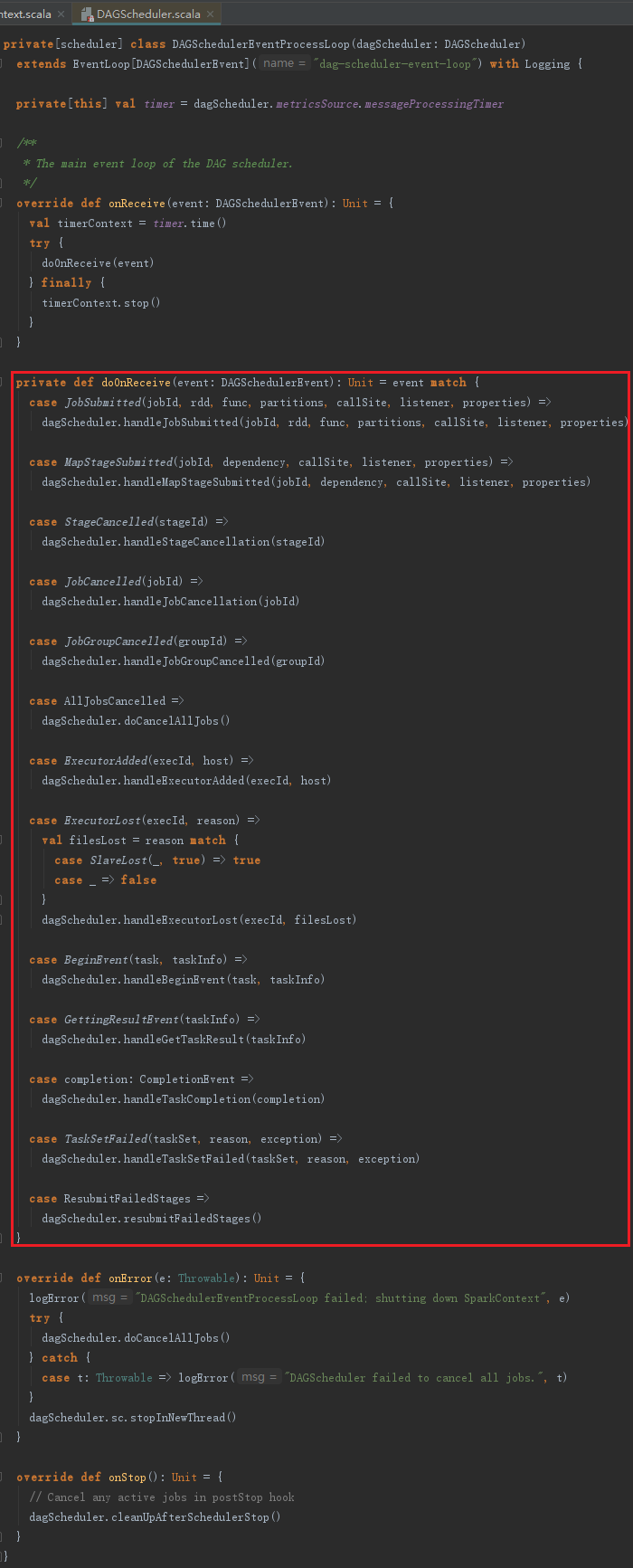

DAGSchedulerEventProcessLoop能处理的消息类型,比如JobSubmitted、MapStageSubmitted、StageCancelled、JobCancelled、JobGroupCancelled、AllJobsCancelled、ExecutorAdded、ExecutorLost、BeginEvent、GettingResultEvent、completion、TaskSetFailed、ResubmitFailedStages。DAGSchedulerEventProcessLoop接受这些消息后会有不同的处理动作。DAGSchedulerEventProcessLoop的代码实现如下:

Spark DAGScheduler详解

Spark DAGScheduler详解

本文深入解析了Spark中DAGScheduler的工作原理,包括其主要职责如创建Job、划分Stage及提交等过程。同时介绍了DAGScheduler的数据结构及其如何通过DAGSchedulerEventProcessLoop处理各类事件。

本文深入解析了Spark中DAGScheduler的工作原理,包括其主要职责如创建Job、划分Stage及提交等过程。同时介绍了DAGScheduler的数据结构及其如何通过DAGSchedulerEventProcessLoop处理各类事件。

3259

3259

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?