一、调度脚本

1、通过hive/beeline的方式

一般情况下的hive之间的数据的转换的话,是通过kettle工具执行的,所以也是在调度的时候传入kettle的执行脚本kitchen.sh。

一般操作:

一般生产多使用ETL工具(kettle)进行处理数据的插入

/opt/data-integration/kitchen.sh -file=%%G_PATH_ETL./adm/adm_qltsys/first_page_load_time_1d_delta_daily/main.kjb -param:DT=%%v_t_day. -level=Detailed

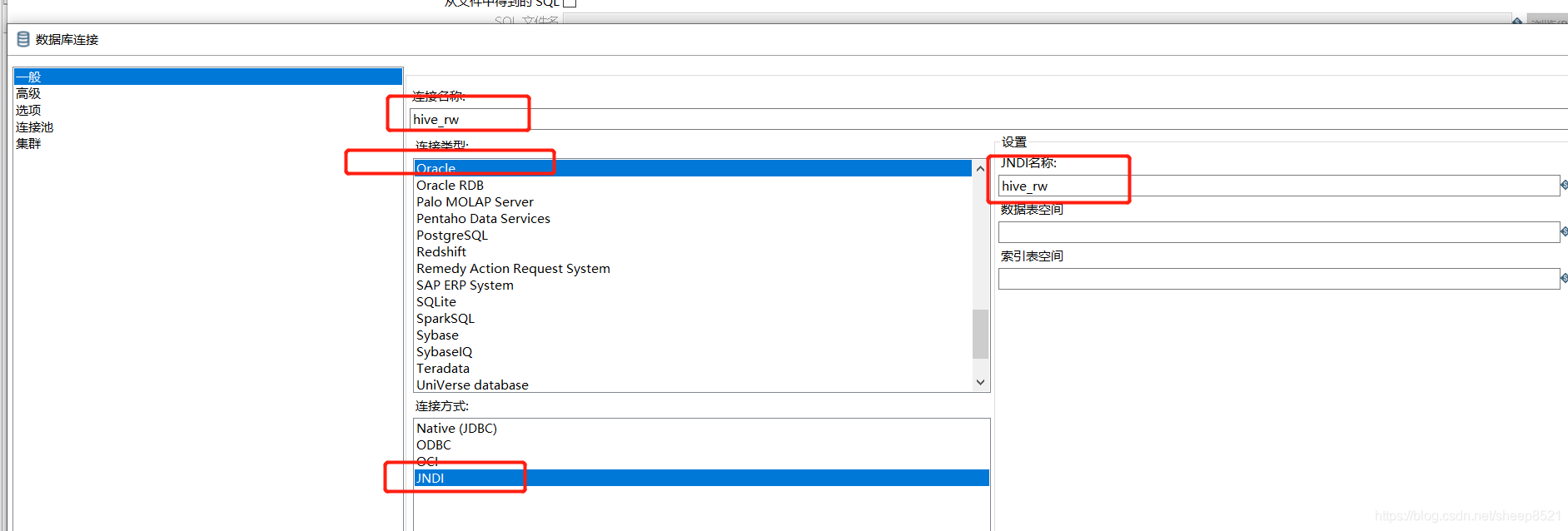

前提是kettle里面已经配置好了要连接的数据库

流程的话都是调度kettle脚本执行工作,最基本的也是同kettle连接hive,只是没有暴露数据连接ip以及集群的认证等重要信息。

2、如果是插入数据不能用kettle方式解决的那么生产常常是shell脚本和sql脚本结合使用,并进行调度使用。

二、生产实践

背景:

需求:要吧hive的数导入phoenix里,使用多列多条件的查询方式(用来代替hbase)对外暴露http接口给前端查询。

从hive到外部的数据导出的情况,像phoenix的话是没有必要通过kettle执行插入数据的(应该也是可以用的)。所以要用原生的hive命令执行插入数据。<

本文探讨了从Hive到Phoenix的数据迁移策略,包括使用Kettle、Shell脚本、SQL脚本及Beeline的不同场景应用。详细介绍了通过beeline执行HQL语句的步骤,以及如何处理UDF函数依赖的JAR文件,确保数据迁移的顺利进行。

本文探讨了从Hive到Phoenix的数据迁移策略,包括使用Kettle、Shell脚本、SQL脚本及Beeline的不同场景应用。详细介绍了通过beeline执行HQL语句的步骤,以及如何处理UDF函数依赖的JAR文件,确保数据迁移的顺利进行。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4160

4160