背景:

用VMware 安装好ubuntu 14.04后,有些应用是需要固定IP的,而默认情况下,每次重启电脑或者重启虚拟机,虚拟机的IP地址可能变化。

目的:重启虚拟机后,虚拟机的IP地址不再变化。

方法:为虚拟机绑定IP。

步骤:经过几次实践,将自己设置的过程总结如下(只说过程,不做原理解释):

如有谬误,请不吝指出。

一、设置网络适配器VMNet8的IP属性。

step1:

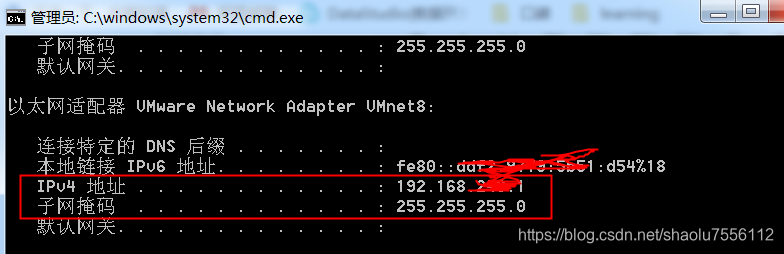

打开Windows控制台,通过ipconfig命令,查看本机各网络适配器的ip配置,记下其中VMware Network Adapter VMnet8的ipv4地址和子网掩码。

step2:

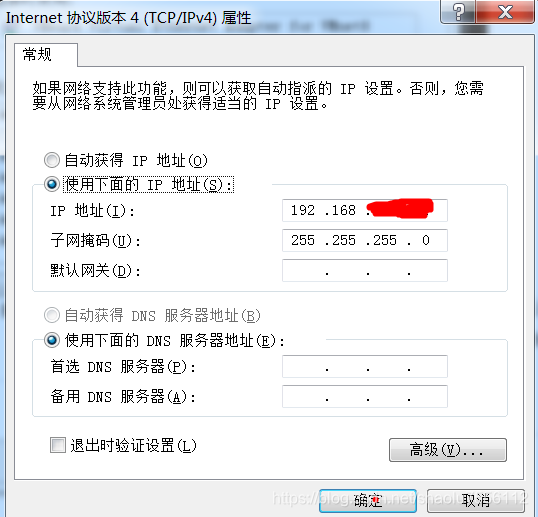

打开控制面板->网络和共享中心->更改适配器设置,找到VMware Network Adapter VMnet8,双击打开,然后点击“属性”,打开新窗口后,双击Internet 协议版本4(TCP/IPv4),打开新窗口如下,然后选中“使用下面的IP地址”,填入在step1中获取的IP地址和子网掩码,其他内容可空置不填。

二、设置VMware的网络配置为NAT模式

step1:

打开VMware Workstation,在上方菜单栏点击“编辑”->“虚拟网络编辑器” ,

step2:

在新窗口上部选中”VMnet8",然后在下方选择“NAT模式(与虚拟机共享主

本文详细介绍了如何在VMware Workstation中为Ubuntu 14.04虚拟机配置静态IP地址。首先,设置网络适配器VMNet8的IP属性,然后将VMware的网络配置更改为NAT模式,并记录相关IP参数。最后,通过修改Ubuntu的网络配置文件,设置静态IP和DNS,确保虚拟机启动后IP地址保持不变。

本文详细介绍了如何在VMware Workstation中为Ubuntu 14.04虚拟机配置静态IP地址。首先,设置网络适配器VMNet8的IP属性,然后将VMware的网络配置更改为NAT模式,并记录相关IP参数。最后,通过修改Ubuntu的网络配置文件,设置静态IP和DNS,确保虚拟机启动后IP地址保持不变。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1223

1223

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?