java.io.IOException: Unreasonable length = 1050410

问题描述:

solr重启失败, 报错信息如下

java.io.IOException: Unreasonable length = 1050410

at org.apache.jute.BinaryInputArchive.checkLength(BinaryInputArchive.java:127)

at org.apache.jute.BinaryInputArchive.readBuffer(BinaryInputArchive.java:92)

at org.apache.zookeeper.proto.GetDataResponse.deserialize(GetDataResponse.java:54)

at org.apache.zookeeper.ClientCnxn$SendThread.readResponse(ClientCnxn.java:814)

at org.apache.zookeeper.ClientCnxnSocketNIO.doIO(ClientCnxnSocketNIO.java:94)

at org.apache.zookeeper.ClientCnxnSocketNIO.doTransport(ClientCnxnSocketNIO.java:355)

at org.apache.zookeeper.ClientCnxn$SendThread.run(ClientCnxn.java:1082)

推测结论:

zookeeper服务器端默认读取数据节点大小为1.01M,当zookeeper客户端读取的节点大小超过该值时就会抛出异常信息:java.io.IOException: Unreasonable length = 1256441

注:一般情况下zookeeper服务端数据节点大小也是1M,此处由于之前碰到过节点超过1M时无法写入的问题,所以在zookeeper服务端提前设置了大小为3M。但是zookeeper客户端这边读取大小没有设置大小,所以才会出现客户端读取超大节点时抛出异常信息问题。

解决方案:

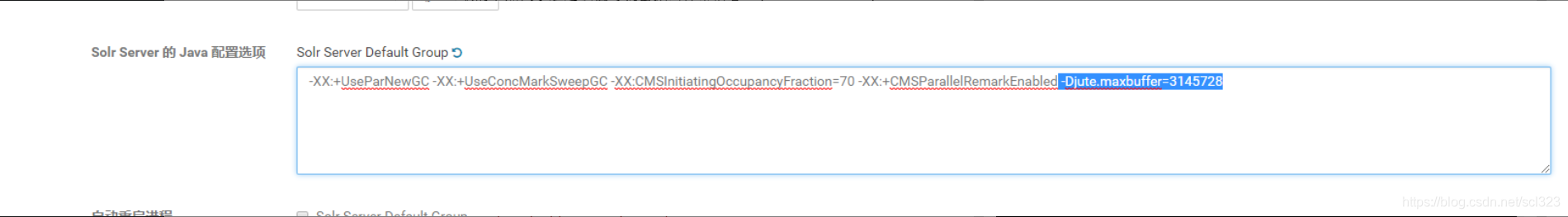

在solr高级配置里面添加jvm参数 -Djute.maxbuffer=3145728

配置完之后重启成功, 但是用hbase-indexer 的jar包同步数据到solr依旧报上面的错误。

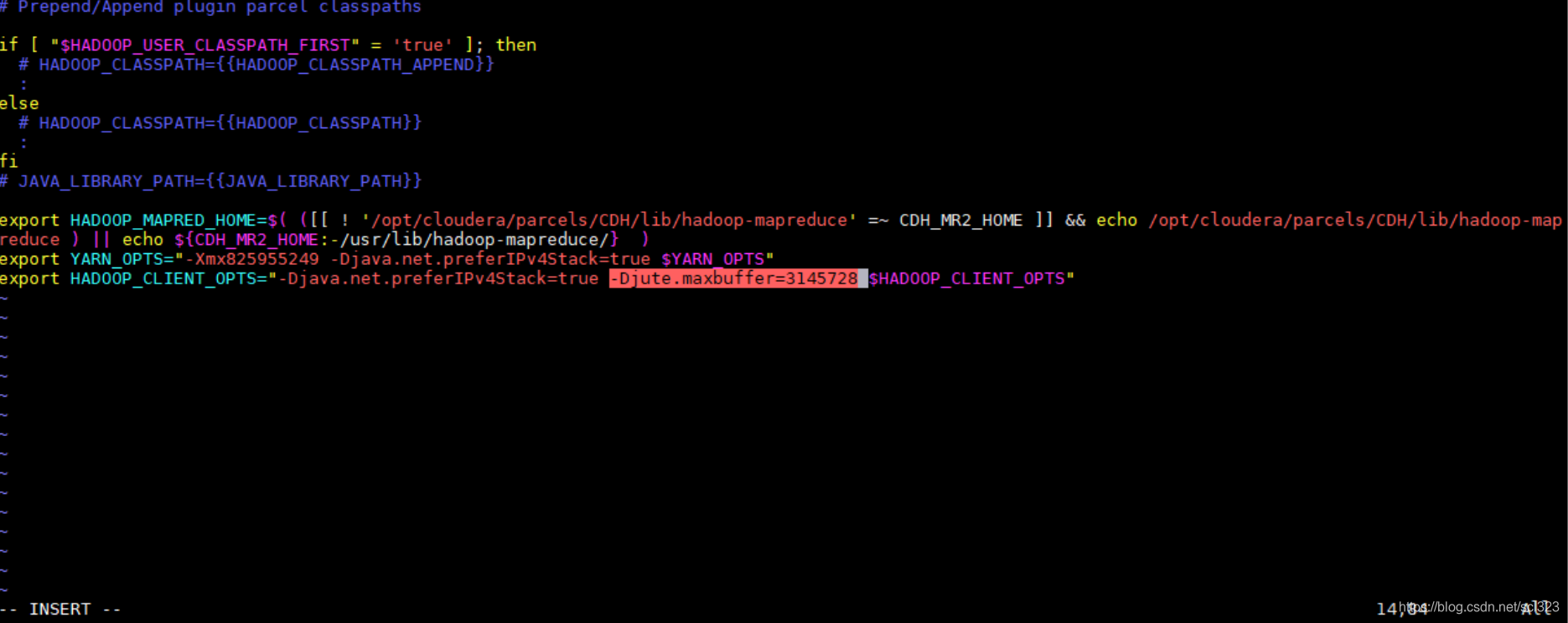

需要在hadoop配置文件增加 jute参数

修改/etc/hadoop/config/hadoop-env.sh

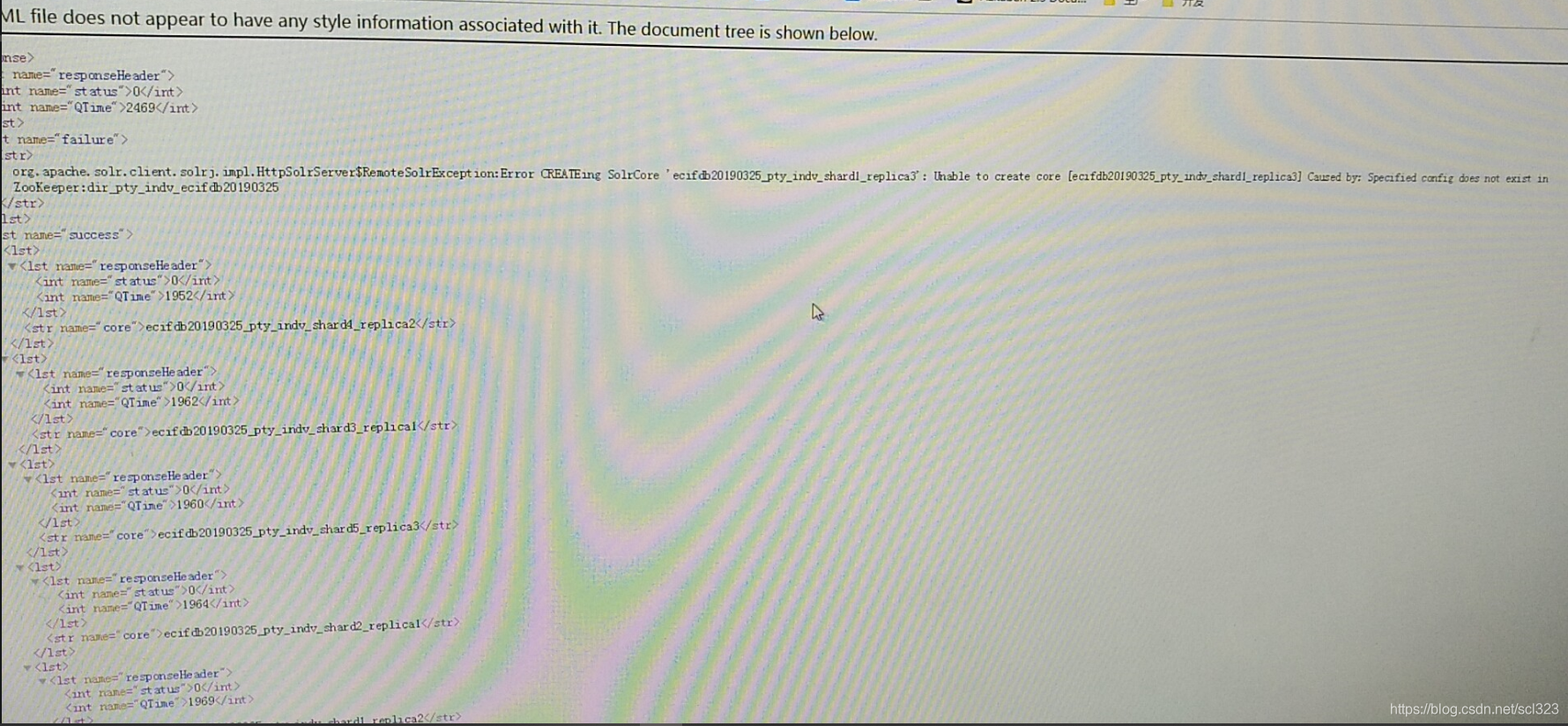

修改完后成功同步, 但是创建collection 会出现部分分片的replication创建失败

错误如下:

org.apache.solr.client.solrj.impl.HttpSolrServer$RemoteSolrException:Error CREATEing SolrCore 'ecifdb20190325_pty_indv_shard1_replica3': Unable to create core [ecifdb20190325_pty_indv_shard1_replica3] Caused by: Specified config does not exist in ZooKeeper:dir_pty_indv_ecifdb20190325

找了很久没找到解决办法, 后面重启集群解决问题。

本文解决了一个关于Solr重启时遇到的IOException异常问题,涉及到Zookeeper的数据节点大小限制,并提供了具体的解决方案,包括调整JVM参数和Hadoop配置。

本文解决了一个关于Solr重启时遇到的IOException异常问题,涉及到Zookeeper的数据节点大小限制,并提供了具体的解决方案,包括调整JVM参数和Hadoop配置。

911

911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?