Hadoop基础环境搭建

- 首先安装好centos 6.5的虚拟机,jdk 1.8 和hadoop 2.6.5

- 设置虚拟机的网络策略,详见 [https://blog.youkuaiyun.com/scenic2009/article/details/91863588]

安装软件

//安装java

rpm -i jdk-8u181-linux-x64.rpm

//设置环境变量

vi /etc/profile

export JAVA_HOME=/usr/java/default

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

基础配置

设置免密登陆

ssh localhost

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

关闭防火墙

service iptables stop

chkconfig iptables off

关闭 selinux

vi /etc/selinux/config

SELINUX=disabled

做时间同步

yum install ntp -y

vi /etc/ntp.conf

server ntp1.aliyun.com

service ntpd start

chkconfig ntpd on

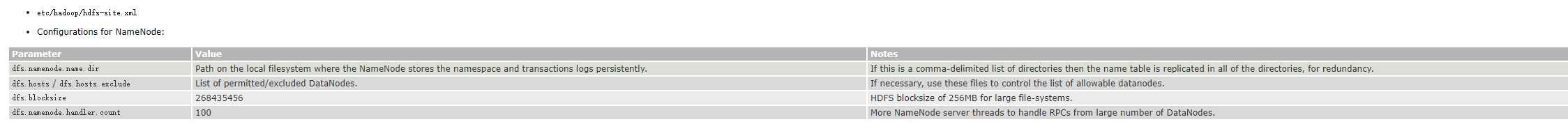

搭建hdfs

1,建立hadoop的安装路径,解压hadoop***.tar.gz到 /opt/bigdata

mkdir /opt/bigdata

tar -xvf hadoop-2.6.5.tar.gz -C /opt/bigdata

2. 配置HADOOP_HOME

vi /etc/profile

export HADOOP_HOME=/opt/bigdata/hadoop-2.6.5

export PATH=

P

A

T

H

:

PATH:

PATH:JAVA_HOME/bin:

H

A

D

O

O

P

H

O

M

E

/

b

i

n

:

HADOOP_HOME/bin:

HADOOPHOME/bin:HADOOP_HOME/sbin

3. 配置hadoop的角色 http://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html

cd $HADOOP_HOME/etc/hadoop

必须给hadoop配置javahome要不ssh过去找不到

vi hadoop-env.sh

export JAVA_HOME=/usr/java/default

给出NN角色在哪里启动

vi core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

<!--配置副本数 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--配置namenode的存储路径 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>/var/bigdata/hadoop/local/dfs/name</value>

</property>

<!--配置datanode的存储路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>/var/bigdata/hadoop/local/dfs/data</value>

</property>

<!--配置第二个namenode再哪里启动 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node02:50090</value>

</property>

<!--配置镜像文件存储地方 -->

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>/var/bigdata/hadoop/local/dfs/secondary</value>

</property>

配置DN这个角色再那里启动

vi slaves

node03

复制三台虚拟机

- 具体的设置:https://mp.youkuaiyun.com/mdeditor/91863588#

- 配置免密登陆

启动HDFS

第一只启动需要格式化:

hdfs namenode -format

启动

start-dfs.sh

可以通过jps查看进程

通过下面网址看详情

http://node01:50070

本文介绍Hadoop基础环境搭建过程。先安装centos 6.5虚拟机、jdk 1.8和hadoop 2.6.5,设置网络策略。接着进行基础配置,搭建hdfs,包括建立安装路径、配置HADOOP_HOME和角色等。然后复制三台虚拟机并配置免密登陆,最后启动HDFS,可通过jps查看进程。

本文介绍Hadoop基础环境搭建过程。先安装centos 6.5虚拟机、jdk 1.8和hadoop 2.6.5,设置网络策略。接着进行基础配置,搭建hdfs,包括建立安装路径、配置HADOOP_HOME和角色等。然后复制三台虚拟机并配置免密登陆,最后启动HDFS,可通过jps查看进程。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?