欢迎大家收看《RWKV 社区最新动态》第五期,本期内容收录了 RWKV 社区 2024 年 9 月的最新动态。

9 月动态省流版(TL;DR)

- RWKV 官方新闻动态

- RWKV-7 发布预览版

- RWKV-7 论文撰写已面向社区开放

- RWKV 官网上线 Bad Case 收集页面

- RWKV 中文文档已开源

- RWKV 学术研究相关

- RWKV-CLIP 论文被 EMNLP 主会收录

- 新论文:OccRWKV(3D 语义占用预测)

- 新论文:MSRWKV-2DTCN(光伏发电预测)

- 新论文:Mod-RWKV(多模态内容审核)

- 新论文:OnlySportsLM(体育运动任务)

- 新论文:RWKV-TIM(人类动作交互建模)

- 社区新项目

- RWKV-nonogram

RWKV 官方新闻动态

RWKV-7 发布预览版

RWKV-7(代号 Goose 雁)现已推出预览版!

RWKV-7 超越了 attention / linear attention 范式,它的状态演化很灵活,可以解决在相同算力消耗下 attention 无法解决的问题。

- RWKV-7 代码:https://github.com/BlinkDL/RWKV-LM/tree/main/RWKV-v7

- RWKV-7 模型(训练中):https://huggingface.co/BlinkDL/temp-latest-training-models/tree/main

RWKV-7 论文撰写面向社区开放

RWKV-7 论文的撰写已面向社区开放,请在此 Discord 频道 中参与论文讨论和撰写。

RWKV 官网上线 Bad Case 收集页面

RWKV 官网已上线 Bad Case 收集页面:https://rwkv.cn/feedback

我们邀请大家反馈 RWKV 模型回答效果不佳的示例。您的每次反馈,都可以帮助我们改进 RWKV 模型!

RWKV 中文文档已开源

rwkv.cn 的文档板块现已在 GitHub 仓库开源:https://github.com/LeoLin4258/rwkvcn-docs

我们欢迎任何关于 RWKV 文档的 Issue / PR ,让我们一起共建更完善的 RWKV 中文文档。

RWKV 学术研究相关

RWKV-CLIP 论文被 EMNLP 主会收录

RWKV-CLIP 被 EMNLP 主会收录!现可在 EMNLP 2024 的 CheckList 中查看。

- 论文:https://arxiv.org/pdf/2406.06973

- 代码:https://github.com/deepglint/RWKV-CLIP

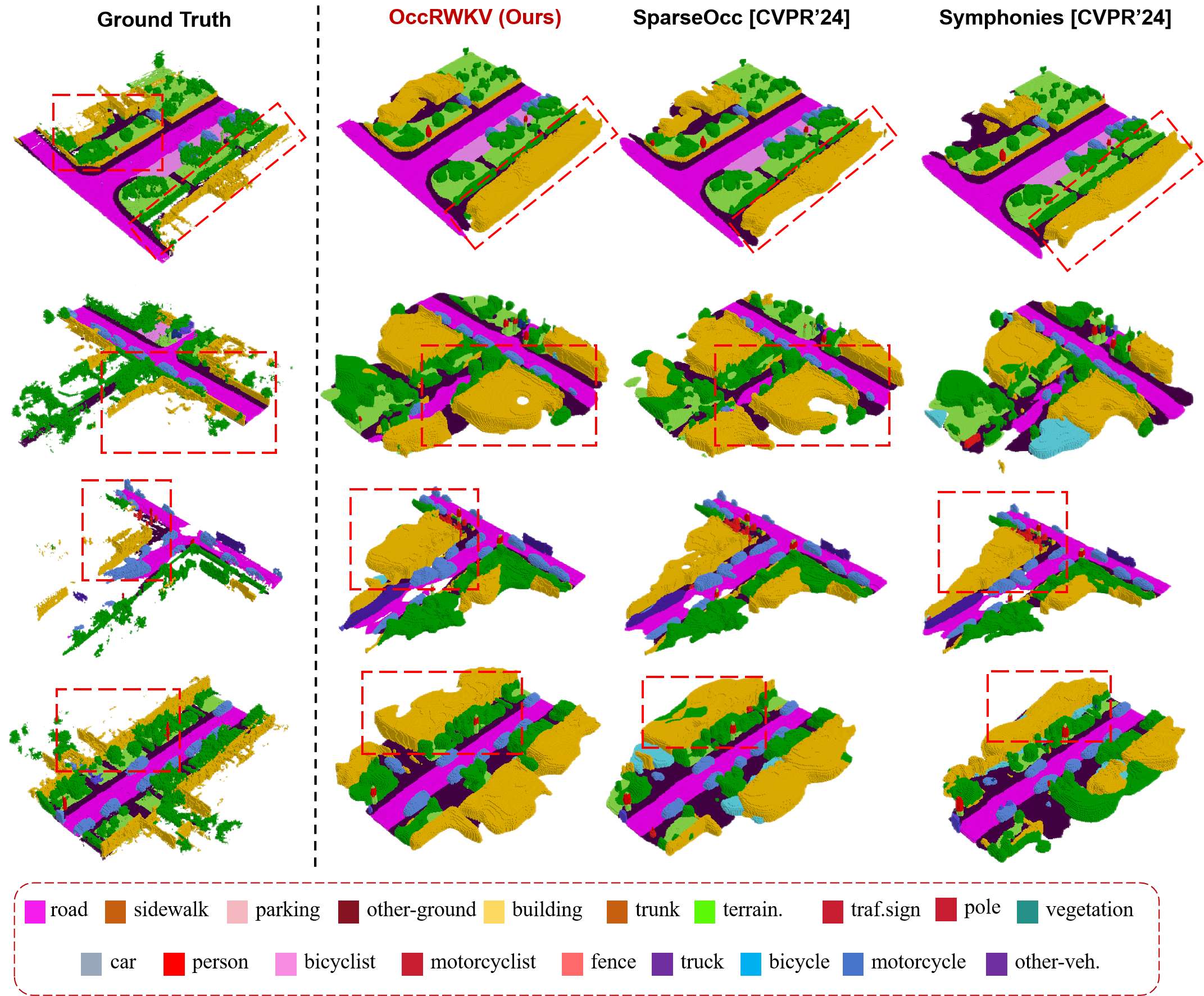

OccRWKV(3D 语义占用预测)

- 论文名称:OccRWKV: Rethinking Efficient 3D Semantic Occupancy Prediction with Linear Complexity

- 论文链接:https://jmwang0117.github.io/OccRWKV/

- GitHub 仓库:https://github.com/jmwang0117/OccRWKV

- 发布时间:2024-09-06

论文提出了 “OccRWKV” :基于 RWKV 的 3D 语义占用预测,可用于自动驾驶、具身智能等领域。

OccRWKV 已提交至 ICRA 2025 。

实验表明,OccRWKV 在 SemanticKITTI 数据集达到 25.1 的 mIoU,比最佳基线 Co-Occ 快 20 倍,使其适合在机器人上实时部署,以增强自主导航效率。

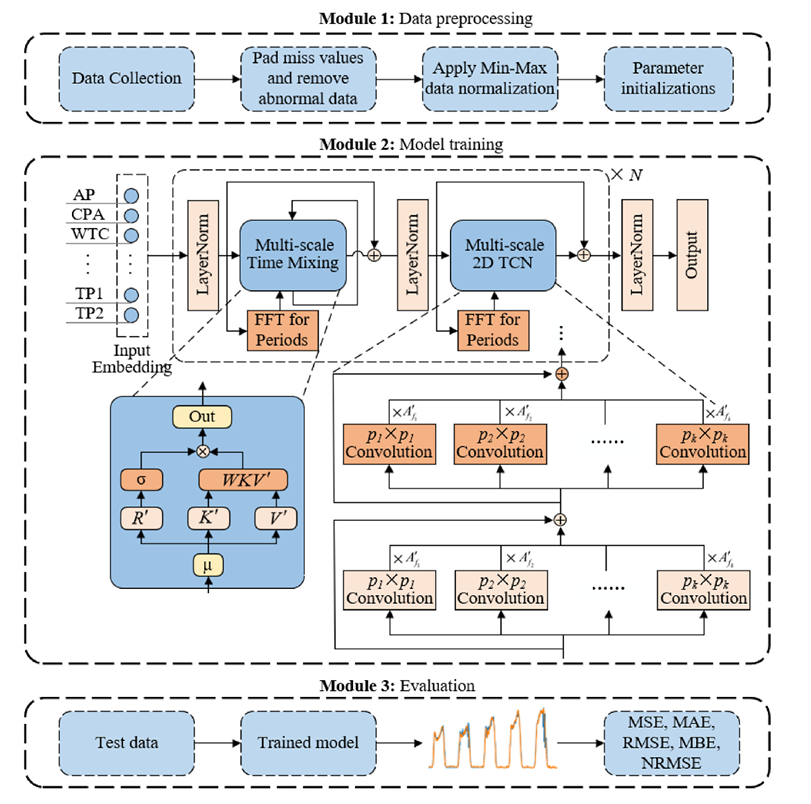

MSRWKV-2DTCN(光伏发电预测)

- 论文名称:Multi-scale RWKV with 2-dimensional temporal convolutional network for short-term photovoltaic power forecasting

- 论文链接:https://www.sciencedirect.com/science/article/abs/pii/S0360544224028433

- 发布时间:2024-09-06

论文提出了“多尺度 RWKV 二维时间卷积网络”(MSRWKV-2DTCN),将 FFT 和 2D TCN 与 RWKV 架构相结合,并应用于光伏发电预测。

研究证实,对比其他光伏发电功率预测模型,MSRWKV-2DTCN 在短期光伏发电功率预测方面具有更高的准确性。

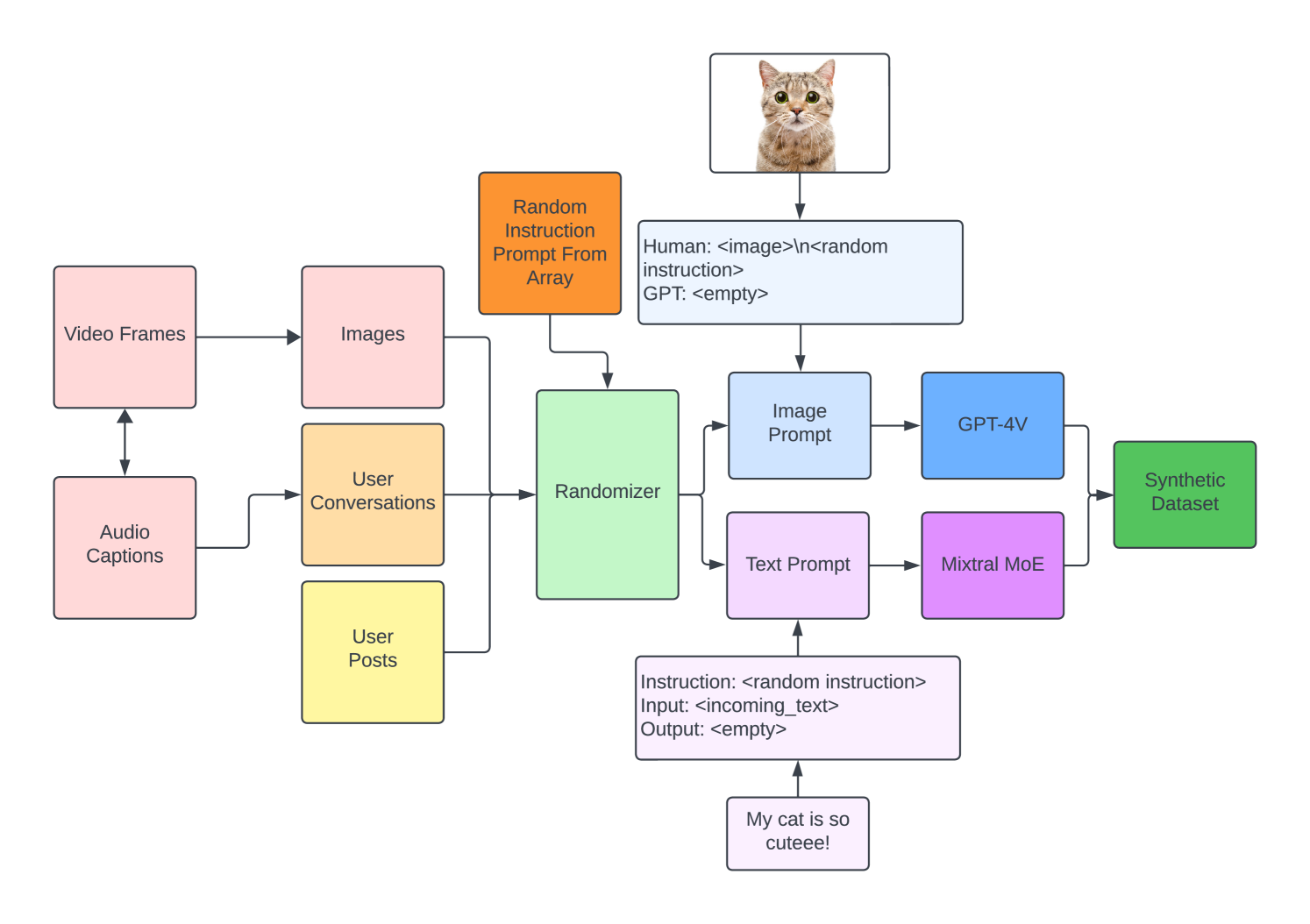

Mod-RWKV(多模态内容审核)

- 论文名称:Experimentation in Content Moderation using RWKV

- 论文链接:https://arxiv.org/abs/2409.03939

- 发布时间:2024-09-05

论文提出了 Mod-RWKV ,研究了 RWKV 模型在内容审核方面的效果。

团队通过使用一个包含图像、视频、声音和文本的数据集对 RWKV 模型进行 SFT 微调,使其适用于各种内容的审查场景。

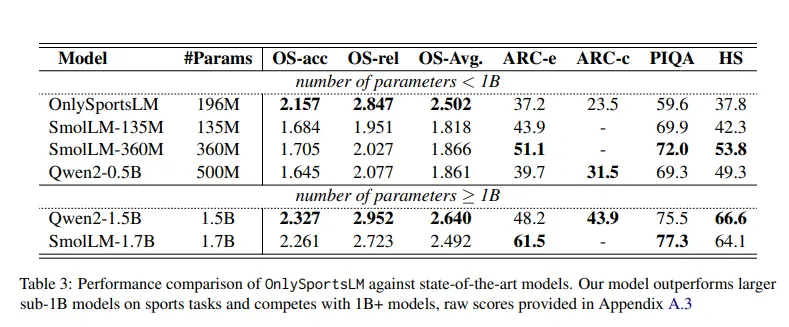

OnlySportsLM(体育运动任务)

- 论文名称:OnlySportsLM: Optimizing Sports-Domain Language Models with SOTA Performance under Billion Parameter

- 论文链接:https://arxiv.org/abs/2409.00286

- 发布时间:2024-08-30

论文提出了 OnlySportsLM :针对体育运动相关任务优化 RWKV-v6 架构,并训练了一个 196M 的 OnlySportsLM 模型。

Benchmark 显示,与 SOTA 135M/360M 体育运动模型相比, OnlySportsLM 的精度提高了 37.62%/34.08% ,其性能比肩运动领域的 SomlLM 1.7B 和 Qwen 1.5B 等较大参数模型。

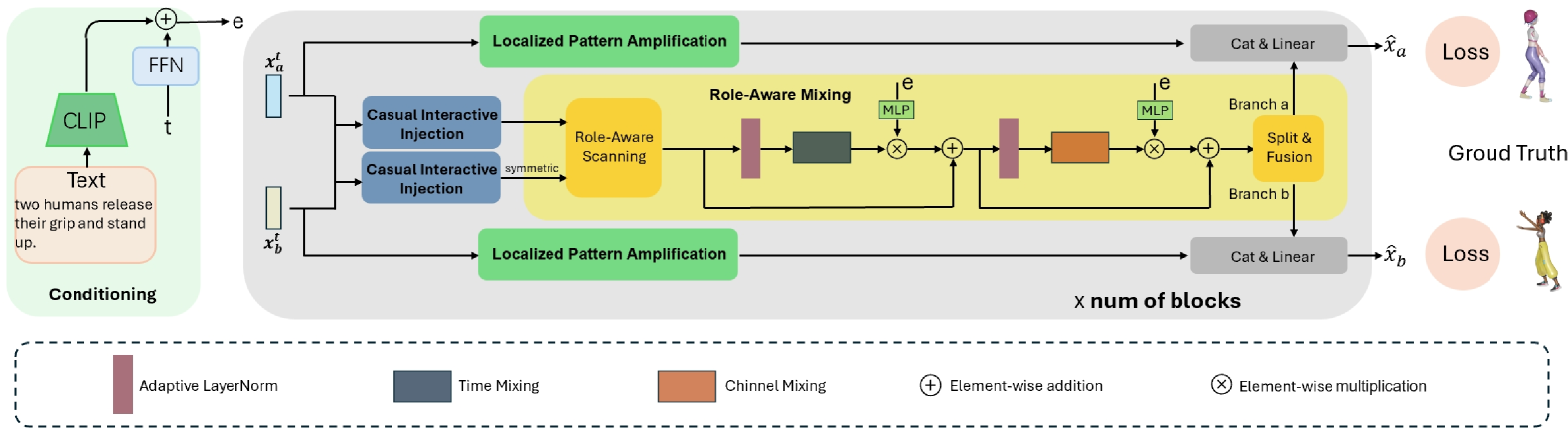

RWKV-TIM(人类动作交互建模)

- 论文名称:Temporal and Interactive Modeling for Efficient Human-Human Motion Generation

- 论文链接:https://arxiv.org/abs/2408.17135

- 发布时间:2024-08-30

论文提出了时间交互式建模(Temporal and Interactive Modeling,TIM),将 RWKV 模型应用于生成人类之间的交互动作。

实验数据显示:TIM 仅使用 InterGen 数据集中 32% 的可训练参数,就取得了 SOTA 效果。

社区新项目

RWKV-nonogram

RWKV-nonogram 使用 RWKV-6 + Chain Of Thought 训练了一个 20M 参数 RWKV 模型,这个模型可以做数织(nonogram)任务。

RWKV-nonogram 的 CoT 过程:

关于《RWKV 社区动态》栏目

《RWKV 社区动态》栏目会不定期播报 RWKV 社区的最新消息,以帮助 RWKV 的关注者、爱好者、开发者更好地了解 RWKV 的发展情况。

《RWKV 社区最新动态》不定期更新,所以请保持关注我们的微信公众号(RWKV 元始智能)、QQ 频道(RWKV)等公开平台,以获取最新的消息。

加入 RWKV 社区

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理。

- RWKV 中文官网(有多篇多模态论文):https://rwkv.cn/

- RWKV-5/6(Eagle & Finch)论文: https://arxiv.org/abs/2404.05892

- RWKV-4 论文: https://arxiv.org/abs/2305.13048

欢迎大家加入 RWKV 社区!可以从 RWKV 中文官网了解 RWKV 模型,也可以加入我们的 QQ 频道和群聊,一起探讨 RWKV 模型。

- QQ 频道:https://pd.qq.com/s/9n21eravc

- QQ 交流群:224287095

721

721

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?