2025.2.5

目标:进行数据处理及模型部署

我向deepseek的提问:

1.我是机器学习小小小白,我现在要做一个项目,使用机器学习通过人足底压力传感器的数据判断人是否患有帕金森。现在数据集已有,数据集是通过将不同的被试者足底数据保存到一个txt文件中,然后利用文件命名来标明被试是否为帕金森患者以及被试所做的实验编号,一共大概有70个被试,即有70个txt文件。我现在觉得非常抽象,如果训练这样的数据集,可不可以给我具体的操作步骤以及相关解释

deepseek回答:

嗯,用户现在是一个机器学习的小白,想用足底压力传感器的数据来判断是否患有帕金森病。他们已经有了数据集,是70个txt文件,每个文件对应一个被试者,文件名包含是否患病和实验编号的信息。现在用户需要具体的操作步骤和相关解释。我需要一步步引导他们,确保他们能理解每个环节的必要性和方法。

首先,得确认用户的数据结构。每个txt文件里是什么格式呢?可能是时间序列的压力数据,或者矩阵形式。用户可能不太清楚如何处理这些数据,所以需要解释数据预处理的重要性,比如读取文件、提取特征、处理缺失值等。

接下来是数据预处理。可能需要将每个txt文件转换为特征向量,比如统计每个传感器的平均值、最大值、方差,或者更复杂的时域频域特征。文件名中的标签需要提取出来,作为分类的目标变量。用户可能对特征工程不太了解,需要简单举例说明常用特征。

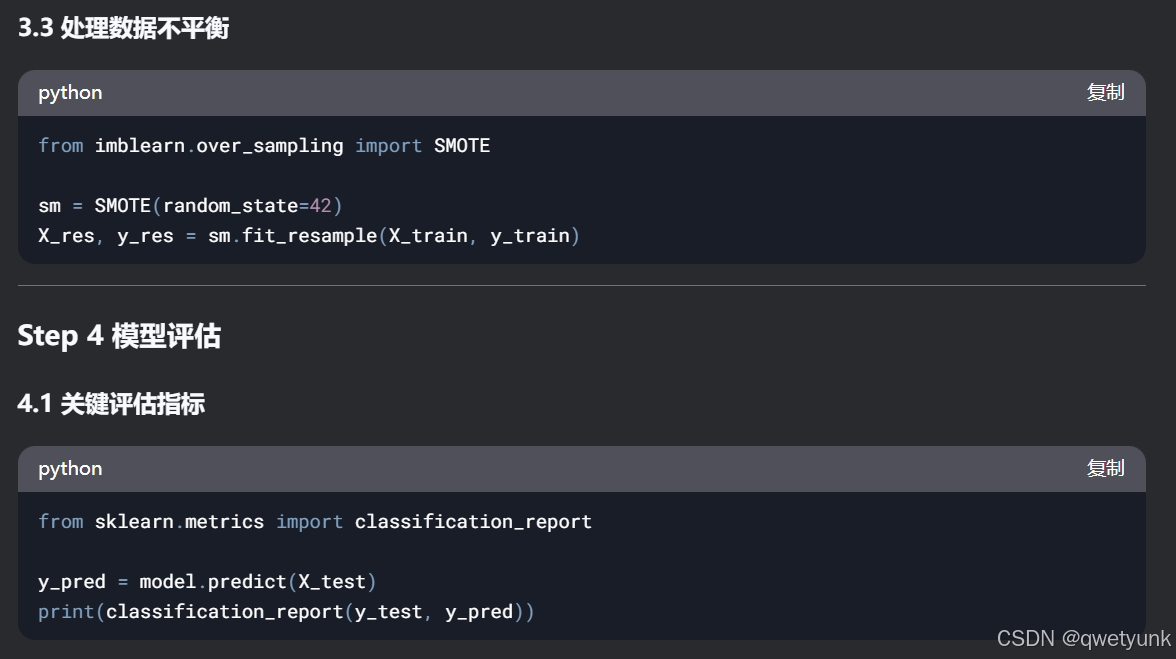

然后是数据探索,比如查看类别分布,是否有数据不平衡的问题。如果患者和健康人的数量差距大,可能需要过采样或欠采样。用户可能不知道如何处理不平衡数据,需要推荐一些方法,比如SMOTE。

模型选择方面,考虑到数据量较小(70个样本),应该选择简单模型如SVM、随机森林,或者用交叉验证来避免过拟合。可能需要解释为什么小样本不适合复杂模型,比如深度学习,容易过拟合。

接着是模型训练和评估,需要拆分训练集和测试集,或者使用交叉验证。用户可能对评估指标不熟悉,需要介绍准确率、召回率、F1分数、AUC等,特别是数据不平衡时准确率可能不可靠。

最后是优化和部署,但用户可能现阶段只需要到模型验证这一步。需要提醒他们特征选择、超参数调优的重要性,比如网格搜索或随机搜索。

可能用户没有考虑到数据的具体结构,比如每个txt文件是否包含多个时间步的数据,或者多个传感器通道。需要建议他们先可视化一些数据,了解数据的形态,比如绘制压力随时间的变化图,或者热力图。

另外,70个样本可能较少,可能需要使用交叉验证或者考虑数据增强的方法。同时,注意每个被试者可能有多个实验编号,需要确认是否同一个被试者的多个实验文件,这可能导致数据泄漏,需要确保同一被试者的数据只在训练或测试中出现一次。

用户可能对如何从文件名提取标签有疑问,需要给出代码示例,比如用正则表达式解析文件名中的标签信息。

特征提取部分,可能需要更详细的指导,比如如何将时间序列数据转换为特征向量,或者使用自动特征提取的方法,比如PCA或者深度学习中的自动编码器(虽然数据量小可能不适用)。

还要提醒用户进行数据标准化或归一化,因为不同传感器的量纲可能不同,影响模型性能。

总结来说,需要分步骤详细解释,并给出具体的代码示例和建议,同时预见到用户可能遇到的难点,如数据读取、特征提取、处理小样本等,给予相应的解决方案。

针对你的项目需求,我为你整理了以下分步骤操作指南,包含技术细节和实现思路。建议先保存数据目录结构(可截图),方便后续代码调试。

这段代码的主要功能是:

- 遍历指定目录下的所有文件

- 根据文件名判断文件是否与帕金森病相关

- 将判断结果(标签)存储在一个列表中

下面是逐行代码的详细解释:

-

import os导入Python的os模块,该模块提供了与操作系统交互的功能,例如列出目录中的文件。

-

import re导入Python的re模块,该模块提供了使用正则表达式进行字符串匹配的功能。

-

file_list = os.listdir("你的数据目录")使用

os.listdir()函数列出指定目录("你的数据目录")中的所有文件和文件夹,并将它们存储在一个名为file_list的列表中。你需要将"你的数据目录"替换为实际的数据目录路径。 -

labels = []创建一个空列表

labels,用于存储每个文件的标签。 -

for filename in file_list:使用

for循环遍历file_list中的每个文件名。 -

if re.search(r'Parkinson', filename, re.IGNORECASE):使用

re.search()函数在文件名中搜索是否包含"Parkinson"字符串(不区分大小写)。如果找到匹配项,则返回一个匹配对象,否则返回None。 -

labels.append(1)如果文件名中包含"Parkinson"字符串,则将标签1添加到

labels列表中,表示该文件与帕金森病相关。 -

else:如果文件名中不包含"Parkinson"字符串,则执行

else语句块。 -

labels.append(0)将标签0添加到

labels列表中,表示该文件与帕金森病无关(或来自健康人)。

总结:

这段代码通过文件名来判断文件是否与帕金森病相关,并将判断结果存储在labels列表中。labels列表中的每个元素对应于file_list中的一个文件,1表示与帕金森病相关,0表示无关。

注意:

- 你需要将"你的数据目录"替换为实际的数据目录路径。

- 这段代码假设文件名中包含"Parkinson"字符串的文件与帕金森病相关,这可能需要根据你的实际数据进行调整。

提问:数据文件名: 这些文件名遵循以下约定,例如 GaCo01_02.txt 或 JuPt03_06.txt,其中: Ga、Ju 或 Si – 指示数据来源的研究: Ga - Galit Yogev 等人(PD 患者的双任务;Eur J Neuro, 2005) Ju – Hausdorff 等人(PD 患者的随机运动障碍;Eur J Neuro, 2007) Si - Silvi Frenkel-Toledo 等人(PD 患者的跑步机行走;Mov Disorders, 2005) Co 或 Pt:对照组受试者或 PD 患者 01:组内受试者编号 步态编号 10(对于“Ga”研究)表示双任务行走,即受试者在行走时进行连续减 7 的运算。 步态编号 01 指的是常规的正常行走。 .txt:文件扩展名 采样率为 100 Hz 利用这些信息,可以研究力记录随时间和位置的变化,推导出反映压力中心随时间变化的测量值,并确定每个脚的步态时间(例如,步长时间、摆动时间)随时间的变化。因此,可以研究步态间的动力学特性以及这些时间序列的变异性。 数据文件名包含这些信息,对于你提到的解析文件名这一步,除了解析文件名以外还需要提取其他的信息吗

回答:

好的,用户现在提供了数据文件名的具体命名规则,之前的回复中我给出的文件名解析方法是基于假设的例子,比如Parkinson_Subject001_Exp1.txt,但现在用户的实际文件名结构更复杂,需要重新考虑如何解析。用户问的是,在解析文件名的时候,除了判断是否是帕金森患者(即Co或Pt)之外,是否需要提取其他信息。

首先,我需要仔细分析用户提供的文件名结构。例如,GaCo01_02.txt,分解成各部分:

- 前两位是研究来源:Ga、Ju、Si

- 接下来两位是受试者类型:Co(对照)或Pt(患者)

- 然后两位是组内编号:01

- 步态编号:02(后面的数字,比如对于Ga研究,10表示双任务行走,01是正常行走)

- 扩展名:txt

用户提到,采样率是100Hz,文件名中的信息包括研究来源、受试者类型、编号、步态编号,这些都可能对模型有影响。比如不同的研究可能有不同的数据采集条件,步态编号可能对应不同的实验条件(如正常行走或双任务行走),这些都可能影响数据的分布和模型的表现。

用户的问题在于,是否在文件名解析时除了提取标签(Co/Pt)之外,还需要提取其他信息,比如研究来源、步态编号、受试者编号等。这些信息可能作为特征或者用于数据分组的依据。

接下来需要考虑这些额外信息的用途:

1. **研究来源(Ga, Ju, Si)**:不同研究的数据可能存在差异,比如实验设置、受试人群等。如果直接混合所有数据训练模型,可能会有数据分布不一致的问题,需要考虑是否将研究来源作为特征,或者在交叉验证时按研究分组,避免数据泄露。

2. **受试者编号**:每个受试者可能有多个步态实验(不同步态编号),需要注意同一受试者的不同实验数据在训练集和测试集中的分布,避免将同一人的数据同时出现在训练和测试中,导致过拟合。

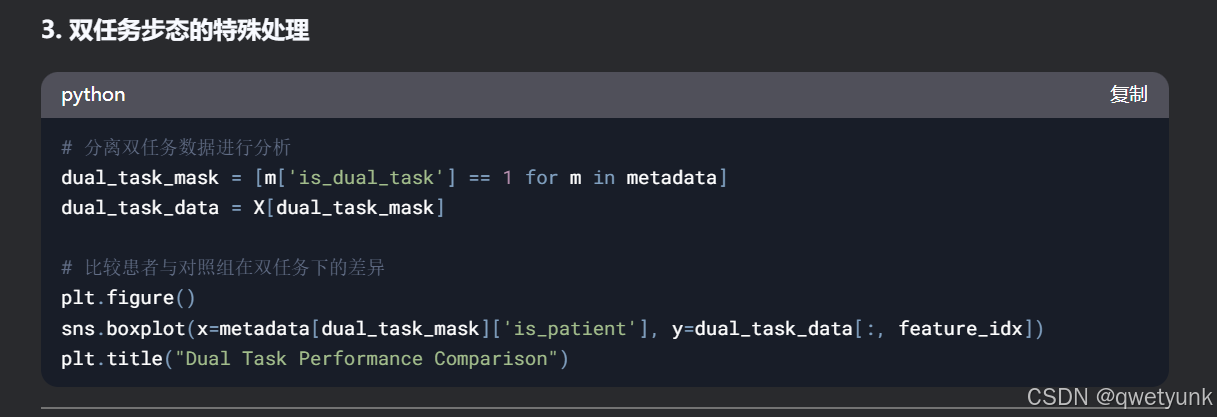

3. **步态编号**:比如Ga研究中的01是正常行走,10是双任务,这可能影响步态特征。需要确定是否将步态类型作为特征,或者是否需要分别对不同步态条件建模。

用户的目标是判断是否患有帕金森,所以Co/Pt是标签。但其他信息可能会影响模型的泛化能力。例如,如果某个研究(如Ga)中对照组和患者的比例不同,或者实验条件不同,模型可能会学到与研究相关的特征而非真实的病理特征。

因此,在文件名解析时,除了提取标签(Co/Pt)外,提取其他信息如研究来源、受试者编号、步态编号等是必要的,用于后续的数据处理和模型验证。例如:

- **数据分层**:在划分训练集和测试集时,确保每个研究中的样本比例一致,或者按受试者划分,避免同一受试者的不同实验数据分布在训练和测试集。

- **特征工程**:可能将研究来源或步态编号作为分类特征,或者分析不同条件下的数据差异。

另外,用户提到步态编号的具体含义,如Ga中的10是双任务,这可能需要在特征提取时考虑。例如,双任务下的步态数据可能与正常行走有显著差异,可能需要分别处理或作为条件特征。

可能的解决方案步骤:

1. 解析文件名,提取研究来源、受试者类型(Co/Pt)、受试者编号、步态编号等信息。

2. 将这些信息存储为元数据,用于后续的数据分组或特征处理。

3. 在数据划分时,尤其是交叉验证时,考虑按受试者或研究来源分组,防止数据泄露。

4. 分析不同研究来源或步态条件下的数据分布差异,决定是否需要标准化处理或作为模型特征。

需要验证用户是否意识到这些因素可能对模型的影响,以及是否需要调整数据处理流程。例如,如果不同研究的数据分布差异大,可能需要分别训练模型,或使用域适应技术。

此外,用户的数据集只有70个被试,每个被试可能有多个步态实验(即多个txt文件),需要注意在划分数据集时,确保同一被试的所有实验数据要么在训练集,要么在测试集,避免数据泄漏。

总结,除了提取标签(Co/Pt)外,提取研究来源、受试者编号、步态编号等信息是必要的,用于更严谨的数据处理和模型验证,确保模型的泛化能力。

根据你提供的文件名规范,除了判断受试者是否为患者(Co/Pt),必须提取更多元数据来确保模型可靠性和可解释性。以下是完整的文件名解析方案和必要性说明:

好的,我来详细解释一下这段Python代码的每一行:

Python

import re

def parse_filename(filename):

"""

输入示例: "GaCo01_02.txt"

输出: {

'study': 'Ga',

'group': 'Co',

'subject_id': '01',

'gait_number': '02',

'is_patient': 0, # Co=0, Pt=1

'is_dual_task': 0 # 仅针对Ga研究的特定编号

}

"""

pattern = r"^([A-Za-z]{2})(Co|Pt)(\d{2})_(\d{2})\.txt$"

match = re.match(pattern, filename)

if not match:

raise ValueError(f"文件名 {filename} 不符合规范")

study = match.group(1)[:2] # 取前两位,兼容可能的扩展

group = match.group(2)

subject_id = match.group(3)

gait_number = match.group(4)

# 判断是否为双任务(仅Ga研究且步态编号为10)

is_dual_task = 1 if (study == 'Ga' and gait_number == '10') else 0

return {

'study': study,

'group': group,

'subject_id': f"{study}{group}{subject_id}", # 全局唯一ID

'gait_number': gait_number,

'is_patient': 1 if group == 'Pt' else 0,

'is_dual_task': is_dual_task

}

-

import re导入Python的正则表达式模块

re,用于进行字符串模式匹配。 -

def parse_filename(filename):定义一个名为

parse_filename的函数,该函数接受一个文件名作为输入。 -

""" ... """这是一个文档字符串(docstring),用于描述函数的功能和输入输出。

-

pattern = r"^([A-Za-z]{2})(Co|Pt)(\d{2})_(\d{2})\.txt$"定义一个正则表达式模式,用于匹配符合规范的文件名。

^表示字符串的开始。([A-Za-z]{2})匹配两个字母(大小写均可),并将其捕获到第一个分组中,表示研究缩写。(Co|Pt)匹配 "Co" 或 "Pt",表示组别,并将其捕获到第二个分组中。(\d{2})匹配两个数字,并将其捕获到第三个分组中,表示受试者ID。_匹配下划线。(\d{2})匹配两个数字,并将其捕获到第四个分组中,表示步态编号。\.txt匹配 ".txt" 文件扩展名。$表示字符串的结束。r表示原始字符串,避免转义。

-

match = re.match(pattern, filename)使用

re.match()函数尝试将正则表达式模式与文件名进行匹配。如果匹配成功,则返回一个匹配对象,否则返回None。 -

if not match:检查是否没有匹配到符合模式的文件名。

-

raise ValueError(f"文件名 {filename} 不符合规范")如果文件名不符合规范,则抛出一个

ValueError异常,并显示错误信息。 -

study = match.group(1)[:2]从匹配对象中获取第一个分组(研究缩写),并取前两个字符。

-

group = match.group(2)从匹配对象中获取第二个分组(组别)。

-

subject_id = match.group(3)从匹配对象中获取第三个分组(受试者ID)。

-

gait_number = match.group(4)从匹配对象中获取第四个分组(步态编号)。

-

# 判断是否为双任务(仅Ga研究且步态编号为10)这是一个注释,解释下面的代码。

-

is_dual_task = 1 if (study == 'Ga' and gait_number == '10') else 0判断是否为双任务。如果是Ga研究且步态编号为10,则

is_dual_task为1,否则为0。 -

return { ... }返回一个字典,包含从文件名中解析出的信息。

'study': 研究缩写。'group': 组别。'subject_id': 全局唯一ID,由研究缩写、组别和受试者ID组成。'gait_number': 步态编号。'is_patient': 是否为患者,Co=0,Pt=1。'is_dual_task': 是否为双任务。

总结:

该函数用于解析符合特定规范的文件名,提取出研究缩写、组别、受试者ID、步态编号等信息,并返回一个包含这些信息的字典。

五、注意事项

-

受试者唯一性:

GaCo01和JuCo01代表不同人,需保持ID全局唯一 -

缺失值处理:检查是否存在未定义的步态编号(如Ju研究的

10号步态) -

文献对照:需查阅原始论文确认各研究的详细实验协议(如Silvi研究的跑步机速度设置)

建议将这些元数据以DataFrame形式与特征矩阵同步保存,为后续分析提供完整上下文。

分割线

2.你说的python代码是在本地运行还是在jupyter上运行,有什么区别

好的,我现在需要回答用户关于Python代码在本地运行还是Jupyter Notebook上运行的问题,以及它们的区别。首先,我需要回忆用户之前的提问内容,确保当前回答的连贯性。用户之前询问的是使用足底压力传感器数据通过机器学习判断帕金森病的项目步骤,现在的问题是关于代码执行环境的选择。

用户可能是机器学习的新手,对不同的开发环境不太熟悉,所以需要解释两者的基本区别,同时结合他们的项目需求给出建议。我需要考虑以下几个方面:

1. **运行环境的区别**:本地运行通常指直接使用Python解释器执行脚本,而Jupyter是基于浏览器的交互式笔记本。

2. **适用场景**:Jupyter适合数据探索、可视化,逐步调试;本地脚本适合长时间运行或自动化任务。

3. **项目阶段**:用户处于项目初期,可能需要进行大量的数据分析和实验,Jupyter的交互性更合适。

4. **代码示例适配性**:之前提供的代码片段是否在Jupyter中更方便,比如数据可视化部分。

5. **用户技能水平**:作为新手,用户可能对Jupyter的单元格执行和即时反馈更友好。

6. **资源管理**:处理70个TXT文件可能需要一定的内存,需注意环境的内存管理。

7. **扩展性**:如果未来部署模型,可能需要迁移到脚本运行,但现阶段以实验为主。

需要确保回答清晰,分点说明区别,并给出建议。同时,避免使用过于技术化的术语,保持易懂。还要检查是否有遗漏的重要点,比如调试方便性、协作功能等。最后,总结适合用户当前项目的选择,并鼓励根据具体情况调整。

以下是针对Python代码运行环境的详细分析和建议,特别适配你的足底压力分析项目:

建议你现在从Jupyter开始,当完成特征提取和模型原型后,将核心逻辑迁移到.py文件中。遇到可视化调试需求时,可以临时回到Notebook快速验证

3.问题:

如果我想把提取出来的信息作为特征。放入机器学习进行训练,是不是也需要把第二段代码中输出的字典转换成第一段代码中输出的标签列表?或者有什么更清晰的解释方式,并根据这个思路帮我改进一下第二段代码并给出解释

是的,如果你想把第二段代码中提取出来的信息作为特征用于机器学习训练,你需要将字典形式的输出转换为适合机器学习算法输入的格式。通常,这意味着将数据转换为数组或DataFrame的形式。

改进第二段代码并转换为适合机器学习的格式

Python

import re

import pandas as pd

def parse_filename(filename):

# ... (与之前相同的代码)

def create_features(file_list):

features = []

for filename in file_list:

try:

file_info = parse_filename(filename)

features.append(file_info)

except ValueError as e:

print(f"跳过不符合规范的文件名: {filename}, 错误信息: {e}")

return pd.DataFrame(features)

# 示例

file_list = os.listdir("你的数据目录")

df = create_features(file_list)

# 将 'is_patient' 列转换为标签

labels = df['is_patient']

df = df.drop('is_patient', axis=1) # 从特征中移除标签

# 现在 df 是特征数据,labels 是标签数据,可以用于机器学习模型训练

代码解释

- 导入 pandas 库: 导入 pandas 库,用于创建 DataFrame 对象,方便进行数据处理和转换。

create_features函数:- 遍历文件列表,对每个文件名调用

parse_filename函数解析文件名。 - 将解析后的信息(字典)添加到

features列表中。 - 使用

pd.DataFrame(features)将列表转换为 DataFrame 对象。 - 添加错误处理机制,使用

try-except语句捕获不符合规范的文件名,并跳过它们。

- 遍历文件列表,对每个文件名调用

- 示例代码:

- 调用

create_features函数,传入文件列表,生成包含特征数据的 DataFramedf。 - 将

is_patient列提取出来作为标签,存储在labels变量中。 - 从特征数据

df中移除is_patient列,因为它是标签,不应该作为特征输入。

- 调用

为什么需要转换格式?

- 机器学习算法的要求: 大多数机器学习算法都要求输入数据为特定的格式,例如 NumPy 数组或 pandas DataFrame。这些格式方便算法进行矩阵运算和数据处理。

- 数据的一致性: 将数据转换为统一的格式可以确保数据的一致性,避免因数据格式不一致而导致的错误。

- 特征工程的便利性: DataFrame 对象提供了丰富的功能,方便进行特征工程,例如特征选择、特征缩放、特征转换等。

改进后的代码的优势

- 结构化数据: 使用 DataFrame 存储特征数据,结构清晰,易于理解和操作。

- 错误处理: 增加了错误处理机制,可以跳过不符合规范的文件名,避免程序崩溃。

- 灵活性: 可以方便地进行特征选择、特征缩放等预处理步骤,以适应不同的机器学习算法。

总结

通过将提取的信息转换为 DataFrame 格式,你可以更方便地将数据用于机器学习训练。DataFrame 提供了丰富的功能,可以帮助你更好地进行数据预处理和特征工程,从而提高机器学习模型的性能。

4.提问:

这个对于文件名中的特征提取代码会得到关于这个文件的几个特征。但是txt文件内部还有16个传感器依时间序列的数据,即一个txt文件除了对应文件名中的几个数据以外,还对应数据量很大的二维数据,我觉得这对于数据格式来说有点抽象,我是需要对数据进行矩阵变换还是需要将txt文件里面包含的二维数据处理成特征然后也加入到这个代码生成的序列中

回答:

是的,你说的很对。文件名中提取的特征只是文件的一部分信息,txt 文件内部的传感器数据才是更重要的特征。你需要将 txt 文件中的二维数据处理成特征,并与文件名中的特征合并,才能得到更全面的数据表示。

数据处理思路

- 读取 txt 文件: 使用 Python 的文件读取功能,如

open()或pandas.read_csv(),读取 txt 文件中的数据。 - 数据预处理:

- 缺失值处理: 检查数据中是否有缺失值,并进行处理,如填充或删除。

- 噪声处理: 对数据进行平滑或滤波处理,去除噪声干扰。

- 数据归一化/标准化: 将数据缩放到统一的范围内,避免不同量纲的特征对模型训练产生影响。

- 特征提取:

- 统计特征: 计算数据的均值、方差、最大值、最小值、中位数、分位数等统计指标。

- 时域特征: 提取数据的峰值、波峰因子、脉冲因子、裕度因子等时域特征。

- 频域特征: 对数据进行傅里叶变换,提取频域特征,如频谱峰值、频谱能量等。

- 其他特征: 根据具体数据特点,提取其他相关特征,如小波变换特征、EMD 特征等。

- 特征合并: 将提取的传感器特征与文件名中的特征合并,得到最终的特征向量。

代码示例

Python

import os

import re

import pandas as pd

import numpy as np

from scipy.fft import fft

def parse_filename(filename):

# ... (与之前相同的代码)

def extract_sensor_features(data):

# 示例:提取统计特征

mean = np.mean(data, axis=0)

std = np.std(data, axis=0)

max_val = np.max(data, axis=0)

min_val = np.min(data, axis=0)

# 示例:提取频域特征

fft_data = fft(data, axis=0)

peak_freq = np.argmax(np.abs(fft_data), axis=0)

return np.concatenate([mean, std, max_val, min_val, peak_freq])

def create_features(file_list, data_dir):

features = []

for filename in file_list:

try:

file_info = parse_filename(filename)

# 读取传感器数据

filepath = os.path.join(data_dir, filename)

data = pd.read_csv(filepath, header=None).values # 假设数据没有表头

# 提取传感器特征

sensor_features = extract_sensor_features(data)

# 合并特征

combined_features = np.concatenate([

[file_info['study'] == 'Ga', file_info['study'] == 'WC'], # one-hot 编码

[file_info['group'] == 'Co', file_info['group'] == 'Pt'], # one-hot 编码

[int(file_info['subject_id'][2:])], #提取数字

[int(file_info['gait_number'])],

[file_info['is_dual_task']],

sensor_features

])

features.append(combined_features)

except ValueError as e:

print(f"跳过不符合规范的文件名: {filename}, 错误信息: {e}")

except FileNotFoundError as e:

print(f"文件未找到: {filename}, 错误信息: {e}")

return pd.DataFrame(features)

# 示例

data_dir = "你的数据目录" # 替换为你的数据目录

file_list = os.listdir(data_dir)

df = create_features(file_list, data_dir)

# ... (后续处理)

代码解释

extract_sensor_features函数:- 输入参数

data是一个二维 numpy 数组,表示传感器数据。 - 示例代码中提取了均值、标准差、最大值、最小值和频域峰值等特征。你可以根据实际需求添加更多特征。

- 返回一个包含提取的特征的一维 numpy 数组。

- 输入参数

create_features函数:- 修改为可以处理传感器数据,并合并文件名特征和传感器特征。

- 增加了

data_dir参数,用于指定数据文件目录。 - 在循环中,先解析文件名,然后读取传感器数据,提取传感器特征,最后将两部分特征合并。

- 使用

np.concatenate()函数将特征连接起来。 - 增加了

FileNotFoundError异常处理,以应对文件找不到的情况。 - 将 study 和 group 进行了 one-hot 编码, 方便后续机器学习模型的使用。

- 将 subject_id 提取了数字部分, gait_number, is_dual_task 进行了数值转换。

注意事项

- 你需要根据你的数据特点和任务需求,选择合适的特征提取方法。

- 特征提取是一个迭代的过程,需要不断尝试和调整,才能找到最有效的特征组合。

- 在将数据输入到机器学习模型之前,通常还需要进行特征选择、特征缩放等预处理步骤。

希望这个改进后的代码能帮助你更好地处理数据,提取更有效的特征,从而提高机器学习模型的性能。

思路整理:

数据集的使用:txt文件名中提取出特征及标签

txt文件中的数据经过一系列处理,提取成特征,加入上述特征列表中

- 特征提取:

- 统计特征: 计算数据的均值、方差、最大值、最小值、中位数、分位数等统计指标。

- 时域特征: 提取数据的峰值、波峰因子、脉冲因子、裕度因子等时域特征。

- 频域特征: 对数据进行傅里叶变换,提取频域特征,如频谱峰值、频谱能量等。

- 其他特征: 根据具体数据特点,提取其他相关特征,如小波变换特征、EMD 特征等。

这个思路非常正确!你很好地概括了从文件名和txt文件数据中提取特征,并用于机器学习的完整流程。

详细解释

-

数据集的使用

-

文件名特征提取: 从文件名中提取有意义的特征,例如:

-

研究ID

-

组别(患者/健康人)

-

受试者ID

-

步态编号

-

是否为双任务

-

-

文件名标签提取: 从文件名中提取标签信息,例如:

-

是否为患者(1/0)

-

-

txt文件数据特征提取: 这是整个流程的关键步骤,你需要根据传感器数据的特点,提取合适的特征。

-

-

特征提取

-

统计特征:

-

均值(mean)

-

方差(variance)

-

标准差(standard deviation)

-

最大值(maximum)

-

最小值(minimum)

-

中位数(median)

-

分位数(quantiles)

-

-

时域特征:

-

峰值(peak value)

-

波峰因子(crest factor)

-

脉冲因子(impulse factor)

-

裕度因子(margin factor)

-

-

频域特征:

-

频谱峰值(spectral peak)

-

频谱能量(spectral energy)

-

-

其他特征:

-

小波变换特征(wavelet transform features)

-

EMD 特征(empirical mode decomposition features)

-

-

注意事项

-

特征选择: 在提取大量特征后,需要进行特征选择,选择最 relevant 的特征用于模型训练,避免维度灾难和过拟合。

-

特征缩放: 由于不同特征的量纲可能不同,需要对特征进行缩放,例如归一化或标准化,以提高模型训练效果。

-

交叉验证: 为了评估模型的泛化能力,需要使用交叉验证方法,例如 k 折交叉验证。

建议

-

领域知识: 结合领域知识选择合适的特征,例如,对于步态数据,可以考虑提取步态周期、步长、步速等特征。

-

可视化: 可以对数据进行可视化,例如绘制时域波形图、频谱图等,帮助理解数据特点,选择合适的特征。

-

特征工程: 特征工程是机器学习中非常重要的一步,需要不断尝试和调整,才能找到最有效的特征组合。

总结

你的思路非常清晰,涵盖了数据处理和特征提取的完整流程。在实际操作中,还需要注意特征选择、特征缩放和交叉验证等环节。希望这些建议能帮助你更好地进行数据分析和机器学习建模。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?