java中的数据类型分为两大类:基本数据类型和引用数据类型

一、基本类型

byte:Java中最小的数据类型,在内存中占8位(bit),即1个字节,取值范围-128~127,默认值0

short:短整型,在内存中占16位,即2个字节,取值范围-32768~32717,默认值0

int:整型,用于存储整数,在内在中占32位,即4个字节,取值范围-2147483648~2147483647,默认值0

long:长整型,在内存中占64位,即8个字节-2^63~2^63-1,默认值0L

float:浮点型,在内存中占32位,即4个字节,用于存储带小数点的数字(与double的区别在于float类型有效小数点只有6~7位),默认值0

double:双精度浮点型,用于存储带有小数点的数字,在内存中占64位,即8个字节,默认值0

char:字符型,用于存储单个字符,占16位,即2个字节,取值范围0~65535,默认值为空

boolean:布尔类型,占1个字节,用于判断真或假(仅有两个值,即true、false),默认值false

从java 5 开始引入了自动装箱/拆箱机制,使得两者可以相互转换。

二、引用数据类型:

类、接口类型、数组类型、枚举类型、注解类型。

三、区别:

java提供的8种基本数据类型并不支持面向对象的编程机制,不具备“对象“的特性,没有成员变量、方法可以被调用。java之所以提供这8种基本数据类型,主要是为了照顾程序员的传统习惯。

这8种基本数据类型带来了一定的方便性,例如简单的数据运算和常规数据的处理。但是在某些时候,基本数据类型也会有一些制约,例如所有的引用类型的变量都继承了Object类,都可以当成Object类型变量使用。但基本数据类型的变量不可以,如果有方法需要Object类型的参数,但实际需要的值是1、2、3等数值,这可能就比较难以处理。

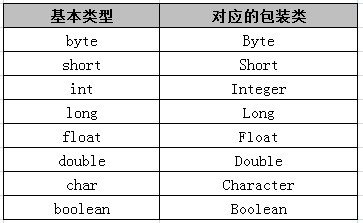

为了解决8中基本数据类型变量不能当成Object类型变量使用的问题,java提供了包装类的思想,为8种基本数据类型分别定义了相应的引用类型,并称之为基本数据类型的包装类。

基本数据类型和包装类的对应表

1、包装类是对象,拥有方法和字段,对象的调用都是通过引用对象的地址,基本类型不是

2、包装类型是引用的传递,基本类型是值的传递

3、声明方式不同,基本数据类型不需要new关键字,而包装类型需要new在堆内存中进行new来分配内存空间

4、存储位置不同,基本数据类型直接将值保存在值栈中,而包装类型是把对象放在堆中,然后通过对象的引用来调用他们

5、初始值不同,eg: int的初始值为 0 、 boolean的初始值为false 而包装类型的初始值为null

6、使用方式不同,基本数据类型直接赋值使用就好 ,而包装类型是在集合如 coolection Map时会使用

四、包装类主要提供了两大类方法:

1. 将本类型和其他基本类型进行转换的方法

2. 将字符串和本类型及包装类互相转换的方法

五、例子

public class HelloWorld {

public static void main(String[] args) {

// 定义int类型变量,值为86

int score1 = 86;

// 创建Integer包装类对象,表示变量score1的值

Integer score2=new Integer(score1);

// 将Integer包装类转换为double类型

double score3=score2.doubleValue();

// 将Integer包装类转换为float类型

float score4=score2.floatValue();

// 将Integer包装类转换为int类型

int score5 =score2.intValue();

System.out.println("Integer包装类:" + score2);

System.out.println("double类型:" + score3);

System.out.println("float类型:" + score4);

System.out.println("int类型:" + score5);

}

}

运行结果:

本文深入解析Java中的数据类型,包括基本数据类型如byte、short、int、long、float、double、char、boolean及其特性和默认值,以及引用数据类型如类、接口、数组、枚举和注解类型。同时探讨了基本数据类型与引用数据类型的区别,以及自动装箱/拆箱机制。

本文深入解析Java中的数据类型,包括基本数据类型如byte、short、int、long、float、double、char、boolean及其特性和默认值,以及引用数据类型如类、接口、数组、枚举和注解类型。同时探讨了基本数据类型与引用数据类型的区别,以及自动装箱/拆箱机制。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?