什么是提示技术?

提示技术是实现提示工程目标的具体技术手段,是提示工程中的“工具库”。

什么又是提示工程?

提示工程是指通过设计、优化和迭代输入到大语言模型(LLM)的提示(Prompt),系统性提升模型输出质量(如相关性、准确性、可控性)的实践领域。它是一个覆盖全流程的方法论,包括:

- 明确目标任务(如生成教学内容、问答、翻译);

- 设计提示结构(如指令、上下文、示例);

- 选择模型与参数(如温度、top_p);

- 验证与迭代(根据输出调整提示)。

其核心是“通过工程化方法控制大语言模型(LLM)的行为”。

概念

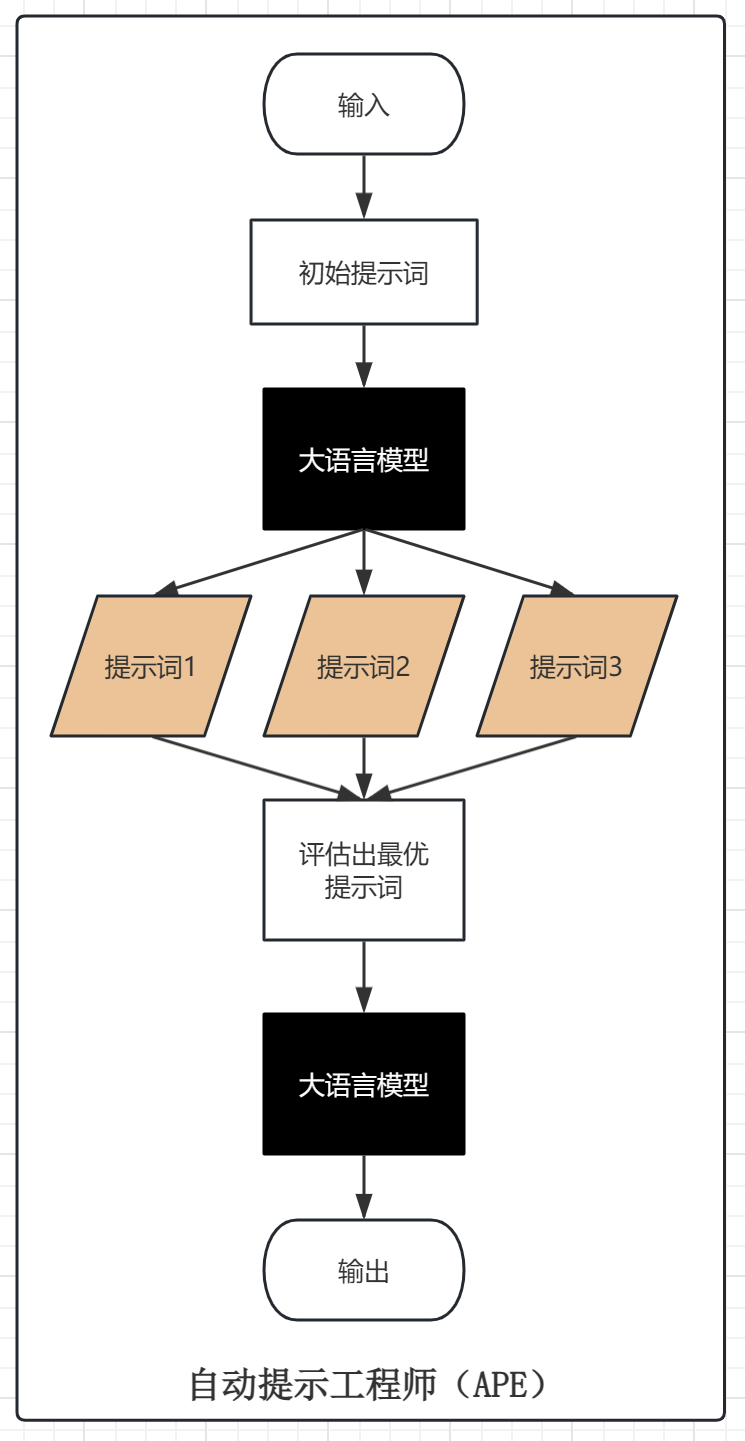

自动提示工程师(Automatic Prompt Engineer, APE),是一种通过大模型自动生成和优化提示词的技术,旨在替代人工设计提示词的过程,提升模型在特定任务上的表现。

APE 基于提示词工程的思路,即编写多个不同的提示词并对其进行测试,只不过是让整个过程自动化。

概念图解

应用场景

- 教育与学习资源开发(创建个性化的学习材料、练习题、考试模拟题等);

- 内容创作与文案生成(自动生成新闻标题、社交谋体帖子、广告文案等);

- 数据分析与报告撰写(从数据集中提取关键信息并自动生成报告);

- 编程助手与代码审查(自动生成代码片段、注解以及进行代码质量检查);

- 创意写作与故事生成(辅助作家完成小说大纲、角色设定、情节发展等工作);

- 法律咨询与合同起草(协助律师准备法律文书,如合同模板、诉讼材料等);

- ……

案例实操

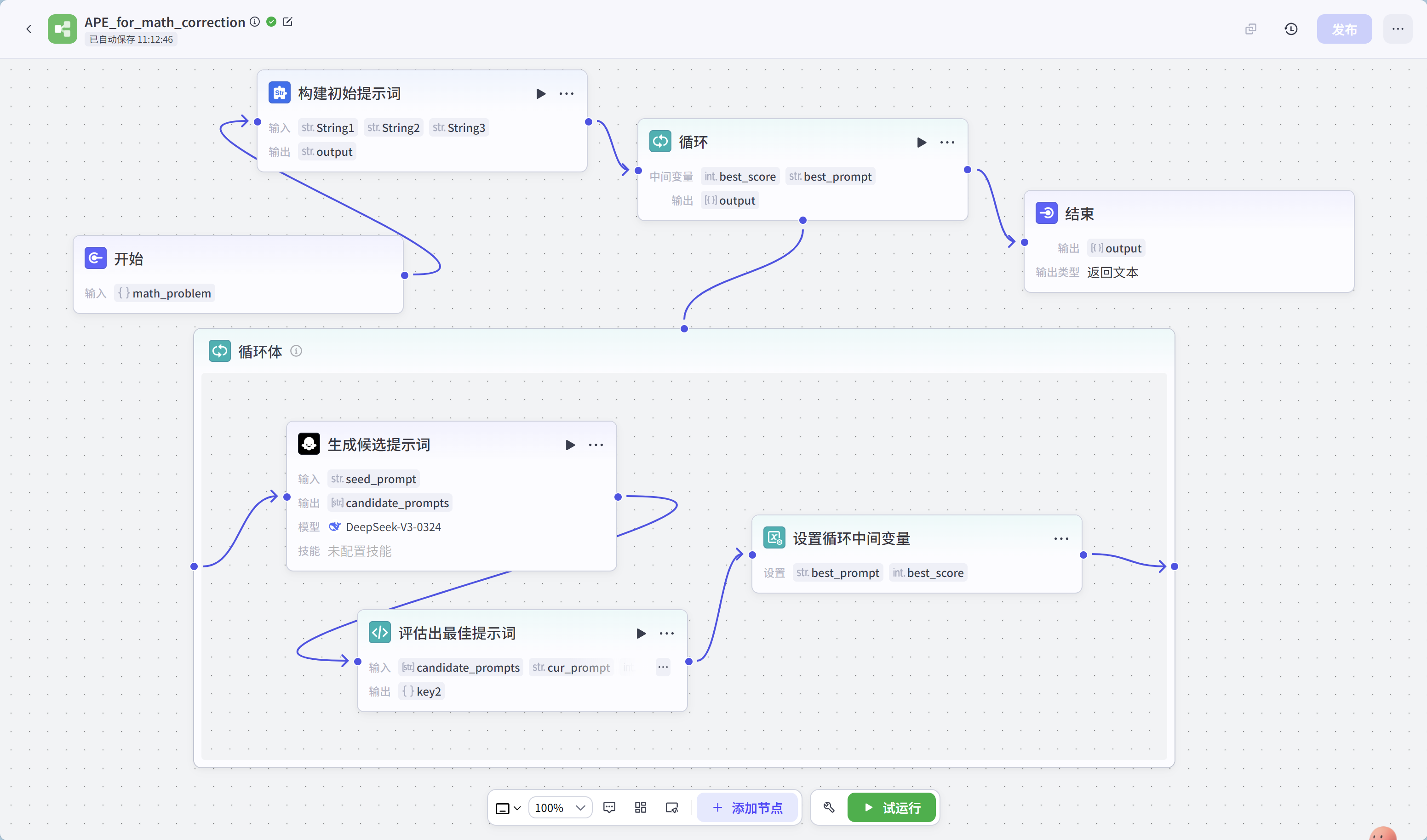

实现工具:扣子

实现方式:扣子工作流

完整工作流如下:

工作流节点配置信息:

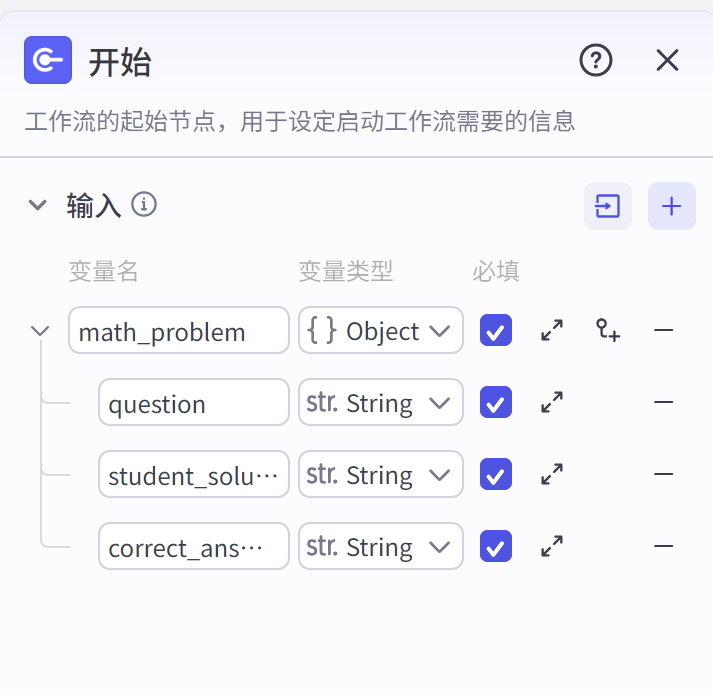

- 开始节点:

- 构建初始提示词节点:

- 循环节点:

- 生成候选提示词节点:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

797

797

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?